Crowd Counting数据集汇总

视频监控=video surveillance

https://github.com/gjy3035/Awesome-Crowd-Counting/blob/master/src/Datasets.md进展 | 密集人群分布检测与计数 :https://www.sohu.com/a/338406719_823210

Free-view

2022_Pedestrian Attribute Recognition

https://github.com/wangxiao5791509/Pedestrian-Attribute-Recognition-Paper-List ; https://paperswithcode.com/task/pedestrian-attribute-recognition/

2022年9月15号发布

原来做的任务:Pedestrian Attribute Recognition(这个做的实际就是crowd counting的进阶任务,商圈人流量用户画像),每个图标注了丰富的行人相关的信息,比如一个人头发长短、是否戴眼镜、袜子什么颜色...

可以拿他的数据集过来做我的计数

2022_FUDAN-UCC

2022,Congested拥挤的, Unlabeled没标签

注意是一些毫不相干的照片,而不是连续的视频

我很好奇人是怎么数出来的?是我拿着数据集自己数出来的,还是数据集作者有提供?

新闻照片

样例

一些黑白老照片

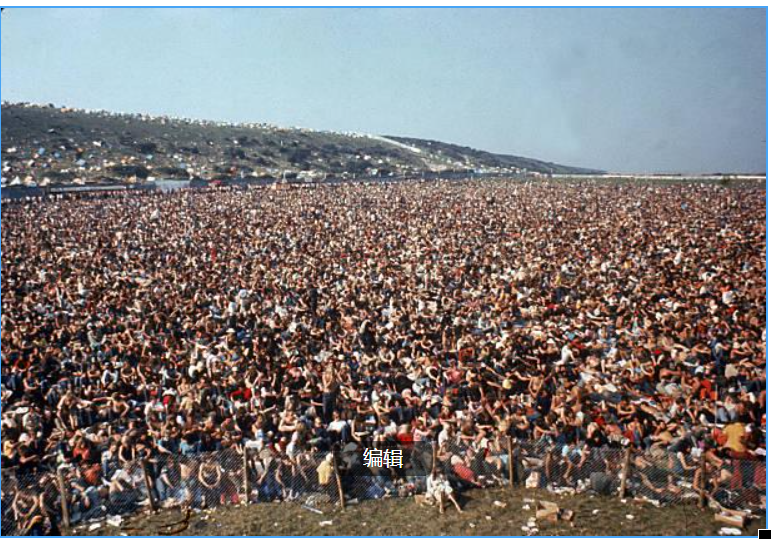

一些彩色照片,这张人非常密集

彩色照片,人不多

一些新闻插画人工绘制的画,里面有很多人

人工绘制的插画,人很少

2021_RGBT-CC

Congested拥挤的, Thermal热度图

数据样例

http://lingboliu.com/RGBT_Crowd_Counting.html

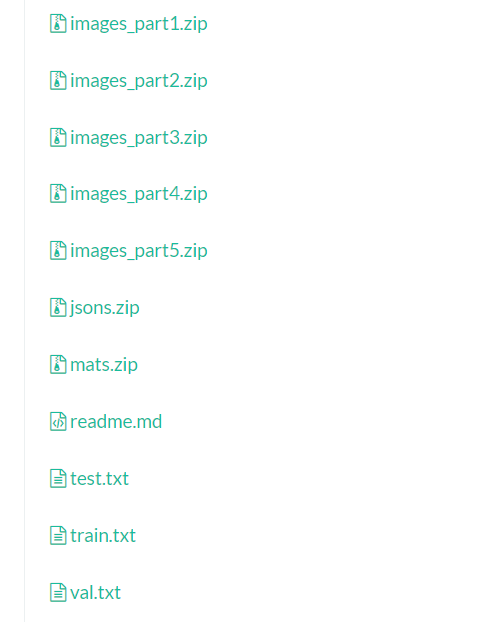

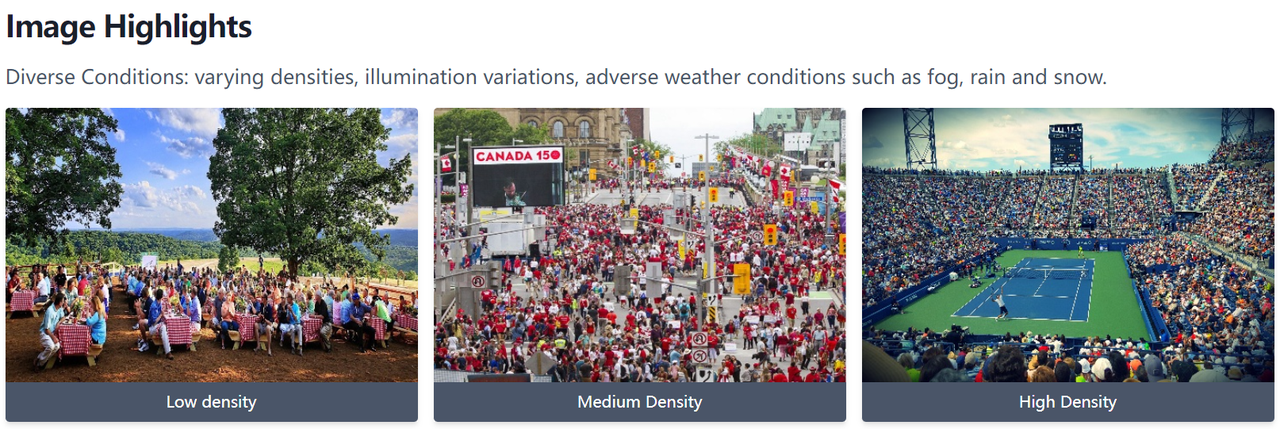

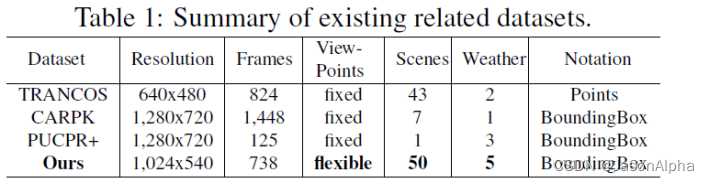

2020_NWPU-Crowd

(比较新出的的数据集,榜单排名还在持续刷新)

https://gjy3035.github.io/NWPU-Crowd-Sample-Code/

Congested图片上的人很多, Localization

Wang等[146]提出了NWPU-Crowd。它是目前人群计数中最大的数据集,有5109张图像和2133238个标记实体。此外,该数据集还包含一些负样本,有助于增强模型的鲁棒性。此外,它包含各种照明场景,密度范围最大[0,20033]。

如果想打榜:有有5,109 images ,图是网上爬的crawl;一个月可以提交6次,模型将会选择验证集中performance最好的那个作为最终结果;榜单每个星期更新一次,新提交的模型的performance会更新进去。

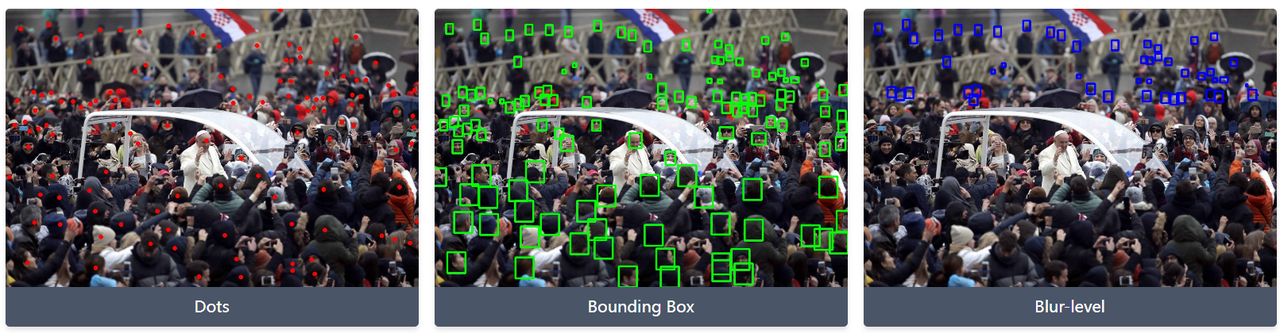

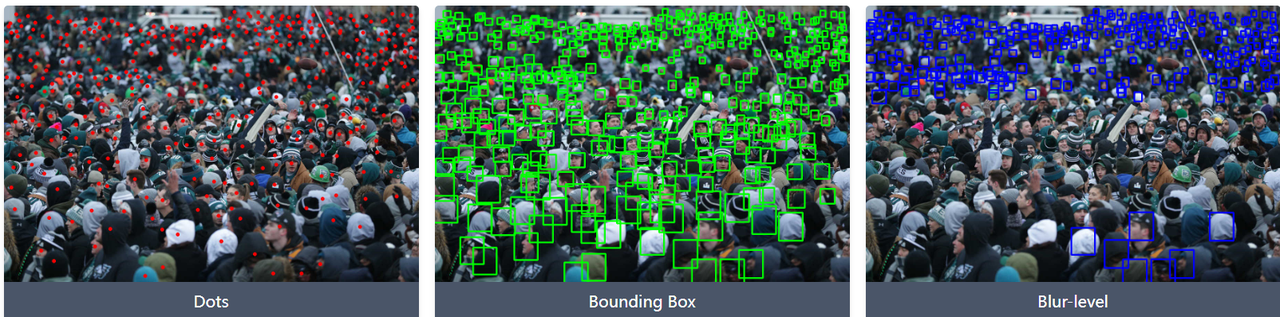

他的每一张图片都打了annotation,有的是方框做标注、有的是点做标注,标注不是直接标在图上的是用json文件 mat等等记录的位置

数据样例

2020_JHU-CROWD++

http://www.crowd-counting.com/

Congested

2018_UCF-QNRF

https://www.crcv.ucf.edu/data/ucf-qnrf/

Congested

人非常密集,数出个数

(离散图片)2016_ShanghaiTech Part A

其他用这个数据集的代码:https://paperswithcode.com/dataset/shanghaitech

数据集首发模型论文:Single Image Crowd Counting via Multi Column Convolutional Neural Network

A部分有482幅从互联网上随机抓取的图像,角度是free view,完全不相干的图片,不是连续的

拥挤人群的人数计数crowd counting/行人数量统计pedestrian counting

shanghai tech A+B数据集包含1198个标记图像和330,165个标记头,分为a和B两个部分。A部分包含482幅图像,其中训练集有300幅,测试集有182幅。这些图片是从互联网上收集的。B部分是在上海城市街道拍摄的400幅训练图像和316幅测试图像。与A区相比,B区人群密度相对较小。这个数据集涵盖了多个场景和不同的密度级别。ShanghaiTech数据集是一个非常具有挑战性的数据集,最近的人群计数工作都是基于该数据集进行比较的。

——有哪些优秀之处?

—— 图片较多:1,198 images

——标记方式是圆点。人太密集了,画bounding box会重合在一起一大堆,根本看不清,更加没法计数。所以在每个人头顶的中央标上一个圆点,表示检测到了Each person in a crowd image is annotated with one point close to the center of the head.

—— 对人的标记的annotation也比较多:the dataset consists of 330,165 annotated people

——拍摄角度:每张图的拍摄角度和清晰度是不同的different perspectives and resolutions

——然后把多少个人的人数ground truth数出来了,你的模型数出来是多少个人也写了

——数据集样例

人数数出来了

(离散图片)2013_UCF_CC_50

https://www.crcv.ucf.edu/data/ucf-cc-50/

Congested,极端密集的人群extremely dense crowds.

首发模型论文:, Multi-Source Multi-Scale Counting in Extremely Dense Crowd Images

UCF_CC_50数据集由50个不同分辨率的图像组成。每张图片平均包含1280人(极度密集)。整个数据集总共包括63075人。每个图像中的个体数在94 - 4543之间,有些图像包含非常密集的人群。该数据集还包含了音乐厅、示威集会、体育馆等多种多样的场景。

Surveillance-view

2022_VSCrowd

(2022年9月新出的数据集,)

https://github.com/HopLee6/VSCrowd-Dataset

首发论文:"Video Crowd Localization with Multi-focus Gaussian Neighborhood Attention and a Large-Scale Benchmark

634 videos, Localization

For each video, the annotations are saved in the corresponding TXT file (train_XXX.txt or test_XXX.txt), with the following format:

FrameID HeadID x1 y1 x2 y2 p1 p2 HeadID x1 y1 x2 y2 p1 p2 …

FrameID HeadID x1 y1 x2 y2 p1 p2 HeadID x1 y1 x2 y2 p1 p2 …

2020_DISCO

https://zenodo.org/record/3828468

Audiovisual(带声音的),extreme conditions

一张图最多有709个人,最少有88个人

之所以会加入声音这个维度,是因为一个人地方的声音越大,说明人就at the louder we perceive the ambient sound to be, the more people there are

论文原文:https://arxiv.org/abs/2005.07097

照片样例--

数据集比较大,4个G下下来要花很久

2019_Crowd Surveillance

填入个人邮箱即可下载:https://ai.baidu.com/broad/download

Free scenes

图片清晰度比其他数据集高很多 the largest dataset with the highest average resolution for crowd counting at present.。人都做了mark。数据有的是从合作方的安防监控视频那里拿来的,有的是爬虫从网上爬的。

2019_ShanghaiTechRGBD

下载地址:https://github.com/svip-lab/RGBD-Counting

是RGBD的3D图,有Depth这个维度的深度图

annotation是用mat文件标注的

ShanghaiTechRGBD/ ├── train_data/ ├── train_img/*.png ├── train_depth/*.mat └── train_gt/*.mat

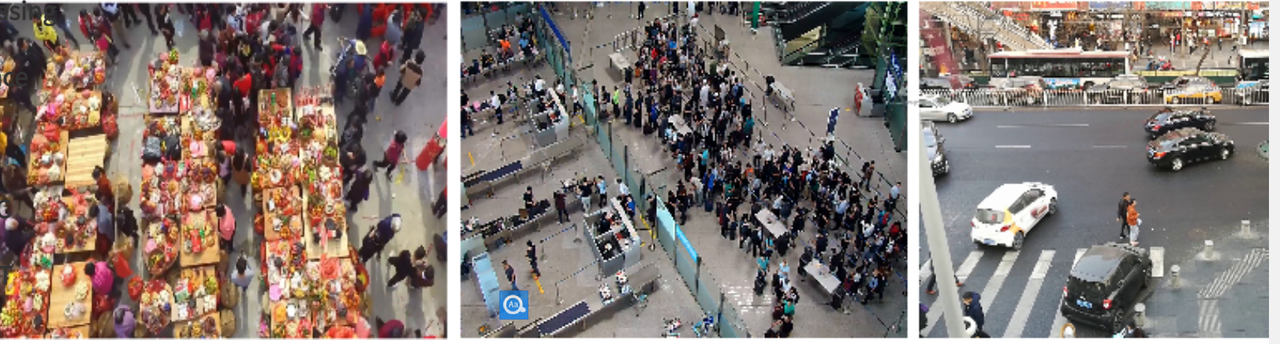

样例+人群特点

有人多有人少的,都是从空中俯视向下拍的

2019_Fudan-ShanghaiTech

(3)下载地址:https://github.com/sweetyy83/Lstn_fdst_dataset;https://drive.google.com/drive/folders/19c2X529VTNjl3YL1EYweBg60G70G2D-w

视频形式的

100 videos captured from 13 different scenes,

数据集特点:

一段视频从里面把每帧的截图拿出来,是连续的,是空中俯视的一个照片

2019_GCC

400 Fixed Scenes, Synthetic

https://gjy3035.github.io/GCC-CL/

基于GTA5这个游戏场景制作出的GCC数据集,拥有丰富的场景,大量的图,很多图是人工合成的

GCC中的图像取自《侠盗猎车手5》。Wang et al.设计了一个数据收集器和标签器来捕捉游戏中稳定的图像及其头部标签。该数据集涵盖了400种场景,场景中的个体有不同的肤色、性别、外貌等。作者还使用了一种循序渐进的方法来打破图像中个体的最大数量的限制。这是人群计数中最大的数据集,无论是样本大小还是涵盖的场景。用它对模型进行预训练,然后对模式分析与应用1 3进行微调,对具有实际数据的模型通常可以获得较好的计数性能。

(1)场景的选择

基于GTA5,选择了100个地点,然后每个地点通过改变相机的位姿,最终获得400个场景,然后通过不同的ROI获得不同的图片

(2)人模型的设计

选择了265个人的模型,每个人的模型有不同的肤色,性别,形状,然后又衣服,发型等6个不同的外观参数,在场景中采用随机的动作

(3)场景合成

原始GTA5每个场景不超过256人,为了产生人多的图片,需要进行场景合成,就是将不同场景下的人拼到一块儿

2019_Venice

各种模型打榜这个数据集:https://paperswithcode.com/sota/crowd-counting-on-venice

图片样例找不到、解释也找不到

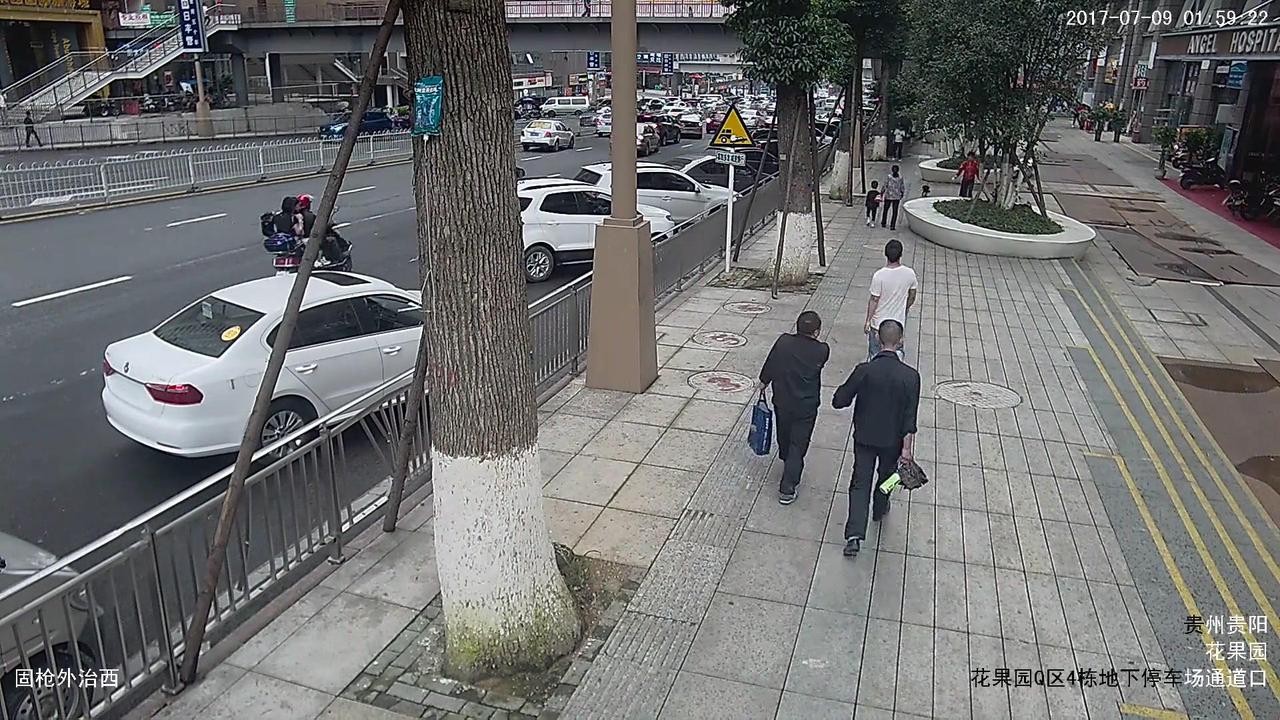

威尼斯一个广场顶上(同一个位置)摄像头拍下的视频,从视频中取出的照片,照片是连续的

人在哪里有,有的多少个人、annotation,作者用mat文件存储的

2019_CityStreet

Multi-View Crowd Counting Dataset

http://visal.cs.cityu.edu.hk/research/citystreet/

同一个地方,同一个时间,他用不同位置的摄像头拍同一个地方,得到的图片

2019_Beijing-BRT

the ground-truth locations of the i-th person in this image, where each row is the location[x,y]

公交站台等车的地方,数人的个数

2018_SmartCity

https://paperswithcode.com/dataset/smartcity

首发论文:Crowd counting via scale-adaptive convolutional neural network

50 images in total collected from ten city scenes including office entrance, sidewalk, atrium, shopping mall etc..;特点就是人少: the average number of pedestrians is only 7.4 with minimum being 1 and maximum being 14.

离散的、不相关的图片,不是连续的

2017_CityUHK-X

http://visal.cs.cityu.edu.hk/downloads/#cityuhk-xCityUHK-X: crowd dataset with extrinsic camera parameters

首发论文:2017_Cite=57_Incorporating Side Information by Adaptive Convolution.

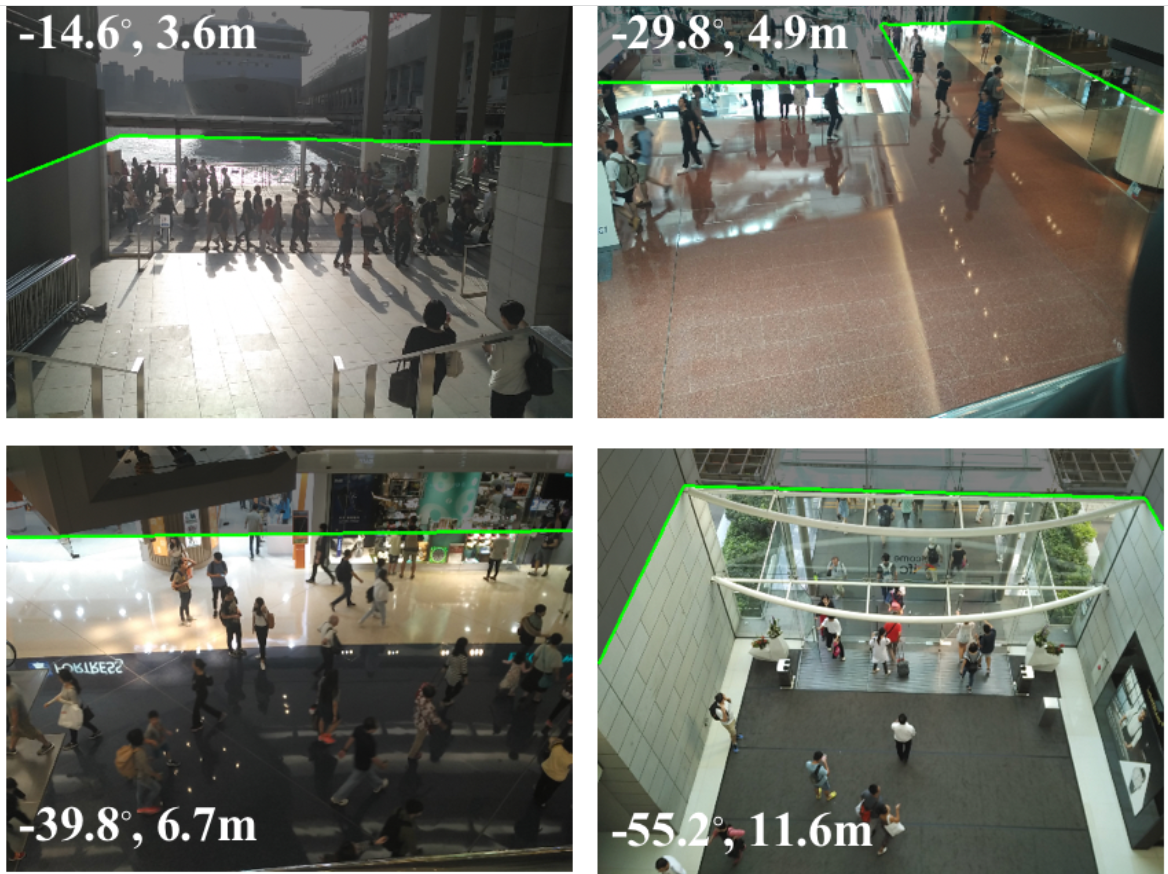

同一个场景里面有一些人,我从不同的高度和角度去拍摄同一个场景、同一个时间,然后做counting

图片的左上角是角度和摄像头的高度

2016_ShanghaiTech Part B

https://www.datafountain.cn/datasets/5670

B部分有716幅取自上海大都市繁华街道的图像,是监控录像

图片和上partA类似‘’

2016_AHU-Crowd

http://cs-chan.com/downloads_crowd_dataset.html;https://drive.google.com/file/d/1pN35I5MmJA4Ase2dZRdcwsFiOM286fXc/view

多个场景下的拥挤人群:pilgrimage, station, marathon, rallies and stadium

Ground truth是txt文件

老套的拥挤图片

(视频)2015_WorldExpo 10

http://www.ee.cuhk.edu.hk/~xgwang/expo.html

首发论文:2015_Zhang_Cite=1148_Cross-scene Crowd Counting via Deep Convolutional Neural Networks

WorldExpo 10数据集[14]由3980 576 × 720个视频帧组成,共有199,923个被标记的行人。它的训练集来自103个场景中的1127个1分钟视频序列,测试集来自5个不同场景中的5个1小时视频序列。每个测试场景包含120帧图像,每帧图像中的个体数在1 - 220之间。

——做的哪种“人流量统计”的任务?有什么特点?

——把拥挤人群用一个多边形标出来,加上颜色,有多少人,它没有标记。 做segmentation的时候总共从图片中分出了这么多个不同拥挤程度的多边形53 637, crowd segments with polygon boundaries

——场景多:cross-scene ;108个场景108 Fixed Scenes上海世博会108个摄像头拍下的监控录像108 surveillance cameras, all from Shanghai 2010 WorldExpo

——有哪些优秀之处?

——场景丰富:这些拥挤人群的场景,马路road,排队queue,广场square,前面几个混合

—— Bounding box标记较多:3,980 annotated frames

(1)是否是类似视频一帧一帧的连续截图:没看原始数据集,不知道

(2)照片中有多少人是否数出来了——没有

(3)他没数出人数,那么我自己人工计数能否数出来?——数不出来,人太多、太密,可以数但是耗时很长、很可能数多了或数少了

(4)是否打了bounding box——打了点表示这是一个人,是在人多的区域画了多边形标注这个地方人多。

(视频)2012_Mall

http://personal.ie.cuhk.edu.hk/~ccloy/downloads_mall_dataset.html

来自公开的网络摄像头collected from a publicly accessible webcam

人的头上都打了十字号

Mall数据集由2000个320 × 230个视频帧组成,包含6000个被标记的行人。通过标记所有帧的行人头部来提供标记个体。与USCD数据集相比,Mall数据集具有更高的人群密度和更丰富的场景。

(视频)2008_UCSD

http://www.svcl.ucsd.edu/projects/peoplecnt/; http://www.svcl.ucsd.edu/projects/peoplecnt/demo.htm

统计了进和出的人,统计了你预测的和实际之间的标准差,红黄绿表示估计的准确程度

UCSD数据集包含一个视频序列中的2000帧,每5帧对应一个ground truth。它是由安装在人行道上的固定摄像机拍摄的,所以场景相对缺乏变化。此外,人行道上的人群密度也存在着从稀疏到拥挤的变化。这个数据集是在人群计数中创建的第一个数据集。由于数据集发布时间较早,数据集存在很多局限性,如图像采集位置单一,场景不可避免的单一。数据分布与许多真实场景不匹配,不适合更一般的应用。

Drone-view

https://github.com/VisDrone/DroneVehicle

2020_DroneVehicle

高空-拍摄汽车的

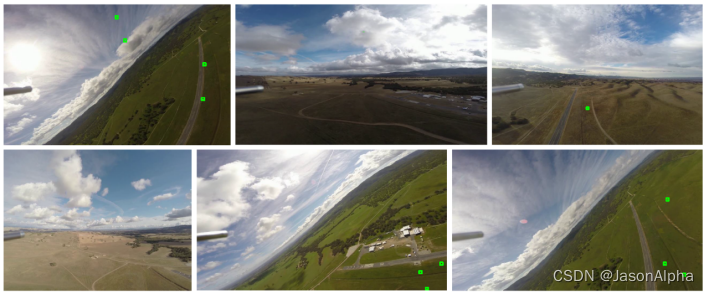

2019_DroneCrowd

天津大学收集的he VisDrone2019 dataset is collected by the AISKYEYE team at Lab of Machine Learning and Data Mining , Tianjin University, China

图片不是连续的video,是毫不相干的一些图片

高空拍摄的人,人的size看着很小

也有size比较大的

2019_DLR-ACD

https://www.dlr.de/eoc/en/desktopdefault.aspx/tabid-12760/22294_read-58354/

It contains 33 large aerial images acquired through 16 different flight campaigns at various mass events and over urban scenes involving crowds, such as sport events, city centers, open-air fairs and festivals.

比较高空拍下的图片。

做的别的任务,可以拿过来做counting的

Caltech Pedestrian识别

Caltech Pedestrian Detection Benchmark: http://www.vision.caltech.edu/Image_Datasets/CaltechPedestrians/

Caltech Pedestrain 数据集由加州理工提供、由固定在在城市环境中常规行驶的车辆上的摄像头采集得到的视频。数据集包含约10小时的 640x480 30Hz 视频,其中标注了约250,000帧(约137分钟的片段)中的350,000个边界框和2300个行人。更多信息可参考:Caltech Pedestrain Detection Benchmark

数据集是视频的,行人都用方框标记出来了

图片来源:Caltech Pedestrian Detection Benchmark

CityPersons-识别

CityPersons: https://github.com/cvgroup-njust/CityPersons

CityPersons 数据集是基于CityScapes数据集在行人检测领域专门建立的数据集,它选取了CityScapes 中5000张精标图片,并对其中的行人进行边界框标注。其中训练集包含2975张图片,验证集包含500张,测试集包含1575张。图片中行人的平均数量为7人,标注提供全身标注和可视区域标注。更多信息可参考:CityPersons

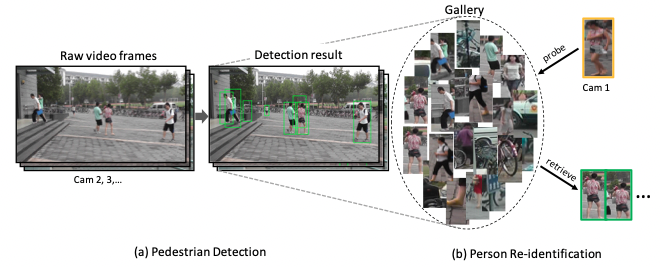

CUHK-SYSU识别

CUHK-SYSU: http://www.ee.cuhk.edu.hk/~xgwang/PS/dataset.html

CUHK-SYSU 是一个大规模的人员搜索基准数据集,包含18184张图像和8432个行人,以及99,809个标注好的边界框。根据图像来源,数据集可分为在街道场景下采集和影视剧中采集两部分。在街道场景下,图像通过手持摄像机采集,包含数百个场景,并尝试尽可能的包含不同的视角、光线、分辨率、遮挡和背景等。另一部分数据集采集自影视剧,因为它们可以提供更加多样化的场景和更具挑战性的视角。

该数据集为行人检测和人员重识别提供注释。每个查询人会出现在至少两个图像中,并且每个图像可包含多个查询人和更多的其他人员。数据集被划分为训练集和测试集。训练集包含11206张图片和5532个查询人,测试集包含6978张图片和2900个查询人。更多信息可参考:End-to-End Deep Learning for Person Search

PRW识别+counting

PRW: https://github.com/liangzheng06/PRW-baseline

PRW (Person Re-identification in the Wild) 是一个人员重识别数据集。该数据集采集于清华大学,通过六个摄像机,采集共10小时的视频。数据集被分为训练、验证和测试集。训练集包含5134帧和482个ID,验证集共570帧和482个ID,测试集则包含6112帧和450个ID。做了counting:每帧中出现的所有行人都会被标注边界框,同时分配一个ID。更多信息可参考:PRW

ETHZ-识别

ETHZ: https://data.vision.ee.ethz.ch/cvl/aess/dataset/

ETHZ 数据集---是视频---由一对车载的AVT Marlins F033C摄像头拍摄采集,分辨率为 640x480,帧率为13-14 fps。数据集给出原始图像、标定信息和行人标注信息。更多信息可参考:ETHZ

MOT16-行人的识别和追踪

MOT16: https://motchallenge.net/data/MOT16/

MOT17: https://motchallenge.net/data/MOT17/

MOT16数据集是在2016年提出的用于衡量多目标跟踪检测和跟踪方法标准的数据集,专门用于行人跟踪。其主要标注目标为移动或静止的行人与行进中的车辆。MOT16基于MOT15添加了更细化的标注和更多的边界框,它拥有更加丰富的画面、不同拍摄视角及不同的天气情况。MOT16数据集共有14个视频,其中7个为带有标注的训练集,7个为测试集。它因为提供了标注好的检测结果,因此可以免去目标检测部分,更加关注在目标跟踪部分。更多信息可参考:MOT16

Head Tracking 21

-

Head Tracking 21: https://motchallenge.net/data/Head_Tracking_21

CrowdHuman

http://www.crowdhuman.org/

没有用的东西

都是做识别、追踪、计数的优质论文-数据集可用、解决问题的思路可以参考

(2)无人机拍摄,目标检测识别人和车

VisDrone2018-test-dev

2018_Zhu_Cite=94_VisDrone-DET2018: The Vision Meets Drone Object Detection in Image Challenge Results (这篇文章里汇总了很多现存数据集)

http://aiskyeye.com/

——做的哪种“人流量统计”的任务?有什么特点?

——识别出行人pedestrian,汽车car,摩托车摩托车,三轮车,给object打方框

——使用的数据集名字是什么(如果开源)?有哪些优秀之处?

——场景:traffic senario也有,运动场也有,高空图像也有,低空图像也有

——数据集的照片长什么样?给个样例

object已经用方框标好了,人数需要你自己去数;是否是连续的图片,不知道

(1)计object个数(object/pedestrian/crowd counting)(2)追踪(3)去重chong

(1)无人机追踪车和人

2020_Li_Cite=173_AutoTrack: Towards High-Performance Visual Tracking for UAV With Automatic Spatio-Temporal Regularization

——做的哪种“人流量统计”的任务?

—— 追踪无人机、车、人tracking drone, people and cars,

——使用的数据集名字是什么(如果开源)?有哪些优秀之处?

——DTB70

——多种场景、无人机大小和旋转角度不同various cluttered scenesand objects with different sizes as well as aspect ratios are included.

——高速运动的时候拍下的这些照片,图片是很糊的,识别和追踪起来就困难,primarily addresses the problem of severe UAV motion.

——视频片段多composed of 70 difficult UAV image sequences,

——annotation多:manually annotated the ground-truth bounding boxes in all video frames.

(1)是否是类似视频一帧一帧的连续截图——大概率是

(2)照片中有多少人是否数出来了——没有

(3)他没数出人数,那么我自己人工计数能否数出来?——可以数出,图太糊了,稍微有点难

(4)是否打了bounding box——给的示例,一张图中打了一个方框,我不知道真实的数据集一张图打几个方框

(5)和“人流量统计”任务的相同在哪?——连续照片、有重复的object出现

(6)和“人流量统计”任务的不同在哪?——有点糊,其他都很好

——数据集的照片长什么样?给个样例

追踪人,只是标了一个

追踪无人机

农业场景,养的牛羊,数数

追踪在海上冲浪的人,看看有多少个

篮球场多少个人在打球,

(1)无人机目标追踪

UAV123@10fps

2016_Mueller_Cite=1100_A Benchmark and Simulator for UAV Tracking

无人机拍摄出的图片的数据集,知乎一个人汇总的很好:https://zhuanlan.zhihu.com/p/421968291(还有这些目标追踪数据集:OTB50, OTB100, VOT2014,VOT2015, TC128, and ALOV300++)

——做的哪种“人流量统计”的任务?有什么特点?

——目标检测,object画方框

——使用的数据集名字是什么(如果开源)?有哪些优秀之处?

——场景:各种场景都有

——任务:目标检测,画方框,把bike,building,car,truck,person,wakeboard水上滑板,UAV,boat船

(1)是否是类似视频一帧一帧的连续截图——没看原文,不知道

(2)照片中有多少人是否数出来了——没有

(3)他没数出人数,那么我自己人工计数能否数出来?——可以数出

(4)是否打了bounding box——不确定

——数据集的照片长什么样?给个样例

(-1)用无人机去数车辆

2020_Yang_Cite=77_Reverse Perspective Network for Perspective-Aware Object Counting

UAV-based Vehicle Counting Dataset

——做的哪种“人流量统计”的任务?有什么特点?

Vehicle Couting Task数的东西不是无人机就是汽车没看原文具体不知道

——使用的数据集名字是什么(if open resources)?有哪些优秀之处?

数据是自己收集的,不是公开数据集800张照片

场景丰富:50 different scenarios for vehicle counting

标记更详细-Precise annotations:manually annotated with 32,770 bounding boxes,用的不是那种粗略的点标记instead of traditional point annotations

拍摄图片的角度perspectives多,front-view in high latitude, front-view in low latitude, side-view, and topview.

在不同天气收集了图片,in different weather conditions,sunny, raining, fog,night, and raining night(做上面这些的目的:increase the diversity of the dataset and make it closer to the real traffic circumstances.)

frame是指的bounding box

(1)是否是类似视频一帧一帧的连续截图——不好说,有很大可能不是连续的(连续的两张差异很小的图片放进去是没有多大意义的)

(2)照片中有多少人是否数出来了——没有

(3)他没数出人数,那么我自己人工计数能否数出来?——人工数出来难度比较大,因为车比较密集

(4)是否打了bounding box——打出了

(6)和“人流量统计”任务的不同在哪?——(1)图像是高空图像,人流量统计是地面摄像机录像(2)地面的人看起来比较大,这个里面的车都太小了

(-1)用无人机从照片中识别无人机

2021_Ashraf_Cite=11_Dogfight: Detecting Drones from Drones Videos

——做的哪种“人流量统计”的任务?有什么特点?

——把图片中的无人机找到,并标个方框

——使用的数据集名字是什么(如果开源)?有哪些优秀之处?

——NPS-Drones,美国海军收集的published by Naval Postgraduate School (NPS)

—— 用肉眼,即使你把图片全屏,也很难找无人机的位置。所以这个应用场景是很有价值的。因为人做不了这个事

——难点:来源和目标无人机的不稳定运动、小尺寸、任意形状、大强度变化和遮挡使得该任务具有相当的挑战性

——视频较多contains 50 videos

——清晰度高that were recorded at HD resolutions(1920×1080 and 1280×760)

——object的大小变动大,The minimum,average and maximum size of drones are 10 × 8, 16.2 ×11.6, and 65 × 21, respectively.

——annotation多:The total number of frames in the dataset are 70250.

——你使用的模型是什么?执行流程是什么?有哪些组件,每个组件起什么作用?

——数据集的照片长什么样?给个样例

(1)是否是类似视频一帧一帧的连续截图——大概率是连续视频的一帧帧截图

(2)照片中有多少人是否数出来了——没有,可以数bounding box的数量

(3)他没数出人数,那么我自己人工计数能否数出来?——可以数出来,一张图只有不到10个bounding box.

(4)是否打了bounding box——有

(5)和“人流量统计”任务的相同在哪?——是连续的视频截图,几张图有重复的无人机出现(有去重这个需求),能数出个数

(6)和“人流量统计”任务的不同在哪?——(1)物体过于小,人流统计的人都是比较大的甚至可以看清脸,但是无人机长相都基本相同,看不清无人的细节,去重这一块很困难(2)摄像头是随着所在的那个无人机飞的,不是定在一个地方蹲点看今天过去了多少架飞机

(-1)用无人机做目标检测与追踪

UAVDT

The Unmanned Aerial Vehicle Benchmark: Object Detection and Tracking", European Conference on Computer Vision (ECCV),

https://sites.google.com/view/grli-uavdt/%E9%A6%96%E9%A1%B5

——做的哪种“人流量统计”的任务?有什么特点?

——录像中,人和车的目标检测,把这些object用方框标出来

——使用的数据集名字是什么(如果开源)?有哪些优秀之处?

——场景比较多、比较复杂complex ,emphasizes vehicle tracking in various scenarios.这样做的目的是提高模型泛化性,使得我的模型不仅仅适用于traffic senario-大马路上,也能到森林公园里用,到海滨浴场用

——下这些条件都很多变动:Weather condition, flying altitude and camera view 有14个场景变动因素。up to 14 kinds of attributes (e.g., weather condition, flying altitude, camera view, vehicle category, and occlusion

——高速运动的时候拍下的照片,很糊,camera motion

——里面的object很密,high density

——里面的object很小small object

——Selected from 10 hours raw videos,

——about 80, 000 representative frames are fully annotated with bounding boxes

(1)是否是类似视频一帧一帧的连续截图——大概率是

(2)照片中有多少人是否数出来了——应该是没有

(3)他没数出人数,那么我自己人工计数能否数出来?——可以做,费眼睛、费时间

(4)是否打了bounding box——打了

(5)和“人流量统计”任务的相同在哪?——不想解释

(6)和“人流量统计”任务的不同在哪?——不想解释

——数据集的照片长什么样?给个样例

右下角标记了senario,白天还是晚上,天气怎么样?有没有frog雾、下没下雨rain,视角是front view还是side view,高度是特别高还是中等还是低

目标检测,小汽车 car和公交车 bus都标出来了

(-1)用无人机做识别、追踪、计数

2020_Wen_Cite=21Detection, Tracking, and Counting Meets Drones in Crowds: A Benchmark

https://github.com/VisDrone/DroneCrowd

(梳理了存在的,人群识别和计数的数据集);作者称这是迄今为止最大的数据集,其中包含了用于密度图估计、人群定位和无人机跟踪的头部标注轨迹。

——做的哪种“人流量统计”的任务?有什么特点?

——(1)数人数Crowd counting and 估计密度density map estimation

——(2)拥挤人群的定位和追踪.

——使用的数据集名字是什么(如果开源)?有哪些优秀之处?

——wide range of scenarios, e.g., campus, street cameras,park, parking lot, playground and plaza

——自己收集的,用drone-mounted安装好的cameras收集的。

——Annotation很多,清晰度很高:The videos are recorded at 25 frames per seconds (FPS) with a resolution of 1920×1080 pixels.

——照片中有人很多的,也有人很少的:The maximal and minimal numbers of people in each video frame are 455 and 25 respectively。and the average number of objects is 144.8.

——标记量巨大:more than 20 thousands of head trajectories of people are annotated with more than 4.8 million head points in individual frames of 112 video

——质量很高、成本很高,20个行业专家复核了annotation2个月才搞定:Over 20 domain experts annotate and double-check the dataset using the vatic software for more than two months clips.数据量大,质量高。

(1)是否是类似视频一帧一帧的连续截图——应该是

(2)照片中有多少人是否数出来了——可能有

(3)他没数出人数,那么我自己人工计数能否数出来?——人太多几乎数不出来

(4)是否打了bounding box——没有

(5)和“人流量统计”任务的相同在哪?——不想解释

(6)和“人流量统计”任务的不同在哪?——人过于密集,是高空拍下的图像

——数据集的照片长什么样?给个样例

(1)无人机识别人类行为

2021_Li_Cite=47_UAV-Human: A Large Benchmark for Human Behavior Understanding with Unmanned Aerial Vehicles

——做的哪种“人流量统计”的任务?有什么特点?

——识别人类的行为,并将人类的行为进行分类

——使用的数据集名字是什么(如果开源)?有哪些优秀之处?

——UAV-Human Dataset

——场景:它由一架飞行的无人机在三个月内的白天和夜晚在多个城市和农村地区收集的

——任务:动作识别、姿势估计、对无人机图像的人类行为进行理解解析,分类出图片中人是在干什么?握手,锁车...

——包含 67,428 个多模式视频序列和

——119 个用于动作识别的目标,22,476 帧用于姿势估计,41,290 帧和 1,144个 用于人员重识别的身份,以及 22,263 帧用于属性识别

——涵盖了广泛的多样性,包括对象、背景、光照、天气、遮挡、相机运动和无人机飞行姿态

(1)是否是类似视频一帧一帧的连续截图——大概率不是

(2)照片中有多少人是否数出来了——没有

(3)他没数出人数,那么我自己人工计数能否数出来?——可以数出,毕竟人很少

(4)是否打了bounding box——没有

——数据集的照片长什么样?给个样例