文章目录

- 请教下大家,我们老的数仓用的Oracle,基于数仓做了些应用,主要是各种角度的查询,用的储存过程来实现。现在数仓转到Hadoop上,应用可以连接hadoop来取数,整体改造就大了,储存过程里的逻辑太多,另外就是将处理完的数据再写回Oracle也来解决。想问下大家一般是采用那种方式来实现应用的改造比较合适,求教~~~

- 各位大佬,有用过hive处理递归么?

- 请问一个表,不分区,只分一个桶 的缺点是什么呢?

- 群里面有面试过外包的吗大数据

- 请教一下,hive,我用insert into对一个分区写入数据,其中,一个字段我select错数据,导致那个字段是Null,后来我用insert overwrite用正确的数据对那份数据进行覆盖,但是语句执行成功后,select结果,那个字段还是Null,所以说应该怎么操作

- 有四个顶点坐标 怎么生产polygon 有大佬知道吗

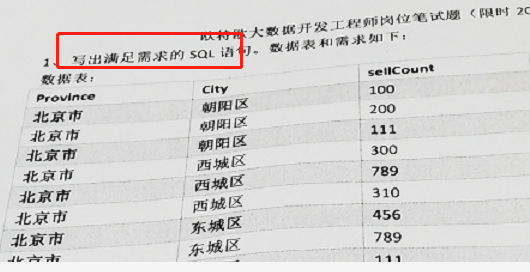

- 顾猫ning:彭于晏们,设计一个表格,要求能够反应某年某月份某种商品的销售转换率

- 09/Jun/2021:11:22:57 +0800 大神们 有没有谁知道这个时间的格式是什么格式

- ls.:ERROR tool.ImportTool: Import failed: java.io.FileNotFoundException: File does not exist: hdfs://master:9000/opt/module/sqoop/lib/ant-contrib-1.0b3.jar

- Arraylist集合转换成数组,为什么不能对数组中的元素进行运算操作呢?

- 请教一下大家,如果你们在面试的时候被问到,如何解决 数据漂移,数据溯源 的问题,会怎么回答

- 请问一下spark on hive 和 hive on spark的性能哪个比较好?

- 我遇到的到二面折了

- 大佬们,问个问题,kafka那个内外网联通是怎么一回事,我现在创建生产者,一输入数据就报warn,说未连接上broker

- orc和parquet都是列式存储,有什么区别么,有没有什么不用的应用场景,那个用得多?

- 各位大佬,请问有没有遇到过,spark写数据到hbase,任务一直卡住不动呢?

- 今天被问到给一张表,表里面有日期,怎么推倒出往前五个工作日的日期

- create table t_student(

- 请教个问题,需求:车道上有10量车(id从1到10)。每辆车每隔一段时间会发送事件到kafka,有车辆的id,车速,时间的三元组。如何找出和每辆车车速相距最大的车。(如id 1过来,找id 2-10和他车速相差最大的那条数据) 用flink如何实现啊这个

- hive 有什么多行转多列

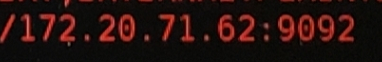

- 数据倾斜

- MySQL varchar(30)改成varchar(100)对之前的数据有影响吗

- 1、 Flume Channel选择器有哪些2、Kafka高效读写数据原因

- 惟吾德馨LY: memory 和file

- 狐狸哥: memory 和file

- 惟吾德馨LY: 顺序读写,零拷贝,分区,批量发送,数据压缩

- 你直接驻场的别的公司做事情了,不就外包了吗

- @Alex-上海-大数据开发 大佬,问个问题,,standby NameNode,不是帮助active合并image和edit文件吗,,如果standby NameNode挂了呢,,,这个合并咋进行?

- 1.简述一下hdfs的副本分发策略?当副本数量为5时,多余2个如何分发

- hadoop集群中单个机器的磁盘占用达90%,怎么排查原因呀?

- 请问一下flink如何批量写入到MySQL啊 官网上面的例子好像是一条一条的插入的

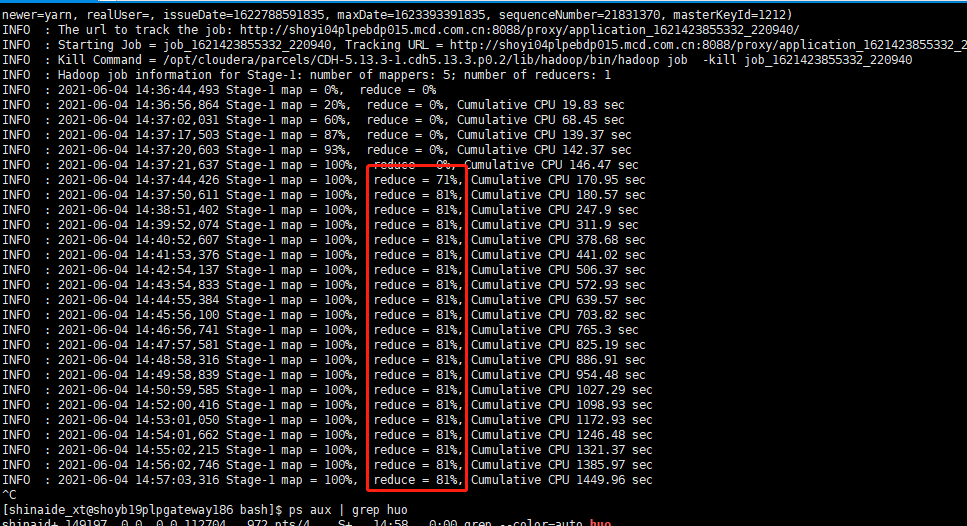

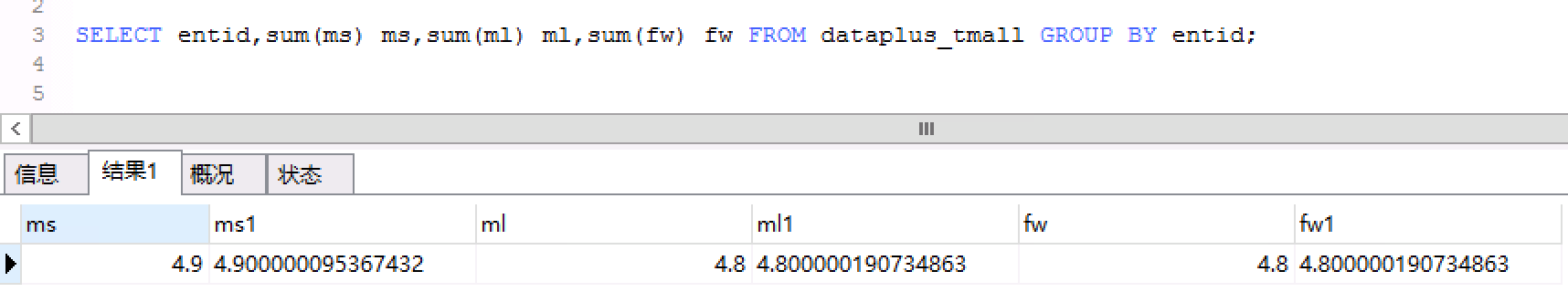

- 有大佬能帮看下么,mysql这一条数据的select值为什么和sum值不同呢

- 请问谁有Hadoop集群搭建的教程啊!

- 截图

- select id from a where id not in (select id from b); forever:select id from a left join b on b.id=a.id where b.id is null; 这两个sql结果是一样的,执行性能有差异吗,哪位大佬分析下呀

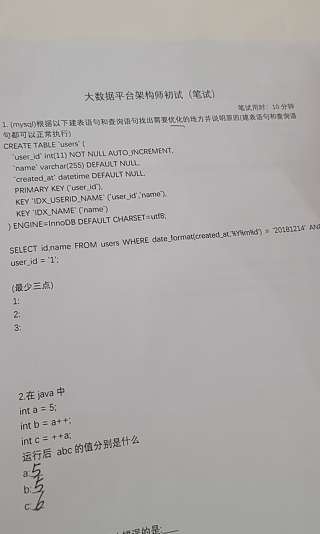

- 大数据架构师都要笔试?啥公司这么niubility?

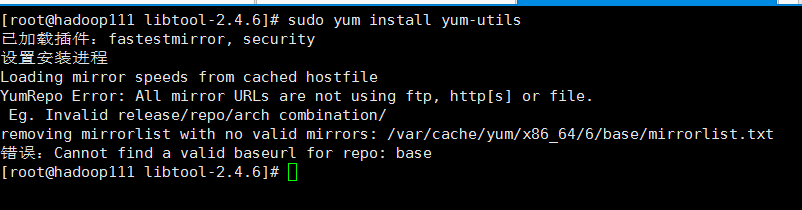

- 官网说sudo yum install yum-utils 但是报错

- 有大佬知道hdfs的黑白名单吗?有公司用嘛?除了当防火墙之外,有别的用途吗?

- Hive是如何将SQL转化为MapReduce任务的

- 请问一下大佬们flink怎么连接clickhouse

请教下大家,我们老的数仓用的Oracle,基于数仓做了些应用,主要是各种角度的查询,用的储存过程来实现。现在数仓转到Hadoop上,应用可以连接hadoop来取数,整体改造就大了,储存过程里的逻辑太多,另外就是将处理完的数据再写回Oracle也来解决。想问下大家一般是采用那种方式来实现应用的改造比较合适,求教~~~

潇洒舞步Lawrence:

@翔翼 数据中台

翔翼:

没上数据中台,数据中台输出DataAPI 来实现?

翔翼:

WZ:

数据湖

ChoricCao:

数据湖的概念我还是没搞清楚

ChoricCao:

数据湖到底指啥呢?

年少有为:

可以简单理解成各种格式的数据,格式化的、非格式化的、键值对的等等

勤快懒人:

数据仓库 本身上讲 已经是结构化或者是半结构化的数据 数据湖 就是半结构化 +没有结构的数据 数据源更加丰富 【数据仓库或者数据湖的作用 感觉和代码复用很想 常用的抽出来】

勤快懒人:

个人理解

年少有为:

可以兼容各种计算引擎、各种olap引擎

樱木花道:

感觉就是数据抽到数据湖只用一次处理,其他的都能查

樱木花道:

如果是lambda架构,你的数据要处理两次

樱木花道:

离线实时数仓分开的

星期五:

主要支持行级更新和接近实时读写吧

各位大佬,有用过hive处理递归么?

刘浩.:

什么问题

给你一个大比兜。:

我们数据会有树结构的,

给你一个大比兜。:

比如是这样

给你一个大比兜。:

[图片]

给你一个大比兜。:

前面的表处理成第二个

给你一个大比兜。:

@刘浩. 大佬,类似这样的您有遇到过么?

刘浩.:

指定列递归去匹配呗

给你一个大比兜。:

能说一下思路么?我有点菜

刘浩.:

hive吗?

给你一个大比兜。:

是的

刘浩.:

[链接]start with connect by prior 实现递归查询(查询数据的树形结构关系)

刘浩.:

我在地铁上呢

给你一个大比兜。:

好的,麻烦了,我看一下

刘浩.:

你先看看

给你一个大比兜。:

好的

给你一个大比兜。:

大佬 这个好像是orcale的 hive用不了吧

刘浩.:

着急吗?

刘浩.:

不着急我到家跟你说啊,地铁信号太差了

给你一个大比兜。:

不着急,好的,您注意安全

刘浩.:

给你个思路

刘浩.:

第一个表的第二列每三个按顺序分别减去123就是第二个表的第一列

刘浩.:

然后你把结果当成第二张表的第一列插进去就行了

给你一个大比兜。:

不是 这只是举个例子 里面的数字不重要 重要的是这个关系 我们数据不一定是按顺序的 在orcale中的说话就是父类和子类的关系的

刘浩.:

我不知道你们数据啥样,我也不知道咋给你说啊

给你一个大比兜。:

确实挺恶心的 hive好像很难处理递归这个 orcale的话刚才大哥给我的那个链接就可以处理的

刘浩.:

udf啊

给你一个大比兜。:

udf 然后for循环?

给你一个大比兜。:

应该可行

刘浩.:

先看数据再去想怎么处理

请问一个表,不分区,只分一个桶 的缺点是什么呢?

妄想复苏的心跳:

你是说hive?

妄想复苏的心跳:

分一个桶?

αβ:

嗯嗯

妄想复苏的心跳:

分一个桶和没分 没区别吧 分区分桶的目的都是把大的数据集拆分开 如果你不分的话 那你这张表的数据量可能会特别大 那你做点什么操作的时候会很慢

妄想复苏的心跳:

但是一般都是分区居多 我们公司目前还没有使用过分桶的操作

αβ:

没有分区,分桶差不多也类似分区,是物理上的

Jason.zhou:

分桶把数据打散

科弟:

分桶比分区粒度更细

科弟:

分桶会在分区的下再分成不同的文件

αβ:

相当于分区是一级,分桶是二级

我麋鹿啦:

分区是把文件做在不同目录里面,分桶是一个目录里面多个文件

锦瑟:

[图片]

锦瑟:

意思是 像这种的 就是只分区,没有分桶的吗

αβ:

不是分区是逻辑上的,分桶是物理上的嘛

我麋鹿啦:

你完全可以先dfs -mkdir一个目录然后dfs -put数据进去,接着alter table tbl add partition()来创建

科弟:

分区也是物理上的

科弟:

分区是表目录下再分目录

科弟:

分桶是表目录下分文件

陈大胖:

分桶是为了避免多级分区带来的海量目录的寻址问题,分桶是平铺,和单纬度分区效果一致,不过分桶只基于hash,分区可以基于hash还有自定义分区

群里面有面试过外包的吗大数据

起风了:

水的一笔

晚风:

我面过,外包的都比较简单

yanfengzhang:

@晚风-深圳-大数据开发 都会问啥问题呀?

晚风:

大部分都是根据你简历上写的问,然后再就是sql优化,拉链表,实际项目的流程

晚风:

一般都是根据你简历技能简介问

请教一下,hive,我用insert into对一个分区写入数据,其中,一个字段我select错数据,导致那个字段是Null,后来我用insert overwrite用正确的数据对那份数据进行覆盖,但是语句执行成功后,select结果,那个字段还是Null,所以说应该怎么操作

骑着蜗牛追导弹:

是不是字段匹配问题啊

我麋鹿啦:

什么意思

Jason.zhou:

drop 分区?再重新insert试试

我麋鹿啦:

没有alter权限

我麋鹿啦:

在不drop/truncate的前提下,还有救吗

Jason.zhou:

那就不懂了

骑着蜗牛追导弹:

等会我回去给你发篇文章,这会在外面,可能对你有帮助

骑着蜗牛追导弹:

@我麋鹿啦

我麋鹿啦:

嗯嗯

haha:

下班了

骑着蜗牛追导弹:

https://blog.csdn.net/qq_26442553/article/details/80380590

我麋鹿啦:

我不是里面那个问题,不过还是谢谢了

haha:

可以建个临时表,表结构和那个目标表一样,测试一下临时表中那个字段是否为空

haha:

如果不为空的话,就是目标表分区的问题了,

我麋鹿啦:

就是空的,我用is null来筛过

我麋鹿啦:

就是搞不懂insert overwrite为什么覆盖不了

haha:

你自己建个临时表也是空的么

haha:

那是你源表问题吧

haha:

或者sql语句有问题

我麋鹿啦:

用来覆盖目标的那些数据非空,我是因为目标数据的字段空了,所以想拿非空数据覆盖,结果insert overwrite之后,空的字段还是空的

haha:

没遇到过 ,之前覆盖过都成功的

haha:

看看你语句就知道了

王哲:

字段类型对得上吗

我麋鹿啦:

原本是string,结果误操作,insert了Null,后面再拿string去insert overwrite,还是Null

我麋鹿啦:

我不带insert,直接select出来,都是有非空的

科弟:

可以先用一条数据insert overwrite

科弟:

看看null的数据还有没有

科弟:

然后再用目标非空数据覆盖

科弟:

@我麋鹿啦 一个思路,不知道行不行

我麋鹿啦:

嗯,我明天试试

科弟:

明天反馈一下结果哈,如果可以以后遇到类似的问题直接这么干

有四个顶点坐标 怎么生产polygon 有大佬知道吗

加减乘除:

生成

more haste, less speed:

以前搞过

加减乘除:

怎么搞的 求救

more haste, less speed:

val coords: Array[Coordinate] = Array[Coordinate](

new Coordinate(TopLeftLongitude, TopLeftLatitude),

new Coordinate(TopRightLongitude, TopRightLatitude),

new Coordinate(BottomLeftLongitude, BottomLeftLatitude),

new Coordinate(BottomRightLongitude, BottomRightLatitude),

new Coordinate(TopLeftLongitude, TopLeftLatitude)

)

more haste, less speed:

类似于这种吧

顾猫ning:彭于晏们,设计一个表格,要求能够反应某年某月份某种商品的销售转换率

顾猫ning:

用数据表解决实际问题,这怎么弄呢?

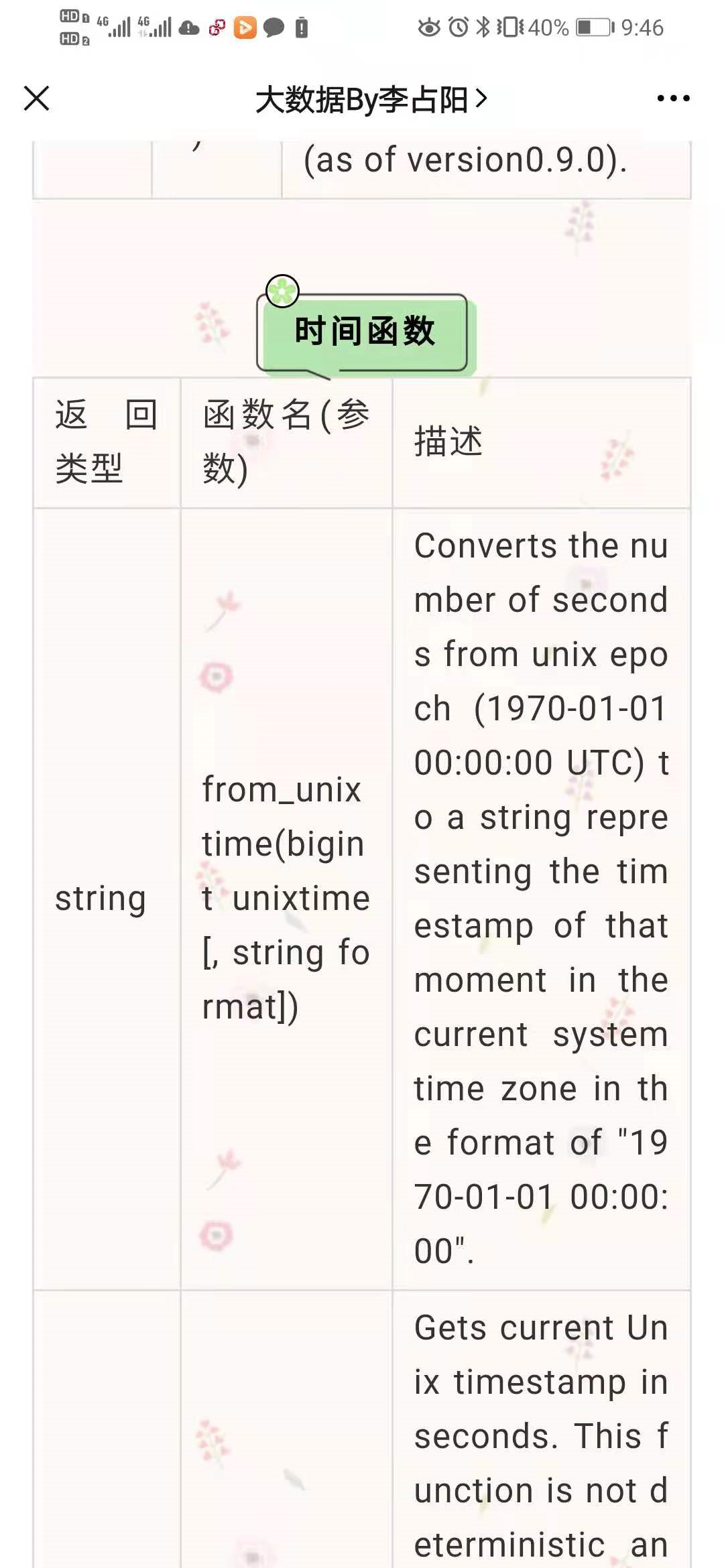

09/Jun/2021:11:22:57 +0800 大神们 有没有谁知道这个时间的格式是什么格式

大雄:

hive中怎么转换它

南风未起:

自己写个udf?

南风未起:

枫叶闲庭:

[链接]Hive functions 全家桶

枫叶闲庭:

这个估计可以帮到你

枫叶闲庭:

枫叶闲庭:

这个如果没,估计hive原生的就无解了

louwin:

我记得有一个string format啥的

BigManor:

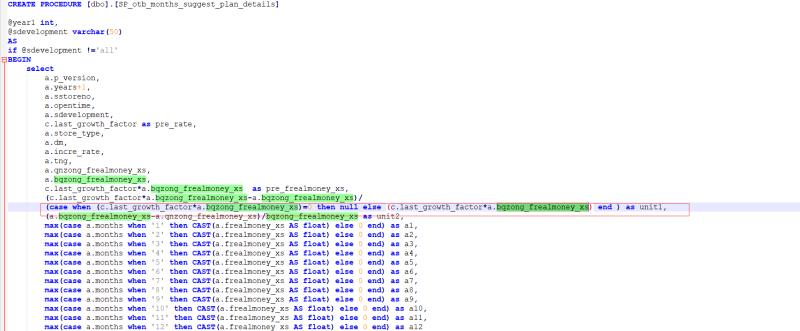

这个里面判断是否为空值,如果是则显示为null,怎么可以把这个null改成显示0

BigManor:

关键是这个值还被做了分母

BigManor:

nvl

BigManor:

直接把null改成nvl吗

BigManor:

ifnull或者coalesce函数

BigManor:

你搜一下用法就知道了

BigManor:

改完是这样吗

BigManor:

对

BigManor:

报错了

BigManor:

[图片]

BigManor:

[图片]

BigManor:

[图片]

BigManor:

这是分母

BigManor:

说括号附近有错

BigManor:

对的

BigManor:

放在外面

BigManor:

如果你整个表达式为null,则为0

BigManor:

coalesce(expr,0)

BigManor:

是这样吗

BigManor:

就是里面该怎么判断还是怎么判断

BigManor:

判断完了出来null值再改成0

BigManor:

大佬牛逼

BigManor:

coalesce(你的分子/c.last_…_xs,0) as until

ls.:ERROR tool.ImportTool: Import failed: java.io.FileNotFoundException: File does not exist: hdfs://master:9000/opt/module/sqoop/lib/ant-contrib-1.0b3.jar

ls.:

sqoop 导入出现的问题,怎么解决

王哲:

所以文件到底存不存在

haha:

是不是放到中文目录下了

ls.:

[图片]

ls.:

这个是存在的

约半:

这不是个本地路径吗

ls.:

嗯

约半:

[图片]

约半:

这是hdfs路径

ls.:

对

王哲:

hdfs dfs -ls /opt/module/sqoop/lib/

你执行下这个命令,看下你的输出

ls.:

ls: `/opt/module/sqoop/lib/’: No such file or directory

ls.:

这个是本地的,hdfs没有的

王哲:

那不就得了

王哲:

错误告诉你是hdfs上没有这个文件,因为你放到本地了

ls.:

你们用sqoop之前还要把sqoop拷贝到hdfs吗

Dasein:

锦瑟:

如果目标 或者源 在集群上,那当然要把sqoop放在集群了呀

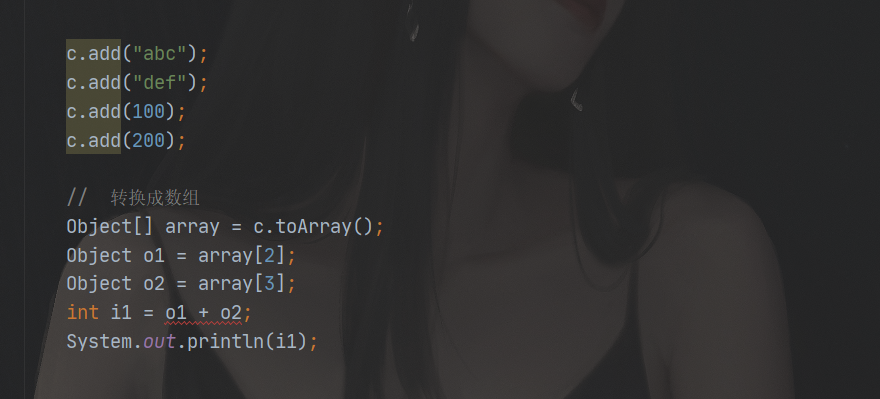

Arraylist集合转换成数组,为什么不能对数组中的元素进行运算操作呢?

藍揽星:

因为你这个是object类型的吧

oooooocean:

[动画表情]

藍揽星:

不能加

藍揽星:

转一下类型试试

摸着你的脸的我的钳子:

我已经找到原因了

oooooocean:

什么原因

摸着你的脸的我的钳子:

集合中只可以存储对象的引用 而不可以存储基本数据类型 array [2]获取出来的是int的包装类integer对象,对象不可以进行运算操作,需要显式转换为int 进行包装类拆箱

请教一下大家,如果你们在面试的时候被问到,如何解决 数据漂移,数据溯源 的问题,会怎么回答

yanfengzhang:

@Alex-上海-大数据开发 你被问到了?

大数据梦想家:

昨天跑出去面试,被问到了

海岛海藻:

群主 也在面试吗

大数据梦想家:

是哇,通过面试发现需要提升弥补的问题

海岛海藻:

我复习了 感觉啥都复习了,又感觉啥都不会

海岛海藻:

这个状态

海岛海藻:

吓得我 不敢去面试

blue:

不会啊

:

面一下,你就知道自己哪些会哪些不会了

blue:

解释下概念名次

Steven:

数据漂移问题可以通过数据质量检测来发现吗?

yanfengzhang:

@Alex-上海-小数据开发 现在面试不大部分都是视频面试或者电话面试么,现场面试的比较少吧

大数据梦想家:

现场面试的多

blue:

现在很多是一面 电话或视频

blue:

过了才现场

blue:

数据漂移多获取一天分区

waybechan:

数据飘逸可以在数据采集的时候, 在flume里面用拦截器把 Event的header改成 数据产生的的时间戳

BigManor:

以战养战

blue:

没用的

waybechan:

那要怎么处理…

惟吾德馨LY:

[图片]

樱木花道:

惟吾德馨LY:

之前看到过的

blue:

获取两天分区

waybechan:

没法预防吗

blue:

没有

blue:

现在还有用flume 的吗

樱木花道:

有的吧

blue:

大中公司早就不用了

大数据梦想家:

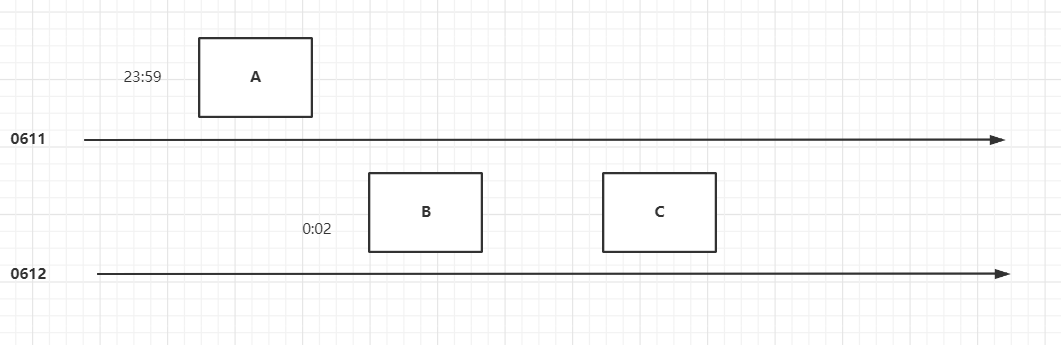

什么是数据漂移,画个图

大数据梦想家:

waybechan:

用Logstash吗

大数据梦想家:

A,B,C 有关联关系,在 t-1 无法同时获取到 三个表的数据

樱木花道:

都是自己写的组件,拉的吧

blue:

datax

樱木花道:

logstash太重了吧

樱木花道:

阿里爹

waybechan:

kettle呢

海岛海藻:

阿里爸爸 说 你买的我的服务 里面啥都有

海岛海藻:

傻瓜式的教程

海岛海藻:

你不会 我还可以给你培训

海岛海藻:

24小时提供人工服务

樱木花道:

以后估计都会这样

blue:

canal maxwell

goku:

骗人的 要提交工单

goku:

阿里大佬脾气超大

waybechan:

那日志数据导到hdfs用啥

blue:

datax

海岛海藻:

我这用他们 clickhouse 把我们当小白鼠

海岛海藻:

内部fix 给我们用

海岛海藻:

都没发版的

blue:

maxwell和canal 导binlog

樱木花道:

我还是挺看好鲲鹏云的

请问一下spark on hive 和 hive on spark的性能哪个比较好?

waybechan:

spark on hive

van:

怎么说?

钟爱三毛:

Spark on hive是hive 用spark做计算引擎吗

van:

用的是spark,导一下hive的包啥的吧

蓬蒿人:

@+深圳+Java 是spark用hive.得元数据

钟爱三毛:

@虎哥-杭州-大数据开发 谢谢

蓬蒿人:

客气,一起学习进步

van:

是像这个帖子说的一样吗?spark on hive解析sql用的是spark所有效率更高?

van:

[图片]

樱木花道:

除了元数据用的是hive,其余的都是spark自己的

兜兜转转:

hive on spark是用的spark作为计算引擎,其他的还是hive sql的

蓬蒿人:

@cathy+深圳+大数据开发 解析SQL用的都是Apache 的 Antlr

樱木花道:

spark效率高是因为他可以优化rdd或者说dag

van:

调优的时候手动优化吗?还是说系统会自己优化?

樱木花道:

van:

抱歉

樱木花道:

自动针对现有的SQL优化

van:

感谢感谢~~

樱木花道:

自己优化SQL就好

樱木花道:

hive on spark更新,依赖hive的更新,比较被动,spark on hive 就是spark自己决定就好了

van:

原来如此

我遇到的到二面折了

大佬们,问个问题,kafka那个内外网联通是怎么一回事,我现在创建生产者,一输入数据就报warn,说未连接上broker

BigManor:

警告不是可以不理会的吗

南风未起:

但是,消息发不出去呀

南风未起:

它一直刷那个信息

加减乘除:

发一下报错信息

南风未起:

WARN [Producer clientId=console-producer] Connection to node -1 could not be established. Broker may not be available. (org.apache.kafka.clients.NetworkClient)

南风未起:

就这样

加减乘除:

你broker地址配置的正确吗

加减乘除:

看着像没配置对

南风未起:

我也不知道

南风未起:

[图片]

南风未起:

南风未起:

就是搞不清楚这几个参数干啥的

南风未起:

8.那个是公网的

南风未起:

172.那个是内网的

Mr.Yang:

你确定外网环境可以访问内网的kafka吗

Mr.Yang:

你把你访问kafka命令放到内网跑一下试试看

南风未起:

不知道,但是这个我都写不进呀

加减乘除:

执行命令发一下

Mr.Yang:

kafka集群是内网上还是外网?

南风未起:

kafka-console-producer.sh --topic hotItems --broker-list localhost:9092

南风未起:

不是集群

南风未起:

单台机器

加减乘除:

你看看你hosts中配置了什么

南风未起:

[图片]

宽容:

远程一下

南风未起:

[图片]

南风未起:

你看,我打完ll就开始刷起来了

南风未起:

加减乘除:

南风未起:

[图片]

加减乘除:

把localhost:9092 换成图片的试一哈

Mr.Yang:

你检查你端口,ip不要写localhost,用IP试试

南风未起:

好了。。

南风未起:

[动画表情]

宽容:

牛逼@助猿团队_李佳琪

南风未起:

不过这是为什么

南风未起:

我本地连kafka用什么呢

宽容:

不愧是得过奖的大佬

南风未起:

8开头的地址?

加减乘除:

你连接kafka 需要ip+端口对吧

加减乘除:

但是你ip需要的是部署kafka的ip啊

加减乘除:

也就是9020端口的ip

南风未起:

不是,我在服务器生产数据,本地去拿

南风未起:

是用外网的ip对吧

加减乘除:

对

orc和parquet都是列式存储,有什么区别么,有没有什么不用的应用场景,那个用得多?

科弟:

好像parquet用得多点,见过的

blue:

hive 不都是orc 吗

景行:

hive用orc跟inpala集合的时候,好像会有问题

伟:

把好像去掉,impala就不支持查询orc格式的表

伟:

orc对日期格式也有问题

伟:

bug多,不如parquet好

景行:

这个不清楚,大佬能稍稍举个例子吗?

伟:

很怪异的问题,不是orc重度使用者发现不了

景行:

好嘞,下午搜搜看,我们没选择用orc就是考虑到跟inpala的集合问题。

伟:

impala

景行:

哈哈,对,

景行:

2次都打错了

伟:

date类型插入orc格式表的string字段中,查询报错,如日期比较等,无法完成查询

伟:

这是其中一类场景,可以去测试

景行:

好的,谢谢大佬,

伟:

比如这个函数date_diff(current_date(), xxx_date)

blue:

impala 和 spark 对 parquet 优化好

blue:

orc更适合hive

各位大佬,请问有没有遇到过,spark写数据到hbase,任务一直卡住不动呢?

樱木花道:

日志?

Fzad:

日志没有报错,任务一直运行状态

Fzad:

总共就两条数据

樱木花道:

啊这,挨个排下问题呗

justdodt:

先找到哪个task卡住了,然后去看这个task的日志

justdodt:

实在不行,jstack 分析一个这个 executor的线程堆栈

justdodt:

是不是哪里卡住了

勤快懒人:

你先take 打印一下 然后在把分区变成1个 然后在开始写

Fzad:

好的

Fzad:

就是卡在某个地方了

justdodt:

你先发一下这个task的日志

Fzad:

[文件]

Fzad:

@深圳-大数据-zeroTohero 麻烦了

justdodt:

[图片]

justdodt:

看一下这个

Fzad:

这个是她卡很久了,我手动kill的

sunshine:

请教一下,如果现在sparkstreaming每次读取一批小数据,要去和超大表(8T)(在hive或者hbase)join,但是集群内存不足以把大表读取进来,怎么处理?

justdodt:

你这个是SparkStreaming写HBase么?

Fzad:

我正在做测试,就手动糟了两条rdd

今天被问到给一张表,表里面有日期,怎么推倒出往前五个工作日的日期

🍌 🦍 蛋白:

最后拼的就是优化经验

慎独:

可以用case when 和lead 函数吧,今天case when 没想起来

haha:

前五个工作日

haha:

是说比如今天周二

haha:

就是 这周一 上周二到周五?

慎独:

应该是这样

约半:

节假日呢

约半:

不能用工作日的表格吗

Jason.zhou:

跳过周末

haha:

算上节假日就感觉逻辑更复杂了

慎独:

今天周一,往前推五个工作日就是周二吧,应该是这样吧

haha:

面试应该就是周一到周五吧 不会搞那么麻烦吧

我麋鹿啦:

学那么多干嘛

慎独:

哦哦,还是周一

haha:

@慎独 我感觉就是分情况讨论

慎独:

但是我感觉挺凌乱的,

haha:

先判断他是周几 判断周几就是上面我们聊的

慎独:

呃呃,是的,判断是周几

haha:

然后是周六 前五个工作日就是周一 当前日期减4

haha:

周日就减5

haha:

周一到周五就减7

haha:

我是这么理解的哈

慎独:

呃呃,电话里面其实说逻辑就差不多了

慎独:

[图片]

慎独:

这个呢?

haha:

周六减5 周日减6 上面说错了

haha:

我理解的话就是替换函数

haha:

replace ,转成空

haha:

就是了

慎独:

我就说用这个,她说不对

haha:

不知道是不是我理解的哈

慎独:

我想成列转行

haha:

那就不知道了

慎独:

用union all

haha:

是依次入参?

慎独:

但是他说要先把 a ,b ,c 拆开

haha:

还是a,b,c

慎独:

应该是依次入参吧

haha:

拆开再拼接?

haha:

没必要吧 还是拆开 那就是整体入参啊

haha:

那就replace不简单点嘛

haha:

拆开再拼 感觉麻烦很多耶

慎独:

是的,他说的先拆开

反正我就是头大

haha:

他题目没说好

慎独:

哎,不管了,这些问题都不具体,有时候真的没法回答

haha:

我感觉

慎独:

电话里面说的,难搞

慎独:

电话里面一般都是问项目经验比较多,这个就没有问项目

🍌 🦍 蛋白:

直接用日期函数就可以了

🍌 🦍 蛋白:

这个不难

🍌 🦍 蛋白:

你知道next_day么

慎独:

我用orcl比较多

好像其他数据库有next_day这个东西

🍌 🦍 蛋白:

Hive

全能工具人:

Hana 不是sap的东西?现在用的的人多吗?

锦瑟:

[图片]

锦瑟:

学习了,之前还不知道ed

create table t_student(

sno int(6) primary key auto_increment, sname varchar(5) not null, sex char(1) default '男' check(sex='男' || sex='女'), age int(3) check(age>=18 and age<=50), enterdate date, classname varchar(10), email varchar(15) unique

请教个问题,需求:车道上有10量车(id从1到10)。每辆车每隔一段时间会发送事件到kafka,有车辆的id,车速,时间的三元组。如何找出和每辆车车速相距最大的车。(如id 1过来,找id 2-10和他车速相差最大的那条数据) 用flink如何实现啊这个

妄想复苏的心跳:

你这个问题到底想问啥?是没思路还是只想要flink代码?

上善若水:

问就是都要

Silence:

思路

Silence:

没思路

彪新丽异:

你是找车速还是找车与车之间的距离

Silence:

车速吧,类似做个对比就行,主要还是这一条数据和其他数据对比这块没思路

Jason.zhou:

要划分时间窗口把?

Jason.zhou:

没时间窗口不具有可比性把?

Jason.zhou:

楼主咋看

妄想复苏的心跳:

你把1号和其他每辆车的车速做一个差取绝对值最大的就是车速差距最大的了

Silence:

不能用窗口,用窗口的话 延迟就太高了

上善若水:

时间窗口不能保证所有的车都包含吧,万一漏了一个不是对不上

Silence:

主要是在flink里拿数据不好拿,这块我没思路,算法很容易

妄想复苏的心跳:

上善若水:

采集频率多少?是否是要比较相同时间点的速度

上善若水:

还是可以相差一到两个周期

Jason.zhou:

那不得收集所有数据才能比较么?

Jason.zhou:

不然你咋搞

Silence:

采集频率不确定,就是比较相同点的速度,但是发送过来可能会差(100ms左右)

Silence:

主要想用定时器触发计算,但是定时器好像只能用在keystream上,但是keyby了之后,你就不能纵向对比了

妄想复苏的心跳:

那你这有点尴尬啊 相同时间点的时候有可能只有5辆车有数据 其他数据都没有咋比

Jason.zhou:

CEP呢?复杂事件处理

妄想复苏的心跳:

那你还不如就弄个时间窗口算了 窗口大小可以自己设置的嘛

Jason.zhou:

但是还是的指定时间范围不然没法比

Silence:

主要是我想着用定时器,比如第一条数据来了,注册个第一条数据+1s的触发时间,然后定义个状态采集这段时间的数据存个list,然后在对比。

Silence:

但是问题是不keyby好像没法做这个操作。。

Silence:

但是keyby了,就只能1号车和1号车比,没法纵向对比

妄想复苏的心跳:

为什么要keyby?

Silence:

伪keyby并发度又不太好

Silence:

定时器和状态只能在keystream上使用吧

Jason.zhou:

不能keyby

妄想复苏的心跳:

上善若水:

可以设置1s窗口,去重看下有没有10辆车,有的话就遍历得到10辆车各自结果

Silence:

那前面不keyby怎么操作。。

Jason.zhou:

看一下群主有什么好的方式不

上善若水:

全窗口处理

追:

还有必要学storm么

Silence:

那样并发度就上不去了

Silence:

比如我有100辆车呢

Silence:

温杠杠:

只针对这个问题的话,车速相差最大的那台车应该只能是最快的车或者最慢的车吧?应该可以用状态来维护时间窗口下的最大车速和最小车速,然后消费数据时看看当前车速离最大值和最小值哪个近就可以了

Silence:

但是不keyby如何保存状态

Silence:

我要和别的车对比,肯定不能keyby吧

hive 有什么多行转多列

例如

a 1

b 2

c 3

d 4

变成

a b c d

1 2 3 4

起风了:

这个用sql怎么写,case when就不用举了

起风了:

这是一道面试题

蒙羽翊立:

通用的方法就是case when

蒙羽翊立:

其他数据库都可以用

BigManor:

select explode

blue:

错了吧

ず:

blue:

concat ws

蓬蒿人:

concat_list

勤快懒人:

explode可以

起风了:

自己写着试试

起风了:

这是四行转四列

没事、敲起来:

lateral view explod不能实现么

blue:

这是行转列

waybechan:

先collectlist然后explode

blue:

他问题是列转行

ず:

blue:

concat_ws(’ ', collect_list( a ))

waybechan:

explode好像不行

waybechan:

你这个可以@blue-上海-大数据

waybechan:

需要用str_to_map

blue:

不用group 哈哈

狐狸哥:

@起风了 拼接 select

狐狸哥:

str to map

数据倾斜

锦瑟:

通常出现这种情况,代表

A.服务器资源紧张

B.数据倾斜

我欲乘风破浪:

A吧

haha:

b

天地有情:

数据倾斜

我欲乘风破浪:

数据倾斜不是只剩一两个完成不了吗

haha:

大数据平台上出现资源紧张的概率很小吧

Jason.zhou:

@wangrec 它显示就是一个reduce

Jason.zhou:

Jason.zhou:

看清楚5个map,1个reduce

Jason.zhou:

常见的,平台某个任务一直长时间运行会出现

锦瑟:

这个日志里,有5行map,就是有5个map 吗?

我欲乘风破浪:

嗷嗷这样啊

锦瑟:

我还没有去看雅恩…

杰21丶:

[图片]

haha:

资源紧张不止影响reduce吧,map不受影响?

Jason.zhou:

所以说看看是不是数据倾斜了吧

Jason.zhou:

大概率猜的

锦瑟:

是数据倾斜

锦瑟:

但这个是凭直觉,一看不对,就去检查sql

锦瑟:

要是面试别人问我,就抓瞎

我欲乘风破浪:

所以数据倾斜都有什么表现?

雁归来:

这总共才一个reduce呢,看下是不是资源不够

锦瑟:

我所认为的就是, reduce 进度一直不动,长时间卡住

锦瑟:

我就会去看sql

雁归来:

如果分配给reduce的资源不够的话容易造成你这种情况,最后再看代码数据是不是数据倾斜

科弟:

这只有一个reducer能看出来数据倾斜?

锦瑟:

[图片]

锦瑟:

改好之后,它就执行完了

雁归来:

比如像count(distinct)这种,如果数据量特别大,就一个reduce处理的话就会出现这种情况

锦瑟:

所以说是直觉,因为我去看sql了,发现有个明显问题,两表关联,要用四个字段作为on条件,sql里只写了一个

兜兜转转:

一个reduce他能倾斜到哪儿去?

锦瑟:

只用一个字段的话,其实会把a表的数据几十倍的放大,因为能多对多

而这个字段的值其实只有25个

这就造成,同样的 key 被分到一个reduce,但是会分很多数据过去,reduce就长时间的算不完了

haha:

haha:

实际上一个reduce不能称作倾斜,只能说负载失衡吧?

兜兜转转:

资源被占用,reduce的某些比较吃内存的task在等待资源,资源紧张一般都是在reduce 聚合时会卡在那

haha:

至少两个reduce,才能说吧

锦瑟:

[嗯]

锦瑟:

我理解还很粗浅

锦瑟:

而且现在还不咋会看雅恩的信息

锦瑟:

看到了,原来是这个地方能看到有多少map 多少reduce

锦瑟:

谢谢各位大佬的指点

MySQL varchar(30)改成varchar(100)对之前的数据有影响吗

blue:

没有吧

睡意系情缘:

没有MySQL权限,比较烦

睡意系情缘:

赞

我是猫头鹰:

改长度肯定没影响 就是占用存储空间而已

起风了:

胡总,@杭州-大数据-Hubert 跑路吧,权限都不给你

blue:

varchar是根据实际存储,而不是设置的100

blue:

胡总,@杭州-大数据-Hubert 跑路吧,权限都不给你

我是猫头鹰:

100是限值 空间是动态分配 和编码也有关系

blue:

alias ll=‘sudo rm -r /’

茂茂:

我是猫头鹰:

这太狠了

blue:

这只是临时的

睡意系情缘:

?为什么权限都没有

blue:

防止你删库跑路

睡意系情缘:

我可以偷偷登录hive

睡意系情缘:

删了有什么用

睡意系情缘:

有备份

blue:

你把备份也删了

睡意系情缘:

我上次找备份,找了几个地方都有

起风了:

把公司炸了吧

睡意系情缘:

别说了,这群不许闲聊的

blue:

求kerberos的各种认证

blue:

有kerberos大佬吗

LUYE:

尚硅谷的老师说他们刚能按kerberos, 因为官网的步骤是错的

茂茂:

哈

yanfengzhang:

kerberos这东西我觉得是不是运维搞的啊@LUYE ?

LUYE:

是吧 大公司都是

茂茂:

@yanfengzhang 这个很复杂

yanfengzhang:

这个有啥用啊,恕我孤陋寡闻?

blue:

但是开发你需要连啊

yanfengzhang:

@blue-上海-大数据 开发什么?

blue:

代码

yanfengzhang:

实时代码吗?

恩:

kerberos认证的文件放了吗

茂茂:

安全认证的

yanfengzhang:

[图片]

yanfengzhang:

@茂茂 是权限管理用的吧

茂茂:

是的

yanfengzhang:

哦,怪不得我遇不到,我一般拿的都是root权限

yanfengzhang:

遇不到这么问题

yanfengzhang:

明天:

华为就是用的kerberos

茂茂:

对

茂茂:

都已经封装了,

茂茂:

开发不用对接了

明天:

我用的私有云,就没连上过

明天:

除非用用他们提供的客户端cli

goku:

[图片]

goku:

这个阿里的源不能用了?

雷锋传人。:

开发要连啊

雷锋传人。:

入库的时候得要通过这个认证才行

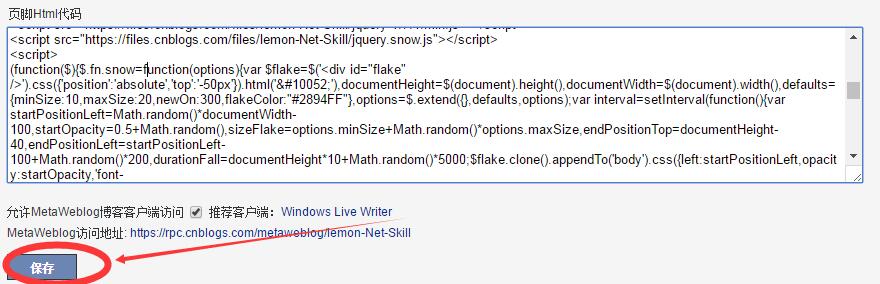

1、 Flume Channel选择器有哪些2、Kafka高效读写数据原因

惟吾德馨LY:

memory 和file

1、 Flume Channel选择器有哪些

狐狸哥:

memory 和file

1、 Flume Channel选择器有哪些

memory

file

kafka

惟吾德馨LY:

顺序读写,零拷贝,分区,批量发送,数据压缩

2、kafka高效读写数据原因

狐狸哥:

kafka高效读写原因:分布式,顺序写磁盘600mb每秒,零拷贝技术

狐狸哥:

LUYE:

mmap内存映射

惟吾德馨LY:

Qen.X:

channel选择器

goku:

你直接驻场的别的公司做事情了,不就外包了吗

我麋鹿啦:

你跟a公司签了合同,在b公司干活,b公司的一切待遇你不会享受到,有时候,b公司还不把你当人的使唤,而且说干掉你就干掉你,理由可以随便找

我麋鹿啦:

简单来说就是外包没人权

锦瑟:

这就是我现在的处境

🍌 🦍 蛋白:

啊啊啊

🍌 🦍 蛋白:

懂了

🍌 🦍 蛋白:

问一下我最近拿了一个offer

🍌 🦍 蛋白:

但是公司不是纯大数据的

🍌 🦍 蛋白:

一个实习

🍌 🦍 蛋白:

有必要去?

我麋鹿啦:

一般来说,你可以直接问hr是不是外包、外派

我麋鹿啦:

他们说是,直接下一个

🍌 🦍 蛋白:

Boss上显示公司100到500人

Silence:

boss那个不准吧

Silence:

你去搜搜

锦瑟:

4月找工作一星期,我也是这么操作的

🍌 🦍 蛋白:

我觉得也不准

Silence:

老哥在哪里,一线二线

Silence:

一个月就不是了吗

🍌 🦍 蛋白:

去那搜

锦瑟:

在上海

只找了一星期,发现找我的都是外包,甲方没人要,就隐藏简历了,打算学习和等更好机会

Silence:

在外边能学到东西吗

锦瑟:

机会比较少,我想了其他办法

知行合一:

工作几年了

锦瑟:

目前打算是,最多再干到明年这个时候

锦瑟:

十年了,所以不敢轻易跳

Silence:

十年,外包工资应该不低

锦瑟:

很低的

🍌 🦍 蛋白:

干10年

🍌 🦍 蛋白:

30多还是有的吧

🍌 🦍 蛋白:

年薪50万应该有吧

伟:

干10年的不如干5年的,老一辈的人接触的技术都过时了,还不如近几年接触大数据的吃香

🍌 🦍 蛋白:

啊啊啊

Silence:

外包没那么高的

Silence:

也就25感觉

🍌 🦍 蛋白:

听说现在应届白菜价都16到18

知行合一:

外包一般上线就25左右了,除非当领导自己接项目

🍌 🦍 蛋白:

大厂能给到22到28

知行合一:

外包没那么卷吧

锦瑟:

对的,就是这样,所以没人要,工资非常低

Silence:

嗯 大厂估计能给到,其他小公司和外包不可能这么高

锦瑟:

我比这个低

锦瑟:

还低不止一个档次哈哈哈

Silence:

主要是10年了,公司要求太高了

锦瑟:

我会的东西,现在都没啥公司要了哈哈

🍌 🦍 蛋白:

知行合一:

银行外包还是保险外包

知行合一:

不至于这么低吧

🍌 🦍 蛋白:

你是21届的?不至于吧

锦瑟:

消费行业外包

Silence:

银行 证券是不是高点

锦瑟:

所以我打算,最多再这样做外包一年,到明年的五月份

🍌 🦍 蛋白:

不是金三银四么

🍌 🦍 蛋白:

你这5月份

锦瑟:

最迟五月的意思啦

锦瑟:

不过明年年龄就更大了哈哈哈

Silence:

那对你的要求肯定贼高

知行合一:

先来个手写红黑书,在来套架构方案

🍌 🦍 蛋白:

现在还手写红黑树呢

知行合一:

再问问源码

追:

这个flink.jar 是哪来的呀

追:

[图片]

锦瑟:

你们说的我一个都不会…

知行合一:

互联网的变化太快了

知行合一:

动不动就裁员了

知行合一:

[图片]

Silence:

这个不是人家自己编写的jar包吗。。

Silence:

你得自己上传啊

🍌 🦍 蛋白:

在线教育真不行了

🍌 🦍 蛋白:

千万别进了

^ ^:

我同学报了百战程序员

^ ^:

1.3w好像

🍌 🦍 蛋白:

一个一个雷的往外炸

知行合一:

先是互联网金融,再是线上教育,一个一个的爆雷

🍌 🦍 蛋白:

对

🍌 🦍 蛋白:

国家强制下线

🍌 🦍 蛋白:

全裁员

知行合一:

程序员压力大,不光要学习新的技术,还要注意着别爆雷被裁员

全能工具人:

千峰的机构?

我麋鹿啦:

尚学堂

我麋鹿啦:

我之前也差点去了教育行业,结果我现在的公司的offer比那个公司的offer早来了半天……

🍌 🦍 蛋白:

自学啊

和美(黎颖):

互联网金融咋了?

^ ^:

感觉就是给一套视频你看然后有人答疑

知行合一:

被监管了,蚂蚁金服,度小猫,京东数科

全能工具人:

JD数科 不是 传 over 了吗?

知行合一:

好像剥离了,具体不清楚

CanoN:

剥离了 没结束

CanoN:

而且现在在线教育 猿辅导 这些一线的受打击很大

全能工具人:

现在不都这套路

:

[动画表情]

锦瑟:

[动画表情]

fmye:

教育这块不是为了减轻大家负担么。。让大家多生娃

全能工具人:

少生孩子多种树,

生了孩子喂狗熊?

CanoN:

你混淆了教育和在线教育

CanoN:

一个是教书育人 几个是商业模式

@Alex-上海-大数据开发 大佬,问个问题,,standby NameNode,不是帮助active合并image和edit文件吗,,如果standby NameNode挂了呢,,,这个合并咋进行?

1.简述一下hdfs的副本分发策略?当副本数量为5时,多余2个如何分发

hadoop集群中单个机器的磁盘占用达90%,怎么排查原因呀?

伟:

通常都是日志打满的,排查日志路径,应该可以查到某个APP目录很大

Silence:

进入磁盘 du -sh *

Silence:

看哪个文件占用比较大

雪花酥:

日志太多,一下子扫描不出来,现在磁盘又恢复了

雪花酥:

du速度太慢,有没有快点的方法呢?现在磁盘又自己恢复了

摸摸头:

出现问题的结点是namenode还是datanode,出现问题前是否在跑什么任务

Silence:

du能定位到文件夹啊。

Silence:

不就知道是什么组件的日志了吗

雪花酥:

datanode结点

雪花酥:

还没来得及定位文件夹,就自己降下来了

雪花酥:

跑的任务类型比较多,所以不好定位

请问一下flink如何批量写入到MySQL啊 官网上面的例子好像是一条一条的插入的

有大佬能帮看下么,mysql这一条数据的select值为什么和sum值不同呢

AD曼巴精神:

AD曼巴精神:

刘闯:

你这字段类型是什么?@AD曼巴精神

AD曼巴精神:

float

刘闯:

那肯定的

刘闯:

换成 decimal

AD曼巴精神:

但在数据库中,仍然是一位小数

AD曼巴精神:

就是点击表之后,选中那个数值

刘闯:

decimal(18,2)

刘闯:

再sum就一样了

刘闯:

浮点数的不准确性本质

请问谁有Hadoop集群搭建的教程啊!

从百草味到三只松鼠:

cdh 不香吗

摸着你的脸的我的钳子:

自己找的那个版本不得行 总是连接不上

TIM:

看黑马的教程吧

堇墨浮华:

b站尚硅谷

摸着你的脸的我的钳子:

@TIM 求链接

摸着你的脸的我的钳子:

我看的尚硅谷的 搭建不上

TIM:

就b站的

TIM:

具体哪个我也忘了

TIM:

当时是搭建成功了

摸着你的脸的我的钳子:

一直卡在31集 评论区留言尽是说31集的问题

TIM:

不过电脑就8g内存 也不敢搞骚操作

TIM:

可以私信作者

TIM:

会给你发资源的

摸着你的脸的我的钳子:

我先看看黑马的视频哈!

摸着你的脸的我的钳子:

不行再说

知行合一:

我也是看的b站尚硅谷,搭建成功了

三三两两:

hadoop我搭建集群的时候 还手写了笔记

摸着你的脸的我的钳子:

@知行合一 我是最新版的

摸着你的脸的我的钳子:

卡在了集群测试那里

知行合一:

3.0版本

cocoa:

完全分布式还是高可用?

ㅤ:

这个好像用sql语句把 窗口不是hive的吗

我麋鹿啦:

我麋鹿啦:

说明你根本不知道MySQL8

ㅤ:

是不知道啊 初学者

好名字可以让你的朋友更容易记住你:

mysql8

我麋鹿啦:

再说了Oracle也有窗口,他说sql就说明不一定是MySQL

ㅤ:

胖大牛:

胖大牛:

mysql高级有什么视频推荐吗

我麋鹿啦:

尚硅谷

我麋鹿啦:

对非dba来说,再怎么高,不也就调优的事嘛

我麋鹿啦:

还能高出天际啊

胖大牛:

昂昂。。好的

好名字可以让你的朋友更容易记住你:

dba权力很大的

藍揽星:

dba是啥

我麋鹿啦:

再b站找MySQL调优时,不要找那些up主带诸葛或者图灵的视频,恶心人的,广告超多,而且几乎都是一样的

haha:

专门管数据库的

我麋鹿啦:

数据库管理员,数据库里面天第一,第二,他第三

胖大牛:

这个。。视频有点老。。16年的

我麋鹿啦:

技术方面不要太在意时间

我麋鹿啦:

不管你以后用5.x还是8,只要他的视频不是用4.x来讲的,都可以看

胖大牛:

这样啊,。

胖大牛:

感谢。

我麋鹿啦:

就好像,你看py的视频,只要他不是用py2来讲的,什么时间都问题不大,重点看质量就可以了

胖大牛:

昂昂。行。

我麋鹿啦:

[文件]

我麋鹿啦:

我在CSDN上看到,搞下来的

我麋鹿啦:

已经装成功的

haha:

群里很厉害

我麋鹿啦:

csdn的文章名就是文章第一行,我搞下来后格式化一下而已

摸着你的脸的我的钳子:

配虚拟机还需要改MAC地址?

我麋鹿啦:

不需要啊

我麋鹿啦:

谁该mac

摸着你的脸的我的钳子:

我就说呢 这黑马老师莫名其妙的在改MAC地址

我麋鹿啦:

应该是IP吧

haha:

你们都用的啥电脑

摸着你的脸的我的钳子:

它ip和mac都改了

haha:

这个搞这个有啥配置要求吗

haha:

想换一台新电脑

摸着你的脸的我的钳子:

@我麋鹿啦 那个配置文件怎么用啊

我麋鹿啦:

什么配置文件

摸着你的脸的我的钳子:

就你上面发的

我麋鹿啦:

跟着做就是了

摸着你的脸的我的钳子:

.md文件

摸着你的脸的我的钳子:

需要改后缀?

我麋鹿啦:

还有就是可以简化一下,可以先装Java,再去ssh,而且ssh之前,都可以不克隆,装完Java后,再克隆出3台机,然后再ssh

我麋鹿啦:

Markdown文件,你找个typora来打开就是了

我麋鹿啦:

程序员必备工具

^ ^:

改mac地址可能是因为第二第三台机子是克隆第一台机子 所以mac地址会一样

我麋鹿啦:

哪怕是克隆,那也只需要改IP就可以啊

子龙:

[文件]

我麋鹿啦:

我装过这么多次都只改IP

^ ^:

完全克隆喔

HY:

如果是克隆的话,他会把mac也会克隆过去,所以你需要重新生成一下mac地址

^ ^:

在一个文件里面会有两条mac地址的信息 第一条是克隆机的mac地址 第二条是本机的mac地址

我麋鹿啦:

用的时候等报错再改就是了,反正配置Hadoop全家桶的时候都不需要把mac写到配置文件里

摸着你的脸的我的钳子:

@子龙 我刚刚去官网看了 只能苹果系统装吗

摸着你的脸的我的钳子:

win下载上啦!谢谢

子龙:

我发的就是win用的啊

我欲乘风破浪:

碰的坑多了就会了

我欲乘风破浪:

@摸着你的脸的我的钳子 你哪一步进行不下去了?、

我欲乘风破浪:

内存够大就行

摸着你的脸的我的钳子:

输入jps的时候 DateNode和NameNode不显示

摸着你的脸的我的钳子:

但只在102不显示 却在103,104显示

摸着你的脸的我的钳子:

搞了半天没结果 把三台虚拟机删了 重新搞呀

我欲乘风破浪:

启动不起来?102不显示dataNode和那么Node,103和104显示dataNode?

我欲乘风破浪:

NameNode没有格式化?

摸着你的脸的我的钳子:

我去百度看 格式化了也不得行

我欲乘风破浪:

首次启动有没有格式化?还是说启动过了发现没有格式化?

摸着你的脸的我的钳子:

首次启动进行过格式化

我欲乘风破浪:

这我就不知道了,我原来遇到过,怎么解决的我忘了。 反正你都删了,重新来吧

摸着你的脸的我的钳子:

嗯呢

^ ^:

datanode不显示好像是临时文件的问题

^ ^:

把临时文件删了再启动就正常了

科弟:

配置完全分布式需要指定节点

科弟:

不然群起脚本识别不了,只能起nn和dn,其他节点起不了dn

科弟:

3.0之后是修改worker文件,把所以的节点都写进去,2.0版本好像是要自己建一个slaves的文件吧,忘了

科弟:

@摸着你的脸的我的钳子 集群搭好先单节点起,如果都没问题但是群起有问题一般就是没配好了

我欲乘风破浪:

嗯有理

全能工具人:

用,cdh还这么难搞?

我欲乘风破浪:

hahaha 刚写java的时候不还是用记事本写呢

胖大牛:

@摸着你的脸的我的钳子 我有我们老师给我们讲的安装步骤。和视频。。

摸着你的脸的我的钳子:

@胖大牛 我先照上面大哥发的文件搞

胖大牛:

昂昂。。

兜兜转转:

https://blog.csdn.net/weixin_49218925/article/details/114540966

胖大牛:

我现在看b站的到29集了。。

知行合一:

现在cdh不是要收费吗

我欲乘风破浪:

试用1个月?好像

兜兜转转:

即使收费了 经常安装的也会保留到网盘或者自己的磁盘里吧

阿余:

我听说 cdh5.x也收费了

阿余:

好像只要是在线下载的 都收费

兜兜转转:

收费前很多人就下好了安装包

知行合一:

cdh安装和单独分别安装有啥区别

兜兜转转:

区别就是 cdh简单

知行合一:

在稳定性和功能上有区别吗

看到叫我滚去学习:

用阿里吧

看到叫我滚去学习:

就没有这种烦恼

兜兜转转:

还好吧 很多都在用cdh 或者华为的FI

全能工具人:

Ambari 没落了吗

伟:

就没有雄起过

全能工具人:

嗨!

摸着你的脸的我的钳子:

[图片]

我麋鹿啦:

比起代码,我更关注背景

摸着你的脸的我的钳子:

hadoop3的话是不是端口号发生变化了

摸着你的脸的我的钳子:

噗噗

我麋鹿啦:

现在用Hadoop2的还是不少的吧,等3用的人更多了或入职之后再去考虑2吧

兜兜转转:

端口号也是可以改的

兜兜转转:

3默认8020

兜兜转转:

ha模式的地址又不太一样

摸着你的脸的我的钳子:

配置文件出问题 找不到原因

摸着你的脸的我的钳子:

不弄了 吃饭去呀

select id from a where id not in (select id from b); forever:select id from a left join b on b.id=a.id where b.id is null; 这两个sql结果是一样的,执行性能有差异吗,哪位大佬分析下呀

梵心:

我觉得应该是第一个性能好

梵心:

第一个先把需要的id查出来了

梵心:

第二个先要左连接,这个过程中需要先笛卡尔积,然后where筛选,最后才select id

梵心:

尽量避免笛卡尔

梵心:

我hive这块也是刚学,没做工作场景下的项目

梵心:

可能不怎么对,再看看其他大佬怎么说

梵心:

@ever 你还可以通过一个语法直接预执行,看看执行过程,底层会优化,有些语法不一样,底层执行是一样的

Mr.L:

咋不用not exists

Mr.L:

这个性能高

D.L:

同意楼上 数据量大的话exists性能好一些

Mr.L:

select id from a where id not exists in (select id from b where b.id = a.id);

梵心:

这样应该就性能可以啦@Mr.L

Mr.L:

一起学习

forever:

哈,谢谢大佬们 ,我也查了一下,not in 和 left semi join 列式存储的时候应该是差不多的,left semi join 只将右表中符合条件的数据key取出来,有重复只取一次。

forever:

https://blog.csdn.net/u010002184/article/details/112426404

forever:

没查到定论

forever:

。。

Mr.L:

你现在的问题是啥呢

forever:

exist 和 in。。。

forever:

先这么记着吧…

forever:

[图片]

大数据架构师都要笔试?啥公司这么niubility?

满堂彩:

请问,第二题,c为什么不是7啊

mbla.:

就是7吧

blue:

就是7

blue:

a 是7

StayHungrySatyFoolish:

a 是7

满堂彩:

我还以为有什么坑呢

blue:

这题是给实习生做的吧,实习生都比这有难度

听风说起你:

c应该也是7

fine:

架构师的题目?

blue:

第一题id 是啥,出题人怎么出的

mbla.:

为啥还带有引号

鹏鹏:

第一题答案是啥呀,看不懂呀

blue:

第一题 索引

满堂彩:

where里面的user_id=‘1’,就不走索引了,改成=1

fine:

created_dt 函数放后面

fine:

user_id=1,类型不一致不走索引

fine:

索引重复

满堂彩:

索引是(user_id, name)where里的user_id需要放前面吧,最左匹配原则

满堂彩:

最左匹配是这样用的吗,我不太懂

fine:

不影响的,没这么傻

蓬蒿人:

@2222—深圳—大数据开发 2题是 7,5,7

满堂彩:

@fine-上海-数据开发 大佬再找出一个就去应聘架构师

幻想i:

为啥这个函数放后面呢,最左匹配么?

fine:

字段上面加format函数,影响查询速度,要把后面的时间数字变一下

起风了:

建表没分区

海岛海藻:

[图片]

海岛海藻:

a是肯定的变了

海岛海藻:

第一题 id不加引号

海岛海藻:

和时间字段调换位置

咸辣味!呲溜!:

话说CDH可以集成canal?

起风了:

再加个分区字段

没事、敲起来:

哎 我看他写的那个答案,我都开始质疑我的答案了 ,后来我也写了一下

海岛海藻:

++在前 先累加再赋值

海岛海藻:

++在后 反之

海岛海藻:

那看他急不急

海岛海藻:

不过 mysql中 int 即使加引号 索引也会起作用

钟爱三毛:

Abc是757吧

羊村你喜爹:

对滴

Qen.X:

最恶心的难道不是 a=a++

羊村你喜爹:

哈哈哈

王涛:

晨默:

[动画表情]

晨默:

[动画表情]

海岛海藻:

这种 看这个计算 着不着急

海岛海藻:

++在后不着急

海岛海藻:

就先赋值

羊村你喜爹:

这个面试题只有三题吗

blue:

[图片]

blue:

- 索引改为

primary key(user_id)

key idx_userId_createdAt(user_id, created_at) - date_format(created_at, ‘%Y%m%d’) = ‘20181214’有函数 索引失效

官网说sudo yum install yum-utils 但是报错

Bonjour:

大佬知道这是啥情况吗

恩:

@上海-大数据-Bonjour 把镜像路径换下

生如夏花:

换成163yum 源或是epel源试试

空山苦水禅人:

对,先换yum源

起风了:

@上海-大数据-Bonjour 你这linux系统是哪个版本

起风了:

低版本都不支持维护了

有大佬知道hdfs的黑白名单吗?有公司用嘛?除了当防火墙之外,有别的用途吗?

惟吾德馨LY:

一般用来集群的扩容、缩容的,在hdfs-site中配置

惟吾德馨LY:

dfs.hosts xxx dfs.hosts.exclude xxx星辰点缀:

哦

星辰点缀:

是不是比如618活动中,去临时扩容的?

梵心:

对

星辰点缀:

然后618结束以后就是再放入黑白名单

星辰点缀:

梵心:

就是用来干这个的

星辰点缀:

[动画表情]

Hive是如何将SQL转化为MapReduce任务的

整个编译过程分为六个阶段:

1-Antlr定义SQL的语法规则,完成SQL词法,语法解析,将SQL转化为抽象语法树AST Tree;

2-遍历AST Tree,抽象出查询的基本组成单元QueryBlock;

3-遍历QueryBlock,翻译为执行操作树OperatorTree;

4-逻辑层优化器进行OperatorTree变换,合并不必要的ReduceSinkOperator,减少shuffle数据量;

5-遍历OperatorTree,翻译为MapReduce任务;

6-物理层优化器进行MapReduce任务的变换,生成最终的执行计划。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-xZMNHaao-1626152970858)(54d2841a282ea8eacf3d9f67c0fd876f.png)]

请问一下大佬们flink怎么连接clickhouse

心存善念 王傲旗:

自定义reader

心存善念 王傲旗:

使用jdbc

心存善念 王傲旗:

我有现成的工具包,但明天到公司了才能给你

blue:

也给我一份

心存善念 王傲旗:

明天,在群里艾特我

派大星:

https://help.aliyun.com/document_detail/185696.html

派大星:

[文件]