网页爬虫作为获取网络数据的重要工具,其效率和性能直接影响到数据获取的速度和质量。Crawler4j作为一个强大的Java库,专门用于网页爬取,提供了丰富的功能来帮助开发者高效地抓取网页内容。本文将探讨如何利用Crawler4j进行多线程网页抓取,以及如何通过代码实现这一过程。

多线程抓取的重要性

在进行网页抓取时,单线程爬虫可能会遇到效率低下的问题,尤其是在面对需要抓取大量页面的网站时。多线程抓取可以显著提高爬虫的工作效率,因为它允许同时向多个网页发送请求,从而减少了总体的抓取时间。此外,多线程还可以提高爬虫的鲁棒性,即使某个线程因为某些原因失败,其他线程仍然可以继续工作。

Crawler4j简介

Crawler4j是一个开源的网页爬虫库,它允许开发者以最小的代码量来创建功能强大的爬虫。它支持多线程抓取,可以自定义抓取策略,如抓取深度、抓取间隔等。Crawler4j还提供了代理支持,这对于需要绕过IP限制的爬虫来说非常有用。

实现多线程网页抓取

要使用Crawler4j进行多线程网页抓取,我们需要创建一个继承自WebCrawler的类,并重写其visit方法来处理每个抓取到的页面。然后,我们可以通过创建多个爬虫实例来实现多线程抓取。

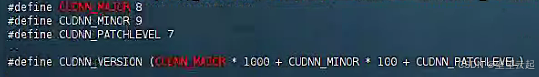

以下是一个简单的示例代码,展示了如何使用Crawler4j进行多线程网页抓取:

import com.github.crawler4j.core.CrawlConfig;

import com.github.crawler4j.core.Crawler;

import com.github.crawler4j.core.CrawlerFactory;

import com.github.crawler4j.core.web.CrawlData;

import com.github.crawler4j.core.web.Page;

import com.github.crawler4j.core.web.WebCrawler;import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;public class MultiThreadCrawler extends WebCrawler {private final static int THREAD_COUNT = 5; // 定义线程数@Overridepublic void visit(Page page, CrawlData crawlData) {String url = page.getWebURL().getURL();String content = page.getText();System.out.println("URL: " + url);System.out.println("Content: " + content);}public static void main(String[] args) throws Exception {CrawlConfig config = new CrawlConfig();// 设置代理信息config.setProxyHost("www.16yun.cn");config.setProxyPort(5445);config.setProxyUser("16QMSOML");config.setProxyPass("280651");config.setCrawlStorageFolder("/path/to/storage"); // 设置存储路径// 创建线程池ExecutorService threadPool = Executors.newFixedThreadPool(THREAD_COUNT);// 创建并启动爬虫for (int i = 0; i < THREAD_COUNT; i++) {Crawler crawler = new CrawlerFactory(config).createCrawler(MultiThreadCrawler.class);threadPool.submit(crawler);}// 等待所有爬虫完成threadPool.shutdown();}

}

代码解析

在上述代码中,我们首先定义了一个MultiThreadCrawler类,它继承自WebCrawler。在这个类中,我们重写了visit方法,该方法会在每个页面被抓取后被调用。在这个方法中,我们可以处理页面内容,例如打印URL和页面文本。

在main方法中,我们创建了一个CrawlConfig实例来配置爬虫,并设置了存储路径。然后,我们创建了一个固定大小的线程池,大小为THREAD_COUNT,这是我们想要的线程数。

接下来,我们使用CrawlerFactory创建了一个Crawler实例,并将其提交给线程池执行。这样,每个线程都会启动一个爬虫实例,从而实现多线程抓取。

最后,我们调用threadPool.shutdown()来等待所有爬虫完成抓取任务。

注意事项

在使用Crawler4j进行多线程抓取时,需要注意以下几点:

- 抓取策略:合理设置抓取间隔和抓取深度,避免对目标网站造成过大压力。

- 异常处理:在

visit方法中添加异常处理逻辑,以确保爬虫的稳定性。 - 资源管理:确保在爬虫完成后释放所有资源,例如关闭线程池和存储文件。

- 遵守Robots协议:尊重目标网站的Robots协议,合法合规地进行网页抓取。

结论

通过本文的介绍和示例代码,我们可以看到Crawler4j在多线程网页抓取中的应用是高效且灵活的。它不仅提供了强大的功能来支持复杂的抓取任务,还允许开发者通过多线程来提高抓取效率。随着数据科学和大数据分析的不断发展,掌握如何使用Crawler4j进行高效网页抓取将成为一项宝贵的技能。