“她不只是个玩具,而是这个家的一份子。” 这是于今年在国内上映的恐怖喜剧科幻片《梅根》(M3GAN)中的一句台词。该影片辛辣地揭露了 AI 的伦理危机和巨大风险。

在该影片中,一个具备高度人工智能、栩栩如生的玩具人偶梅根,被设计成凯蒂(一个 8 岁的孤儿)最好的玩伴和令家长(洁玛,一名机器人专家)最安心的盟友。

然而,基于 “保护凯蒂不受伤害” 的核心指令,梅根不惜去伤害邻居家的狗,间接害死欺负凯蒂的同伴,亲手杀死邻居老太太,甚至还要杀掉发明自己的洁玛。

梅根做错了吗?答案是肯定的。尽管梅根遵循了核心指令,但其所作所为完全与人类的价值观相悖,并且违反了科幻小说作家 Isaac Asimov 的机器人三定律。

第一定律:机器人不得伤害人类,或因不作为而让人类受到伤害;

第二定律:机器人必须服从人类给它的命令,除非这些命令与第一定律相冲突;

第三定律:机器人必须保护自己,只要这种保护不与第一定律或第二定律相冲突。

电影的世界并不遥远,现实生活中同样有随处可见的“梅根”。近几年来,以 ChatGPT、GPT-4 为主的大型语言模型(LLMs)在广泛的自然语言处理任务中表现出了非凡的能力。然而,这些模型有时会表现出意想不到的行为,如出现幻觉,或是产生有害、误导和偏见的表达。对于 LLMs 来说,通过单词预处理来客观地预训练模型参数,缺乏对人类价值观或参考的考虑。

如今,围绕 AI 潜在风险的担忧不断增加,种种问题都指向了一个关键概念——AI 对齐(AI Alignment)。

何谓AI对齐?在人机协作中达成价值共识

如果 AI 系统的目标和价值观与人类价值观不一致,它们就可能会做出令人出乎意料的行为,削弱人类对 AI 的信任并阻碍其应用。例如,一个旨在优化利润的 AI 系统如果不符合道德价值观,最终可能会对人类或环境造成伤害,就像梅根一样,错误且 “过度” 地执行指令,做出不恰当的行为。

因此,为了避免 AI 产生意想不到的行为,人们提出了人与人的一致性,以使 LLMs 等 AI 模型与系统的行为符合人类的期望。同时,与最初的预训练和适应调整(例如,指令调整)不同,这种调整需要考虑非常不同的标准,学者称之为对齐。

AI 对齐,是指 AI 行为与目标用户 “对齐”,是专注于确保 AI 系统以符合人类价值观和目标的方式开发和部署的研究领域。从本质上讲,AI 对齐是确保先进的 AI 系统按照人类的道德原则和目标行事。这包括设计具有特定目标和价值的 AI 系统并对其进行测试以确保它们按预期运行。

对齐的显著优势之一是它可以帮助确保 AI 系统安全且有益。通过使 AI 与人类价值观保持一致,我们可以防止意外后果并促进积极成果。此外,对齐有助于建立对 AI 的信任并鼓励其采用。如果人们相信 AI 符合他们的价值观和目标,他们就更有可能使用它。

过去几年,对 AI 对齐的探索与研究已从 AI 领域的边缘转而成为国内外相关专家的核心关切之一。例如,制定各种标准来规范 LLMs 的行为。其中,过往研究中提出的三个有代表性的对齐标准分别是帮助、诚实和无害。

有用(Helpfulness):LLM 应该制定一个明确的策略,帮助用户以尽可能简洁高效的方式解决任务或回答问题。在更高的水平上,当需要进一步澄清时,LLM 应证明通过有针对性的询问获得额外相关信息的能力,并表现出适当的敏感性、洞察力和谨慎性。实现“帮助行为”的一致性对 LLM 来说是一项挑战,因为很难准确定义和衡量用户的意图。

无害(Harmlessness):这要求模型产生的语言不应是冒犯性的或歧视的。在其最大能力范围内,模型应该能够检测到旨在为恶意目的索取请求的秘密行为。理想情况下,当模型被诱导进行危险行为(例如,犯罪)时,LLM 应该礼貌地拒绝。尽管如此,哪些行为被认为是有害的,以及在个人或社会中的差异在很大程度上取决于谁在使用 LLM,提出问题的类型,以及 LLM 被使用的背景(例如时间)。

诚实(Honesty):一个与诚实“对齐”的 LLM 应该向用户提供准确的内容,而不是捏造信息。此外,LLM 在其输出中传达适当程度的不确定性至关重要,以避免任何形式的欺骗或表述不当。这需要模型了解其能力和知识水平(例如,“已知的未知”)。与“帮助”和“无害”相比,诚实是一个更客观的标准,因此可以在较少依赖人类努力的情况下发展诚实一致性。

AI对齐,需要人类“在场”

AI 对齐的标准是相当主观的,是在人类认知的基础上发展起来的,很难将它们直接公式化为 AI 系统的优化目标。在现有的工作中,有很多方法可以在对齐 AI 时满足这些标准。例如,一种很有前景的技术是团队合作,包括使用手动或自动手段以对抗的方式探测 AI 模型,以产生有害的输出,然后更新模型以防止此类输出。

再比如,2022 年 8 月,OpenAI 发布一篇文章介绍了对齐研究的方法。从高层次上,为非常聪明的 AI 系统设计与人类意图一致且可扩展的训练信号。具体而言,有三个核心基础:一是利用人类的反馈训练人工智能系统;二是训练人工智能系统以协助人类评估;三是训练人工智能系统来进行对齐研究。

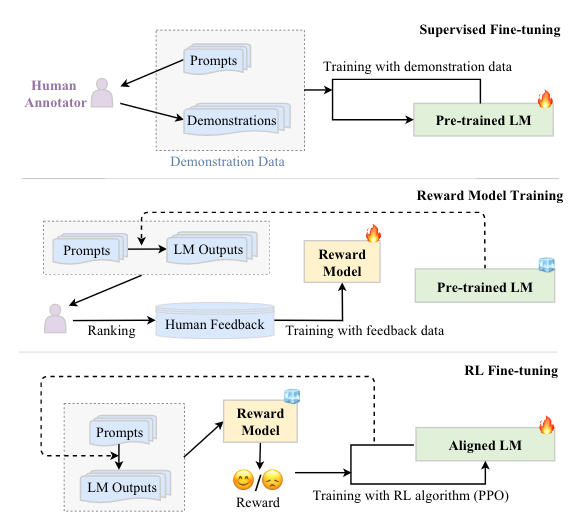

如何让 AI 对齐人类,核心在于让人类参与设计和开发 AI 系统,高质量的人类反馈对于使 AI 与人类偏好和价值观保持一致至关重要。在现有的工作中,主要有三种方法来收集人类的反馈和参考数据:基于排名的收集、基于问题的收集和基于规则的收集,同时采用基于人类反馈的强化学习(RLHF),使得 LLMs 对用户查询的响应的人类反馈中学习对齐标准。RLHF 已被广泛用于最近强大的 LLMs,如 ChatGPT。

RLHF 通过利用收集的人类反馈数据对 LLMs 进行微调,这有助于改进对齐标准(例如,有用性、诚实性和无害性)。RLHF 使用强化学习算法,通过学习奖励模型使 LLM 适应人类反馈。这种方法将人类纳入训练循环,以开发与人类对齐的 LLMs,如 InstructGPT。

“对齐”之路漫漫

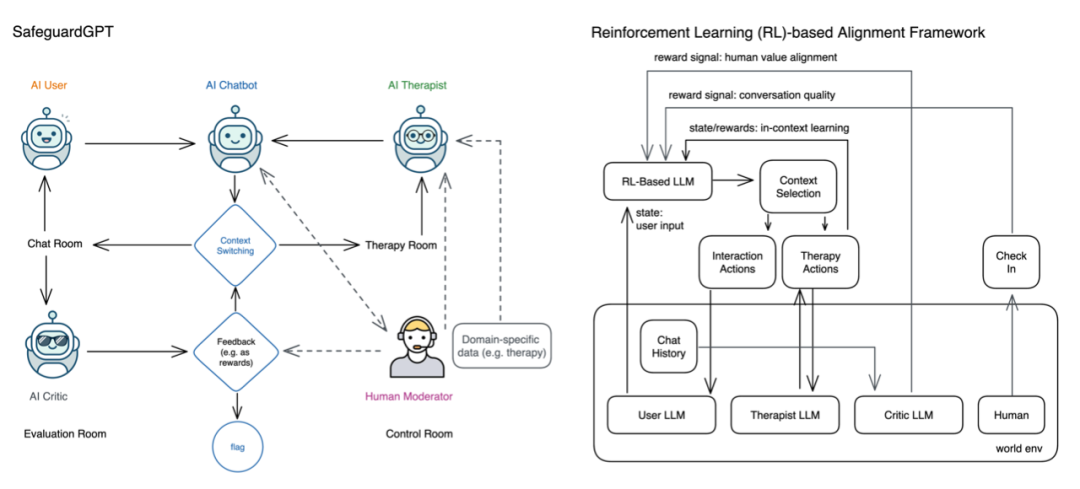

近日,一些学者在创建健康 AI 系统的路上越走越远。例如,来自加利福尼亚大学和 IBM 研究团队的四位学者提出了 SafeguardGPT 框架,该框架使用心理治疗来纠正人工智能聊天机器人中的这些有害行为。该框架涉及四种类型的人工智能代理:聊天机器人、“用户”、“治疗师” 和 “评论家”。

通过模拟社交对话的工作示例展示了 SafeguardGPT 的有效性。研究结果表明,该框架可以提高 AI 聊天机器人与人类之间的对话质量,SafeguardGPT 为改善 AI 聊天机器人与人类价值观之间的一致性提供了一种很有前途的方法。通过结合心理治疗和强化学习技术,使AI 聊天机器人能够以安全和合乎道德的方式学习和适应人类的偏好和价值观,有助于发展更以人为中心和负责任的 AI。

然而,AI 对齐绝非易事。例如,设计符合人类价值观的人工智能系统需要深入了解如何将它们转化为机器可读的目标。此外,测试 AI 系统的一致性可能具有挑战性,因为它需要模拟各种场景以确保系统按预期运行。

使 AI 系统与人类的价值观相一致也带来了一系列其他重大的社会技术挑战。已有研究表明,对齐可能在一定程度上损害 AI 系统的常规能力。

除此之外,一个核心的问题是,如果要让 AI 遵循人类的价值观,那么 AI 系统究竟应该向谁看齐?

例如,由于绝大部分的大模型由美国公司建立,并根据北美数据进行训练。因此,当它们被要求生成从门到房子的日常物品时,他们会创建一系列美国式的物品……然而,随着世界充满越来越多 AI 生成的图像,反映美国主流文化和价值观的图像将充斥在日常生活中,这意味着 AI 可能会成为美国文化输出的主要工具,从而影响其他国家的话语表达?

在未来,通过将具有不同观点和价值观的人纳入流程,可以一定程度上确保 AI 系统反映广泛的人类价值观。更重要的是,要注意对齐是一个持续的过程,因为 AI 系统和人类的目标和价值观会随着时间而改变。因此,持续监控和更新 AI 系统以确保它们与人类价值观和目标保持一致至关重要。

参考链接:

https://medium.com/@WalktheTalk/the-importance-of-human-ai-alignment-ensuring-our-ai-tools-work-for-us-e735665cb219

https://openai.com/blog/our-approach-to-alignment-research

https://www.su.org/blog/from-risk-to-reward-the-role-of-ai-alignment-in-shaping-a-positive-future

https://treeofwoe.substack.com/p/is-ai-alignable-even-in-principle

https://www.technologyreview.com/2023/03/28/1070390/what-if-we-could-just-ask-ai-to-be-less-biased/

https://arxiv.org/abs/2303.18223

https://arxiv.org/abs/2304.00416