2023 年初,来自法国蔚蓝海岸大学和 德国马克斯·普朗克学会的作者发表了一篇题为“用于实时现场渲染的 3D 高斯泼溅”的论文3d_gaussian_splatting。该论文提出了实时神经渲染的重大进步,超越了NeRF等以往方法的实用性。高斯泼溅不仅减少了延迟,而且达到或超过了 NeRF 的渲染质量,在神经渲染领域掀起了一场风暴。

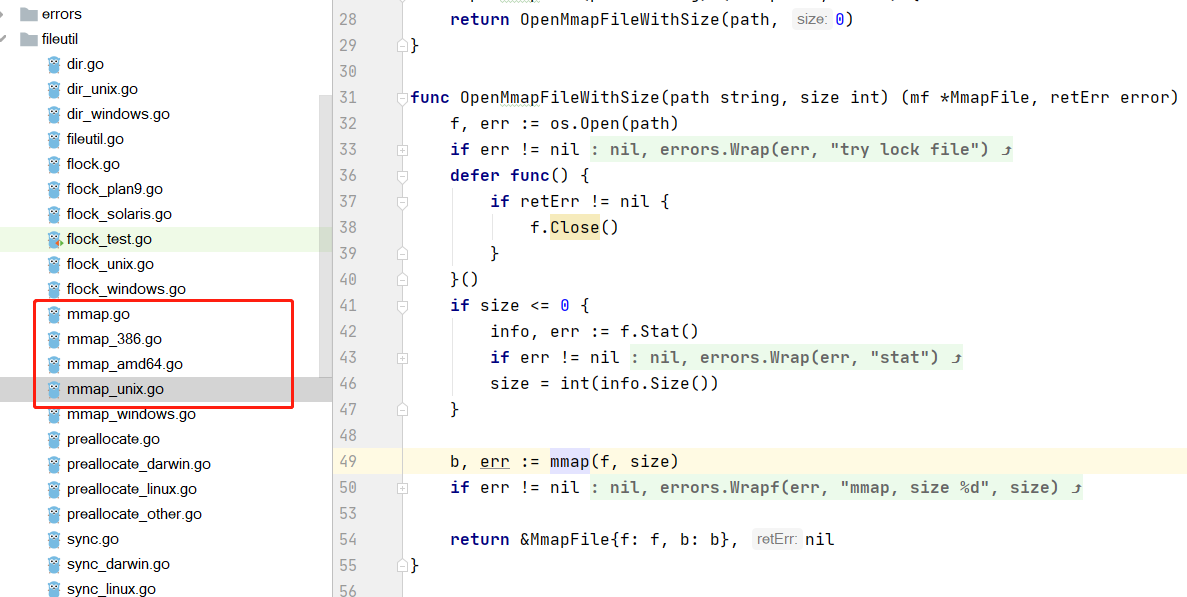

高斯泼溅虽然有效,但对于不熟悉像机矩阵和图形渲染的人来说可能很难理解。此外,可以发现在 Python 中实现高斯泼溅的资源相对比较稀缺,甚至作者的源代码也是用 CUDA 编写的(原作者对CUDA有较深入研究和理解)。

本文档旨在弥合这一差距,为精通 Python 和机器学习但在图形渲染方面经验不足的工程师提供基于 Python 的高斯泼溅介绍。GitHub 上的相关代码演示了如何初始化 COLMAP 扫描中的点并将其渲染为最终图像,该图像类似于splatting应用程序中的前向传递(并为感兴趣的人提供一些额外的 CUDA 代码)。本教程还有一个配套的 jupyter notebook(GitHub 中的 part_1),其中包含继续学习所需的所有代码。虽然我们不会构建完整的高斯 splatting 场景,本教程可以为读者提供基础知识,以更深入地研究 splatting 技术。

首先,我们使用 COLMAP,这是一款使用从运动到结构 (SfM) 提取在多个图像中一致看到的点的软件。SfM 基本上可以识别在多个图片中发现的点(例如,门口的右上边缘)。通过在不同图像中匹配这些点,我们可以估计 3D 空间中每个点的深度。这与人类立体视觉的工作原理非常相似,其中深度是通过比较每只眼睛略有不同的视图来感知的。因此,SfM 从多个图像中的公共点生成一组 3D 点,每个点都有 x、y 和 z 坐标,从而为我们提供了场景的“结构”。

在本教程中,我们将使用预构建的 COLMAP 扫描点云,可