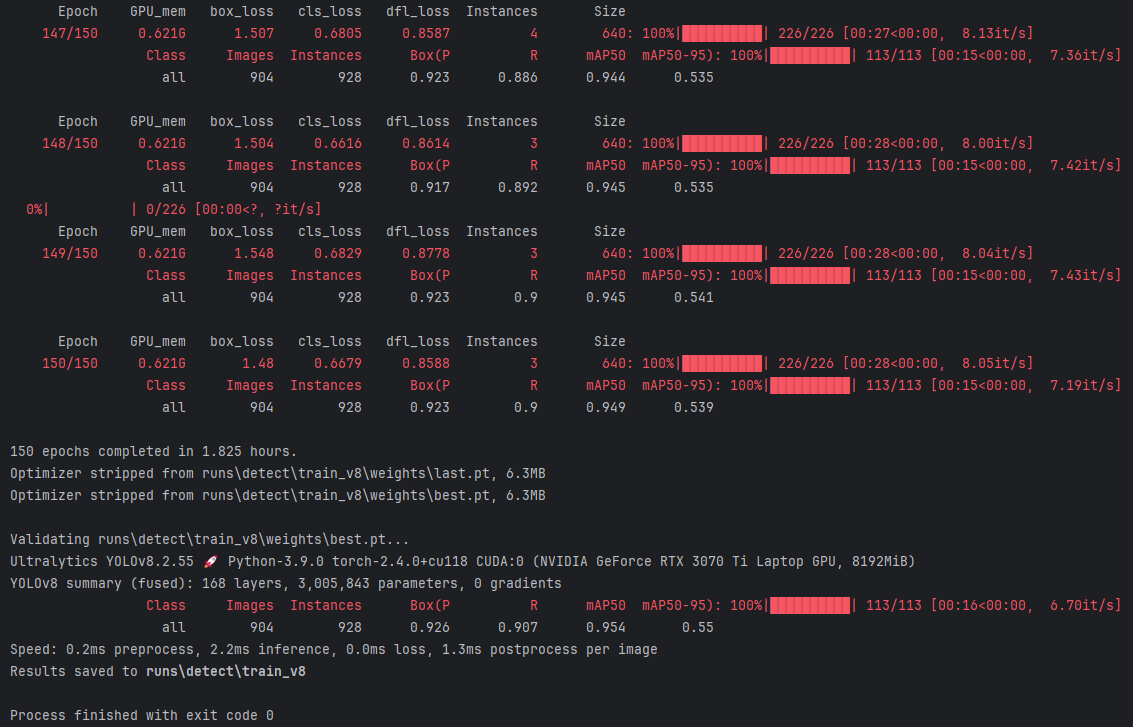

这是今年早期发表在EMNLP 2024 Findings上的一篇综述性论文:Knowledge Mechanisms in Large Language Models: A Survey and Perspective。

虽然论文尝试落脚点在以“Knowledge”为内涵去尝试阐释LLMs内部机制的这种“古典主义”思想上稍显过时且机械,但通过论文中对近几年LLMs在认知与推理这一研究领域的回顾,也更加系统性的审视了人们对LLMs为传统NLP领域带来的认知发展、探索与研究历程,我想其中的几项研究亦为后续围绕LLM模型及应用带来些许深刻的启示。

如文中根据Bloom这种古典的认知分类法将LLMs对知识的掌握与利用分为记忆、理解、总结和创造,也侧面印证了当前以GPT为代表的模型开发训练范式、演进发展历程、对真实世界数据持续的知识压缩与泛化再到以o1为代表的探索推理机制。

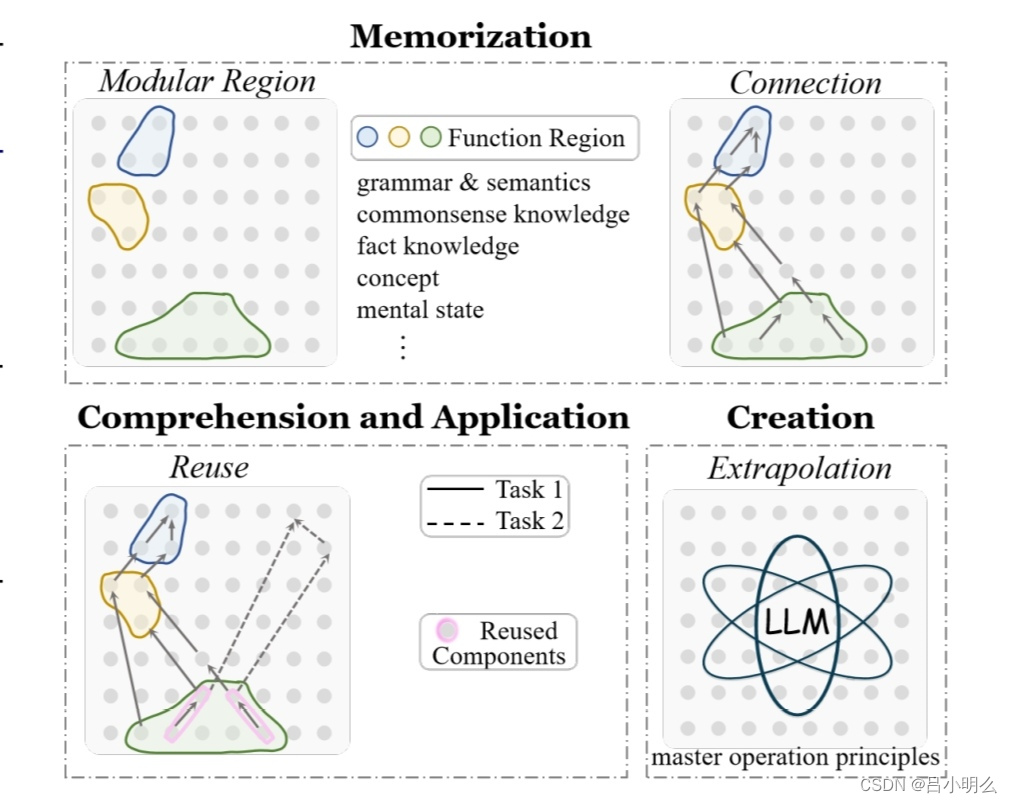

如在“知识记忆”方面,将transformer对知识的表征类比为人脑功能区域的模块化映射,并深入模型内部hidden参数层探索认知过程中对知识与模式的表征,我想这也为后续围绕LLMs内部的理论研究及模型可解释性研究打下了一定的基础。

在“理解与应用”维度,提供了某种更具象化的模型内部层次化机理对泛化过程的部分解释,如对模型内模块化区域表征的映射,再到Olsson等人在 Llama 和 GPT 模型中识别出“归纳头”,以及模型特定神经元对基础知识的表征。

在“知识创造”方面,从知识的连续性与离散性角度阐释LLMs创造知识的过程等。

另外,文中也从“知识进化”这一角度阐释了LLMs从pre-train→post-train等不同阶段模型对数据分布的学习与压缩进程,并尝试从中探明模型在训练进程中对数据延伸到浅层知识泛化的分布及跨训练阶段或新训练范式下知识由低到高层级抽象的泛化与利用机制(虽然论文对这一领域并未结合前沿成果深入分析,但我想这对于未来LLMs在处理更加复杂的推理任务甚至是对未知领域探索过程中的泛化迁移能力尤为重要)。

有趣的是,文中从“群体进化”这一新颖的角度阐释了在Multi-model或Multi-agent间的通信交互下群体对知识的进化与认知演变,我想不管对于当下流行的多智能体协作还是对未来探寻更高效人机协作过程来说,也是十分有意义的。

最后,文中提出了一种“暗知识”假说,我想这也预示着当前人类对世界发现与探索的局限及对未知领域的敬畏。

By 吕明