最近在炼丹发现一件很有趣的现象,决定系数R2竟然为负,小学生都知道任何一个常数的平方绝不可能为负,潜意识里告诉我这里面必有蹊跷,因此查阅许多资料得知,决定系数R2不是r相关系数的平方这么简单,实际上当非线性模型未捕获任何特征信息,而仅拟合随机噪声就会造成此类现象。

1、定义:

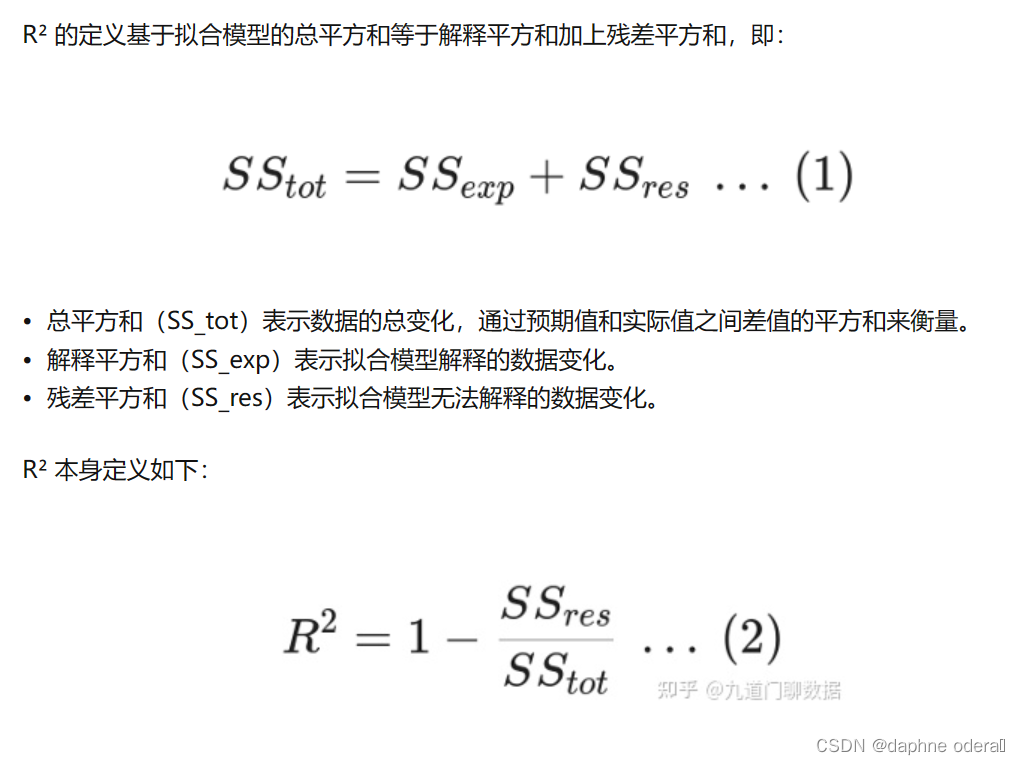

R2 决定系数(Coefficient of Determination)是一种用于评估回归模型拟合优度的指标。它表示模型能够解释数据方差的比例,通常用于比较不同模型的表现。

普遍来讲,R2决定系数的取值范围为[0,1],当R2为1时,表示模型完美预测了数据;当R2为0时,表示模型无法解释数据方差。在实际应用中,R2决定系数通常用于比较不同模型的表现,取值越接近1,表示模型解释的数据方差越多,表现越好。

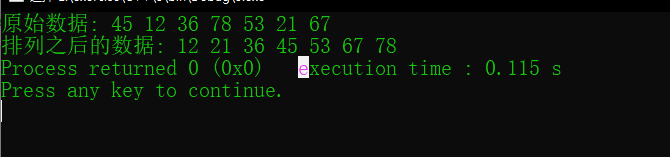

以下三种公式表达含义一样,作为后续答案补充。

公式定义1:

假设有n个样本,真实值分别为y₁, y₂, ……, yₙ,预测值分别为ŷ₁, ŷ₂, ……, ŷₙ

首先定义总方差(Total Sum of Squares,TSS)为真实值y的方差,即:

TSS = Σ(yᵢ - ȳ)² / n,(i=1,2,…,n)

其中,ȳ为所有真实值的平均数。我们希望得到模型的解释方差,即预测值能够解释的数据方差。因此,定义残差平方和(Residual Sum of Squares,RSS)为:

RSS = Σ(yᵢ - ŷᵢ)² / n,(i=1,2,…,n)

其中,ŷᵢ为第i个样本预测值,yᵢ - ŷᵢ为第i个样本的残差,表示预测值与真实值之间的差。

R2决定系数为解释方差占总方差的比例,即:

R² = 1 - (RSS / TSS)

公式定义2:

公式定义3:

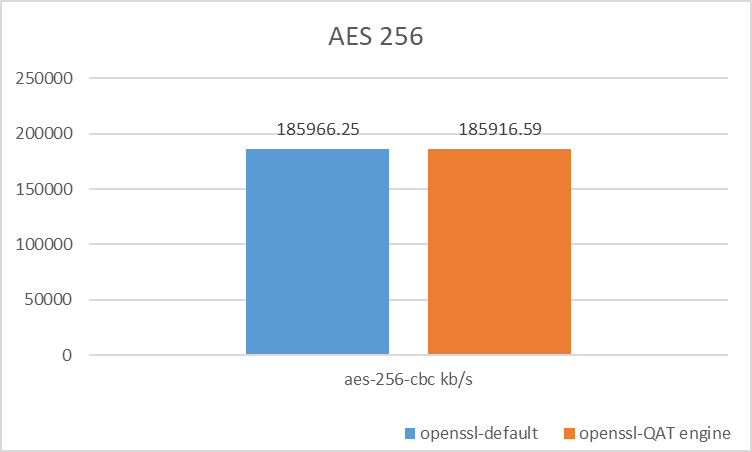

通过分析以上公式不难发现,当应用非线性回归模型时,SSE>SST 即预测值误差特别大,可能会导致R2为负数。

通过分析以上公式不难发现,当应用非线性回归模型时,SSE>SST 即预测值误差特别大,可能会导致R2为负数。

网络其他回答:

解决强多重共线性问题或设计矩阵是奇异的,R2可能为负数。

自变量、因变量间不具有线性关系会导致R2为负数。

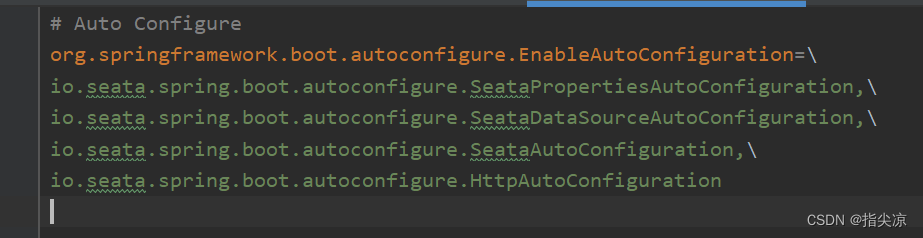

2、官方文档

def score(self, X, y, sample_weight=None):

"""Returns the coefficient of determination R^2 of the prediction.

The coefficient R^2 is defined as (1 - u/v), where u is the residual sum of squares ((y_true - y_pred) ** 2).sum() and v is the total sum of squares ((y_true - y_true.mean()) ** 2).sum().

The best possible score is 1.0 and it can be negative (because the model can be arbitrarily worse). A constant model that always predicts the expected value of y, disregarding the input features, would get a R^2 score of 0.0.

def score(self, X, y, sample_weight=None):

“”“返回预测的决定系数R^2。

决定系数R^2定义为(1-u/v),其中u是残差平方和((y_true-y_pred)**2).sum(),v是平方和总和((y_true-y_true.mean())**2).sum()。

可能的最佳分数是1.0,也可能是负数(因为模型可能更差)。一个总是预测y的期望值的常数模型,忽略输入特征,会得到0.0的R^2分数。

3、何时R² = R * R

似乎只有在有限的情况下,R² = R * R。引用相关维基百科的解释:

R²有几个定义,其中一类情况包括使用 r² 而不是 R² 的简单线性回归。当仅包含一个截距时, r² 就是观测结果和预测变量值之间的样本相关系数(即 r)的平方。如果包括其他回归系数,则 R² 是多重相关系数的平方。在这两种情况下,确定系数通常范围为0到1。

简而言之,R²只是相关系数的平方,如果我们恰好(1)使用线性回归模型,(2) 对它们拟合的相同数据进行评估。

所以只有当线性回归模型是拟合的,并且在拟合的相同数据上对其进行评估时,我们才能期望R²在0和1之间。否则,R² 的定义可能会导致负值出现。

参考:

(10条消息) R2决定系数_决定系数r2_丰。。的博客-CSDN博客

(10条消息) R2系数浅析_enginelong的博客-CSDN博客

九道门丨扒一扒机器学习中,R² 为何会出现负数? - 知乎 (zhihu.com)