爬虫使用代理IP的主要目的是为了隐藏自己的真实IP地址,以避免被目标网站封禁或限制访问。如果一个爬虫频繁地向一个网站发送请求,而且每次请求的IP地址都相同,那么这个网站就有可能认为这是一种恶意行为,从而采取封禁或限制访问的措施。使用代理IP可以让爬虫在每次请求时使用不同的IP地址,从而降低被封禁或限制访问的风险。此外,使用代理IP还可以让爬虫绕过一些地区的访问限制,以获取更多的数据。

爬虫使用HTTP代理的主要目的是为了隐藏自己的真实IP地址,以避免被目标网站封禁或限制访问。此外,使用HTTP代理还可以实现一些其他的功能,比如:

1、提高爬虫的访问速度:通过使用多个代理IP,可以实现并发访问目标网站,从而提高爬虫的访问速度。

2、突破地域限制:有些网站会根据用户的IP地址来限制访问,使用HTTP代理可以模拟不同地区的IP地址,从而突破地域限制。

3、防止被反爬虫机制识别:一些网站会通过检测用户的访问行为来判断是否为爬虫,使用HTTP代理可以模拟不同的用户行为,从而避免被反爬虫机制识别。

总之,使用HTTP代理可以帮助爬虫更好地完成数据采集任务,并提高爬虫的效率和稳定性。

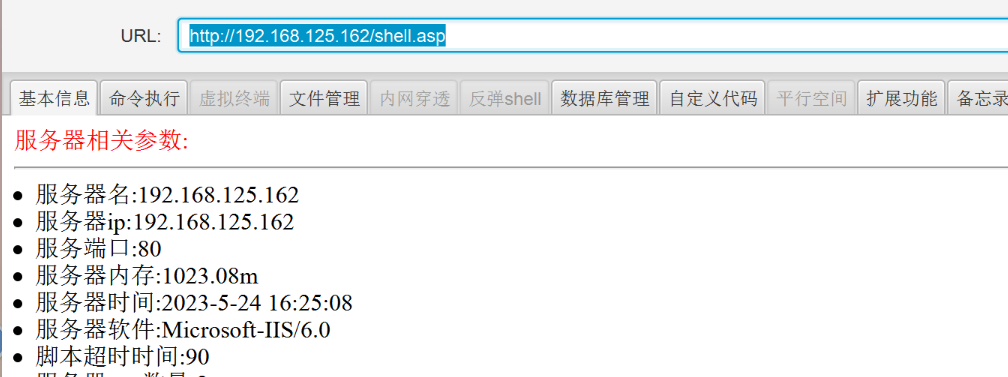

使用HTTP代理可以帮助我们在爬取网页时隐藏自己的IP地址,防止被网站封禁或者被反爬虫机制识别。以下是使用Python requests库实现HTTP代理的代码示例:

import requests# 设置代理IP和端口号

# 提取代理ip(http://jshk.com.cn/mb/http.asp)

proxy = {'http': 'http://127.0.0.1:8888','https': 'http://127.0.0.1:8888'

}# 发送请求时使用代理

response = requests.get('http://www.example.com', proxies=proxy)# 输出响应内容

print(response.text)

其中,http://127.0.0.1:8888是代理服务器的IP地址和端口号,可以根据实际情况进行修改。在发送请求时,将代理参数传递给proxies参数即可。

使用HTTP代理时需要注意以下几点:

1、选择可靠的代理:选择可靠的代理服务器很重要,因为不可靠的代理服务器可能会导致爬虫无法正常工作或者泄露你的数据。

2、避免频繁更换代理:频繁更换代理会增加爬虫的复杂度,也会增加代理服务器的负担,可能会导致代理服务器被封禁。

3、避免使用免费代理:免费代理通常质量较差,容易被封禁或者被滥用,使用时需要谨慎。

4、避免使用相同的代理:如果多个爬虫使用相同的代理服务器,可能会导致代理服务器被封禁。

5、避免过度使用代理:过度使用代理可能会导致代理服务器被封禁,也会增加代理服务器的负担。

6、避免使用不支持HTTPS的代理:如果代理服务器不支持HTTPS,可能会导致爬虫无法访问HTTPS网站。

7、避免使用代理时暴露真实IP地址:如果代理服务器不支持匿名代理或者透明代理,可能会导致爬虫的真实IP地址被暴露