大家好,我是微学AI,今天给大家介绍一下深度学习技巧应用12-神经网络训练中批归一化的应用,在深度学习中,批归一化(Batch Normalization,简称BN)是一种重要的技巧,它在许多神经网络中都得到了广泛应用。本文将详细介绍批归一化的原理和应用,并结合PyTorch框架构建一个简单的神经网络,用于演示批归一化的实际效果。

一、 批归一化的原理

传统的神经网络在训练时可能会面临梯度消失或梯度爆炸的问题,这往往需要对权重进行合适的初始化以及对学习率进行调节。批归一化提出了一个较为通用的解决方案,它通过对网络中每一层的输入进行归一化,使其具有统一的标准差和均值,从而加速网络的收敛过程。

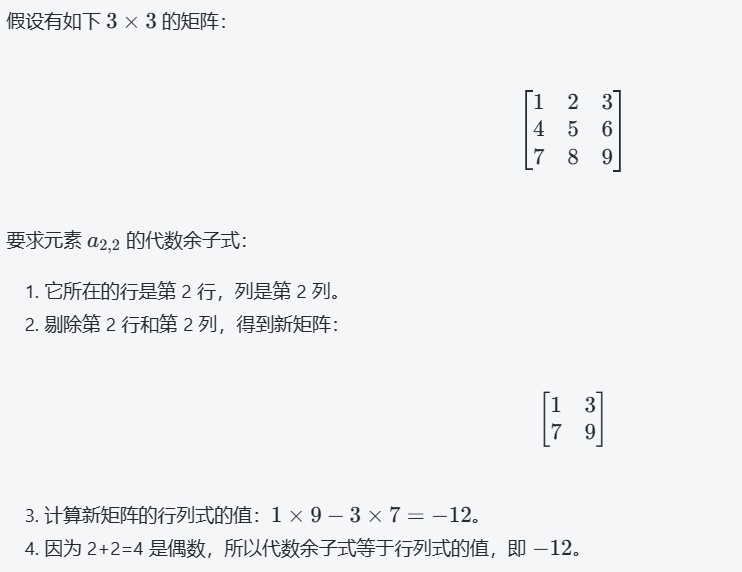

批归一化方法具体的操作为:在每一层的计算过程中,先计算-mini-batch中每个样本的均值和标准差

,然后利用这两个参数对每个样本进行归一化: