某次上课无聊,突然想写个图片爬虫玩玩,顺便把爬取的图片做个随机图片API接口(之前说写也一直拖到现在...);因为部分知识领域只知道其存在,但从没有实战学习过,干脆从头到尾练手一次,于是有了这篇博文,记录一下过程。

实现目标:

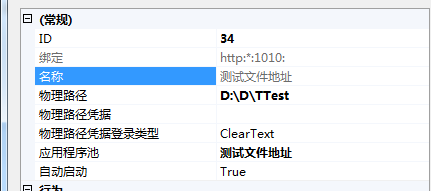

利用云服务器自动后台运行 Python脚本,包含开启自启;脚本实现内容:爬虫自动爬取图片,临时保存到本地,再上传到搜狗图床,自动保存图片上传之后的地址,以Json形式保存到本地文件。

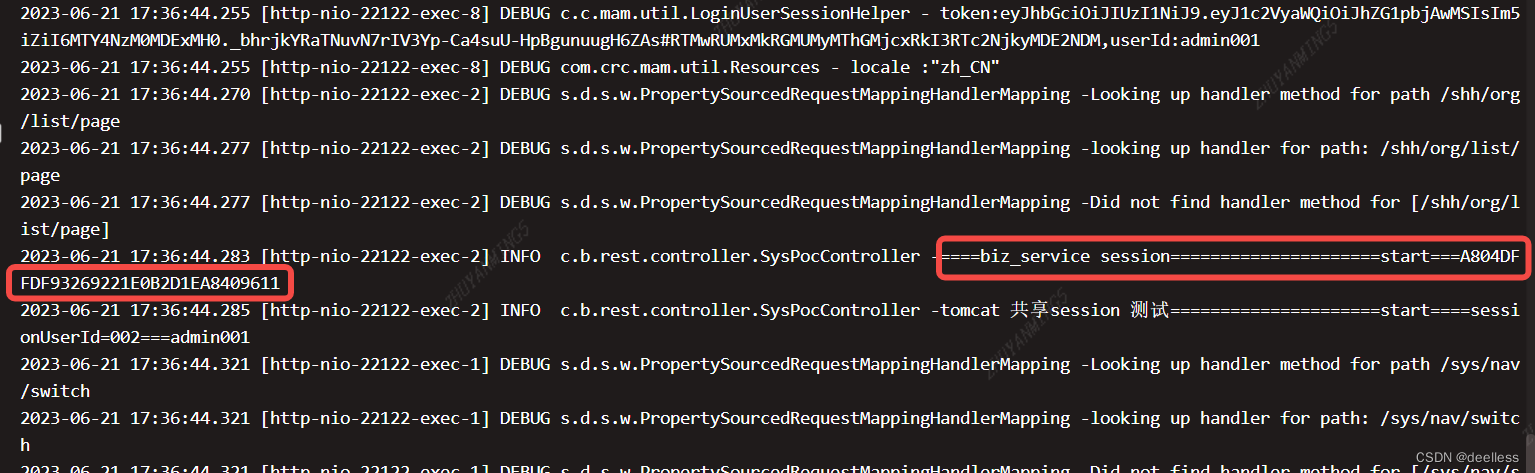

采集日志图片

采集结果图片

Ps:这里的搜狗图床其实抓的搜狗图片搜索上传接口,我测试了百度(会改变图片分别率),360(不支持SSL且最大只能2M),所以选择了搜狗。至于为啥是JSON形式保存,这是方便后面用PHP写接口时,直接读取保存数组即可,方便调用。

环境要求:

个人使用的是百度云服务器,配置有点低...

机子配置:1H、2G、1M,操作系统:Centos7.2,运行环境:Python3.7

操作步骤

1.配置Python环境

注意:本步骤全是都在root超级用户权限下执行,非root用户注意添加 sudo

新购服务器,简单配置一下,升级所有包,升级软件和系统内核,非必须,需要一点时间&#