直白点来说map输出到reduce输入的中间过程就是shuffle阶段,那么现在就来说下shuffle做了什么:

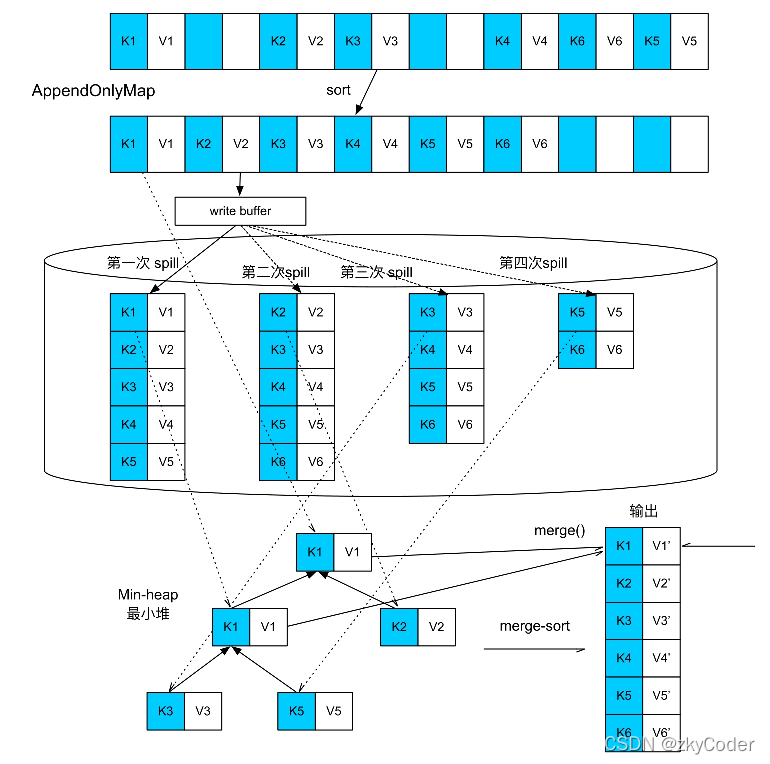

(1)collect阶段:将 MapTask 的结果输出到默认大小为 100M 的环形缓冲区,

保存的是 key/value,Partition 分区信息等。

(2)spill阶段:当内存中的数据量达到一定的阀值的时候,就会将数据写

入本地磁盘,在将数据写入磁盘之前需要对数据进行一次排序的操作,如果配置

了 combiner,还会将有相同分区号和 key 的数据进行排序。

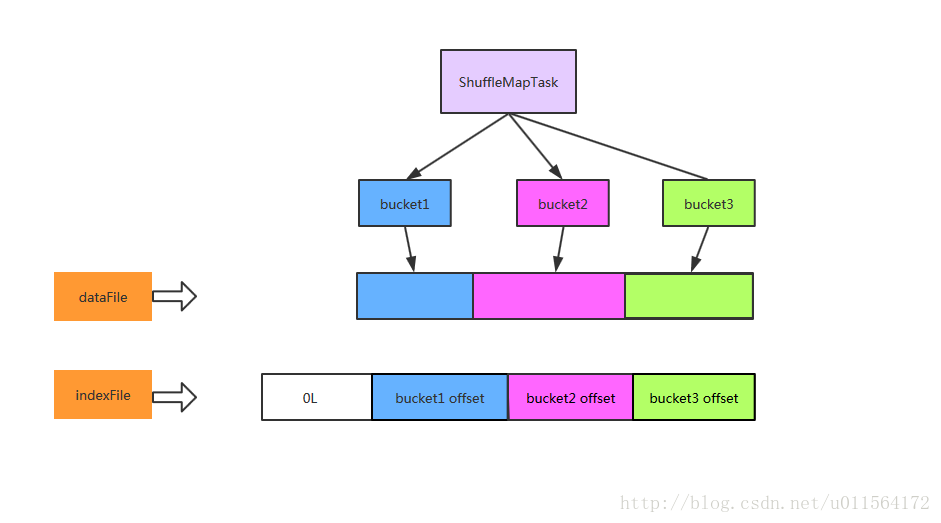

(3)merge阶段:把所有溢出的临时文件进行一次合并操作,以确保一个

MapTask 最终只产生一个中间数据文件。

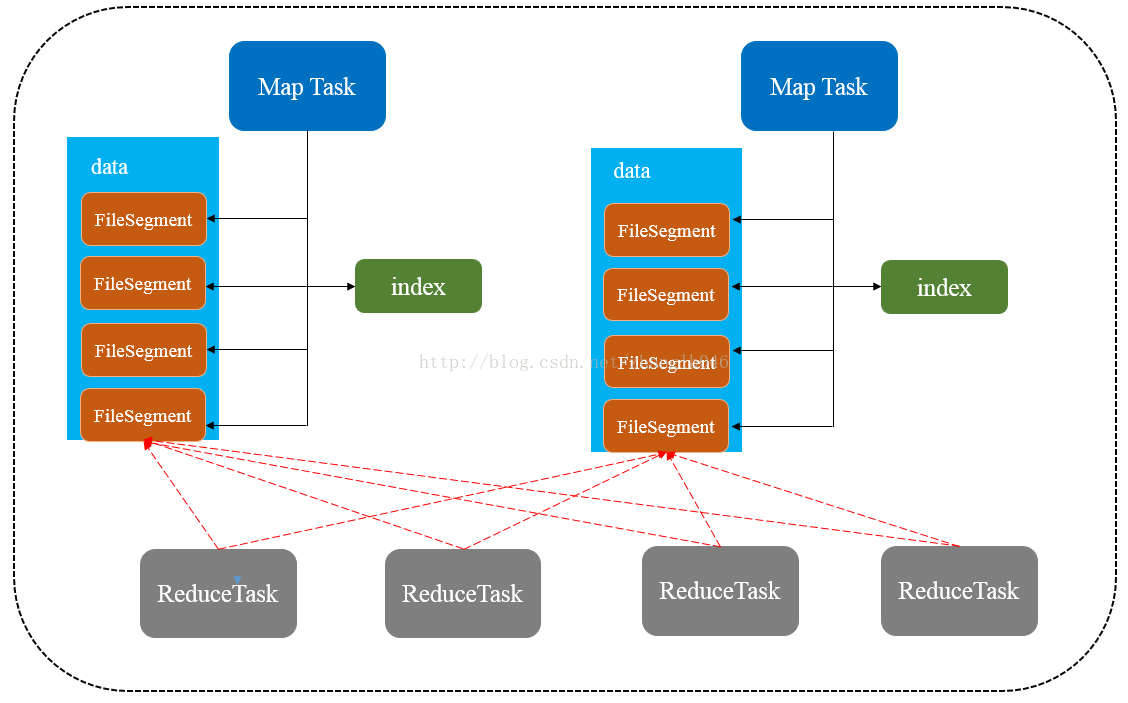

(4)copy阶段:ReduceTask 启动 Fetcher 线程到已经完成 MapTask 的节点

上复制一份属于自己的数据,这些数据默认会保存在内存的缓冲区中,当内存的

缓冲区达到一定的阀值的时候,就会将数据写到磁盘之上。

(5)merge阶段:在 ReduceTask 远程复制数据的同时,会在后台开启两个线

程对内存到本地的数据文件进行合并操作。

(6)sort阶段:在对数据进行合并的同时,会进行排序操作,由于 MapTask

阶段已经对数据进行了局部的排序,ReduceTask 只需保证 Copy 的数据的最终整

体有效性即可。

Shuffle 中的缓冲区大小会影响到 mapreduce 程序的执行效率,原则上说,

缓冲区越大,磁盘 io 的次数越少,执行速度就越快

缓冲区的大小可以通过参数调整, 参数:io.sort.mb 默认 100M