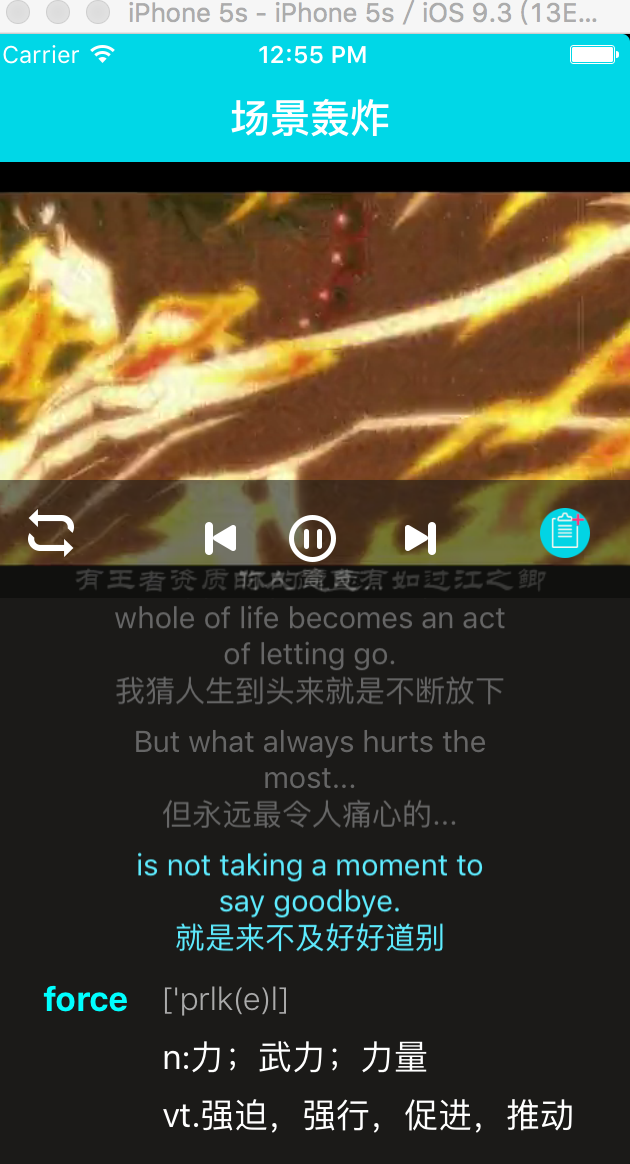

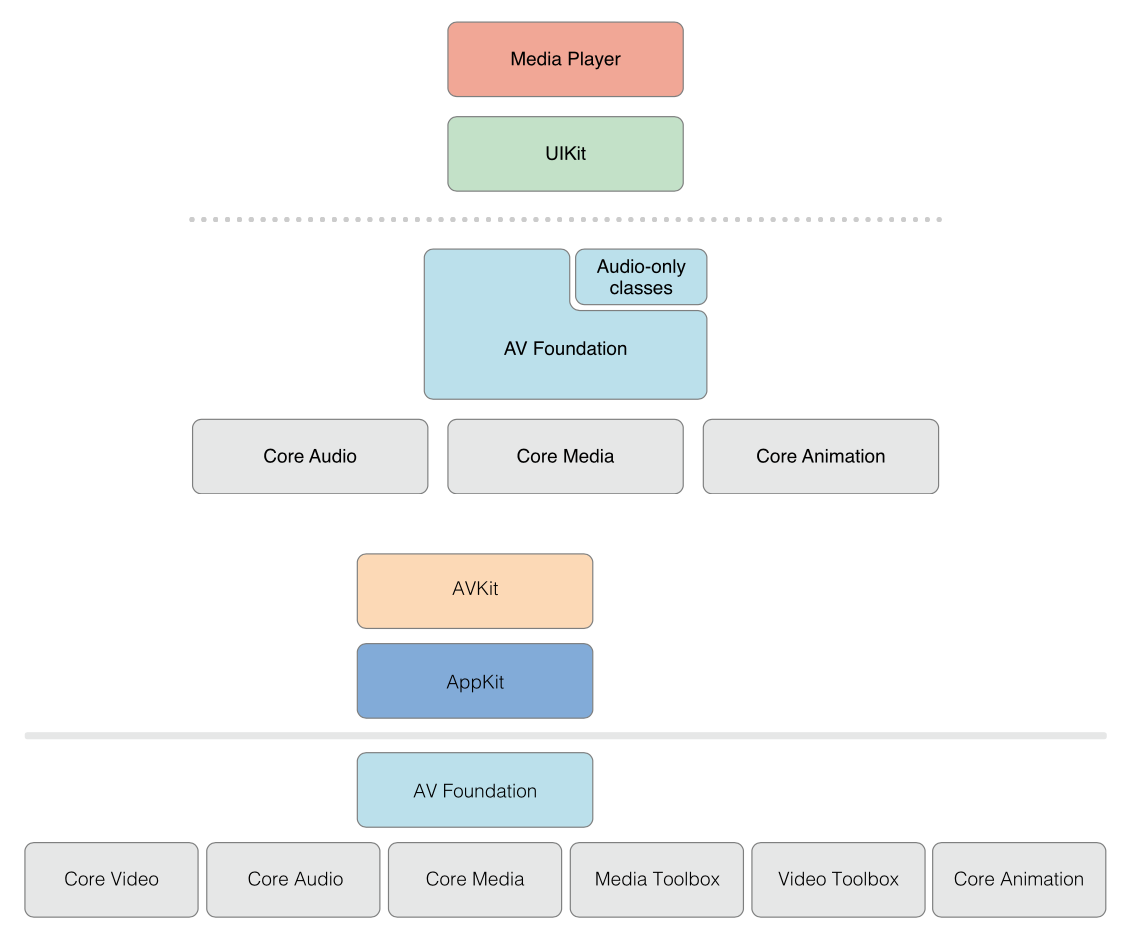

AVFoundation是可用于播放和创建基于时间的视听媒体的几种框架之一。它提供了一个Objective-C接口,您可以使用该接口详细处理基于时间的视听数据。例如,您可以使用它来检查、创建、编辑或重新编码媒体文件。您还可以从设备中获取输入流,并在实时捕获和回放期间操纵视频。图I-1显示了iOS上的体系结构。

通常,您应该使用可用的最高级别抽象来执行您想要的任务。

如果您只是想播放电影,请使用AVKit框架。

在iOS上,要在只需要对格式进行最小控制的情况下录制视频,请使用UIKit框架(UIImagePickerController)。

但是,请注意,在AVFoundation会中使用的一些原始数据结构,包括与时间相关的数据结构和不透明对象来承载和描述媒体数据,它们都在核心媒体框架中声明。

AVFoundationframework api提供与视频相关,与音频相关。旧的音频相关类提供了处理音频的简单方法。

要播放声音文件,可以使用AVAudioPlayer。

要录制音频,可以使用AVAudioRecorder。

您还可以使用AVAudioSession配置应用程序的音频行为;这在《音频会话编程指南》中有介绍。

用AVFoundation表示和使用媒体

AV基础框架用来表示媒体的主要类是AVAsset。框架的设计在很大程度上受这种表示法的指导。了解其结构将帮助您了解框架的工作原理。AVAsset实例是一个或多个媒体数据(音频和视频曲目)集合的聚合表示。它提供有关集合整体的信息,例如其标题、持续时间、自然呈现大小等。AVAsset与特定的数据格式无关。AVAsset是其他类的超类,用于从URL处的媒体创建asset实例(请参见使用资产)和创建新组合(请参见编辑)。

asset中的每个单独的媒体数据块都是统一类型的,称为轨迹(track)。在典型的简单情况下,一个轨迹表示音频分量,另一个轨迹表示视频分量;然而,在复杂的构图中,可能有多个音频和视频的重叠轨迹。asset也可能有元数据。

AVFoundation的一个重要概念是,初始化一个Asset或一个track并不一定意味着它已经准备好使用。计算项目的持续时间可能需要一些时间(例如,MP3文件可能不包含摘要信息)。在计算值时,您不需要阻塞当前线程,而是请求值并通过使用块定义的回调异步返回答案。

相关章节:使用asset、时间和媒体表示

回放

AVFoundation允许您以复杂的方式管理asset的播放。为了支持这一点,它将asset的表示状态与asset本身分开。例如,这允许您以不同的分辨率同时播放同一asset的两个不同片段。asset的表示状态由播放器项对象管理;资源中每个曲目的显示状态由播放器项曲目对象管理。例如,使用播放器项目和播放器项目轨迹,可以设置播放器显示项目视觉部分的大小,设置要在播放期间应用的音频混合参数和视频合成设置,或者在播放期间禁用资源的组件。

使用播放器对象播放播放器项目,并将播放器的输出定向到核心动画层。您可以使用播放机队列按顺序安排播放机项目集合的播放。

读取、写入和重新编码asset

AVFoundation允许您以多种方式创建asset的新表示。您可以简单地对现有asset重新编码,或者在iOS 4.1及更高版本中,您可以对asset的内容执行操作,并将结果保存为新asset。

您可以使用导出会话将现有资源重新编码为由少量常用预设之一定义的格式。如果您需要对转换进行更多控制,在iOS 4.1及更高版本中,您可以同时使用asset读取器和asset写入器对象将资产从一种表示转换为另一种表示。例如,使用这些对象,可以选择要在输出文件中表示的轨迹,指定自己的输出格式,或在转换过程中修改资源。

要生成波形的可视表示,请使用资源读取器读取资源的音频轨迹。

缩略图

要创建视频演示文稿的缩略图,请使用要从中生成缩略图的资源初始化AVAssetImageGenerator的实例。AVAssetImageGenerator使用默认启用的视频曲目生成图像。

编辑

AVFoundation使用合成从现有媒体片段(通常是一个或多个视频和音频曲目)创建新asset。您可以使用可变组合来添加和删除轨迹,并调整它们的时间顺序。您还可以设置音轨的相对音量和渐变;并设置视频轨迹的不透明度和不透明度渐变。composition是存储在内存中的媒体片段的集合。使用导出会话导出合成时,它将折叠为文件。

您还可以使用asset写入器从媒体(如样本缓冲区或静态图像)创建asset。

静态和视频媒体捕获

摄像机和麦克风的录制输入由捕获会话管理。捕获会话协调从输入设备到输出(如电影文件)的数据流。即使会话正在运行,也可以为单个会话配置多个输入和输出。向会话发送消息以启动和停止数据流。

此外,可以使用预览层的实例向用户显示摄影机正在录制的内容。

基于AVFoundation的并发编程

AVFoundation调用块、键值观察器和通知处理程序的回调不保证在任何特定线程或队列上进行。相反,AVFoundation在执行内部任务的线程或队列上调用这些处理程序。

关于通知和线程,有两个一般准则:

与UI相关的通知发生在主线程上。

需要您创建和/或指定队列的类或方法将在该队列上返回通知。

除了这两条准则(参考文档中也有例外),您不应该假设在任何特定线程上都会返回通知。

如果您正在编写多线程应用程序,可以使用NSThread方法isMainThread或[[NSThread currentThread]isEqual:<#存储的线程引用#>]来测试调用线程是否是您希望在其上执行工作的线程。您可以使用诸如performSelectorOnMainThread:withObject:waitUntilDone:和performSelector:onThread:withObject:waitUntilDone:modes:等方法将消息重定向到适当的线程。您还可以使用dispatch_async“跳转”到相应队列上的块,该队列可以是UI任务的主队列,也可以是您为并发操作准备的队列。有关并发操作的更多信息,请参阅《并发编程指南》;有关块的更多信息,请参见块编程主题。AVCam iOS:使用AVFoundation捕获图像和电影示例代码被认为是所有AVFoundation功能的主要示例,可以参考AVFoundation的线程和队列使用示例。

先决条件

AVFoundation是一个高级Cocoa框架。要有效地使用它,您必须具备:

对基本可可开发工具和技术有深入的了解

对方块的基本掌握

基本了解键值编码和键值观察

对于播放,了解核心动画的基本知识(请参阅《核心动画编程指南》,对于基本播放,请参阅《AVKit框架参考》。

![[AV1] AV1 Reference Software](https://img-blog.csdnimg.cn/20201101192235554.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L3N0YXJwZXJmZWN0aW9u,size_16,color_FFFFFF,t_70#pic_center)