GPU计算是指使用GPU(图形处理单元)作为协处理器来加速CPU,以加速科学、分析、工程、消费者和企业应用程序的运行。GPU加速器由NVIDIA®于2007年首次推出,现在已经支持了世界各地的政府实验室、大学、公司和中小企业的节能数据中心。GPU加速了从汽车、手机和平板电脑到无人机和机器人等平台的应用程序。

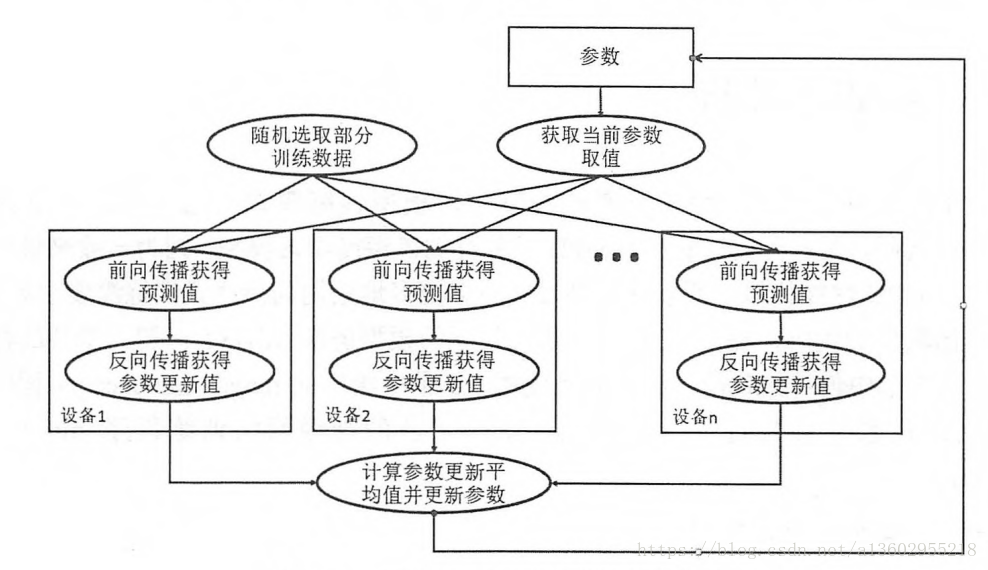

GPU通过卸载一些计算密集型和耗时的代码部分来加速运行在CPU上的应用程序。 应用程序的其余部分仍在CPU上运行。 从用户的角度来看,应用程序运行得更快,因为它使用GPU的大规模并行处理能力来提高性能。 这被称为“异类”或“混合”计算。

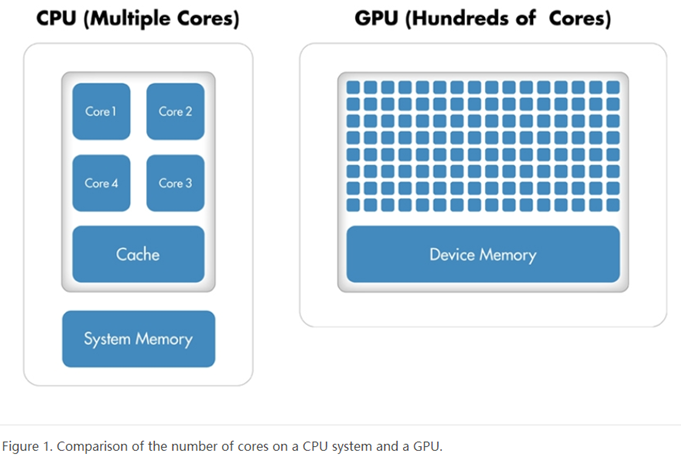

CPU 由4到8个 CPU 核心组成,而 gpu 由数百个较小的核心组成。它们协同工作以处理应用程序中的数据。这种大规模并行处理机架构为 gpu 提供了高计算性能。有许多 gpu 加速的应用程序提供了访问高性能计算(hpc)的简单方法。

GPU与CPU的区别

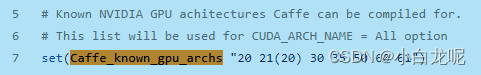

应用程序开发人员使用NVIDIA发明的名为CUDA的并行编程模型来利用并行GPU架构的性能。所有NVIDIA GPU——GeForce、Quadro和Tesla——都支持NVIDIA CUDA并行编程模型。

Tesla GPU设计为计算加速器或配套服务处理器,针对社会科学和技术进行计算方法应用研究进行了分析优化。最新的Tesla 20系列GPU基于CUDA平台的最新发 展实现,称为“Fermi架构”。 Fermi具有关键的计算系统功能,例如500 + gigaflops的IEEE标准双精度浮点硬件资源支持,L1和L2缓存,ECC内存错误保护,分布在整个GPU中的共享内存形式的本地用户可以管理数据缓存,合并内存访问等。

GPU计算的历史

图形芯片原先是固定功能图形管道。多年来,这些图形芯片变得越来越可编程,这导致NVIDIA推出了它的第一个GPU。在1999-2000年的时间框架内,医学成像和电磁学等领域的研究人员开始使用GPU来加速一系列的科学应用。这就是被称为GPGPU或通用GPU计算的运动的出现。

挑战在于GPGPU需要使用OpenGL和Cg等编程语言来编程GPU,开发人员必须使他们的科学应用程序看起来像图形应用程序,并将它们映射到绘制三角形和多边形的问题,这限制了GPU对科学性能的可访问性。

NVIDIA认识到这种能力将带给科学界的更大潜力,并投资于修改GPU使其完全可编程用于科学应用,此外还增加了对 c、 c + + 和 Fortran 等高级语言的支持,导致了GPU的 Cuda 并行计算平台。

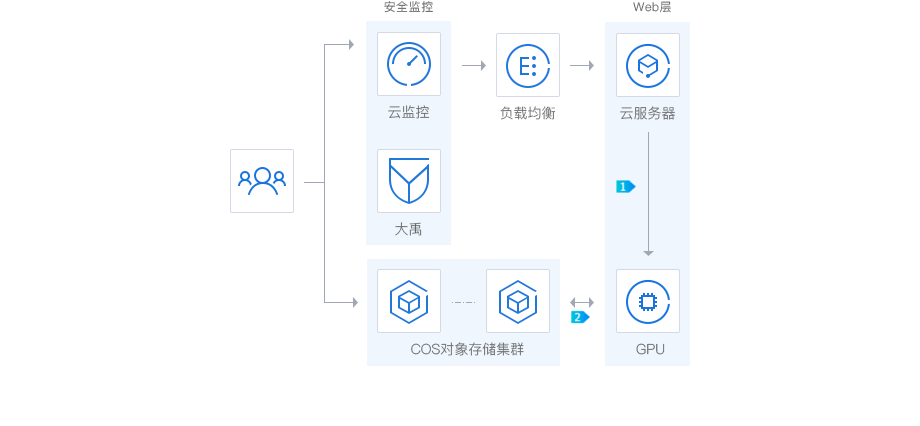

阿里云国际版GPU云服务器

阿里云国际版GPU云服务器是基于GPU应用的计算服务,具备实时高速、并行计算、浮点计算分析能力强等特点,适用于网络视频解码、图形渲染、深度学习、科学计算等场景。主要型号包括AMD S7150、 Nvidia M40、Nvidia P100、Nvidia P4、Nvidia V100。

更多关于GPU云服务器资讯可访问阿里云国际版官网,关于注册阿里云国际版账户、代充续费等资讯可访问unirech官网查看,unirech是阿里云国际总代,注册阿里云国际版账户无需paypal即可充值,关联分销商账户更加稳定可靠不易被风控,海外云产品免实名免备案,官方tg@unirech_dingding