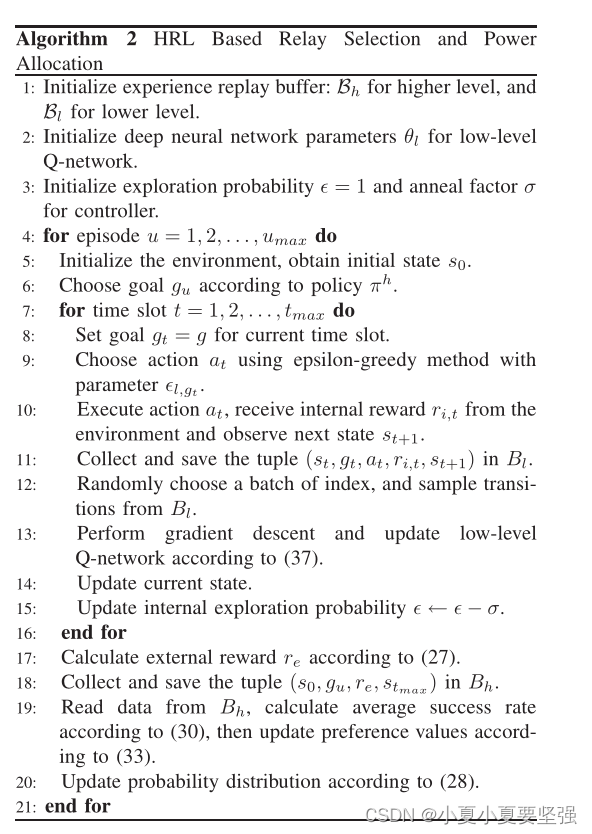

最近一直在看分层强化学习,今天看了一篇Hierarchical Reinforcement Learning for Relay Selection and Power Optimization in Two-Hop Cooperative Relay Network。两跳协同中继网络中中继选择和功率优化的层次强化学习。

他是分了两层来处理不同动作。第一层先做了中继器选择,第二层做了功率分配。第一层虽然他说了用强化学习,但是实际上他没有用具体的网络结构,他虽然有一个选择动作的网络结构,但是这个网络的优化和传统的强化不同,他是根据自己推导出的一个式子去做的。还有一点,他第一层网络的更新,是在第二层走了多少slot后。才更新一次,就是假如第二层更新50次后,第一层更新1次。第二层网络用的dueling dqn。

强化学习读书笔记之Gradient Bandit及实现(二) - 知乎 (zhihu.com)

这里面重新说一下第一层,他用强化中的Gradient Bandit,来选择动作,这个方法我之前是不了解的,他的推导和上面知乎上的链接是一样的。所以说也是具体用了强化的某一个方法。

在做实验时,说比用两层dqn效果要好

伪代码

Enabling Efficient Scheduling in Large-Scale UAV-Assisted Mobile-Edge Computing via Hierarchical Reinforcement Learning

通过分层强化学习实现大规模无人机辅助移动边缘计算的高效调度

这篇文章主要解决的无人机在计算卸载时的问题。她用分层的方法为:第一层解决的是无人机的位置,它是一个连续变量,所以用ddpg。第二层解决无人机在该位置上做的计算卸载。卸载到哪个无人机/本地,离散离量,所以用dqn