晓查 发自 凹非寺

量子位 报道 | 公众号 QbitAI

英伟达的最新AI工具又让网友用户们激动了。

“我已经等不及了!”

一位网友在看完演示视频后表示。

对于“手残党”来说,英伟达的EditGAN简直就是零基础P图神器。

能够高质量、高精细度地对图像进行修改,让P图方式从未如此容易。

例如,让画像和雕塑“挤眉弄眼”:

只要你会上传图片、能画草图,就能够轻松P图。如此“魔性”的工具,难怪得到了网友热捧。

EditGAN甚至能精细到修改车轮辐条大小和方向:

当然,真人照片也不在话下,如控制人眼朝向、头发量等:

还能给猫咪修改耳朵大小:

而你要做的,只是上传一张图片,然后由程序生成一张语义分割草图,直接在草图上涂抹修改。

△ 在草图中加入牙齿部分,人就笑了

EditGAN只会修改你想要改变的部位,其他部分都原封不动。

和最近的GauGAN2一样,英伟达也为EditGAN开发了一个电脑软件:

这项研究已经被NeurIPS 2021接收。

本文一作是来自多伦多大学的华人博士生凌欢,他同时在该校人工智能研究院(Vector Institute)和英伟达做研究。

首个GAN驱动的图像编辑器

研究人员表示,EditGAN是第一个GAN驱动的图像编辑框架,它的主要特点是:

1、提供非常高的精度编辑,

2、只需要很少的注释训练数据,

3、可以实时交互式运行,

4、允许多个编辑的直接合成,

5、适用于真正的嵌入式、GAN生成甚至域外图像。

首先,EditGAN使用StyleGAN2生成图像。

StyleGAN2的工作流程是:获取图像,将其编码到潜在空间,并使用生成器将这个编码子空间转换为另一个图像。

但问题在于,这个空间是多维的,我们很难将其可视化,也很难确定该子空间的哪一部分负责重建图像中的哪个特征。

通常,需要庞大的标注数据集,才能知道模型中潜在空间哪一部分控制哪些特征。

而EditGAN仅通过对少数标记的数据集示例进行学习,就能将分割与图像相匹配,从而实现图像图像的编辑。

EditGAN保留了完整的图像质量,同时提供了前所未有的细节和自由度。

更重要的是EditGAN不仅知道潜在空间对应控制那个部分,而且还将它们与草图对应起来。这样,我们就可以通过修改草图轻易地修改图像了。

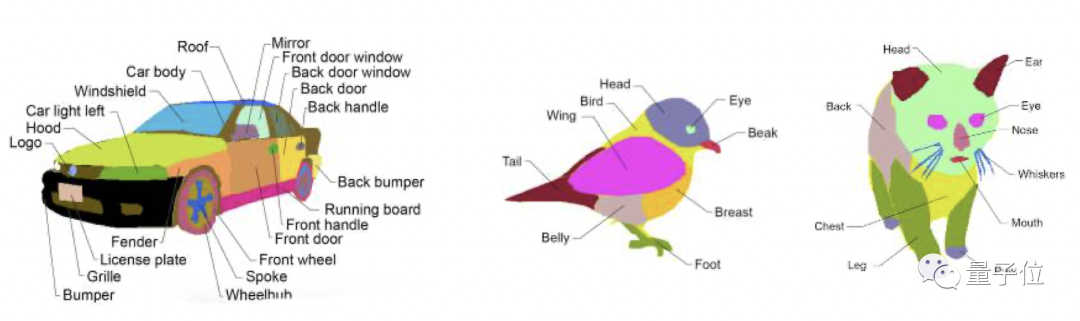

EditGAN基于DatasetGAN,结合了图像建模及其语义分割。

EditGAN的关键思想在于利用图像和像素级语言分割联合分布。

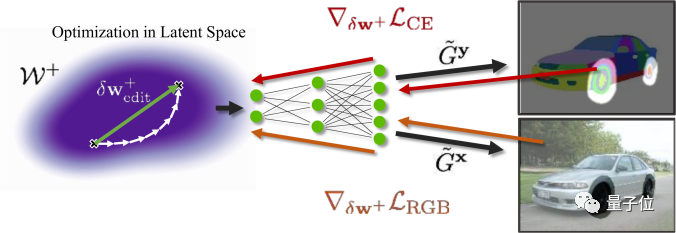

具体而言,就是将图像嵌入GAN的潜在空间,并根据分割编辑执行条件潜在代码优化。

以上展示了EditGAN的训练过程:修改语义分割并优化共享的潜在代码,与编辑区域内的新分割,以及编辑区域外的RGB外观保持一致。相应的梯度通过共享生成器进行反向传播。

为了摊销优化,作者在实现编辑的潜在空间中找到“编辑矢量”。该框架允许学习任意数量的编辑矢量,然后以实时的速率直接应用于其他图像。

P图工具即将发布

作者团队在英伟达内部GPU集群上使用V100执行底层 StyleGAN2、编码器和分割分支的训练以及嵌入和编辑的优化。

该项目使用了大约14000个GPU 小时,其中大约3500个 GPU 小时用于最终实验,其余用于研究项目早期阶段的探索和测试。

至于EditGAN的运行,在V100上进行30 (60) 步优化需要 11.4 (18.9) 秒。

虽然训练不起,但是用训练好的模型来P图还是有可能的。

此前英伟达发布的Canvas就集成了GauGAN2等最新成果,可以用手绘草图生成精细的PS文件。

可能Canvas也会很快集成EditGAN的吧。

有个好消息是,英伟达表示,将会代码和编辑工具软件即将推出。你是是不是迫不及待想尝试一把了?

论文地址:

https://arxiv.org/abs/2111.03186

补充材料:

https://nv-tlabs.github.io/editGAN/editGAN_supp_compressed.pdf

讲解视频:

https://www.youtube.com/watch?v=bus4OGyMQec

![[linux] NVIDIA RTX A6000 with CUDA capability sm_86 is not compatible with the current PyTorch ins](/images/no-images.jpg)