在Spark中,RDD(弹性分布式数据集)的分区数影响了数据的并行处理能力,不同的数据源由于数据存储方式和访问模式的不同,RDD的分区数会有所不同。以下是不同数据源(如 MySQL、Parquet、HDFS、Hive、Doris、Kafka)读取时,RDD分区数的影响因素以及如何配置:

1. Spark读取MySQL时的RDD分区数

当Spark从MySQL读取数据时,RDD的分区数主要受到以下几个因素的影响:

spark.sql.shuffle.partitions:该参数控制Shuffle阶段的分区数。虽然直接影响的是SQL查询操作,但也间接影响RDD的分区数。spark.sql.parallelPartitionDiscovery.threshold:如果数据源支持分区发现,这个阈值决定了分区数。- 查询条件:在查询MySQL时,通常会对表的数据进行分区(例如,使用范围条件分区),通过

partitionColumn、lowerBound、upperBound和numPartitions来控制。Spark会在多个分区中并行读取不同范围的数据。 numPartitions参数:指定从MySQL读取数据时要使用的分区数量。这个参数对数据的并行度有直接影响,过低的分区数会导致资源浪费,过高的分区数会导致过多的任务调度和小任务执行的开销。

例如,读取MySQL的代码可以这样设置:

val jdbcDF = spark.read.format("jdbc").option("url", "jdbc:mysql://localhost:3306/mydb").option("dbtable", "my_table").option("user", "username").option("password", "password").option("partitionColumn", "id").option("lowerBound", "1").option("upperBound", "1000").option("numPartitions", "4").load()

解释:

partitionColumn: 指定用于分区的列,通常选择一个连续的数值列。lowerBound和upperBound: 确定分区范围。numPartitions: 设定分区的数目,Spark会在不同的分区之间分布读取数据。

2. Spark读取Parquet时的RDD分区数

读取Parquet文件时,RDD的分区数主要受以下因素的影响:

- 文件大小和数量:每个文件会被一个分区读取。如果Parquet文件较小,则可能只有少数几个分区;如果文件较大,Spark会尝试为每个文件分配多个分区。

spark.sql.files.maxPartitionBytes:控制单个分区处理的最大字节数。Spark会尝试将Parquet文件划分为合理大小的分区以进行并行处理。

例如,读取Parquet文件时:

val parquetDF = spark.read.parquet("hdfs://path_to_parquet")

- 如果文件较大,Spark会自动将数据分成多个分区进行并行处理。如果文件数量多,但每个文件很小,则可能需要通过增加

numPartitions来增加并行度。

3. Spark读取HDFS数据时的RDD分区数

读取HDFS数据时,RDD的分区数由以下因素影响:

- HDFS文件块大小:HDFS中的每个文件块通常会映射到一个分区,因此文件块的大小和数量直接影响分区数。如果文件较大,HDFS会将文件拆分成多个块,每个块对应一个Spark分区。

spark.sql.files.maxPartitionBytes:控制每个分区的最大字节数,影响分区的数量和大小。spark.sql.files.openCostInBytes:控制Spark读取数据时每个文件打开的开销大小,影响文件的读取分区数。

例如,读取HDFS上的数据:

val hdfsDF = spark.read.text("hdfs://path_to_file")

- 如果文件很大,HDFS会将文件分块,每个分块通常会对应一个分区。对于小文件,Spark会将它们合并到少数几个分区。

4. Spark读取Hive时的RDD分区数

当Spark从Hive读取数据时,RDD的分区数会受以下因素影响:

spark.sql.shuffle.partitions:Hive查询会触发Spark的shuffle操作,因此该参数控制了Hive查询的分区数。- 分区表:如果Hive表是分区表(如按日期、地区等字段进行分区),Spark会根据Hive表的分区情况来分配读取任务,通常每个分区对应一个RDD分区。

numPartitions:如果查询涉及到大量的行或需要处理分区表,可以通过numPartitions来控制分区数。

例如:

val hiveDF = spark.sql("SELECT * FROM hive_table WHERE year = 2022")

- 通过查询条件,Spark可以自动选择相应的分区进行数据读取。

5. Spark读取Doris时的RDD分区数

读取Doris(一个分布式SQL数据库)时,RDD的分区数由以下因素影响:

spark.sql.shuffle.partitions:与其他数据源一样,Doris读取时的分区数受到此参数的影响。- 分区策略:Doris支持分布式查询,可以通过优化查询语句(例如基于主键范围或其他字段的分区)来提高并行度。

- Doris JDBC连接:可以通过设置连接的

numPartitions来控制读取数据时的并行度。例如,使用partitionColumn来进行分区读取。

val dorisDF = spark.read.format("doris").option("doris.table.identifier", "your_table").option("doris.fenqi.partition.column", "id").option("doris.fenqi.numPartitions", "4").load()

6. Spark读取Kafka时的RDD分区数

读取Kafka时,RDD的分区数与以下因素相关:

- Kafka分区数:Kafka的每个分区会映射到一个Spark分区,Kafka的分区数决定了Spark中生成的任务数。Kafka的分区越多,Spark的并行度就越高。

spark.sql.kafka.consumer.poll.timeout:控制从Kafka获取数据的超时设置,这可以影响任务的数量。spark.kafka.partition.assignment.strategy:控制如何将Kafka的分区分配给Spark任务,可能影响RDD分区的数量。

例如:

val kafkaDF = spark.read.format("kafka").option("kafka.bootstrap.servers", "localhost:9092").option("subscribe", "your_topic").load()

- Kafka分区数(

your_topic的分区数量)会影响Spark的分区数。

总结

不同的数据源对RDD分区数的影响如下:

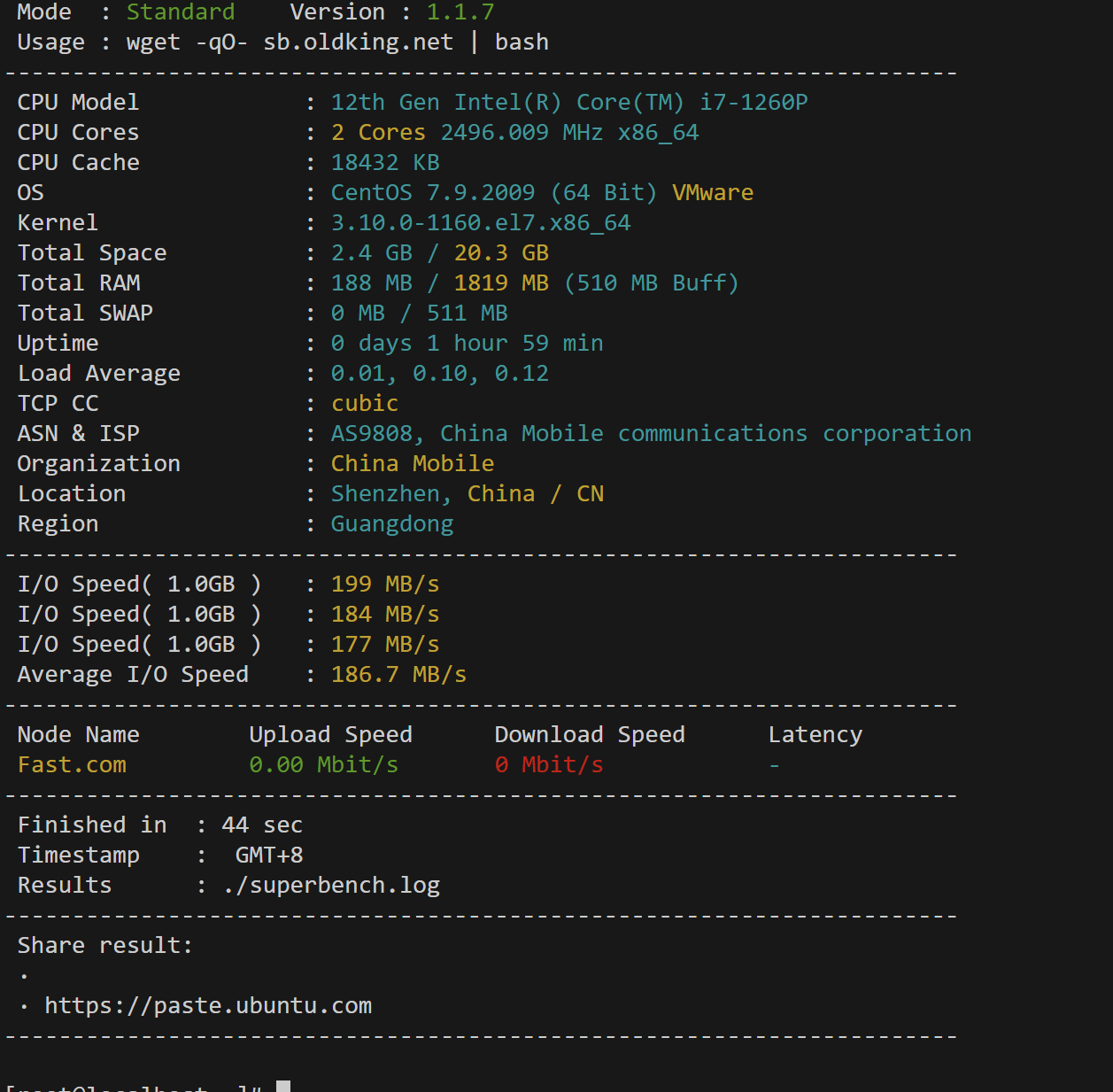

| 数据源 | 影响因素 | 配置参数 |

|---|---|---|

| MySQL | partitionColumn、numPartitions、查询条件 | partitionColumn、lowerBound、upperBound、numPartitions |

| Parquet | 文件大小、文件数量、spark.sql.files.maxPartitionBytes | spark.sql.files.maxPartitionBytes |

| HDFS | HDFS文件块大小、文件数量、spark.sql.files.maxPartitionBytes | spark.sql.files.maxPartitionBytes |

| Hive | 分区表、spark.sql.shuffle.partitions | spark.sql.shuffle.partitions |

| Doris | 查询条件、分区策略、spark.sql.shuffle.partitions | doris.fenqi.partition.column、doris.fenqi.numPartitions |

| Kafka | Kafka分区数、spark.sql.kafka.consumer.poll.timeout | spark.kafka.partition.assignment.strategy |

因此,读取数据源时的RDD分区数会受到数据源自身的存储方式、配置参数以及查询条件的影响。合理的分区数可以提高Spark任务的并行度,优化性能。