预测知识 | 机器学习预测模型局限性

目录

- 预测知识 | 机器学习预测模型局限性

- 问题描述

- 未来发展

- 参考资料

问题描述

-

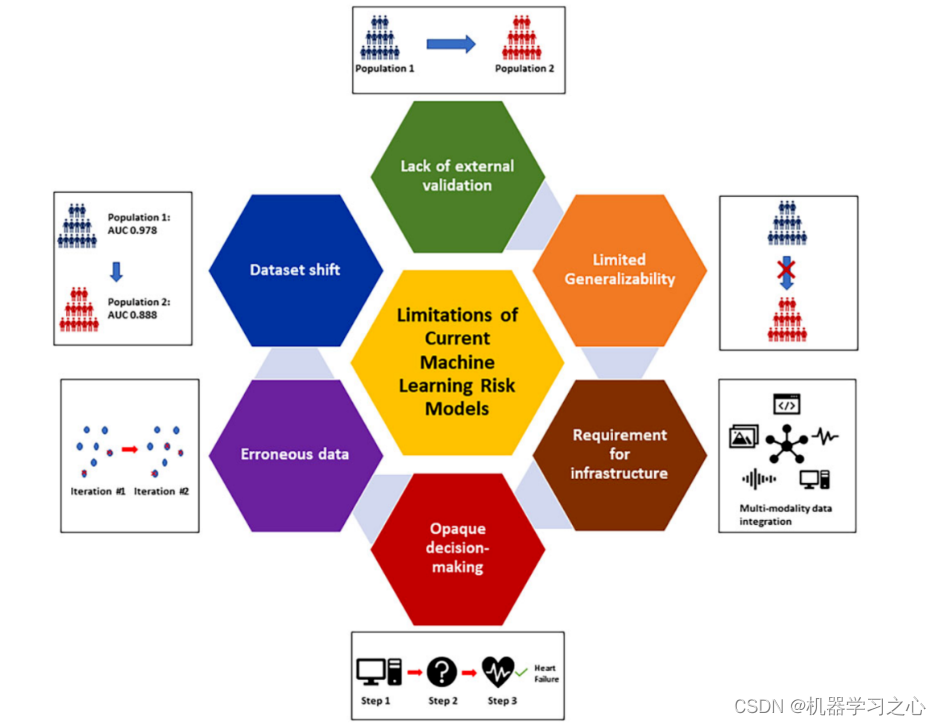

数据基础设施:要构建模型,必须有数据,且有多来源的大数据。这一切都离不开数据基础设施的建设和发展。

-

错误数据输入:数据质量是任何分析的基石,如果数据的数据质量很差甚至错误,那么得到的结果也将是不可靠或错误的,正所谓garbage in,garbage out!因此,高质量数据来源是人工智能研究的基础。

-

数据漂移:这指的是用来决策的数据和模型训练的数据存在很大差异。可想而知,这种情况下模型性能势必不佳。数据飘移包括如下几种,1)协变量漂移,指的是预测因素在两个数据集上分布差异很大;2)先验概率漂移,指的是两个数据集上结局发生率不同;3)概念漂移,指的是协变量和结局之间的关系随时间而变化。因此,要使构建的模型好,一定要解决数据漂移问题,这也是为什么研究论文中,需要开展训练集和测试集比较的原因所在(备注:期望结果是,训练集和测试集不存在差异)。

-

缺乏外部验证:目前研究文献中所构建的预测模型,绝大多数仅做了内部验证,而缺乏有效的外部验证。原因很简单,数据比较难获取罢了。但是外部验证这个东西,也是一个相对宽泛的概念,其包括了同一个队列非同一时段的时间外部验证,也包括不同队列来源的验证。所以,在数据有限时,不妨试试时间外部验证。

-

有限的泛化能力:泛化能力指的是模型在应用到新数据集时的表现。尽管现在很多文献,包括顶刊发表的模型,其报告的性能很高,但是泛化能力却不得而知。尤其是模型构建时,受限于研究数据,其仅代表了当时背景下的人群特征,一旦泛化到更一般人群时,其模型预测效果可能大打折扣。

-

模型黑盒问题:当下算力越来越快,模型越来越复杂。在人工智能研究中,你可能很难找到类似线性回归、决策树这种易于理解的小而简的模型了。事实上正是如此,越来越多研究追求大而复杂的模型,旨在提高预测效果。但是,一个不可避免的问题就是,模型可解释性很差。关于如何解决该问题,也衍生出一门学问,即可解释性机器学习。

未来发展

机器学习作为人工智能领域的重要分支,在未来发展方面有许多潜力和趋势。

-

深度学习的进一步发展:深度学习已经在图像识别、语音识别、自然语言处理等领域取得了巨大成功。未来,深度学习模型的架构和算法可能会进一步改进,以提高模型的性能和效率。

-

迁移学习和增强学习的应用扩展:迁移学习和增强学习是机器学习中的重要技术,用于在不同任务和环境中进行知识迁移和决策优化。未来,这些技术可能会在更广泛的应用领域得到应用,例如自动驾驶、智能机器人等。

-

解释性机器学习和可解释性人工智能:随着机器学习模型的复杂性增加,解释性机器学习和可解释性人工智能变得越来越重要。未来,研究人员可能会更加关注如何解释和理解机器学习模型的决策过程,以及如何提高模型的可解释性和可信度。

-

自动化机器学习:自动化机器学习旨在简化机器学习的流程,使非专业人士也能够轻松应用机器学习技术。未来,自动化机器学习工具和平台可能会进一步发展,提供更智能、高效的模型选择、特征工程和超参数调优等功能。

-

联邦学习和隐私保护:联邦学习是一种分布式学习方法,可以在保护数据隐私的同时进行模型训练与更新。随着对数据隐私的关注增加,联邦学习和隐私保护技术可能会在未来得到更广泛的应用。

-

结合领域知识的机器学习:结合领域知识和机器学习技术可以提高模型的性能和鲁棒性。未来,研究人员可能会更加关注如何将领域知识融入到机器学习模型中,以提高模型的学习能力和泛化能力。

-

可持续性和公平性的机器学习:可持续性和公平性是未来机器学习发展中的重要议题。研究人员和从业者可能会更加关注如何构建可持续和公平的机器学习模型,避免模型的偏见和歧视。

需要注意的是,以上只是一些可能的未来发展方向,随着科技的不断进步和应用需求的变化,机器学习的发展将是一个不断演化和创新的过程

参考资料

[1] Reference: Development and validation of predictive models for unplanned hospitalization in the Basque Country: analyzing the variability of non-deterministic algorithms