CUDA编程【1】

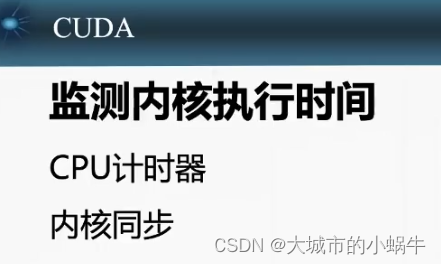

- 29. 检测内核执行时间

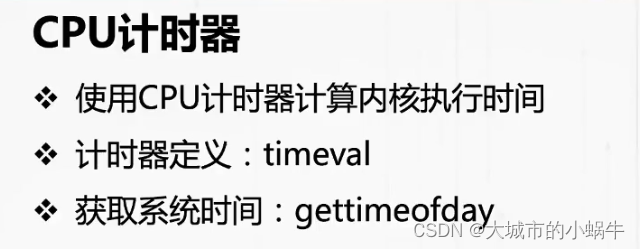

- 29.1 CPU计时器

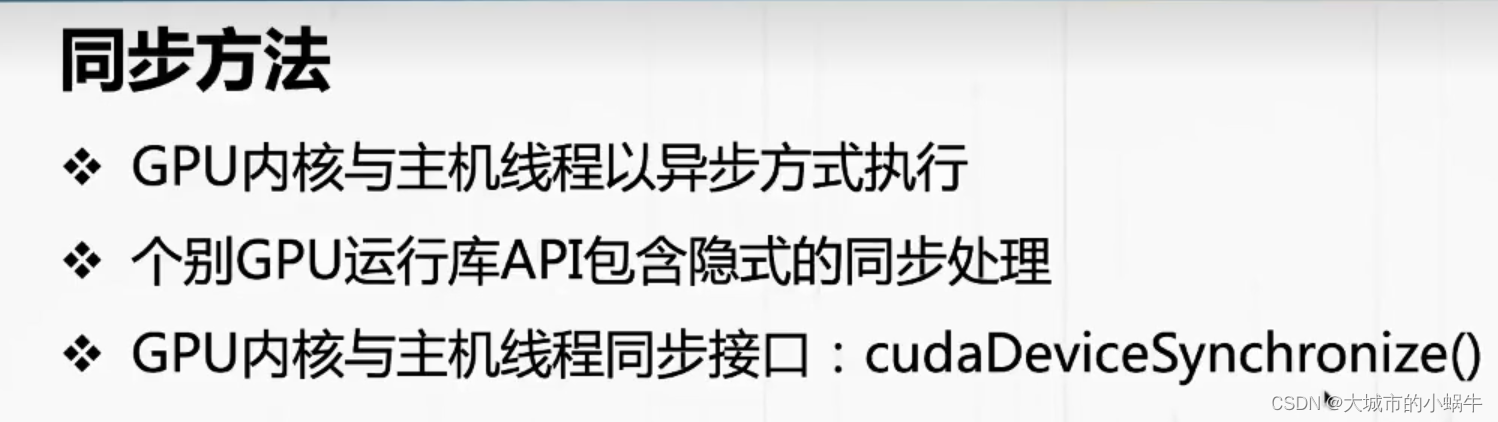

- 29.2 内核同步

- 30. nvprof监测内核执行时间

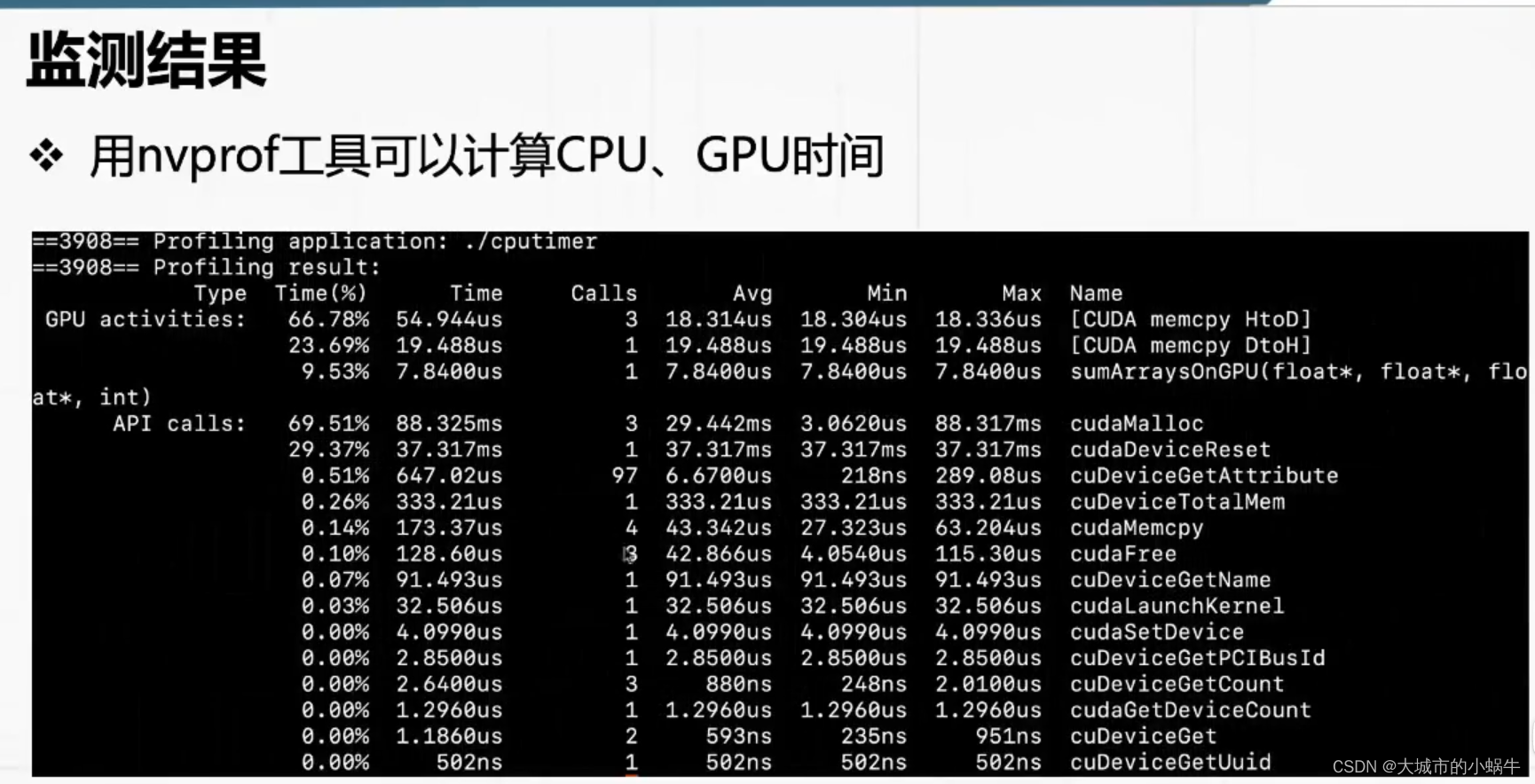

- 30.1 监测结果

- 30.2 使用方法

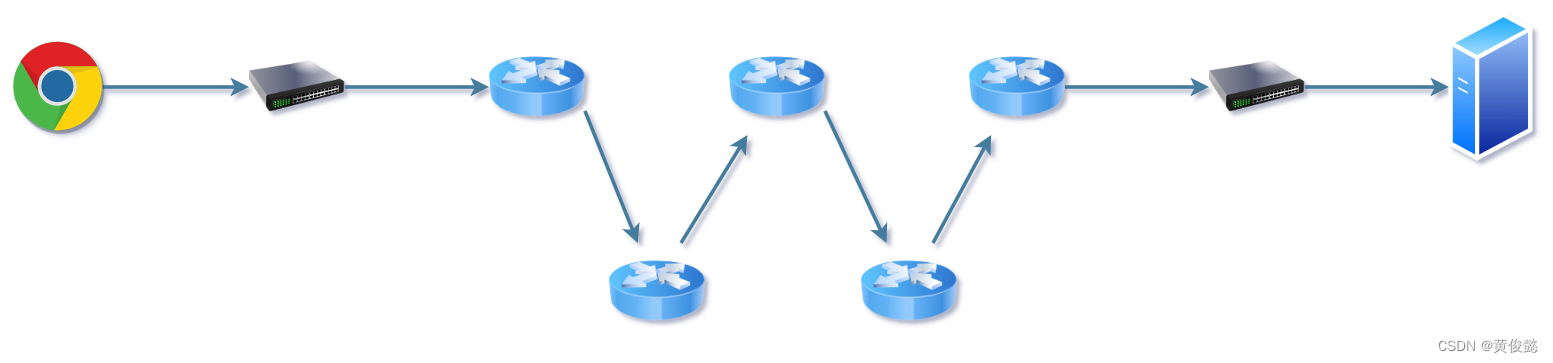

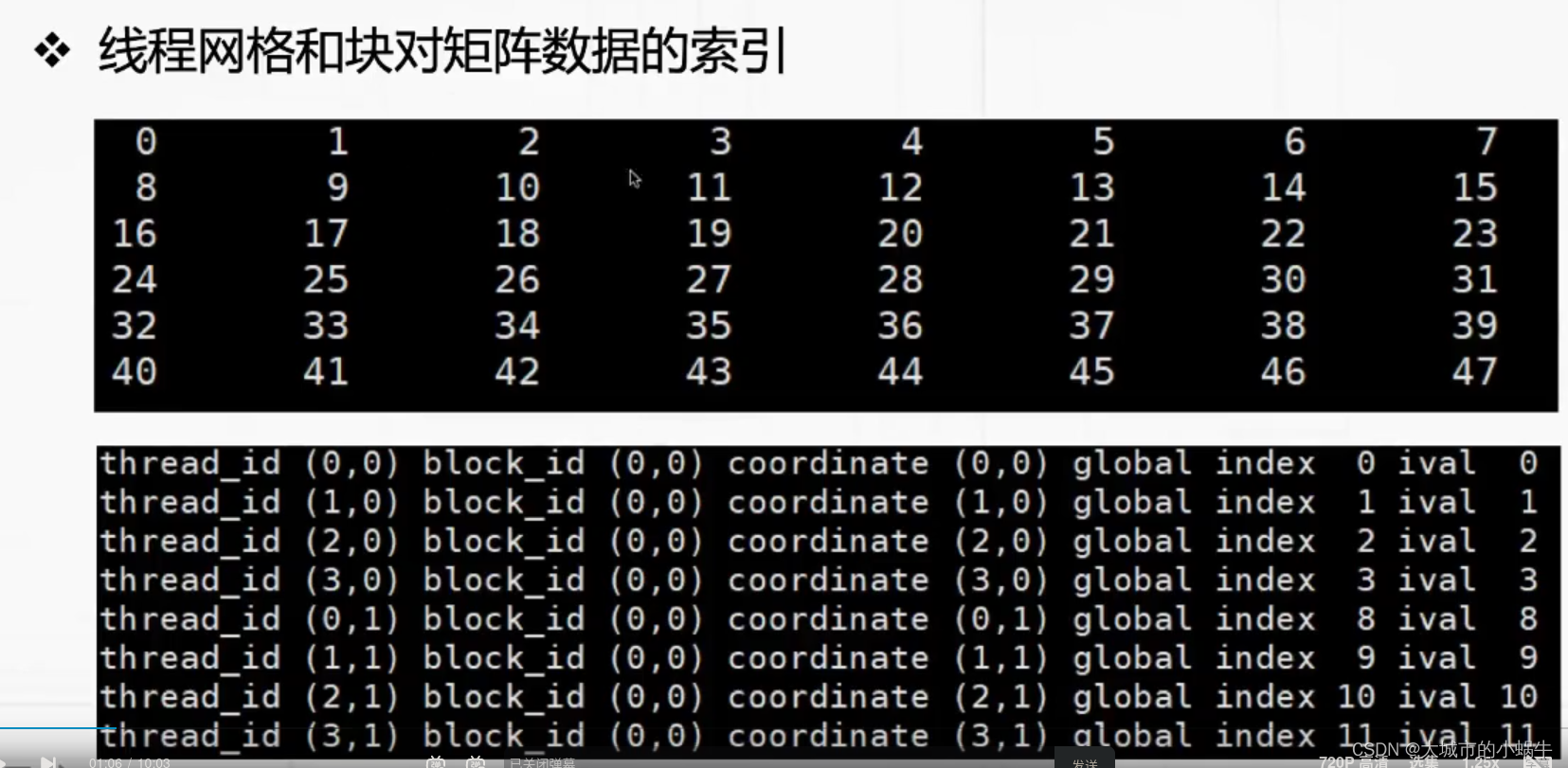

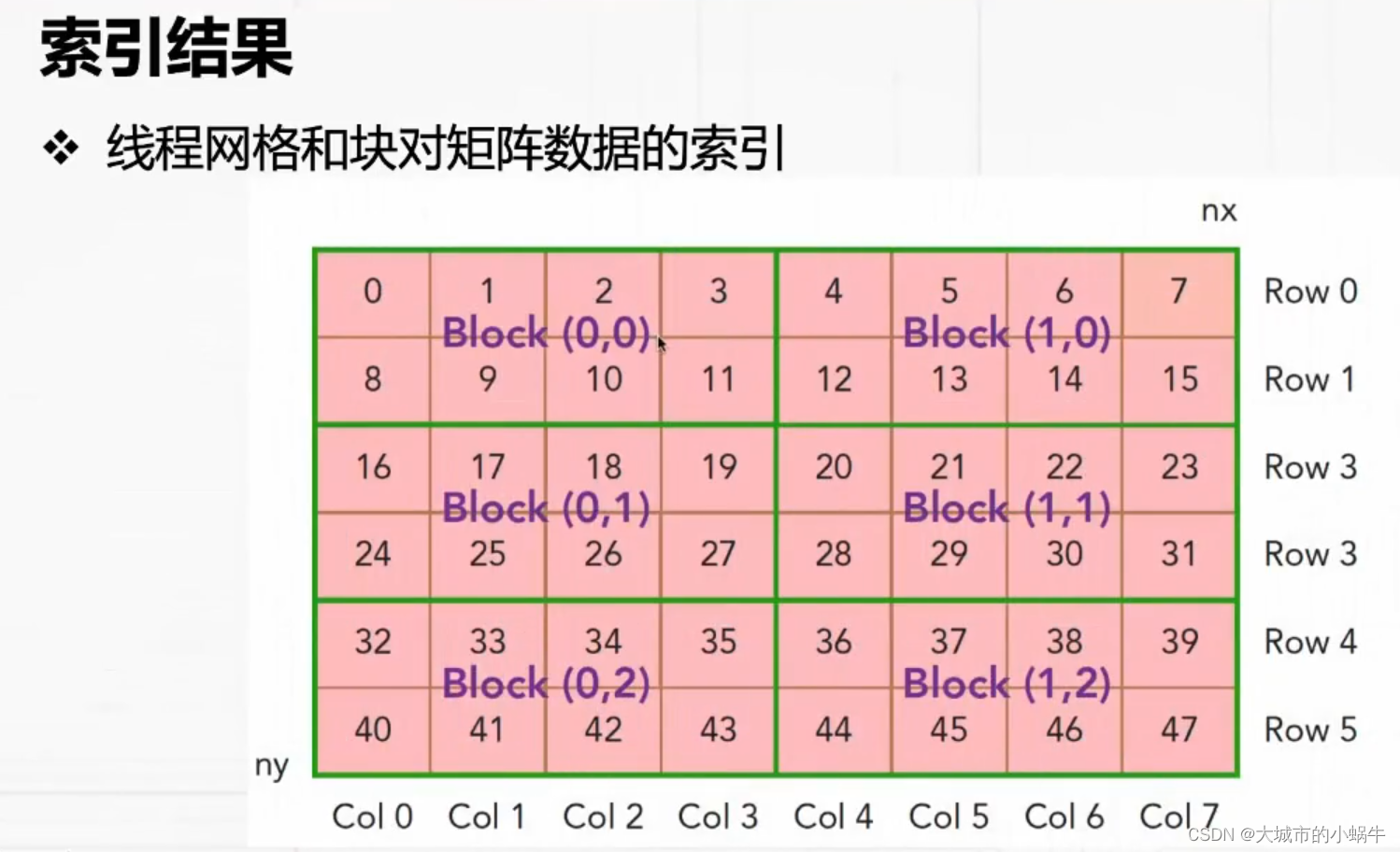

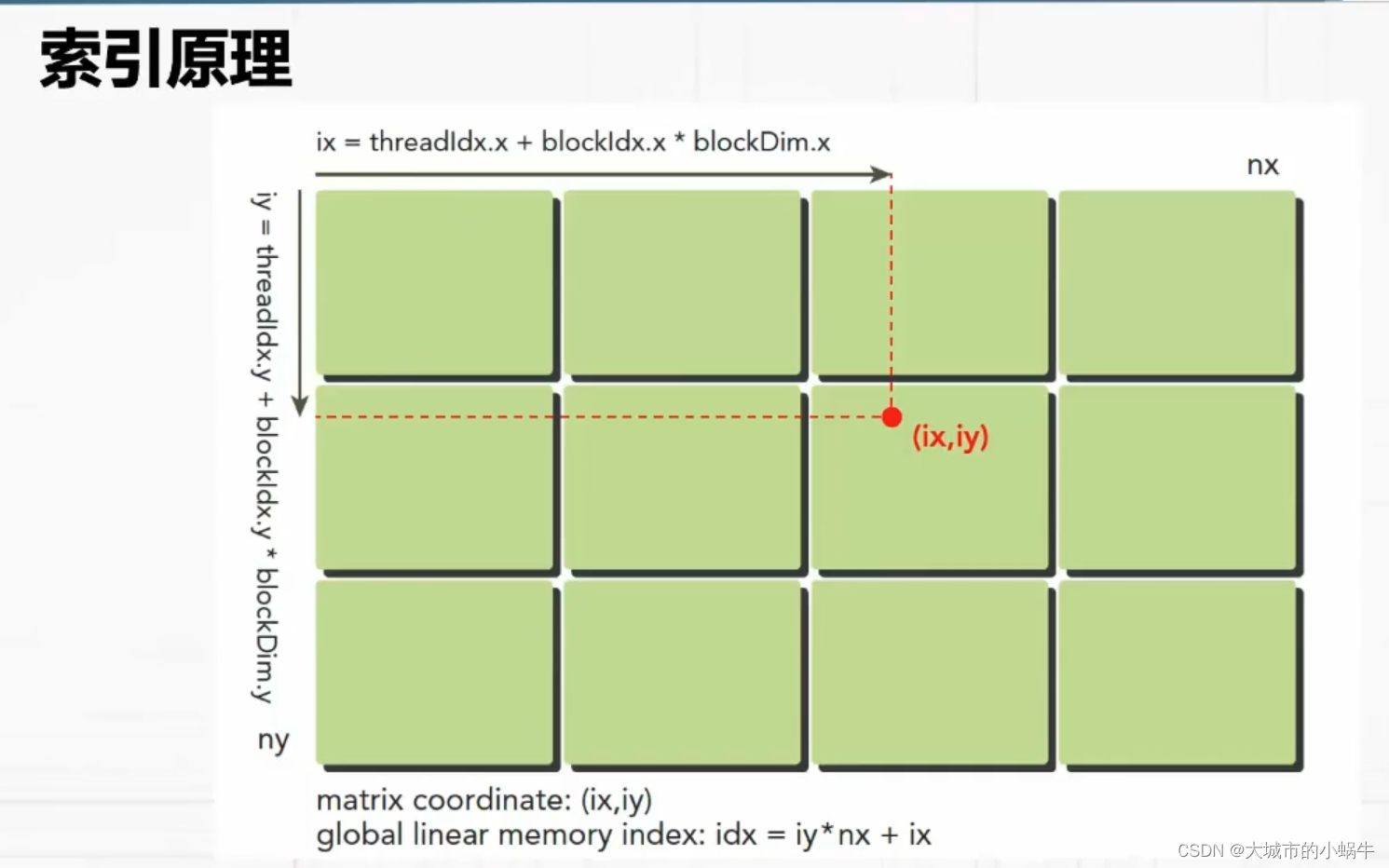

- 31. 用网格和块索引数据

- 31.1 索引结果

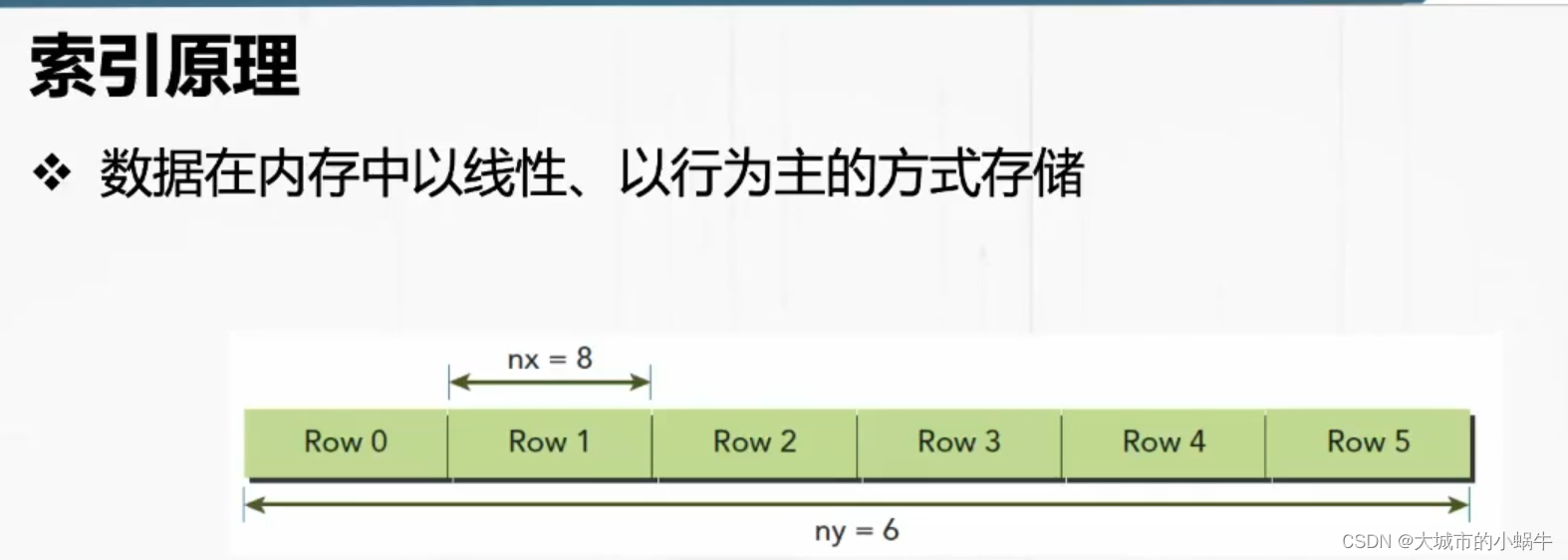

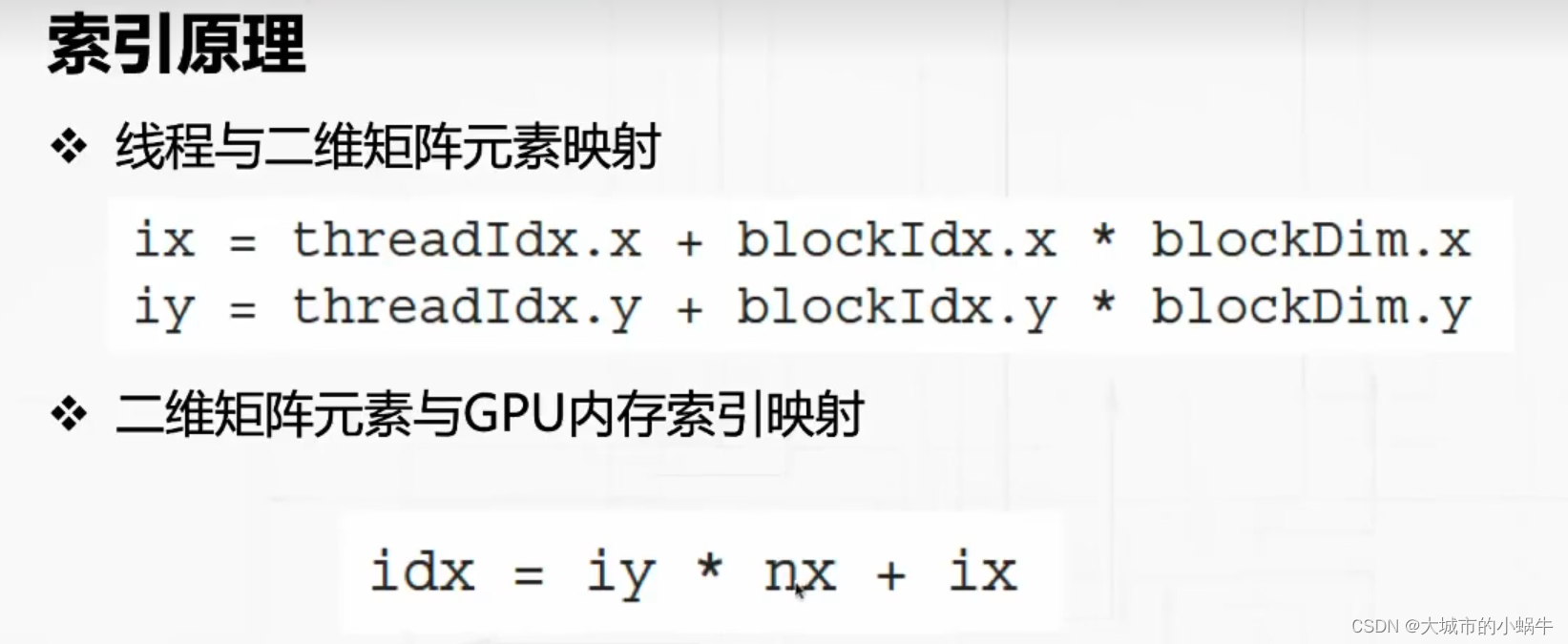

- 31.2 索引原理

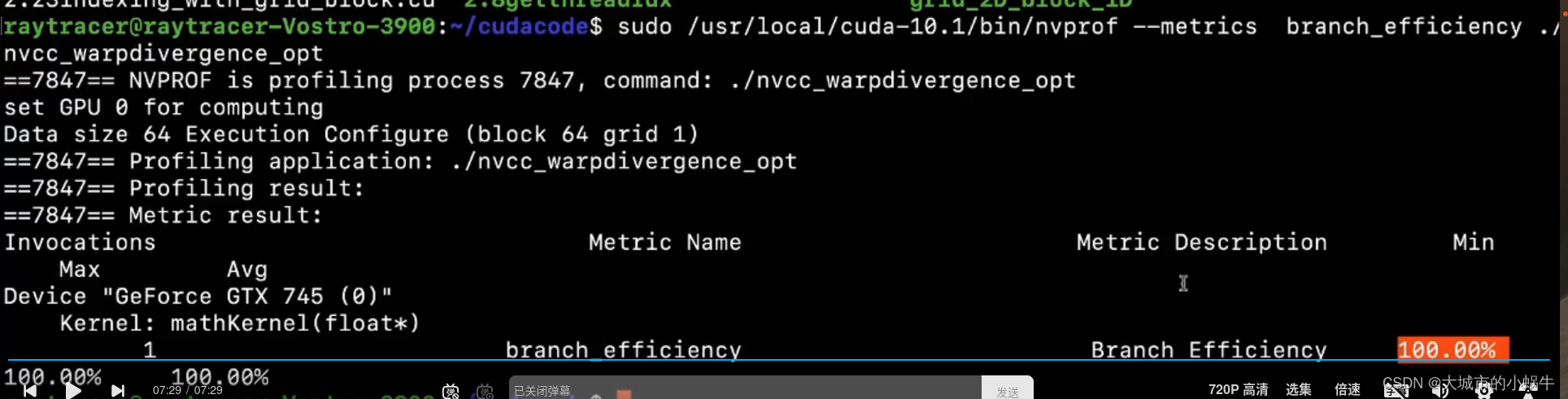

- 36. 线程束分支优化

- 37. 线程束分支特点

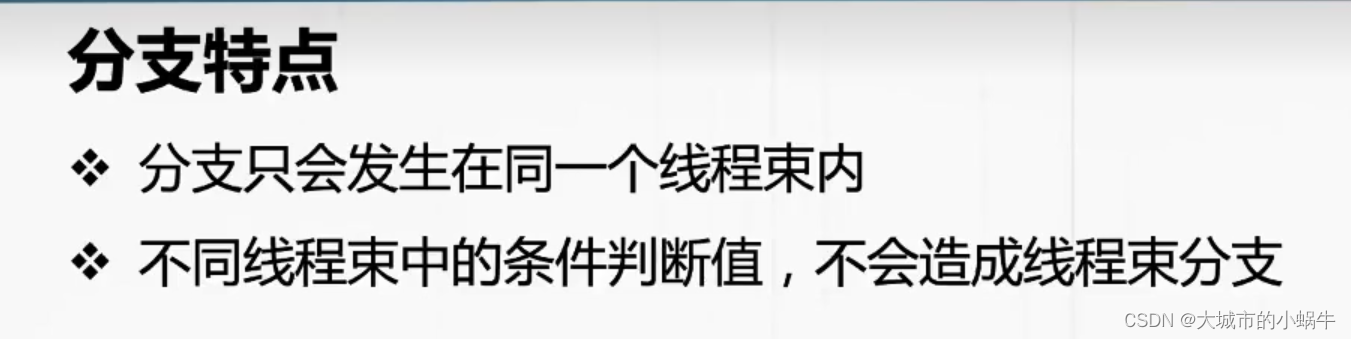

- 37.1 分支特点

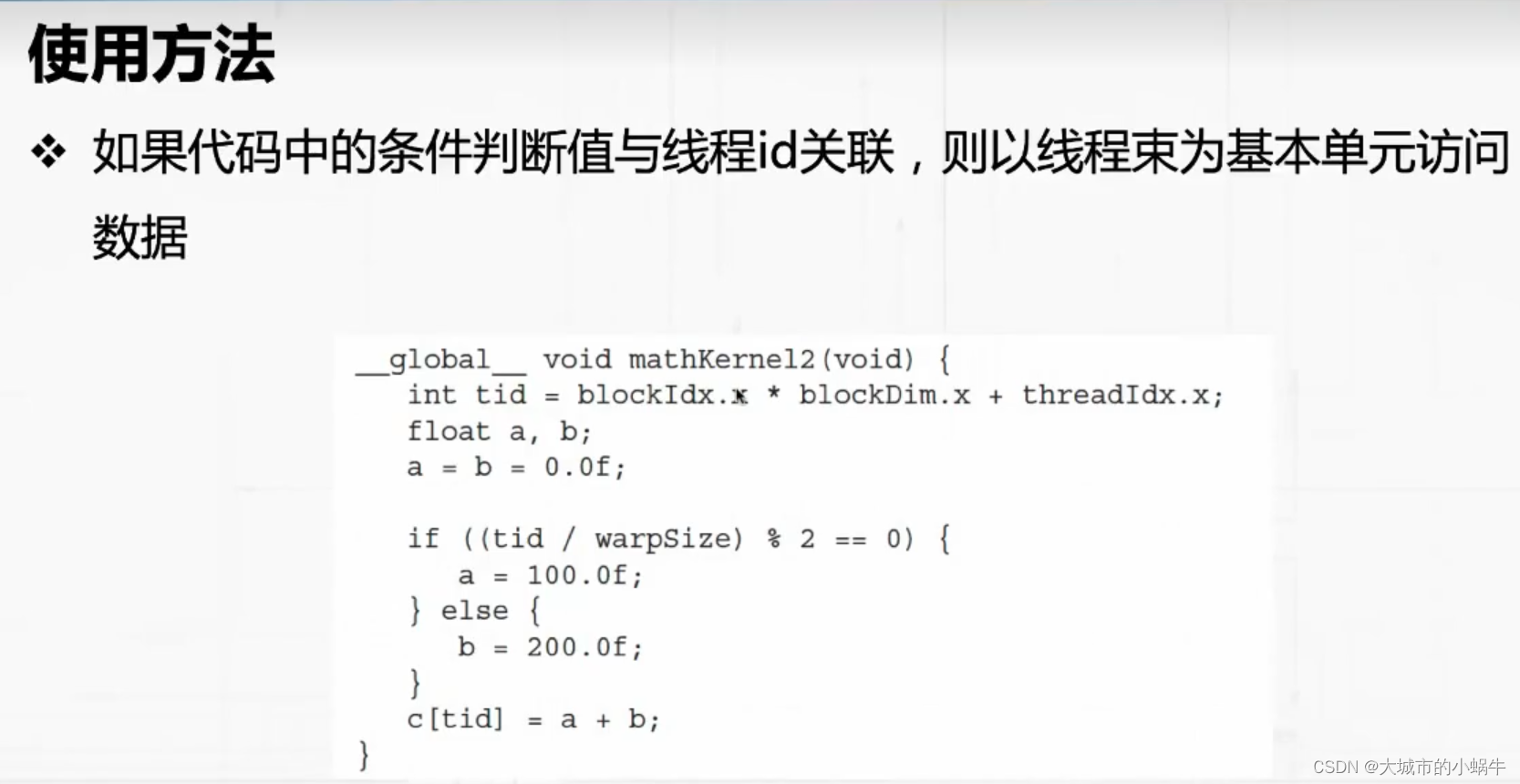

- 37.2 使用方法

- 38. 线程束计算资源分配

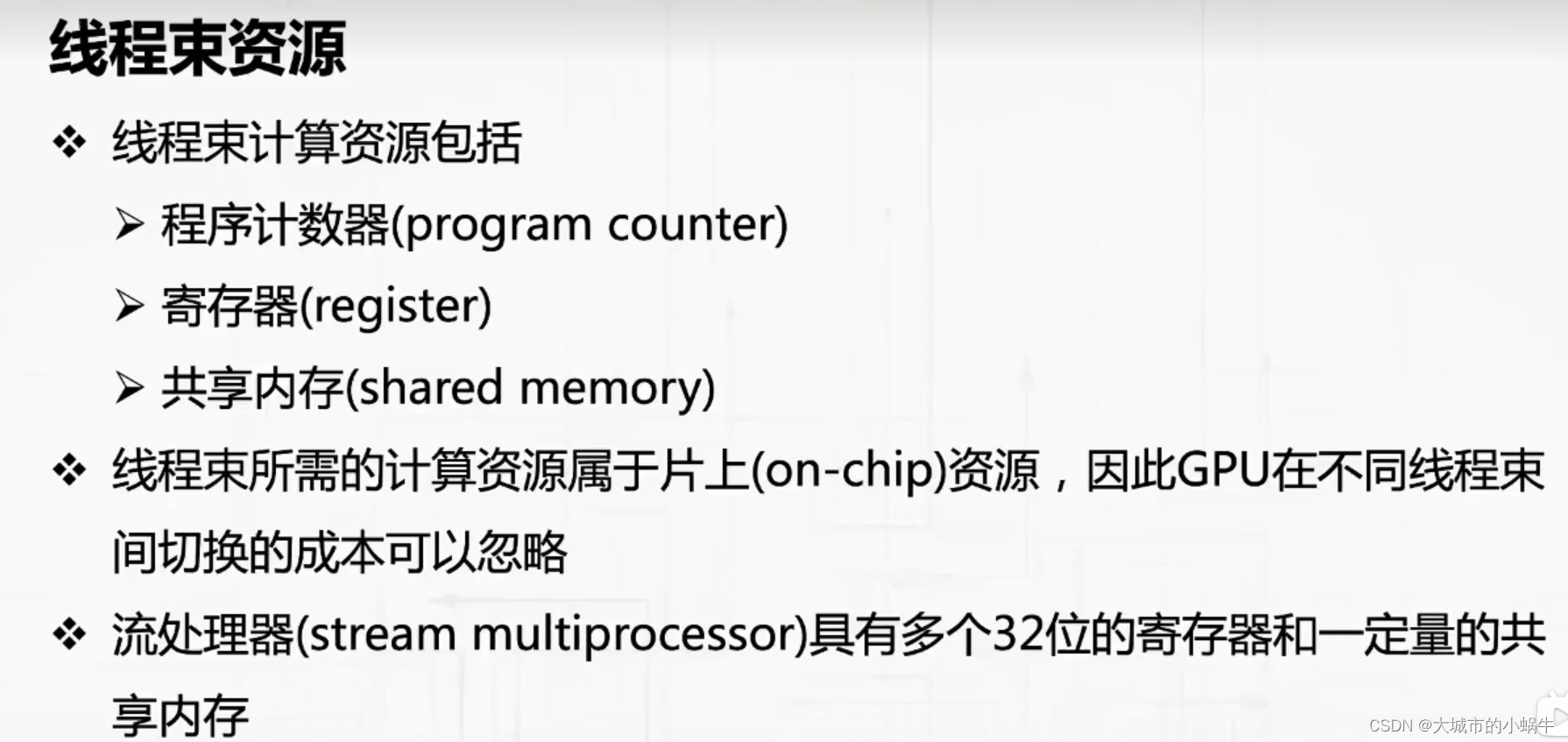

- 38.1 线程束资源

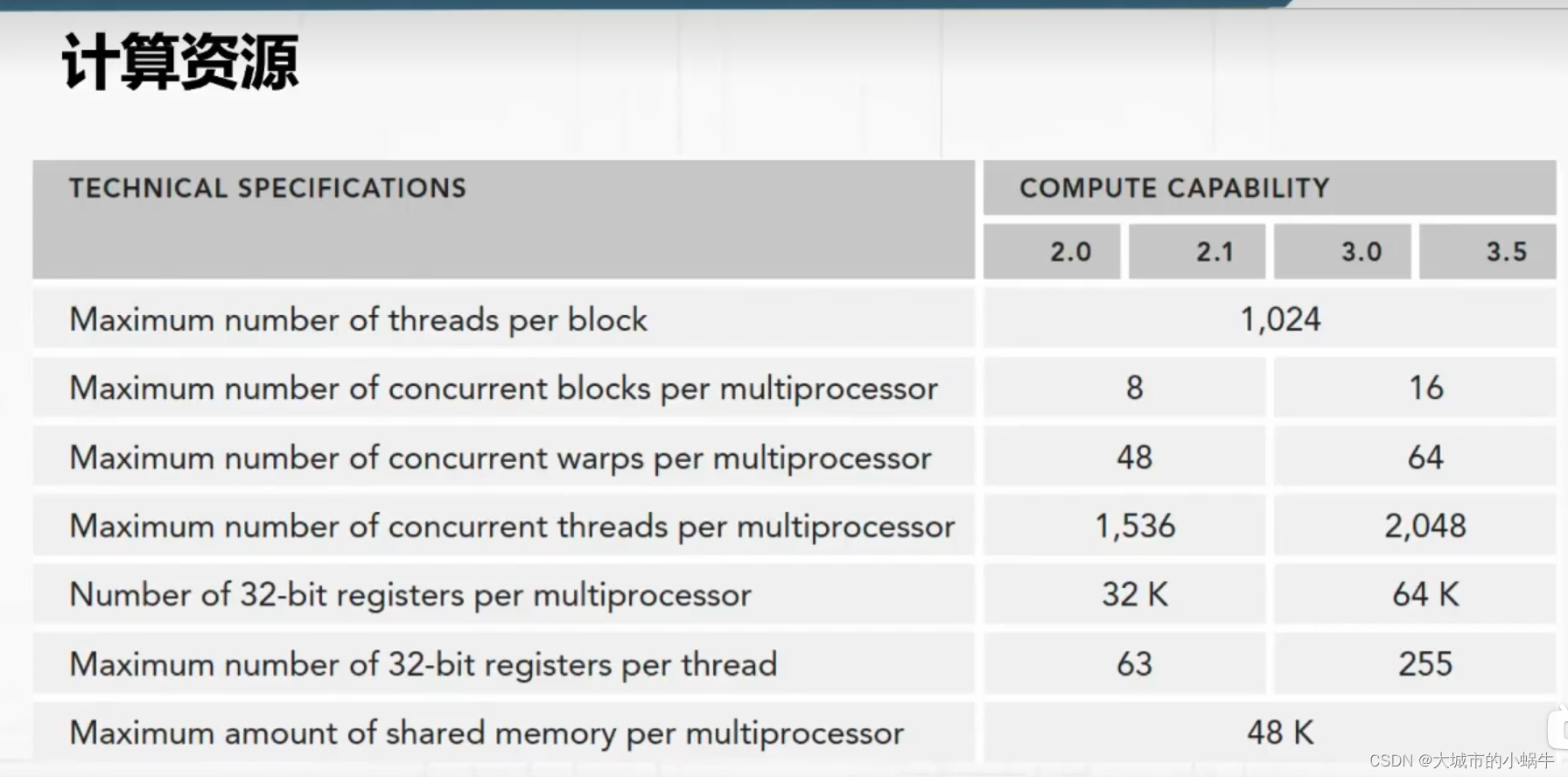

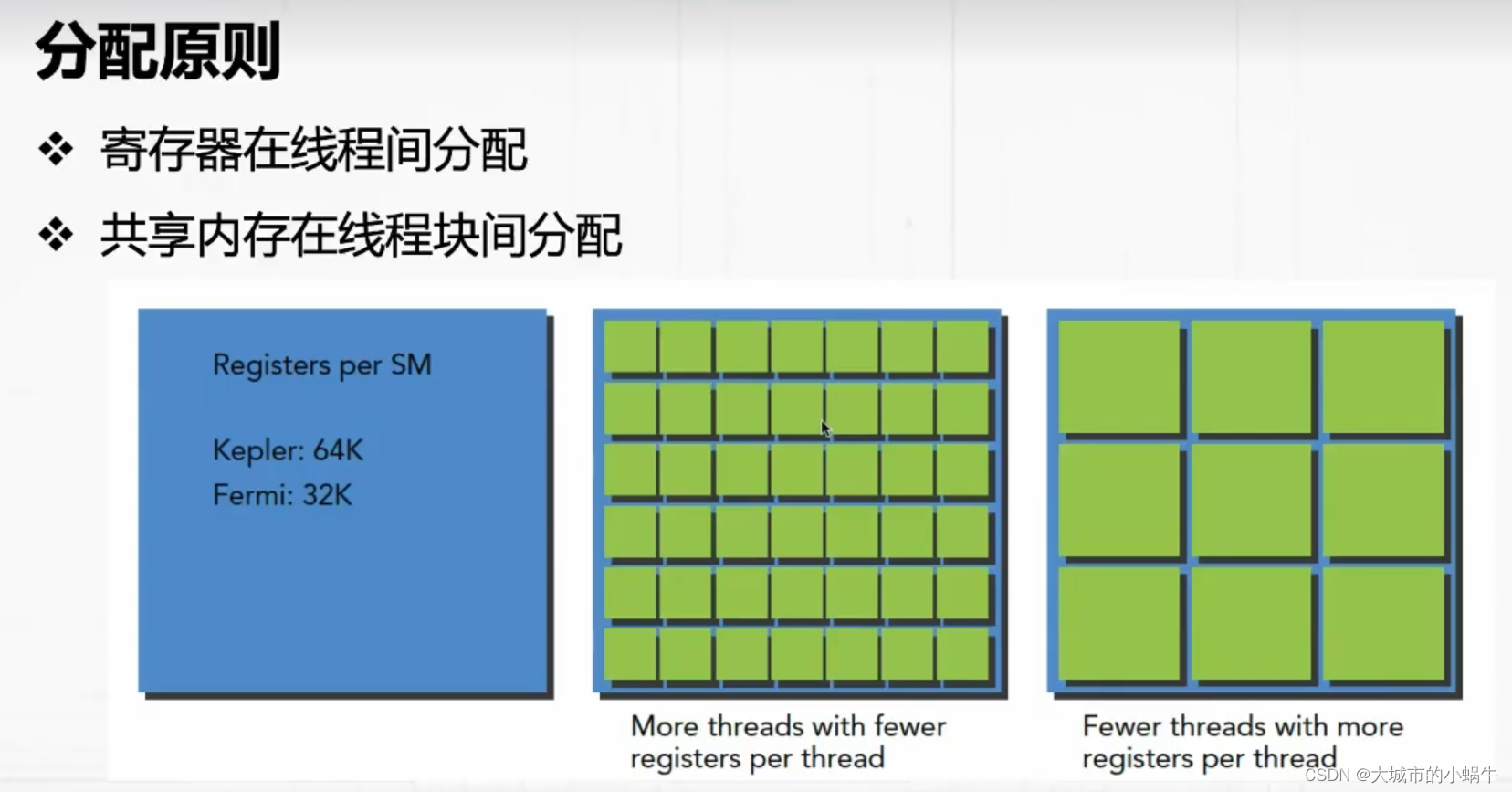

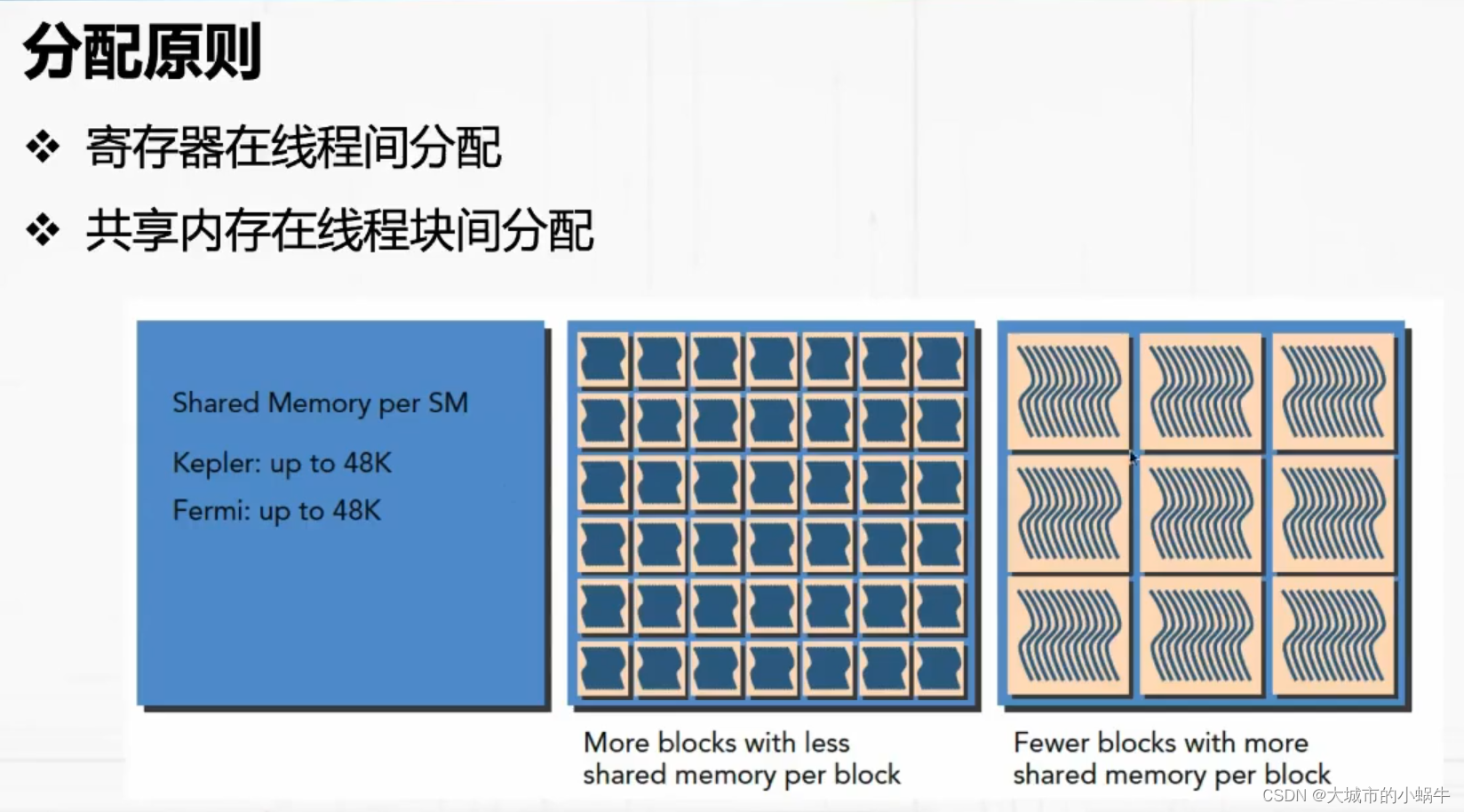

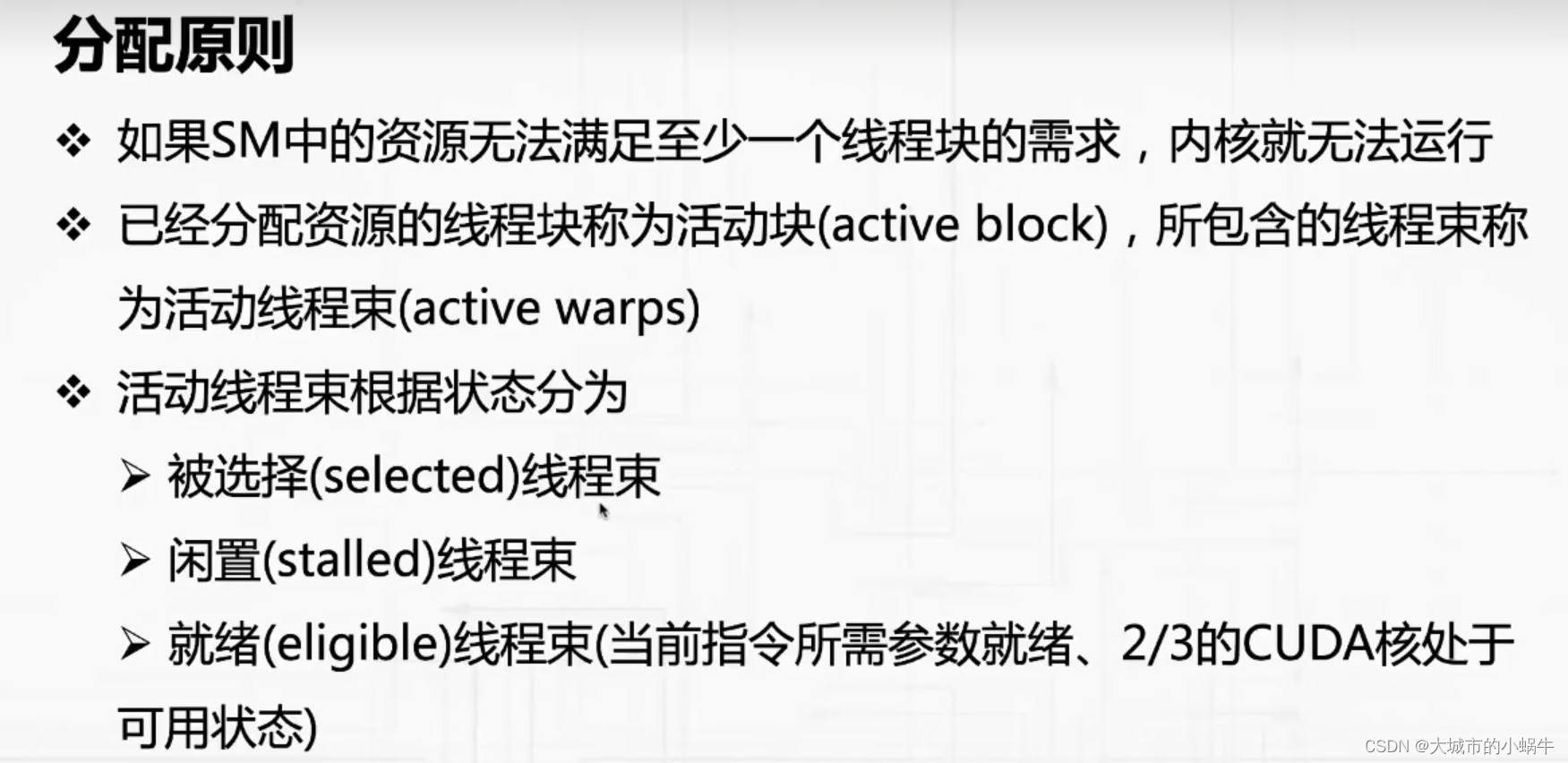

- 38.2 分配原则

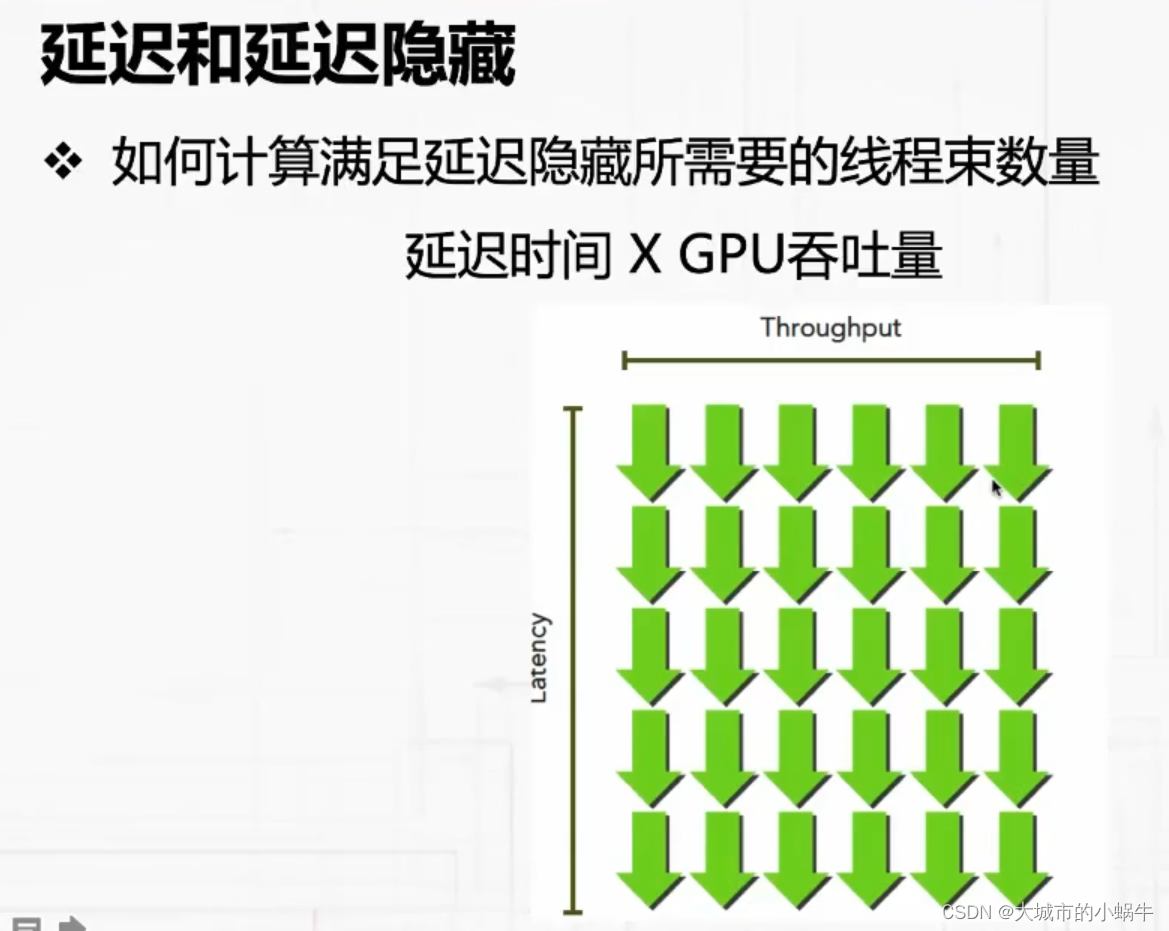

- 39. 指令延迟隐藏

- 39.1 延迟和延迟隐藏

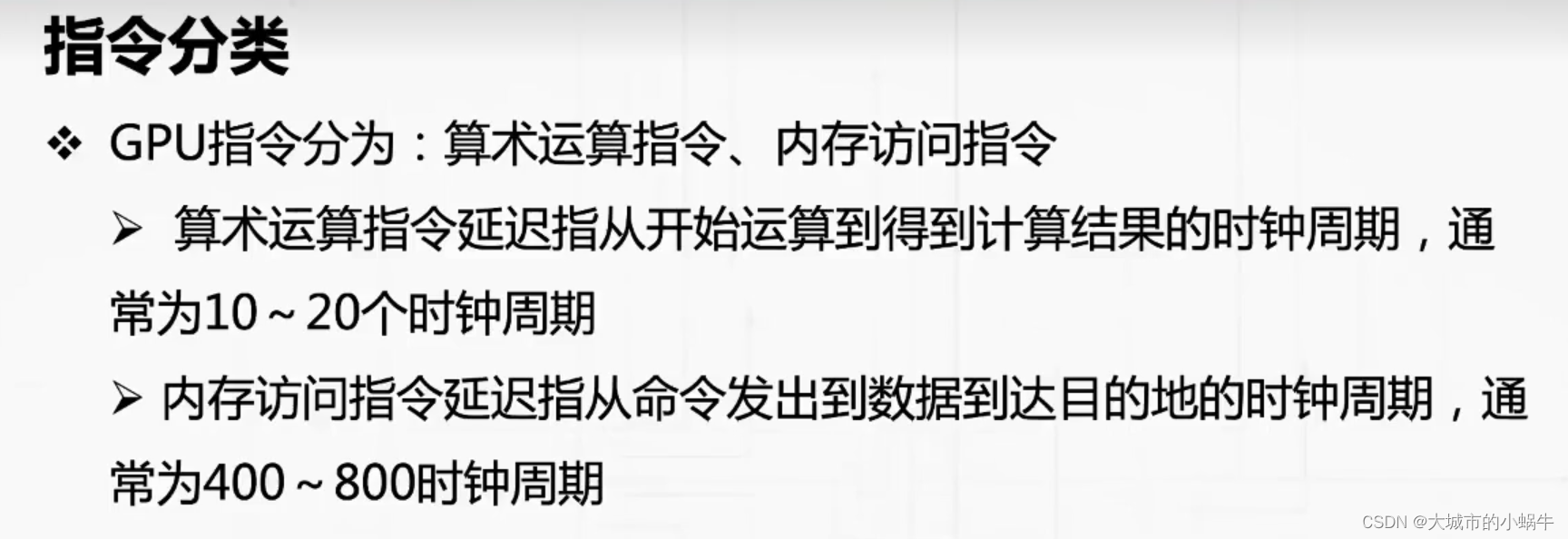

- 39.2 指令类型

- 40.算术运算指令并行性需求

- 40.1 并行性需求概念

- 40.2 并行性需求计算

- 41. 内存指令并行性需求

- 41.1 并行性需求概念

- 41.2 并行性需求计算

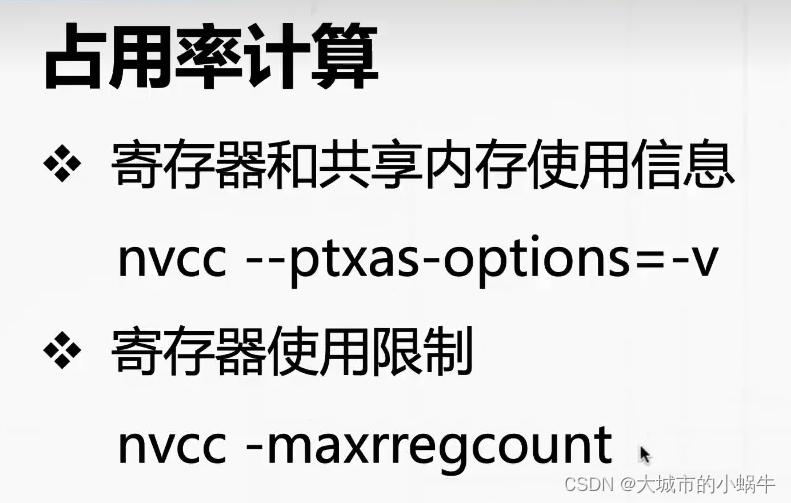

- 42. 流处理器占用率

- 42.1 占用率定义

- 42.2 占用率计算

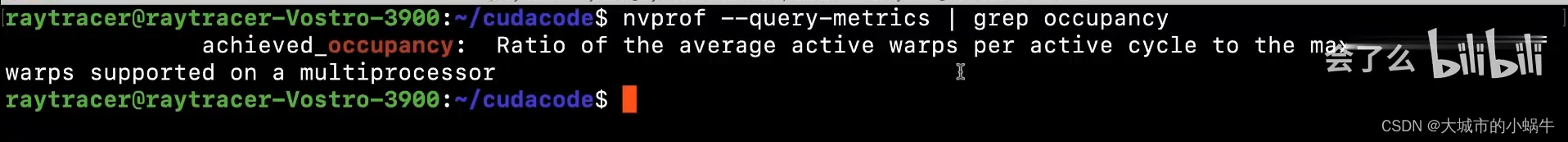

- 43. nvprof分析线程束和内存读写

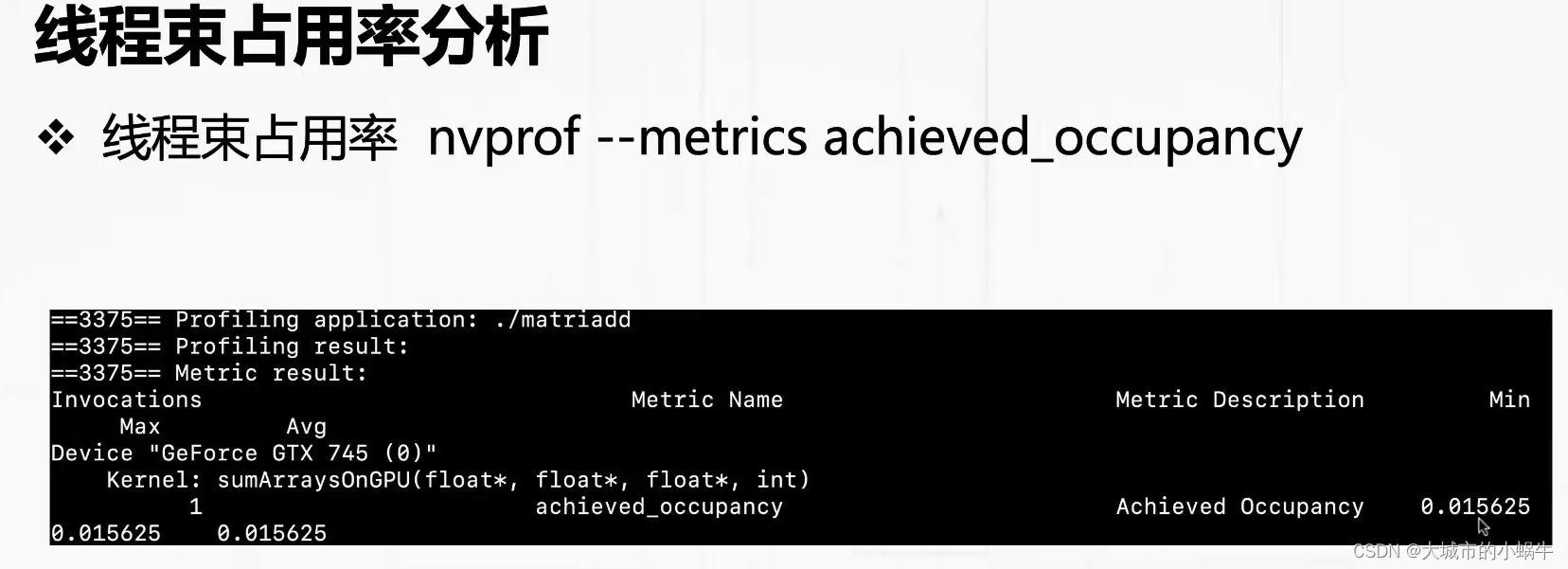

- 43.1 线程束占用率分析

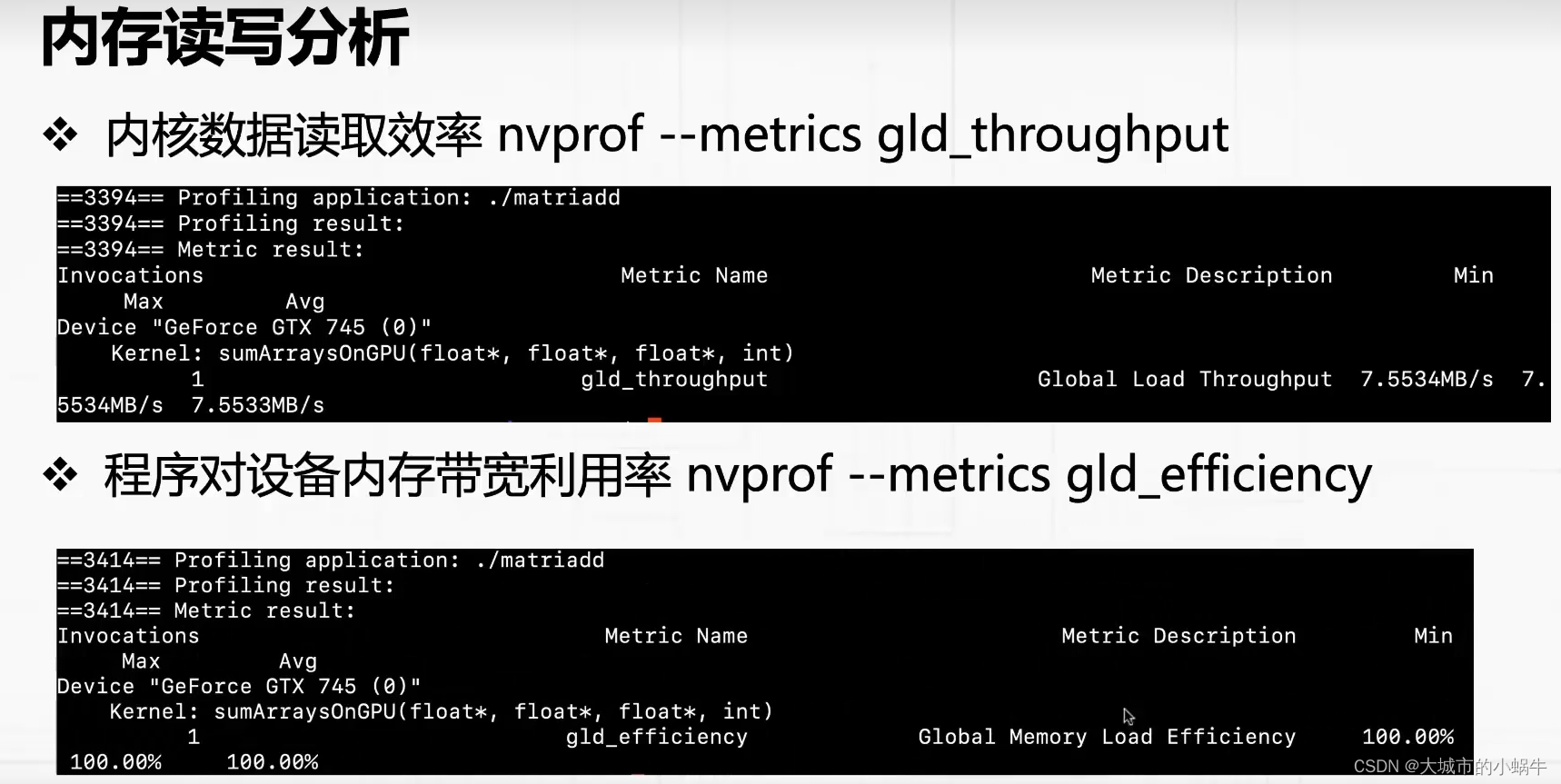

- 43.2 内存读写分析

- 44. 邻域并行计算

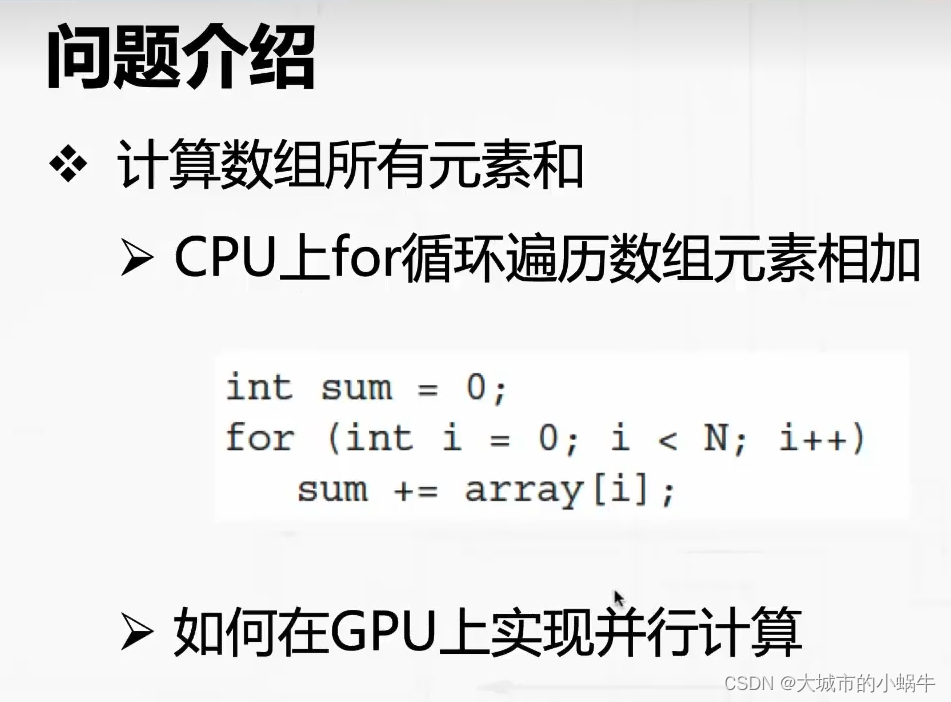

- 44.1 问题介绍

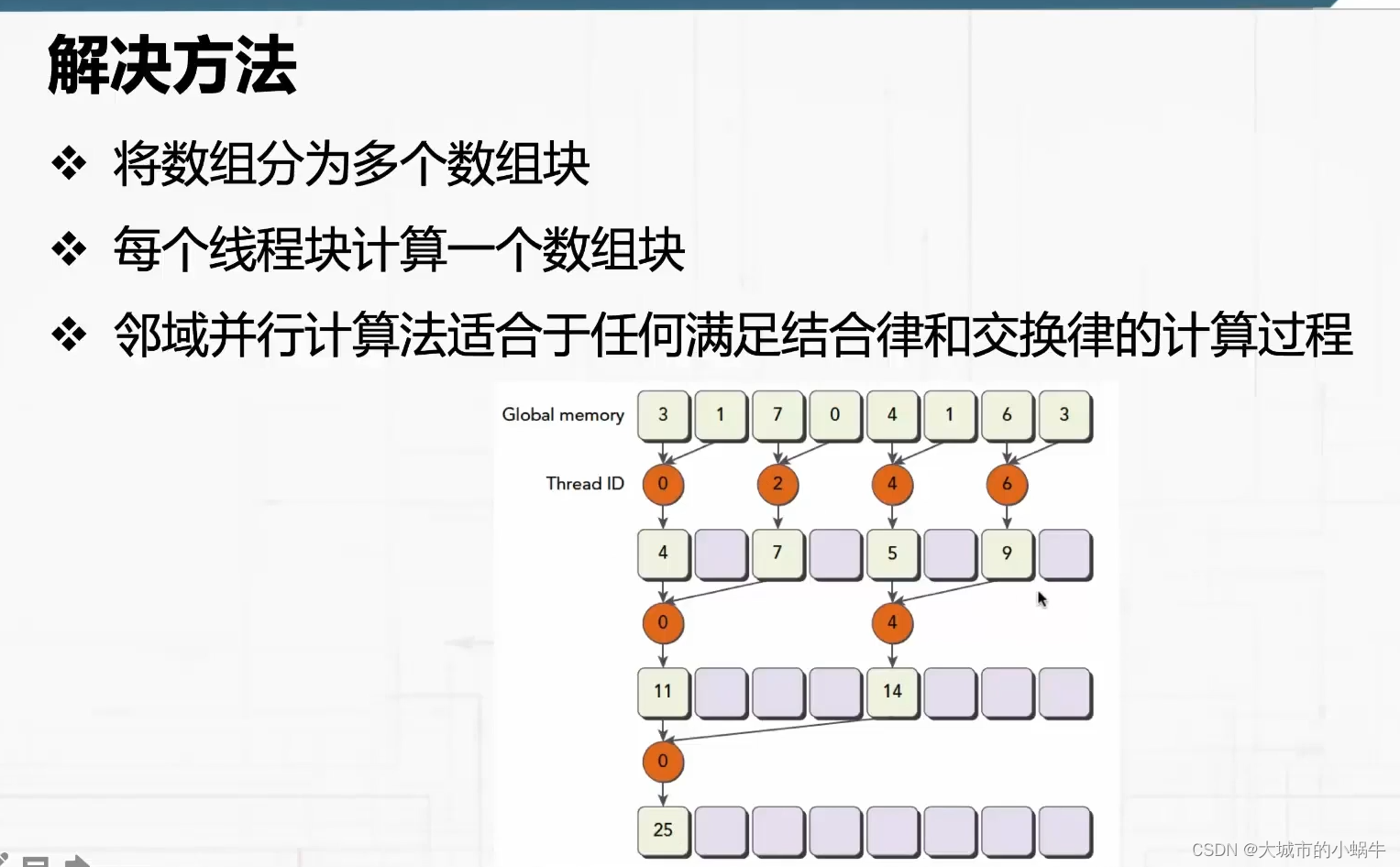

- 44.2 解决办法

- 45. 间域并行计算

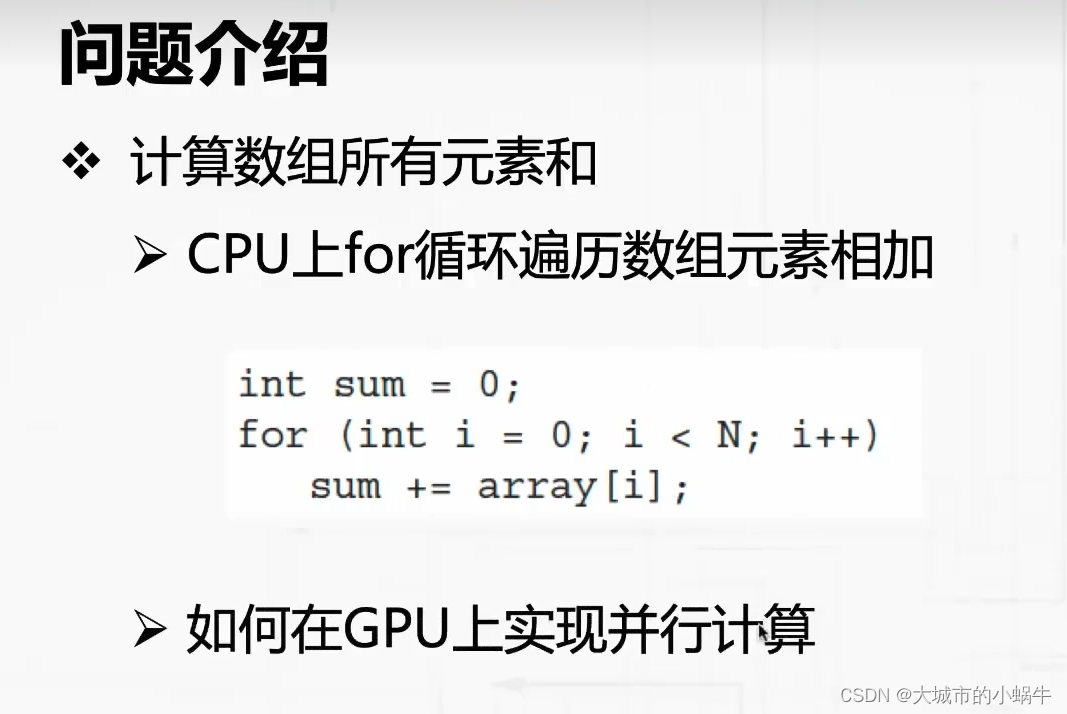

- 45.1 问题介绍

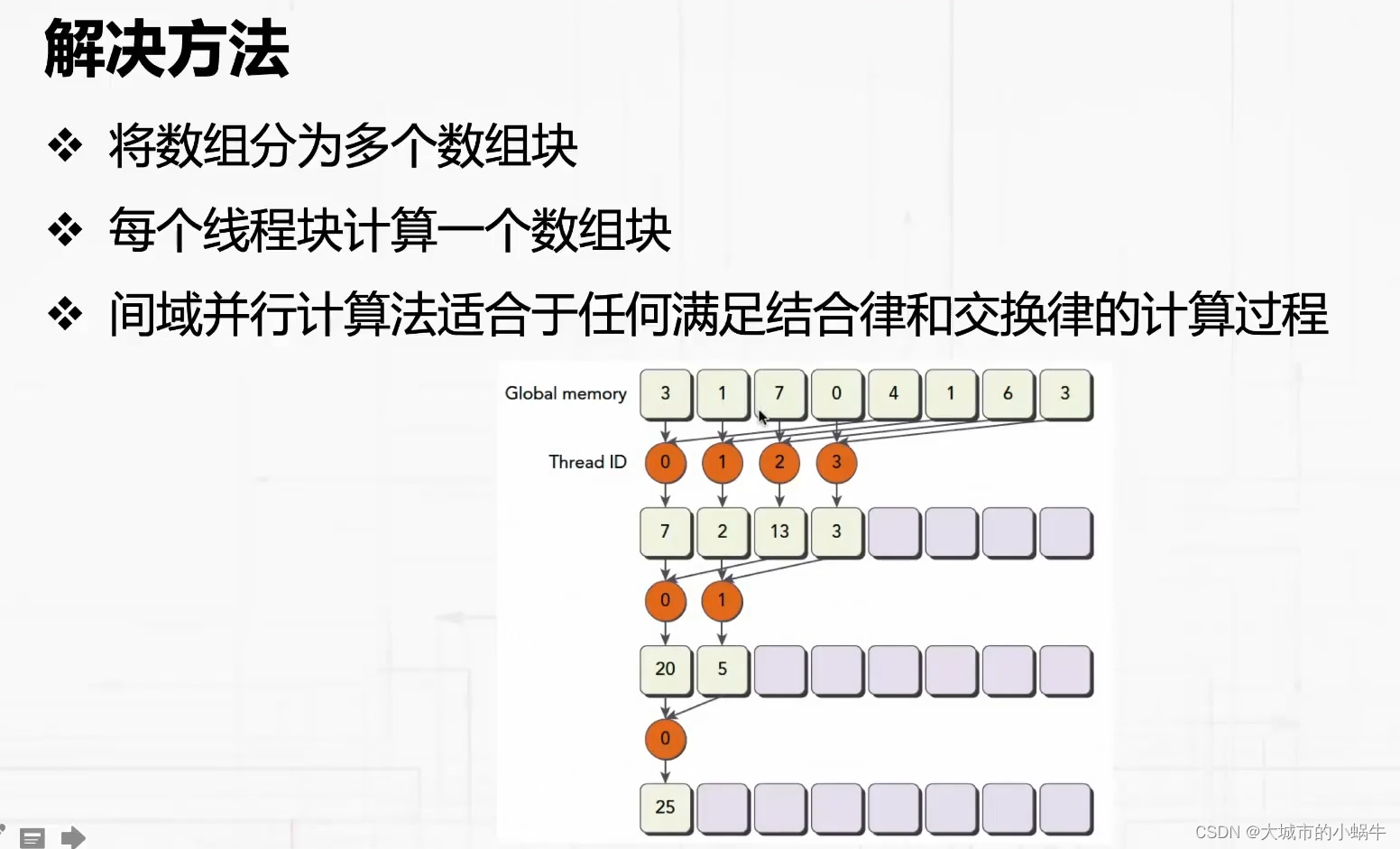

- 45.2 解决办法

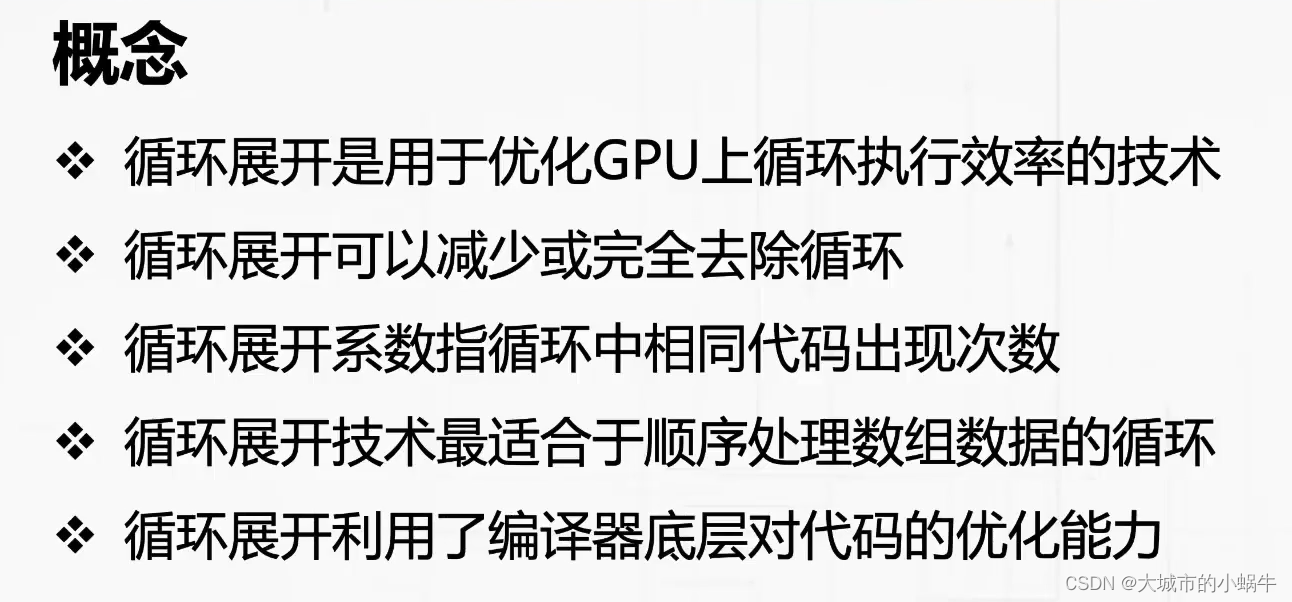

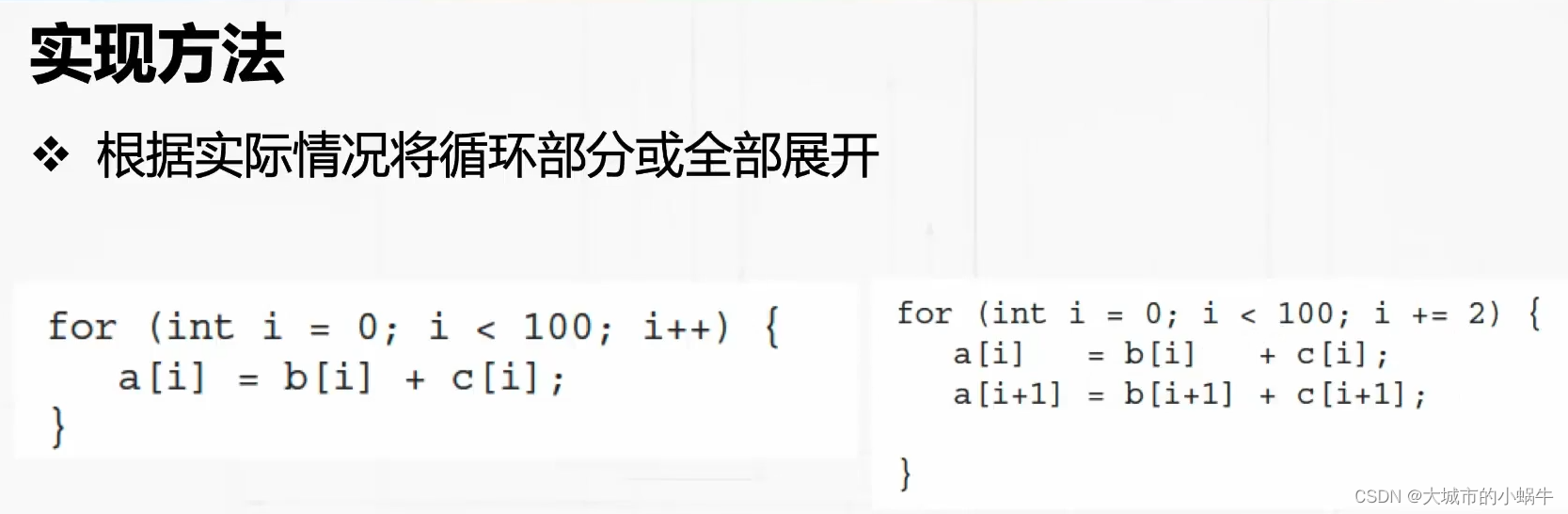

- 46. 循环展开

- 46.1 概念

- 46.2 实现方法

- 47. 模板函数

- 47.1 模板函数定义

- 47.2 模板函数使用

- 48. GPU动态并行

- 48.1 动态并行概念

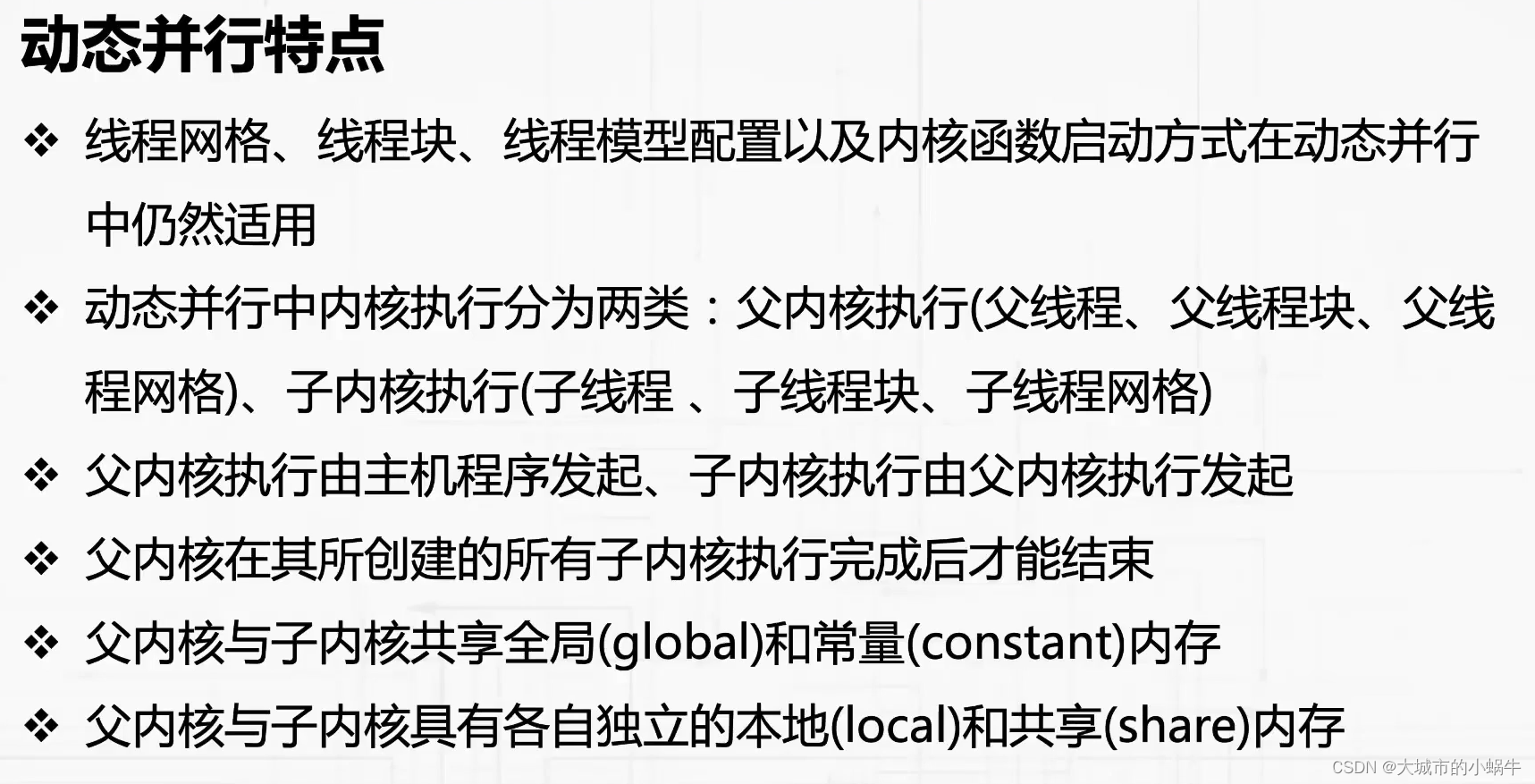

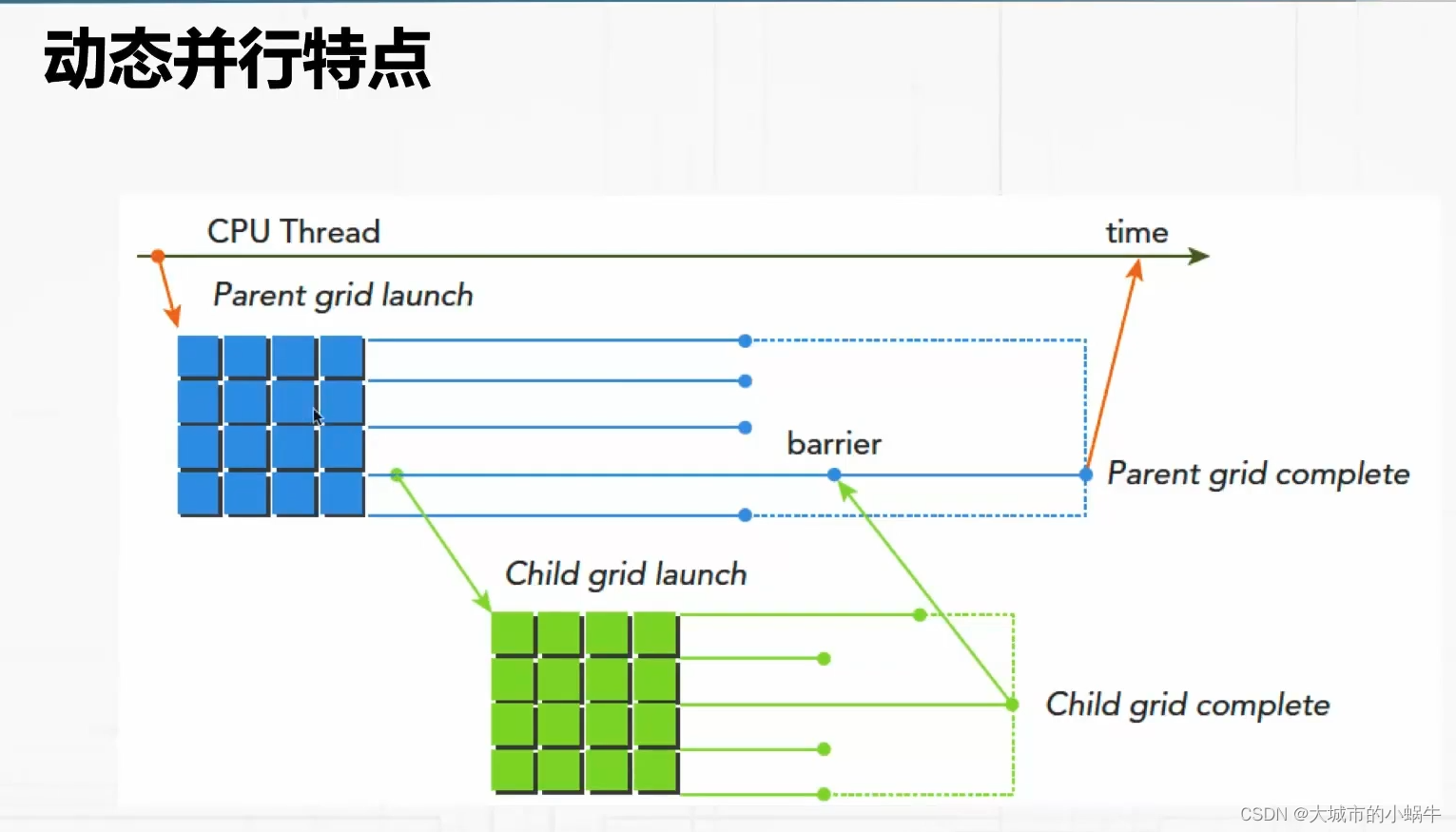

- 48.2 动态并行特点

- 49. 动态并行HelloWorld

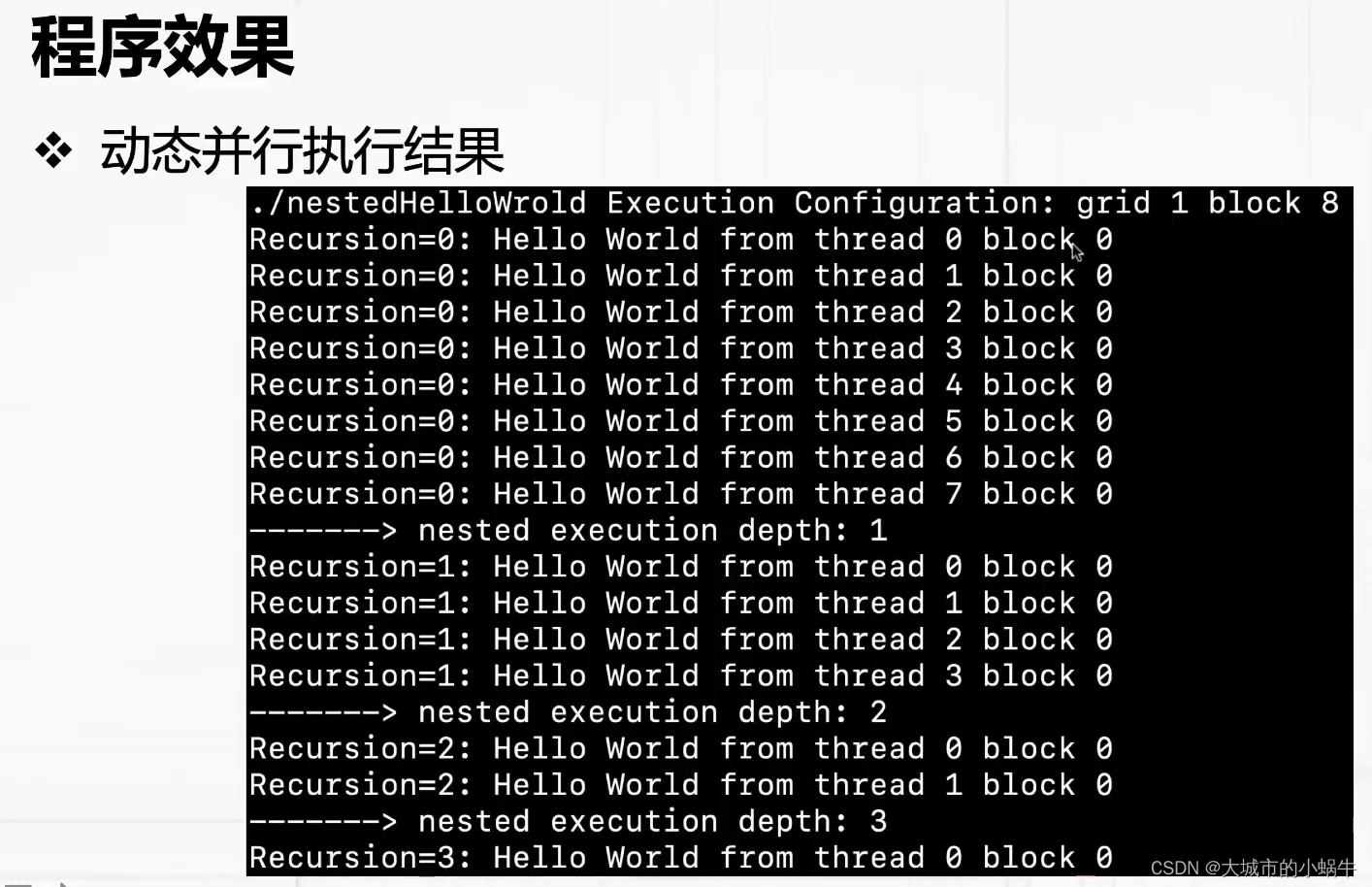

- 49.1 程序效果

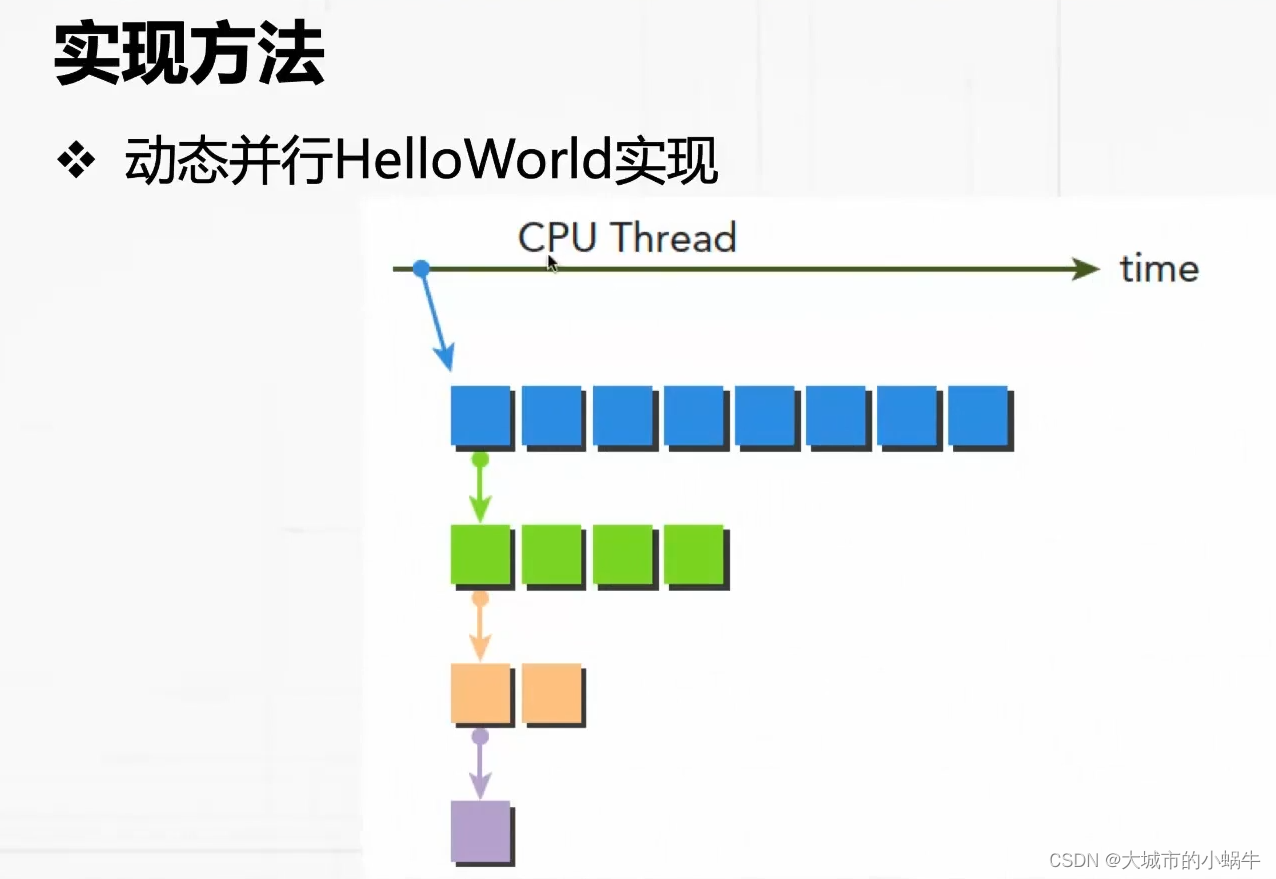

- 49.2 实现方法

- 50. 本地化原则

- 50.1 本地化原则

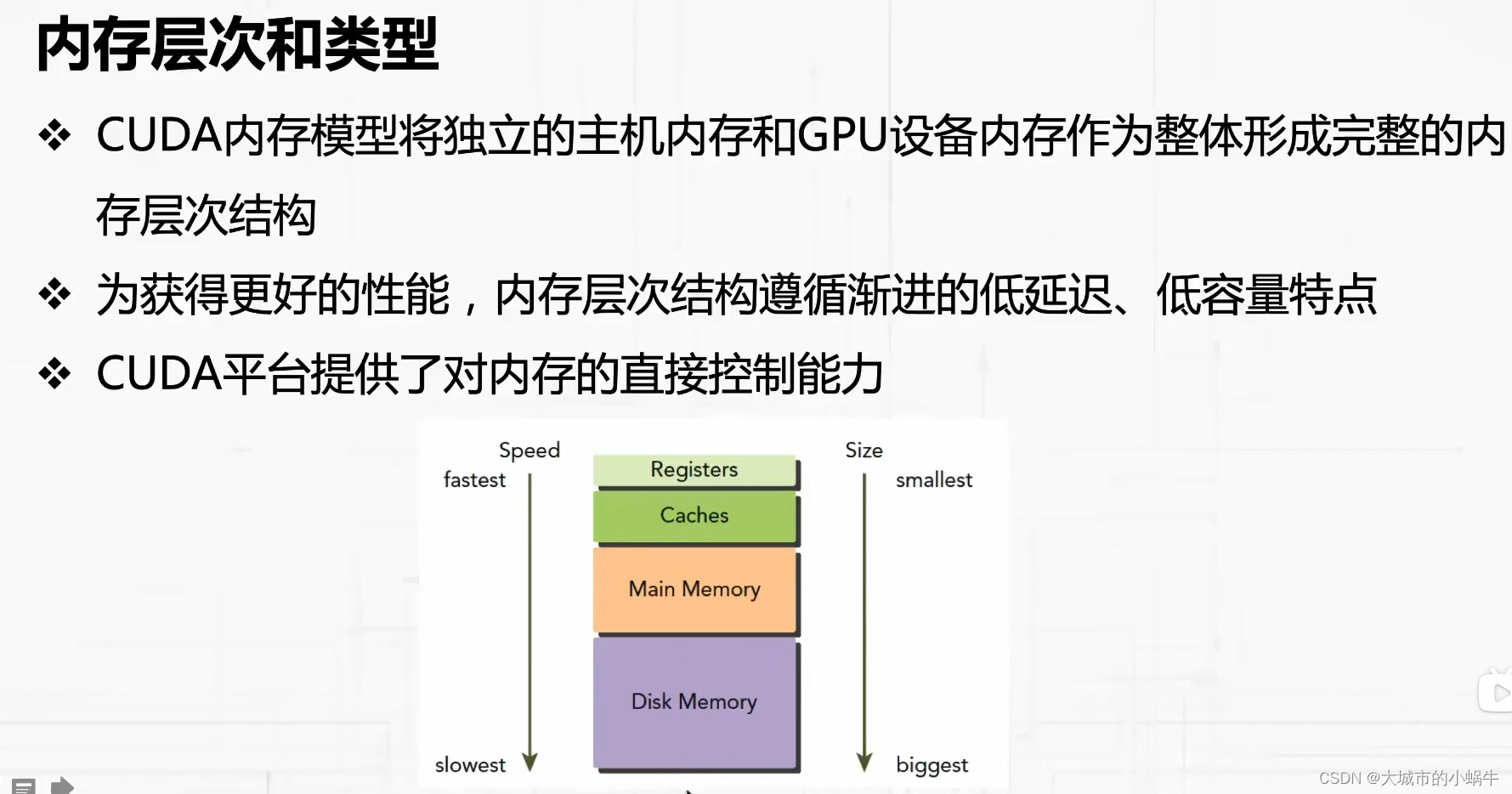

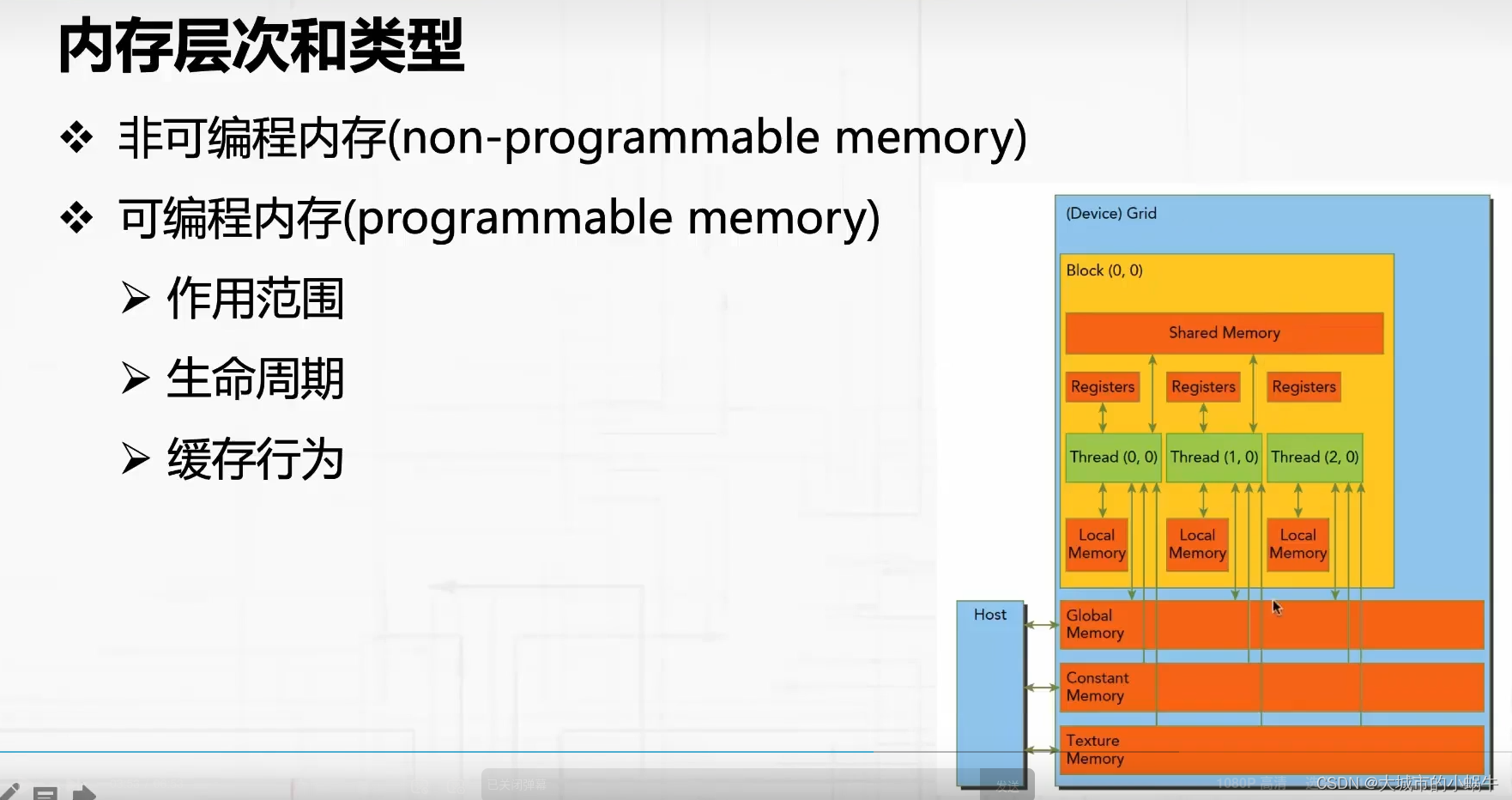

- 50.2 内存层次和类型

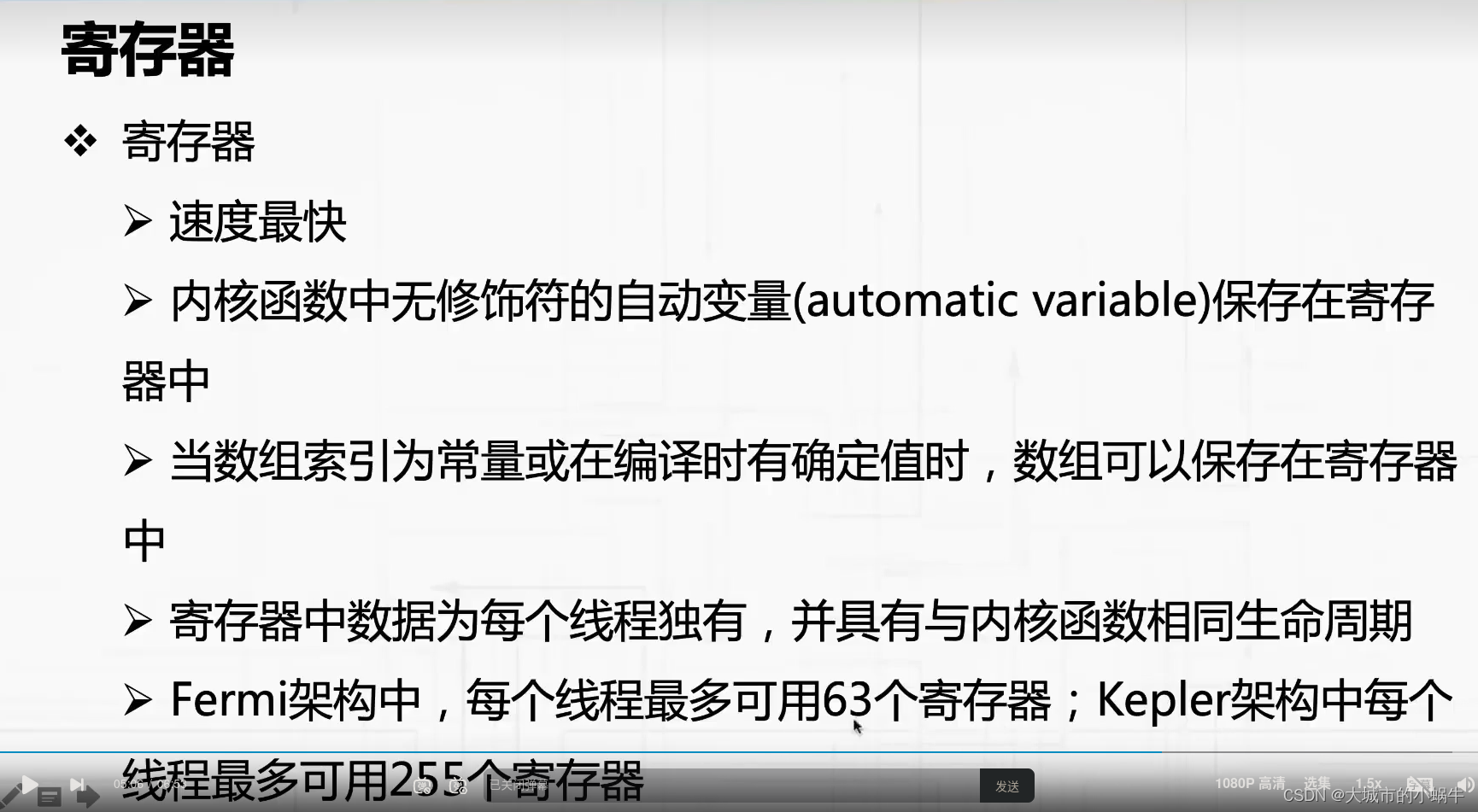

- 50.3 寄存器

29. 检测内核执行时间

29.1 CPU计时器

29.2 内核同步

30. nvprof监测内核执行时间

30.1 监测结果

30.2 使用方法

31. 用网格和块索引数据

31.1 索引结果

31.2 索引原理

36. 线程束分支优化

37. 线程束分支特点

37.1 分支特点

37.2 使用方法

38. 线程束计算资源分配

38.1 线程束资源

38.2 分配原则

39. 指令延迟隐藏

39.1 延迟和延迟隐藏

39.2 指令类型

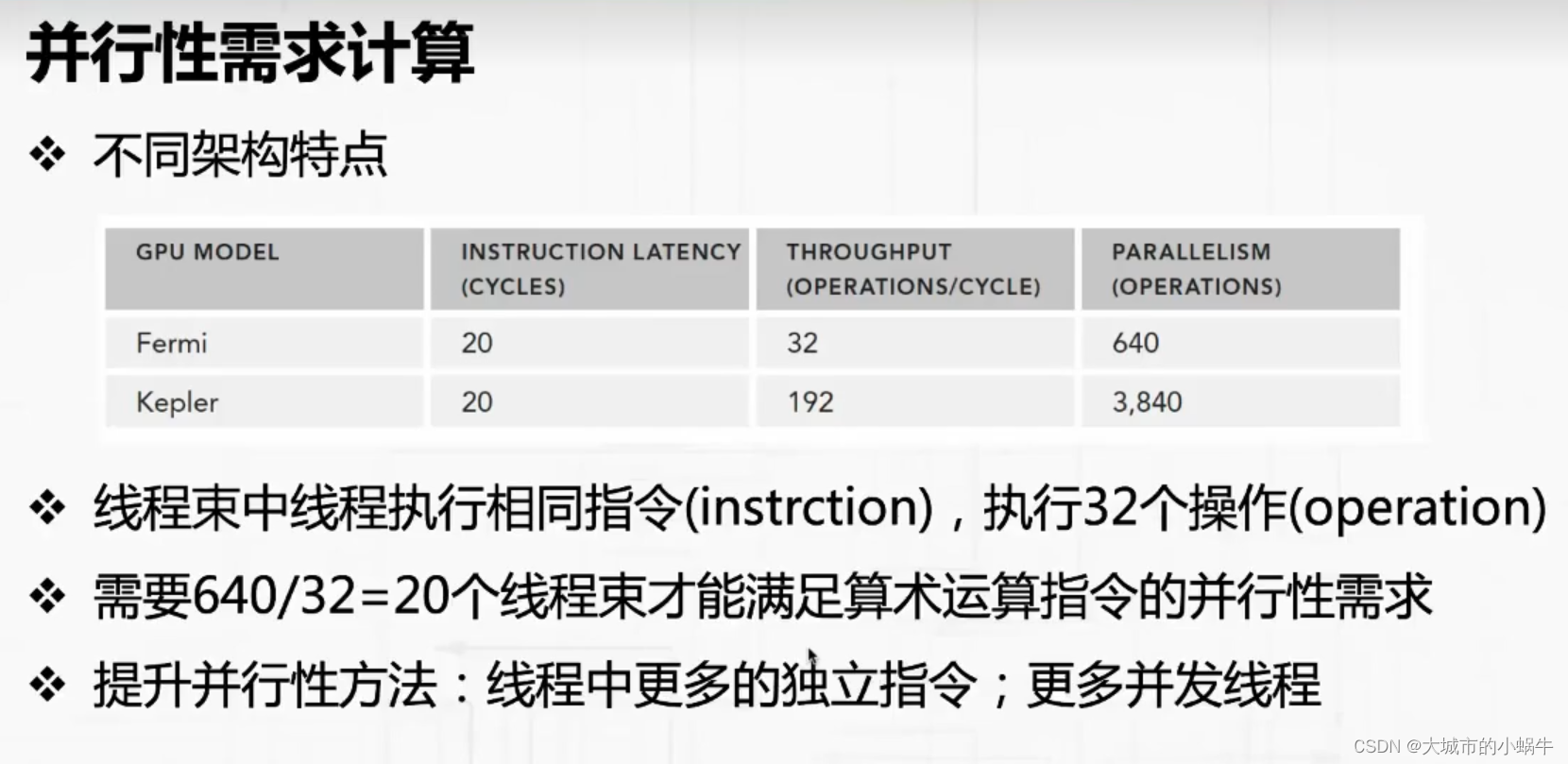

40.算术运算指令并行性需求

40.1 并行性需求概念

40.2 并行性需求计算

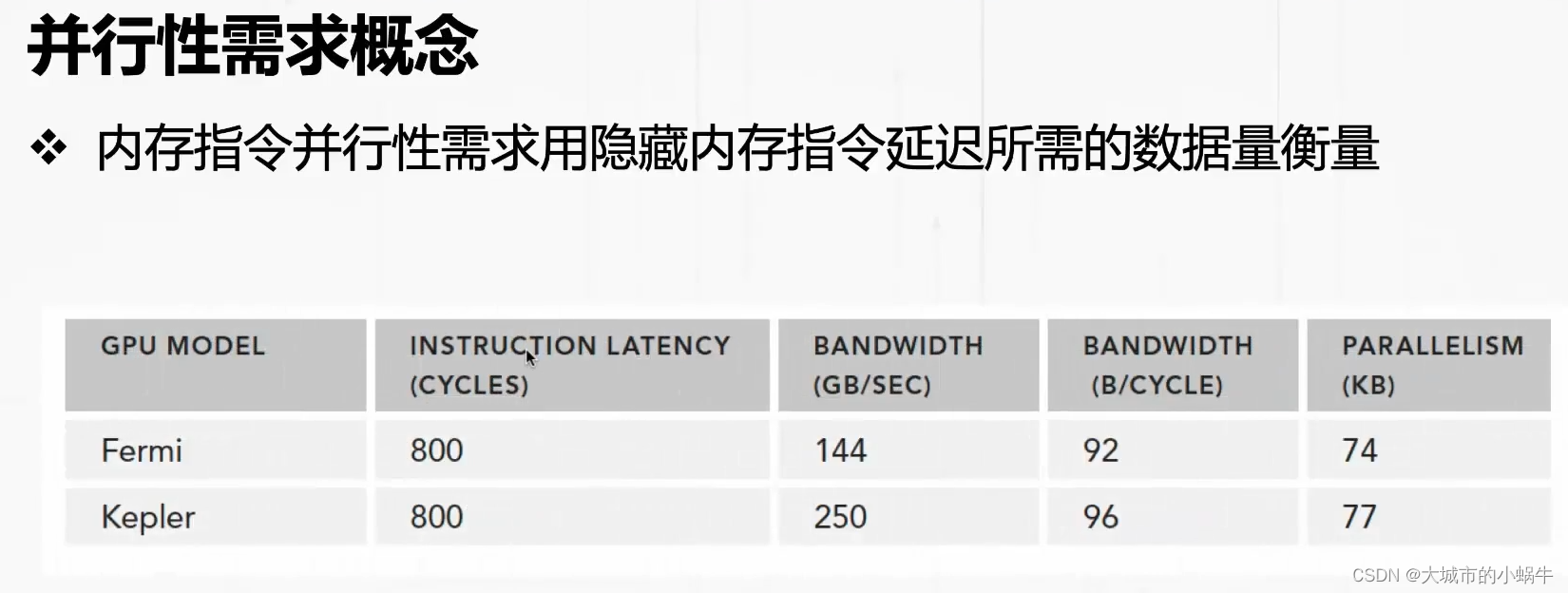

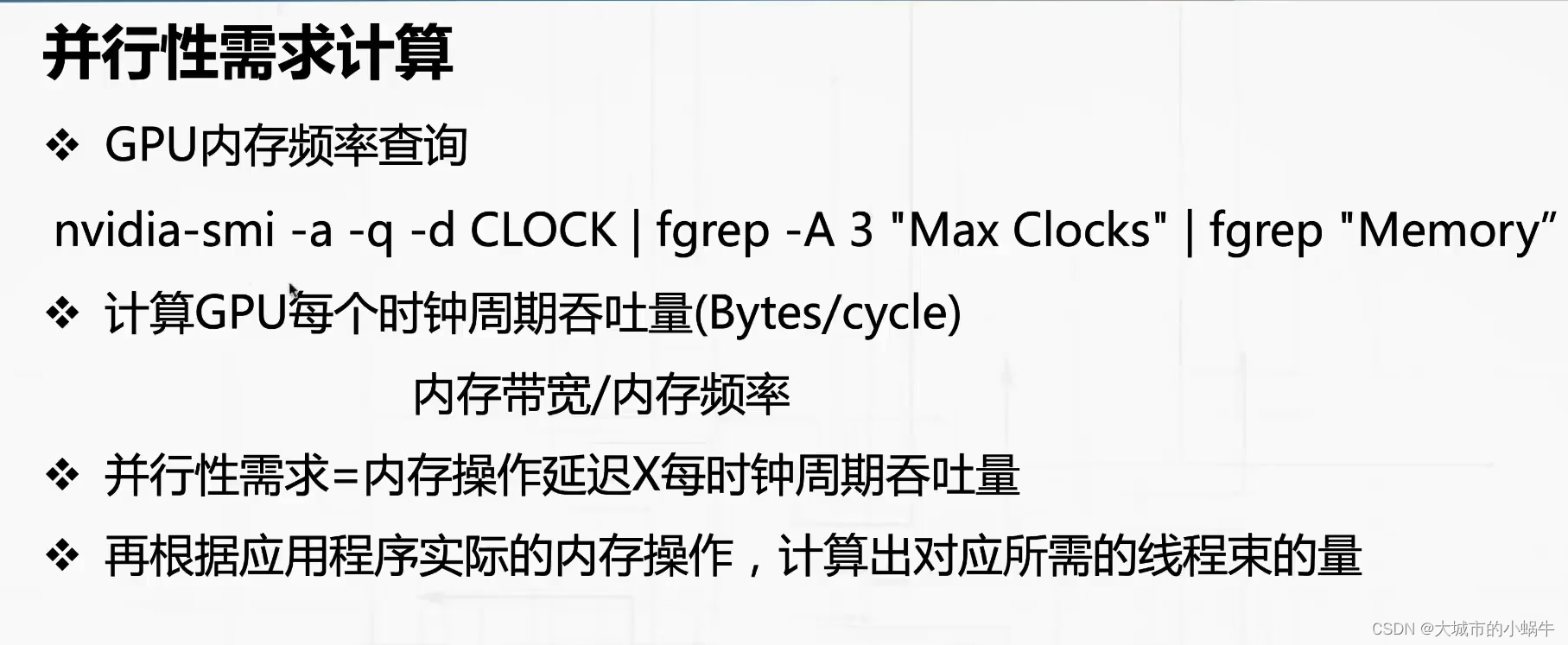

41. 内存指令并行性需求

41.1 并行性需求概念

41.2 并行性需求计算

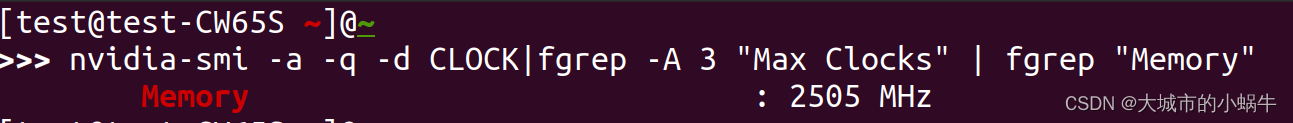

42. 流处理器占用率

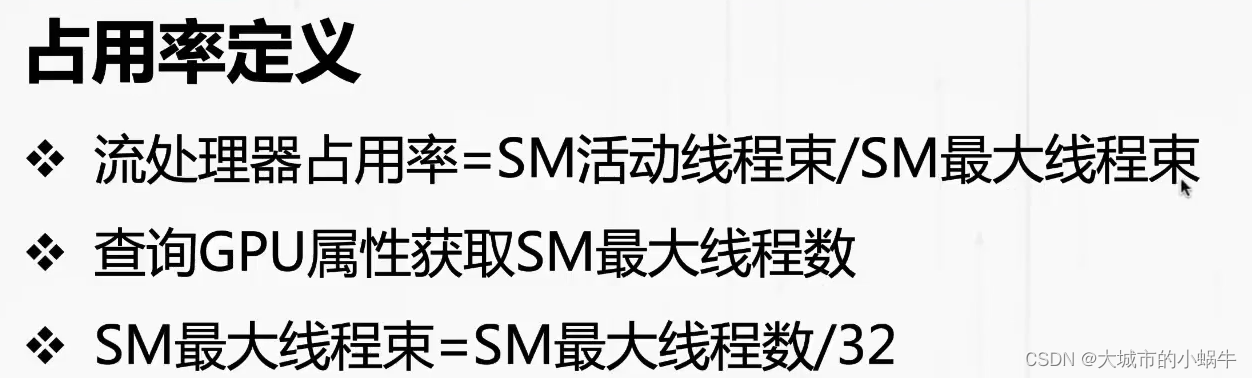

42.1 占用率定义

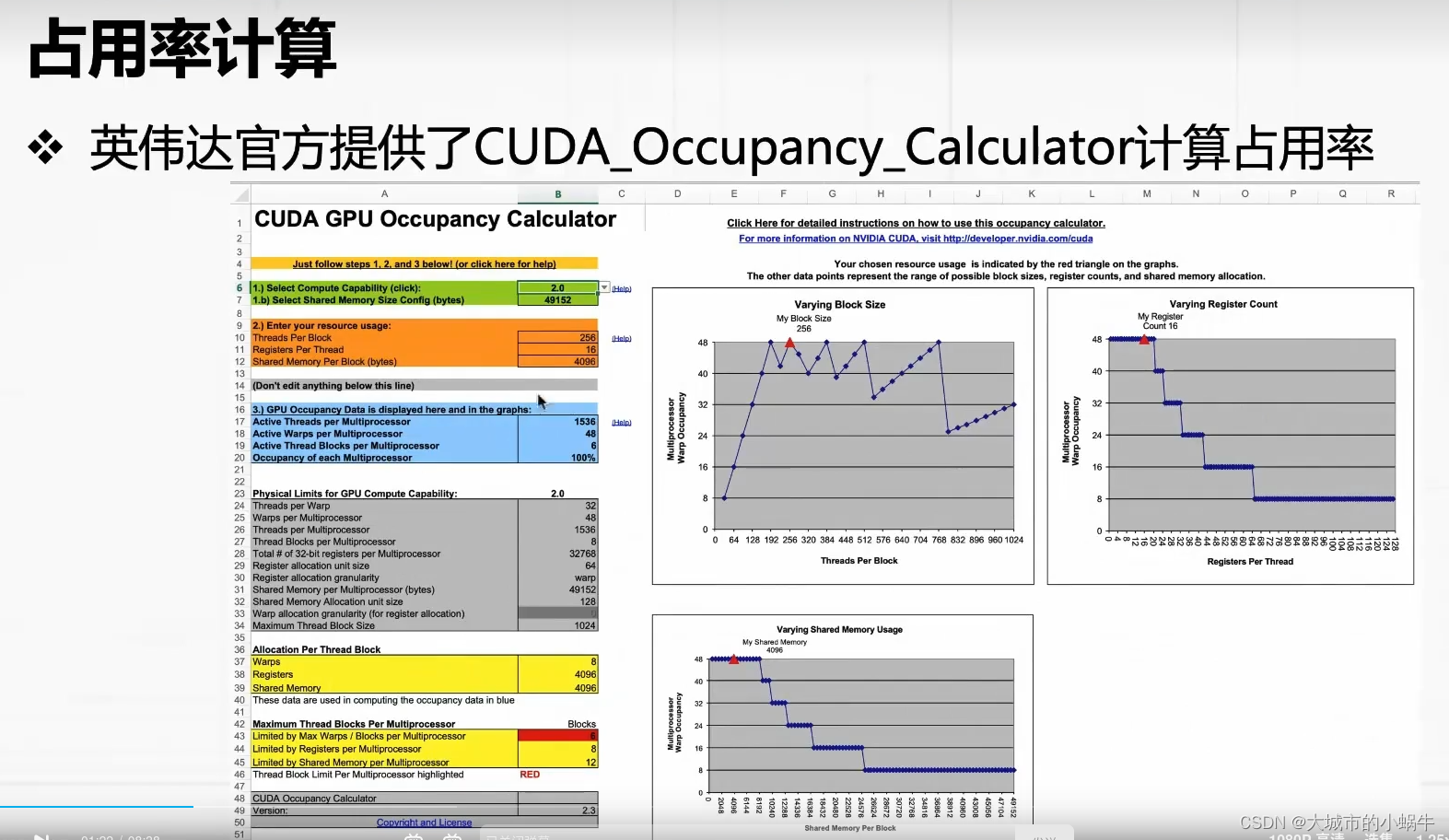

42.2 占用率计算

43. nvprof分析线程束和内存读写

43.1 线程束占用率分析

43.2 内存读写分析

44. 邻域并行计算

44.1 问题介绍

44.2 解决办法

45. 间域并行计算

45.1 问题介绍

45.2 解决办法

46. 循环展开

46.1 概念

46.2 实现方法

47. 模板函数

47.1 模板函数定义

47.2 模板函数使用

48. GPU动态并行

48.1 动态并行概念

48.2 动态并行特点

49. 动态并行HelloWorld

49.1 程序效果

49.2 实现方法

50. 本地化原则

50.1 本地化原则

50.2 内存层次和类型

50.3 寄存器