分布式爬虫在现代大数据采集中是不可或缺的一部分。随着互联网信息量的爆炸性增长,单机爬虫在性能、效率和稳定性上都面临巨大的挑战。分布式爬虫通过任务分发、多节点协作以及结果整合,成为解决大规模数据抓取任务的核心手段。

本节将从 Scrapy 框架的基本使用、Scrapy-Redis 的分布式实现、分布式爬虫的优化策略 等多个方面展开,结合实际案例,帮助开发者掌握分布式爬虫的设计与实现。

1. Scrapy 框架的核心概念与高效使用

1.1 什么是 Scrapy?

Scrapy 是 Python 中最流行的爬虫框架之一,它支持异步 IO,拥有高度模块化的结构,尤其适合高效抓取任务。Scrapy 的设计遵循爬虫的核心逻辑:请求发送、数据提取、数据存储。

1.2 Scrapy 的核心组件

理解 Scrapy 的核心组件对于优化爬虫性能至关重要。

-

Spider(爬虫模块)

定义抓取目标与逻辑的核心模块。例如:- 爬取的 URL 列表。

- 页面解析规则(如 XPath、CSS 选择器)。

- 数据提取与存储逻辑。

-

Request(请求模块)

负责构造 HTTP 请求,支持 GET/POST 方法、Cookie、Headers 等高级配置。 -

Item(数据模块)

定义爬取的结构化数据格式。 -

Pipeline(数据处理模块)

负责清洗、格式化和存储爬取到的数据,例如存入 CSV、数据库或其他存储系统。

1.3 提升 Scrapy 性能的关键点

-

使用异步下载器

Scrapy 默认使用 Twisted 异步网络库,可以极大提高并发性能。 -

优化并发数和延迟设置

配置settings.py:CONCURRENT_REQUESTS = 32 # 并发请求数量 DOWNLOAD_DELAY = 0.25 # 每个请求的间隔时间 -

缓存与去重

启用 HTTP 缓存以避免重复下载:HTTPCACHE_ENABLED = True HTTPCACHE_EXPIRATION_SECS = 3600 # 缓存过期时间 -

扩展功能

利用中间件、扩展和插件提高灵活性,如自定义代理池、用户代理切换等。

1.4 实战:构建 Scrapy 爬虫

以下代码展示如何使用 Scrapy 爬取示例网站,并提取标题与链接:

import scrapyclass ExampleSpider(scrapy.Spider):name = "example_spider"start_urls = ["https://example.com"]def parse(self, response):# 提取所有标题和链接for item in response.css('div.article'):yield {'title': item.css('h2::text').get(),'link': item.css('a::attr(href)').get(),}# 继续爬取下一页next_page = response.css('a.next::attr(href)').get()if next_page:yield response.follow(next_page, self.parse)2. Scrapy-Redis 实现分布式爬虫

2.1 分布式爬虫的挑战

- 任务分发:如何将 URL 或任务均匀分布到各节点。

- 结果整合:如何将多个爬虫节点的抓取结果统一存储和处理。

- 去重与调度:如何避免重复爬取,并确保任务按优先级进行。

2.2 Scrapy-Redis 的核心思想

-

Redis 作为任务调度中心

-

去重机制

- 利用 Redis 的集合结构对 URL 去重,避免重复抓取。

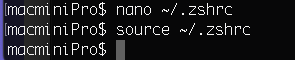

2.3 安装与配置

-

安装 Scrapy 和 Scrapy-Redis:

pip install scrapy scrapy-redis -

修改 Scrapy 项目的配置文件

settings.py:SCHEDULER = "scrapy_redis.scheduler.Scheduler" # 启用分布式调度器 DUPEFILTER_CLASS = "scrapy_redis.dupefilter.RFPDupeFilter" # 使用 Redis 去重 SCHEDULER_PERSIST = True # 任务队列持久化 REDIS_HOST = 'localhost' # Redis 地址 REDIS_PORT = 6379 # Redis 端口 -

编写爬虫代码:

from scrapy_redis.spiders import RedisSpiderclass DistributedSpider(RedisSpider):name = "distributed_spider"redis_key = "distributed:start_urls" # Redis 中的任务队列名称def parse(self, response):title = response.xpath('//title/text()').get()yield {'title': title} -

启动 Redis 服务:

redis-server -

添加任务到 Redis:

redis-cli lpush distributed:start_urls "https://example.com" -

启动多个爬虫节点:

scrapy runspider distributed_spider.py

2.4 分布式爬虫的优化

-

动态代理池

使用 IP 池应对 IP 封禁,例如通过开源库 ProxyPool 构建代理服务。 -

分层任务调度

将不同优先级的任务分配到不同的队列,提升调度效率。 -

去重优化

配置 Redis 的过期策略,清理长时间未使用的 URL。

3. 分布式爬虫的应用场景与实践

3.1 应用场景

-

新闻爬取与实时监控

实时抓取新闻网站的最新内容,用于舆情分析和关键词挖掘。 -

电商数据采集

抓取多个电商平台的价格、评价、库存等信息,构建价格比较系统。 -

知识图谱构建

抓取学术论文、百科内容,构建知识图谱。

3.2 实战:大型新闻爬取案例

from scrapy_redis.spiders import RedisSpiderclass NewsSpider(RedisSpider):name = 'news_spider'redis_key = 'news:start_urls'def parse(self, response):for article in response.css('div.news-item'):yield {'title': article.css('h2::text').get(),'url': article.css('a::attr(href)').get(),'summary': article.css('p.summary::text').get(),}3.3 优缺点总结

-

优点:

- 高效率:支持多节点并行,显著提升爬取速度。

- 可扩展性:支持动态扩展节点。

- 容错性:单节点故障不会影响整体任务。

-

缺点:

- 部署复杂:需要配置 Redis、代理池等。

- 数据一致性:分布式环境下的数据整合难度较大。

总结

分布式爬虫通过任务分发和节点协作,解决了单机爬虫性能瓶颈问题。Scrapy-Redis 提供了灵活的分布式架构,使得任务调度和数据整合更加高效。在实际项目中,根据业务需求选择合理的分布式策略,结合动态代理、数据存储优化等技术,构建性能稳定的爬虫系统。