💓 博客主页:瑕疵的CSDN主页

📝 Gitee主页:瑕疵的gitee主页

⏩ 文章专栏:《热点资讯》

使用Kafka实现大规模数据流处理的最佳实践

- 使用Kafka实现大规模数据流处理的最佳实践

- 引言

- Kafka 概述

- 什么是 Apache Kafka

- Kafka 的核心概念

- Kafka 的架构

- 使用 Kafka 实现大规模数据流处理的最佳实践

- 1. 合理设计 Topic 和 Partition

- 2. 配置合适的 Broker 参数

- 3. 优化生产者和消费者

- 4. 监控和报警

- 5. 安全性考虑

- 6. 容灾和备份

- 7. 性能调优

- 实际案例:使用 Kafka 构建实时日志分析系统

- 系统架构

- 日志收集

- 日志处理

- 日志存储

- 日志展示

- 总结

- 参考资料

Apache Kafka 是一个分布式流处理平台,广泛用于构建实时数据管道和流处理应用程序。Kafka 的高性能、可扩展性和可靠性使其成为处理大规模数据流的理想选择。本文将详细介绍如何使用 Kafka 实现大规模数据流处理,并分享一些最佳实践。

Apache Kafka 是一个开源的流处理平台,由 LinkedIn 开发并于 2011 年开源。Kafka 主要用于构建实时数据管道和流处理应用程序,具有以下特点:

- 高性能:Kafka 可以处理每秒数百万条消息,延迟低至毫秒级。

- 可扩展性:Kafka 是一个分布式系统,可以轻松扩展到数百台服务器。

- 持久性:Kafka 将消息持久化到磁盘,确保数据的可靠性和持久性。

- 容错性:Kafka 支持多副本机制,确保数据的高可用性和容错性。

- Topic:Kafka 中的消息分类,类似于数据库中的表。

- Partition:Topic 的物理划分,每个 Partition 是一个有序的队列。

- Broker:Kafka 集群中的节点,负责消息的存储和传输。

- Producer:生产者,负责将消息发送到 Kafka 集群。

- Consumer:消费者,负责从 Kafka 集群中消费消息。

- Consumer Group:消费者组,同一组内的消费者互斥地消费消息。

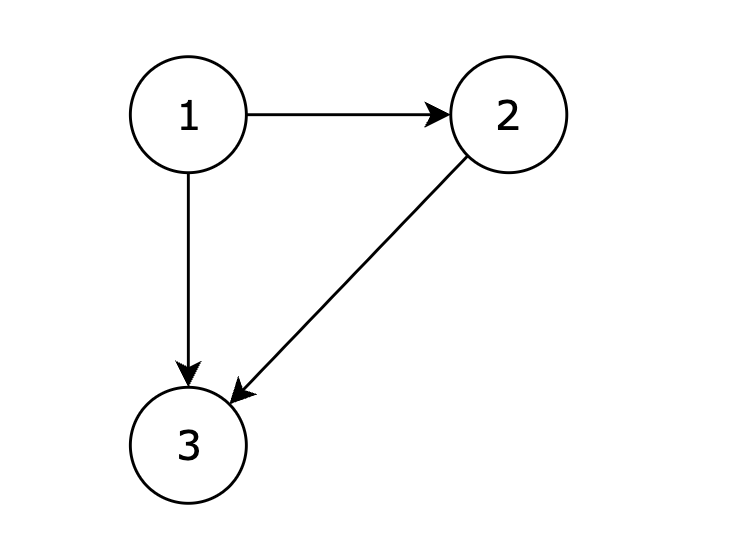

Kafka 的架构包括生产者、消费者、Broker 和 ZooKeeper。ZooKeeper 负责集群的管理和协调,确保高可用性和一致性。

- Topic 设计:根据业务需求合理设计 Topic,避免过多或过少的 Topic。

- Partition 设计:合理设置 Partition 数量,以平衡负载和提高吞吐量。一般建议 Partition 数量为 Broker 数量的 2-3 倍。

- 消息保留时间:根据业务需求配置消息的保留时间,避免磁盘空间不足。

- 日志段大小:合理设置日志段大小,以优化磁盘 I/O 性能。

- 副本因子:设置合适的副本因子,确保数据的高可用性和容错性。

- 批量发送:生产者可以批量发送消息,减少网络开销。

- 压缩:启用消息压缩,减少网络带宽和磁盘 I/O 开销。

- 异步发送:使用异步发送方式,提高生产者的吞吐量。

- 消费者组:合理配置消费者组,确保消息的均衡消费。

- 自动提交偏移量:合理配置偏移量的自动提交,避免数据丢失。

- 监控指标:监控 Kafka 集群的关键指标,如消息延迟、吞吐量、磁盘使用率等。

- 报警机制:设置合理的报警阈值,及时发现和处理问题。

- 身份认证:启用身份认证机制,确保只有授权的生产者和消费者可以访问 Kafka 集群。

- 数据加密:启用数据加密,保护数据在传输过程中的安全性。

- 权限控制:合理配置权限控制,确保不同用户只能访问其授权的资源。

- 多数据中心:部署多数据中心,确保数据的高可用性和容灾能力。

- 定期备份:定期备份 Kafka 集群的数据,防止数据丢失。

- 硬件选择:选择高性能的硬件,如 SSD 磁盘和高速网络设备。

- JVM 调优:合理配置 JVM 参数,优化 Kafka 的内存管理和垃圾回收。

- 网络调优:优化网络配置,减少网络延迟和丢包率。

假设我们要构建一个实时日志分析系统,系统的主要功能包括收集日志、处理日志和展示分析结果。

- 日志收集:使用 Logstash 或 Fluentd 收集日志,并发送到 Kafka 集群。

- 日志处理:使用 Kafka Streams 或 Apache Flink 处理日志数据。

- 日志存储:将处理后的日志数据存储到 HDFS 或 Elasticsearch。

- 日志展示:使用 Kibana 或 Grafana 展示分析结果。

使用 Logstash 收集日志并发送到 Kafka 集群。

input {file {path => "/var/log/*.log"start_position => "beginning"}

}output {kafka {topic_id => "logs"bootstrap_servers => "kafka1:9092,kafka2:9092,kafka3:9092"}

}

使用 Kafka Streams 处理日志数据。

import org.apache.kafka.streams.KafkaStreams;

import org.apache.kafka.streams.StreamsBuilder;

import org.apache.kafka.streams.kstream.KStream;public class LogProcessor {public static void main(String[] args) {StreamsBuilder builder = new StreamsBuilder();KStream<String, String> logs = builder.stream("logs");KStream<String, String> processedLogs = logs.mapValues(value -> {// 处理日志逻辑return value.toUpperCase();});processedLogs.to("processed-logs");KafkaStreams streams = new KafkaStreams(builder.build(), config);streams.start();}

}

将处理后的日志数据存储到 Elasticsearch。

input {kafka {topics => ["processed-logs"]bootstrap_servers => "kafka1:9092,kafka2:9092,kafka3:9092"}

}output {elasticsearch {hosts => ["localhost:9200"]index => "logs"}

}

使用 Kibana 展示分析结果。

- 安装 Kibana:按照官方文档安装 Kibana。

- 配置索引模式:在 Kibana 中配置索引模式,指向 Elasticsearch 中的日志索引。

- 创建仪表盘:创建仪表盘,展示日志分析结果。

使用 Kafka 实现大规模数据流处理需要综合考虑多个方面,包括 Topic 和 Partition 的设计、Broker 参数的配置、生产者和消费者的优化、监控和报警、安全性、容灾和备份以及性能调优。本文详细介绍了这些最佳实践,并通过一个实际案例展示了如何使用 Kafka 构建实时日志分析系统。通过遵循这些最佳实践,可以确保 Kafka 集群的高性能、可扩展性和可靠性。

- Apache Kafka Official Website

- Kafka Streams Documentation

- Apache Flink Documentation

- Logstash Documentation

- Elasticsearch Documentation

- Kibana Documentation