认识决策树

决策树思想的来源非常朴素,程序设计中的条件分支结构就是if-else结构,最早的决策树就是利用这类结构分割数据的一种分类学习方法。

决策树分类原理详解

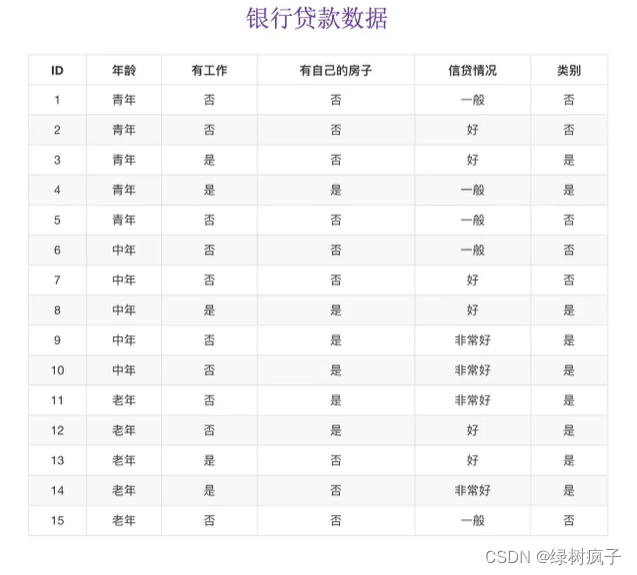

为了更好理解决策树具体怎么分类的,通过一个问题例子:

问题:如何对这些客户进行分类预测?如何划分?

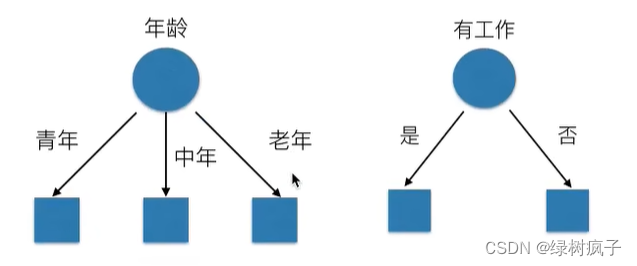

有可能划分是这样的:

已知有四个特征值,预测是否贷款给某个人:

①类:先看房子,再工作–> 是否贷款——只看了两个特征

②类:年龄,信贷情况,工作——看了三个特征

1原理

- 信息熵、信息增益等

需要用到信息论的知识!!!问题:通过例子引入信息熵

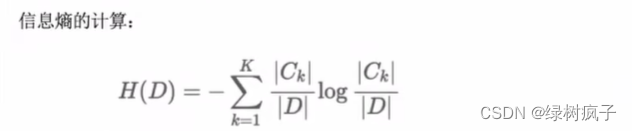

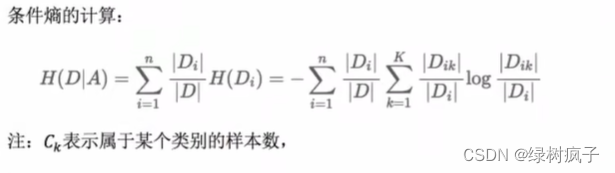

2信息熵的定义

- H的专业术语称之为信息熵,单位为比特。

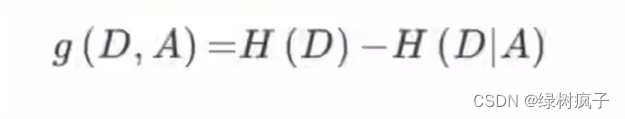

3决策树的划分依据之-------信息增益

香农:消除随机不定性的东西

小明,年龄“我今年18岁”——信息

小华 “小明明年19岁”——不是信息

- 定义与公式

特征A对训练数据集D的信息增益 g(D,A),定义为集合D的信息熵H(D)与特征A给定条件下D的信息条件熵 H(D|A) 之差,即公式为:

- 公式的详细解释:

注:信息增益表示得知特征X的信息而息的不确定性减少的程度使得类Y的信息熵减少的程度

- 我们以年龄特征来计算:

1、g(D,年龄)=H(D)-H(D|年龄)=0.971-[5/15H(青年)+5/15H(中年)+5/15H(老年)]

2、H(D)=-(6/15log(6/15)+9/15log(9/15))=0.971

3、H(青年)=-(3/5log(3/5)+2/5log(2/5))

H(中年)=-(3/5log(3/5)+2/5log(2/5))

H(老年)=-(4/5log(4/5)+1/5log(1/5))

我们以A1、A2、A3、A4代表年龄、有工作、有自己的房子和贷款情况。最终计算的结果g(D,A1)=0.313,g(D,A2)=0.324,g(D,A3)=0.420,g(D,A4)=0.363。所以我们选择A3作为划分的第一个特征。这样我们就可以一棵树慢慢建立。

4决策树的划分依据之-------信息增益

当然决策树的原理不止信息增益这一种,还有其他方法。但是原理都类似。

- ID3

- 信息增益 最大的准则

- C4.5

- 信息增益比 最大的准则

- CART

- 分类树:基尼系数 最小的准则(在sklearn中可以选择划分的默认原则)

- 优势:划分更加细致(从后面例子的树显示来理解)

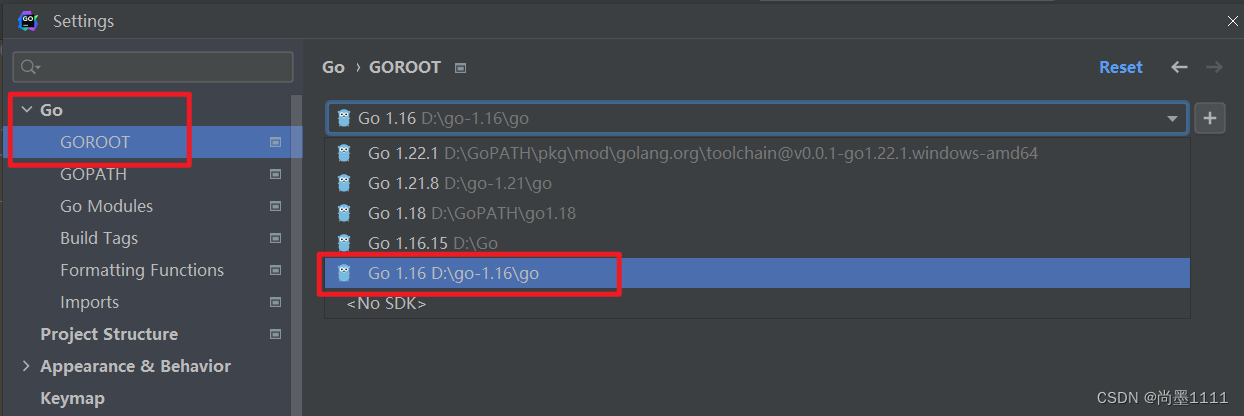

决策树API

- class sklearn.tree.DecisionTreeClassifier(criterion='gini’,max_depth=None,random_state=None)

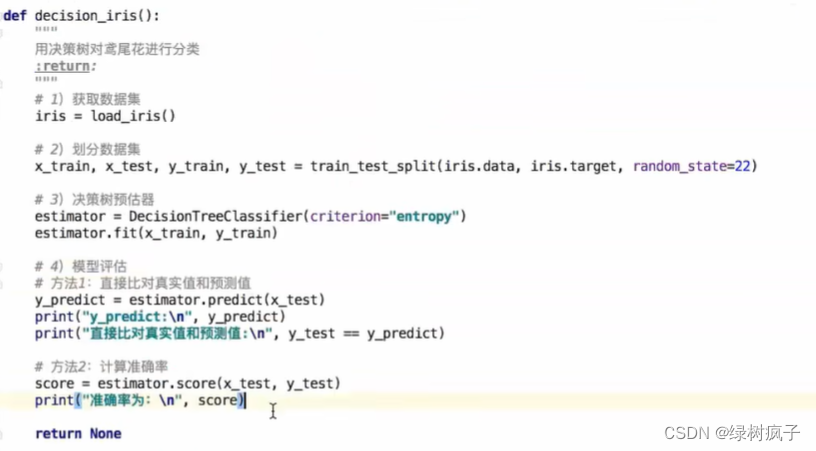

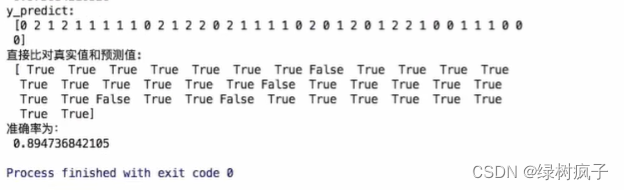

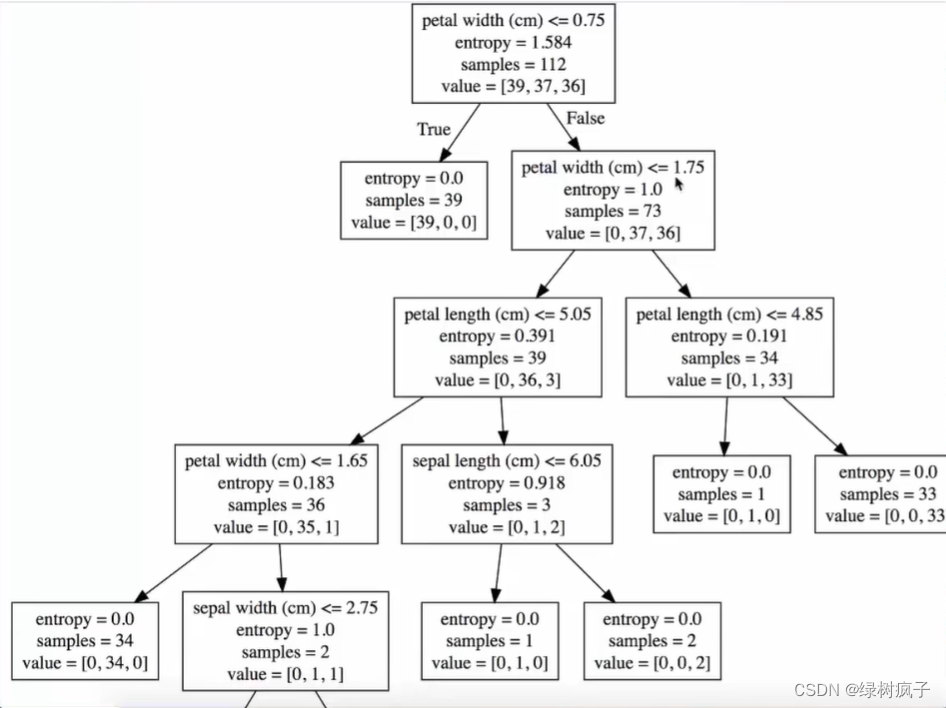

1用决策树对鸢尾花进行分类

决策树的结构是可以直接显示的,所以

决策树可视化

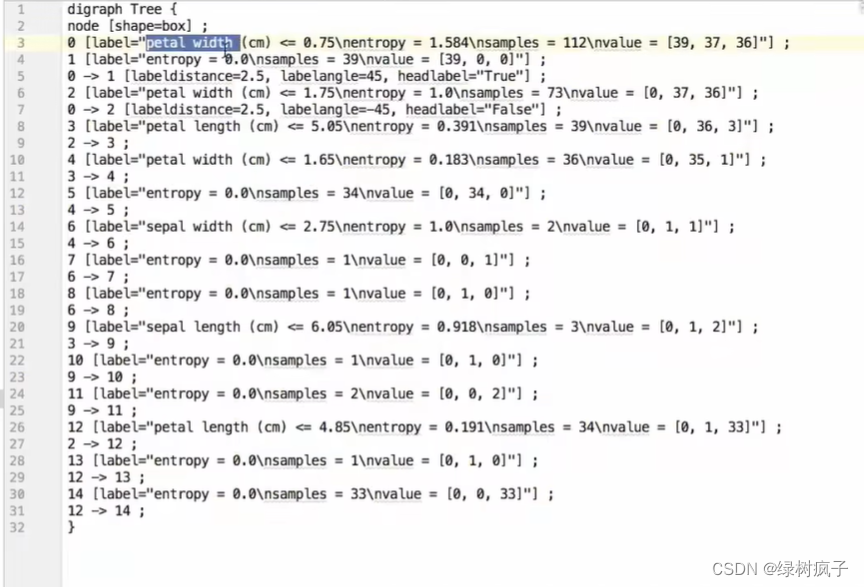

1保存树的结构到dot文件

- sklearn.tree.export_graphviz() 该函数能够导出DOT格式

- tree.export_graphviz(estimator,out_file=‘tree.dot’,feature_names=[“,”])

//可视化决策树

export_graphviz(estimator,out_file="iris_tree.dot",feature_names=iris.feature_names

运行后生成:

复制到webgraphviz.com网页中:

决策树总结

- 优点:

- 简单的理解和解释,树有可视化

- 缺点:

- 决策树学习者可以创建不能很好地推广数据的过于复杂的树,这被称为过拟合

- 改进:

- 减枝cart算法(决策树API当中已经实现,随机森林参数调优有相关介绍)

- 随机森林

注:企业重要决策,由于决策树很好的分析能力,在决策过程应用较多,可以选择特征

总结

- 信息熵、信息增益的计算

- DecisionTreeClassifier进行决策树的划分

- export_graphviz导出到dot文件