语言模型

2024/9/13 22:16:14文本嵌入新方案:合合信息acge模型荣登C-MTEB榜首

目录 0 写在前面1 文本嵌入:LLM落地的根基2 C-MTEB:acge荣夺榜一2.1 max tokens2.2 文本分类2.3 文本聚类 3 acge demo演示与体验总结 0 写在前面

随着信息技术的发展和应用场景的不断扩大,人们需要处理和利用大量的文档信息。而传统的手动处…

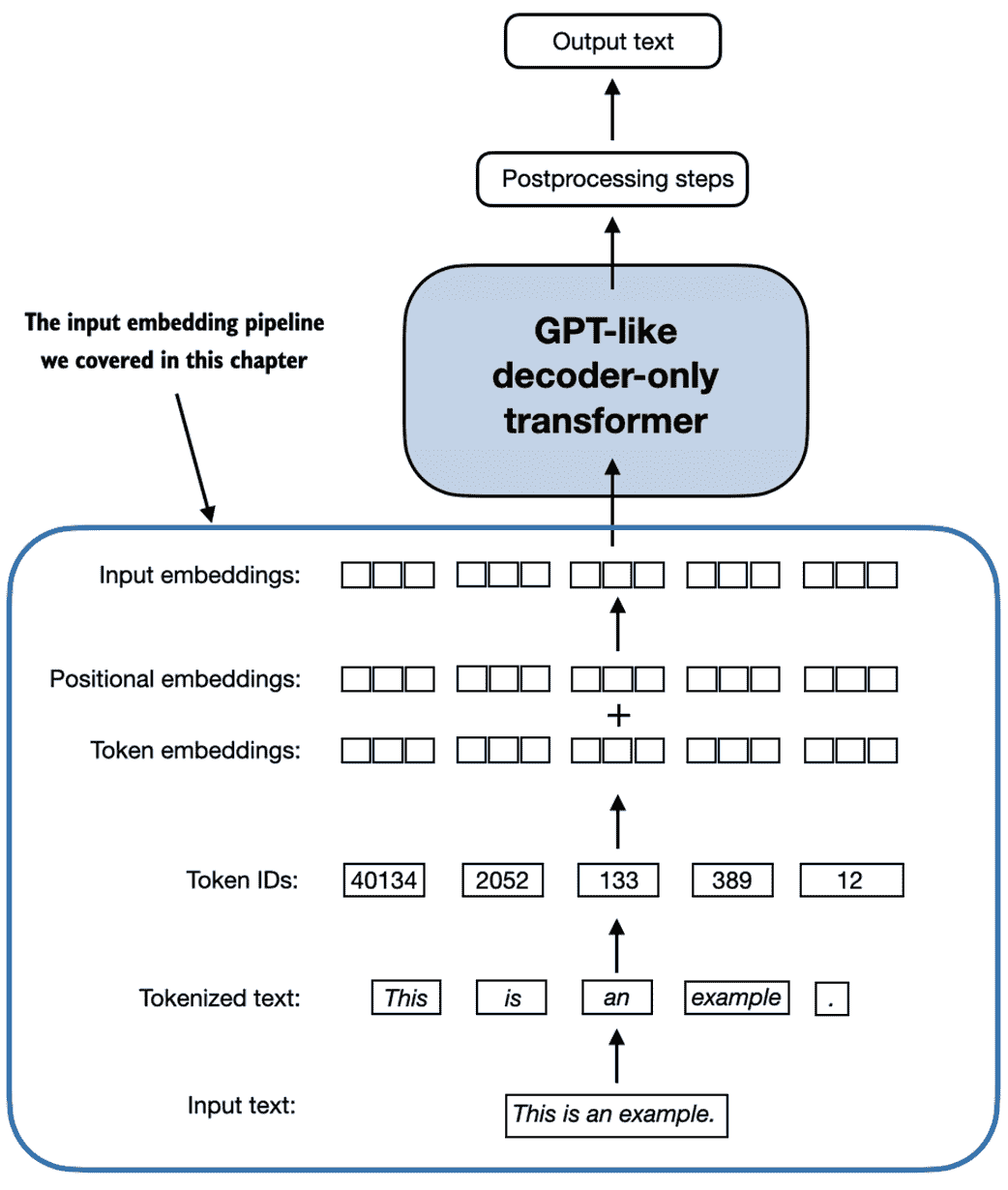

从零开始构建大语言模型(MEAP)

原文:annas-archive.org/md5/c19a4ef8ab1664a3c5a59d52651430e2 译者:飞龙 协议:CC BY-NC-SA 4.0 一、理解大型语言模型

本章包括 大型语言模型(LLM)背后的基本概念的高层次解释 探索 ChatGPT 类 LLM 源自的 Transfo…

Reflection 70B——HyperWrite推出的大型语言模型

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领…

大语言模型的上下文窗口(Context Windows):对人工智能应用的影响

大语言模型(LLMs)极大地提升了人工智能在理解和生成类人文本方面的能力。其中一个影响其效用的基本方面是它们的 “上下文窗口”—— 这个概念直接影响着这些模型接收和生成语言的有效性。我将深入探讨上下文窗口是什么、它们对人工智能应用的影响以及组…

必备资源!精选大模型领域100篇必读论文,赶紧加入收藏夹!

本文主要为当前大模型领域热门研究方向(如文生图、文生视频、文生音乐等)的热门论文。希望能够为大家提供较为全面的大模型最新研究进展。当然,目前还无法涵盖所有热门论文以及研究方向,望请见谅。

以下,为2024年2月份…

欢迎 Llama 3:Meta 的新一代开源大语言模型

介绍 Meta 公司的 Llama 3 是开放获取的 Llama 系列的最新版本,现已在 Hugging Face 平台发布。看到 Meta 持续致力于开放 AI 领域的发展令人振奋,我们也非常高兴地全力支持此次发布,并实现了与 Hugging Face 生态系统的深度集成。 Llama 3 提…

在亚马逊云科技上利用Agent和生成式AI写小说(上篇)

今天小李哥将介绍亚马逊推出的国际前沿人工智能AI大模型平台Amazon Bedrock上的Agent的功能。我们将利用Agent结合代码应用工作流服务Step Functions创建链式提示词(Prompt Chaining),通过提示词调用Amazon Bedrock上AI大模型写一篇小说。其中…

【Datawhale AI夏令营第四期】 浪潮源大模型应用开发方向笔记 Task05 源大模型微调实战代码精读 RAG测试 AI简历助手代码优化 网课剩余部分

【Datawhale AI夏令营第四期】 浪潮源大模型应用开发方向笔记 Task05 源大模型微调实战代码精读 RAG测试 AI简历助手代码优化 网课剩余部分

教程基础背景知识:

微调能解决的问题正好是我需要的——模型在某个特定方面上能力不够。我感觉这种情况适用于让模型去完成…

【Qwen-Audio部署实战】Qwen-Audio-Chat模型之对话机器人部署测试

系列篇章💥

No.文章1【Qwen部署实战】探索Qwen-7B-Chat:阿里云大型语言模型的对话实践2【Qwen2部署实战】Qwen2初体验:用Transformers打造智能聊天机器人3【Qwen2部署实战】探索Qwen2-7B:通过FastApi框架实现API的部署与调用4【Q…

通过API方式访问llama3

一、安装Ollama,在上一篇文章中已经详细介绍如何安装Ollama Ollama安装好,就是下面的界面: 二、从Ollama中获得接口地址 三、从通过命令行窗口,访问llama3 API

curl http://localhost:11434/api/generate -d {"model":…

经典大语言模型解读(1):BERT——基于双向Transformer的预训练语言模型

论文:BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

前言

BERT(Bidirectional Encoder Representation from Transformer)是Google于2019年提出的预训练语言模型。与寻常的Transformer架构不同&#…

欺诈文本分类检测(十四):GPTQ量化模型

1. 引言

量化的本质:通过将模型参数从高精度(例如32位)降低到低精度(例如8位),来缩小模型体积。

本文将采用一种训练后量化方法GPTQ,对前文已经训练并合并过的模型文件进行量化,通…

开源模型应用落地-sherpa-onnx-AIGC应用探索(十)

一、前言 sherpa-onnx 具有诸多优势,它功能丰富,支持语音转文本、文本转语音、说话人识别等多种功能且能离线运行,无需联网;可在多种架构和操作系统上使用,包括 Android、iOS、Windows 等;提供多种编程语言的 API;拥有丰富的预构建资源,如 Android APKs、Flutter APPs …

【自然语言处理】python之人工智能应用篇——文本生成技术

文本生成是指使用自然语言处理技术,基于给定的上下文或主题自动生成人类可读的文本。这种技术可以应用于各种领域,如自动写作、聊天机器人、新闻生成、广告文案创作等。

一、文本生成技术的核心要素包括:

1. 预训练模型

概述:预…

论文解读 | ACL2024 Outstanding Paper:因果指导的主动学习方法:助力大语言模型自动识别并去除偏见...

点击蓝字 关注我们 AI TIME欢迎每一位AI爱好者的加入! 点击阅读原文观看作者直播讲解回放! 作者简介 孙洲浩,哈尔滨工业大学SCIR实验室博士生 概述 尽管大语言模型(LLMs)展现出了非常强大的能力,但它们仍然…

AI跟踪报道第55期-新加坡内哥谈技术-本周AI新闻: GPT NEXT (x100倍)即将在2024推出

每周跟踪AI热点新闻动向和震撼发展 想要探索生成式人工智能的前沿进展吗?订阅我们的简报,深入解析最新的技术突破、实际应用案例和未来的趋势。与全球数同行一同,从行业内部的深度分析和实用指南中受益。不要错过这个机会,成为AI领…