TensorRT

2024/9/18 23:07:34yolo-world开放词汇检测onnxruntime和tensorrt推理

onnxruntime推理

导出onnx模型:

from ultralytics import YOLOWorld,YOLO

model YOLOWorld(yolov8s-worldv2.pt)

model.set_classes(["glasses","shoes"])

model.save("yolo_world.pt")

model YOLO(yolo_world.pt)

model.export(…

使用 TensorRT 进行推理的系统讲解

使用 TensorRT 进行推理需要几个主要步骤,从创建 Runtime 到最终的推理。这些步骤包括: 创建 Runtime 反序列化引擎 创建 Execution Context 分配内存 图像前处理 执行推理 结果后处理 以下是对每一步的详细解释: 1. 创建 Runtime 目的…

六. 部署分类器-deploy-classification-advanced

目录 前言0. 简述1. 案例运行2. 补充说明3. 代码分析3.1 main.cpp3.2 trt_worker.cpp3.3 trt_logger.cpp3.4 trt_classifier.cpp3.5 trt_model.cpp3.6 inference部分 结语下载链接参考 前言 自动驾驶之心推出的 《CUDA与TensorRT部署实战课程》,链接。记录下个人学习…

三. TensorRT基础入门-TensorRT应用场景

目录 前言0. 简述1. TensorRT的优化意义2. 自动驾驶中需要关注的实时性3. 自动驾驶中需要关注的电力消耗4. 自动驾驶中模型部署所关注的东西总结参考 前言 自动驾驶之心推出的 《CUDA与TensorRT部署实战课程》,链接。记录下个人学习笔记,仅供自己参考 本…

TensorRT-LLM——优化大型语言模型推理以实现最大性能的综合指南

引言

随着对大型语言模型 (LLM) 的需求不断增长,确保快速、高效和可扩展的推理变得比以往任何时候都更加重要。NVIDIA 的 TensorRT-LLM 通过提供一套专为 LLM 推理设计的强大工具和优化,TensorRT-LLM 可以应对这一挑战。TensorRT-LLM 提供了一系列令人印…

三. TensorRT基础入门-TensorRT简介

目录 前言0. 简述1. 什么是TensorRT2. TensorRT的工作流介绍3. TensorRT的一些限制总结参考 前言 自动驾驶之心推出的 《CUDA与TensorRT部署实战课程》,链接。记录下个人学习笔记,仅供自己参考 本次课程我们来学习课程第三章—TensorRT 基础入门…

ComfyUI: 报EP Error错误(onnxruntime)

🤶背景描述

在使用反推提示词的时候,按照上一篇介绍的方法是可以正常使用的。 但是看后台的时候,发现有一个错误:

*************** EP Error *************** EP Error D:\a\_work\1\s\onnxruntime\python\onnxruntime_pybind_s…

yolo-world开放词汇检测onnxruntime和tensorrt推理

onnxruntime推理

导出onnx模型:

from ultralytics import YOLOWorld,YOLO

model YOLOWorld(yolov8s-worldv2.pt)

model.set_classes(["glasses","shoes"])

model.save("yolo_world.pt")

model YOLO(yolo_world.pt)

model.export(…

ubuntu20.04(wsl2)测试 arcface 人脸识别(计算特征向量)

1. 参考博客和代码、模型仓库: 1.1. 【C随记】collect2: error: ld returned 1 exit status错误分析与解决 1.2. Visual Studio 2022新建 cmake 工程测试 tensorRT 自带样例 sampleOnnxMNIST 1.3.报错:ModuleNotFoundError: No module named ‘ten…

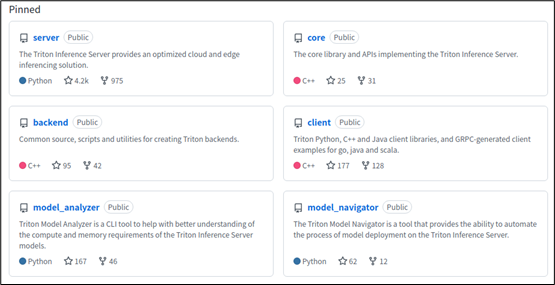

NVIDIA Triton系列03-开发资源说明

NVIDIA Triton系列03-开发资源说明

大部分要学习 Triton 推理服务器的入门者,都会被搜索引擎或网上文章引导至官方的 https://developer.nvidia.com/nvidia-triton-inference-server 处(如下截图),然后从 “Get Started” 直接安…

基于c++的yolov5推理之前处理详解及代码(一)

目录 一、前言:

二、关于环境安装:

三、首先记录下自己的几个问题 问题:c部署和python部署的区别?

四、正文开始 4.1 图像预处理讲解 1、BGR---->RBG 2、等比例放缩图片(涉及到短边的填充) 3、归一化…

三. TensorRT基础入门-TensorRT简介

目录 前言0. 简述1. 什么是TensorRT2. TensorRT的工作流介绍3. TensorRT的一些限制总结参考 前言 自动驾驶之心推出的 《CUDA与TensorRT部署实战课程》,链接。记录下个人学习笔记,仅供自己参考 本次课程我们来学习课程第三章—TensorRT 基础入门…

yolov8实战第六天——yolov8 TensorRT C++ 部署——(踩坑,平坑,保姆教程)

C 结合 TensorRT 部署深度学习模型有几个关键优势,这些优势在各种工业和商业应用中极其重要: 高效的性能:TensorRT 通过优化深度学习模型来提高推理速度,减少延迟。这对于实时处理应用(如视频分析、机器人导航等&#…

NVIDIA Triton Inference Server 部署 yolov5

文章目录 一、拉取 tensorrt 、yolov5、tritonserver 镜像二、下载 yolov5-6.2、tensorrtx/yolov5-6.2源码三、pt转wts四、wts转engine五、创建triton推理服务器六、创建客户端进行测试 一、拉取 tensorrt 、yolov5、tritonserver 镜像

docker pull hakuyyf/tensorrtx:trt8.2_…

七. 部署YOLOv8检测器-load-save-tensor

目录 前言0. 简述1. 案例运行2. 补充说明3. 代码分析3.1 main.cpp3.2 create_data.py 结语下载链接参考 前言 自动驾驶之心推出的 《CUDA与TensorRT部署实战课程》,链接。记录下个人学习笔记,仅供自己参考 本次课程我们来学习课程第六章—部署分类器&…

windows 环境 Visual Studio 2022 新建 cmake 工程测试 cuda 代码编译

1. 参考博客: 1. 【CUDA】CUDA编译:https://blog.csdn.net/u011285477/article/details/104408296 2. 项目文件夹结构:

c_cuda/cuda/CMakeLists.txtfoo.cufoo.cuhCMakeLists.txtmain.cpp3. 完整代码: 1. c_cuda/CMakeLis…