ChatGPT是一个基于Transformer架构的自然语言生成模型,它是OpenAI开发的一种强大的自然语言处理模型。该模型利用了深度学习和自然语言处理技术,可以用于文本生成、翻译、问题回答等多种任务。

以下是ChatGPT的实现原理:

1.数据集

ChatGPT的实现基于大规模的自然语言语料库,如维基百科、互联网论坛、新闻报道等。OpenAI通过使用Web爬虫和API获取了这些数据集,并对它们进行了预处理。这些数据集被用来训练ChatGPT的神经网络,以便生成自然语言文本。

2.模型架构

ChatGPT使用的是Transformer架构,它是一种基于注意力机制的神经网络模型。这种模型的优点在于,它可以并行化处理文本序列,并且能够捕捉序列中单词之间的长距离依赖关系。

Transformer模型的架构分为编码器和解码器两部分。在ChatGPT中,只有一个解码器,没有编码器。这是因为ChatGPT主要用于生成文本,而不是处理输入文本。

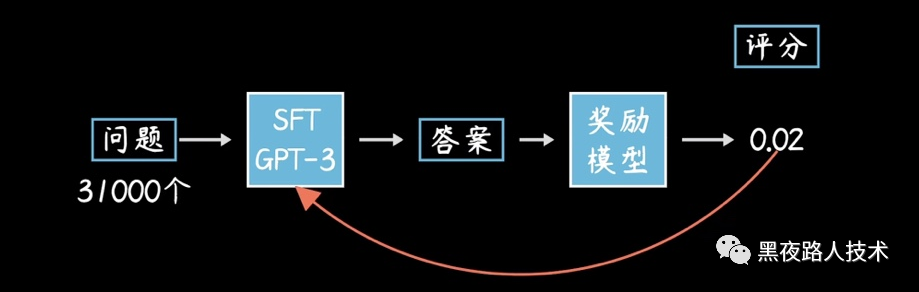

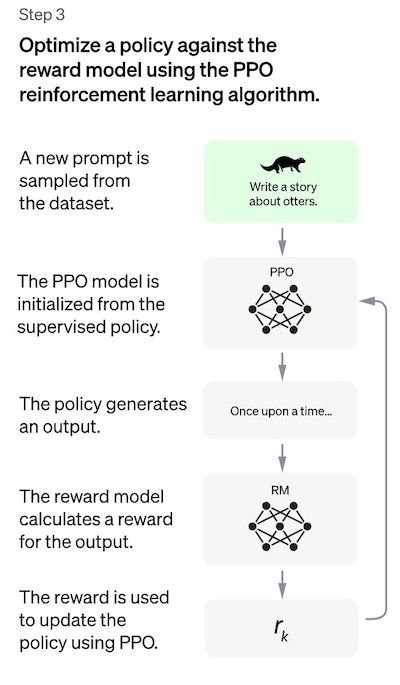

3.训练模型

在ChatGPT中,模型的训练是通过无监督的方式进行的。在训练过程中,模型的目标是最大化给定一段文本序列的概率。具体来说,模型的目标是预测下一个单词在给定上下文中出现的概率。

为了训练模型,OpenAI使用了一种称为“掩码语言建模”的技术。在掩码语言建模中,模型会随机将文本序列中的一些单词替换为特殊的掩码符号,然后根据上下文预测被掩码的单词。通过这种方式,模型可以学习到单词之间的关系,并生成自然语言文本。

4.生成文本

当ChatGPT训练完成后,就可以用于生成自然语言文本。生成文本的过程是通过向模型提供一些初始文本,然后模型会根据初始文本生成后续的文本。生成文本的过程使用的是基于采样的方法,即从模型预测的概率分布中随机采样。

5.Fine-tuning

除了在大规模的语料库上进行训练之外,ChatGPT还可以通过fine-tuning来适应特定的任务。在fine-tuning中,模型会通过使用特定的数据集进行有监督的训练。这样,模型就可以生成与特定任务相关的自然语言文本。比如,可以使用fine-tuning训练一个对话生成模型,使其能够生成与特定话题相关的对话。

6.多头注意力机制

Transformer模型中的多头注意力机制是ChatGPT实现原理的重要组成部分之一。这种机制可以让模型同时关注不同的位置,从而提高模型的性能。具体来说,多头注意力机制将输入分成多个子空间,每个子空间都有自己的注意力机制,从而可以并行计算。这样,模型可以关注不同子空间中的不同特征,从而提高模型的性能。

7.对抗训练

除了使用无监督的训练方式外,ChatGPT还使用了对抗训练技术来提高模型的鲁棒性。在对抗训练中,模型会与一个敌对模型进行对抗。敌对模型会生成一些文本序列,这些文本序列是有意识地设计成能够欺骗ChatGPT模型的。然后,ChatGPT会学习如何识别这些欺骗性的文本序列,并生成更为准确的文本。

总之,ChatGPT是一个基于Transformer架构的自然语言生成模型,它利用深度学习和自然语言处理技术实现了对自然语言文本的生成。ChatGPT的实现原理包括使用大规模的语料库进行无监督的训练,使用多头注意力机制来提高模型的性能,以及使用对抗训练技术来提高模型的鲁棒性。