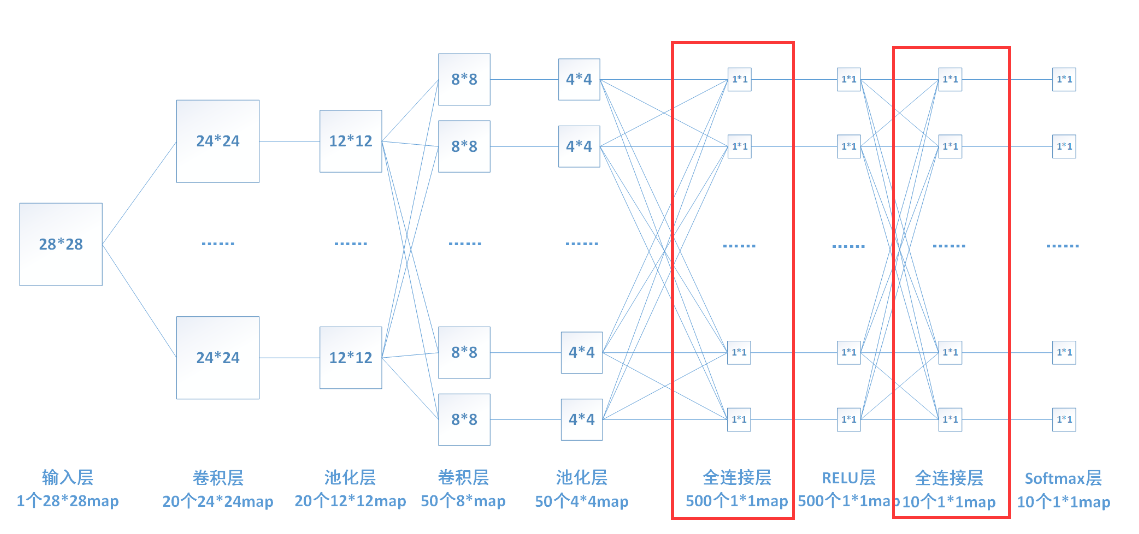

1、将前一层输出的二维特征图综合起来转化为一维向量,它的每一个节点都与上一层的每个节点连接

2、全连接层的主要作用是将输入图像在经过卷积和池化操作后提取的特征进行压缩,并且根据压缩的特征完成模型的分类功能;在整个卷积神经网络中起到“分类器”的作用,如果说卷积层、池化层和激活函数等操作是将原始数据映射到隐层特征空间的话,全连接层则起到将学到的特征表示映射到样本的标记空间的作用。

3、全连接层实现过程:对前层是全连接的全连接层可以转换为卷积核为1*1的卷积;而前层是卷积层的全连接层可以转换为卷积核为前层卷积输出结果的高和宽一样大小的全局卷积。

最后的两列小圆球就是两个全连接层。在经过若干卷积和池化之后,会输出20个12x12的矩阵E,这代表用了20个神经元,每个神经元都对这张图进行了一次次卷积,并且每个神经元最后输出的12x12的矩阵都代表了这个神经元对该图片的一个特征的理解,接下来到了全连接层,输出一个1x100的矩阵,其实就是有100个20x12x12的卷积核(卷积核的大小和池化层的输出规模是一样的,所以得到的是20个数相加后的一个数)卷积出来的,对于输入的每一张图,用了一个和图像一样大小尺寸的核卷积,这样整幅图就变成了一个数,因为厚度是20,所以对20个核卷积完了之后再相加求和得到一个数,一共是100个卷积核,所以得到100个数。每个数代表一个高度提纯的特征

最后在经过一个分类器(也是一个全连接层)对这些特征再进行一次计算(降维),将其中的某几个特征进行组合,得到属于各个类别的概率。

参考:

https://www.cnblogs.com/MrSaver/p/10357334.html

https://blog.csdn.net/v_road/article/details/89343769

缺点

参数量过大,特别是与最有一个卷积层(池化层)相连的全连接层,如图就需要 100 * 20 * 12 * 12个参数。参数量过大会导致训练速度降低,容易过拟合。