Kafka如何处理存储实现上的并发访问问题

- 一、简介

- 二、Kafka 存储方案的设计

- 2.1 相关技术选型

- 2.2 实现机制

- 2.3 生产者/消费者数据读写优化

- 三、Kafka存储方案的实践

- 3.1 实现细节与注意事项

- 3.2 系统性能测试及优化方案

- 3.3 存储方案更新与升级

- 四、Kafka 并发访问问题应用场景

- 4.1 基于 Kafka 的分布式事务

- 4.2 基于 Kafka 的大规模日志采集系统

- 4.3 基于 Kafka 的流处理系统

一、简介

Kafka 是一个分布式的消息队列,主要使用文件系统存储消息数据,支持发布订阅模式以及处理流式数据。在多个 Topic 和 Partition 存储操作时,会产生并发访问和数据冲突等问题。

二、Kafka 存储方案的设计

Kafka 存储方案的设计需要选择相关技术,并实现相应的机制来解决多个 Topic 和 Partition 的存储操作的并发及锁问题,同时需要对生产者和消费者数据读写进行优化。

2.1 相关技术选型

2.1.1 文件系统选择

Kafka 使用的是基于磁盘的文件系统,如 ext3、ext4、XFS 等,这些文件系统都被广泛地应用在大数据场景中。目前大部分 Kafka 消息存储是基于 Linux 兼容的文件系统,这些文件系统支持数据的持久化存储和快速恢复。

2.1.2 锁机制选择

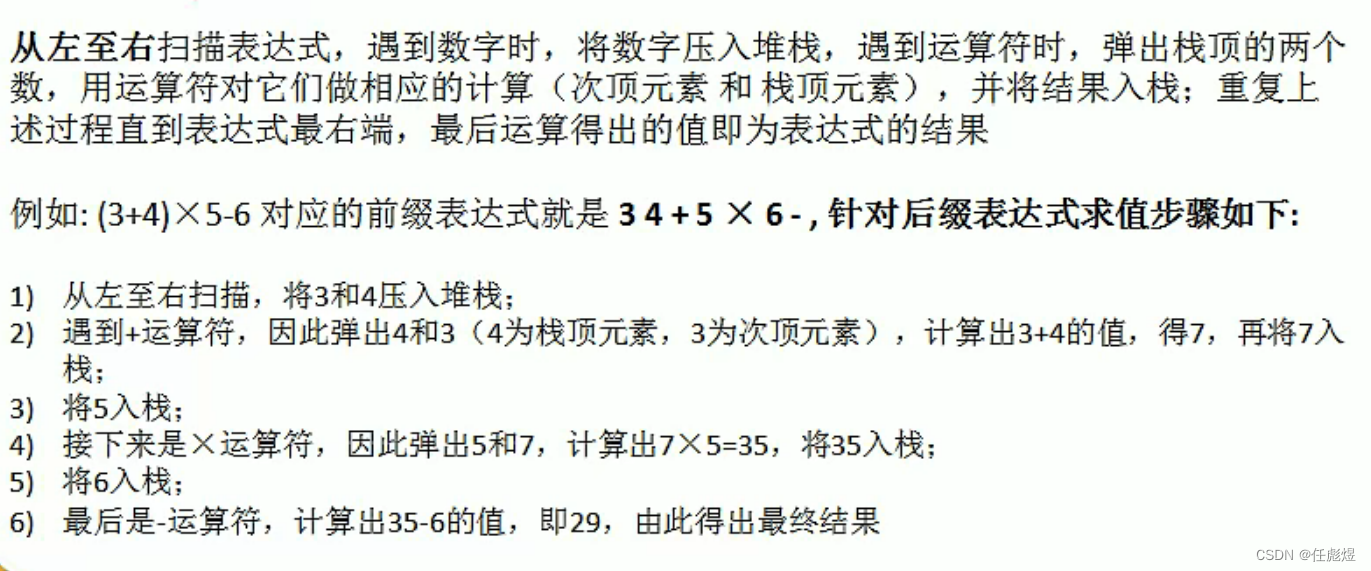

Kafka 中的 Topic 和 Partition 都可以被多个生产者同时写入和多个消费者同时读取。在解决 Topic 和 Partition 的并发写入问题上,Kafka 采用的是基于文件锁的机制,即每个文件对应一个锁文件,锁文件与数据文件名相同,后缀为 .lock。采用锁机制可以实现在多个生产者同时写入一个 Partition 时,每个生产者都获得自己的锁,保证顺序写入和数据的一致性。

2.2 实现机制

2.2.1 顺序写入和缓冲的实现

Kafka 在设计时采用了基于顺序写的机制,这种机制能够最大化磁盘的吞吐量,提升数据的写入效率。同时,Kafka 还采用了内存缓冲技术来缓存待写入的数据,减少写磁盘的频率。当达到一定条件时,再将缓存数据批量写入磁盘,这样能够显著地提高 Kafka 的性能表现。

2.2.2 压缩和索引的实现

Kafka 同时支持消息的压缩和索引,通过压缩和索引使得 Kafka 总体的数据量变小,并且在消费时能够快速定位需要的数据,提高了读取效率。

2.3 生产者/消费者数据读写优化

为了优化生产者和消费者的数据读写效率,Kafka 中采用了消息缓存、零拷贝技术、磁盘分区等技术方案进行优化。此外,Kafka 还使用了批处理的方式将多条数据组合成一个大的消息进行发送,减少了与服务端通信的次数,同时还能够提高数据传输效率。

// kafka 生产者生产消息示例

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");Producer<String, String> producer = new KafkaProducer<>(props);

for(int i = 0; i < 100; i++)producer.send(new ProducerRecord<>("test-topic", Integer.toString(i), Integer.toString(i)));

producer.close();// kafka 消费者消费消息示例

Properties props = new Properties();

props.put("bootstrap.servers", "localhost:9092");

props.put("group.id", "test-group");

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

consumer.subscribe(Collections.singletonList("test-topic"));

while (true) {ConsumerRecords<String, String> records = consumer.poll(Duration.ofMillis(100));for (ConsumerRecord<String, String> record : records)System.out.printf("offset = %d, key = %s, value = %s%n", record.offset(), record.key(), record.value());

}

三、Kafka存储方案的实践

3.1 实现细节与注意事项

在使用Kafka存储数据时,有以下几个要点需要注意:

- 消息的键和值大小限制:在默认设置下,Kafka消息中的键和值大小最大只能为1MB。如果需要发送更大的消息,则需要修改 broker 配置中的

message.max.bytes和replica.fetch.max.bytes参数,并重新启动 broker。 - 消息的持久化存储:Kafka中的消息是以追加的方式写入磁盘的,一旦写入就不能修改。由于Kafka默认的消息保留策略是按时间保留,因此消息会被自动删除。如果需要将消息持久化存储,可以将消息保留策略更改为按大小或者按消息数量进行保留。

- 消息的可靠性保证:为了保证消息的可靠性,可以通过以下方式进行配置:

acks参数:用于指定必须收到哪些副本的确认,才能认为消息已成功发送。有三个取值:0表示不需要确认;1表示需要至少收到一个副本的确认;all表示需要等待所有可用副本的确认。retries参数:当发生网络错误或分区错误时,可以重试发送消息的次数。默认为0,表示不进行重试。该参数应该与retry.backoff.ms参数一起使用,以控制重试之间的延迟时间。max.in.flight.requests.per.connection参数:用于指定客户端在收到服务端响应之前可以向服务端发送的最大请求次数。默认为5,表示Kafka可以在收到前五个请求的响应之前发送另外五个请求。

3.2 系统性能测试及优化方案

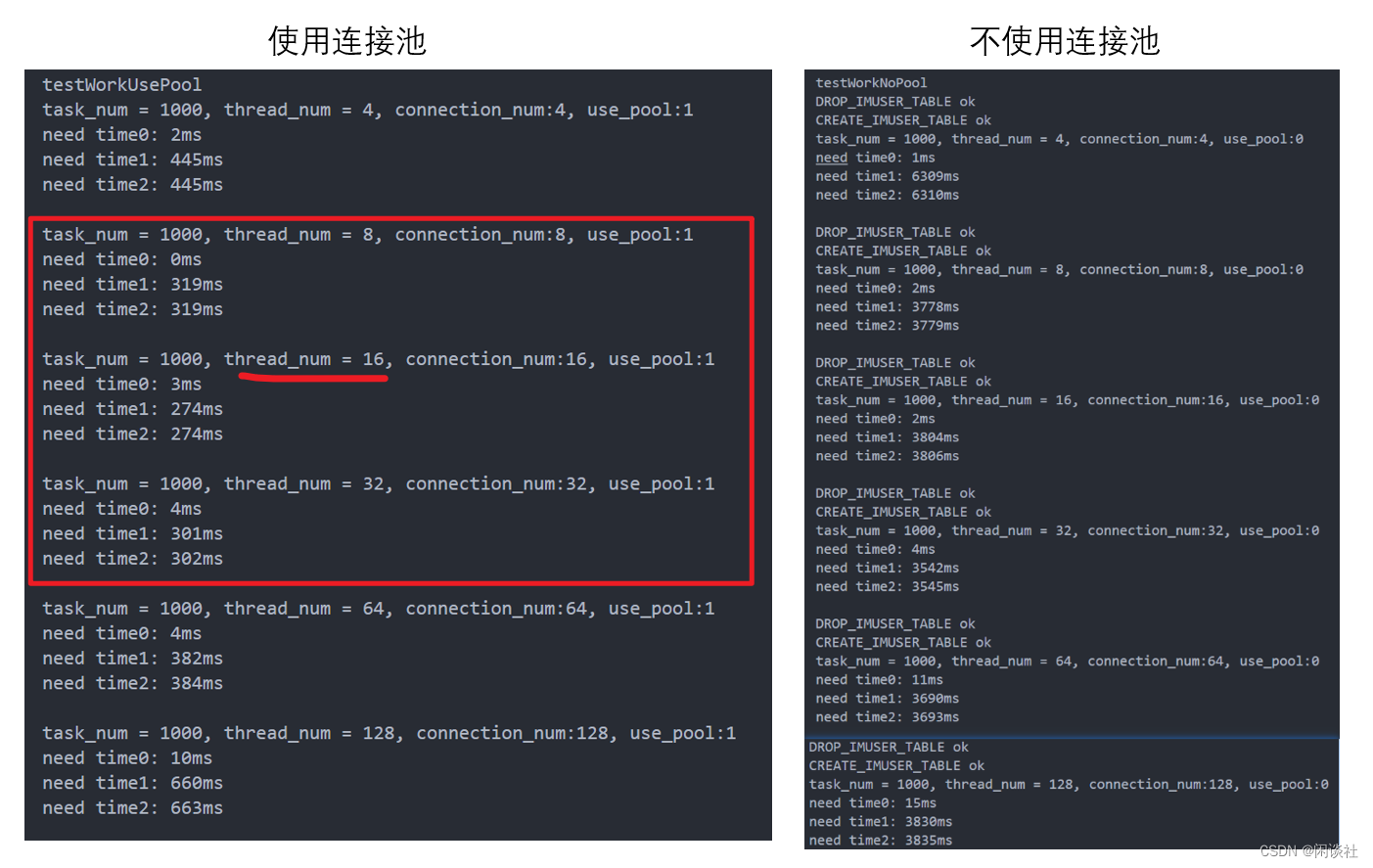

在实际使用过程中,需要对Kafka存储方案的性能进行测试和优化。以下是几种常见的性能测试和优化方案:

- 测试并发读写性能:通过向 Kafka 发送大量并发消息,以测试其读写性能。如果出现性能瓶颈,则可以考虑增加分区数,提高 broker 配置中的

num.io.threads和num.network.threads参数,增加Kafka集群规模等方式来优化性能。 - 测试数据保留策略性能:通过设置不同的消息保留策略(按时间、大小或数量),来测试 Kafka 的性能表现。如果出现数据存储瓶颈,则需要调整cleanup.policy参数,或者通过添加消费者来降低消息存储压力。

- 测试消息大小和数量与吞吐量之间的关系:通过发送不同数量和大小的消息,来测试 Kafka 的性能表现。根据测试结果,可以对消息大小和数量进行优化,以达到更好的吞吐量。

3.3 存储方案更新与升级

当Kafka存储方案需要更新或升级时,需要注意以下几个要点:

- 备份数据:在更新或升级之前,需要备份所有数据。最好将数据备份到一个独立的存储介质上,以免丢失数据。

- 停止服务:在升级 KafKa 时,需要停止所有服务,并确保在升级完成之前不会启动任何服务。

- 升级顺序:应该按顺序升级各个组件,例如,首先升级Zookeeper,然后是broker,最后是Kafka-client。

- 测试和验证:在升级完成之后,需要进行测试和验证,以确保系统能够正常工作,并且没有数据丢失。

四、Kafka 并发访问问题应用场景

Kafka 是一个分布式的消息队列系统,广泛用于实时数据流处理、日志、事件和指标等场景。在 Kafka 存储实现上,它采用了一些优秀的设计,以解决并发访问问题,因此也可以应用于以下几个场景。

4.1 基于 Kafka 的分布式事务

Kafka 可以支持多个生产者同时向同一个 topic 发送消息,并且保证消息的顺序性。在实现分布式事务时,Kafka 可以作为事务日志来使用,记录所有与业务相关的操作过程。利用 Kafka 事务日志机制中的幂等性和原子性特征,可以确保分布式事务的正确性和可靠性。

以下是 Java 代码示例:

// 创建 Kafka 生产者

KafkaProducer<String, String> producer = new KafkaProducer<>(props);

// 初始化事务

producer.initTransactions();

try {// 开启事务producer.beginTransaction();// 发送消息producer.send(new ProducerRecord<String, String>(topic, message));// 提交事务producer.commitTransaction();

} catch (ProducerFencedException | OutOfOrderSequenceException | AuthorizationException e) {// 异常处理producer.abortTransaction();

} catch (KafkaException e) {// 异常处理producer.abortTransaction();

}

4.2 基于 Kafka 的大规模日志采集系统

在大规模的日志采集系统中,需要处理巨量的日志数据并实时传输到存储系统中,这就需要保证高效的数据流处理和可靠的消息传输。Kafka 可以作为日志搜集的中间件来使用,接受日志信息并分发到下游存储层,同时保证消息的可靠性、顺序性和重试机制。

// 创建 Kafka 生产者

KafkaProducer<String, String> producer = new KafkaProducer<>(props);

// 发送消息

producer.send(new ProducerRecord<String, String>(topic, message));

4.3 基于 Kafka 的流处理系统

Kafka 还可以作为流处理系统的基础架构,主要用于数据输入、输出和流转等功能。流处理系统会采集海量实时数据,并进行计算、过滤和聚合等操作,最终将结果输出到下游存储系统中。Kafka 可以作为流处理系统中的缓存层来使用,保证数据的及时性和可靠性。

// 创建 Kafka 流处理器

StreamsBuilder builder = new StreamsBuilder();

// 输入源头 topic1

KStream<String, String> inputStream = builder.stream("topic1");

// 数据处理

KStream<String, String> outputStream = inputStream.filter((k, v) -> v.length() > 10);

// 输出目标 topic2

outputStream.to("topic2");

// 构建拓扑并启动应用

KafkaStreams streams = new KafkaStreams(builder.build(), props);

streams.start();

上述示例代码演示了如何用 Kafka 进行数据流的过滤和输出,从 topic1 中过滤出长度大于 10 的数据并输出到 topic2 中。