TF1与TF2的求和程序对比

相比于TF1,TF2的变化某种程度上是翻天覆地的。TensorFlow2.0在1.x的基础上进行了重新设计,针对提高使用者的开发效率,对API做了精简,删除了冗余的API并使之更加一致。同时由原来的静态计算图转为动态计算图优先,使用function而不是session执行计算图。

一、两数求和程序

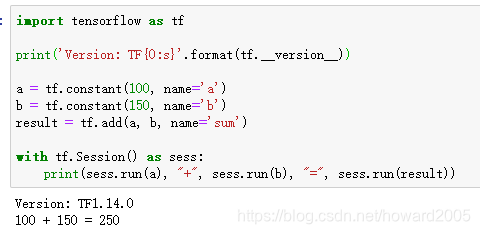

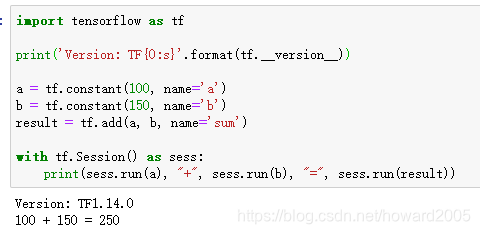

1、TF1的两数求和程序

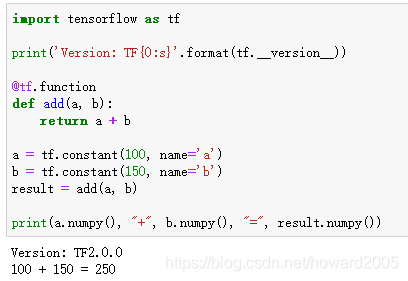

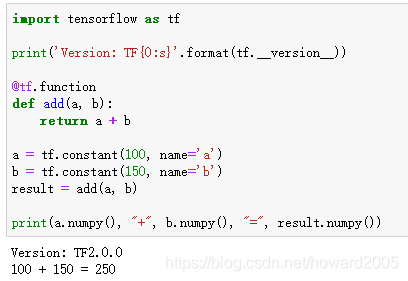

2、TF2的两数求和程序

二、阶乘求和程序

1、TF1的阶乘求和程序

TF1与TF2的求和程序对比

相比于TF1,TF2的变化某种程度上是翻天覆地的。TensorFlow2.0在1.x的基础上进行了重新设计,针对提高使用者的开发效率,对API做了精简,删除了冗余的API并使之更加一致。同时由原来的静态计算图转为动态计算图优先,使用function而不是session执行计算图。

一、两数求和程序

1、TF1的两数求和程序

2、TF2的两数求和程序

二、阶乘求和程序

1、TF1的阶乘求和程序