Autonomous Driving in Adverse Weather Conditions: A Survey - 恶劣天气条件下的自动驾驶:一项调查(arXiv 2021)

- 摘要

- 1. 引言

- 2. 自动驾驶汽车概述

- 2.1 社会意义

- 2.2 传感器

- 2.2.1 激光雷达

- 2.2.2 摄像机

- 2.2.3 雷达

- 2.2.4 超声波

- 2.2.5 GNSS/INS

- 2.3 目标检测、跟踪和定位

- 2.4 规划和控制

- 3. 不利天气影响

- 3.1 对激光雷达的影响

- 3.1.1 雨和雾

- 3.1.2 雪

- 3.1.3 对其他激光雷达类型的影响

- 3.1.4 其他

- 3.2 对雷达的影响

- 3.3 对摄像机的影响

- 3.3.1 雨和雾

- 3.3.2 雪

- 3.3.3 光照条件

- 3.4 其他问题

- 4. 传感器融合和机械解决方案

- 4.1 传感器融合模式

- 4.1.1 雷达占主导地位

- 4.1.2 摄像机占主导地位

- 4.1.3 综合融合

- 4.2 机械解决方案

- 4.2.1 保护和清洁

- 4.2.2 被动附件

- 4.2.3 完整性和重新校准

- 5. 不同天气条件下的感知增强

- 5.1 雨水

- 5.2 雾

- 5.3 雪

- 5.4 光相关

- 5.5 污染

- 6. 分类和评估

- 6.1 天气分类

- 6.2 能见度分类

- 6.3 风险评估

- 7. 定位和建图

- 7.1 同时定位和建图

- 7.2 先验图

- 7.3 传感器解决方案

- 7.4 横向定位

- 8. 规划和控制

- 8.1 规划

- 8.2 控制

- 9. 不利条件下的辅助方法

- 9.1 路面检测

- 9.2 鸟瞰图

- 9.3 路边装置

- 9.4 V2X

- 9.5 其他

- 10. 工具

- 10.1 数据集

- 10.2 模拟器和实验设施

- 11. 结论

- References

声明:此翻译仅为个人学习记录

文章信息

- 标题:Autonomous Driving in Adverse Weather Conditions: A Survey (arXiv 2021)

- 作者:Yuxiao Zhang, Alexander Carballo, Hanting Yang, Kazuya Takeda

- 文章链接:https://arxiv.org/pdf/2112.08936.pdf

摘要

自动驾驶系统(ADS)为汽车行业开辟了一个新领域,为未来的交通运输提供了更高的效率和舒适的体验。然而,恶劣天气条件下的自动驾驶一直是阻碍自动驾驶车辆(AVs)长期达到4级或更高自主性的问题。本文以分析和统计的方式评估了天气给ADS传感器带来的影响和挑战,并调查了针对恶劣天气条件的解决方案。关于每种天气的感知增强的最新技术得到了全面报道。外部辅助解决方案,如V2X技术、当前可用数据集中的天气条件覆盖范围、模拟器和带有气象室的实验设施都得到了明确的分类。通过指出自动驾驶领域目前面临的各种主要天气问题,并回顾近年来的硬件和计算机科学解决方案,本调查全面概述了恶劣天气驾驶条件下ADS发展的障碍和方向。

索引术语 - 自动驾驶、恶劣天气条件、传感器融合、感知增强、传感器鲁棒性

1. 引言

自动驾驶汽车(AVs)和自动驾驶系统(ADS)是当今汽车的前沿。自汽车诞生以来,没有任何技术以如此革命性的方式改变了汽车。自动驾驶汽车减少了交通事故和死亡人数,减少了能源消耗和空气污染,增加了可靠出行选择有限的人的交通出行机会。无人驾驶汽车正在从根本上改变人和货物的运输方式,并将在很大程度上造福未来社会。然而,涉及装有ADS的车辆的事故和伤亡仍在令人不安地增加。为了更广泛地认识自动驾驶汽车的优点,必须适当处理ADS的直接问题,即自动驾驶汽车在恶劣天气条件下的性能[1][2][3]。

天气现象对交通和运输有各种负面影响。平均而言,全球降水量占时间的11.0%[4]。已经证明,在雨天发生事故的风险比正常情况高70%[5]。世界上77%的国家都会下雪。以美国国家统计数据为例,每年在下雪或结冰的道路上,或在降雪或雨夹雪期间,有超过3万辆汽车发生碰撞[6],因此雪的威胁是真实的。雾、霾、沙尘暴和强光等现象严重降低了能见度,给驾驶带来的困难显而易见[7]。由天气直接或间接引起的次要问题,如热和冷、污染或车辆硬件损坏,也会对载人和自动驾驶汽车产生不可预测或不利的影响。

图1. Mcity 4级自动驾驶穿梭机。图片由密歇根大学Huei Peng博士提供。

随着近年来的一些快速发展,世界各地已经有许多可部署的自动驾驶汽车处于试验阶段或运行中,并且借助LiDAR(光探测和测距,有时是光成像探测和测距)技术,一些制造商声称已经或即将交付具有等同于SAE标准4级自主性的车辆[8],如Waymo在亚利桑那州凤凰城的商业自动驾驶出租车服务[9]。在过去几年中,密歇根大学在安娜堡校区成功举办了一个名为Mcity的无人驾驶穿梭机项目,这是美国第一个4级自动穿梭机项目。如图1所示[10]。然而,目前所有自动驾驶汽车不可避免的一个问题是,由于安全问题,它们在大雨或雪中几乎无法运行。尽管在恶劣的天气条件下进行了大量的研究和测试,但当穿梭机的挡风玻璃雨刮器需要在雨或雪中连续运行时,Mcity穿梭机仍将关闭运行。Sohjoa Baltic项目[11]揭示,由于爱沙尼亚冬季气温低,自动驾驶迷你巴士无法在一夜之间正常充电,并且由于额外的供暖能耗,每天的运行时间不得不减少。另一方面,来自芬兰的Sensible4不会在雪地上停车,并且已经开始在下雪天气中进行公开试驾,如图2所示[12]。

图2. 雪地中的Sensible4自动公交车。图片由Sensible4的Tsuneki Kaiho先生提供。(https://sensible4.fi/)

看看我们现在已经掌握的情况,值得注意的是,由于法律上潜在的事故责任问题和车人交接的必要性,大多数主要汽车企业都计划跳过3级自主(有条件自动化),直接跳到4级,而奥迪A8和本田则是目前在普通市场上宣布3级承诺的少数玩家[13]。可以肯定的是,几乎所有汽车行业的主流制造商都可以提供2级自主,或者说多个高级驾驶员辅助系统(ADAS),主要表现在自适应巡航控制和手动/自由车道居中功能上[14]。然而,如图3所示,在雨天或雪天条件下,2级的性能几乎没有达到预期,车道保持功能在高速公路雪中打滑时使汽车转向过度。特斯拉的自动驾驶仪可以设法在道路标记清晰可见的情况下在正常的雨雪天气中导航,但在某些棘手的情况下,如暴雨或有覆盖的车道线,仍会遇到困难[15]。至于另一个典型的2级提供商,通用汽车的超级巡航,官方禁止在湿滑或其他不利条件下使用自动驾驶功能,包括雨、雨夹雪、雾、冰或雪[16]。显然,恶劣的天气条件限制了人类驾驶者的方向盘,而且还不能完全相信自动驾驶汽车会独自驾驶。因此,为了让ADS继续前进到下一个时代,自动驾驶汽车需要更多的时间来度过所有的天气。

图3. 2级车道保持功能,在高速公路上雪地滑行时车辆转向过度。

来自世界各地的许多研究人员都在研究一种特定传感器在处理雨和雾方面的更好能力,但很少有人在研究雪。除了对自动驾驶中的驾驶性能评估的概述[17]外,还有关于天气条件下ADS中常用传感器性能评估的文献综述[18][19][20]。目前还没有一篇论文全面涵盖了所有天气现象、对AV的所有直接和间接影响、不同AV组件在恶劣天气条件下的性能、硬件和软件方面的传感器解决方案、每种天气的感知增强方法以及其他技术的潜在解决方案。本文的主要贡献包括:填补文献中关于天气的空白,对传感器和相关解决方案进行全面分析,并提供自动驾驶天气相关文献索引的快速访问。

本文的其余部分分为十个部分:第2部分概述了自动驾驶,而第3部分介绍了天气给ADS传感器带来的挑战和影响。第4节介绍了与天气相关的传感器融合和机械解决方案,第5节介绍了各种天气的感知增强方法;第6、7和8节陈述了分类和评估、定位以及规划和控制。第9节给出了不利天气解决方案的辅助方法,第10节总结了支持天气条件的数据集、模拟器和实验设施。第11节总结并总结了这项工作。

图4. 恶劣天气条件下自动驾驶系统的信息流程图。部分基于[1]

2. 自动驾驶汽车概述

自动驾驶汽车也称为自动驾驶汽车,是一种能够感知周围环境并安全驾驶的车辆,几乎不需要或不需要人工输入[21]。图4中的信息流程图显示了自动驾驶体系结构及其与天气条件的关系。作为车辆传感器的信息源,环境状态直接受天气条件的影响。这些变化增加了ADS利用受损数据完成目标检测、跟踪和定位任务的难度,因此规划和控制也将不同于正常情况。天气也会影响自我车辆本身,并产生诸如风和路面状况等副作用。自我车辆或周围车辆状态的变化所带来的后果导致环境状态的变化,并形成一个循环。

以下小节将解释AV的主要组成部分及其社会意义。

2.1 社会意义

在所有自动化车辆项目中,认识并解决广泛的法律、法规和责任问题至关重要。幸运的是,世界各地的立法与当前的研究趋势保持着良好的同步,大多数情况下允许达到4级操作(条件适用)。图1所示的Mcity项目是一个很好的榜样,密歇根州是首批允许在开放道路上测试4级自动驾驶汽车的州之一[22]。他们的操作协议要求“操作车辆”的人员能够在紧急情况下控制车辆的移动。或者,如果人员无法控制,则车辆必须“能够达到最低风险条件”[3]。这就是为什么Mcity穿梭机上仍然配备了一名具有超控控制功能的操作员,尽管绝对没有方向盘或任何其他传统的操纵装置。另一个汽车大国日本也在2020年修订了相关立法,允许3级或更高级别的运营[23],并在2020年东京奥运会期间部署了丰田的4级自动穿梭机运送运动员。然而,其中一辆自动驾驶公交车撞上了一名视障残疾人[24],这正是进一步开展自动驾驶研究的原因。当局通过免除驾驶员在车内的绝对要求,为ADS研究创造了大量空间,这仍然是非常有帮助的。

社会调查显示,有过电动汽车驾驶经历的人,无论是与一辆电动汽车一起驾驶,还是在现实生活中看到一辆电动车辆在运行,其满意度和认可率都超过75%,对这一主题的兴趣也增加了60%[25],这表明了自动驾驶汽车进一步发展的积极前景。韩国延世大学数学模型的结果表明,信任和感知有用性是AV使用意图的核心决定因素[26]。所述信任的一个主要来源是技术能力,这意味着在不利天气中的未决挑战在公众接受AVs方面起着重要作用。

2.2 传感器

天气条件在自然界中自发发生,并影响AVs存在的环境状态。环境的变化导致车辆传感器感知的差异,车辆传感器是ADS的主要组件。以下是用于AV的主要感知传感器。

2.2.1 激光雷达

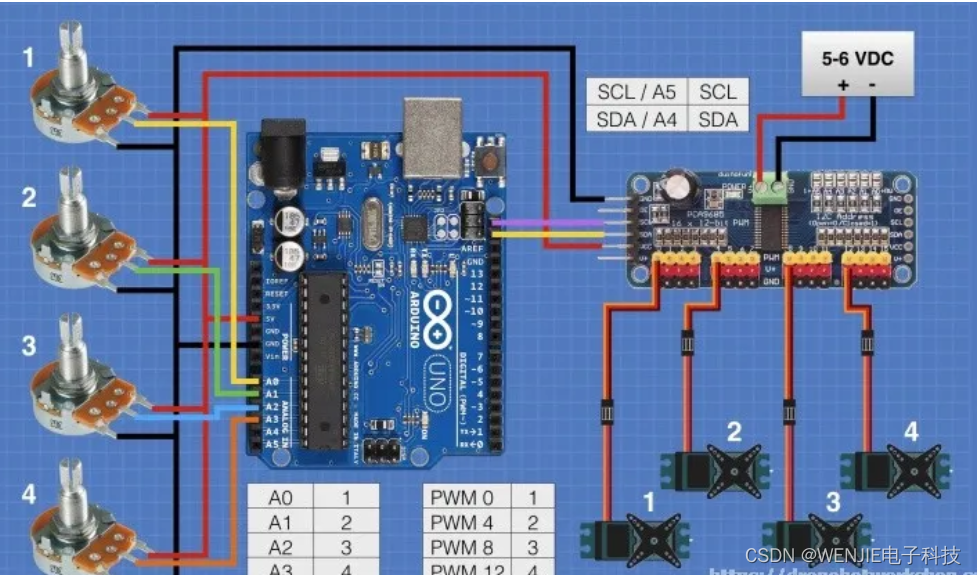

激光雷达是自动驾驶领域的核心感知传感器。3D激光雷达在汽车上的使用还没有超过十年,并且已经证明了其在ADAS和AVs中的不可或缺性,具有高测量精度和独立于照明的传感能力[27]。这种三维激光扫描技术具有一些关键属性:测量范围、测量精度、点密度、扫描速度和配置能力、波长、对环境变化的鲁棒性、形状因素和成本[2]。图5显示了用于AVs的一些常见3D激光雷达。

图5. Velodyne、Hesai、RoboSense、Ouster等公司的多个3D激光雷达。

现代激光雷达具有内部属性灵活性。许多激光雷达模型都配备了最强信号返回和最后一次信号返回(也称为回波)之间的模态切换,对于晴朗天气,两者都提供相同的点云配置。假设在雾越来越浓的情况下,最后一次回归显示出与参考点云的重叠比最强回波更大。Velodyne HDL64-S3D[28]等激光雷达还提供输出激光功率和噪声领域级别手动调节功能。虽然更高的功率输出保证了更长的检测范围,但正确的噪声水平选择有助于通过兼容的去噪方法提高准确性[29]。

固态LiDAR和MEMS LiDAR等新型LiDAR技术在很大程度上依赖于半导体行业,目前仍处于研发阶段。与传统的旋转激光雷达不同,固态激光雷达需要光束控制来调整激光方向,其中一种流行的方法是通过光学相控阵(OPA)平台。由于两种主要材料Si和SiN的热光系数相差超过一个数量级[30],热光调谐目前是主要方法。热调谐的可调谐性受到某种程度的限制,而波长调谐可以在1550 nm激光波长附近实现每100 nm变化几十度的可调谐[31]。近年来,还出现了其他尖端光束控制技术,如元表面[32]。

FMCW(调频连续波)激光雷达是一种使用连续波进行相干检测的技术。与使用振幅调制(AM)方法的传统激光雷达不同,FMCW激光雷达发射连续激光束,以测量波形从目标反射时的频率变化,这使其能够看到远达300米的距离,并基于多普勒频移测量瞬时速度[33]。更长的检测范围和准确的速度感测有助于在一定距离内识别相关的高运动目标,并给AV足够的时间做出反应。尽管这种差异可能只有一秒钟的一小部分,但考虑到其巨大的惯性,它仍然会对重型车辆(如公共汽车或货车)产生巨大的影响。最重要的是,没有检测到与FMCW激光雷达的本地振荡器不匹配的光,这提供了对来自太阳光的干扰和其他AVs之间的串扰的免疫力,甚至是自我车辆之前的信号本身。这一优点将这种激光雷达的注意力集中在解决我们的天气问题上。

还有另一种不常见的激光雷达称为超连续光谱激光器[34],这是一种在极短脉冲持续时间内泵浦的宽带光束。此类技术广泛应用于气体传感、光学通信等领域,Outsight AI是一家以在ADS领域开发该技术而闻名的公司[35]。这种激光雷达工作在短波红外波段,可以实时进行多光谱探测。SWIR波段的每个波长都有一个基于目标材料的独特反射光谱特征,例如雪、冰、皮肤、棉花、塑料、沥青等。这样,就可以从人体模型或海报中识别出真实的人,或者对正在进行的天气进行分类。

2.2.2 摄像机

尽管相机是一项比激光雷达更古老的技术,但它实际上是ADS中绝对不可替代的一个元素,同时也是在恶劣天气条件下最脆弱的元素之一。除了我们熟悉的普通相机外,还有几种相机类型可用于AVs。

立体相机有两个或多个镜头,每个镜头都有一个单独的图像传感器,这提供了捕获3D图像的能力,就像人类的双眼视觉一样。热相机使用红外辐射来创建图像。远红外(FIR)相机工作在8-12µm,可以看到热源,而近红外(NIR)相机通常工作在700-1400 nm左右,可以穿透可见光无法穿透的东西,如雾霾、轻雾和烟雾[36]。事件摄像机,如动态视觉传感器(DVS),不像传统摄像机那样使用快门捕捉图像,而是报告任何亮度变化的单个和异步像素[37]。事件摄像机提供了非常高的动态范围和无运动模糊,但传统的视觉算法不适用于异步事件输出,因此汽车上的应用通常需要额外的算法。高动态范围(HDR)相机是一种类型的相机,它以三种不同的快门速度捕捉同一场景的三幅图像,对应不同的亮度:亮、中和暗。然后,通过上述三种方法的组合,产生了既能揭示黑暗中的东西又能揭示眩光的HDR图像[38]。显然,这样的功能使HDR相机在强光或阴影条件下具有强大的优势,但它对移动目标有严重的限制,因为连续图像之间的任何移动都会在将它们组合在一起后产生交错的模糊频闪效果。此外,由于需要多幅图像来实现所需的亮度范围,因此需要额外的时间,这对于视频条件来说是一种奢侈。为了增加视频的动态范围,为了获得两个不同曝光的图像,帧速率或分辨率将被减半。如果不希望牺牲帧速率或分辨率,则需要具有双增益架构的CMOS图像传感器。为了用于ADS,HDR相机可能需要在图像处理结构中内置一些额外的计算算法。无论如何,在应对恶劣天气的无休止尝试中,每种相机都有自己的ADS份额。

2.2.3 雷达

早在LiDAR掌舵自动驾驶之前,汽车雷达系统就是ADAS领域的老手。汽车雷达由发射机和接收机组成。发射器发出无线电波,击中目标(静止或移动)并反弹到接收器,确定目标的距离、速度和方向。在特斯拉宣布将转向基于摄像头的纯视觉自动驾驶系统[39]之前,他们多年来一直将雷达作为主要核心[40],并巩固了雷达在ADS中的地位。汽车雷达通常工作在24 GHz和77 GHz之间的频段,即毫米波频率,而一些芯片上雷达也工作在122 GHz。雷达可用于检测目标和障碍物,如驻车辅助系统,也可用于检测相对于前方车辆的位置和速度,如自适应巡航控制系统[41]。

雷达也有一种FMCW形式,其中发射信号的频率以已知的速率连续变化,这使得发射和反射的差异与飞行时间、麦角距离成比例。除了速度测量优势,FMCW雷达在自动驾驶中显示出优越的距离分辨率和精度[42]。

2.2.4 超声波

在所有常见的汽车传感器中,在ADS模态中很少使用的是超声波传感器。超声波安装在保险杠和车身各处,作为驻车辅助传感器和盲点监视器,长期以来一直是最勤奋和最便宜的传感器[43]。超声波传感器的原理与雷达非常相似,都是通过计算发射的电磁波的传播时间来测量距离,只有超声波在40至70 kHz的超声波波段工作。因此,超声波传感器的探测范围通常不超过11米[44],这限制了超声波传感器在倒车等近距离用途中的应用。这并不像人们没有试图扩大超声波的有效范围,使其适合远程检测[45],或者超声波在自动驾驶中没有用处。事实上,特斯拉的“召唤”功能使用超声波在停车场和车库门之间导航[46]。

2.2.5 GNSS/INS

导航或定位系统是机器人、自动驾驶汽车、无人机(无人机)、飞行器、船舶甚至智能手机中最基本的技术之一。Groves[47]提供了各种测量类型和相应定位方法的列表。

全球导航卫星系统(GNSS)是由多个卫星星座组成的国际系统,包括GPS(美国)、GLONASS(俄罗斯)、北斗(中国)、伽利略(欧盟)等系统以及其他星座和定位系统。GNSS工作在L波段(1至2 GHz),可以穿过云层和雨水,在路径衰减方面对传输信号的影响最小。GNSS传感器包括一个或多个天线、可重新配置的GNSS接收器、处理器和存储器。GNSS通常与实时动态定位(RTK)系统结合使用地面基站来传输校正数据。

非GNSS宽带无线电信号用于室内、GNSS信号缺失区域(即隧道)和城市定位。此类系统包括基于Wi-Fi的定位系统(WPS)、蓝牙和超宽带(UWB)信标、地标、车辆到基础设施(V2I)站、射频ID(RFID)标签等。

里程表和惯性导航系统(INS)使用航位推算来计算位置、速度和方位,而不使用外部参考。INS结合了运动传感器(加速度计)、旋转传感器(陀螺仪)以及磁场传感器(磁强计)。对于先进的惯性导航系统,使用光纤陀螺仪(FOG):没有移动部件,两束激光束通过非常长的光纤线轴以相反方向传播,比较两束激光的相位差,并与旋转速度成比例。

上述的组合,例如GNSS与INS(GNSS+INS)和其他传感器,以及诸如卡尔曼滤波器和运动模型的算法,是提高定位精度和减少漂移的常用方法。例如,高级导航[48]的空间FOG双GNSS/INS具有8mm水平位置精度和约0.005°滚动/俯仰精度。

2.3 目标检测、跟踪和定位

传感器可以被视为ADS感知的手段。除了感知周围环境外,感知的另一个主要目的是提取对AV安全导航至关重要的关键信息。在常识上,这些信息可能意味着道路上的汽车和行人、交通灯和路标,以及静态目标,如停放的汽车或城市基础设施,因为这些是我们作为人类驾驶时需要注意的。我们会注意这些事情,这也是任何驾驶的首要规则,背后的最终原因是我们需要避免与它们发生碰撞。为了实现这一点,我们首先需要知道这些东西的存在以及它们的位置,即目标检测。计算机视觉领域中的一般目标检测是确定图像中特定类别目标的存在,然后通过矩形边界框确定它们的大小,这是当今自动驾驶数据集中的标签。YOLO(你只看一次)[49]将目标检测演变为具有空间分离边界框的回归问题,并提供目标类概率,这是目前最流行的方法之一。至于ADS的其他传感器,如LiDAR和雷达,通过信号返回来显示对目标的检测。然而,考虑到LiDAR相对较高的密度,一些方法(如PointPillars[50]、Second[51]和Voxel-FPN[52])允许正确识别点云中的目标类。

显然,为了避免冲突,只知道别人的位置是不够的,但知道自己的位置同样重要,这就是定位的目的。就自动驾驶而言,定位是AV在给定环境中相对于参考系的自我位置的认知[53]。一些定位方法很大程度上依赖于对周围环境中某些元素的成功检测,我们将在第7节中讨论。

但同样,对于具有高度自主性的AV来说,仅仅是其自身和被检测目标的位置是不够的。只有有了对方的未来轨迹,我们才能在相对动态的情况下做出正确的决定,避免碰撞。感知航向方向和移动速度并预测对手轨迹的过程就是目标跟踪。作为自动驾驶环节的一部分,它对自我车辆的后续规划和控制非常重要。为了更好地关注天气状况,本文没有深入探讨这一点。有关目标检测和跟踪的更多详细信息,请参见[1]。

2.4 规划和控制

规划通常意味着自动驾驶中的两个子任务:全局路线规划和局部路径规划。全球规划师的工作是在指定给定的起点和目的地时生成道路选项和选择。本地路径规划是指在不碰到任何障碍物或违反任何规则的情况下执行道路选择,这在很大程度上由ADS的其他模块(如目标检测)来确保。有关一般运动规划的详细信息,请参见[54]。

AV控制在三个方面实现:转向、油门和制动输入,几乎每辆车也是如此[64]。某些致动器的激活是ADS主机基于感知信息和处理分析做出的决定的直接结果。方向盘、油门和制动器的输入控制AV的方向、速度和加速度动态,最终实现“驾驶”。车辆还可以在电子控制单元(ECU)或车辆控制单元(VCU)处通过接入诸如声纳之类的简单传感器来实施低级别的补充安全措施。

通过带来环境状态变化,天气条件正在影响ADS传感器的正常感知功能,这导致以下检测、规划和控制等方面的复杂性。同时,一些通常无法被感知传感器感知到的其他天气影响,如风和路面状况变化,也直接造成自我车辆,并对车辆状态造成异常。作为返回,自我车辆状态的变化进一步影响其传感器的正常运行;自我车辆行为的改变会影响其他周围车辆,并导致原始环境状态的改变,因为周围车辆本身就是环境的一部分。到目前为止,由天气条件的出现导致的恶性循环已经形成,如图4所示。这就是为什么在恶劣天气条件下研究自动驾驶很重要的原因。

3. 不利天气影响

天气挑战已经成为ADS的瓶颈一段时间了,并且已经做了很多努力来解决它。事实上,气象学会已经研究了恶劣天气和道路安全的联系很长时间了。早在自动驾驶汽车还没有引起市场太多关注的时候,Perry等人[65]就彻底回顾了湿滑路面和结冰带来的危险、高速公路上的能见度下降以及对驾驶员决策过程的影响、天气引发的事故以及国际上促进道路安全的努力。时间过去了,现在AV继续战斗。

十多年前,R.H.Rasshofer等人[66]已经尝试分析天气对汽车激光雷达系统的影响。他们提出了一种在真实测试和人工环境合成目标模拟之前的方法,即在真实天气条件下再现参考激光雷达测量的光学返回信号。信号参数如脉冲形状、波长和功率水平被复制,天气的影响以分析的方式呈现。然而,考虑到现实世界不是一成不变的,而且合成目标不可能达到穷尽性,这种方法对于ADS来说不再足够可靠。尽管如此,他们还是开始应对恶劣天气的先驱之一。

为了更好地证明一些主要天气条件对ADS传感器的影响,表1中给出了详细的比较。值得注意的是,在本表中,三级中等影响导致感知误差高达30%的时间,也可能意味着多达30%的LiDAR点云受噪声影响,或者相机图像中多达30%的像素受失真或模糊影响。这同样适用于严重的4级影响。

表1. 各种天气条件对传感器的影响程度

3.1 对激光雷达的影响

一些关键因素,如测量范围、测量精度和点密度,可能会受到天气条件的干扰,从而影响AVs的正常运行。自概念出现以来,人们已经在恶劣天气条件下对激光雷达或整个AV设备进行了测试和验证,无论是在雾室等人工环境中,还是在斯堪的纳维亚雪原等真实世界中,甚至是在模拟环境中。

3.1.1 雨和雾

根据Fersch等人[67]对小孔径激光雷达传感器的研究,对于最常见的天气,雨水,当它不像正常的雨天那样极端时,对激光雷达和AV本身没有太大影响。激光束和雨滴之间的直接相互作用导致的散射造成的功率衰减几乎可以忽略不计:在信号保持在原始功率90%以上的标准下,并且即使对于更严格的标准(99.5%),超过10%的信号功率损失也已被证明是非常不可能的。来自发射器窗口的润湿的影响根据液滴大小而变化,当水滴相对较小时,最大衰减约为50%,当水滴约为孔径大小的一半时,最小衰减约为25%。雨水的直接影响似乎并没有真正动摇激光雷达,但仍值得注意的是,当大气温度刚好低于露点时,发射器上的冷凝水滴可能会小于[67]中的最小水滴大小,功率损失超过50%的信号很难被视为可靠的信号。此外,降雨对激光雷达的影响不仅取决于信号功率水平,还可能影响点云的准确性和完整性,这很难从数学模型或模拟中分辨出来。

当雨变得猛烈或肆无忌惮时,就会产生更严重的危害。降水率高且不均匀的降雨很可能会形成结块雾,并对激光雷达造成假障碍。因此,在测量其影响时,我们将暴雨视为浓雾或浓烟。Hasirlioglu等人[68]通过使用模拟中将信号传输路径划分为多个层的方法,并在手动降雨模拟器中使用激光测距仪验证模型,证明了在40 mm/hr和95 mm/hr的降雨率下,信号反射强度显著下降。考虑到超过50 mm/hr的降水率被视为暴雨,即使在热带地区也很少发生[69],这里的参考值在现实生活中相对较低。用真正的商用激光雷达进行的测试给出了更直接的说明。

我们可以从Carballo等人[2][70]进行的LIBRE数据集中看到,图6(b)和6(c)中的激光雷达点云由于雾、雨和潮湿条件而显示出令人沮丧的结果。如图6(a)所示,日本汽车研究所(JARI)天气实验设施雾室内产生的人工降雨,提出了一个新的问题,即大多数激光雷达探测到洒水喷头中的水是作为垂直圆柱体下落的,如图6(d)所示,这使得点云变得更加模糊。雾室与十多年前相比已经取得了长足的进步,当时研究人员仍在努力稳定能见度控制,以获得更好的测试环境[71]。然而,在更好的复制系统可用之前,真实天气测试可能无法完全被雾室所取代,否则此类研究的效率可能会因此受到影响。我们在第10.2节中对气象设施进行了全面审查。

图6. JARI特殊环境试验场的激光雷达性能测试(LIBRE数据集[2])。

图7. 雪天行驶在领先车辆后面时的激光雷达点云[72]。图片由芬兰VTT技术研究中心有限公司Maria Jokela博士提供。(https://www.vttresearch.com/en)

3.1.2 雪

与雨不同,雪是由固体物体、雪花组成的,它们很容易将自己塑造成更大的固体物体,并成为障碍物,从而导致激光雷达的错误探测,或者阻碍视线进行有用的探测。鉴于雪试验场(如雾室)不太容易接近,而且在雪中驾驶显然存在危险,因此很少进行雪效应试验。

Jokela等人[72]测试了AVs LiDAR在芬兰和瑞典雪况下的性能,主要集中在领先汽车引起的雪漩涡。图7(a)显示,对于典型的VLP-16激光雷达(Velodyne的Puck激光雷达[73]),除了传感器附近的几个噪声点外,几乎没有检测到粉末雪,但由前导车和自我车本身引起的湍流雪在点云中的前视图和后视图中产生了空隙。不同制造商的激光雷达在同一问题上可能有不同的性能。图7(b)显示RS-LiDAR-32[74]具有相同的雪漩涡空隙,但在传感器周围也有由雪造成的高密度云。因此,可以肯定地说,大气中的雪或从地面上旋转的雪可能会导致激光雷达的点云出现异常,并缩短视距。更重要的是,像Velodyne VLP-16这样的激光雷达,其设计最低工作温度为−10℃,在北半球并不罕见的寒冷环境中可能根本没有机会。当温度发生大范围变化时,例如极冷(−20◦C) 温度极高(+60◦C) 环境中,激光雷达测量的时间延迟将增加约6.8纳秒,这将激光雷达的测距范围扩大了1米以上,并降低了近场的精度[75],更不用说光电探测器和测距的灵敏度了。

3.1.3 对其他激光雷达类型的影响

目前,大多数市场使用905nm波长的激光雷达部署。然而,激光雷达的升级一直是研究界关注的焦点之一。Kutila等人[76]于2018年提出使用1550nm激光雷达来克服雾状条件,因为在此波长下允许发射更高的光功率。在我们确定其可行性之前,有必要提出激光雷达选择中的两个关键设计考虑因素:眼睛安全和环境抑制。根据国际激光产品安全标准(IEC 60825-1:2014)1级[77],大多数民用或商用激光雷达在人眼暴露的环境中使用,因此激光雷达的红外激光不得超过最大允许暴露量(MPE)或对视网膜造成任何损害。因此,激光波长的选择几乎被缩小为两种选择:800nm-1000nm和1300nm-1600nm。这就是为什么当前为AVs制造的激光雷达具有850 nm(OS1-64, Ouster LiDAR [78])、905 nm(Puck, Velodyne LiDAR [73])和1550 nm(PandarGT, Hesai LiDAR [79])波长的选择,并且它们都落入低太阳辐照度的窗口,这有助于抑制SNR较低的信号接收器的环境光[30]。1550 nm波长具有相对较大的水消光系数(图8),并且可以被晶体或眼睛的玻璃体大量吸收,因此允许比905 nm更多的能量,考虑到天气中的功率衰减困境,这似乎是一件好事[80]。

然而,根据J.Wojtanowski等人[81]对905 nm和1550 nm性能因不利环境条件而恶化的对比研究,在25 mm/hr的降雨速率下,905 nm的性能比1550 nm高两倍。1550 nm处的光传播可能比较短波长处的光衰减更小,但Kim等人[82]认为,该规则仅适用于雾霾(能见度>2 km),而在雾(能见度<500 m)中,衰减与波长无关,905 nm的测量值仍比1550 nm长60%。此外,1550 nm波在雪中的反射率比905 nm差97%[83]。较少的雪干扰不能弥补原始目标检测工作的不足。

图8. 水消光系数谱。1550nm的水对激光能量的吸收是905nm的100倍以上。[84]

以前一节中提到的FMCW激光雷达为例。像Aurora[85]和Aeva[86]这样的FMCW激光雷达制造商正在使用1550nm波长的固态激光器。尽管1550nm波长在过滤强光和抗干扰方面具有明显的优势,但在上述讨论中基本上证明了其在处理水方面的无效性。一些宣传文章可能认为,FMCW激光雷达能够很好地处理发射器上的水滴,并能够根据其速度检测能力轻松过滤掉雨滴或雪花[87],但此处省略了波长本身带来的大信号衰减,在这一阶段几乎找不到任何在不利天气条件下对FMCW激光雷达进行的现场测试。尽管1550 nm在固态激光雷达的进一步发展和CMOS(互补金属氧化物半导体)技术的兼容性方面具有一定的潜力,但其不令人满意的性能仍然无法赢得主流的青睐。从短期来看,LiDAR在硬件性能方面的升级并不像预期的那么有希望,但这并没有使LiDAR陷入困境。

类似地,超连续激光雷达的用户之一Outsight没有解释波长不是905nm或1550nm时的眼睛安全难题。考虑到超连续激光器通常工作在728-810 nm[88],关于其在该波长范围内使用的功率水平是否对眼睛有任何风险的具体信息以及其在天气条件下的现场测试中的性能并不完全清楚。与大多数FMCW激光雷达一样,目前市场上很少有固态激光雷达能够与成熟的传统旋转激光雷达竞争,但主要用于机器人,因此它们在恶劣天气条件下的性能也很少受到测试。尽管如此,新型激光雷达中的新技术,例如Baraja的光谱扫描技术[89][90],仍被期待。

3.1.4 其他

根据我们的常识,还有更多的天气现象会给交通带来问题,比如沙尘暴和雾霾。对于中东或沙漠地区这样的一些地区来说,它们可能是比雨雪更严重的问题。然而,由于在连人类都不能驾驶的条件下,注意力低下,发展缓慢,因此很难在这种天气下进行测试和研究。激光雷达与沙尘暴或危险天气有关的部分超出了公路机载或太空。CALIPSO高光谱分辨率激光雷达[91]被用于卫星监测地球大气层,并可以透过雾霾和沙尘暴进行观测。单光子激光雷达也经常用于机载激光雷达中的3D地形测绘。尽管这种技术通常用于气象学和海洋学[92],但由于其在远程能力(千米)、卓越的深度分辨率(厘米)和低功率(眼睛安全)激光源的使用方面的优势,已经有单光子雪崩二极管(SPAD)激光雷达用于汽车应用[93]。未来的空中激光雷达和无人机将面临更多的天气挑战,因为天空中的情况与地面上的情况不太一样。大气湍流会产生受风影响的时变折射梯度,导致闪烁、光束扩展和漂移[95]。由于空中激光雷达和无人机尚未投入实际使用,这种对抗性条件对自动驾驶区域的特殊影响尚未得到系统的研究,但可以肯定的是,它们需要克服这一问题,才能在未来朦胧和动荡的条件下为智能交通系统服务。第9节将介绍空中激光雷达和无人机的详细信息。

3.2 对雷达的影响

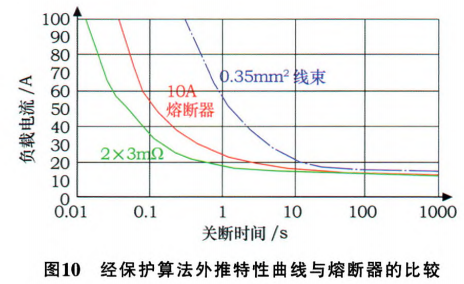

雷达在天气条件下似乎更有弹性。通过检查图9中不同降雨率下的电磁功率衰减[96][97],我们可以观察到,在25 mm/hr的大雨中,77 GHz雷达的衰减水平为10 dB/km,而在0.5 km以下的相同能见度条件下,905 nm激光雷达的衰减约为35 dB/km[98][99]。根据Sharma和Sergeyev对具有较低大气波动的非相干光子学雷达的模拟,线性调频77 GHz和1550 nm连续波激光器配置的探测范围在浓雾中可达260米,在轻雾中可达460米,在大雨中可达600米,信噪比阈值为20 dB[100]。Norouzian等人[101]还测试了雷达在降雪中的信号衰减。雪速越高,衰减越大,这是意料之中的,而湿雪由于吸水率越高,雪花越大,衰减越高。考虑到10 mm/hr的降雪已经具有相当低的能见度(<0.1 km)[102],我们得出77 GHz雷达在10 mm/hr雪中的比衰减约为6 dB/km,考虑到降雨数据,这似乎是可以接受的。

图9. 不同降雨率下电磁功率衰减与频率的关系。

在Zhang等人的研究中[18],对毫米波雷达的降雨衰减和后向散射效应以及接收机噪声进行了数学分析。他们进行了模拟,包括4种不同的场景,在不同的降雨率水平下,雷达探测汽车或行人。结果表明,当雷达截面积很小时,背散射效应会导致信号干扰加噪声比的下降,就像大雨条件下的行人一样。然而,在100mm/hr的降雨率下,退化处于个位数水平,他们的模拟将测试变量扩展到400mm/hr的降雨量,这在现实世界中基本上是不现实的,因为即使出现如此高的降雨率,驾驶条件也会非常困难。

毫无疑问,雷达客观上更好地适应潮湿天气,但与激光雷达相比,由于空间分辨率低,雷达在行人检测和物体形状和尺寸信息分类方面的能力不足,经常受到批评。Akita等人[103]通过实现可处理时间序列数据的长短期存储器(LSTM),对此进行了改进。此外,牛津RobotCar数据集[104]的雷达扩展所使用的传感器之一是Navtech radar CTS350-X 360°FMCW扫描雷达[105],其测量范围可达100-200 m,可仅在黑夜、浓雾和大雪条件下处理同时定位和测绘(SLAM)[106]。因此,雷达的有用性具有更大的潜力。

图10. 降雨条件下的相机与激光雷达。[107]图片由Ouster股份有限公司Kim Xie女士提供。(https://ouster.com/)

3.3 对摄像机的影响

3.3.1 雨和雾

雨中的相机,无论分辨率如何高,都很容易因发射器或镜头上的一滴水滴而失效[107],如图10所示。图像中的阻塞和失真会立即使ADS失去输入数据的感觉,无法正确处理。至于雾,根据其密度,它会在一定程度上造成近乎均匀的阻塞,这直接剥夺了摄像机的信息。Reway等人[108]提出了一种环中相机方法,以评估不同天气条件下目标检测算法的性能。环境模型数据由一组摄像机获取,并由对象分类算法处理,然后将结果反馈给决策者,决策者重新参与模拟环境并完成闭环。夜间或雾天的漏检率高达40%,这一结果非常符合人们对相机的普遍期望,也证明了单靠相机是无法战胜天气的。

3.3.2 雪

冬天的天气,比如雪,会像下雨一样影响相机,当雪花碰到镜头或相机的光学窗口时,会立即融化成冰浆。更糟糕的是,这些冰水混合物在低温下可能会再次快速冻结,并在相机的视线上形成不透明的障碍物。

大雪或冰雹可能会使图像强度波动,并使图像或视频中特定对象的图案边缘模糊,从而导致检测失败[18]。除动态影响外,雪还可以扩展为静态天气现象。大多数时候,雪给交通带来的问题并不是即时的,因为雪会积聚在地表上,堵塞道路标记或车道线,甚至可能在道路上结冰[109]。这使得人类和自动驾驶汽车都处于不确定状态。特别是对于摄像头,数据源的获取受到了损害,整个自动驾驶的过程在一开始就中断了。

3.3.3 光照条件

一种特殊的天气现象,强烈的光线,直接来自太阳或人造光源,如摩天大楼的光污染,也可能给相机带来严重的麻烦。即使是激光雷达,在极端条件下也会受到强光的影响[2]。从图11可以看出,在直射强光下,普通可见光相机(左上角)几乎被遮挡,在室内测试期间,LiDAR点云(中下角)基本上只显示光源区域周围的黑色,但热摄像机(中上部)仍然是区分光源下方矩形板的能力的一部分,而普通摄像机无法做到这一点。过高的照明会使相机的可见度降低到几乎为零,各种光泽表面反射的眩光会使相机曝光选择变得困难[110]。HDR相机专门用于恶劣的光线条件。通过将这种技术应用于自动驾驶汽车,由于光线条件的突然变化(如隧道的入口和出口)导致的能见度下降得到了很大程度的缓解。得益于更好的色彩保护,在阳光直射下驾驶时的AV导航性能也可以提高[111]。

由光引起的另一个相关问题是反射表面的反射。如果反射恰好是理想的,那么它可能会让相机误以为这是真的,并发送虚假信号。缺乏立体意识是普通相机的致命弱点。人类驾驶员经常会遇到挡风玻璃反射的问题,在非常明亮的白天或夜间,驾驶室内有照明,这正是夜间巡航时不建议使用舱灯的原因。同样的问题也适用于安装在挡风板后面的摄像头。有时,由于路面温度高,反射是劣质的海市蜃楼,有时是汽车内部的镜像。这种虚假信息很难在2D意义上被识别出来,光线条件对相机永远不会100%友好。没有其他具有三维深度感的传感器的帮助,相机无法独自承担责任。从另一个角度来看,这里摄像头的无效性意味着ADS在天气条件下的冗余性在很大程度上受到了损害,因此我们需要做得更好,而不仅仅是克服不利天气,以确保总体安全。

图11. 传感器在强光下的性能。左上:可见RGB摄像机;中上部:带有铁弓调色板的热相机(热对象以较浅的暖色显示,而较冷的对象则以较暗的冷色显示[112]);中下部:LiDAR点云。[2]

当涉及到相机图像失真时,我们脑海中浮现出一个熟悉的场景,即图片被热浪般的火焰烧毁。至于这种失真是否会影响ADS,我们可以通过查看Ma等人[113]对环境温度和相机自热引起的数码相机图像失真的研究,推断出物体大小的估计变化。他们的实验表明,测量的和理论的热致图像失真之间的平均绝对误差为11.85μ。将相同的错误率应用于ADS相机测量距离稍远的约1.5m高度的物体时的场景,我们得出绝对尺寸变化不会超过0.2mm的水平,这几乎可以忽略不计,几乎不会影响ADS识别和分类此类物体的能力。基于此,正常环境温度升高导致的图像失真不应成为相机感知的问题。

3.4 其他问题

除了人们熟悉和可以预测的正常天气之外,总是有一些意外的天气或天气导致的现象会让我们措手不及,这也是AV需要做好的准备。就像飞石撞击汽车挡风玻璃一样,像激光雷达发射窗这样的ADS设备的外壳也可能受到飞行物体、强风吹起的石头或沙子、强对流天气下的大块冰雹以及一般碎片的直接撞击。玻璃上的裂缝可能会影响信号的正常数据接收或破坏原始图像,也可能会产生空气或湿气渗透的机会,这可能会阻碍电子设备,最坏的情况会导致小部分增长并最终破裂[114]。作为著名的不可预测现象之一,风会带来更多的麻烦。周围环境中未知物质的污染,如被吹动的树叶和垃圾,可能会突然阻挡ADS传感器的视线。附着在发射器窗口外表面的道路灰尘颗粒可能会恶化激光雷达信号衰减[115]。使用分布在扫描仪表面的近均匀灰尘颗粒进行的测试显示,LiDAR最大范围减少了75%[116]。尽管其中一些场景可以被视为罕见事件,但最好做好准备,因为ADS安全无法承受任何容忍。

超声波是在评估天气影响时几乎不考虑的传感器之一,但它确实显示出一些特殊的特征。声音在空气中传播的速度受空气压力、湿度和温度的影响[117]。由这引起的精度波动是自动驾驶所关注的问题,除非寻求能够根据产生额外成本的周围环境调整读数的算法的帮助。尽管如此,考虑到超声波的基本功能几乎不受恶劣天气的影响,为了在ADS模式中保持开放心态,超声波确实有其优势。超声波的回波信号不会因目标的深色或低反射率而降低,因此在低能见度环境中更为可靠,在低能见度的环境中,摄像机可能会遇到困难,例如高眩光或天桥下的阴影区域。此外,超声波的近距离特性可用于对路面状况进行分类。沥青、草地、砾石或土路可以通过其背面散射的超声波信号进行区分[118],因此不难想象道路上的雪、冰或泥浆可以被识别,并有助于AV天气分类。最重要的是,当LiDAR和摄像头等其他传感器在某些恶劣环境中受损时,超声波传感器提供了另一层冗余,至少可以在保持其原有功能的同时防止AV发生碰撞。

现在我们知道,天气条件直接影响环境状态,并削弱ADS传感器的感知能力;或者通过诸如风和路面的次要影响来影响车辆的状态。自我车辆或周围车辆状态的变化仍然会带来相应的影响。Walz等人[119]对附近切割车辆在白天和夜间条件下对摄像机和激光雷达造成的喷洒效果进行了基准测试。他们证明,喷雾会对Velodyne HDL64-S3D激光雷达造成“幽灵”目标,对不旋转的Velodyne VLP32C激光雷达造成严重堵塞,因为它没有离心力扔掉水滴或任何其他自清洁机制;还有尾灯周围的假阳性、错误的物体尺寸和相机外壳的缺失检测。Vargas Rivero[120]使用合成数据构建了一个虚拟场景,其中喷水区域中的障碍物在强度、回声数和遮挡方面具有与真实物体相同的检测特征。他们从对这一虚拟场景的检测中生成了增强数据,并获得了良好的LiDAR点云数据,用于在前车喷水条件下进行分类器训练。这种影响有时甚至超过了天气的直接影响,因为来自主要车辆的喷雾羽流通常是猛烈且不稳定的,就像[72]中的雪漩涡一样。

来自GPS、伽利略等卫星导航系统的信号在通过大气和其他水体中的水时会经历一些衰减和反射。正如Gernot[121]所分析的,水是一种介电介质和导体。电磁波将由于水分子根据引起能量耗散的电场旋转而经历衰减。此外,水体中的移动电荷会反射和折射波,这发生在空气-水和水-空气界面。

Balasubramaniam和Ruf[122]研究了雨和风对GNSS反射计(GNSS-R)的影响,他们的模型考虑了路径衰减、修改的表面粗糙度和下沉风。他们的研究发现,由于雨滴,L波段的衰减很小,对于低于30mm/hr的小雨,透射率约为96%。虽然L波段能够穿透大雨,但风的影响往往会增加衰减。

在Gernot的工作[121]中,GPS信号在穿过1mm的液态水层时损失超过9.4dB,但在穿过4cm的雪层时损失仅为0.9dB,在14cm的雪层中损失仅为1.7dB。这项实验表明,湿路和水坑形式的水体将进一步影响全球导航卫星系统的信噪比。

4. 传感器融合和机械解决方案

天气对自动驾驶造成的严重影响鼓励人们研究解决方案。在机器学习和人工智能训练技术的广泛传播和使用之前,在大多数制造商和汽车工厂眼中,更直接的解决方案是不受天气影响的传感器融合模式,以及有助于减轻天气影响的机械部件。表2显示了关于不同类型传感器融合和机械解决方案的文献和通讯报道。

4.1 传感器融合模式

图12. LiDAR+相机融合的点云。

到目前为止,几乎可以肯定的是,单凭传统的激光雷达或相机架构无法在恶劣的天气条件下航行,并没有足够的安全保障。但两种力量结合在一起将是一个不同的故事,具有额外的强度,正如图12所示的来自LiDAR + Camera融合的增强点云。因此,来自世界各地的团体通过添加雷达、红外相机、门控相机、立体相机、气象站和其他与天气相关的传感器,提出了自己的排列和组合,如图13所示。当然,融合模式需要校准,以确保所有参与传感器的同步,从而获得最佳性能。具有厘米级精度的一个优秀例子是Monrroy Cano等人开发的多传感器融合工具箱。[141]其框架包含LiDAR到LiDAR和 Camera-LiDAR外部算法,仅需一次校准即可简化多点云和相机的融合。该工具箱集成到称为Autoware的开源自动驾驶框架中[142]。

表2. 传感器融合和机械解决方案

图13. 名古屋大学用于ADS测试的丰田普锐斯。LiDAR传感器和其他传感器一起,用螺栓固定在一块固定在汽车顶部的板上。

4.1.1 雷达占主导地位

Yang等人[123]提出了一种形态称为RadarNet,它利用雷达和激光雷达传感器进行感知。他们的早期融合利用了几何信息,将激光雷达和雷达的体素表示沿着信道维度连接在一起,而基于注意力的后期融合被指定专门提取雷达的径向速度证据。他们在nuScenes数据集中验证了他们的模态[143]。尽管没有在不利天气条件下进行具体测试,但我们知道nuScenes数据集无约束地收集了波士顿和新加坡的降雨情况,因此证明了这种经典融合的鲁棒性,特别是在改进远距离目标检测和速度估计方面。

Liu等人[124]提出了一种在恶劣天气条件下结合雷达和相机信息的鲁棒目标识别和跟踪方法,雷达是主要硬件,相机是辅助设备。他们在雨雾中测试了他们的方案,包括能见度最差的夜间条件。结果表明,雷达在潮湿天气中检测运动目标时具有相当高的精度,而相机在分类目标方面更为出色,这种组合比激光雷达单独检测的精度高出三分之一以上。由于视野(FOV)有限,他们的雷达在跟踪垂直目标时也表现出良好的稳定性,而不是水平目标。雷达和相机一起接近激光雷达的跟踪能力,他们得出结论,这种混合物在恶劣天气条件下很有可能出现。

Fritsche等人[144]使用2D高带宽扫描仪,即机械旋转雷达(MPR)[145],与LiDAR数据融合,以在低能见度雾环境中实现SLAM。MPR只有15米的测量范围,但穿透雾的能力足以证明其在地标搜索中的作用,并弥补LiDAR缺失的部分。这种融合是在机器人而不是AV上测试的。

4.1.2 摄像机占主导地位

FLIR系统股份有限公司[125]和VSI实验室[146]于2020年测试了世界上第一套融合的自动紧急制动(AEB)传感器套件,配备了长波红外(LWIR)热像仪、雷达和可视摄像机。LWIR的波长范围从8µm到14µm,这种相机在被称为非制冷热相机的环境温度下工作。该传感器套件与几辆具有各种AEB功能的汽车一起进行了测试,这些汽车采用了雷达和可见摄像头,以防止白天、夜间和隧道出口进入阳光直射。对比表明,尽管大多数AEB系统在白天工作良好,但在这些不利条件下,正常的AEB几乎击中了每个人体模型,而LWIR传感器套件从未击倒任何一个。事实上,与MWIR(3µm-5µm)和SWIR(0.85µm-2µm)相比,当散射损耗非常高时,LWIR相机在浓雾条件下也表现出优异的性能[147]。

Vertens等人[148]绕过了麻烦的夜间图像注释和利用热图像。他们教网络调整现有的RGB数据集并将其与夜间域对齐,并完成了多模态语义分割。Spoolen等人[126]提出了一种多光谱有源门控成像系统,该系统集成了RGB和NIR相机,用于低光水平和恶劣天气条件。他们设计了定制滤波器,以实现标准RGB通道和额外NIR通道的并行采集。他们的融合图像是用RGB图像中的颜色和NIR中的细节生成的。John等人[127]还提出了一种可视和热摄像机深度传感器融合框架,该框架既执行语义精确预测,也执行最佳语义分割。这些可能是天气条件下最具成本效益的解决方案,但特定的门控CMOS成像系统仍在开发中[59]。

应该注意的是,尽管热摄像机的性能比常规摄像机更好,并且可以在冬季进行测试,但制造商提供的工作温度有一定的下限,如表1所示,这可能会严重限制此类传感器在寒冷冬季的实际使用,即使天气晴朗。这种温度敏感装置的耐久性需要在未来的实际环境中进一步验证,以确保其有用性。

4.1.3 综合融合

Kutila等人[128]提出了一种称为RobustSENSE项目的架构。他们将激光雷达与长距离(77GHz)和短距离(24GHz)雷达以及立体和热像仪集成,同时连接激光雷达探测层和性能评估层。这样,当LiDAR性能被评估为下降到临界水平时,由辅助传感器收集的数据可用于车辆控制层以供参考。他们在雾蒙蒙的机场用路边激光雷达测试了该架构,并收集了性能数据,同时将硬件组件成本保持在相当低的价格(<1000欧元)内。尽管与AV试驾的可比性并不理想,但硬件和软件互补的概念是AV天气适应的基础之一。Radecki等人[110]广泛总结了每种传感器在各种天气条件下的性能,包括潮湿条件、昼夜、多云、强光和灰尘。他们根据联合数据关联的概率制定了一个具有跟踪和分类能力的系统。他们的视觉检测算法是通过使用与实时联合概率感知的各种天气条件相对应的传感器子集来实现的。这种融合的本质是实时战略转变。传感器多样性提高了感知能力,但传感器权重的智能选择和基于特定天气的精确量化参数决定了此类模态的鲁棒性和可靠性的上限。

来自梅赛德斯-奔驰公司的Bijelic等人[129]在未知的不利天气中提出了一种大型深度多模态传感器融合。他们的测试车配备了以下设备:一对面向前方的立体RGB摄像头;近红外(NIR)门控相机,其闪光激光脉冲的可调节延迟捕获减少了不利天气中粒子的反向散射[130];77 GHz雷达,1°分辨率;两个Velodyne LiDAR,即HDL64 S3D和VLP32C;远红外(FIR)热像仪;能够感知温度、风速和风向、湿度、气压和露点的气象站;以及专用道路摩擦传感器,其用途未明确,可能用于分类用途。所有这些都是在惯性测量单元(IMU)的帮助下进行时间同步和自我运动校正的。他们声称他们的融合熵是可控的,这意味着低熵的捕获区域可以被衰减,而熵丰富的区域可以在特征提取中被放大。由外部感知传感器收集的所有数据被连接起来用于熵估计过程,并且训练仅通过使用晴朗的天气来完成,这表明了很强的适应性。仅在雾条件下,融合检测性能被证明比LiDAR或图像明显提高。这种模式的缺陷在于传感器的数量超过了ADS系统的正常预期。更多的传感器需要更多的电源和连接通道,这对车辆本身来说是一种负担,专有的天气传感器并不完全成本友好。即使这样的算法仍然是实时处理的,但考虑到来自多个传感器的大量数据,响应和反应时间也应该令人担忧。

4.2 机械解决方案

4.2.1 保护和清洁

机械地解决问题,就像拧紧螺丝一样,总是人类的第一本能。自动驾驶也是如此。天气给AV带来的所有问题无疑引起了主要汽车企业的注意,并已努力通过简单、低成本的机械解决方案来解决这些问题。例如,在斯堪的纳维亚半岛的雪域中长大的沃尔沃首先注意到,领头的汽车造成的雪漩涡挡住了传感器的视线,并使传感器冻结。在将传感器移动到汽车上的多个位置后,最终导致故障,沃尔沃最终决定将雷达和摄像头安置在挡风玻璃后面,使其永久远离积雪的困扰[131]。然而,考虑到在驾驶室内安装这些传感器并不符合当前市场的要求,这更多的是一种妥协,而不是一种真正的解决方案,在当前市场中,人类驾驶员仍然将座椅放在方向盘后面,一些传感器(如LWIR热摄像机)无法安装在车窗后面,因为它们的波长不会穿过玻璃。

在经历了挡风玻璃的重要性之后,我们自然会想到为ADS传感器安装与指定挡风玻璃相同的机制。Waymo和Uber是将ADS传感器(主要是LiDAR和摄像头)安装在外壳内并在其上安装一个小型雨刷器的支持者之一[132][133]。与挡风玻璃和雨刮器类似,现在传感器可以享受与机舱内几乎相同的好处。我们谈论的不仅是雨和霜,还有像鸟粪和昆虫飞溅物这样的污染,这些污染对人们的认知既常见又有害。此外,外壳至少可以保护脆弱的传感器免受来自飞石、冰雹或腐蚀性物质(如酸雨或融雪剂)的钝伤。唯一的问题是,挡风玻璃后面的传感器或AV上的外壳需要自动雨刮器来清除雨滴和污染物。当前现代汽车自动挡风玻璃雨刮系统中的光学或电子雨量传感器能够完成这一任务,但污染检测技术仍在发展中。

但当然,更多的机械部件意味着更多的移动部件和潜在的功能障碍或损坏风险。有些人可能更喜欢一种静态的机制,作为雨刮器的替代品,例如加热器。当在冬天或寒冷的雨中驾驶时,我们倾向于打开后窗和后视镜上的加热器,以消除雾气或霜冻,以保持清晰的视野[134]。因此,加热器当然也可以帮助保持传感器发射器或相机镜头的清洁。为了帮助实现这一任务,除了嵌入式耐热导线之外,还开发了最先进的技术。Canatu公司制造了碳纳米机器人,可以在不到6秒内产生10°C的温度,然后将其沉积在传感器和前照灯的塑料盖上[135]。这种机制不仅提供了无冰的传感器表面,而且几乎不消耗对电动汽车(EV)至关重要的任何能量。

在珠宝和眼镜等行业中有一种广泛使用的工艺,即超声波清洗[149]。该技术采用压电电子(PZT)产生35 kHz的超声波,并振动发射器表面,以将污垢转移到水或清洁液的薄膜中。然后液体从表面雾化,带走污垢。这一机制是一个巨大的武器库,可以防止昆虫飞溅、灰尘、道路碎片,最重要的是,雾凝结。

4.2.2 被动附件

除了主动机制,还有被动解决方案可以帮助缓解不利影响。疏水膜已经应用于汽车挡风玻璃几十年了,并被证明能够提高可视距离,将最小可视角度降低近34%[150]。研究还表明,这种改进大大有助于物体的检测和道路标志的读取,这对ADS至关重要[136]。因此,没有理由拒绝AV传感器盖上的疏水涂层,PPG股份有限公司(匹兹堡平板玻璃公司)已经在汽车玻璃上开发了相关的防水产品[137]。

除了所有先进的技术之外,有时机械解决方案可以像在仪表板上放一块布一样简单。一家名为KoPro的日本公司开发了极低反射涂料(称为Musou Black),该公司还生产一种由人造丝基织物制成的植绒板,在可见光和近红外(NIR)中的反射率低于0.5%[138]。只需将植绒板放在汽车的仪表板上,挡风玻璃上几乎看不到汽车内部的反光,晴天时驾驶室内的整体感觉也会明显增强,即使是人眼,如图14所示。仅需30美元左右的价格,这种相机感知的改善可能是目前机械解决方案中最好的性价比。

图14. 与右侧相比,仪表板左侧的KoPro Musou黑色视觉吸光植绒板减轻了汽车内部的反射,并提高了阳光下的能见度。

4.2.3 完整性和重新校准

尽管有所有额外的机械部件,但外壳不可避免的问题仍然是一样的:外壳作为外部世界和传感器之间的最后一层保护层,与挡风玻璃一样需要警报系统。由于一些传感器(如行车记录仪)仍安装在挡风玻璃后面,即使前排座椅上没有人,防护玻璃的结构完整性仍需确保。即使现在的挡风玻璃是用嵌有聚乙烯醇缩丁醛的防碎玻璃制成的[139],它仍然不是坚不可摧的。苹果汽车已经申请了一项专利,在早期阶段使用红外光检测挡风玻璃上的芯片和裂缝,以防止裂缝扩展和碎片[114],这可以看作是苹果为AV安全铺平道路的一部分。

机械部件结构完整性预警是硬币的一面,而另一面是重新校准。[151]表明,AV传感器受到寿命效应的严重影响,并导致退化。当前流行的ADS传感器设置是车顶架上的LiDAR;车身周围或挡风玻璃后面的摄像头;雷达和超声波部件隐藏在格栅或前/后保险杠内。而且,由于每个传感器都在一个公差很小的状态下工作,任何机械部件发生的任何冲击或状态变化都会很容易使传感器失去对准。外壳曲线或一般位置的轻微变化可能会导致相机失去焦点;激光雷达或雷达的支撑结构中肉眼不可见的变形可能会使其视野偏离指定间隔;甚至由于重量或轮胎压力变化导致的汽车重心高度变化也可能导致传感器的感知结果与以前不同。Bosch使用绿色激光拍摄可见直线,以帮助进行校准。美国三巨头(福特、通用、Stellantis[前FCA])都需要对其巡航和车道保持系统进行动态重新校准,其中包括运行设计领域(ODD)中的测试驾驶和速度要求。本田和奔驰的一些车型需要在典型维修的基础上进行静态和动态重新校准,这可能很容易花费一大笔钱[140]。这些点可能不完全属于天气范畴,但不利条件肯定会对传感器的寿命产生影响。因此,为了弥补AV重新校准成本的上升,AV的机械部件需要更高的耐久性和鲁棒性。

5. 不同天气条件下的感知增强

如前所述,天气现象导致的信号强度衰减和噪声干扰削弱了ADS传感器执行其原始任务的能力,并使自动驾驶的风险指数迅速攀升。尽管有机械保护和先进的导航技术的补偿,ADS的核心是物体探测,在对抗恶劣天气条件时最值得关注和努力。在本节中,将分别根据每种天气介绍关于增强感知的研究和工作。表3中列出了本文中涉及的针对各种天气类型的不利天气解决方案的文献索引。

5.1 雨水

雨是一种被认为是命中注定的东西,因为它是从天上掉下来的。知道下雨是无法避免的,它会对ADS传感器产生影响,所以很自然地希望AV能够意识到下雨的存在。在气象学中,雨是通过气象雷达和固定雨量计观测和测量的。考虑到在梅赛德斯集团这样的汽车上搭载气象站[129]不适用于商业推广,人们在早期阶段就开始实现基于车辆的二元(湿/干)降水观测,当时目的还不是自动驾驶[206][207]。尽管这些方法成功地实现了实时现场的降水感知,但数据是从模拟中提取的,仅通过天气雷达进行了验证,而没有通过真实数据进行验证。Karlsson等人使用概率方法估算了气象室内静态和动态条件下汽车激光雷达点云的实时降雨率[156]。Bartos等人[154]提出了一个想法,即在2019年使用挡风玻璃雨刮器测量联网车辆来生成高精度降雨地图。考虑到联网车辆网络尚未大规模建设,这是一个非常领先的概念。与雨量计等传统传感方法相比,挡风玻璃雨刮器的状态(开/关)可以作为二元降雨状态的完美指示器。这项工作被认为有助于城市洪水预警,并促进雨水基础设施的实时运行,但汽车的参与为基于车辆的雨水传感提供了思路。

从前面的上下文中,我们知道毛毛雨和小雨几乎不会影响像LiDAR这样的主要ADS传感器的性能,但当降雨率上升时,我们确实担心这一点。A.Filgueira等人[155]认为要量化降雨对激光雷达的影响。他们在路边放置了一个固定的激光雷达,并比较了距离检测变化、信号强度变化和检测点数量的变化,这些变化涉及几个检测区域,包括道路标志、建筑外墙和沥青路面。问题是,不仅他们的测试场景是固定的,而且沥青路面垂直于雨水,建筑立面平行于雨水,这一事实也影响了量化标准的公正性。尽管如此,他们的工作还是提出了通过直接量化降雨导致的激光雷达性能变化来量化降雨的想法。根据这一思路,当需要采取某些措施来应对影响时,可以设置降雨影响阈值[208],只要基准能够准确且包容。Goodin等人[153]以更具体的方式尝试了这项任务。他们只使用了两个参数:降雨率(由降雨散射系数表示)和LiDAR传感器在晴朗条件下90%反射目标的最大范围,成功地生成了降雨率和传感器性能之间的定量方程。他们的设计和验证是在容易控制降雨率的模拟环境下进行的。尽管还没有进行现场验证,但结合适当的降水传感模式,现在完全可以知道激光雷达性能何时根据降雨率下降到临界水平。这有助于通过设定可量化的基准来简化决策过程。

在新的激光雷达技术出现之前,除了1550nm波长之外,相机仍然是增强雨中感知的主要焦点,主要是在计算机视觉领域已经深入研究的除雨技术方面。雨滴的检测和去除可分为落下的雨滴和积聚在相机保护罩上的粘附雨滴[164]。为了去除雨纹,已经使用了几种训练和学习方法,包括基于准稀疏度的训练[159]和连续学习[160]。Quan等人[162]提出了一种级联网络架构,在展示自己的真实世界降雨数据集的同时,一次性去除雨带和雨滴。他们的雨滴去除和雨斑去除以互补的方式工作,结果通过基于注意力的融合模块进行融合。他们借助于神经架构搜索和他们指定的去雨搜索空间,有效地实现了对各种类型的雨的去雨。Ni等人[161]介绍了一种可以实现移除和渲染的网络。他们构建了一个降雨强度控制网络(RIC Net),该网络包含三个子网络:背景提取、高频降雨条纹消除和主控制。定向梯度直方图(HOG)和自相关损失被用于促进定向一致性并抑制重复的雨纹。他们对网络进行了一路训练,从细雨到倾盆大雨,使用真实数据进行验证显示了优势。

表3. 针对不同类型不利天气的解决方案汇总

与常见的去噪方法一样,生成和去除的闭环可以提供更好的性能。H.Wang等人[163]通过首先构建降雨图像的完整贝叶斯生成模型来处理单图像雨水去除(SIRR)任务。物理结构由方向、尺度和厚度等参数构成。好的部分是生成器可以自动生成不同的非重复训练对,从而确保效率。Ye等人[158]提出了类似的降雨生成,使用解纠缠的图像平移来闭合循环。此外,Z.Yue等人[157]超越了图像帧,并使用动态雨生成器实现了半监督视频去雨。动态发生器由发射和过渡模型组成,以同时构建雨带的空间和动态参数,如上述三个。他们使用深度神经网络(DNN)进行半监督学习,以帮助真实案例的泛化。

虽然已经使用各种训练和学习方法对去雨进行了广泛的研究,但大多数算法都遇到了对附着雨滴的挑战,并且在雨率或场景动态变高时表现不佳。在假定的光学条件得到满足的情况下,粘附雨滴的检测似乎很容易实现,但无论性能如何,实时去除粘附雨滴都不可避免地带来了处理延迟的权衡。峰值信噪比(PSNR)和结构相似性(SSIM)度量虽然得到了广泛实施和微弱改进,但与深度学习和卷积神经网络(CNN)相比,在雨滴检测和去除方面似乎并不完全有希望[164]。

5.2 雾

雾在不利天气条件下的感知增强中起着重要作用,主要原因有两个。首先,雾室测试环境的快速和先进发展,其次,各种天气的雾格式共性,包括潮湿天气、雾霾和灰尘,换句话说,能见度以相对均匀的方式降低。2014年初,Pfennigbauer[165]提出了雾和浓烟条件下测距的在线波形处理的想法。与飞行时间(TOF)激光雷达的传统机制不同,他们的RIEGL VZ-1000激光器通过反射特性(反射率和方向性)、尺寸、形状和相对于激光束的方向的特征来识别目标,这意味着,该回波数字化激光雷达系统能够记录目标的波形,这使得能够通过识别其波形来识别被检测目标的性质,即雾和浓烟。此外,由于雾引起的振幅衰减率遵循雾密度的特定数学模式,他们实现了能见度范围分类,因此能够过滤掉不属于该范围的虚假目标。尽管他们的实验被限制在非常近的距离(30米)内,但只要信号功率保持在指定的楼层以上,无论衰减和散射效应如何,他们都为恢复隐藏在雾和烟雾中的目标铺平了道路,因为能见度太低,比如低于10米,几乎完全阻挡了探测。最重要的是,波形识别的概念将多回波技术引入了商用激光雷达市场。

SICK AG公司开发了HDDM+(高清距离测量加)技术[169],该技术以极高的重复率接收多个回波。雾、雨、灰尘、雪、树叶和围栏波形的独特性都可以通过MRS1000 3D激光雷达识别[209],并且物体检测和测量的准确性得到了很大保证。它们还能够设置感兴趣区域(ROI),其边界基于最大和最小信号电平以及最大和最小检测距离来建立。这种技术为大雨和其他极低能见度条件下的结块雾问题提供了一个非常有前途的解决方案。Wallace等人[167]探索了在雾状条件下实施全波形激光雷达(FWL)的可能性。该系统记录返回光能的分布,因此与离散返回LiDAR系统相比,可以捕获更多信息。他们在距离41米的雾室内使用FWL评估了3D深度图像的性能。这种类型的激光雷达可分为单光子激光雷达和1550nm波长,Tobin等人[170]也使用它来重建移动物体通过雾状高水平遮蔽物的深度轮廓,距离可达150m。单光子激光雷达提供的高灵敏度和高分辨率深度剖面,使其在远程、复杂和高散射场景中具有吸引力。但这再次让我们回到了1550nm波长和OPA制造困难的老问题[30]。无论如何,波形识别和多回波处理的思想是目前激光雷达感知增强的主要指导,如果半导体技术能够跟上市场需求的步伐,它应该能够表现出更多的潜力。

Lin等人[172]尝试了雾中的纯LiDAR去噪,他们在点云上实现了最近邻分割算法和卡尔曼滤波器。然而,在2m范围内的改善率低于20%被认为是可以通过的。毫无疑问,激光雷达和雷达的组合也能应对大雾天气。Qian等人[168]介绍了一种多模式车辆检测网络(MVDNet),该网络具有激光雷达和雷达。它首先从两个传感器中提取特征并生成建议,然后多模态融合处理区域特征以改进检测。他们基于牛津雷达Robotcar[104]创建了自己的训练数据集,评估结果显示,在雾天条件下,比LiDAR的性能要好得多。Mai等人[171]将雾应用于公共KITTI数据集,为图像和点云创建多雾KITTI数据库。他们使用基于激光雷达和相机的备用激光雷达立体融合网络(SLS Fusion)进行了评估。通过使用清晰和模糊的数据训练他们的网络,性能在原来的基础上提高了四分之一,几乎降低了一半。事实上,无论使用哪种辅助传感器,融合感知增强的核心是最好地利用每个传感器的数据,提取有用的特征,并获得1+1>2的最佳结果。

Shamsudin等人[166]提出了检测后从3D点云中消除雾的算法。使用强度和几何分布来分离集群,并将其作为目标并移除。限制是,他们的环境是一个室内实验室,算法是为建造搜救机器人而设计的,这些机器人的工作条件能见度太低,无法适应远场存在光束发散和反射的室外驾驶场景。但它再次提醒人们去噪方法,即雾状条件下的去模糊技术。

由于图像采集传感器对外部环境的敏感性,尤其是在雾霾天气下,室外图像将经历严重退化,如模糊、低对比度和颜色失真[210]。它无助于特征提取,并对后续分析产生负面影响。因此,图像去模糊已引起广泛关注。

图15:基于大气散射模型的去雾方法图解。图像是雾城景观的一部分[212]。

图像去模糊的目的是消除不利天气的不良影响,增强图像的对比度和饱和度,并恢复有用的特征。总之,从模糊的输入中估计干净的图像。目前,现有方法可分为两类。一种是基于图像处理的非模型增强方法(直方图均衡[177]、负相关[178]、同态滤波器[179]、Retinex[180]等),另一种是根据大气散射模型的图像恢复方法(对比度恢复[181]、人类交互[182]、在线地理模型、偏振滤波[183])。前者虽然可以提高对比度,突出纹理细节,但没有考虑到雾霾图像的内在机制。因此,场景深度信息没有得到有效利用,并且会导致严重的颜色失真。后者根据大气散射的物理模型从输入中推断出相应的无霾图像。基于此,霾模型可以描述为

其中I(x)是观察到的模糊图像,J(x)为要恢复的场景辐射亮度。A和t(x)分别是全球大气光和透射图。考虑输入I是RGB彩色图像,在每个位置,只有三个强度值已知,而J、t和A仍然未知。通常,该模型本身是一个不适定[211]问题,这意味着其解决方案涉及许多未知参数(如场景深度、大气光等)。因此,许多去模糊方法将首先尝试在某些物理约束下计算这些未知参数中的一个或两个,然后将其组合到一个恢复模型中,以获得无雾图像,如图15所示。

直到几年前,基于物理先验的单图像去模糊算法仍然是焦点。它通常首先预先定义模型参数的一些约束、先验或假设,然后在大气散射模型的框架下恢复干净的图像,例如对比先验[184]、空中飞行假设[185]。然而,推断这些物理先验需要专业知识,并且在应用于不同场景时并不总是可用的。随着深度学习理论的发展,越来越多的研究人员将这种数据驱动方法引入该领域。

Chen等人[174]发现,由于合成数据和真实数据之间的领域差距,基于合成图像训练的去模糊模型通常难以推广到真实世界的模糊图像。他们提出了一个原则性的综合到真实去模糊化(PSD)框架,包括两个步骤。首先,用合成数据对选定的去模糊模型主干进行预训练。然后,使用真实的模糊图像以无监督的方式微调主干。无监督训练的损失函数基于暗通道先验、亮通道先验和对比度受限自适应直方图均衡。

考虑到现有的基于深度学习的去模糊方法没有充分利用负面信息的问题,Wu等人[176]提出了一种新的ACER网络,该网络可以通过对比正则化(CR)和高度紧凑的基于自动编码器的去模糊网络有效地生成高质量无雾图像。它定义了模糊图像,其对应的恢复图像由去模糊网络生成,其清晰图像分别为负、锚和正。CR确保恢复的图像被拉得更接近清晰图像,并被推离表示空间中的模糊图像。Zhang等人[175]使用来自邻域模糊帧的时间冗余来执行视频去模糊。作者收集了一个真实世界的视频去模糊数据集,其中包含真实模糊和相应的无模糊视频对。此外,他们提出了一种置信引导和改进的可变形网络(CG-IDN),其中,置信引导的预去散列模块和成本体积可以通过提高估计偏移的精度而使可变形对准模块受益。

现有的深度去模糊模型具有如此高的计算复杂性,使得它们不适合超高清(UHD)图像。因此,Zheng等人[173]提出了一种用于4K分辨率图像去模糊的多引导双边学习框架。该框架由三个深度CNN组成,一个用于以降低的分辨率提取雾霾相关特征,一个用来学习与学习的双边模型相对应的多个全分辨率引导图,最后一个将高质量特征图融合到去雾霾图像中。

尽管该领域已经接近成熟,但主流方法仍然使用合成数据来训练模型。因为收集成对的模糊和无雾真值图像需要捕获具有相同场景亮度的两幅图像,这在真实道路场景中几乎是不可能的。不可避免地,现有的去模糊质量度量仅限于非参考图像质量度量(NRIQA)[213]。最近的工作开始使用专业的雾霾/雾生成器来收集雾霾数据集,该生成器模仿雾霾场景的真实条件[214],或多天气叠加架构[215],通过添加、交换和组合组件来生成具有不同天气条件的图像。希望这一新趋势能够带来更有效的指标,并推动现有算法在ADS上的部署。

图16:采用不同去噪方法的降雪条件下的激光雷达点云。左:原始点云;中间:普通ROR滤波器;右:DROR过滤器。[189]图片由滑铁卢大学Nicholas Charron博士提供。

5.3 雪

雪中的感知分为两个分支。一种是降雪导致的信号或图像清晰度下降,就像雨点一样,只是以较慢的速度降落,但体积较大;另一个是由于积雪导致的寻路,这在早期就已经引起了自主机器人的注意。Yinka等人[186]在2014年提出了一种可驾驶路径检测系统,旨在提取和去除视觉输入中的雨或雪。他们通过其不同的RGB元素值来区分可行驶和不可行驶的路径,因为雪的白色与道路表面相比是明显的,然后基于对雨天或雪天拍摄的图像的强度值像素进行建模来应用滤波算法,以实现去除。他们的输出是单色的,基于100帧道路图片的评估显示接近100%的寻路能力。尽管场景很简单,路边只积了一些雪,但这为ADS在雪况下处理同样的问题奠定了良好的基础。

Vachmanus等人[188]通过在模态中添加热摄像机,将这一想法扩展到自动驾驶语义分割任务中。RGB摄像机的输入可能不足以代表周围环境中各种颜色的每个相关物体,或雪地驾驶场景中涉及的行人,这恰好是热摄像机的强项。他们的架构包含两个编码器分支,一个用于RGB摄像机,另一个用于热摄像机,每个用于从自己的输入中提取特征。热图中的温度特征完美地支持了由于雪造成的图像元素损失,并且融合模型成功地改进了雪分割,这不仅仅是基于RGB相机,而是基于对包括Synthia和Cityscapes在内的多个数据集的验证。该网络非常适合在有人行道的道路上使用自动扫雪机,这超出了传统的自动驾驶目的,可能比AV更早地实现真正的商业用途。

此外,Rawashdeh等人[187]在其CNN传感器融合中包括摄像机、激光雷达和雷达,用于可驱动路径检测。这种多流编码器解码器几乎在最大程度上补充了传感器输入的不对称退化。架构中每个传感器的深度和块数由其输入数据密度决定,其中相机最多,激光雷达次之,雷达最后,完全连接的网络的输出被重塑为二维阵列,将被馈送到解码器。他们的模型可以成功地忽略道路上出现的线条和边缘,这可能会导致错误的解释,并描绘出一般的可行驶区域。这样的融合模式当然可以做的不仅仅是应对雪况,但其他低能见度场景和人们正朝着网络中更多的信道努力,因为激光雷达和雷达可以提供更多类型的信息,如反射光束数量和速度。

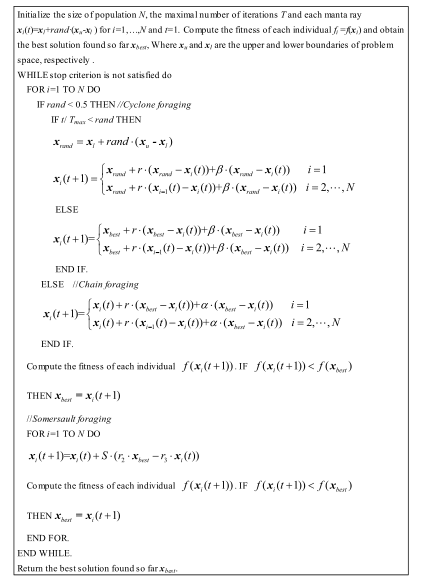

对于降雪,应对方法再次回到去噪技术,即使是对于激光雷达点云。Charron等人[189]在提出自己的动态半径异常值去除(DROR)滤波器之前,广泛解释了2D中值滤波器和传统半径异常值消除(ROR)的不足。由于降雪是一个动态过程,只有来自指向地面的激光的数据才适合2D中值滤波器,而从一开始就不需要。在地面以上的垂直视野中,数据非常稀疏,2D滤波器不能很好地处理噪声点去除和边缘平滑特性。因此,需要3D点云ROR过滤器。该过滤器遍历点云中的每个点,并检查特定附近(搜索半径)内的连续点,如果发现的点的数量小于指定的最小值,则该点将被视为噪声并被移除,这符合雪花是小的单个固体物体的降雪模式。问题是,直接在三维意义上实施该滤波器会导致不希望的环境中的点的移除,并损害LiDAR在预识别方面的感知能力,如图16中所示。为了防止这个问题,Charron的团队通过根据每个点的原始几何属性设置每个点的搜索半径来动态应用过滤器,并成功地保留了远离中心的点云中的基本点,同时去除了点云中的盐和胡椒,精度提高了近4倍于常规ROR过滤器,如图16右图所示。

另一方面,Park等人[192]提出了一种基于雪粒子和真实物体之间的强度差异的低强度离群值去除(LIOR)滤波器。它也可以像DROR滤波器一样保留重要的环境特征,但在某种程度上,它比DROR在点云中保留了更多的点,因为LIOR的阈值基于受试者的光学特性更具针对性。在正确的情况下,这可能是准确性方面的优势。

相机的除雪技术与除雾的方式类似。Zhang等人[191]提出了用于除雪的深度密集多尺度网络(DDMSNet)。雪首先由具有三个模块的粗去除网络处理,即预处理模块、核心模块和后处理模块,每个模块包含密集块和卷积层的不同组合。输出是一个粗略的结果,其中降雪的负面影响被初步消除,并被馈送到另一个网络以获取语义和几何标签。DDMSNet通过自我关注从语义和几何先验中学习,并生成无雪的干净图像。有趣的是,他们使用Photoshop从Cityscapes和KITTI数据集中创建大型雪景图像来进行评估。尽管这确实完全能够执行最先进的除雪,但仍有必要引入模拟照片逼真的雪图像的先进方法。

Von Bernuth等人[190]通过三个步骤生成雪:首先,使用OpenGL中的深度信息重建3D真实世界场景;然后根据物理和气象原理将雪花分布到场景中,包括来自风、重力或车辆位移速度的运动模糊;最后,OpenGL在真实的图像中渲染雪花。深度信息对于重建场景至关重要,因此图像要么是从立体摄像机或真实世界中的其他传感器(如上述两个数据集)收集的,要么是从Vires VTD或CARLA等模拟器收集的,其深度信息是完全可量化的。雪花有两种形式:一种是二维的扁平晶体,另一种是三维的由三个成对的垂直四边形构成的厚厚的聚集雪花,这确保了合成雪看起来尽可能接近现实。这些雪生成方法的比较显示出与真实世界雪图像惊人的相似性。毫无疑问,使用合成雪和雾图像进行去噪可以帮助机器学习过程,并在很大程度上有利于在恶劣天气条件下增强相机感知。

5.4 光相关

尽管强光和眩光对AV有严重影响,但专门针对光相关问题的解决方案的文献非常有限。早在2014年,Maddern等人研究了一天24小时内光线条件变化对AV的影响,并通过实施照明不变变换,设法提高了基于视觉的自动驾驶的性能和鲁棒性,该变换消除了原始RGB图像中存在的几乎所有因阳光强度、方向、光谱和阴影造成的变化[201]。通常的想法是依靠某些融合模式的冗余性和鲁棒性,这些融合模式配备了对强光不敏感的传感器,这就留下了眩光检测,或者说是强光感知。

Yahiaoui等人[193]开发了他们自己的自动驾驶阳光眩光数据集,称为Woodscape,包括天空中的阳光直射或干燥道路上的阳光眩光、潮湿道路上的道路标记被阳光眩光擦掉、反光表面上的阳光眩光等情况,自适应阈值、几何滤波器和斑点检测,并使用CNN网络进行训练。眩光和强光可能不容易去除,但类似条件下的反射在吸收效应[194]、无反射闪光提示[196]和计算机视觉领域的曝光校正[198]技术的帮助下相对可去除。该原理遵循反射对准和透射恢复,它可以很好地消除图像的模糊性,特别是在ADS中常用的全景图像中[197]。它仅限于可识别的反射,在无法获得图像内容知识的极强光线下会失效。同样的原理也适用于阴影条件,在阴影条件下,原始图像元素完好无损,某些区域的亮度稍低[195]。这种图像处理使用与前面段落中类似的计算机视觉技术,也可以采取先生成阴影然后移除阴影的方法[202]。Retinex算法也可用于低光条件下的图像增强[203]。

图17. 凯迪拉克XT5倒车摄像头的污染影响。泥浆污染是在雨后越野行驶时自然形成的。由泛亚汽车技术中心有限公司(Pan Asia Technical Automotive Center Co.,Ltd.)(http://www.patac.com.cn/EN/about.html)王大伟先生提供的车辆测试和图像。

5.5 污染

正如我们在表1中总结的那样,污染以一种强烈的方式影响ADS传感器的感知,比如侵入传感器的视线。例如,图17显示了对备用摄像头的污染影响。因此,系统的鲁棒性和适应性面临着严峻的考验。Valeo的U‘ri‘c‘a’r等人[204]创建了一个名为SoilingNet的数据集,该数据集具有不透明和透明污染[205],并开发了一种基于GAN的数据增强技术,用于自动驾驶中的相机镜头污染检测。与雨或雪不同,一般污垢通常被认为是不透明或半透明的,因此互补的传感方法可能无法以足够的精度执行。同样,法雷奥集团从人工污染图像生成开始,因为在实际驾驶条件下无法获得污染图像和相同的清洁图像。CycleGAN网络将生成具有随机污损图案的图像,该图像提供从语义分割网络获得的模糊掩模,该语义分割网络对生成的污损图像应用高斯平滑滤波器,最后,污损图像的合成版本由原始图像和通过掩模估计的污损图案组成。相似程度非常接近图17(c)所示的真实污损效果。唯一的问题是CycleGAN对污损图像的设计区域没有限制,而是对整个图像进行变换,因此他们仅对遮罩区域施加限制,并将网络修改为新的污损GAN。此外,他们使用这个DirtyGAN根据上一段提到的先前数据集Woodscape生成了一个Dirty数据集,并且基于Cityscape数据集的退化评估得到了很好的证明。尽管在这项工作中没有讨论脏图像的去除或解释,但它确实提供了与去模糊和去噪相同的训练方法的可能性。至少可以说,一旦ADS能够检测到污染,现在就可以使用诸如刮水器或喷雾器之类的机械设备了。

Trierweiler等人[115]基于相同的思路对雨刮器和喷嘴进行了自动控制,只有它们的检测是基于挡风玻璃上的全内反射。由于液体(如雨滴)和固体(如灰尘)之间反射率和强度分布的差异,他们能够通过将红光漫射器的外耦合强度分为两部分来区分ADS传感器盖玻璃上污染的物理状态。与目前只能触发雨刮器的雨量传感器相比,该型号知道是否需要触发喷嘴来清除污染。一个担忧是,汽车的挡风玻璃可能不会在任何地方都保持均匀的曲率,因此安装这种检测装置的实用性及其操作一致性仍然受到挑战。尽管目前还不清楚激光雷达或照相机是否能够解释由自身污染引起的受影响数据,但一种常规的普通解决方案总比没有好。

SICK传感器公司的microScan 3安全激光扫描仪在这方面有发言权,因为它可以抵抗严重污染[216]。该近距离安全监视器使用845 nm激光扫描275°角,使用前面提到的HDDM+技术,可以在室外天气条件下正常工作[169]。该传感器的亮点在于,即使木屑等污染物附着在传感器发射器盖窗口上,它仍然可以检测到附近物体的存在,而不会发出错误警报,这得益于难以置信的宽扫描角度和以0.1°角分辨率发射多个脉冲的能力。当污染在极端恶劣的条件下征服了几乎所有传感器时,这种传感器具有充当AV和障碍物之间的最终屏障的潜力。

6. 分类和评估

在ADS如何工作的过程中,在传感器收集完信息之后,“大脑”就该对驾驶状况及其当前风险水平做出判断了。表4列出了分类方法的总结,包括天气分类、能见度分类和风险评估。

6.1 天气分类

感知增强从根本上使ADS能够在各种恶劣天气条件下导航,但它主要关注如何忽略天气的存在或补偿负面影响。天气分类从相反的角度起作用,但并非无法使用。同样重要的是,要了解当前的天气状况,因为它能够看穿天气,只有具备适当的天气分类能力,ADS才能以高度的信心和准确性做出有针对性的决策。在这里,我们重点关注单个AVs的局部范围天气分类,因为宏观天气分类与天气雷达一样,不具有反映应用于一辆汽车的实际天气影响的密度和分辨率。

起初,天气分类只涉及几个级别的天气分类,如在单个图像上区分清晰与否[217]。进一步的机器学习技术,如内核学习,实现了晴、雨、雾和静雪等多类天气分类。在此阶段,通过设置具有每种天气的独特特征的分类器来实现分类任务。阳光特征来自图片的晴空区域,并形成高度多维的特征向量;当天空元素不包含在图片中时,一个具有自信边界的强阴影区域将成为阳光条件的指标。降雨条纹很难在图像中捕获,因此从图像中提取HOG特征作为降雨特征向量。落雪被认为是噪声,具有特定灰度级的像素被定义为雪花。雾度由暗通道确定,其中一些像素在至少一个颜色通道(即暗通道)中具有非常低的强度[218]。随着人工智能技术的发展,Elhosiny等人[219]在这项任务中使用了机器学习神经网络,如深度CNN,以增强特征提取和学习性能。Al Haija等人[220]提出了一个强大的ResNet-18 CNN网络,包括基于ImageNet数据集上多类天气识别的预训练进行多类天气分类的转移学习技术。然而,该网络中设置的类别仍然限于日出、晴、雨和多云,其对ADS的影响不明显或不具有代表性。Dhananjaya等人[221]在他们自己的天气和光照水平(明亮、中等和低)数据集上测试了ResNet-18网络,获得了相当低的精度,这意味着传统的图像天气分类仍然不饱和。为了为自动驾驶目的的天气分类服务,需要精细分类和精确分类,仅可能超出摄像机图像。

Heinzler等人[222]仅使用多回波激光雷达传感器就实现了相当好的天气分类。首先将点云转换为网格矩阵,通过物体上的二次回波可以很容易地注意到雨或雾的存在。然后,不同于记录每种情况下的回波,每个回波的平均距离及其数学性质(如方差)用于详细分类,因为协方差矩阵受到不同程度的雨或雾以及点云中的变化的影响,或者说矩阵是可见的。采用最近邻分类器(kNN)和支持向量机(SVM)作为分类器,大大改进了雨水分类。可以想象,与静态场景相比,当使用具有较小垂直FOV的LiDAR传感器时,由于点的数量不足,并且在动态场景中,测试结果可能不太好。这意味着该方法仍然依赖于受控环境,鲁棒性可能无法满足4级或更高的自治性要求。

Dannheim等人[223]几年前确实提出使用激光雷达和相机的融合数据进行天气分类。他们的主要分类器基于雨和雾的反向散射效应产生的强度差,在图像处理中没有提到神经网络,这在今天看来似乎并不有效。因此,将上述先进的图像检测和LiDAR数据处理结合起来,以实现天气分类,并确保在不利条件下的准确性和鲁棒性可能是一个好主意。如果目前市场上仍有3级自主性,那么一个人机界面向车辆操作员提示基本天气分类结果的确认可能是目前最可靠的方式,就像导航系统要求批准路线更改一样。由于我们的工作方向是减少人为干预,因此天气分类模块对于成熟的ADS来说是必要的。

装备在V2X或V2I设施上的传感器进行的天气分类工作方式相同,但需要额外的数据传输步骤。第9.3节将讨论V2X的细节。

6.2 能见度分类

在不利条件下还有另一个分类角度:能见度。这个定义最初是作为人类观察者的主观估计而发明的。为了测量气象量,或者说大气的透明度,客观地定义了气象光学范围(MOR)[224]。在自动驾驶的背景下,当能见度被量化为特定数字时,它通常意味着MOR。例如,Foggy Cityscapes[212]数据集中雾场景的每个不同版本都由恒定MOR表征。由于天气条件通常会导致不同级别的能见度下降,因此有助于提高ADS的能见度下降意识,以避免提前检测错误和碰撞。传统的能见度分类通常在机场等设施中进行,由人工估算和商业仪器负责[225]。人工观测雾等天气的存在和能见度范围被认为是最准确和可靠的。光学能见度计(如透射计和散射计)也通常用于在相当长的范围内进行精确的能见度测量。然而,这两种方法不适合应用于自动驾驶领域,因此像LiDAR和摄像头这样的传感器必须取而代之。通过分析微小液滴引起的激光雷达信号后向散射效应,可以估计雾状条件下的能见度范围,但如前所述,它需要极其精细的激光雷达功率来适应多变的变量,因此其实际应用受到限制。目前,能见度分类主要依赖于基于摄像机的神经网络方法[226],并按照几十米的距离分类,而不是精确值。考虑到ADS中摄像机的低成本和不可替代的地位,它也得到了很好的研究。

Chaabani等人[226]最初使用只有三层的神经网络:作为输入的特征向量图像描述符,作为隐藏层的一组完全互连的计算节点,以及作为输出的与可见性范围类相对应的向量。他们使用FROSI(Foggy ROad Sign Images)合成数据集[227][228]进行评估,并能够以50m的间距将能见度从低于60m到大于250m进行分类。后来,他们将深度学习CNN用于特征提取和SVM分类器[229]相结合,改进了这种网络。新网络使用AlexNet架构[230],该架构由五个卷积层、三个maxpool层和三个完全连接的层组成。整体召回率、精度和准确性均达到了最先进水平,不仅可用于车载摄像头,还可用于路边摄像头,这在未来物联网系统中显示出进一步的潜力。

Duddu等人[231]提出了一种基于混合神经网络的自动驾驶应用雾能见度范围估计算法。他们的输入包括香农熵[232]和基于图像的特征。由50度FOV摄像机拍摄的每个图像被分成32乘32像素块,计算每个块的香农熵,然后将其映射到从一系列卷积层以及maxpool层中提取的相应图像特征,这些卷积层输出三个可见性等级:0-50米、50-150米和150米以上。他们使用BOSCH测距仪设备创建了自己的雾数据集作为真值,以建立网络架构,FORSI合成数据集用于公共基准测试。85%或更高的总体精度使ADS能够设置危险的低能见度阈值。还有其他类似的模型,如前馈-反向传播神经网络(BPNN)[233],其使用从气象监测站收集的数据作为输入,可以在道路连接层面以更小的间距预测能见度范围。目前尚不清楚汽车上配备的移动气象站是否能够实时完成能见度分类,但在雪和雨等雾以外的情况下,复杂的传感器融合可能是必要的。考虑到可以向人类驾驶员提供警告信息的可见性分类模块在当前ADAS中是有用的,因此该技术可能比完全自主更早地实现。

事实上,在气候学中,天气和能见度之间存在相关性,几十年前就已经进行了关于驾驶员所能看到的距离与降水率之间的对应关系的研究[99]。如果有详细的对应关系,那么我们可能只需要检测雨或雪的速度,而不是通过计算机视觉技术对能见度进行分类。然而,这种类型的一对一对应图在相当长的范围内工作,因为大多数降水不会使道路能见度降至1公里以下,远离当前AV的视觉问题。能见度危机主要来源于下雨时的水幕和薄雾,有时不仅仅取决于降雨率。似乎只有能见度通常低于几百米的浓雾、污染烟雾或沙尘暴才有意义以这种直接的方式来考虑。Sallis等人[234]考虑使用车载激光雷达的后向散射效应来检测空气污染和雾强度,但当时没有考虑能见度。Miclea等人[235]想出了一种创造性的方法,建立了一个3米长的模型室,里面有一条“玩具”路和模型车,可以很容易地充满几乎均匀的雾。他们成功地确定了在缩放雾条件下,光学功率的降低和视力的降低之间的相关性。此外,Yang等人[236]通过确定具有已知距离的物体的检测范围是真实的还是有噪声的,成功地提供了903nm NIR激光雷达在雾室内的最小能见度的预测。尽管这些方法仍然是间接的,但也许通过未来的物联网或V2X技术,可以实现实时可见性分类。

6.3 风险评估

当谈到驾驶时,能见度只是一种直接的感知。真正决定我们驾驶方式的是我们大脑根据感知输入评估的风险水平,包括速度控制和路线改变。对于人类驾驶和AV都有一个重要的定义,即停车视距(SSD)。根据美国国家公路与运输官员协会(AASHTO),SSD是反应距离(假设人类反应时间为2.5秒)和制动距离(减速率3.4 m/s2)的总和[237]。作为参考,在60 km/h的速度下,设计的SSD通常为85 m。考虑到机器的反应速度应该比人类快,文献[238]中假设AV的反应时间为0.5秒(约至少15个摄像机帧,或5个激光雷达帧,或20个雷达帧),这意味着AV的SSD更短,安全性挑战更大。Mobileye的Shalev Shwartz等人[239]提出了AV安全的责任敏感安全(RSS)模型。最重要的一条规则是“不要撞到前面的车”,并带有纵向距离控制。

上述所有规则代表在正常或理想驾驶条件下基于定量能见度估计的风险评估。当恶劣天气来袭时,两种可能的情况可能会对这些基本安全规则构成威胁:(1)受损的传感器(如脏相机)失去部分能见度或对某些环境的直接视线;(2)严重的天气条件(如水雾或浓雾)将能见度降低到低于设计SSD的临界水平。这种情况在很大程度上增加了输入变量的不确定性,并破坏了预设的安全标准和阈值。类似于复杂的道路场景,当行人或骑自行车的人很难被AV检测或预测时,在可疑位置有足够密集的信息(如LiDAR点云),以便根据能见度提前调查风险水平是有意义的[240]。很少有文献专门针对自动驾驶领域的风险评估,但风险评估或可靠性分析模块应包含在与能见度相关的所有决策和控制过程中,以确保在任何可能和不可预测的情况下,AV的最大安全性。

7. 定位和建图

对自我车辆自身位置的了解与了解周围环境中其他元素的位置一样重要。目前最常用的定位方法是全球定位系统和惯性测量单元(GPS-IMU)、SLAM和最先进的基于先验地图的定位。通常情况下,精度更高的一种会带来更高的成本,但我们将重点关注它们在天气条件下的鲁棒性。表4显示了不利天气条件下的定位方法汇总。

仅使用GPS或INS(内部导航系统)实现高精度定位可能是一项挑战,因为尽管有车轮里程计的辅助,但在大多数道路上,GPS或INS通常具有超过1米的双重标准偏差[263],更不用说恶劣和湿滑的道路条件了。尽管如此,Onyekpe等人[254]利用深度学习,提出了车轮里程表神经网络(WhONet)来评估车轮位移测量中的不确定性,并找到补偿因子。考文垂大学自动汽车公共道路数据集(CUPAC)中针对潮湿和泥泞道路的测试表明,在缺少GNSS的环境中,与物理模型相比,定位误差降低了90%以上。该网络并非专门针对天气情况,而是主要针对轮胎的变化,因此在天气引发的道路条件下的实际性能有待验证。

7.1 同时定位和建图

同时,在线地图制作和定位方法广泛应用于机器人和室内环境,因此它不会经常在室外遇到潮湿天气的挑战。然而,不同季节特征描述符的变化在一定程度上影响了SLAM的准确性。除了季节变化之外,天气造成的影响,包括树叶掉落和生长以及地面积雪也是原因之一。为了解决SLAM的鲁棒性问题,Milford等人[241]提出识别相干导航序列,而不是匹配单个图像,并将SeqSLAM作为SLAM在光照、天气和季节变化条件下的早期改进之一。SeqSLAM有一个弱点,即在不同的运行中假设良好的对齐,这可能会导致在无重叠图像或不同帧速率下的性能不佳。Naseer等人[242]更进一步,首先使用深度卷积神经网络(DCNN)从两个给定序列中提取全局图像特征描述符,然后利用相似度矩阵上的序列信息,最后计算序列之间的匹配假设,以实现不同季节数据集中环路闭合的检测。

Wenzel等人[243]在欧洲几个城市收集了各种天气和光照条件下的数据,并为自动驾驶中的多天气SLAM提供了一个跨季节数据集,称为4Seasons。在GNSS接收良好的条件下,它们显示了厘米级的参考姿态精度,以及高度精确的跨序列对应。

尽管视觉SLAM可能已经变得强大,但地图在必要信息方面的不足(与外观变化无关)仍然是SLAM的主要问题之一。随着时间的推移,定位漂移以及地图在各种驾驶条件下的可行性不足也阻碍了SLAM进行长距离导航,这使其与自动驾驶中预先构建的基于地图的定位相比竞争力降低[244]。

表4. 关于天气的分类、定位和建图以及规划和控制方法汇总。

图18. 日本北海道积雪覆盖道路边缘的向下箭头。图片由CERI(寒冷地区土木工程研究所)的Atsushi Nishimura博士提供[264]。(https://www.ceri.go.jp/index.html)

7.2 先验图

用于比较和匹配用于定位的在线读数的参考预建地图称为先验地图,这是目前ADS定位的主要力量。保证基于先验地图的点云匹配精度的关键方法是地标搜索。现在教AV如何驾驶最直接的方法是让AV像人类一样思考和行为。人类如何应对低确定性定位的一个典型例子是日本北海道的雪杆“Yabane”(杆上的向下箭头),如图18所示。箭头指向道路边缘,在夜间闪烁或反光,因此驾驶员可以大致了解他们在道路上的相对位置,并防止他们徘徊和远离路边。

在自动驾驶的早期阶段,RFID(射频识别)技术被用于机器人在受控环境和ODD中的定位[245]。当机器人到达一米或两米范围内时,可以通过天线读取路线检查站嵌入RFID标签中的地理信息。此类方法仍被工厂或仓库中的AGV(自动引导车辆)使用[246]。利用V2I通信,AVs可以享受相同的本地化特权[247]。考虑到标记的存在被认为是固定的,在AV定位中地标搜索的基本思想随着时间的推移而出现。像福特这样的企业与主要从事详细3D先验地图的公司密切合作,他们的自动Fusion轿车将通过摄像头或激光雷达在路边寻找停车标志或其他路标等标记,并通过计算其与先验地图中标记的相对距离来感知自我的位置[248]。虽然听起来很简单,但这仍然让福特能够在不增加额外硬件成本的情况下,以厘米为单位精确定位自己的AV。然而,潜在的成本和困难在于不断更新和维护先验地图,这也是地图公司正在致力于实现更智能、更高效的系统。

Cornick等人[249]创建了一种新的基于地图的定位,称为定位探地雷达(LGPR)。顾名思义,他们安装在汽车底架上的系统向地面发送电磁脉冲,并测量来自地表下的独特反射轮廓。通过高效的处理单元将标识符与注册数据相匹配,他们能够按照高速公路标准的速度获取自我车辆的准确位置。与普通的汽车雷达不同,该系统使用100MHz至400MHz的雷达,能够在各种恶劣环境下工作。它不仅实现了至少与传统定位方法相同或更好的精度,而且在水坑或雪堆导航方面也显示出巨大的优势。但它确实有局限性。当土壤饱和度达到某一水平(如30%)时,雷达在其工作范围内产生的衰减可能达到10 dB/m[265]。雪中的另一个风险是融雪盐,它会严重衰减RF信号。尽管为克服这些问题保留了余地,但他们仍在努力更好地刻画LGPR系统。

Sensible4使用基于LiDAR的体积概率分布[266]方法在所有天气下进行建图和定位,这减少了地图中的信息量和细节,而是捕获了表面(表面)的斑块分布。他们根据长达一年的激光雷达数据创建了这样的地图,因此,无论季节如何,都会对道路的常见元素进行建模。

7.3 传感器解决方案

ADS、LiDAR、雷达和相机中的所有参与传感器都有机会在恶劣条件下进行定位,多感官位置识别被证明更加稳健[267]。牛津Robotcar数据集的雷达扩展[104]仅使用Navtech雷达在雨雪天气中完成地图构建和定位,这得益于雷达在恶劣天气中的特殊性。Wolcott和Eustice[250]使用多分辨率高斯混合图开发了一种鲁棒的激光雷达定位。他们将点云离散为二维网格,并在z轴上扩展高斯混合分布。这有助于将点云压缩为具有参数表示的压缩2.5D地图。他们展示了在各种路况(包括建筑)下以及在恶劣天气(如下雪)下驾驶的能力。他们的测试表明,与传统的基于反射率的定位相比,正常市区条件下的均方根(RSM)误差略有增加,这并不被认为是一个问题。在下雪条件下,他们确实将RSM误差率在横向和纵向两侧降低了约80%[251]。

与传感器融合类似,还需要额外的模态来帮助定位。Brunner等人[253]在传统SLAM算法中结合了视觉和红外成像来完成这项工作。他们首先评估每个传感器的数据质量,并在组合数据之前处理可能导致错误的不良数据。这里引入热摄像机的原理与前面讨论的几乎相同,仅用于此处的定位目的。他们的独特之处在于,他们不仅在低能见度条件下(如黄昏或突然的人造强光)测试了这种模式,还在烟雾、火灾和酷热条件下进行了测试,这些条件使红外相机饱和。无法保证有缺陷的数据在算法中完全没有权重,但与单个传感器模态相比,这种组合确实降低了错误率。他们的方法在不受严重影响的情况下充分利用每个传感器,并抑制受影响者的错误。这种扬长避短的策略为我们提供了一个有弹性的认知的机会。

7.4 横向定位

除了沿着道路的行驶方向外,车辆在垂直于行驶运动的横向方向上的定位也同样重要,因为巡航时保持在车道内是重要的交通规则,也是安全驾驶的保证之一。在不利天气条件下,横向定位面临的挑战是,用于正常定位的许多要素,如车道线、路缘、道路护栏和其他地标,以及感知这些要素的传感器,目前可能不可用或受到影响。在一些寒冷的地方,即使在晴朗的日子,道路也可能被积雪覆盖;激光雷达或摄像机在下雨或下雪期间接收到的噪声或干扰可能会阻碍基本的参考车道标记;因此,在这种情况下,AV将很难将自己放在右车道上转弯或导航通过十字路口。

Aldibaja等人[268]通过将地图图像转换为边缘轮廓以表示一系列LiDAR信号反射率峰值中的道路标记,描述了横向定位漂移的一般原因。路边累积的雪为激光雷达造成了不规则分布的尖锐强度峰值,而来自雪雨天气的潮湿元素在道路上留下了低反射率的线路。旧路的磨损和树枝伸入道路空间的植被有时也会造成异常。这些问题使激光雷达对车道线的实际位置和道路区域的边界感到困惑,从而导致错误的横向移动。Aldibaja的小组建议使用主成分分析(PCA)方法提取优势边缘轮廓分布模式,并通过边缘轮廓匹配消除“假”车道线[152][252]。此外,通过基于主导特征向量(特征道路)修补缺失的激光雷达元素,重建了可靠的激光雷达轮廓。在关键环境中,横向移动的误差减小到15 cm,定位精度为96.4%[268]。

8. 规划和控制

到目前为止,几乎所有的基本信息都已收集和处理,以确保规划者做出最安全和有效的决策。最后,执行器执行命令并执行“驱动”。与天气相关的规划和控制汇总见表4。

8.1 规划

天气对全球路线规划的影响可能还没有进入人们的视线,因为要满足难以遇到的条件,需要进行长距离的实地测试和不可预测的天气。然而,设想由飓风或洪水等极端天气造成的气象灾害或地质灾害,破坏道路或对户外活动构成威胁,全球路径规划模块必须调整其原始路线,并在受影响区域周围导航AV。与我们现在智能手机上的导航类似,地图应用程序可以在途中发生事故或道路作业时提醒客户,并在估计时间因情况而延长时自动优化路线。寒冷地区土木工程研究所(CERI)冰雪研究团队[269]正在日本北部地区开发一种广泛的信息提供服务,那里的雪很常见。这项服务可以向司机的手机发送有关当前降雪、能见度和预报信息的警报或电子邮件,并提供暴风雪周围的绕行选项。对于AVs,这种功能依赖于互联网连接的设备和海量数据挖掘,因此,对于天气条件下的此类任务,需要物联网或至少车辆对车辆(V2V),就像之前在[154]中引入的洪水预警系统一样。

值得一提的是,冬季驾驶模式和道路磨损预防是当地路线规划中的一个值得关注的问题,因为自动驾驶是一个不断完善的过程:如果穿梭服务AV反复驾驶相同的路线,而不会对其驾驶路线造成任何变化,随着时间的推移,其行驶路线的精度将接近厘米级,道路将面临磨损的沟槽,或冬季危险的湿滑轨道[255]。

Ta’s等人[261]提出了在有限能见度下的不确定性感知运动规划,这可能是不利天气或闭塞的结果。他们的计划者模仿了人类驾驶员在恶劣驾驶条件下的行为,包括降低车速、准备避让不可见的驶近车辆,以及尽管我们有自己的通行权,但仍要注意不符合规定的行为。通过假设最坏的情况,使运动规划器具有鲁棒性。Jalalmaab等人[256]设计了一种具有时变安全约束的模型预测控制器(MPC),用于避免碰撞的路径规划。所提出的控制器将道路边界和周围车辆的动态变化纳入约束考虑,并找到用于导航AV的纵向和横向控制的最佳命令。虽然它不是为天气条件而设计的,但天气只是另一个参数,也具有时变动态特性。它可以是可量化的感知数据或路况数据,将在第9节中介绍。Peng等人[257]介绍了一种自适应路径规划模型和跟踪控制方法,用于雨天的防撞和变道机动。他们首先使用高斯分布来评估雨水对路面的影响,并推导出自适应轨迹,随后基于分数的决策和多级驾驶模式在保持安全、舒适和效率的同时进行控制。由此可见,这种运动规划需要天气分类或不确定性水平评估的基础。因此,传感器和功能模块的集成对于全能ADS至关重要。

8.2 控制

毫无疑问,在不利条件下的车辆控制或决策模式将不会保持完全相同,以便适应。一个典型的例子:一辆AV在道路上遭遇雷雨,能见度骤降。AV必须做出调整,以应对不利条件,包括减速、针对低能见度和潮湿路面启动应对措施等。众所周知,当路面潮湿或结冰时,制动距离会更长,追尾风险也会大大增加。根据Ali Abdi Kordani等人[258]对80 km/h速度下车辆制动距离的研究,雨雪和结冰路面条件下的道路摩擦系数分别为0.4、0.28和0.18,而平均干燥路面摩擦系数约为0.7。尽管考虑到公共汽车或卡车自身的高惯性,雨天条件下的制动距离几乎没有变化,但轿车的制动距离增加了10米;在下雪的情况下,制动距离增加28%,在结冰的情况下大幅增加71%,普通轿车的制动距离可达180米,卡车和公共汽车的制动距离为300米[270]。这一惊人的数据提醒我们,在不利条件下,尤其是路面潮湿或结冰时,AV的行为需要进行一定的调整。大幅度延长的制动距离需要更长的跟车距离,必要时可能需要更低的巡航速度。当道路状况发生变化时,某些类型的汽车也可能需要切换牵引模式。因此,对AVs造成的天气影响直接产生了调整行为的需求。

在大风天气或在大面积水域上的桥梁上行驶时,车辆会承受垂直于车辆前进方向的较大力。这称为侧滑,通常由侧风引起。横向风稳定通常是电子稳定控制系统(ESC)的工作,它稳定车辆的横向运动,以防止打滑[271]。然而,作为冗余,ESC系统启动较晚,当车辆开始打滑时,使用制动器纠正偏航参考模型的偏差[272]。对于ADS,最好采用比人类驾驶员更具判断力的主动转向控制模式。

除了算法模型,业界更关注AV控制的实际性能。风险评估是运动规划和控制的主要基础,而天气状况会以几何级数增加风险指数和控制难度。上述打滑和牵引力损失导致的车轮编码器与真实车辆运动不匹配不仅对自我车辆的定位造成威胁,也对AV控制命令的成功执行造成威胁[259]。自动驾驶技术提供商Sensible4公司使用多个传感器监控车轮,实现了一个控制堆栈。实际加速度、车轮转速和车轮角度的信息对于控制模块进行正确修正和保持精确控制至关重要[255]。至少可以说,在没有安全驾驶员的情况下,AV控制的最后一道障碍是4级或更高级别车辆的遥控[260]。工作人员会坐在遥控中心监控AV的移动和数据,并在必要时接管。

最后但并非最不重要的是,当乘客舒适度很大程度上取决于AV的控制算法时,ADS提供商不应忽视乘客舒适度[273]。为了乘客的最佳乘坐体验,应避免不必要的加速和急刹车,但这还不是全部。如果有任何不利的驾驶条件,是对AV行为的不信任和缺乏信心扰乱了人们的神经。因此,为了向消费者保证,安装信息显示系统,如平视显示器(HUD),特别是在低能见度条件下提示AV即将移动,仍然可以被视为技术公司和制造商的良好选择[262]。

表5:不利天气辅助方法汇总

9. 不利条件下的辅助方法

表5显示了不利天气解决方案中的辅助方法汇总。在这里,我们介绍了三种常见概念之外的恶劣天气解决方案的主要辅助方法:路面检测、空中/鸟瞰单元和V2X。

9.1 路面检测

最初,路面检测旨在对沥青、草、砾石、沙子等道路类型进行分类,以更好地提供牵引能力。另一方面,路面状况的变化是天气状况,特别是潮湿天气的直接结果,因此自然会将路面检测视为天气分类的辅助手段。尽管由于高温,道路表面也会出现海市蜃楼效应,但这更多的是与光有关的情况,而不是道路的物理变化,如第5.4节所述。

如第8.2节所述,湿滑路面对交通安全构成实际威胁。道路状况的信息可能与汽车的天气状况一样重要。除了道路摩擦或环境传感器之外,可以通过各种方式确定干燥或潮湿条件[277]。Sabanovic等人[274]建立了基于视觉的DNN来估计道路摩擦系数,因为摩擦降低的干燥、湿滑、泥浆和结冰表面基本上可以相应地识别为晴朗、下雨、下雪和冰冻天气。他们的算法不仅检测潮湿条件,而且能够对潮湿条件和路面类型的组合进行分类。虽然他们没有在自动驾驶上实施,但它适用于改进车辆动态控制和防抱死制动系统(ABS),这也是ADS的关键。Panhuber等人[275]在自动驾驶中成功应用了路面检测。通过在挡风玻璃后面安装一个单摄像头,观察前车引起的水或灰尘的喷洒以及周围道路特征的鸟瞰图,他们使用多个分类器确定路面状况。自动驾驶的干湿分类准确率为86%,这是ADS中天气分类模块的一大优势。

路面检测也可以以我们意想不到的方式进行:音频。在不同路况或不同湿度条件下,车辆速度、轮胎表面相互作用和噪音的声音可能是独特的,因此Abdic等人[276]有理由使用超过78万箱音频来训练深度学习网络,包括声音微弱时的低速,即使在0速时也是如此,因为它可以检测其他车辆驾驶发出的声音。人们担心车辆类型或轮胎类型可能会影响这种方法的通用性以及在AV上安装声音收集装置的不确定难度。所有这些都告诉我们,在汽车或道路上仍有很多需要探索的地方,以找到在恶劣天气条件下有帮助的东西。

9.2 鸟瞰图

早在引入自动驾驶之前,激光雷达技术就被广泛应用于地理测绘和气象监测。地形、水文、林业和植被覆盖可以通过安装在飞机上甚至卫星上的激光雷达进行测量[300]。从上面看的好处是视野覆盖范围很大,障碍物比从地面看的少。随着无人机(UAV)如无人机的快速发展,从俯视图进行交通感知变得越来越现实,俯视图可以看到地面上看不到的东西。例如,在交叉路口,AV只能根据其引导车辆而不是超出直接视线的东西进行行为,然而,无人机可以看到引导车辆的引导车辆,然后可以预见远离目标AV的风险,并提前避免事故。空中激光雷达使AV自我感知成为宏观视角。Xu等人[280]开发了一种通过模拟学习使用航空图像离线检测路缘石的方法。他们从纽约市平面数据集[301]中获取图像作为输入,并生成一个带有代表道路边缘的顶点和边的图形。还有成熟的激光雷达障碍物警告和回避系统(LOWAS)用于无人机感知和回避[279]。LOWAS系统由三个关键模块构成:轨迹预测、潜在碰撞计算和最佳回避轨迹生成,它们为在地面运输导航中使用空中激光雷达提供了可能性并证明了其可行性。

就作者而言,目前阻碍空中激光雷达部署到ADS中的最大问题是传输和通信。如果没有先进的无线信道,很难从一定距离将无人机的数据或决策实时传输到AV,更不用说鸟瞰图不足以覆盖隧道和高架道路常见的现代城市环境。因此,尽管正在对航空图像分割和目标检测进行研究,但目前航空激光雷达的主要用途集中在固定任务上,如结构检查[278]。

9.3 路边装置

路边激光雷达,也从与汽车顶部不同的角度来看,已经开始参与自动驾驶。与鸟瞰装置类似,安装在路边装置(RSU)上的激光雷达安装在电杆上,视角也很宽,在雨天不会受到水幕的影响,在下雪天气也不会受到周围车辆造成的雪旋的影响。稍微向下指向的角度也可以避免阳光直射。Wu等人[281]测试了路边激光雷达在风和雪条件下的车辆检测性能,并通过背景过滤和对象聚类改进了数据处理。如果有可用的连接系统,则AV可以利用路边激光雷达捕获的数据并进行更好的规划。有时,当天气条件太差,任何传感器都无法在浓雾等可靠状态下工作时,路边激光雷达提供的数据可以作为冗余,以配合ADS对AV的决策,并减少重要地点的事故。Tian[302]使用路边激光雷达识别天气状况。他们记录了包括雨、雪和风在内的各种天气的激光雷达点云模式特征,并量化了每种天气的影响,以便根据其检测距离偏移的标准差来区分天气。他们的数据不包括内华达州可能罕见的雾况,它揭示了路边激光雷达的地理局限性。Vargas Rivero等人[282]将LiDAR放置在指向停车场沥青的固定位置9个月,检测距离在x方向上的标准偏差、第二回波检测的次数和回波脉冲宽度(EPW)的平均值。在晴朗、大雾、雨雪天气下,准确度F评分通常保持在90%以上。

无论如何,通过连接的车辆系统或V2X系统,路边激光雷达至少可以从自己的位置向附近的车辆提供天气分类信息和感知数据,这已经优于单独的AV。世界上的几个城市,如密歇根州的安娜堡[303];西班牙巴塞罗那[304];中国广州[305]已经启动了他们的智能城市项目,数千个路边激光雷达和传感器将安装在城市基础设施上,形成一个巨大的本地连接系统。可以想象,有了路边的天气感知传感器,恶劣的天气难题将更容易解决。

图19. 日本名古屋Morikoro公园的V2I基础设施。图片由Perception Engine Inc.的Abraham Monrroy-Cano先生提供。(https://perceptionengine.jp/)

9.4 V2X

车辆到一切系统是智能交通系统(ITS)和ADS发展过程中不可忽视的一部分。无论经验丰富的驾驶员熟练程度如何,由于驾驶员之间的道路信息不对称和反应时间短,事故仍然会发生。V2X系统扩大了信息收集的范围,从一辆汽车的感知扩展到对道路上几乎所有元素的感知。这里的“一切”或X可以指其他车辆、路边基础设施,甚至行人。为了将行人纳入V2X或进一步的物联网(IoT)系统,需要先进的可穿戴设备或通用智能手机技术支持,这超出了本次调查的范围。在这里,我们将主要介绍车辆对车辆(V2V)和车辆对基础设施(V2I)中V2X的不利天气解决方案。

V2V的核心是互联车辆之间的信息共享(CV),这从根本上消除了信息不对称的问题。在正常情况下,由于地形或交叉口的原因,视觉障碍(如卡车在自我车辆前面或车辆超出直接视线)是发生事故的高风险。利用V2V技术,自我车辆获得了从另一辆车获取感知数据和位置信息的能力,此时该车的视野超出了自己的视野[287],因此驾驶员或自我车辆可以通过根据附加信息做出正确的决定和调整行为来避免事故。就恶劣天气而言,首先经历或感知到天气状况或路面状况变化的车辆可以在其他车辆到达该位置之前进行天气评估,然后将感知数据或评估结果转发给其他车辆,以提醒他们注意危险。如果不利条件导致交通拥堵或事故,后一种车辆可以根据前一种CVs实时收集的信息规划新路线,以提高交叉口和工作区的效率和安全性[283]。随着V2V技术的发展,卡车在高速公路或码头区域的排队将成为ADS的第一个成熟应用。根据M.Ahmed等人[284]对怀俄明州驾驶员对CV的感知的评估,几乎90%的人类测试驾驶员发现,前方碰撞警告和改道功能非常有用,因为道路状况信息得到了改善。因此,可以肯定的是,V2V可以为ADS带来的改善是毋庸置疑的。

另一方面,V2I(图19)不像V2V那样易变,但在智能交通方面仍具有巨大潜力。前一节中介绍了路边传感器(如鸟瞰激光雷达)的优点。除了在连接到天气信息服务或具有自己的天气感知能力时在特定路段提供警报[288],V2I还提供了基于多图像的去风化的可能性,而无需涉及第5节中讨论的复杂神经网络。通过预先捕获并存储在基础设施中的晴朗天气中的特定场景的图像,可以轻松地重建没有天气(雨、雾、雪等)干扰的三维模型,并将其提供给附近的车辆,以帮助他们在低能见度和不完整的道路信息下安全导航。但当然,这样的功能需要基础设施和车辆之间的实时视频(快速图像)共享。这就是为什么为了V2X传输需要压缩大量LiDAR点云数据[306]的原因,也是电信界致力于V2X通信方法以实现更高带宽和更低延迟的原因,例如第五代无线技术,即5G[283],以从服务器访问此类可视数据并在车辆之间传输。

Jung等人[285]开发了一种带有V2X通信辅助的ADS,包括超视距感知和扩展规划。如果我们认为V2X是一个额外的传感器,那么这样的系统就像一个新的融合模式。Ego车辆自身的传感器以及其他车辆的传感器和路边传感器有助于感知的数据输入,包括视线以外的感知。通过V2I通信获得的路线、速度和实时交通信息被集成在一起,以优化解决方案扩展路线规划。这种模式在很大程度上接近完全自动驾驶,但仍受到CV网络规模和连接基础设施覆盖范围的限制。

与感知方法一样,V2X的架构也在改进,以更好地应对天气条件。Barracina等人[289]提出了一种V2X-d架构,该架构将V2V和V2I结合在一起,以克服各自的不足,例如V2V的水平视野有限以及路边基础设施上传统监控摄像头的脆弱性。该架构允许在所有天气条件下估计城市地区的车辆密度,这是在自动驾驶中使用V2X系统的理想方式。Vaidya等人[290]使用路边基础设施作为边缘云的附近处理和存储服务器,并将模糊推理系统部署为道路天气危害评估方法。他们将从路边环境传感器和CVs收集的路面条件和表面温度作为语言变量,模糊推理系统基于IF-THEN和and类型以及OR类型规则输出结果滑动。总共建立了10个模糊规则。以一个为例:如果表面状况为“冰警告”,表面温度为“低”或“非常低”,则滑溜是“非常滑”。这些结果在分段网络中进行本地处理,并分发到附近的CVs。计算集中的压力、处理时间和CVs通信的延迟都大大降低。

Onesimu[286]等人提出了一种基于物联网的智能事故避免系统,用于恶劣天气和道路条件。他们使用了Hjelkrem和Ryeng[307]收集的数据集,该数据集不仅包含天气条件,还包含车辆速度和重量信息,这些信息用于计算当前条件下车辆的适当速度限制,以避免碰撞。他们在训练过程中实现了一个Naıve Bayes分类器,以预测网络中发生事故的可能性,并使用Blynk[308]移动应用程序进行硬件控制和模拟。此应用程序将在汽车后窗上显示一条包含事故警告或天气信息的消息,如“前方有事故,沙尘暴”,随后的汽车将收到此消息,并采取相应措施防止事故发生,并可能会被传递。

有一个名为OpenXC[309]的有趣平台,它是一种应用程序编程接口(API),它结合了开源软件和硬件,通过自定义应用程序和模块扩展车辆。大多数应用程序基于Android,可以读取和翻译汽车指标,最重要的是,它们已经做好了连接服务集成的准备。举两个与不利条件相关的例子。夜间前方碰撞警告(Nighttime Forward Collision Warning,夜视)项目使用标准USB网络摄像头捕捉物体的边缘以进行物体检测,并帮助避免动物或障碍物碰撞。制动距离跟踪项目使用SICK DMT-2 LiDAR[310]传感器测量车辆之间的距离,并在驾驶员以过高的动量接近其他车辆时发出警告。这些设置看起来很简单,但它们都在Android平台上运行,比如可以访问传感器数据和实时车辆数据的平板电脑。这意味着,在形成一个CV网络之前,只有一个步骤,将这些Android设备连接到一个中心节点。凭借其开放的兼容性和集成灵活性,OpenXC是以简化方式探索V2X的一个很好的候选者。目前,物联网作为智能领域的全球平台,正在一次一个地解决ADS中的安全问题,因此毫无疑问,随着大量的天气和道路数据,物联网系统的可靠性和多功能性将使自动驾驶成为现实。

9.5 其他

恶劣的天气条件给人类驾驶员带来了挑战和影响,就像AV流行之前一样。因此,一些旨在建立人类驾驶员抵御天气的武器库的解决方案仍然可以用于当今的AV。我们知道,当下雨或下雪时,能见度会下降,尤其是在晚上。当数字去除图像中的雨雪条纹成为计算机视觉的趋势时,Charette等人[298]提出了一种智能汽车前照灯,通过禁用与雨滴或雪花颗粒相交的光线,可以看穿雨雪。他们追踪并避免了雨滴上的照明,光通量损失很少,并成功地实现了明显的能见度改善。考虑到车载摄像头现在所看到的与当时人类驾驶员所看到的没有太大不同,这种智能大灯也应该能够提高ADS的能见度。Donati等人[299]甚至制造了一种智能前照灯,内置了电荷耦合(CCD)摄像头和激光雷达,在穿越时可以智能地关闭远光灯,并能够在20米距离检测到人体大小的物体,同时识别率为85%。

在恢复或改善ADS基本功能(如人/行人检测和车辆跟踪)的性能方面,还做出了其他一些努力。特定微多普勒频谱的识别[293]和多层深度学习方法[292]用于恶劣天气下的行人检测任务。专门针对行人的热数据集[294]或大规模模拟数据集[291]也正在建立,以确保ADS能够在天气中断的情况下完成这项重要工作。虽然传统的基于高斯混合概率假设密度滤波器的跟踪器正被用于深度学习车辆跟踪框架[297]中以提高性能,雷达跟踪[296]和无标记道路上基于颜色的视觉车道跟踪系统[295]也显示了鲁棒性,即使ADS不是专门针对这些条件设计的,也可以帮助ADS在不利条件下保持功能。

随着近年来人工智能技术的快速发展,在ADS应用中,包括恶劣天气解决方案在内的新的机器学习方法是不可能避免的。例如,NVIDIA DRIVE主动学习DNN。主动学习从对标记数据进行训练的DNN开始,然后对未标记的数据进行排序,并选择它无法识别的帧,然后将其发送给人类注释器进行标记并添加到训练池中,然后完成学习循环。在夜间场景中,雨滴模糊了相机镜头,很难检测到带雨伞和自行车的行人,主动学习被证明具有超过3倍的准确度,能够避免误报。其他新兴的机器学习方法,如转移学习和联合学习,在强健的人工智能基础设施上也非常有效。不久之后,我们就会看到使用这些先进的机器学习方法在物联网和V2X上的巨大发展[311]。

10. 工具

10.1 数据集

自动驾驶研究离不开数据集。目标检测任务中使用的许多特征需要从数据集中提取,几乎所有算法都需要在数据集中进行测试和验证。为了更好地应对自动驾驶中的不利天气条件,有必要在数据集中有足够的天气条件来覆盖每种天气。不幸的是,大多数通常用于训练的数据集不包含太多不同于晴朗天气的条件。在热带地区收集的一些著名数据集,如nuScenes[143]包含新加坡的一些降雨条件,A*3D[321]包含夜间降雨条件,ApolloScape[323]包含一些强光和阴影条件。表6显示了每个数据集中用于收集的天气条件覆盖范围和传感器的汇总。

研究人员收集了他们生活地区常见的天气数据,或使用模拟[291]建立自己的天气数据集。密歇根大学在早期阶段使用Segway机器人在校园中收集了四季LiDAR数据[327]。Pitropov等人[312]提出了第一个专门关注雪况的AV数据集,称为加拿大不利驾驶条件(CADC)数据集。加拿大滑铁卢的8台摄像机、激光雷达和全球导航卫星系统+惯性导航系统收集了冬季的变化。他们的LiDAR也通过去噪方法进行了修改[189]。大量的雪使得研究人员能够在各种雪条件下测试物体检测、定位和映射,这在人工环境中很难实现。牛津RobotCar[316]是早期的数据集之一,该数据集将不利条件(包括大雨、雪、阳光直射和夜间,甚至道路和建筑工程)纳入权重。Sakaridis等人[212]在Cityscape数据集[349]上应用了雾状合成,并生成了超过20000张清晰天气图像的雾状Cityscapes,该图像广泛用于去雾化任务。同一团队后来引入了ACDC[326],即不利条件数据集和对应项,用于训练和测试不利视觉条件下的语义分割方法。它涵盖视觉领域,包含高质量的精细像素级语义注释雾、夜间、雨和雪图像。Zheng等人[350]将IUPUI驾驶视频/图像基准上传到消费者数字视频库,其中包含公共安全车辆在巡逻和应对灾害时,在不同照明和道路条件下的车载摄像头的示例视图。条件包括雪、雨、直射光、昏暗的照明条件、向阳的阳光、阴影、夜晚及其导致的现象,如道路潮湿、玻璃反光、玻璃结冰、下雨和挡风玻璃脏污、雨刮器移动等。正是在寒冷天气和危险驾驶条件下收集数据的不懈努力,让我们有机会在不利条件下将自动驾驶进一步推向下一个水平。

表6. 常见自动驾驶数据集中的天气状况覆盖率

表7. 模拟器中的天气条件和传感器支持

表8. 世界各地的实验气象设施

图20. CARLA模拟器中雾天气下路面潮湿的城镇场景。

10.2 模拟器和实验设施

自动驾驶的快速发展,尤其是在恶劣天气条件下,得益于模拟平台和试验设施(如雾室或测试道路)的可用性。如图20所示,著名的CARLA[334]模拟器等虚拟平台使研究人员能够构建定制设计的复杂道路环境和非自我参与者,在无限场景中进行真实现场实验非常困难且成本高昂。此外,对于天气条件,每种天气的出现,特别是季节相关或极端气候相关的天气,并非随时待命。例如,热带地区不可能有机会进行雪测试;自然降雨可能不足以收集实验数据。最重要的是,不利条件通常对驾驶来说是危险的,在正常的现场测试中,受试者总是面临安全威胁,而模拟器可以保证绝对零风险。模拟器为随时随地在恶劣天气条件下研究自动驾驶提供了一个很好的平台。近年来,包括开源和开源软件在内的各种模拟平台开发了可调整的天气条件和“一天中的时间”插件。因此,人们可以在将ADS带到室外之前,在模拟器中测试其ADS模式,以抵御雨、雪、不同降水率的雾和强光[351]。表7列出了一些常见自动驾驶模拟器中支持的天气条件和传感器。

另一方面,实验室环境也可以用控制代替真实的现场测试。考虑到试验场地的限制和对周围人员或设施的安全隐患,封闭式人工轨道或室内有造雨(雪)机,具有降水率可控和风险低的优点,可提供几乎相同的环境条件。退一步讲,即使有足够的资源和适合研究人员需求的完美天气条件,当前的立法也很难支持在不利条件和恶劣天气下自主性等于或大于4级的AV测试。表8列出了一些著名的测试设施,并提供了一些有关测试室或轨道的详细信息。

11. 结论

在这项工作中,我们调查了恶劣天气条件对主要ADS传感器(如LiDAR和相机)的影响,以及它们对AV不同元素的影响。列出了包括传感器硬件和机械设备在内的解决方案。不利驾驶条件的核心解决方案是感知增强,并对各种机器学习和图像处理方法(如去噪)进行了深入分析。还讨论了分类、评估、控制和规划、潜在的和未来针对不利天气的辅助解决方案,如路边装置和V2X。这项调查涵盖了几乎所有对交通造成负面影响的常见天气类型,包括雨、雪、雾、霾、强光和污染,并列出了具有天气支持的模拟器和实验设施。

随着LiDAR架构中先进测试仪器和新技术的发展,在常见潮湿天气下的自动驾驶性能方面取得了很大进展。近年来,随着计算机视觉的发展,雨雾条件似乎越来越好,但激光雷达仍有一些改进空间。另一方面,雪仍然处于数据集扩展的阶段,对雪的感知增强还有很多需要挖掘的地方。两个主要的影响源,强光和污染,仍然没有丰富的研究和解决方案。无论如何,在对抗恶劣天气条件方面具有特殊优势的各种传感器,如热摄像机和雷达,正积极部署在各种传感器融合模式中,这为任务提供了强大的支持。希望,为ADS的鲁棒性和可靠性所做的努力能够将自动驾驶研究推向下一个自主水平。

利益声明

作者声明,他们没有已知的相互竞争的财务利益或个人关系可能会影响本文所述的工作。

Acknowledgment

Funding: The author (Y.Zhang) acknowledges “Nagoya University Interdisciplinary Frontier Fellowship” supported by MEXT and Nagoya University, and the Core Research for Evolutional Science and Technology (CREST) project of the Japan Science and Technology Agency (JST).

The authors thank Prof. Ming Ding from Nagoya University for his help. We would also like to extend our gratitude to Sensible4, University of Michigan, Tier IV Inc., Ouster Inc., Perception Engine Inc., and Mr. Kang Yang for their support. In addition, our deepest thanks to VTT Technical Research Center of Finland, the University of Waterloo, Pan Asia Technical Automotive Center Co., Ltd, and Civil Engineering Research Institute for Cold Region of Japan.

References

[1] Ekim Yurtsever et al. “A survey of autonomous driving: Common practices and emerging technologies”. In: IEEE Access 8 (2020), pp. 58443–58469.

[2] Alexander Carballo et al. “LIBRE: The multiple 3D LiDAR dataset”. In: 2020 IEEE Intelligent Vehicles Symposium (IV). IEEE. 2020, pp. 1094–1101.

[3] University of Michigan. Getting Traction: Tips for Traveling in Winter Weather. [Last accessed 06 May 2021]. url: https://mcity.umich.edu/wpcontent/uploads/2020/10/mcity-driverless-shuttle-whitepaper.pdf.

[4] Kevin E Trenberth and Yongxin Zhang. “How often does it really rain?” In: Bulletin of the American Meteorological Society 99.2 (2018), pp. 289–298.

[5] Jean Andrey and Sam Yagar. “A temporal analysis of rain-related crash risk”. In: Accident Analysis & Prevention 25.4 (1993), pp. 465–472.

[6] National Oceanic and Atmospheric Administration. Getting Traction: Tips for Traveling in Winter Weather. [Last accessed 03 May 2021]. url:https : / / www . weather . gov / wrn / getting _traction.

[7] Aryan Mehra et al. “ReViewNet: A fast and resource optimized network for enabling safe autonomous driving in hazy weather conditions”. In: IEEE Transactions on Intelligent Transportation Systems (2020).

[8] Automated Driving. “Levels of driving automation are defined in new SAE international standard J3016: 2014”. In: SAE International: Warrendale, PA, USA 1 (2014).

[9] Michael Laris. “Transportation Waymo launches nation’s first commercial self-driving taxi service in Arizona”. In: Washington Post 6 (2018), p. 2018.

[10] UMTRI Briefs. “Mcity Grand Opening”. In: Research Review 46.3 (2015).

[11] Mauro Bellone et al. “Autonomous Driving in the Real-World: The Weather Challenge in the Sohjoa Baltic Project”. In: Towards Connected and Autonomous Vehicle Highways. Springer, 2021, pp. 229–255.

[12] Laura Sulkava. Mid-winter self-driving pilot in a busy Finnish campus suburb. [Last accessed 02 Nov. 2021]. url: https://sensible4.fi/2021/10/20/mid- winter- self- driving- pilot- in-a-busy-finnish-campus-suburb/.

[13] Pete Bigelow. Why Level 3 automated technology has failed to take hold. [Last accessed 10 May 2021]. url: https://www.autonews.com/shift/ why - level - 3 - automated - technology - has - failed-take-hold.

[14] Fred Meier. Which Cars Have Self-Driving Features for 2021? [Last accessed 08 May 2021]. url:https://www.cars.com/articles/which-cars-have - self - driving - features - for - 2021 - 433821/.

[15] Fred Lambert. Watch Tesla Autopilot go through a snowstorm. [Last accessed 10 May 2021]. url: https : / / electrek . co / 2019 / 01 / 28 / tesla - autopilot-snow-storm/.

[16] Cadillac General Motors. Designed to take your hands and breath away. [Last accessed 10 May 2021]. url: https : / / www . cadillac . com /ownership / vehicle - technology / super -cruise.

[17] Junyao Guo, Unmesh Kurup, and Mohak Shah. “Is it Safe to Drive? An Overview of Factors, Metrics, and Datasets for Driveability Assessment in Autonomous Driving”. In: IEEE Transactions on Intelligent Transportation Systems 21.8 (2020), pp. 3135–3151. doi: 10 . 1109 / TITS . 2019 . 2926042.

[18] Shizhe Zang et al. “The impact of adverse weather conditions on autonomous vehicles: how rain, snow, fog, and hail affect the performance of a self-driving car”. In: IEEE vehicular technology magazine 14.2 (2019), pp. 103–111.

[19] Abdul Sajeed Mohammed et al. “The perception system of intelligent ground vehicles in all weather conditions: A systematic literature review”. In: Sensors 20.22 (2020), p. 6532.

[20] Keisuke Yoneda et al. “Automated driving recognition technologies for adverse weather conditions”. In: IATSS research 43.4 (2019), pp. 253–262.

[21] Stefan K Gehrig and Fridtjof J Stein. “Dead reckoning and cartography using stereo vision for an autonomous car”. In: Proceedings 1999 IEEE/RSJ International Conference on Intelligent Robots and Systems. Human and Environment Friendly Robots with High Intelligence and Emotional Quotients (Cat. No. 99CH36289). Vol. 3. IEEE. 1999, pp. 1507–1512.

[22] Yiqun Dong et al. “Mcity data collection for automated vehicles study”. In: arXiv preprint arXiv:1912.06258 (2019).

[23] Takeyoshi Imai. “Legal regulation of autonomous driving technology: Current conditions and issues in Japan”. In: IATSS Research 43.4 (2019), pp. 263–267. issn: 0386-1112.

[24] NIKKEI Asia. Toyota autonomous bus hits Tokyo Paralympian, taking him out of match. [Last accessed 20 Nov 2021]. url: https://asia.nikkei.com/Spotlight/Tokyo-2020-Olympics/Toyota-autonomous - bus - hits - Tokyo - Paralympian -taking-him-out-of-match.

[25] University of Michigan. Mcity-driverless-shuttle-case-study. [Last accessed 06 May 2021]. url:https : / / mcity . umich . edu / wp - content /uploads/2018/09/mcity-driverless-shuttle-case-study.pdf.

[26] Jong Kyu Choi and Yong Gu Ji. “Investigating the importance of trust on adopting an autonomous vehicle”. In: International Journal of Human Computer Interaction 31.10 (2015), pp. 692–702.

[27] Sebastian Thrun et al. “Stanley: The robot that won the DARPA Grand Challenge”. In: Journal of Field Robotics 23.9 (2006), pp. 661–692.doi: https : / / doi . org / 10 . 1002 / rob . 20147.eprint: https : / / onlinelibrary . wiley . com /doi/pdf/10.1002/rob.20147. url: https://onlinelibrary.wiley.com/doi/abs/10.1002/rob.20147.

[28] Velodyne. HDL-64E Spec Sheet. [Last accessed 10 Oct. 2021]. url: https : / / velodynesupport .zendesk . com / hc / en - us / articles /115003632634-HDL-64E-Spec-Sheet.

[29] Mario Bijelic, Tobias Gruber, and Werner Ritter. “A benchmark for lidar sensors in fog: Is detection breaking down?” In: 2018 IEEE Intelligent Vehicles Symposium (IV). IEEE. 2018, pp. 760–767.

[30] Xiaochen Sun et al. “Siphotonics for practical LiDAR solutions”. In: Applied Sciences 9.20 (2019), p. 4225.

[31] Dachuan Wu, Yasha Yi, and Yuxiao Zhang. “High-efficiency end-fire 3D optical phased array based on a multi-layer Si 3 N 4/SiO 2 platform”. In: Applied optics 59.8 (2020), pp. 2489–2497.

[32] Giuseppe Emanuele Lio and Antonio Ferraro. “LIDAR and Beam Steering Tailored by Neuromorphic Metasurfaces Dipped in a Tunable Surrounding Medium”. In: Photonics 8.3 (2021). doi: 10. 3390/photonics8030065.

[33] You Li and Javier Ibanez-Guzman. “Lidar for autonomous driving: The principles, challenges, and trends for automotive lidar and perception systems”. In: IEEE Signal Processing Magazine 37.4 (2020), pp. 50–61.

[34] Norihiko Nishizawa and Masahito Yamanaka. “Characteristics of Spectral Peaking in Coherent Supercontinuum Generation”. In: CLEO: Science and Innovations. Optical Society of America. 2021, STh5A–4.

[35] Outsight. Smarter Vehicles and Robots. [Last accessed 14 June 2021]. url: https : / / www .outsight.ai/smarter-vehicles-and-robots.

[36] SONY. NIR (Near-Infrared) Imaging Cameras. [Last accessed 21 Oct. 2021]. url: https://www. infinitioptics . com / technology / nir - near - infrared.

[37] Guillermo Gallego et al. “Event-based vision: A survey”. In: arXiv preprint arXiv:1904.08405 (2019).

[38] Steve Mann and Rosalind W. Picard. “On being ‘undigital’ with digital cameras: Extending Dynamic Range by Combining Differently Exposed Pictures”. In: Proceedings of IS&T. 1995, pp. 442–448.

[39] Tesla. Transitioning to Tesla Vision. [Last accessed 14 May 2021]. url: https://www.tesla.com/support/transitioning-tesla-vision.

[40] Beverly Braga. What is Tesla Autopilot? [Last accessed 14 June 2021]. url: https : / / www .jdpower . com / cars / shopping - guides / what -is-tesla-autopilot.

[41] Sujeet Milind Patole et al. “Automotive radars: A review of signal processing techniques”. In: IEEE Signal Processing Magazine 34.2 (2017), pp. 22–35.

[42] Navtech Radar. FMCW Radar. [Last accessed 22 Nov 2021]. url: https : / / navtechradar . com / explore/fmcw-radar/.

[43] Alessio Carullo and Marco Parvis. “An ultrasonic sensor for distance measurement in automotive applications”. In: IEEE Sensors journal 1.2 (2001), p. 143.

[44] Lou Frenzel. Ultrasonic Sensors: A Smart Choice for Shorter-Range Applications. [Last accessed 17 Aug. 2021]. url: https : / / www . electronicdesign . com / industrial - automation / article / 21806202 / ultrasonic - sensors-a-smart-choice-for-shorterrange-applications.

[45] Takafumi Kamemura et al. “Development of a Long-Range Ultrasonic Sensor for Automotive Application”. In: SAE International Journal of Passenger Cars-Electronic and Electrical Systems 1.2008-01-0910 (2008), pp. 301–306.

[46] Tesla. Summon Your Tesla from Your Phone. [Last accessed 14 June 2021]. url: https://www. tesla . com / blog / summon - your - tesla - your - phone.

[47] Paul D Groves. “The complexity problem in future multisensor navigation and positioning systems: A modular solution”. In: Journal of Navigation 67.2 (2014), pp. 311–326.

[48] Advanced Navigation. Spatial FOG Dual Reference Manual version 1.3. [Last accessed 12 Dec 2021]. url: https://www.advancednavigation.com/wp- content/uploads/2021/08/Spatial-FOG-Dual-Reference-Manual.pdf.

[49] Joseph Redmon et al. “You only look once: Unified, real-time object detection”. In: Proceedings of the IEEE conference on computer vision and pattern recognition. 2016, pp. 779–788.

[50] Alex H Lang et al. “Pointpillars: Fast encoders for object detection from point clouds”. In: Proceedings of the IEEE/CVF Conference on Computer

Vision and Pattern Recognition. 2019, pp. 12697–12705.

[51] Yan Yan, Yuxing Mao, and Bo Li. “Second: Sparsely embedded convolutional detection”. In: Sensors 18.10 (2018), p. 3337.

[52] Hongwu Kuang et al. “Voxel-FPN: Multi-scale voxel feature aggregation for 3D object detection from LIDAR point clouds”. In: Sensors 20.3

(2020), p. 704.

[53] Sampo Kuutti et al. “A survey of the state-of-the-art localization techniques and their potentials for autonomous vehicle applications”. In: IEEE Internet of Things Journal 5.2 (2018), pp. 829–846.

[54] Brian Paden et al. “A survey of motion planning and control techniques for self-driving urban vehicles”. In: IEEE Transactions on intelligent vehicles 1.1 (2016), pp. 33–55.

[55] Velodyne. Velodyne Alpha Prime datasheet. [Last accessed 21 Oct. 2021]. url: https : / / velodynelidar . com / wp - content / uploads / 2019 / 12 / 63 - 9679 _ Rev - 1 _ DATASHEET _ ALPHA - PRIME_Web.pdf.

[56] Texas Instruments. AWR1642 Single-Chip 77- and 79-GHz FMCW Radar sensor datasheet. [Last accessed 17 June 2021]. url: https://www.ti.com/product/AWR1642.

[57] Garmin Ltd. VIRB 360 Owner’s Manual. [Last accessed 17 June 2021]. url: https : / / www8 . garmin . com / manuals / webhelp / virb360 / EN - US/VIRB_360_OM_EN-US.pdf.

[58] Ricoh. SV-M-S1 Product specifications. [Last accessed 17 June 2021]. url: https://industry. ricoh.com/en/fa_camera_lens/sv-m-s1/spec. html.

[59] Bright Way Vision. See through adverse weather, darkness, and glare. [Last accessed 17 June 2021]. url: https : / / www . brightwayvision . com / technology.

[60] SenS HiPe. SenS HiPe Long Exposure SWIR Camera. [Last accessed 17 June 2021]. url: https : / / pembrokeinstruments . com / swir - cameras / SenS-HiPe//.

[61] Axis Communications. Product support for AXIS Q1922 Thermal Network Camera. [Last accessed 17 June 2021]. url: https : / / www . axis . com / products/axis-q1922/support.

[62] Lufft. StaRWIS-UMB - Stationary Road Weather Information Sensor. [Last accessed 17 June 2021]. url: https : / / www . lufft . com / products / road - runway - sensors - 292 / starwis - umb - stationary - road - weather - information - sensor-2317/.

[63] Bosch GmbH. Ultrasonic Sensor Generation 6. [Last accessed 12 Dec 2021]. url: https : / / www . bosch - mobility - solutions . com / en / solutions/sensors/ultrasonic-sensor/.

[64] Steven E Shladover et al. “Automated vehicle control developments in the PATH program”. In: IEEE Transactions on vehicular technology 40.1 (1991), pp. 114–130.

[65] Allen Howard Perry and Leslie J Symons. Highway meteorology. CRC Press, 1991.

[66] Ralph H Rasshofer, M Spies, and H Spies. “Influences of weather phenomena on automotive laser radar systems”. In: Advances in Radio Science 9.B. 2 (2011), pp. 49–60.

[67] Thomas Fersch et al. “The influence of rain on small aperture LiDAR sensors”. In: 2016 German Microwave Conference (GeMiC). IEEE. 2016, pp. 84–87.

[68] Sinan Hasirlioglu et al. “Modeling and simulation of rain for the test of automotive sensor systems”. In: 2016 IEEE Intelligent Vehicles Symposium (IV). IEEE. 2016, pp. 286–291.

[69] S Jebson. “Fact sheet number 3: Water in the atmosphere”. In: National Meteorological Library and Archive, 2007.

[70] Jacob Lambert et al. “Performance analysis of 10 models of 3D LiDARs for automated driving”. In: IEEE Access 8 (2020), pp. 131699–131722.

[71] Michele Colomb et al. “An innovative artificial fog production device improved in the European project ‘FOG’”. In: Atmospheric Research 87.3-4 (2008), pp. 242–251.

[72] Maria Jokela, Matti Kutila, and Pasi Pyyk¨onen. “Testing and validation of automotive point-cloud sensors in adverse weather conditions”. In: Applied Sciences 9.11 (2019), p. 2341.

[73] Velodyne. A Smart, Powerful Lidar Solution. [Last accessed 21 Oct. 2021]. url: https : / / velodynelidar.com/products/puck/.

[74] Robosense. RS-LiDAR-32. [Last accessed 21 Oct. 2021]. url: https : / / www . robosense . ai / en / rslidar/RS-LiDAR-32.

[75] Tianyu Gao et al. “Effects of temperature environment on ranging accuracy of lidar”. In: Tenth International Conference on Digital Image Processing (ICDIP 2018). Vol. 10806. International Society for Optics and Photonics. 2018, p. 1080671.

[76] Matti Kutila et al. “Automotive LiDAR performance verification in fog and rain”. In: 2018 21st International Conference on Intelligent Transportation Systems (ITSC). IEEE. 2018, pp. 1695–1701.

[77] LED Laser. “The new edition of the international laser product safety standard IEC 60825-1”. In: laser 43.50550 (2017), p. 2882.

[78] Angus Pacala. How Multi-Beam Flash Lidar Works. [Last accessed 26 Nov 2021]. url: https: //ouster.com/blog/how- multi- beam- flash-lidar-works/.

[79] Kai Sun Yifan David Li. Hesai Introduces PandarGT – Third-Gen Solid-State LiDAR. [Last accessed 26 Nov 2021]. url: https : / / www . hesaitech.com/en/media/3.

[80] Mial E Warren. “Automotive LIDAR Technology”. In: Symposium on VLSI Circuits. 2019, pp. C254–C255. doi: 10 . 23919 / VLSIC . 2019 . 8777993.

[81] Jacek Wojtanowski et al. “Comparison of 905 nm and 1550 nm semiconductor laser rangefinders’ performance deterioration due to adverse environmental conditions”. In: Opto-Electronics Review 22.3 (2014), pp. 183–190.

[82] Isaac I Kim, Bruce McArthur, and Eric J Korevaar. “Comparison of laser beam propagation at 785 nm and 1550 nm in fog and haze for optical wireless communications”. In: Optical Wireless Communications III. Vol. 4214. International Society for Optics and Photonics. 2001, pp. 26–37.

[83] Velodyne. A Guide to Lidar Wavelengths for Autonomous Vehicles and Driver Assistance. [Last accessed 06 June. 2021]. url: https : / / velodynelidar . com / blog / guide - to - lidar - wavelengths/.

[84] Kent F Palmer and Dudley Williams. “Optical properties of water in the near infrared”. In: JOSA 64.8 (1974), pp. 1107–1110.

[85] Aurora. FMCW Lidar: The Self-Driving Game Changer. [Last accessed 14 June 2021]. url: https://aurora.tech/blog/fmcw-lidar-the-self-driving-game-changer.

[86] Aeva. Perception for all devices. [Last accessed 14 June 2021]. url: https://www.aeva.ai/.

[87] Stephen Crouch. Frequency-modulated continuous-wave lidar has all-weather capabilities. [Last accessed 14 June 2021]. url: https : / / www . laserfocusworld . com / lasers - sources / article / 14035383 / frequencymodulated - continuouswave - lidar - has - allweather - capabilities.

[88] Mikko Lehtonen et al. “Supercontinuum generation in a highly birefringent microstructured

fiber”. In: Applied physics letters 82.14 (2003), pp. 2197–2199.

[89] Cibby Pulikkaseril and Stanley Lam. “Laser eyes for driverless cars: the road to automotive LIDAR”. In: Optical Fiber Communication Conference (OFC). Optical Society of America, 2019, Tu3D.2. doi: 10.1364/OFC.2019.Tu3D.2.

[90] Darren Tsai et al. “Optimising the selection of samples for robust lidar camera calibration”. In: arXiv preprint arXiv:2103.12287 (2021).

[91] R.R. Rogers et al. “Looking through the haze: evaluating the CALIPSO level 2 aerosol optical depth using airborne high spectral resolution lidar data”. In: Atmospheric Measurement Techniques 7.12 (2014), pp. 4317–4340.

[92] Anu Swatantran et al. “Rapid, high-resolution forest structure and terrain mapping over large areas using single photon lidar”. In: Scientific reports 6.1 (2016), pp. 1–12.

[93] SONY Semiconductor Solutions Corporation. Sony to Release a Stacked SPAD Depth Sensor for Automotive LiDAR Applications, an Industry First Contributing to the Safety and Security of Future Mobility with Enhanced Detection and Recognition Capabilities for Automotive LiDAR Applications. [Last accessed 21 Oct. 2021]. url: https://www.sony- semicon.co.jp/e/news/2021/2021090601.html.

[94] Joshua Rapp et al. “Advances in single-photon lidar for autonomous vehicles: Working principles, challenges, and recent advances”. In: IEEE Signal Processing Magazine 37.4 (2020), pp. 62–71.

[95] Gregory R Osche and Donald S Young. “Imaging laser radar in the near and far infrared”. In: Proceedings of the IEEE 84.2 (1996), pp. 103–125.

[96] International Telecommunication Union. Recommendation ITU-R P.838-3 Specific attenuation model for rain for use in prediction methods. [Last accessed 14 June 2021]. url: https://www.itu.int/dms_pubrec/itu-r/rec/p/R-REC-P.838-3-200503-I!!PDF-E.pdf.

[97] Rogers Olsen, D V Rogers, and D Hodge. “The aR b relation in the calculation of rain attenuation”. In: IEEE Transactions on antennas and propagation 26.2 (1978), pp. 318–329.

[98] Muhammad Ijaz et al. “Analysis of fog and smoke attenuation in a free space optical communication link under controlled laboratory conditions”. In: 2012 International Workshop on Optical Wireless Communications (IWOW). IEEE. 2012, pp. 1–3.

[99] Ismail Gultepe. “Measurements of light rain, drizzle and heavy fog”. In: Precipitation: advances in measurement, estimation and prediction. Springer, 2008, pp. 59–82.

[100] Vishal Sharma and Sergey Sergeyev. “Range detection assessment of photonic radar under adverse weather perceptions”. In: Optics Communications 472 (2020), p. 125891. issn: 0030-4018. doi: https : / / doi . org / 10 . 1016 / j . optcom . 2020.125891.

[101] Fatemeh Norouzian et al. “Experimental study on low-THz automotive radar signal attenuation during snowfall”. In: IET Radar, Sonar & Navigation 13.9 (2019), pp. 1421–1427.

[102] Roy M Rasmussen et al. “The estimation of snowfall rate using visibility”. In: Journal of Applied Meteorology 38.10 (1999), pp. 1542–1563.

[103] Tokihiko Akita and Seiichi Mita. “Object Tracking and Classification Using Millimeter-Wave Radar Based on LSTM”. In: 2019 IEEE Intelligent Transportation Systems Conference (ITSC). IEEE. 2019, pp. 1110–1115.

[104] Dan Barnes et al. “The oxford radar robotcar dataset: A radar extension to the oxford robotcar dataset”. In: 2020 IEEE International Conference on Robotics and Automation (ICRA). IEEE. 2020, pp. 6433–6438.

[105] Navtech Radar. ClearWay Software and Sensors CTS350-X & CTS175-X Technical Specifications. [Last accessed 22 Oct. 2021]. url: https : / /navtechradar . com / clearway - technical -specifications/.

[106] Ziyang Hong, Yvan Petillot, and Sen Wang. “Radarslam: Radar based large-scale slam in all weathers”. In: 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). IEEE. 2020, pp. 5164–5170.

[107] Raffi Mardirosian. Lidar vs. camera: driving in the rain. [Last accessed 15 May 2021]. url: https : //ouster.com/zh-cn/blog/lidar-vs-camera-comparison-in-the-rain/.

[108] Fabio Reway, Werner Huber, and Eduardo Parente Ribeiro. “Test methodology for vision-based adas algorithms with an automotive camera-in-the-loop”. In: 2018 IEEE International Conference on Vehicular Electronics and Safety (ICVES). IEEE. 2018, pp. 1–7.

[109] Keith Naughton. Self-driving cars succumb to snow blindness as driving lanes disappear. [Last accessed 15 May 2021]. url: https : / / www . autonews . com / article / 20160210 / OEM06 / 160219995 / self - driving - cars - succumb -to - snow - blindness - as - driving - lanes -disappear.

[110] Peter Radecki, Mark Campbell, and Kevin Matzen. “All weather perception: Joint data association, tracking, and classification for autonomous ground vehicles”. In: arXiv preprint arXiv:1605.02196 (2016).

[111] Nicholas Paul and ChanJin Chung. “Application of HDR algorithms to solve direct sunlight problems when autonomous vehicles using machine vision systems are driving into sun”. In: Computers in Industry 98 (2018), pp. 192–196.

[112] FLIR. Your Perfect Palette. [Last accessed 21 Oct. 2021]. url: https://www.flir.com/discover/ots/outdoor/your-perfect-palette/.

[113] Shaopeng Ma, Shichao Zhou, and Qinwei Ma. “Image distortion of working digital camera induced by environmental temperature and camera selfheating”. In: Optics and Lasers in Engineering 115 (2019), pp. 67–73.

[114] Martin Melcher, Christopher D. Jones, and James R. Wilson. “Systems for Detecting Cracks in Windows”. U.S. Patent 20200363362. Nov. 2020.

[115] Manuel Trierweiler, Tobias Peterseim, and Cornelius Neumann. “Automotive LiDAR pollution detection system based on total internal reflection techniques”. In: Light-Emitting Devices, Materials, and Applications XXIV. Vol. 11302. International Society for Optics and Photonics. 2020, p. 1130216.

[116] Manuel Trierweiler et al. “Influence of sensor blockage on automotive LiDAR systems”. In: 2019 IEEE SENSORS. 2019, pp. 1–4. doi: 10 . 1109 / SENSORS43011.2019.8956792.

[117] Jaycil Z Varghese, Randy G Boone, et al. “Overview of autonomous vehicle sensors and systems”. In: International Conference on Operations Excellence and Service Engineering. 2015, pp. 178–191.

[118] Aleksandr Bystrov et al. “Road surface classification using automotive ultrasonic sensor”. In: Procedia Engineering 168 (2016), pp. 19–22.

[119] Stefanie Walz et al. “A Benchmark for Spray from Nearby Cutting Vehicles”. In: International Intelligent Transportation Systems Conference (ITSC). IEEE. 2021, pp. 188–195.

[120] Jose Roberto Vargas Rivero et al. “Data Augmentation of Automotive LIDAR Point Clouds under Adverse Weather Situations”. In: Sensors 21.13 (2021), p. 4503. doi: 10.3390/s21134503.

[121] Cyrille Gernot. “GPS signal disturbances by water in various states”. In: International Technical Meeting of the Satellite Division of The Institute of Navigation (ION GNSS). ION. 2007, pp. 2187–2195.

[122] Rajeswari Balasubramaniam and Christopher Ruf. “Characterization of rain impact on L-Band GNSS-R ocean surface measurements”. In: Remote Sensing of Environment 239 (2020), p. 111607. issn: 0034-4257. doi: https : / / doi . org / 10 . 1016/j.rse.2019.111607.

[123] Bin Yang et al. “Radarnet: Exploiting radar for robust perception of dynamic objects”. In: European Conference on Computer Vision. Springer. 2020, pp. 496–512.

[124] Ze Liu et al. “Robust target recognition and tracking of self-driving cars with radar and camera information fusion under severe weather conditions”. In: IEEE Transactions on Intelligent Transportation Systems (2021).

[125] FLIR. Fused AEB with thermal can save lives. [Last accessed 22 Oct. 2021]. url: https : / /www.flir.com/globalassets/industrial/oem/adas / flir - thermal - aeb - white - paper —final-v1.pdf.

[126] Nick Spooren et al. “RGB-NIR active gated imaging”. In: Electro-Optical and Infrared Systems: Technology and Applications XIII. Vol. 9987. International Society for Optics and Photonics. 2016, p. 998704.

[127] Vijay John et al. “Deep Visible and Thermal Camera-Based Optimal Semantic Segmentation Using Semantic Forecasting”. In: Journal of Autonomous Vehicles and Systems 1.2 (2021), p. 021006.

[128] Matti Kutila et al. “Automotive LIDAR sensor development scenarios for harsh weather conditions”. In: 2016 IEEE 19th International Conference on Intelligent Transportation Systems (ITSC). IEEE. 2016, pp. 265–270.

[129] Mario Bijelic et al. “Seeing through fog without seeing fog: Deep multimodal sensor fusion in unseen adverse weather”. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020, pp. 11682–11692.

[130] Mario Bijelic, Tobias Gruber, and Werner Ritter. “Benchmarking image sensors under adverse weather conditions for autonomous driving”. In: 2018 IEEE Intelligent Vehicles Symposium (IV). IEEE. 2018, pp. 1773–1779.

[131] Keith Naughton. Self-driving cars succumb to snow blindness as driving lanes disappear. [Last accessed 22 May 2021]. url: https : / / www . autonews . com / article / 20160210 / OEM06 / 160219995 / self - driving - cars - succumb - to - snow - blindness - as - driving - lanes - disappear.

[132] Graham Doorley, Paul Thomas Hansen Karplus, and Peter Avram. “Passive wiper system”. U.S. Patent US9731688B2. Aug. 2017.