小羊驼(Vicuna)是什么

Vicuna: 一个开源的GPT,宣称实现了GPT-4 90%的功能。

UC伯克利学者联手CMU、斯坦福等,再次推出一个全新模型70亿/130亿参数的Vicuna,俗称「小羊驼」(骆马)。

并且和其他以往不同的是你可以在自己的设备上跑起来!比如Mac,再比如你的主力机!

官网在这:https://vicuna.lmsys.org

体验点这个(如果打不开就用魔法):https://chat.lmsys.org

一.环境准备

- ubuntu 20.04 (自带python3,且版本满足要求)

- 硬盘大约200G左右(100G也不是不能用,最好是200G,50G肯定是不行)

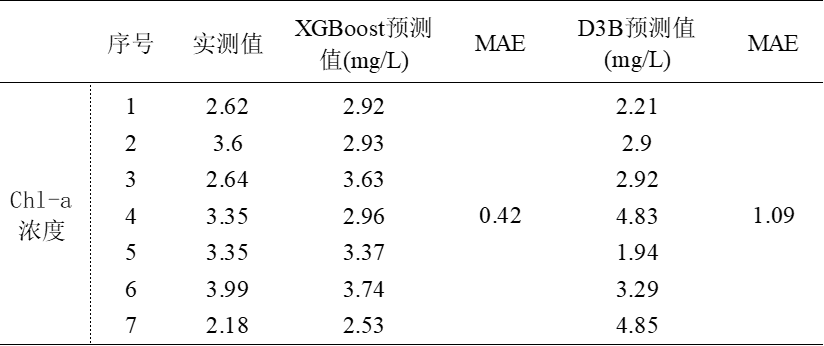

- 内存(计划用vicuna-7b的30G,vicuna-13b的60G,选哪个大家自己按需,满分100的话7b大概是40分,13b的话大概70分)

- 显卡(越贵越好,风浪越贵鱼越大)

以我自己的环境为例:

1.E5-2697-V2,64G内存,没有用显卡,能跑但是速度十分难受。

2.Macbook Pro M1 pro版本16+512,7b的能跑,效果还行。

二.开始操作

1.LLaMa模型下载与转换

1.1 模型下载

磁力链接:magnet:?xt=urn:btih:b8287ebfa04f879b048d4d4404108cf3e8014352&dn=LLaMA

大家自行按需下载

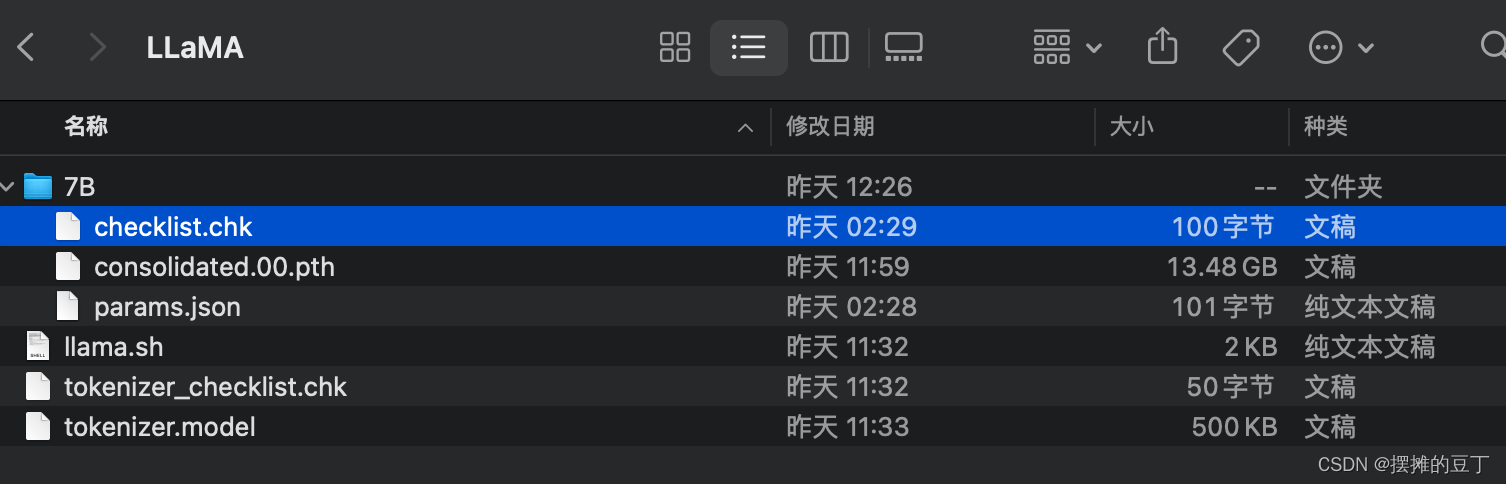

以7b为例下载之后的模型长这样

这里我下载的路径是/home/douding/LLaMA

1.2 模型转换

$ git clone https://github.com/huggingface/transformers.git

$ cd transformers

7B参考下面的

$ python3 src/transformers/models/llama/convert_llama_weights_to_hf.py \--input_dir /home/douding/LLaMA --model_size 7B --output_dir ./output/llama-7b13B看这个$ python3 src/transformers/models/llama/convert_llama_weights_to_hf.py \--input_dir /home/douding/LLaMA --model_size 13B --output_dir ./output/llama-13b

转换完成后会在/home/douding/transformers/output中看到你的模型

2.小羊驼模型合并与生成

$ pip3 install fschat

$ pip3 install git+https://github.com/huggingface/transformers

7b参考如下

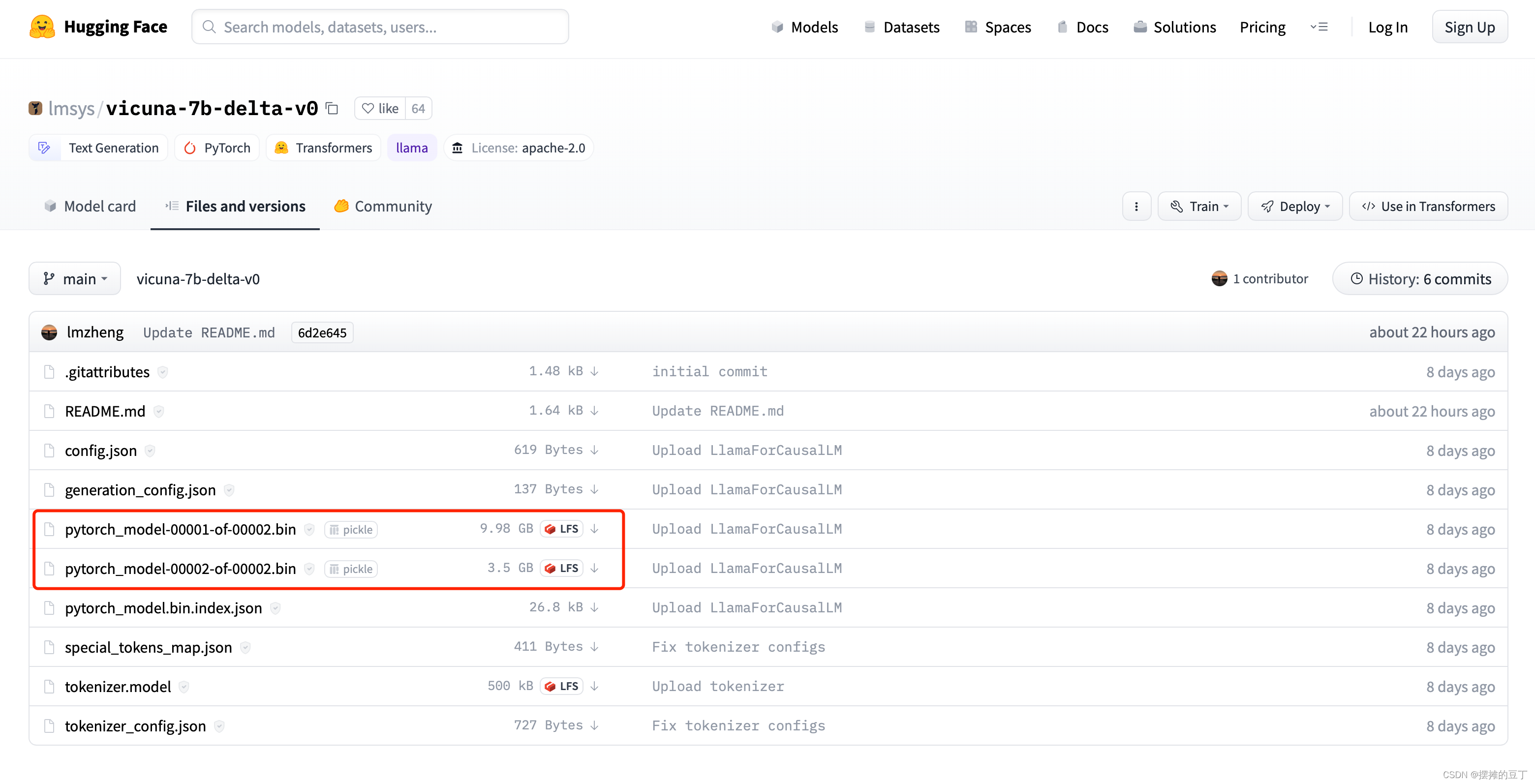

$ git clone https://huggingface.co/lmsys/vicuna-7b-delta-v0注意这里需要手动下载大文件到/home/douding/lmsys/vicuna-7b-delta-v0中

$ python3 -m fastchat.model.apply_delta \--base /home/douding/transformers/output/llama-7b \--target /home/douding/vicuna-7b \--delta /home/douding/lmsys/vicuna-7b-delta-v0

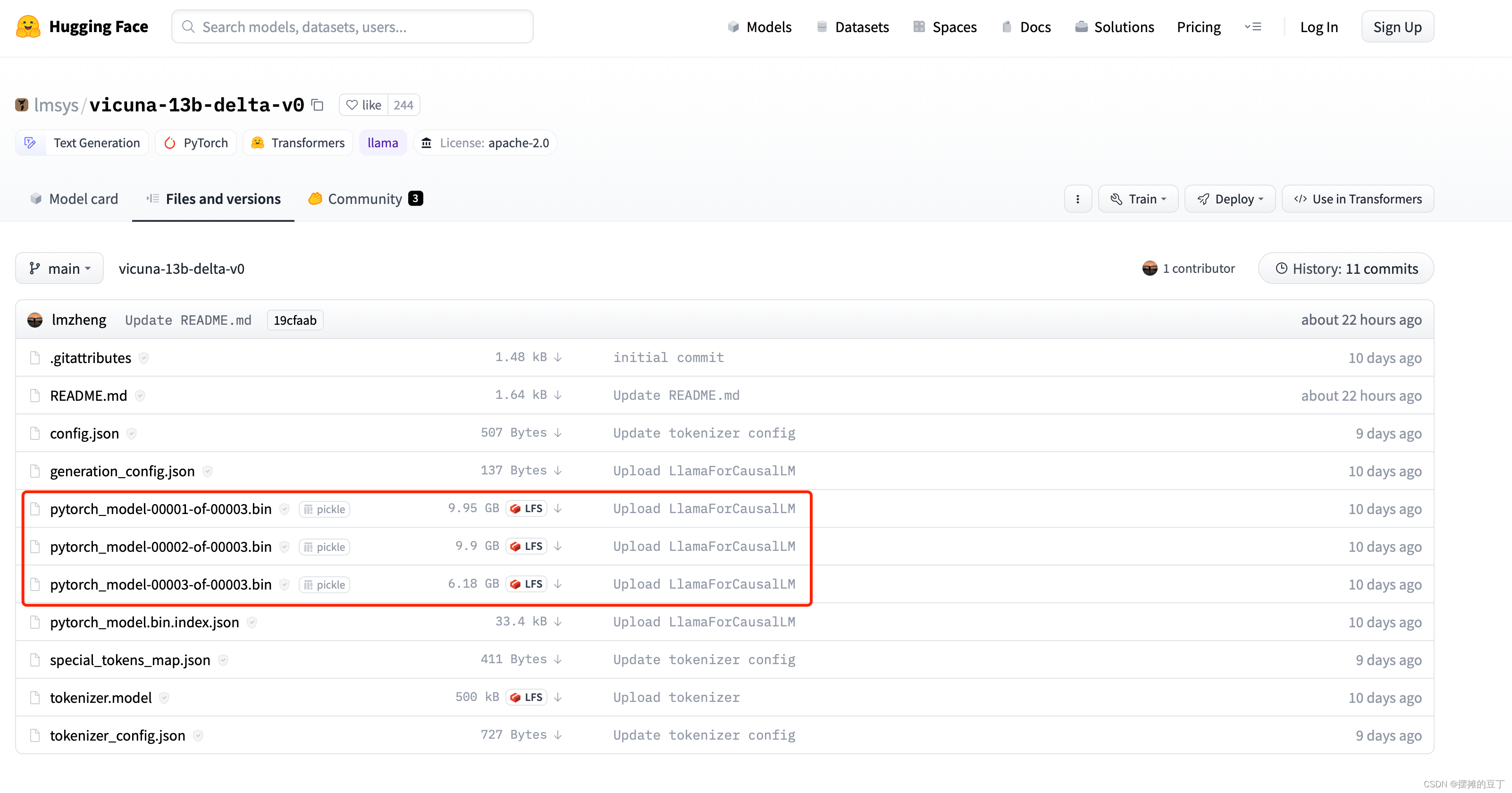

13b参考如下$git clone https://huggingface.co/lmsys/vicuna-13b-delta-v0 /home/douding/lmsys/vicuna-13b-delta-v0

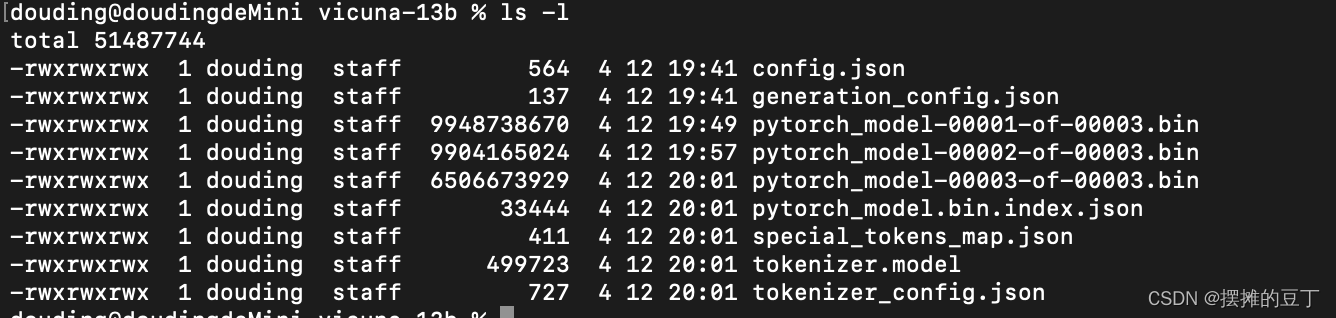

注意这里需要手动下载大文件到/home/douding/lmsys/vicuna-13b-delta-v0中

$ python3 -m fastchat.model.apply_delta \--base /home/douding/transformers/output/llama-13b \--target /home/douding/vicuna-13b \--delta /home/douding/lmsys/vicuna-13b-delta-v0

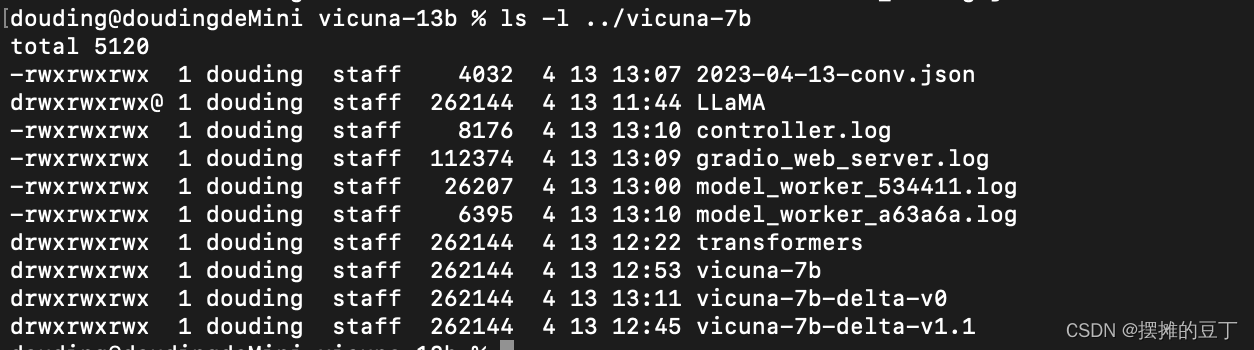

成功后会对应的目录/home/douding/vicuna-7b和/home/douding/vicuna-13b中看到对应的小羊驼模型

我这里提供已经做好了的小羊驼模型(含7b和13b):

链接: https://pan.baidu.com/s/1t2He47-qDCYYJ38pak_beQ?pwd=w9nw 提取码: w9nw

3.运行

CPU纯享版

python3 -m fastchat.serve.cli --model-path /path/to/vicuna/weights --device cpu

GPU畅爽版

python3 -m fastchat.serve.cli --model-path /home/douding/vicuna-7b

Mac勉强享受版

python3 -m fastchat.serve.cli --model-path /home/douding/vicuna-7b --device mps --load-8bit

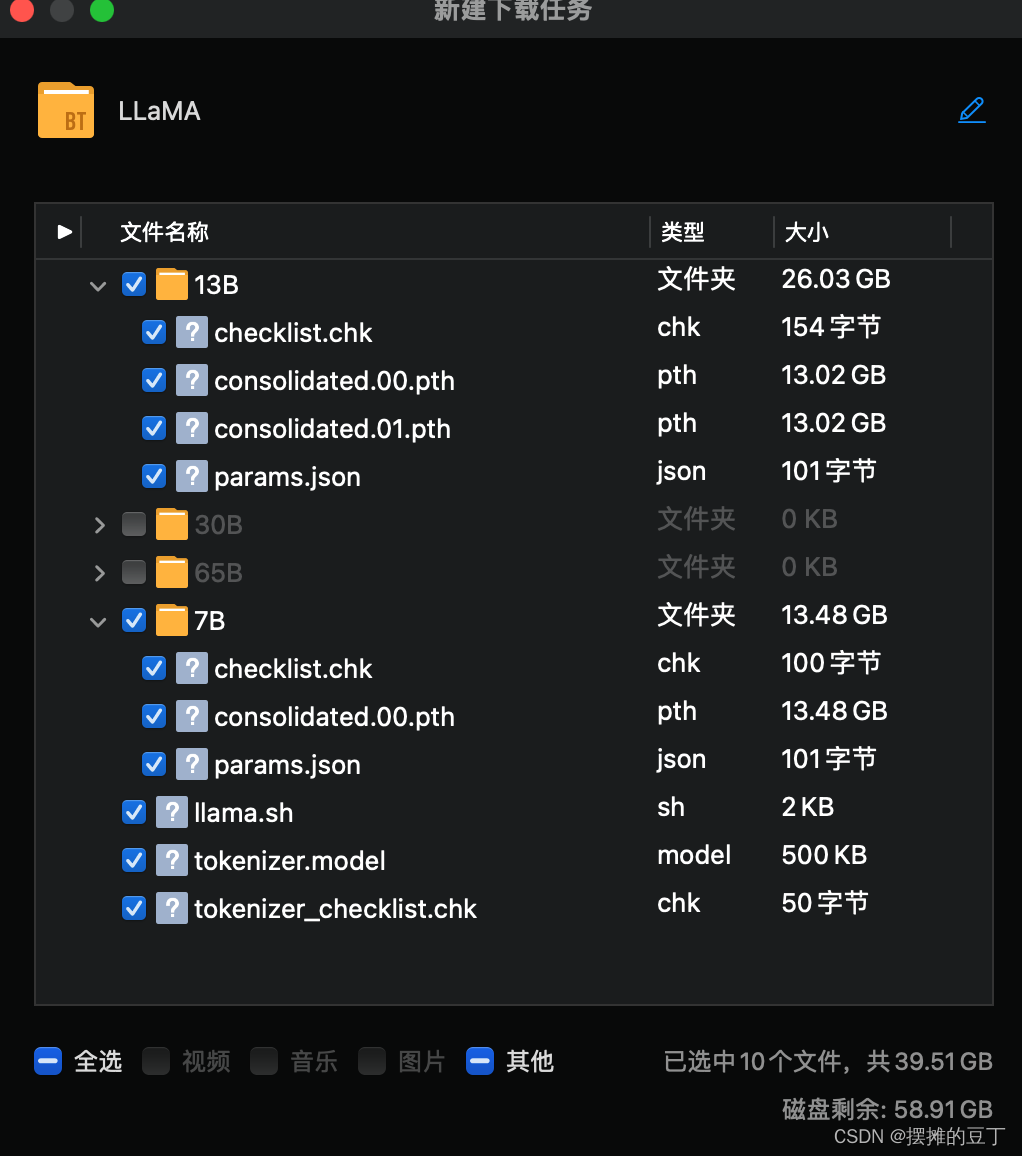

贴一张运行成功的截图,虽然满慢,但……充钱就可以变强!