2021年10月,中共中央、国务院发布的《国家标准化发展纲要》明确提出构建多层次从业人员培养培训体系,开展专业人才培养培训和国家质量基础设施综合教育。建立健全人才的职业能力评价和激励机制。由中国标准化协会(CAS)组织开展的项目管理专业人员能力评价等级证书(CSPM)应运而生。

一、国标项目管理(项目管理专业人员能力评级)证书是什么?

《项目管理专业人员能力评价要求》(GB/T 41831-2022)是2022年10月12日开始实施的一项中国国家标准,归口于全国项目管理标准化技术委员会。

《项目管理专业人员能力评价要求》(GB/T 41831-2022)规定了项目管理专业人员的项目管理专业能力的组成及其级别的指导性内容。该标准适用于企业事业单位、机关和社团的任何类型组织内从事项目管理及相关辅导工作的人员能力评价、维度、能力划分的五个等级、每个能力等级所对应的核心能力要求、能力评价的方法、能力评价结果及应用。

《项目管理专业人员能力评价要求》(GB/T 41831-2022)适用于企事业单位、机关、社团等各类组织和各行业对其从事项目管理工作的人员进行项目管理专业能力的分级评价,也可作为各省市区县开展项目管理专业人才引进、培养、职称评定和任用等工作的依据。

二、国标项目管理(项目管理专业人员能力评级)证书有几级?

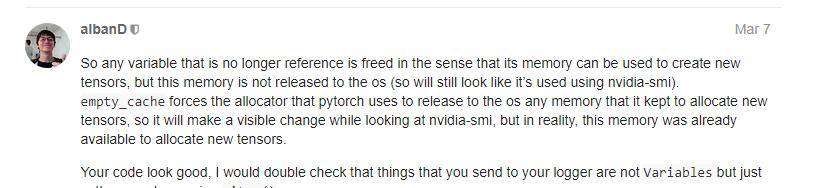

项目管理专业人员能力评价,包括从事项目和项目群组管理的人员以及从事项目管理办公室(PMO)工作的人员,从低到高分为五个等级,分别为:

三、我是怎么对标增持的CSPM-2证书

1、看看自己的PMP证书有没有过期,没有过期是最好的,如果还在续费缓冲期那就去续费

2、然后找到授权机构提交材料

3、坐等证书到手,大概2周左右吧

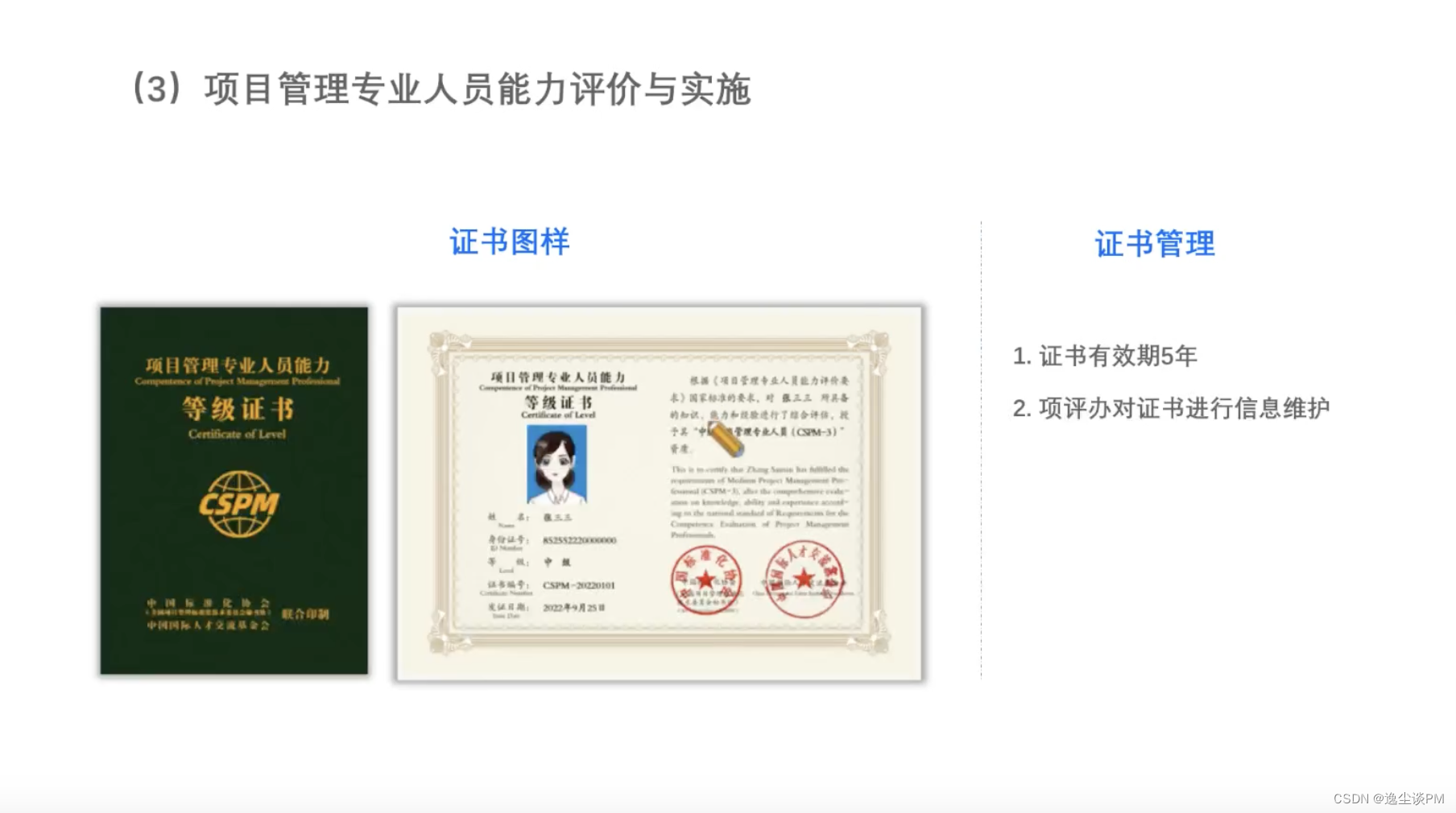

4、证书有效期是五年,目前知道的是到期后只需付个工本费即可续费

5、证书是由项目管理专业人员能力评价工作办公室建立和维护项目管理专业人员信息系统,为社会和用人单位提供查询取得项目管理专业人员能力等级评价证书人员的信息服务。

证书到手真香!!!

具体怎么操作看评论区