Transformer - 编码器和解码器中的QKV分别来自哪

flyfish

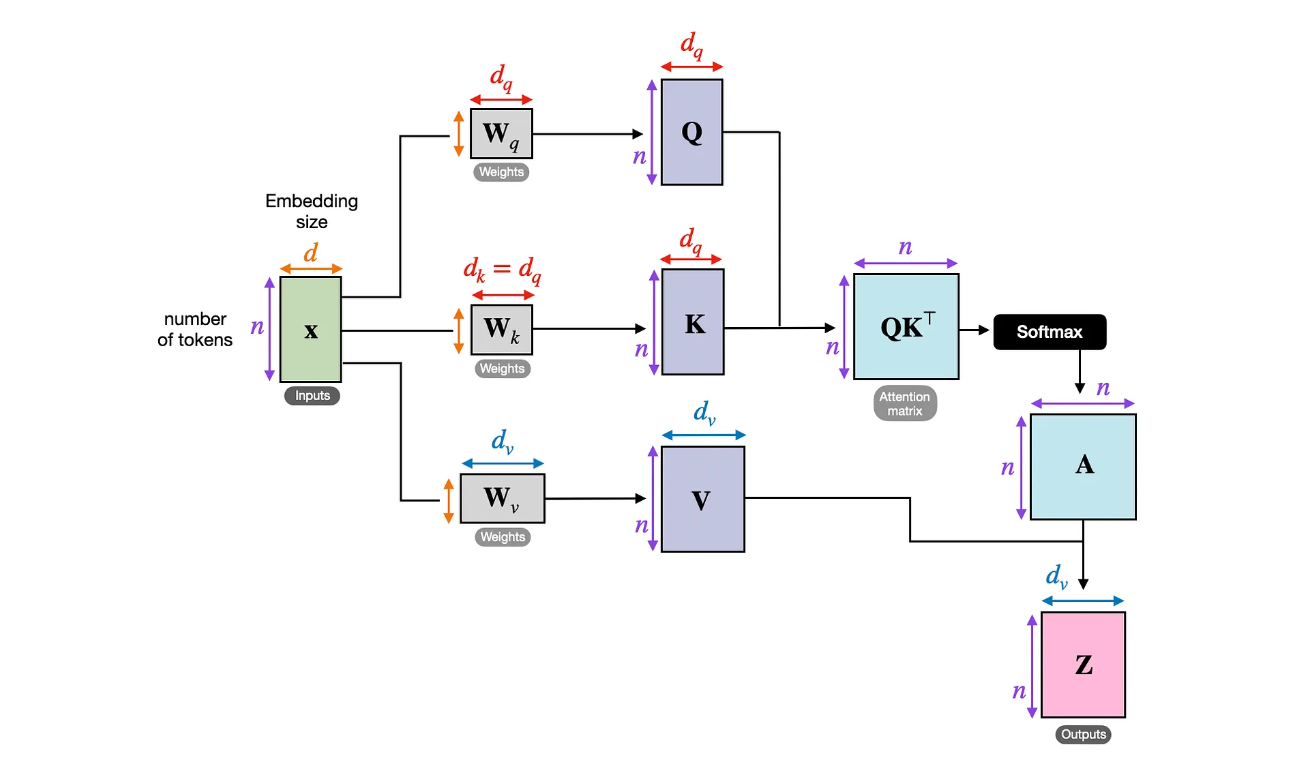

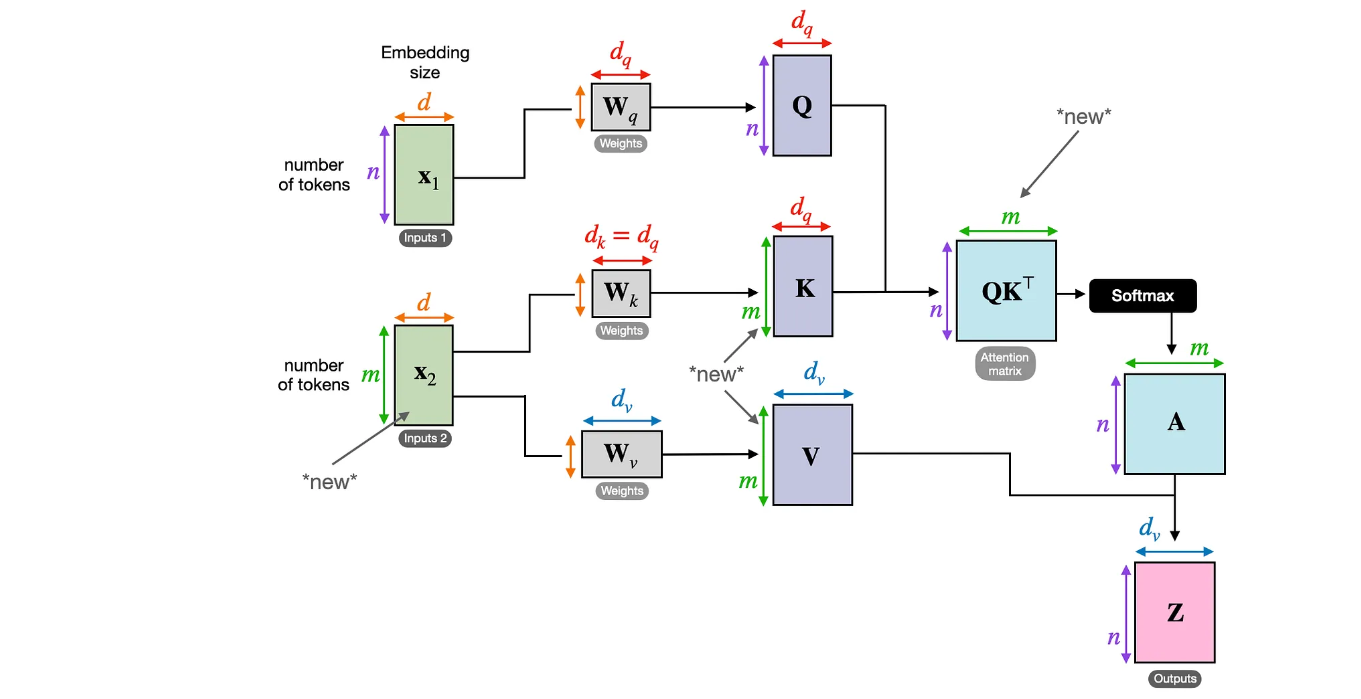

Transformer - 注意⼒机制 Scaled Dot-Product Attention 计算过程

Transformer - 注意⼒机制 代码实现

Transformer - 注意⼒机制 Scaled Dot-Product Attention不同的代码比较

Transformer - 注意⼒机制 代码解释

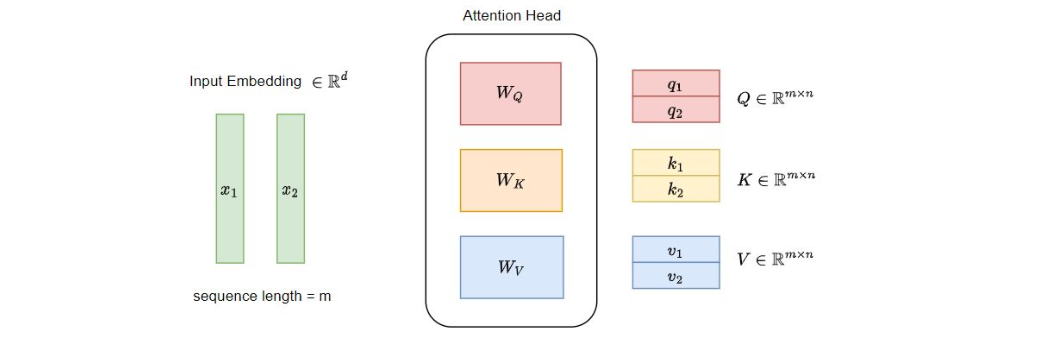

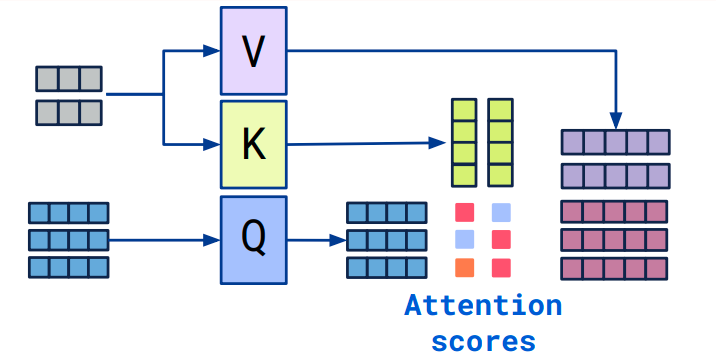

Transformer - 注意⼒机制 Attention 中的 Q, K, V 解释(1)

Transformer - 注意⼒机制 Attention 中的 Q, K, V 解释(2)

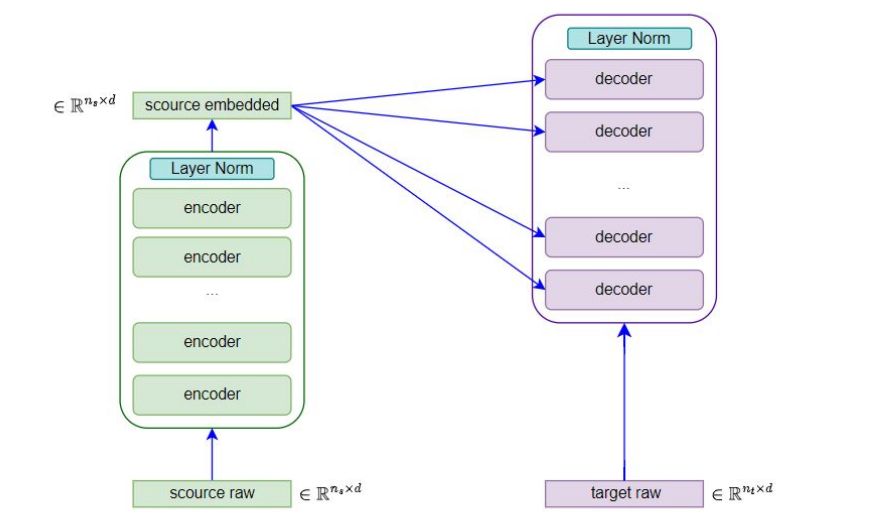

在编码器的self-attention中,QKV是从 source embedding来的

在解码器的self-attention中,QKV是从 target embedding来的

self-attention画的详细一些

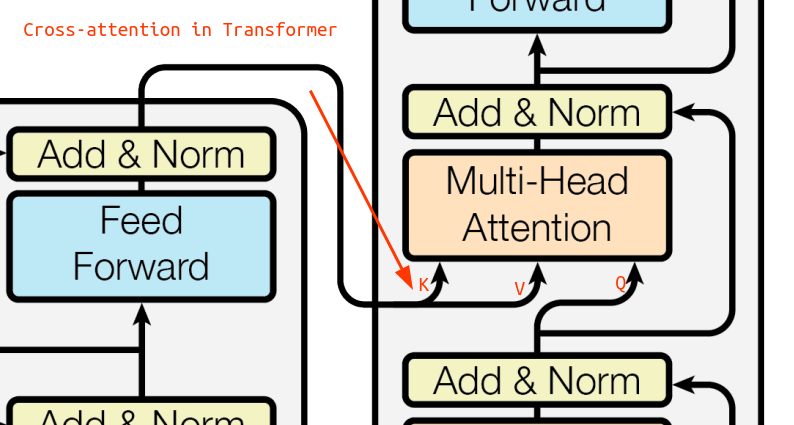

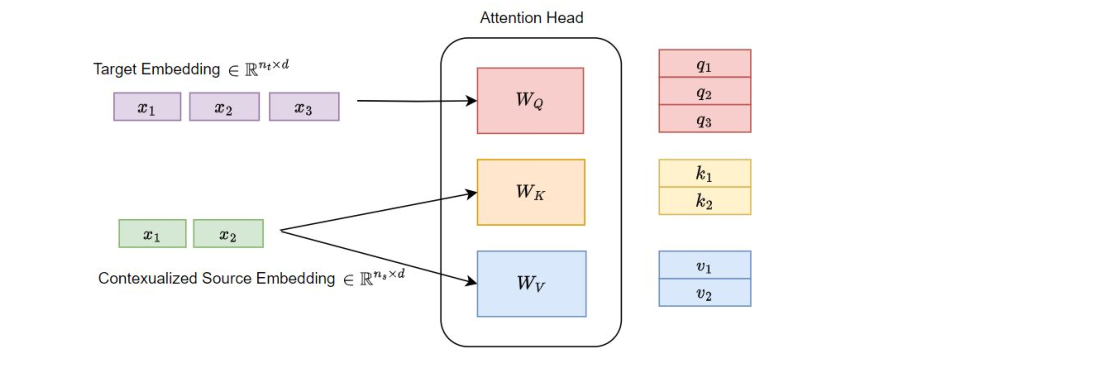

在encoder-decoder-attention中

Q 是从target embedding来的

K和V 是从 contextualized source embedding来的

encoder-decoder-attention画的详细一些

例如解码器的encoder-decoder-attention中的 K和V则来自编码器

重复说

解码器内部自注意力的QKV均源自解码器自身,而编码器-解码器注意力中的Q来自解码器,K和V则来自编码器

“编码器-解码器注意力”和“交叉注意力”是同一种注意力机制的不同称呼

其他名字

Encoder-decoder attention, also known as inter-attention or cross attention。