人类对大脑结构的了解是通过长时间的科学研究和多种技术的应用逐渐积累起来的。下面是一些关键的方法和里程碑:

-

解剖学研究:最早的大脑研究来自于解剖学,通过解剖死亡后的大脑,科学家们能够观察到大脑的物理结构。这些早期研究帮助建立了大脑各部分的基本地图。

-

显微镜技术:随着显微镜技术的发展,科学家开始观察大脑的更细微结构,包括神经元和它们之间的连接。十九世纪末,卡哈尔(Santiago Ramón y Cajal)等神经科学家通过染色技术在显微镜下观察神经元,发现了神经网络的基本结构。

-

电生理技术:电生理学的方法,如脑电图(EEG)和神经元电位测量,使科学家能够直接测量和记录大脑活动和神经元之间的电信号。

-

影像技术:近代,脑部影像技术的发展,如计算机断层扫描(CT)、磁共振成像(MRI)和正电子发射断层扫描(PET),使得科学家可以在活体状态下观察和研究大脑结构和功能。

-

计算神经科学和建模:随着计算机技术的发展,科学家开始使用计算模型来模拟大脑的工作机制,这有助于理解神经网络是如何处理信息和进行学习的。

-

遗传学和分子生物学:对大脑发育和功能的遗传和分子层面的研究也提供了重要信息。比如,通过研究特定基因突变对大脑功能的影响,科学家能够更好地理解大脑的工作原理。

通过这些方法,科学家们逐步揭示了大脑的结构,理解了神经元如何工作,以及它们是如何通过复杂的网络连接来处理信息和控制行为的。这就像是逐步解开一个极其复杂的谜题,每一项技术和方法都像是一把打开这个谜题的钥匙。

神经网络的基本原理是通过独立的神经元及其相互连接来传递和处理信息。这一过程涉及到神经信号的生成、传递和整合。以下是这个过程的关键步骤和原理:

-

信号的产生:每个神经元可以接收来自其他神经元的信号。这些信号通常是化学物质(神经递质)的形式,它们在突触间隙中被释放,然后与接收神经元的树突上的受体结合。

-

兴奋和抑制:神经递质与受体结合后,可以使接收神经元产生兴奋性或抑制性的反应。兴奋性递质(如谷氨酸)使神经元更容易发放电信号,而抑制性递质(如GABA)则使其更难发放电信号。

-

电信号的传递:当一个神经元的树突接收到足够多的兴奋性信号时,这个神经元将产生一个电信号,称为动作电位。动作电位沿着神经元的轴突传播,直至到达轴突末端。

-

信息的传递:到达轴突末端的动作电位会导致神经递质的释放。神经递质随后穿过突触间隙,与下一个神经元的树突或细胞体上的受体结合,从而将信号传递给下一个神经元。

-

信息的整合:每个神经元都可以同时从多个神经元接收信号。神经元内部会对这些不同的信号进行整合,根据信号的强度和类型来决定是否产生动作电位。

-

学习和记忆:神经网络通过改变神经元之间的连接强度来学习和存储信息,这一过程称为突触可塑性。长期增强(LTP)和长期抑制(LTD)是突触可塑性的两种形式,它们分别对应于连接的加强和减弱。

-

网络的复杂性:大脑中的神经网络非常复杂,每个神经元可能与数千个其他神经元相连,形成一个高度复杂且动态的网络。这个网络能够处理大量的信息,并支持各种复杂的认知功能,如感知、思考、记忆和情感。

总的来说,神经网络通过这些复杂的电化学过程来传递和处理信息,形成了大脑功能的基础。

神经科学家通过染色技术在显微镜下观察神经元,并发现了神经网络的基本结构,这个过程是19世纪末神经科学的一个重要突破。其中最著名的贡献者是西班牙神经解剖学家圣地亚哥·拉蒙-卡哈尔(Santiago Ramón y Cajal)。

-

染色技术的发展:在拉蒙-卡哈尔之前,意大利科学家卡米洛·高尔吉(Camillo Golgi)发展了一种叫做“黑反应”(Golgi stain)的染色方法。这种方法通过使用铬酸钾和硝酸银的混合物来染色大脑组织,能够随机突显个别神经元的整个结构,包括细胞体和细胞突起。

-

显微镜下的观察:使用这种染色方法,神经科学家能在显微镜下观察到单个神经元的详细结构。拉蒙-卡哈尔是利用这种技术的大师,他对不同动物大脑的详细观察帮助他绘制出神经元的精细结构图。

-

神经元学说的形成:基于这些观察,拉蒙-卡哈尔提出了“神经元学说”,这是对之前的“网状理论”(认为神经系统是一个连续的网络)的重要反驳。他的研究显示,神经系统是由独立的神经元组成的,这些神经元通过特殊的结构(后来被称为突触)相互连接。

-

突触的发现:虽然拉蒙-卡哈尔本人并未直接观察到突触(因为它们在显微镜下太小,无法直接看到),但他基于神经元之间的空隙推测出了它们的存在。这个假设后来被电子显微镜的发明和其他实验方法所证实。

-

神经网络的理解:拉蒙-卡哈尔的工作揭示了神经网络的基本原理,即如何通过独立的神经元和它们之间的连接来传递和处理信息。这对后来的神经科学,尤其是对理解大脑如何工作产生了深远的影响。

总的来说,这一过程是一次神经科学的重大革命,它将大脑研究从宏观结构转向微观结构,为后来的神经科学研究奠定了坚实的基础。

神经网络的基本结构是由神经元和它们之间的连接组成的复杂网络。这里是其主要组成部分和功能:

-

神经元(Neuron):神经网络的基本单位。每个神经元包括三个主要部分:

- 细胞体(Soma):包含细胞核和其他为细胞提供能量和维持功能的器官。

- 树突(Dendrites):从细胞体延伸出的短而多分支的结构,负责接收来自其他神经元的信号。

- 轴突(Axon):从细胞体延伸出的长结构,用于传输信号到其他神经元或肌肉细胞。轴突末端分叉并形成与其他神经元的树突或细胞体相连的突触。

-

突触(Synapse):神经元之间的连接点。在突触,信息以化学物质(神经递质)的形式从一个神经元传递到另一个神经元。这个过程包括:

- 突触前膜(Presynaptic Membrane):信号发出神经元的轴突末端。

- 突触后膜(Postsynaptic Membrane):信号接收神经元的树突或细胞体。

- 突触间隙(Synaptic Cleft):突触前膜和突触后膜之间的小空间,神经递质在此被释放。

-

神经递质(Neurotransmitters):在突触间隙中传递信号的化学物质。不同的神经递质有不同的作用,如兴奋或抑制接收神经元的活动。

-

神经网络的组织结构:神经元通过突触相互连接,形成复杂的网络。这些网络可以根据功能和位置在大脑中被分为不同的区域,负责处理不同类型的信息,如感觉输入、运动控制、情感、思维等。

神经网络的这种组织方式使得大脑能够高效地处理复杂的信息,进行学习和记忆,并控制身体的各种功能。每个神经元通过与数千甚至数万个其他神经元的连接,参与到这个极其复杂的信息处理系统中。

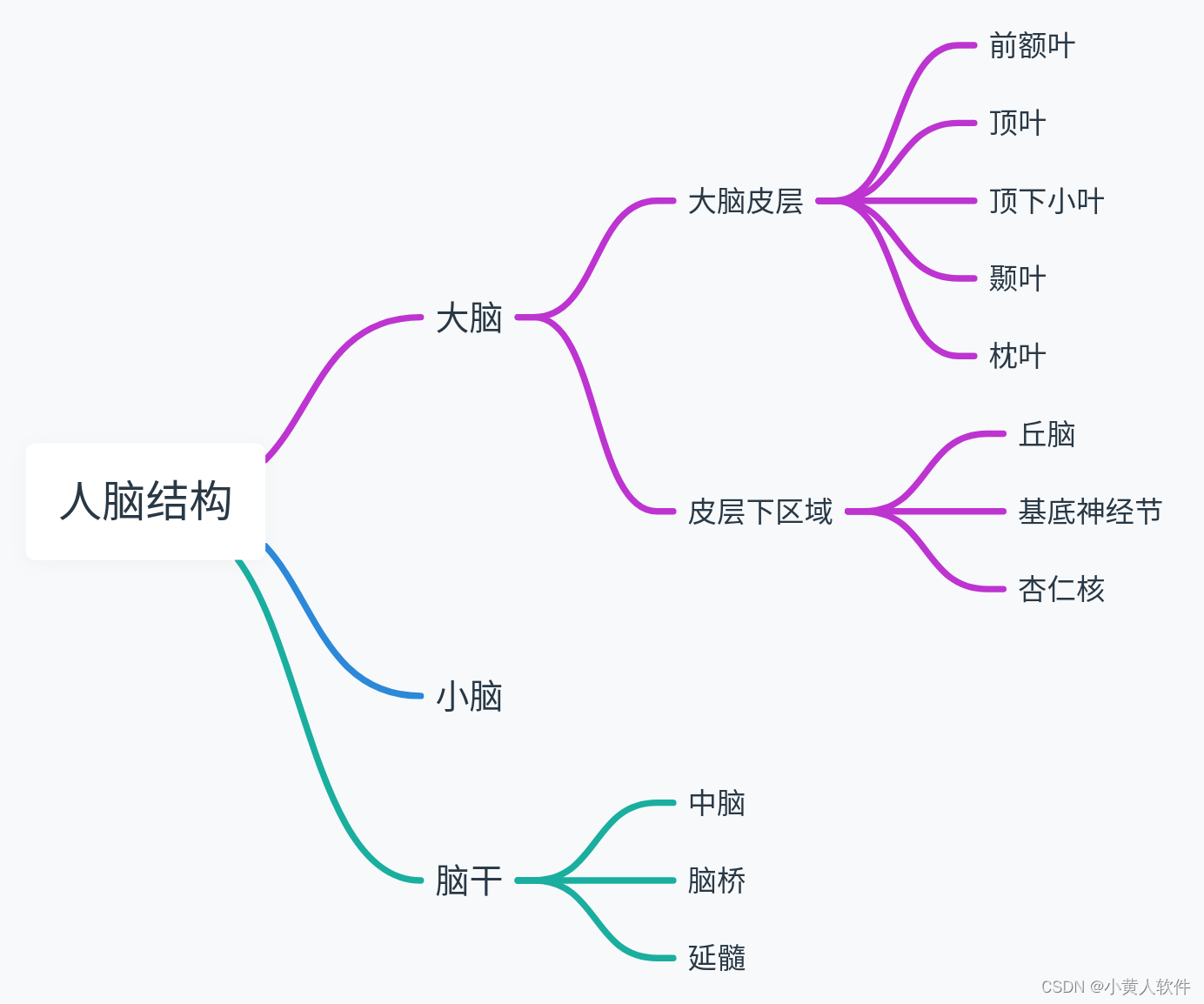

人脑的结构主要区域及其作用:

-

大脑皮层(Cerebral Cortex):这是大脑的外层部分,负责处理复杂的认知功能,如思考、决策、感知和语言。大脑皮层可以分为几个区域,包括前额叶、顶叶、枕叶和颞叶,它们各自负责不同的功能。例如,前额叶与决策和解决问题有关,而枕叶则主要处理视觉信息。

-

边缘系统(Limbic System):这一区域包括海马、杏仁核等部分,主要负责情绪调节、记忆和学习。例如,海马是长期记忆形成的关键区域,而杏仁核则与情绪反应(尤其是恐惧和愉悦)相关。

-

脑干(Brainstem):脑干连接大脑和脊髓,负责调节许多基本生命功能,如心跳、呼吸和睡眠周期。它也是许多神经通路的交汇点。

-

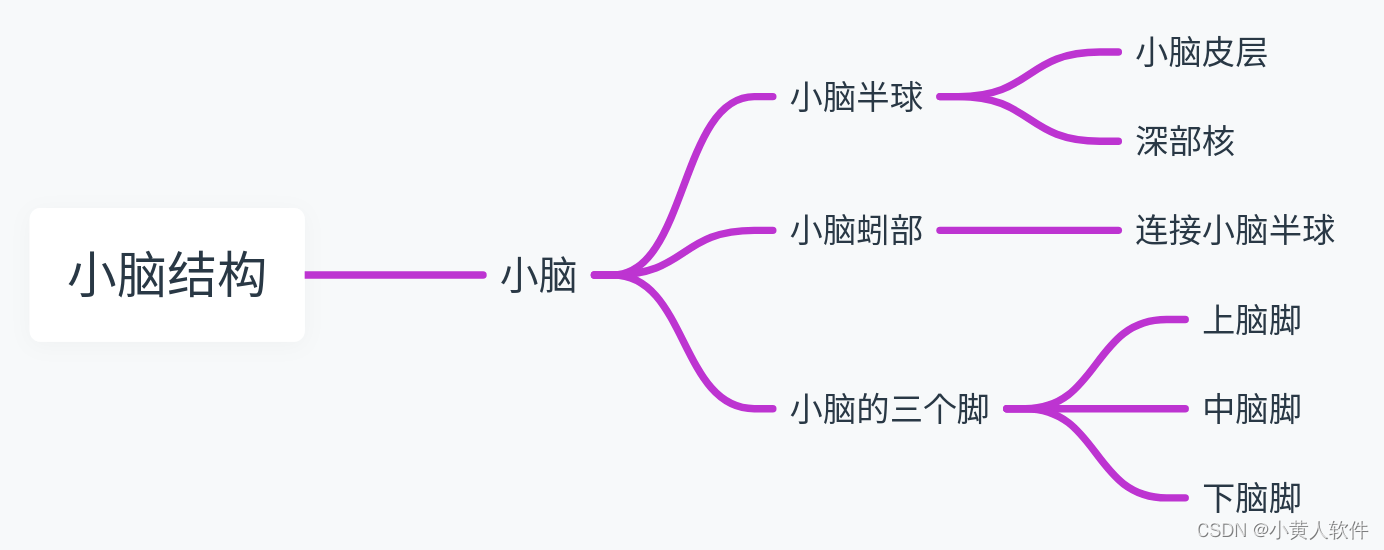

小脑(Cerebellum):小脑位于大脑的后部和下部,主要负责协调运动和平衡。例如,当你骑自行车或写字时,小脑帮助你保持动作的流畅和精准。

-

间脑(Thalamus and Hypothalamus):间脑是一组位于大脑中心的结构,包括丘脑和下丘脑。丘脑主要作为感觉信息(除嗅觉外)的中继站,下丘脑则调节多种内分泌功能,包括温度调节、饥饿和口渴感等。

每个部分都像是一个专门的“工作站”,处理特定类型的信息或执行特定的功能。比如,就像一家公司里不同的部门,每个部门都有自己的工作职责,但所有部门共同协作,确保整个公司运行顺畅。

用python写一个模仿人脑结构的示例

import numpy as np# 定义一个简单的神经网络类

class SimpleNeuralNetwork:def __init__(self, input_size, hidden_size, output_size):# 初始化权重和偏置self.weights_input_hidden = np.random.randn(input_size, hidden_size)self.weights_hidden_output = np.random.randn(hidden_size, output_size)self.bias_hidden = np.random.randn(hidden_size)self.bias_output = np.random.randn(output_size)def sigmoid(self, x):# Sigmoid 激活函数return 1 / (1 + np.exp(-x))def forward(self, inputs):# 前向传播hidden = self.sigmoid(np.dot(inputs, self.weights_input_hidden) + self.bias_hidden)output = self.sigmoid(np.dot(hidden, self.weights_hidden_output) + self.bias_output)return output# 创建一个简单的神经网络示例

input_size = 2 # 输入层节点数

hidden_size = 3 # 隐藏层节点数

output_size = 1 # 输出层节点数# 创建神经网络实例

network = SimpleNeuralNetwork(input_size, hidden_size, output_size)# 创建一些示例输入

inputs = np.array([0.5, 0.6])# 进行前向传播

output = network.forward(inputs)

output这个简单的Python示例创建了一个基本的神经网络,模仿人脑的结构。这个网络包含输入层、隐藏层和输出层。每一层都有一定数量的节点(神经元),并且相邻层之间的节点通过权重相连。网络还使用了Sigmoid激活函数,它是神经网络中常用的非线性函数,用于模仿神经元的激活方式。

在这个例子中,我创建了一个具有2个输入节点、3个隐藏层节点和1个输出节点的网络。输入是一个简单的数组 [0.5, 0.6],表示两个输入信号。网络执行前向传播,即它接受输入,通过隐藏层(其中应用了权重和偏置,然后应用了激活函数),最后产生输出。

输出值是一个介于0和1之间的数字,这是Sigmoid函数的特性。这个值可以被解释为网络对某个特定输入的响应强度。

请注意,这个网络是随机初始化的,没有经过训练来执行特定任务,因此它的输出没有实际的意义。在实际应用中,神经网络需要通过学习数据集来调整其权重和偏置,以便完成特定任务,如分类、回归或其他复杂任务。