遥感综述小集合

Image fusion meets deep learning: A survey and perspective(张浩,马佳义)

Sharpening fusion

多光谱图像锐化和高光谱图像锐化是两种典型的锐化融合任务。

Multi-spectral sharpening多光谱锐化

多光谱锐化是将低空间分辨率的多光谱图像(LRMS)与全色图像(PAN)融合生成高空间分辨率的多光谱图像(HRMS)。多光谱锐化对信息保真度的要求更高(即光谱、结构)。锐化的深度学习方法主要有CNN和GAN方法,根据学习方式分为有监督模型和无监督模型。具体而言,监督方法遵循Wald协议对原始MS和PAN图像执行空间退化操作,以获得LRMS和LRPAN图像,例如低通滤波、下采样等。然后将生成的LRMS和LRPAN图像作为输入图像,原始MS图像作为参考图像。相反,无监督方法直接在原始MS和PAN图像上训练。

Hyperspectral sharpening高光谱锐化

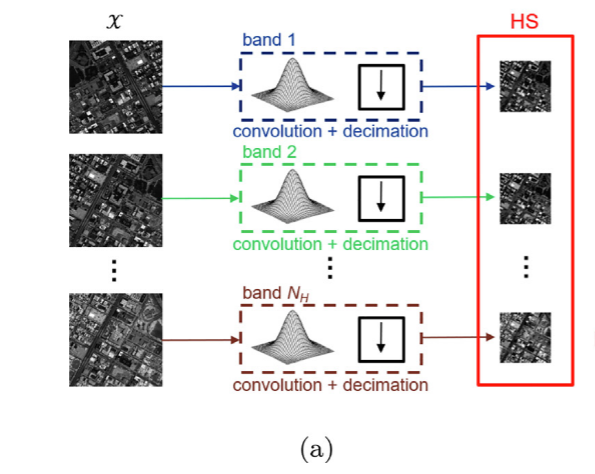

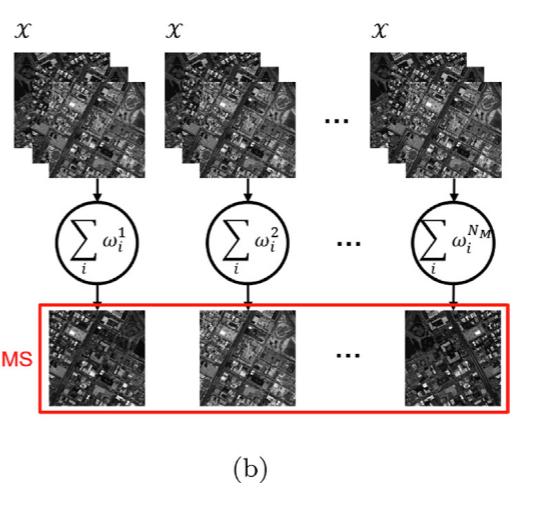

与多光谱图像相比,高光谱图像具有较高的光谱分辨率和较低的空间分辨率。因此,可以通过将低空间分辨率的高光谱图像(LRHS)与多光谱图像或全色图像进行融合来实现高光谱锐化,从而产生高空间分辨率的高光谱图像(HRHS)。用于高光谱锐化的深层模型包括CNN和GAN方法。与多光谱锐化任务类似,高光谱锐化任务中的这些方法也可分为有监督方法和无监督方法。由于HRHS图像不可用,监督CNN方法通常在模拟数据上训练。更具体地说,这些方法直接使用现有的光谱响应函数(SRF)和自定义点扩展函数(PSF)来实现原始HS图像的光谱退化和空间退化。并将原始HS图像构造成图像对,以在监督下学习高光谱锐化。然而,通过仿真中的监督训练获得的这种模型可能不适合真实的场景。在一些无监督CNN方法中,虽然不需要参考图像来监督训练过程,但要求CRF和PSF已知。这些方法通过SRF和PSF建立生成的HRHS图像与观测到的源图像之间的一致性关系,从而实现对HRHS图像的有效估计。不幸的是,SRF和PSF在大多数情况下是不可知的。为了解决这一问题,一些CNN方法联合收割机高光谱解混设计耦合网络来估计SRF和PSF,从而实现无监督的高光谱锐化,表现出良好的性能。与上述方法不同的是,[98]假设HRHS和LRHS图像共享相同的谱子空间,其中CNN仅用于正则化子空间系数的估计,以生成期望的HRHS图像。

Review of pixel-level remote sensing image fusion based on deep learning(王兆斌)

一般来说,融合方法可以分为三个处理水平从低到高:进行像素级、特征级和决策级。其中,进行像素级融合直接处理原始图像的像素点来生成融合图像与高质量。特征级融合从输入图像和提取关键特性进行综合处理,而决策级融合使得最优结论可信度的基础上初步决定完成本地与某些规则不同的图像。

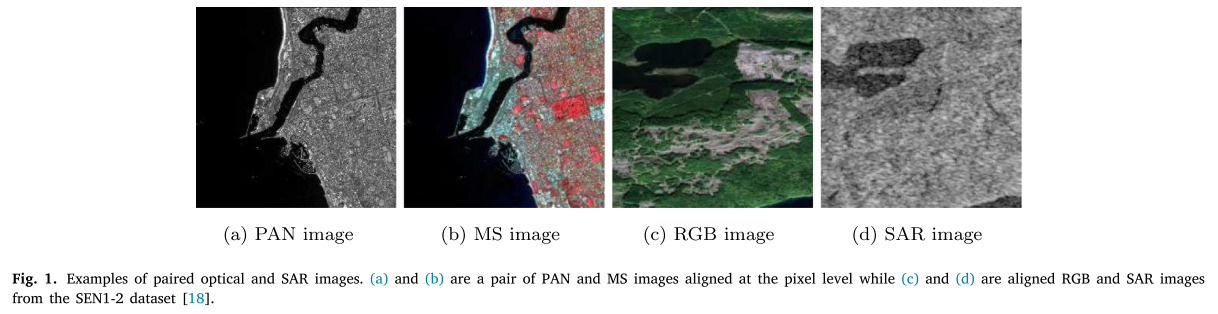

相比之下,进行像素级融合尽可能保持原始信息和提供的信息,其他级别不能供应。然而,它也有一定的局限性,特别是图像配准的高要求。一般来说,大多数融合模型要求的图像像素级融合必须精确对齐,这对数据预处理提出了挑战。图1显示了不同的光学和SAR(synthetic aperture radar 合成孔径雷达)图像配对的例子。

我们发现空间信息融合和时空融合一直是研究的重点。时空融合的目的是把图像的信息在不同的日期生产系列与时间和空间分辨率好的图片。

传统融合方法Traditional image fusion methods

Spatial information fusion 空间信息融合

Classical methods

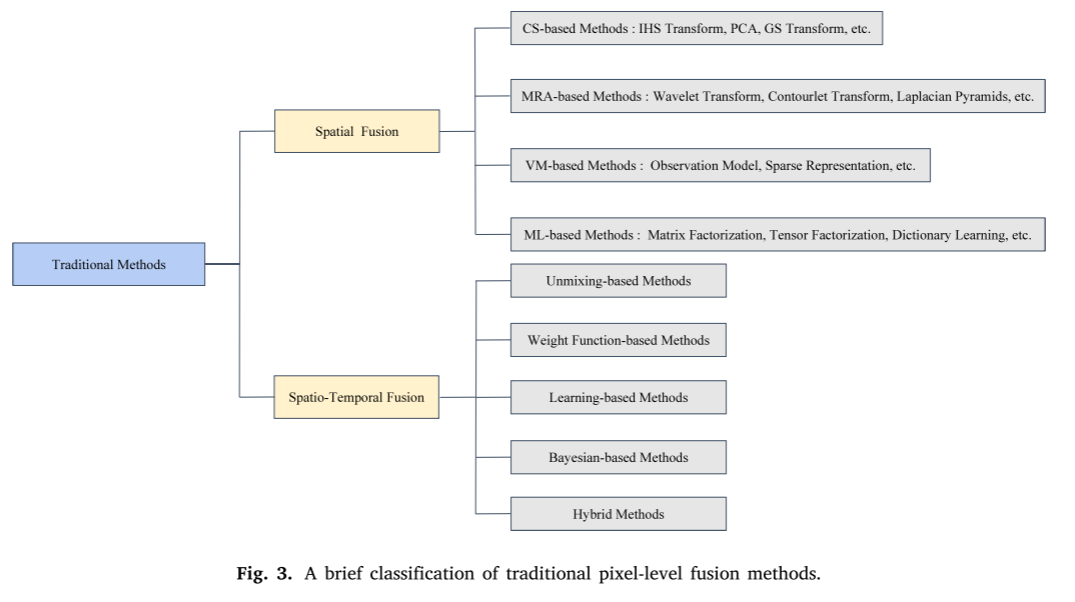

传统方法pansharpening可以主要分为三类:(1)组件替换(component substitution (CS));(2)多分辨率分析(multi-resolution analysis (MRA);(3)变分模型(variational model (VM))。

Spatio-temporal information fusion 空间-时间融合(时空融合)

传统方法在这一领域可以分为五类:(1)基于unmixing方法;(2)基于weight函数的方法;基于(3)基于learning方法;(4)基于Bayesian方法;(5)混合方法。

基于unmixing方法使用线性光谱混合分解理论的像素高时间分辨率的图像来估计高空间分辨率图像的像素值。注意,目前很多基于unmixing方法的原理可以追溯到多传感器多分辨率技术方法。这些方法通过引入局部校正、自适应移动窗口、成本函数等来改进原始模型。

基于权函数的方法通过提取输入信息的权函数估计理想像素值。时空适应性反射融合模型(STARFM)是第一个方法。自那时以来,一些改进的方法基于STARFM出现而其他人则介绍了一些重要指标和新开发的技术。

基于学习方法主要是基于dictionary-pair学习,极端的学习机器,随机森林等等之前深度学习的出现。

基于Bayesian方法模型输入图像和理想的结果之间的关系在贝叶斯框架,融合可以被视为一个最大后验的问题。

基于混合方法集成的优势上面的两个或两个以上的类别去追求更好的结果。

缺点:高度依赖函数和模型的选择根据一些人为设计的关系和假设。

Commonly used deep learning models常用的深度学习模型

常用S-AE、CNN、RNN和GAN的基本模型及其优化版本。

S-AE

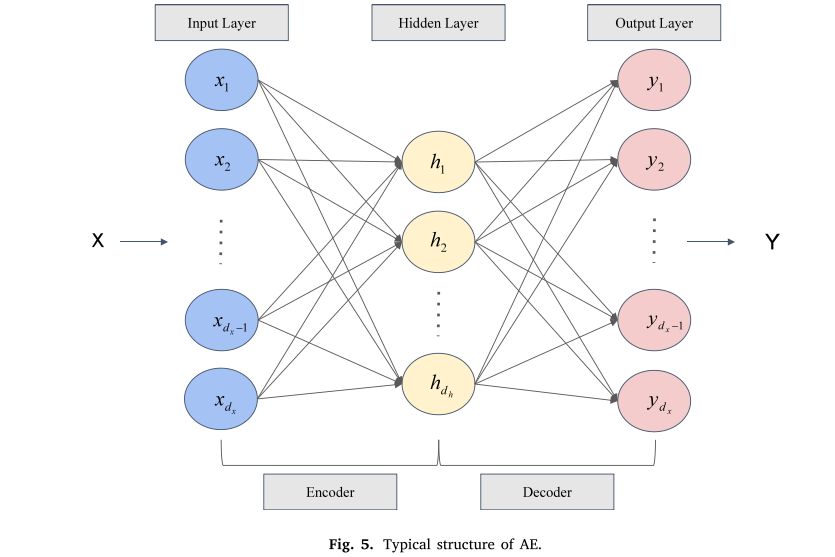

S-AE可以视为一个深层神经网络组成的多层autoencoders,前一层的输出的autoencoder (AE)是用作下一层的输入。一个典型的AE结构(图5)所示由三层构成两个子结构:编码器和译码器。

在输出层神经元的个数等于输入层隐层神经元的数量通常比其他少。AE进行重建的输入使它尽可能平等的原始输入。这个过程由编码器和译码器实现。编码器压缩的过程输入一个潜在空间表示

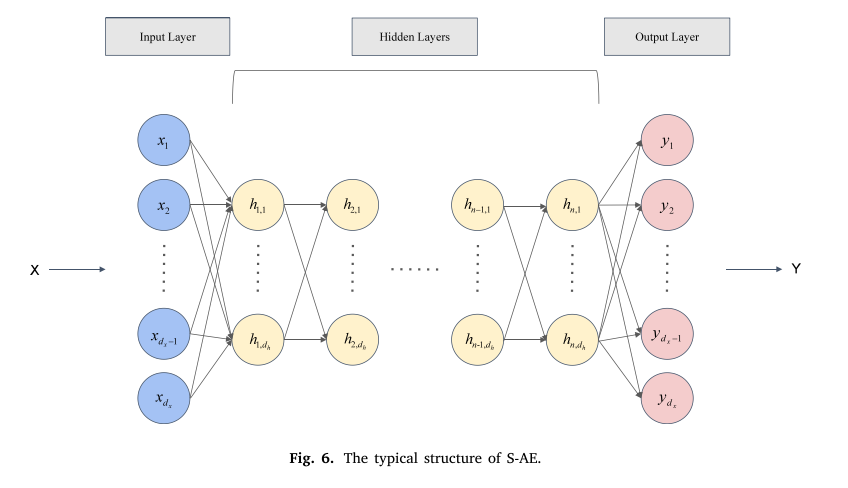

图6显示了一个典型的S-AE结构。在培训过程中,由于梯度问题深陷网络消失,整个过程包括两个步骤:无监督分层技术训练和监督微调

The development of deep learning-based methods

Spatial information fusion

Spatial information fusion

方法:

1)S-AE

2)CNN

3)RNN

4)GAN

HS image sharpening

融合PAN图像和MS图像

Spatio-temporal fusion

以CNN模型为主,时空融合的目的是将多源图像的时空信息融合在一起来生成一个具有更高空间分辨率或具有更多空间细节和更短时间间隔的时间序列图像。

Multispectral and hyperspectral image fusion in remote sensing: A survey(Gemine Vivone)

(hyperspectral image 高光谱图片 )

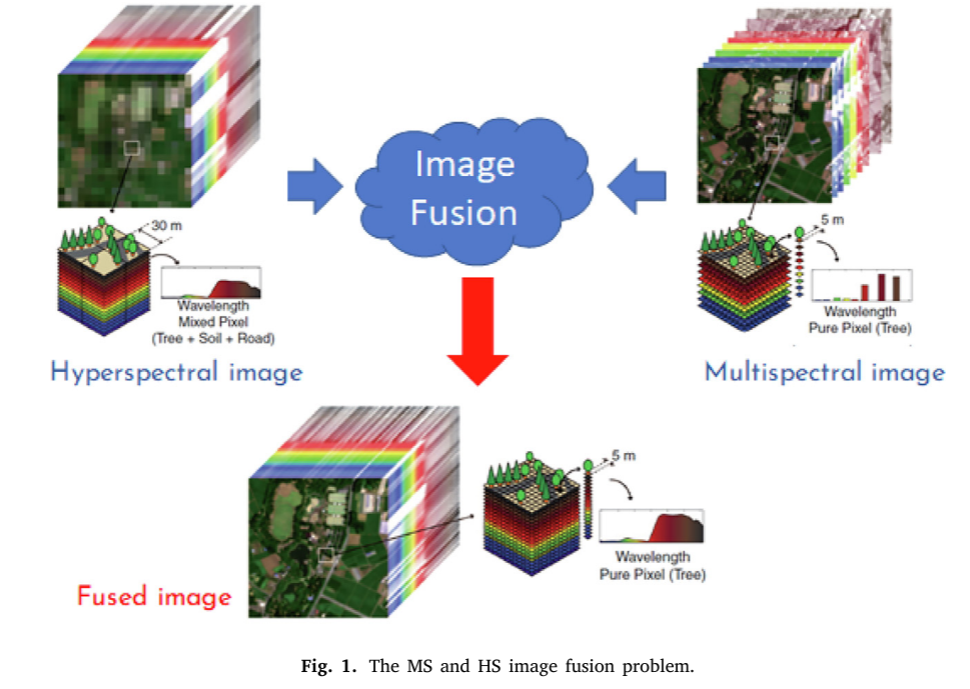

多光谱(MS)和高光谱(HS)图像的融合是近年来研究的热点。这些技术的目的是将高空间分辨率MS图像与显示较低空间分辨率但更精确光谱分辨率的HS数据相结合。

介绍

高光谱(HS)遥感信号的数据代表一个相关类工作在许多不同的领域,例如,植被监测、水资源管理、土壤调查和地质。相对于多光谱(MS)图像,HS图像的使用受到了一些研究所证实的识别照明场景关键特征的上级能力的激励。然而,利用卫星上的传感器获得的HS数据受到空间分辨率低(主要在30米至10米之间)的严重限制,无法获得可接受的最终产品信噪比。因此,若干应用经历了由空间分辨率引起的显著性能降级,例如,土壤成分估计、植被分类和城市变化检测问题。另一方面,使用模拟和真实的数据的研究已经证明了通过图像融合提高空间分辨率所带来的益处;例如,参见关于叶面积指数的估计、矿物测绘和入侵植物检测的研究。这些结果推动了大量技术的发展,这些技术用于将HS图像与MS和全色(PAN)传感器获得的高空间分辨率(HR)数据相结合,从而克服了空间分辨率的限制,在全球范围内解决了高空间分辨率机载成像系统仅在局部面临的新应用。此类应用包括高空间分辨率生态系统监测、矿物的高空间分辨率测绘、城市表面材料、土壤有机碳检测、作物参数提取等。

迄今为止,已有一些卫星考虑同时获取HS数据和MS或PAN图像的实例。先驱使命是退役的地球观测(EO) 。它安装了一个仪器(先进的陆地成像仪- ALI),可以获取MS(30米空间分辨率)和PAN(10米空间分辨率)图像。传感设备由一个超光谱传感器(Hyperion)完成,该传感器可采集可见近红外(VNIR)和短波红外(SWIR)光谱中的数百个光谱带,空间分辨率为30 m。因此,只有全色照相机(其特征在于比HS传感器的空间分辨率更精细的空间分辨率)可用于增强空间分辨率。这些数据确实有助于解决一个众所周知的问题,即所谓的超光谱全色锐化[18]。聚焦于最新技术,2019年3月发射并由意大利航天局管理的Prisma任务值得一提。卫星平台上有两个传感器:(1)30 m空间分辨率的HS相机在30 km的扫描带上获取VNIR和SWIR区域的约250个波段;(2)以5m的空间分辨率采集PAN信道。(略)

利用在同一平台上同时采集的这些异构数据源的一个有价值的选择是利用数据融合。结合MS图像的有趣特征,具有比HS传感器更精细的空间分辨率,而HS传感器显示更高的光谱分辨率,这是MS和HS图像融合的目标。这些方法可以提供具有高空间分辨率(即,MS图像之一)和高光谱分辨率(即,HS传感器之一),从而以更好的方式解决更复杂的任务,参见图1。

值得注意的是,可以放宽同时获取两个输入的要求,从而导致多平台数据融合方法的发展。然而,该问题引入了关于例如数据校准以及更关键的要融合的图像的一致性的进一步问题。事实上,关键问题涉及不同的视角和不同的获取时间,而这些几乎无法通过遥感数据处理链加以补偿。

介绍一下当前问题的分类。多光谱和超光谱图像融合问题,通常缩写为MS+HS。“超分辨率”,即:HS图像超分辨率。“锐化"被用来指出可以用该过程获得的空间分辨率增强。

这些方法将分为三个不同的类别。第一类与基于全色锐化的方法有关,即,全色锐化的应用,只是进一步解决频带分配问题,以使用经典全色锐化算法来处理该问题。之后,将考虑基于分解的技术的类别。这个类表示包含几个方法的较大类。更具体地,将输入图像建模为矩阵或张量带来两个不同的子类。

第二类,从许多原子到很少原子的字典的使用允许从稀疏表示到低秩的概念的应用。

最后一个类别则专注于应用新出现的技术,这些技术依赖于范例训练的范例。因此,基于机器学习的方法最近被开发出来,冲浪深度学习的大浪潮,经常借用计算机视觉的方法。

MS and HS image fusion: Pansharpening-based approaches

为HS和MS图像融合提出的第一种方法是从全色锐化借用的基于小波的技术。全色锐化,与光谱分辨率高于PAN影像的MS影像的融合有关,而不是显示更好的空间分辨率。全色锐化算法可分为四类,即:多分辨率分析、组件替换、基于变分优化和机器学习。使用全色锐化方法来解决不同图像融合任务的想法已被广泛开发。为了使该问题适应于经典全色锐化,要面对的进一步问题涉及波段分配问题,即,应当选择哪个高空间分辨率MS波段来增强给定HS波段的空间分辨率。实际上,当我们开发全色锐化方法时没有考虑这个问题,这是由于唯一的高空间分辨率图像,即PAN。

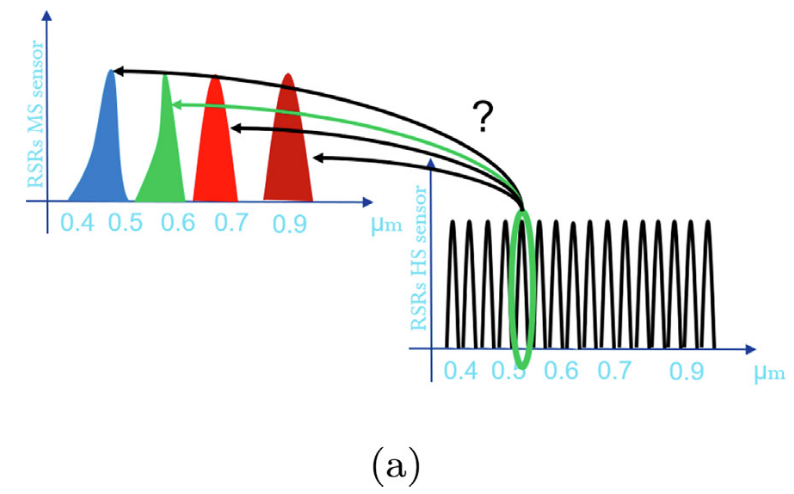

Band selection

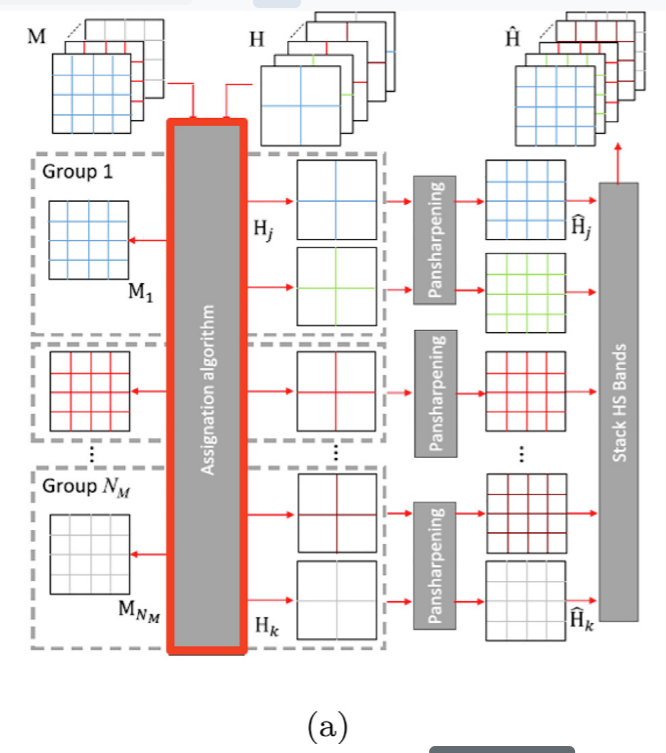

在图3(a)中描绘了该硬判决方案,其中用红框指出了主块。其思想是创建依赖于分配算法的组。属于给定组的所有HS波段用相同的MS波段增强,从而将该问题报告给经典全色锐化,其中PAN图像由给定MS波段表示。为了定义分配算法,我们可以利用不同的标准,这些标准可以分为两个主要的子类别。第一种称为静态赋值。在这种情况下,使用MS和HS传感器的相对光谱响应(RSRs)的相似性度量,参见图4(a)。

该分配是静态的,因为其对于要用于融合的每对HS和MS传感器定义一次。这些算法计算HS频带与MS频带集合之间的相似性度量。最大相似性准则用于分配。不同的度量导致不同的算法。关联度量的一个简单示例是通过最小化两个RSR的质心之间的欧氏距离。

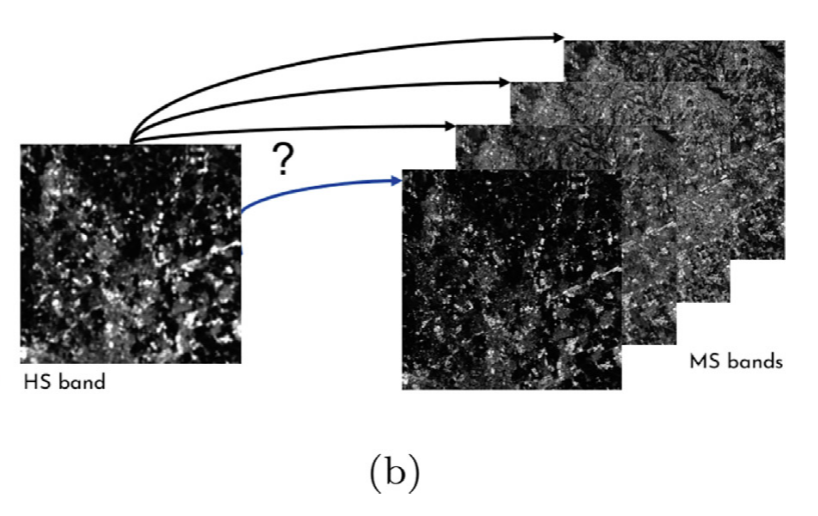

第二个子类别基于动态分配。在这种情况下,相似性度量直接定义在所采集的图像上(图像相关算法),从而导致甚至来自相同传感器对的不同采集的不同分配。因此,计算每个HS图像和所有MS图像集之间的相似性度量,参见图4(b)

最大相似性准则用于分配。值得注意的是,这些基于分配的方法可以与全色锐化技术一起使用。这些技术集合的适当组合产生用于MS和HS图像融合问题的新方法。

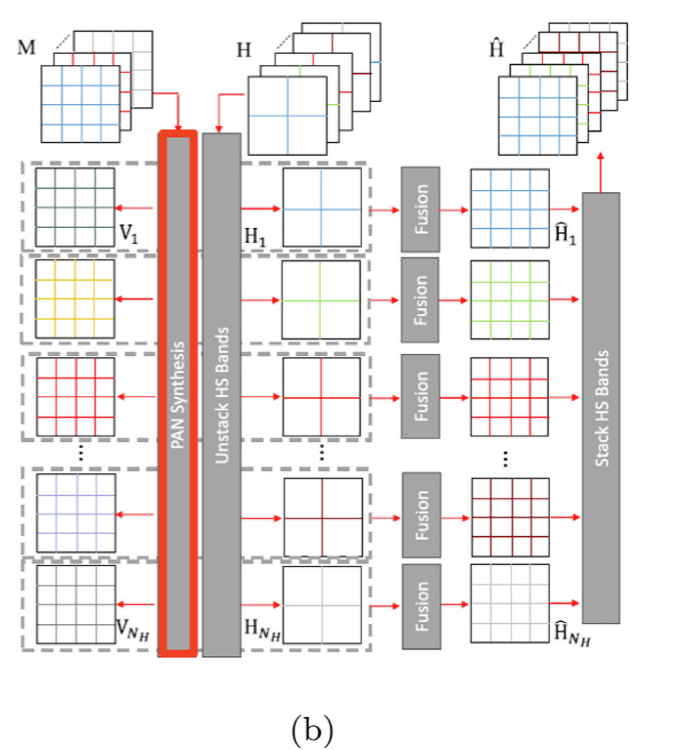

Band synthetization

在图3(b)中描绘了该软判决方案,其中用红框指出了主块。其思想是从所有MS谱带的集合开始为每个HS带合成HR图像。合成模型为线性模型。线性组合的权重通过最小化MS影像的降低分辨率版本与以全比例内插的低分辨率HS影像之间的均方误差来计算。对每个HS图像迭代该过程,我们可以得到一组𝑁𝐻合成图像,如𝐕图3(b)所示。对于每个波段𝑗,我们可以融合第𝑗个HS波段和相关的合成版本,比如说𝐕𝑗,得到第HS波段的锐化版本𝑗。该过程被称为超锐化。还提出并评估了遵循这一模式的其他办法。例如,提出了一种基于光谱调制的超锐化框架,其调整MS图像,就像在相同的成像条件下用相应的HS传感器观察到的那样。

MS and HS image fusion: Decomposition-based approaches

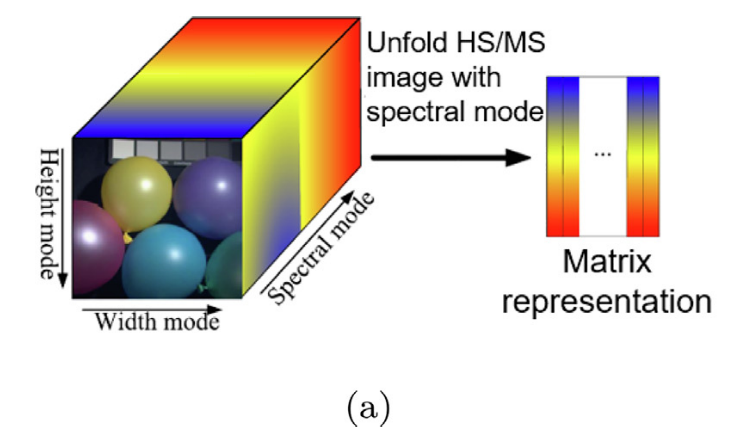

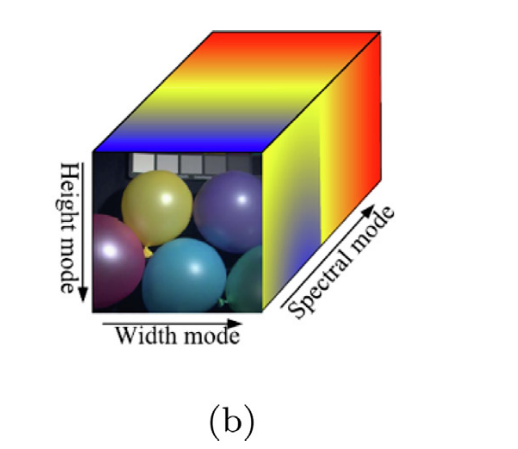

本节专门描述属于基于分解的类的MS和HS方法。这些方法的第一分类基于HS和MS图像的建模。实际上,HS或MS图像是具有三维(或模式)的立方体。前两个维度,即,空间因素是高度和宽度。第三个维度是光谱模式,收集由给定传感器获取的光谱带。这些立方体从数学的角度被视为矩阵。更具体地,HS或MS立方体以提供矩阵的频谱模式展开,参见图5(a)。

这导致了一种更简单的方法来解决这个问题,甚至在计算上更负担得起。然而,在该阶段中丢失了一些信息,从而排除了充分考虑数据中的局部空间-谱相关性的可能性。为了解决这个问题,最近的文献使用张量对该问题进行建模,从而得到比矩阵更复杂的表示。张量是描述与向量空间相关的代数对象集合之间的多线性关系的代数对象。因此,张量可以将HS/MS立方体的三种模式信息合并到一个统一的模型中,见图5(b)

在本综述中,我们将回顾基于分解思想的方法,分解使用输入数据的建模。在进入细节之前,报告了所使用的符号、一些有用的定义以及为矩阵和张量定义的空间和谱模型。矢量以粗体小写表示(例如,𝐱),二维(2-D)阵列(即,matrices),以粗体大写表示(例如,𝐗)。张量改为用欧拉脚本字母表示(例如,X)【不会花体的打法就以X为主,将就】。X∈ R𝑊×𝐻×𝑁R^{𝑊 ×𝐻 ×𝑁}RW×H×N𝐻是表示(unknown; ground-truth)高分辨率HS影像的三维张量,具有𝑁𝐻光谱波段和𝑊𝐻光谱像素。y∈R𝑤×h×𝑁R^{𝑤 ×h×𝑁}Rw×h×N𝐻是表示低分辨率HS图像的3-D张量,具有𝑤h〈𝑊𝐻光谱像素。相反,Z∈ R𝑊×𝐻×𝑁R^{𝑊 ×𝐻 ×𝑁}RW×H×N𝑀是表示高分辨率MS图像的三维张量,其具有𝑁𝑀〈𝑁𝐻光谱带。进一步,给定一𝑁个维张量=(𝑚𝑖1,…,m𝑖𝑁)∈R𝐼1×𝐼2×⋯×𝐼NR^{𝐼~1~ ×𝐼~2~×⋯×𝐼~N~}RI 1 ×I 2 ×⋯×I N ,通过改变张量的指数𝑖𝑛而保持其它指数不变,将张量的模𝑛展开向量定义为维数向量𝐼𝑛。张量的𝑛-模展开矩阵为𝐌(𝑛)∈ R𝐼𝑛×𝐼1𝐼2,...,𝐼𝑛−1𝐼𝑛+1,...𝐼𝑁R^{𝐼𝑛 ×𝐼1 𝐼2,...,𝐼𝑛−1𝐼𝑛 + 1,...𝐼𝑁}RIn×I1I2,...,In−1In+1,...IN,其列为所有𝑛-模向量。一个典型的例子是𝐗(3)∈R𝑁𝐻×𝑊𝐻R^{𝑁~𝐻~ ×𝑊𝐻}RN H ×WH表示张量的3-模展开矩阵𝐗(即𝐗(3)的每一列是大小的谱向量𝑁𝐻)。

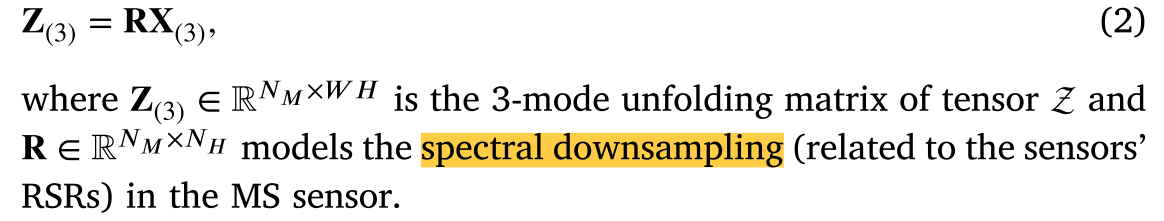

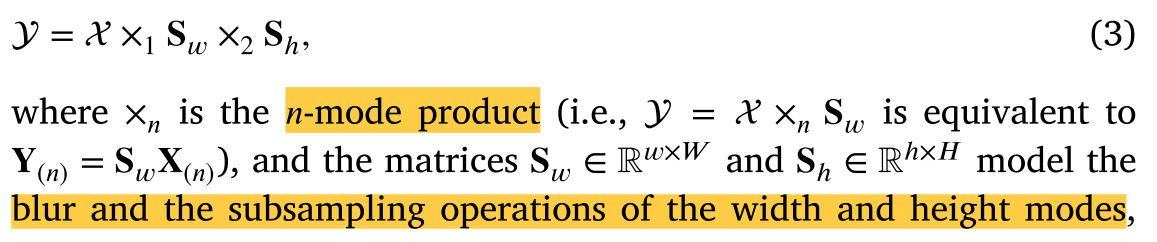

聚焦使用矩阵的建模,空间模型(也见图6(a))定义为:

𝐗(3)∈R𝑁𝐻×𝑊𝐻R^{𝑁~𝐻~ ×𝑊𝐻}RN H ×WH和Y(3)∈R𝑁𝐻×𝑊𝐻R^{𝑁~𝐻~ ×𝑊𝐻}RN H ×WH分别是张量X和Y的三模展开矩阵,𝐁和𝐒矩阵分别对模糊和子采样操作建模。

相关的光谱模型(也可参见图6(b))为:

张量的等效空间模型如下:

相反,光谱模型为:

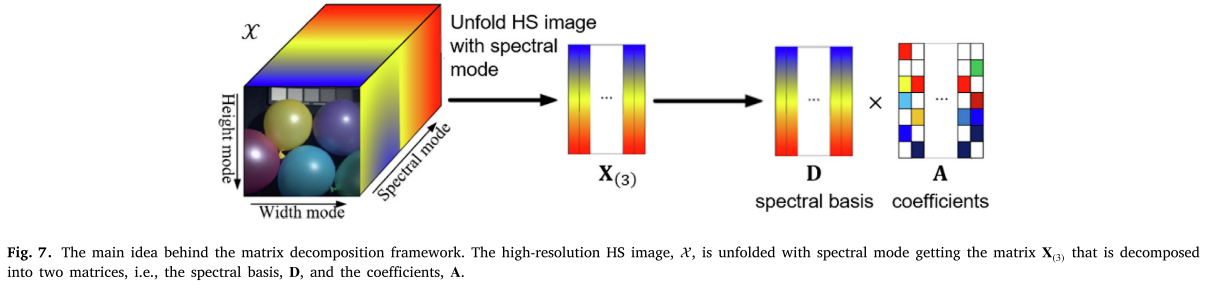

Matrix decomposition

属于该类的方法将输入中的HS和MS立方体建模为矩阵。假设𝐗(3)可以分解为一个谱基𝐃∈$R^{𝑁𝐻 ×𝐿}乘以若干系数𝐀∈ R𝐿×𝑊𝐻R^{𝐿 ×𝑊𝐻}RL×WH,即,𝐗(3)=𝐃𝐀,见图7

根据建模方式𝐃,这些方法可分为:

Sparse representation

Low-rank

基于矩阵分解的融合方法依赖于谱基和系数的估计来解决该问题。基于优化公式,我们可以进一步将方法分为三类:

Fully splitting of the optimization problem

Partial splitting of the optimization problem

Joint optimization problem

Tensor decomposition

基于张量的MS和HS图像融合方法依赖于表示MS和HS图像的张量的分解。Tucker分解是用于解决该问题的广泛使用的方法之一,例如,正则多进(CP)分解和张量奇异值分解(t-SVD)已经被用于该问题。

MS and HS image fusion: Machine learning-based approaches

基于机器学习的融合方法通常学习非线性映射函数。

MS and HS image fusion: Datasets

MS and HS image fusion: Quality assessment

从待融合的HS图像开始,通常获得通过空间滤波的降级版本以用作待评估的图像融合方法的输入。因此,HS图像的原始(未改变的)版本被用作质量评估过程的参考。HR MS图像或者降级到原始HS空间分辨率,或者在进一步仿真的情况下,利用来自待仿真传感器的RSR的知识从原始HS图像开始获得。空间滤波器通常根据传感器的调制传递函数来设计。由于多维相似性指数的使用和/或用于灰度图像的度量的使用,提供了定量评估,其在每个HS带上计算,然后仅沿着谱带平均以获得最终的总体指数。第一类中的示例是光谱角映射器(SAM)、合成中的相对无量纲全局误差(ERGAS)和通用图像质量指数Q2𝑛 的多维扩展。相反,沿着结构相似性指数测量(SSIM)的谱带沿着平均值是第二类的示例。

由于无法获得全分辨率(FR)的参考图像,因此锐化产品的FR评估必须依赖于原始图像。通常,分别通过光谱失真指数和空间失真指数在光谱域和空间域中单独地评估最终产品质量,然后将这两个度量组合。值得注意的例子是无参考质量(QNR)指数、Khan协议、无参考混合质量指数(HQNR)和QNR+指数。

Deep learning in multimodal remote sensing data fusion: A comprehensive review(Jiaxin Li)

随着遥感(remote sensing (RS))技术的飞速发展,地球观测(Earth observation

(EO))数据量大、异质性复杂,这为研究者提供了一个全新的机会来处理当前的地学应用问题。随着光电数据的联合利用,近年来多模态遥感数据融合的研究取得了长足的进展,但这些传统算法由于缺乏对强异构数据的综合分析和解释能力而不可避免地遇到了性能瓶颈。因此,这种不可忽视的局限性进一步引起了对具有强大处理能力的替代工具的强烈需求。深度学习(Deep Learning,DL)作为一种前沿技术,由于其在数据表示和重构方面的卓越能力,在许多计算机视觉任务中取得了显著的突破。该方法已成功地应用于多模式遥感数据融合领域,与传统方法相比有了很大的改进。本文对基于DL的多模式遥感数据融合技术进行了系统的综述。

介绍

由于在观测地球环境方面的优势,遥感技术在各种光电任务中发挥着越来越重要的作用。随着多模式遥感数据的日益增长,研究人员可以方便地获得适合手头应用的数据。虽然大量的多模态数据变得容易获得,但是每一模态仅能捕获一个或少数特定属性,因此不能完全描述观察到的场景,这对后续应用造成了很大的限制。自然,多模态遥感数据融合是解决单一模态数据困境的一种可行途径。通过整合从多模态数据中提取的互补信息,可以在许多任务中做出更鲁棒和可靠的决策,例如变化检测、LULC分类等。

与多源多时相遥感不同,“模态”一词一直缺乏清晰统一的定义。本文试图在前人工作的基础上给予一个详细的定义。原则上,遥感数据有两个主要特征,即:传感器的技术规格和实际采集情况。具体地说,前者决定产品的内部特性,例如,成像机理和分辨率。而后者控制外部性质,例如,采集时间、观测角度和安装的平台。因此,上述因素有助于描述所捕获的场景,并且可以被描述为“模态”。显然,多模式遥感数据融合包括多源遥感数据融合和多时相遥感数据融合。

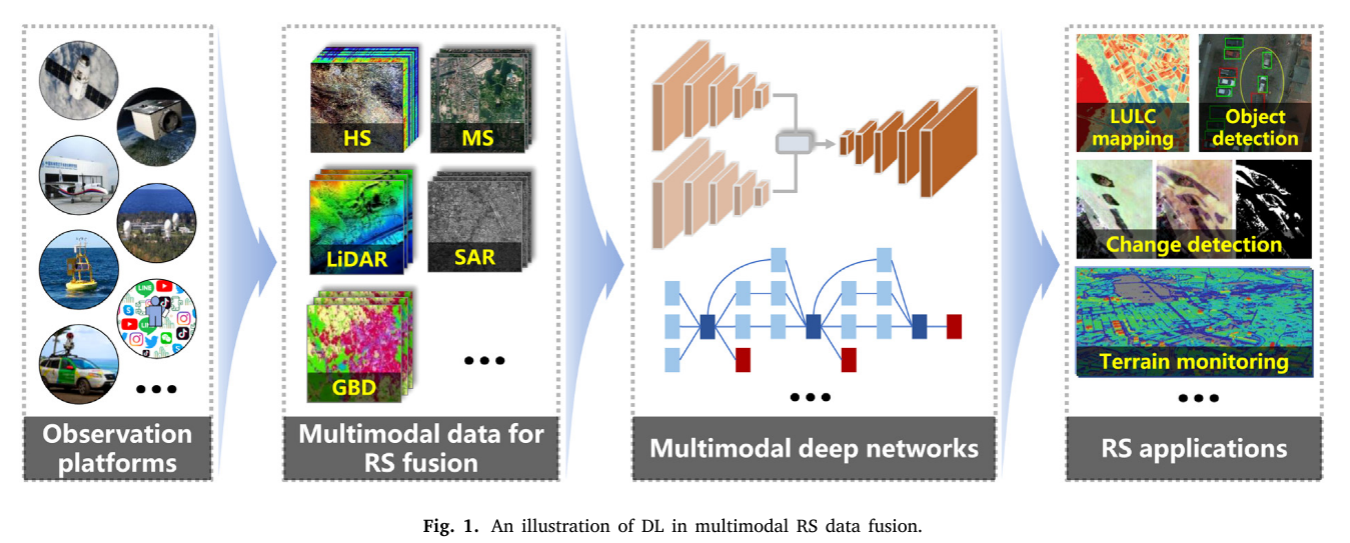

一些典型的RS模态包括Pan、MS、HS、LiDAR、SAR、红外、夜间光和卫星视频数据。近年来,GBD作为RS家族中的新成员,在光电探测任务中引起了越来越多的关注。为了整合这些模态提供的互补信息,传统方法通过基于领域知识设计手工特征和采用粗糙融合策略进行了深入研究,但这不可避免地降低了融合性能,尤其是对于异构数据。随着人工智能的发展,数据挖掘技术通过自适应地自动实现特征提取和融合,在输入和输出数据之间的复杂关系建模方面显示出巨大的潜力。根据待融合模态和相应任务的不同,基于DL的多模态RS数据融合可以归纳为一个统一的框架(见图1)

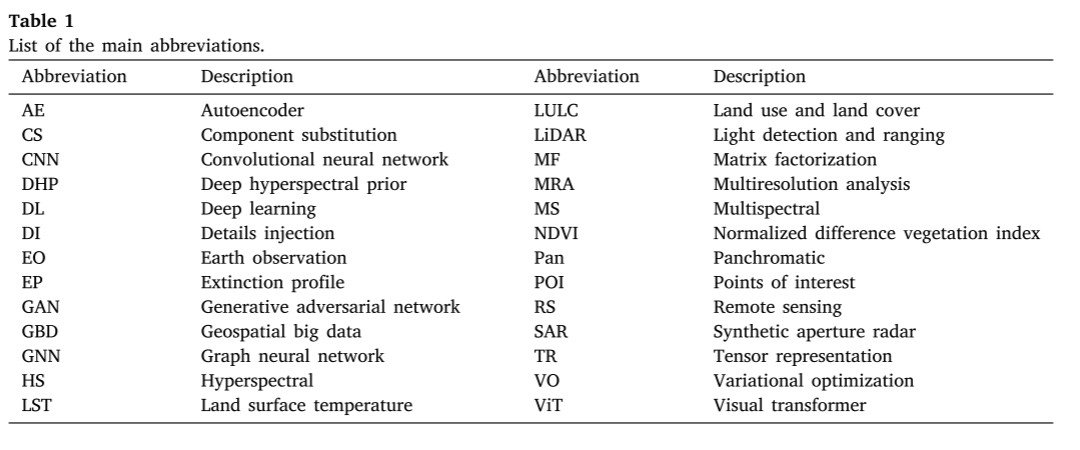

为方便读者,本文中使用的主要缩略语列于表1。

Literature analysis

Data retrieval and collection(数据检索和收集)

Web of Science和CiteSpace被选为主要的分析工具。

A review of DL-based multimodal remote sensing data fusion methods

(基于DL的多模态遥感数据融合方法综述)

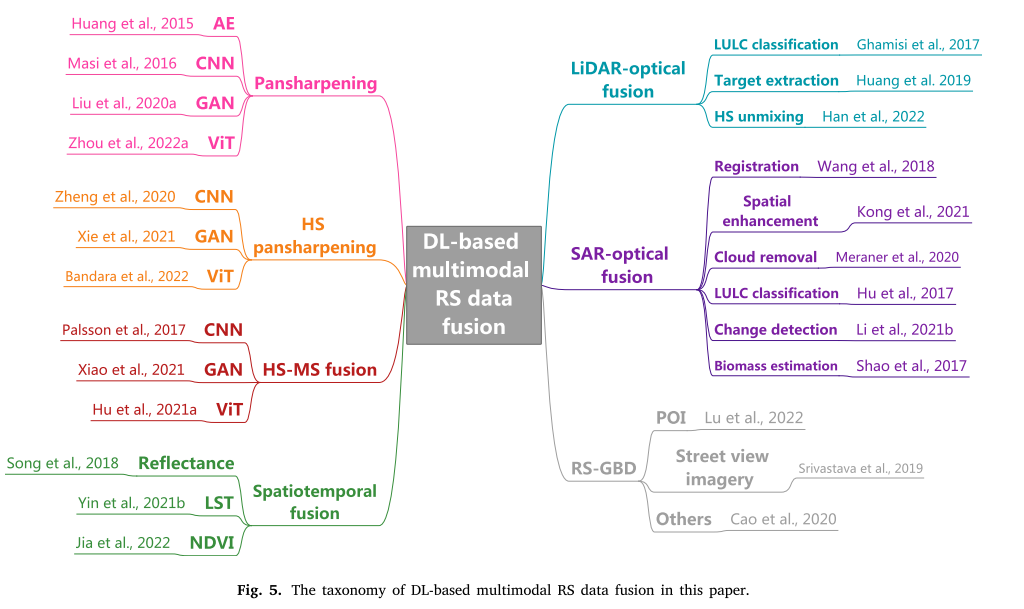

本文将现有方法分为两大类,即,同质融合和异质融合。具体地,同质融合指全色锐化、HS全色锐化、HS-MS融合和时空融合,而异质融合包括LiDAR光学、SAR光学和RS-GBD融合。由于上述子领域的发展差异较大,因此采用不同的标准来引入每个子领域,如图5所示。为了方便读者,我们还列出了各个方向的一些经典文献。

Homogeneous fusion(同质融合)

同质融合,包括空间光谱融合(即,全色锐化、HS全色锐化和HS-MS融合)和时空融合,主要致力于解决由于成像机制而在光学图像中发生的空间-光谱和空间-时间分辨率的折衷。

Pansharpening

全色锐化是指融合MS和Pan以生成高空间分辨率MS图像。一般而言,AE、CNN和GAN是用于基于DL的全色锐化的常用网络架构。

全色锐化也分:有监督和无监督;

HS pansharpening

与全色锐化类似,HS全色锐化旨在将HS中的光谱信息与PAN中的空间信息相结合以产生具有高空间分辨率的HS图像。

分为:有监督和无监督;

HS-MS fusion

全色锐化相关工作可视为HS-MS融合的特例,其目的是通过融合成对的HS-MS图像来获得具有高空间分辨率的HS图像。因此,许多基于DL的全色锐化方法经过必要的修改可以被转移到处理HS-MS融合。在此之后,将根据全色锐化中的相同分类来介绍典型方法。

分为:有监督和无监督;

监督

监督HS-MS融合通过用MS代替输入Pan而遵循HS全色锐化的相同方案。提出了具有经典结构的单分支HS-MS融合方法,例如3-D CNN(Palsson等人,2017)、残差网络(Han和Chen,2019)、密集连接网络(Han等人,2018)和三分量网络(Zhang等人,2021 a)等。与这些直接将HS上采样到与MS相同分辨率的单分支工作相比,多分支方法采用替代策略来缓解该问题,即:通过去卷积或像素混洗的操作逐渐上采样HS,其中从MS提取的空间信息被注入到相应的尺度中(Xu等人,2020 a; Han等人,2019; Zhou等人,2019年)。(略)

Spatiotemporal fusion

除了空间-光谱分辨率的折衷之外,还存在空间-时间域的矛盾,即:现有卫星平台获取同一区域的高空间分辨率图像通常需要较长的时间间隔,反之亦然,这极大地阻碍了变化检测等实际应用。因此,时空融合旨在通过融合一对或多对粗略/精细图像(例如,MODIS-Landsat对)和预测时间的粗空间分辨率图像。本节从预测陆面变量的角度介绍了一些典型的方法,如:反射率、LST、NDVI等。

Heterogeneous fusion 异质融合

与同质融合(homogeneous fusion)不同,异质融合主要是指LiDAR-optical、SAR-optical、RS-GBD等数据的融合,由于这些数据的成像机理完全不同,因此广泛采用特征级和决策级融合。

LiDAR-optical fusion

LiDAR-optical融合可以应用于许多任务,例如,配准、锐化、目标提取、森林生物量估算(Zhang和Lin,2017年)。由于很难对所有方面给予全面、详细的介绍,因此,我们将重点放在一个特定领域,即:研究了HS-LiDAR数据融合在LULC分类中的应用,并给予了在其他任务中的应用实例。

HS数据由于其丰富的光谱信息已被广泛用于分类任务,但在光谱信息不足以区分目标的情况下,其性能不可避免地遇到瓶颈(Hong等人,2020年a)。由于LiDAR系统能够获取三维空间几何信息,弥补了HS数据的不足,因此联合利用HS和LiDAR数据进行物质识别成为近年来的研究热点。Ghamisi等人(2017年)开创了第一个基于DL的HS-LiDAR融合网络,其中输入数据的特征由EP提取,然后通过两种融合策略进行整合,用于随后的基于DL的分类器。

SAR-optical fusion

与光学图像不同,SAR系统被设计用来采集地物的后向散射信号,这些信号不仅能反映雷达系统参数信息,而且能体现所观测场景的物理和几何特征。尽管SAR数据可以为光学图像提供补充知识,但它非常容易受到斑点噪声的影响,这可能严重限制其实际潜力。SAR和光学数据的联合使用成为实现更好地理解和分析感兴趣目标的可行解决方案。

RS-GBD fusion

GBD包含了来自社交媒体、地理信息系统、移动的等广泛的资源,极大地促进了我们对生活环境的理解。更具体地说,RS在从全球视角捕捉大尺度地球表面的物理属性方面表现出很强的能力。另一方面,GBD提供的信息与人类行为高度相关,作为RS的补充,GBD提供了丰富的社会经济描述。值得注意的是,GBD与RS在数据结构上存在较大差距,目前流行的提取模态特征的双分支网络不能直接应用于GBD与RS数据融合。本节根据融合过程中使用的GBD类别,如街景影像、POI、车辆轨迹数据等,整理了一些在RS-GBD融合中的成功案例。