文章目录

- Introduction

- Supervised / unsupervised learning

- Overfitting

- Bayesian

Introduction

Supervised / unsupervised learning

P3

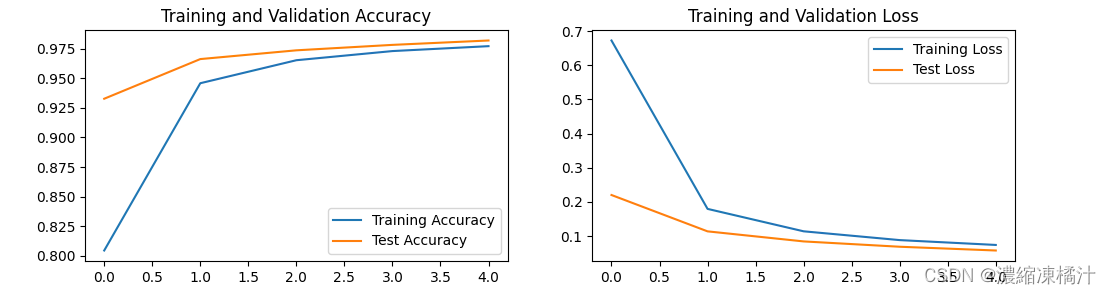

Overfitting

p6

p9:

For a given model complexity, the over-fitting problem become less severe as the size of the data set increases.

Choose the complexity of the model according to the complexity of the problem being solved.

Least squares approach to finding the model parameters represents a specific case of maximum likelihood.

当误差项服从正态分布时,最小二乘法估计与最大似然估计是一致的,分析如下:

- 在回归分析中,

最小二乘法用于寻找模型参数,使得预测值与实际观测值之间的平方误差和最小化。对于线性回归模型: y = X β + ϵ y=X\beta+\epsilon y=Xβ+ϵ,其中 y y y是观测值向量, X X X是设计矩阵, β \beta β是待估参数向量, ϵ \epsilon ϵ是误差向量。最小二乘估计通过最小化平方误差和来找到参数 β : \beta: β: β ^ L S = arg min β ∥ y − X β ∥ 2 \hat{\beta}_{LS}=\arg\min_\beta\|y-X\beta\|^2 β^LS=argminβ∥y−Xβ∥2

这个优化问题的解是: β ^ L S = ( X T X ) − 1 X T y \hat{\beta}_{LS}=(X^TX)^{-1}X^Ty β^LS=(XTX)−1XTy. - 最大似然估计的目标是找到使得观测数据概率最大的参数值。在回归模型中,如果我们假设误差项 ϵ \epsilon ϵ服从正态分布 ϵ ∼ N ( 0 , σ 2 I ) \epsilon\sim\mathcal{N}(0,\sigma^2I) ϵ∼N(0,σ2I) ,那么观测值 y y y也服从正态分布: y ∼ N ( X β , σ 2 I ) y\sim\mathcal{N}(X\beta,\sigma^2I) y∼N(Xβ,σ2I)

观测数据的似然函数为: L ( β , σ 2 ) = P ( y ∣ β , σ 2 ) = 1 ( 2 π σ 2 ) n / 2 exp ( − 1 2 σ 2 ( y − X β ) T ( y − X β ) ) L(\beta,\sigma^2)=P(y|\beta,\sigma^2)=\frac{1}{(2\pi\sigma^2)^{n/2}}\exp\left(-\frac{1}{2\sigma^2}(y-X\beta)^T(y-X\beta)\right) L(β,σ2)=P(y∣β,σ2)=