在云原生与AI技术深度融合的今天,如何将大模型能力无缝嵌入后端架构,已成为开发者构建下一代智能应用的核心命题。本文将深入解析腾讯云大模型API(如DeepSeek-R1/V3、混元大模型)与云原生技术的创新结合方案,通过架构设计、实战案例与高阶技巧,揭示一条从0到1构建AI增强型服务的完整路径。

---

## 一、云原生与大模型的融合新范式

### 1.1 技术趋势的双向奔赴

云原生后端的核心优势在于弹性扩展、敏捷交付与高效运维,而大模型则提供了自然语言理解、生成与推理的认知能力。二者的结合催生了全新的开发范式:

- **动态资源调度**:通过Kubernetes自动扩缩容机制,应对大模型推理的算力波动需求,如DeepSeek-R1在高峰期自动扩展GPU节点

- **微服务化AI能力**:将大模型API封装为独立服务,如文档解析、多轮对话等原子能力,通过服务网格实现智能流量管理

- **持续交付流水线**:结合CI/CD工具链,实现模型版本与后端代码的协同更新,确保AI服务迭代效率

### 1.2 腾讯云技术栈全景图

腾讯云提供完整的技术生态支持:

- **基础架构层**:TKE容器服务、Serverless函数计算

- **模型服务层**:DeepSeek系列模型API、混元大模型API、Ollama框架支持

- **开发工具链**:Cloud Studio云端IDE、HAI高性能计算实例、10000分钟免费算力计划

---

## 二、架构设计与技术选型

### 2.1 智能微服务架构

采用分层架构实现AI能力模块化:

```plaintext

+---------------------+

| API Gateway | # 统一入口,路由至AI服务

+---------------------+

| Auth Service | # JWT鉴权与访问控制

+---------------------+

| Model Orchestrator | # 多模型调度与结果融合

+---------------------+

| AI Service Layer | # 大模型API封装(如DeepSeek-R1)

+---------------------+

| Data Cache | # Redis缓存高频请求结果

+---------------------+

| Monitoring | # Prometheus+Grafana监控模型耗时与异常

+---------------------+

```

### 2.2 容器化部署实践

以DeepSeek-R1模型服务为例,Dockerfile关键配置:

```dockerfile

FROM nvidia/cuda:12.1-base

WORKDIR /app

COPY requirements.txt .

RUN pip install -r requirements.txt

COPY ollama_service.py .

EXPOSE 11434

CMD ["python", "ollama_service.py"]

```

通过Kubernetes配置GPU资源调度:

```yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: deepseek-r1

spec:

replicas: 2

template:

spec:

containers:

- name: model-service

image: registry.tencent.com/deepseek-r1:1.5b

resources:

limits:

nvidia.com/gpu: 1

```

---

## 三、全链路开发实战:构建智能客服系统

### 3.1 环境快速搭建

1. **云资源准备**

- 开通Cloud Studio工作空间,选择HAI进阶型实例(32G显存)

- 通过预置模板一键部署Ollama环境与DeepSeek-R1模型

```bash

ollama run deepseek-r1:7b

```

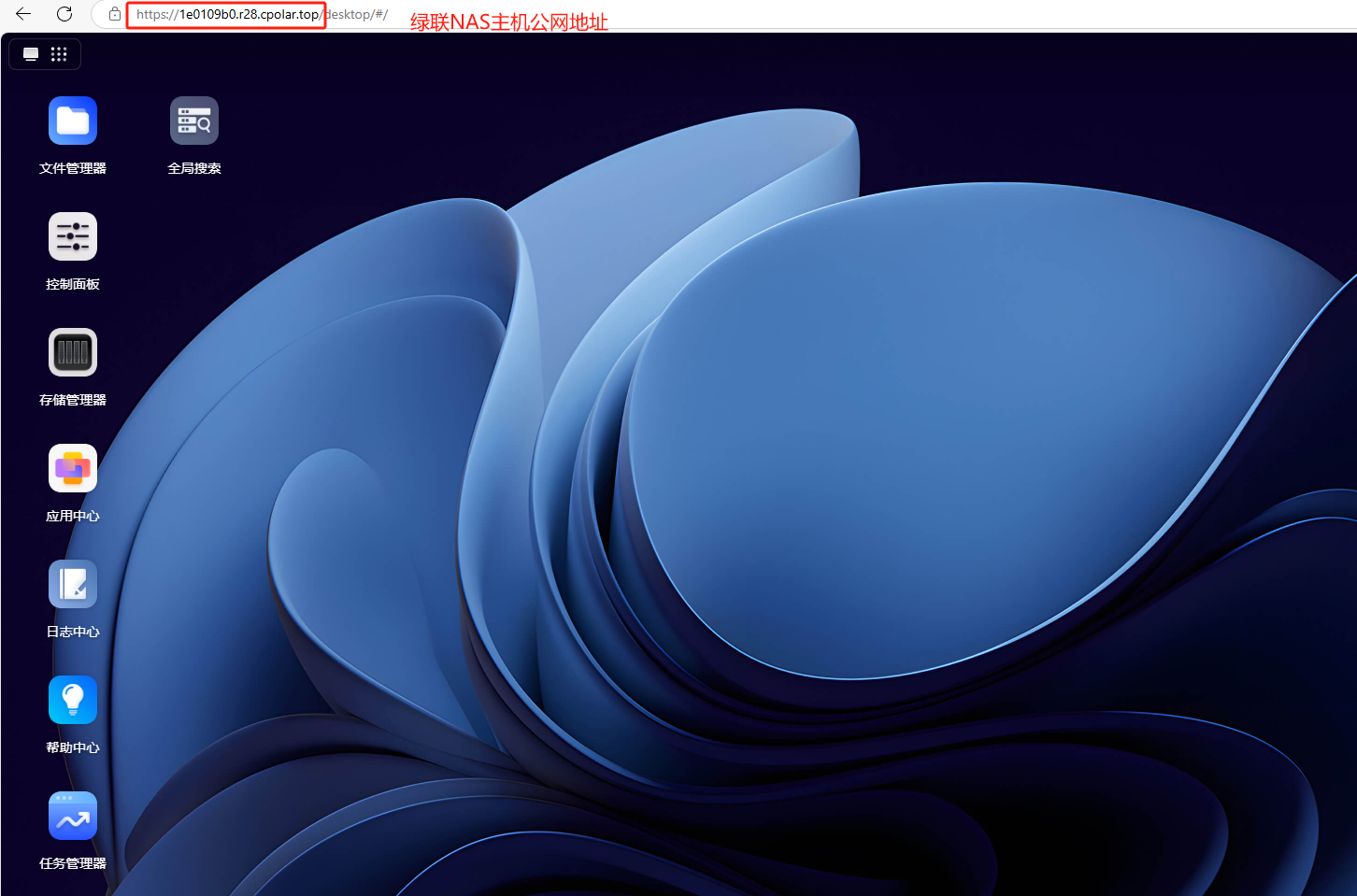

2. **API服务暴露**

使用Ngrok穿透内网实现公网访问:

```bash

./ngrok http 11434 # 生成https://abc123.ngrok-free.app

```

### 3.2 核心代码实现

**后端服务(Flask+DeepSeek API)**

```python

from flask import Flask, request, jsonify

import requests

app = Flask(__name__)

OLLAMA_URL = "http://localhost:11434/api/chat"

@app.route('/chat', methods=['POST'])

def chat():

data = request.json

response = requests.post(

OLLAMA_URL,

json={

"model": "deepseek-r1:7b",

"messages": data['messages'],

"stream": False

}

)

return jsonify(response.json())

```

**前端交互(Vue3+WebSocket)**

```javascript

// 实时对话实现

const socket = new WebSocket('wss://your-domain/chat')

socket.onmessage = (event) => {

this.messages.push({role:'assistant', content: JSON.parse(event.data).content})

}

```

### 3.3 领域适配优化

通过Modelfile定制医疗场景模型:

```modelfile

FROM deepseek-r1:7b

SYSTEM """

你是一名三甲医院AI助手,需基于最新指南回答患者问题。

"""

PARAMETER temperature 0.3

```

构建专属模型:

```bash

ollama create medical-assistant -f Modelfile

```

---

## 四、高阶技巧与生产级优化

### 4.1 性能调优策略

- **量化压缩**:采用4-bit量化降低显存占用

```bash

ollama pull deepseek-r1:7b-q4_0

```

- **批处理请求**:合并多个用户查询提升GPU利用率

- **缓存热点数据**:对高频问题结果进行Redis缓存

### 4.2 安全增强方案

- **三层防护机制**:数据加密传输+内容过滤+权限控制

- **模型输入净化**:使用正则表达式过滤敏感词

- **限流熔断**:通过Sentinel实现QPS控制

---

## 五、成本控制与创新场景

### 5.1 算力成本优化

- **混合部署模式**:CPU处理简单请求,GPU专注复杂推理

- **自动缩放策略**:基于Prometheus指标动态调整实例数量

- **免费资源利用**:合理规划10000分钟免费算力时段

### 5.2 创新场景拓展

1. **智能合同生成**

集成腾讯电子签API,实现"一句话生成合规合同"

2. **商业数据分析**

通过ChatBI接入DeepSeek-R1,自然语言生成可视化报表

3. **代码智能生成**

结合Semantic Kernel框架,实现需求文档转可执行代码

---

## 六、未来演进方向

1. **边缘计算融合**:在CDN节点部署轻量化模型,降低响应延迟

2. **多模态能力扩展**:整合文生图、语音合成等跨模态API

3. **自动化评估体系**:构建基于大模型的CI/CD质量检测流水线

通过以上实践,开发者可快速将腾讯云大模型能力注入云原生架构,在智能客服、数据分析、自动化办公等场景中构建差异化竞争力。腾讯云持续迭代的模型服务与开发工具链,正推动AI普惠化进入全新阶段——在这里,每个开发者都能以极低门槛,释放大模型的无限潜能。