讯飞智作 AI 配音技术依赖于深度学习与神经网络,特别是 Tacotron、WaveNet 和 Transformer-TTS 模型。这些模型通过复杂的神经网络架构和数学公式,实现了从文本到自然语音的高效转换。

一、Tacotron 模型

Tacotron 是一种端到端的语音合成模型,能够直接从文本生成语音频谱(Mel-spectrogram),然后通过声码器生成最终的语音信号。其主要优势在于能够捕捉文本与语音之间的复杂关系,生成自然流畅的语音。

1. 模型架构

Tacotron 的架构主要包括以下几个部分:

1.编码器(Encoder)

2.注意力机制(Attention Mechanism)

3.解码器(Decoder)

4.后处理网络(Post-processing Network)

2. 详细技术解析

1. 编码器(Encoder)

功能:将输入的文本序列转换为隐藏表示(hidden representations),捕捉文本的语义和语法信息。

过程:

-

文本嵌入(Text Embedding):将每个字符或单词转换为向量表示。

其中,

是第

个字符,

是其对应的嵌入向量。

-

卷积层(Convolutional Layers):使用多层一维卷积神经网络(1D CNN)来捕捉文本的局部特征。

-

双向长短期记忆网络(Bi-directional LSTM):捕捉文本的上下文信息。

其中,

是第

个时间步的隐藏状态。

输出:编码器输出一个隐藏状态序列 ,作为注意力机制的输入。

2. 注意力机制(Attention Mechanism)

功能:在解码过程中,选择性地关注输入文本的不同部分,生成相应的语音频谱。

过程:

-

计算注意力权重:

其中,

是解码器在第

个时间步的隐藏状态,

是评分函数(如点积、拼接等)。

-

计算上下文向量:

输出:上下文向量 ,用于指导解码器生成语音频谱。

3. 解码器(Decoder)

功能:根据上下文向量和之前的语音频谱,生成当前时间步的语音频谱。

过程:

-

LSTM 层:

其中,

是之前生成的语音频谱。

-

全连接层:

生成当前时间步的语音频谱预测。

输出:语音频谱序列 。

4. 后处理网络(Post-processing Network)

功能:将预测的语音频谱转换为最终的语音信号。

过程:

-

使用声码器(Vocoder):Tacotron 通常使用 Griffin-Lim 算法作为声码器,将梅尔频谱转换为语音波形。

输出:最终的语音波形 。

3. 关键技术公式总结

二、WaveNet 模型

WaveNet 是一种基于卷积神经网络的声码器,能够生成高保真度的语音波形。其主要优势在于能够捕捉语音中的细微变化,生成非常自然的语音。

1. 模型架构

WaveNet 的架构主要包括以下几个部分:

1.因果卷积层(Causal Convolutional Layers)

2.扩张卷积层(Dilated Convolutional Layers)

3.门控激活单元(Gated Activation Units)

4.残差连接(Residual Connections)

5.跳跃连接(Skip Connections)

6.输出层(Output Layer)

2. 详细技术解析

1. 因果卷积层(Causal Convolutional Layers)

功能:确保模型在生成当前样本时,只依赖于之前的样本。

过程:

- 使用一维卷积神经网络(1D CNN),并通过填充(padding)实现因果性。

2. 扩张卷积层(Dilated Convolutional Layers)

功能:增加感受野(receptive field),捕捉更长时间的依赖关系。

过程:

-

在卷积层中引入扩张因子(dilation factor),使得卷积操作跳过若干个样本。

其中,

是扩张因子,

是卷积核。

3. 门控激活单元(Gated Activation Units)

功能:引入非线性,增强模型的表达能力。

过程:

-

使用门控机制,将卷积输出分为两部分:

其中,

表示卷积操作,

表示逐元素相乘,

是 sigmoid 函数。

4. 残差连接(Residual Connections)

功能:缓解梯度消失问题,促进梯度流动。

过程:

-

将卷积层的输入与输出相加:

5. 跳跃连接(Skip Connections)

功能:将底层信息直接传递到高层,增强模型的表达能力。

过程:

-

将每一层的输出通过跳跃连接传递到输出层:

6. 输出层(Output Layer)

功能:将模型输出转换为最终的语音波形。

过程:

-

使用全连接层,将跳跃连接的结果映射到语音波形的概率分布:

3. 关键技术公式总结

三、Transformer-TTS 模型

Transformer-TTS 模型基于 Transformer 架构,利用自注意力机制(Self-Attention)捕捉文本与语音之间的长距离依赖关系,生成更加自然的语音。

1. 模型架构

Transformer-TTS 的架构主要包括以下几个部分:

1.编码器(Encoder)

2.解码器(Decoder)

3.位置编码(Positional Encoding)

4.多头自注意力机制(Multi-head Self-Attention)

5.前馈神经网络(Feed-Forward Neural Network)

6.输出层(Output Layer)

2. 详细技术解析

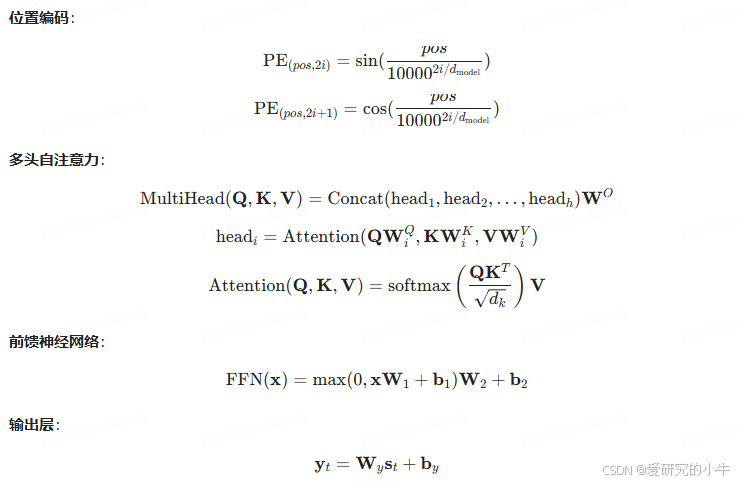

1. 位置编码(Positional Encoding)

功能:为序列中的每个位置添加位置信息,使模型能够感知序列的顺序。

过程:

-

使用正弦和余弦函数生成位置编码:

其中,

是位置,

是维度索引,

是模型的维度。

2. 多头自注意力机制(Multi-head Self-Attention)

功能:捕捉序列中不同位置之间的依赖关系。

过程:

-

将输入序列分割成多个头(heads),分别进行自注意力计算:

其中,

分别是查询、键和值矩阵,

是对应的权重矩阵,

是输出权重矩阵。

-

注意力计算:

3. 前馈神经网络(Feed-Forward Neural Network)

功能:为每个位置提供非线性变换。

过程:

-

使用两层全连接层:

4. 编码器和解码器

5. 输出层

功能:将解码器输出转换为语音频谱。

过程:

-

使用线性层将解码器输出映射到语音频谱: