本文内容:添加MLCA注意力机制

目录

论文简介

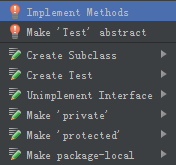

1.步骤一

2.步骤二

3.步骤三

4.步骤四

论文简介

注意机制是计算机视觉中应用最广泛的组成部分之一,它可以帮助神经网络突出重要元素,抑制无关元素。然而,绝大多数通道注意机制只包含通道特征信息,忽略了空间特征信息,导致模型表示效果或目标检测性能较差,且空间注意模块往往复杂且昂贵。为了在性能和复杂性之间取得平衡,本文提出了一种轻量级的混合本地信道注意(MLCA)模块来提高目标检测网络的性能,该模块可以同时包含信道信息和空间信息,以及局部信息和全局信息,以提高网络的表达效果。在此基础上,提出了MobileNet-Attention-YOLO(MAY)算法,用于比较不同注意力模块的性能。在Pascal VOC和SMID数据集上,MLCA比其他注意技术在模型表示效率、性能和复杂性之间取得了更好的平衡。

对比PASCAL VOC数据集上的挤压-激励(SE)注意机制和SIMD数据集上的坐标注意(CA)方法,mAP分别提高了1.0%和1.5%