- 本节将解析文本的常见预处理步骤包括:

- 将文本作为字符串加载到内存中。

- 将字符串拆分为词元(如单词和字符)。

- 建立一个词表,将拆分的词元映射到数字索引。

- 将文本转换为数字索引序列,方便模型操作。

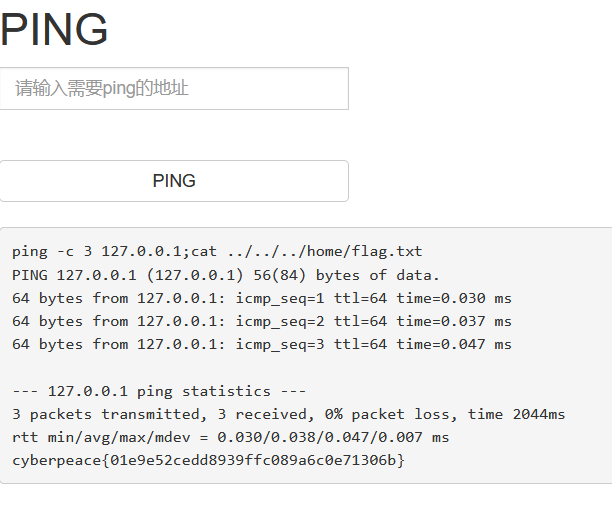

1. 读取数据集

- 我们下载并暴力地预处理文本:将所有非字母的字符都处理成空格,然后将它们都转化为小写,这样我们就只有27种字符了:

2. 词元化

- 词元是文本的基本单位,我们输入一个文本行列表,返回一个由词元组成的列表

3. 词表

- 词元的类型是字符串,而模型需要的输入是数字

- 构建一个字典,通常也叫做词表(vocabulary),用来将字符串类型的词元映射到从 0 开始的数字索引中。我们先将训练集中的所有文档合并在一起,对它们的唯一词元进行统计,得到的统计结果为语料

- 然后根据每个唯一词元出现的频率,为其分配一个数字索引。很少出现的词元通常被移除,这样可以降低复杂性

- 对于语料库不存在或已删除的任何词元都映射到一个特定的未知词元

“<unk>”。我们可以选择增加一个列表,用于保存那些被保留的词元,例如:填充词元(“<pad>”); 序列开始词元(“<bos>”); 序列结束词元(“<eos>”)

class Vocab: """文本词表"""def __init__(self, tokens=None, min_freq=0, reserved_tokens=None):if tokens is None:tokens = []if reserved_tokens is None:reserved_tokens = []counter = count_corpus(tokens)self._token_freqs = sorted(counter.items(), key=lambda x: x[1],reverse=True)self.idx_to_token = ['<unk>'] + reserved_tokensself.token_to_idx = {token: idxfor idx, token in enumerate(self.idx_to_token)}for token, freq in self._token_freqs:if freq < min_freq:breakif token not in self.token_to_idx:self.idx_to_token.append(token)self.token_to_idx[token] = len(self.idx_to_token) - 1def __len__(self):return len(self.idx_to_token)def __getitem__(self, tokens):if not isinstance(tokens, (list, tuple)):return self.token_to_idx.get(tokens, self.unk)return [self.__getitem__(token) for token in tokens]def to_tokens(self, indices):if not isinstance(indices, (list, tuple)):return self.idx_to_token[indices]return [self.idx_to_token[index] for index in indices]@propertydef unk(self): return 0@propertydef token_freqs(self):return self._token_freqsdef count_corpus(tokens): """统计词元的频率"""if len(tokens) == 0 or isinstance(tokens[0], list):tokens = [token for line in tokens for token in line]return collections.Counter(tokens)

- 我们打印一下看看这个数据集的情况

4. 整合所有功能

- 我们将上面的所有功能进行打包,但是进行了一些更改

- 为了简化后面章节的训练,我们使用字符实现文本词元化

- 时光机器数据集中的每个文本行不一定是一个句子或一个段落,还可能是一个单词,因此返回的corpus仅处理为单个列表,而不是使用多词元列表构成的一个列表