相关文章:

Ollama教程——入门:开启本地大型语言模型开发之旅

Ollama教程——模型:如何将模型高效导入到ollama框架

Ollama教程——兼容OpenAI API:高效利用兼容OpenAI的API进行AI项目开发

Ollama教程——使用langchain:ollama与langchain的强强联合

Ollama教程——使用langchain:ollama与langchain的强强联合

- 简介

- 背景知识

- ollama简介

- langchain简介

- 结合使用的重要性

- 环境搭建

- 安装LangChain

- 安装ollama

- 环境设置

- 加载文档

- 使用WebBaseLoader加载《奥德赛》

- 文档处理

- 分割文档

- 向模型提问

- 构建查询

- 使用文档内容进行查询

- 创建嵌入和使用向量数据库

- 实施检索与问答

- 实战应用

- 检索与问答链

- 优化技巧

- 结论

简介

在当今技术迅速发展的时代,利用最新的人工智能技术来处理复杂的数据和文档成为了开发者们追求的目标。ollama和langchain作为两个强大的工具,能够帮助我们更加高效地完成这项任务。本文将深入探讨如何将ollama与langchain结合使用,通过一个具体的示例——处理和理解《奥德赛》这一经典文献——来展示其强大的实战应用能力。本文适合具有一定编程经验的中高级开发者,旨在通过丰富的技术细节和实战代码,帮助读者掌握这两个工具的高效结合使用方法。

背景知识

ollama简介

ollama是一个基于LLM(Large Language Model,大型语言模型)的工具,专为提高开发者与模型交互效率而设计。通过提供简洁的API接口,ollama使得开发者能够轻松地将复杂的自然语言处理任务委托给底层的语言模型。

langchain_20">langchain简介

langchain是一个旨在简化和加速语言模型应用开发的框架。它提供了一系列的工具和接口,帮助开发者更加高效地构建、测试和部署基于语言模型的应用。

结合使用的重要性

单独使用ollama或langchain已经能够为开发者带来很多便利,但将两者结合使用则能够发挥出更大的潜力。通过ollama,开发者可以轻松地调用语言模型来处理自然语言任务;而langchain则提供了一系列工具来管理这些任务的输入输出、文档加载、文本分割等复杂过程。结合使用两者,开发者可以在更短的时间内完成更加复杂的任务,提高开发效率和应用性能。

环境搭建

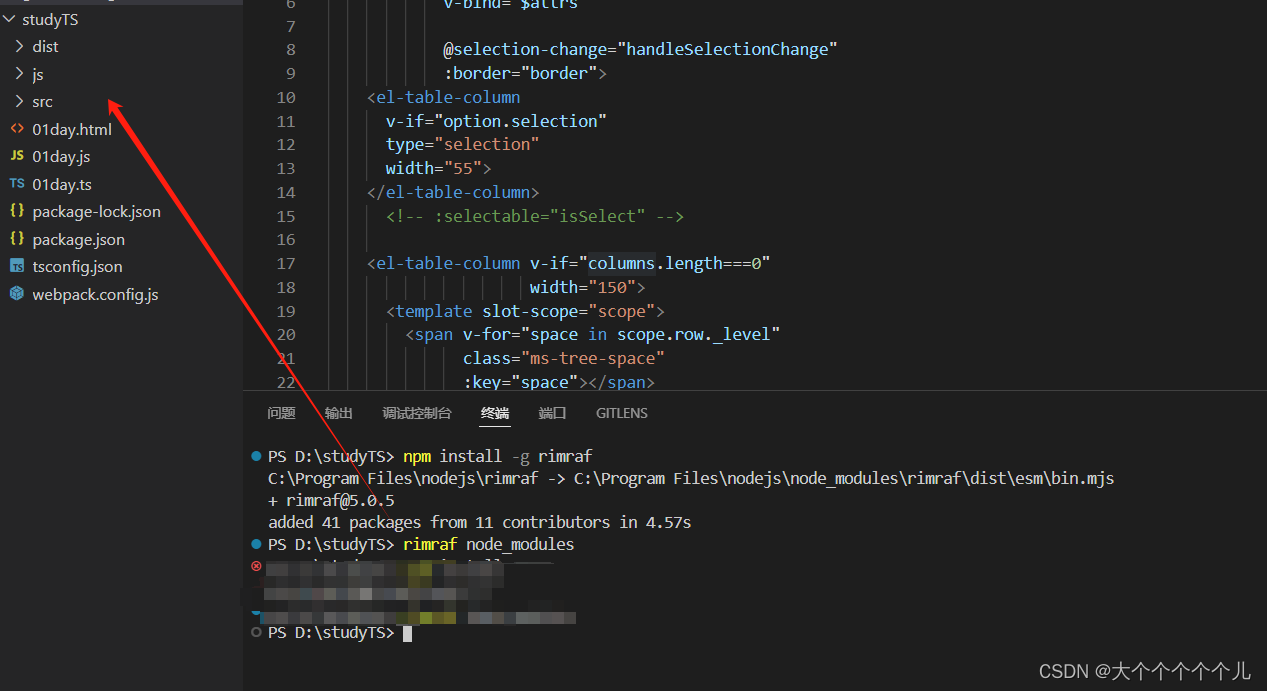

在深入探讨如何结合使用ollama与langchain之前,我们首先需要设置一个适合进行开发的环境。这一节将指导你完成安装langchain、ollama所需的库以及环境设置的过程。

安装LangChain

LangChain是一个开源框架,它简化了语言模型的应用开发流程。要开始使用LangChain,首先需要通过Python的包管理工具pip进行安装:

pip install langchain

这条命令会安装LangChain及其依赖。确保你的开发环境中已经安装了Python和pip。

安装ollama

ollama是作为LangChain的一部分集成的,所以不需要单独安装ollama。但是,使用ollama进行开发时,你可能需要安装其他的依赖库,比如bs4,用于处理Web文档加载:

pip install bs4

确保这些依赖项根据你的项目需求被正确安装。

环境设置

在进行下一步之前,我们需要确保ollama的服务已经启动并可以通过指定的URL访问。通常,这涉及到运行ollama的服务端实例,并确保它监听在你打算使用的端口上。在本教程中,我们假设ollama的服务端已经在本地运行,并且监听在http://localhost:11434上。

现在,你的开发环境应该已经准备就绪,接下来我们将进入实际的开发流程。

加载文档

在本教程中,我们以《奥德赛》为例,演示如何加载外部文档并准备它们以便于ollama和langchain进行处理。

使用WebBaseLoader加载《奥德赛》

首先,我们需要获取《奥德赛》的文本。这里,我们使用Project Gutenberg上的版本。为了从网页上加载文本,我们将使用LangChain提供的WebBaseLoader:

from langchain.document_loaders import WebBaseLoader# 指定《奥德赛》在Project Gutenberg上的URL

odyssey_url = "https://www.gutenberg.org/files/1727/1727-h/1727-h.htm"# 实例化WebBaseLoader并加载文档

loader = WebBaseLoader(odyssey_url)

data = loader.load()

这段代码将从给定的URL加载《奥德赛》的全文。由于Web文档通常包含HTML标记,WebBaseLoader会自动处理这些标记,仅保留文本内容。

文档处理

由于《奥德赛》的全文很长,我们需要将其分割成更小的部分,以适应ollama模型的处理能力。

分割文档

我们将使用LangChain的RecursiveCharacterTextSplitter来分割文档:

from langchain.text_splitter import RecursiveCharacterTextSplitter# 实例化文本分割器,设置每块的字符数

text_splitter = RecursiveCharacterTextSplitter(chunk_size=500, chunk_overlap=0)# 分割文档

all_splits = text_splitter.split_documents(data)

这将产生一系列小于或等于500字符的文本块,它们可以被ollama模型单独处理。chunk_overlap参数设置为0意味着文本块之间没有重叠,你可以根据需要调整这个值以改善结果的连贯性。

向模型提问

在文档被正确加载和分割之后,下一步是如何有效地向模型提出问题,并获取有用的答案。这一节将通过具体的代码示例,演示如何构建问题并利用ollama模型进行查询。

构建查询

为了从《奥德赛》文档中获取特定信息,我们需要向ollama模型提出清晰且具体的问题。例如,我们想知道“Neleus是谁,以及他的家庭成员有哪些”。首先,我们需要确保ollama模型已经就绪,并可通过指定的URL进行访问:

from langchain.llms import Ollama# 实例化ollama模型

ollama = Ollama(base_url='http://localhost:11434', model="llama2")

然后,我们可以直接使用ollama对象来提出问题:

# 向ollama提问

response = ollama("Who is Neleus and who are in Neleus' family?")

print(response)

这段代码将输出模型对于这个问题的回答。但由于我们还没有将《奥德赛》的内容与此查询相结合,这个回答可能不会直接基于文档内容。

使用文档内容进行查询

为了让ollama模型能够基于《奥德赛》的内容来回答问题,我们需要结合之前分割的文档块进行查询。这一步骤涉及到将文档块转换为向模型查询时可以使用的格式,以及确保查询针对的是与问题最相关的文档块。

创建嵌入和使用向量数据库

我们将使用ollama创建文档块的嵌入,并将这些嵌入存储在向量数据库中,以便进行高效的相似性搜索:

from langchain.embeddings import OllamaEmbeddings

from langchain.vectorstores import Chroma# 实例化嵌入模型

oembed = OllamaEmbeddings(base_url="http://localhost:11434", model="nomic-embed-text")# 使用文档块创建向量数据库

vectorstore = Chroma.from_documents(documents=all_splits, embedding=oembed)

这段代码将所有文档块的嵌入存储在Chroma向量数据库中,使我们能够根据问题的嵌入找到最相关的文档块。

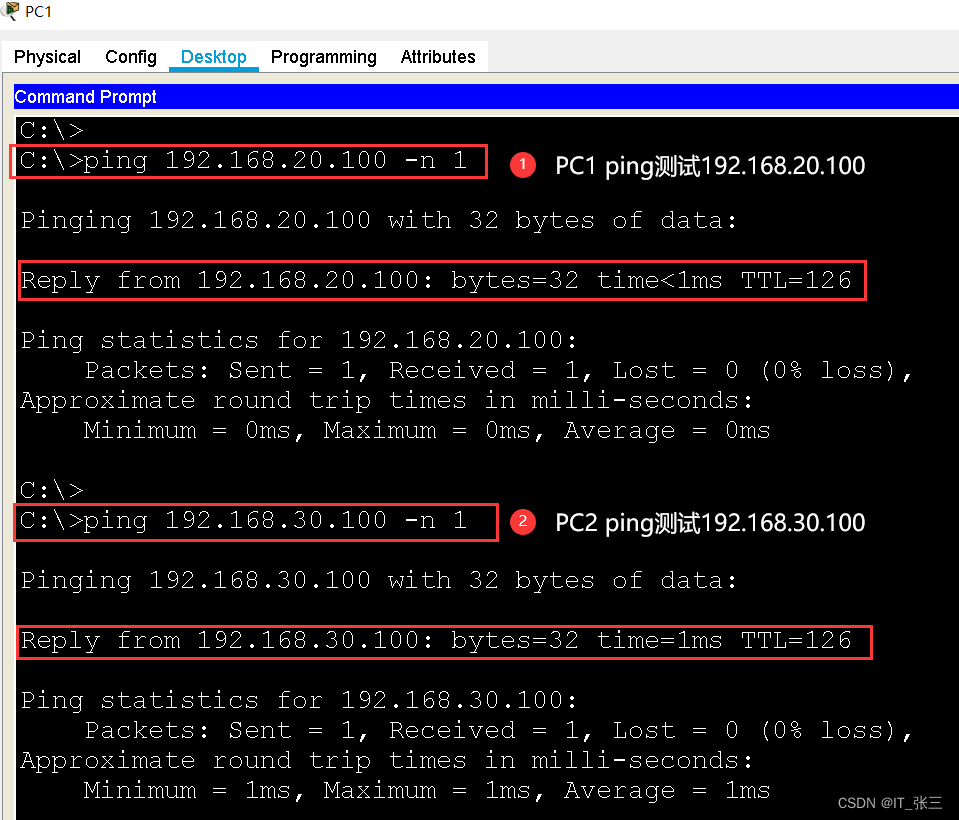

实施检索与问答

有了向量数据库之后,我们就可以进行相似性搜索,找到与提出的问题最相关的文档块:

# 执行相似性搜索

question = "Who is Neleus and who are in Neleus' family?"

docs = vectorstore.similarity_search(question)# 显示匹配文档块的数量

print(len(docs))

这将输出与问题最相关的文档块数量。然后,我们需要将这些文档块及问题一同提交给模型,获取答案。

实战应用

检索与问答链

要将检索和问答过程结合起来,我们需要定义一个检索问答链(RetrievalQA):

from langchain.chains import RetrievalQA# 实例化检索问答链

qachain = RetrievalQA.from_chain_type(ollama, retriever=vectorstore.as_retriever())# 执行查询并获取答案

answer = qachain.invoke({"query": question})

print(answer)

这个检索问答链首先基于问题的嵌入找到最相关的文档块,然后将这些文档块作为上下文,结合问题一起提交给ollama模型,以获取更加准确的答案。

优化技巧

- 增加文本块重叠:通过增加文本块之间的重叠,可以提高文档块

之间的连贯性,有助于提高回答的准确性。

- 调整嵌入模型参数:根据具体的查询需求,调整嵌入模型的参数可能会改善嵌入的质量,从而提高检索的相关性。

结论

通过结合使用ollama与langchain,开发者可以在处理复杂文档和执行自然语言处理任务时,实现更高的效率和准确性。本文通过《奥德赛》这一实例,展示了如何有效地加载文档、进行文本处理、构建问题以及实施检索问答,为开发者提供了一种强大的工具组合。未来,随着技术的不断进步,这种结合使用的模式有望在更多领域发挥重要作用,为处理更加复杂的问题提供解决方案。