大模型微调实战之强化学习 贝尔曼方程及价值函数

强化学习(RL)是机器学习中一个话题,不仅在人工智能方面。它解决问题的方式与人类类似,我们每天都在学习并在生活中变得更好。

作为一名大模型学习者,当开始深入研究强化学习时,需花了一些时间来了解幕后发生的事情,因为它与传统的机器学习技术相比往往有所不同。这篇文章将帮助你了解 强化学习算法的组成部分以及如何利用它们来解决 RL 问题。

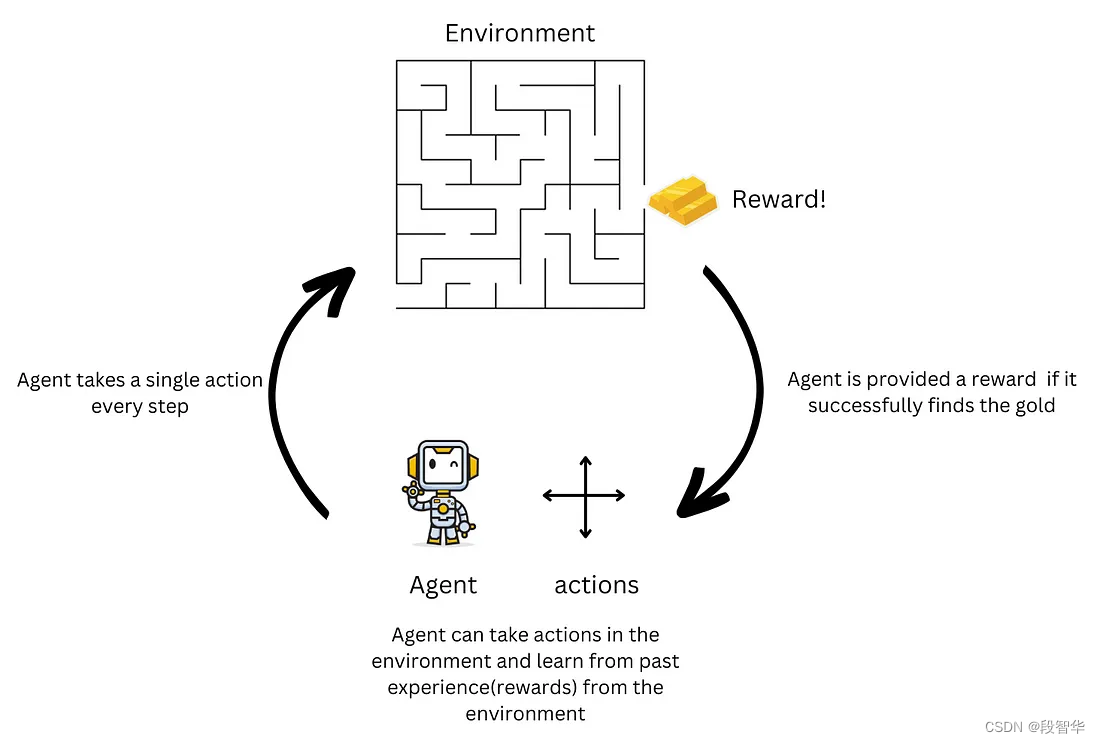

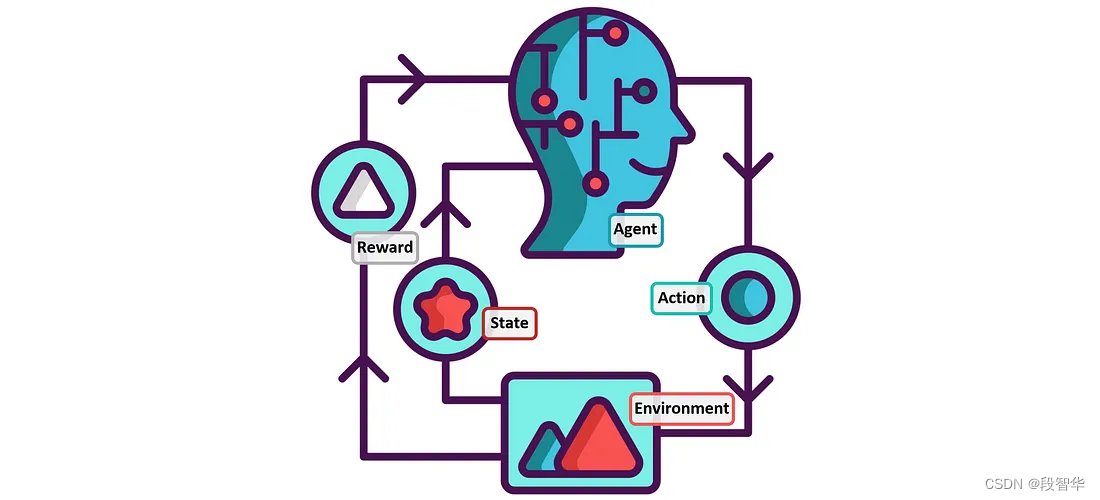

强化学习问题由代理和环境组成。代理有一组操作可供选择。代理通过选择动作与环境交互。设计的环境必须为其内采取的操作提供反馈。这种反馈可以称为奖励,奖励可以是正的,也可以是负的,具体取决于所选操作的好坏。

一个简单的强化学习问题可以如图所示表示。代理具有一组可以在环境中移动的操作。环境是一个简单的迷宫,只有一个入口和出口,奖励位于出口处。代理的目标是找到通往黄金的道路并获得奖励。然后,智能体可以从环境中过去的经验中学习,以更好地寻找黄金。

随着智能体从环境中积累经验和奖励,它逐渐学会根据获得的奖励贪婪地行动。这使得它能够选择在环境中产生最大奖励的最佳行动。

强化学习的组成部分

- 奖励:奖励(R)可以表示为来自环境的标量反馈,该反馈反映了代理在给定时间步长的环境中的表现。

- 状态:状态 (S) 提供有关代理在环境中的位置的信息。

- 动作:代理可以选择的动作集 (A)。

- 策略:它保存代理的行为。它将动作映射到状态。

- 价值函数:它是对给定代理所处状态的未来预期奖励的预测。可以用来评价一个状态的好坏。

- 代理:可以选择在环境中采取的操作的函数或类。它由策略和 RL 算法组成,用于从过去的经验中学习。

- 环境:可以输入代理动作并执行问题计算以解决并返回奖励的函数或类。

有限马尔可夫决策过程

一旦你对强化学习的组成部分有了充分的理解,就可以开始学习马尔可夫决策过程(通常称为(Markov Decision Process, MDP) 。 MDP 是构建 RL 问题的基础构建块。

在一个环境中,所有状态S都必须遵守马尔可夫性质。如果状态S内采取的行动完全取决于当前状态S以及预期的未来状态和要获得的预期奖励,而不是过去访问的状态,则状态S被认为是马尔可夫状态。这些状态的集合称为马尔可夫过程。

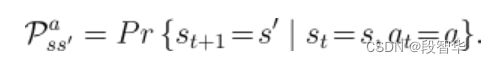

整个过程涉及智能体遍历不同的状态,环境的所有状态都遵循马尔可夫性质。这个过程称为马尔可夫决策过程。有限MDP对于构建和理解近 90% 的强化学习问题具有重要意义。它可以定义如下:给定环境中状态S和动作A的有限集合,执行动作A时,环境中从状态S ( t )到S ( t +1)的每个步骤都存在特定的概率

马尔可夫决策过程的简单示例:

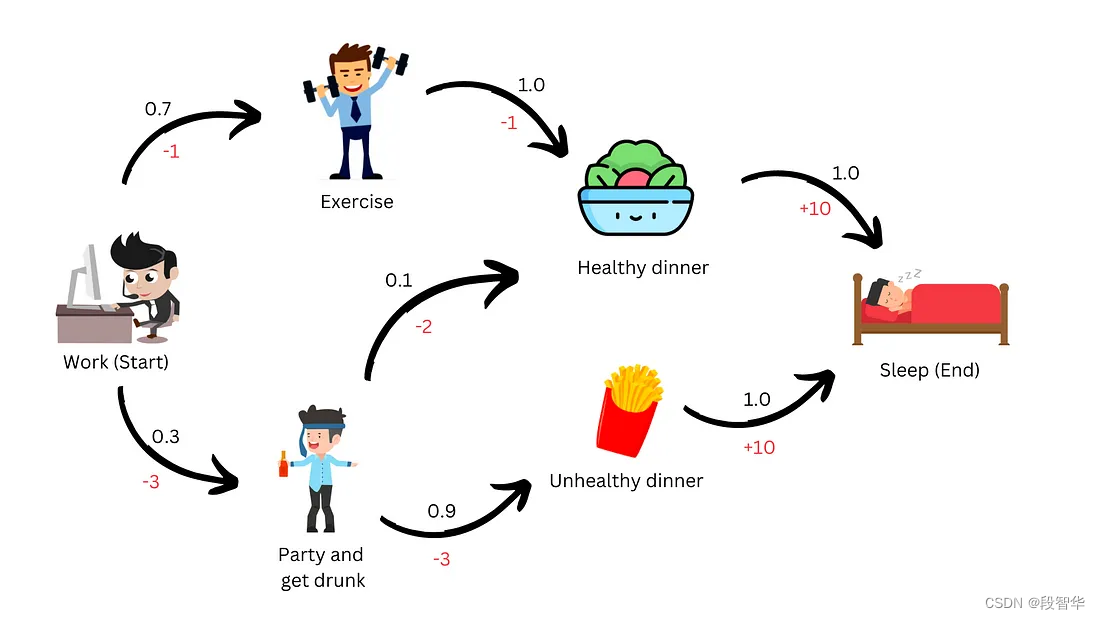

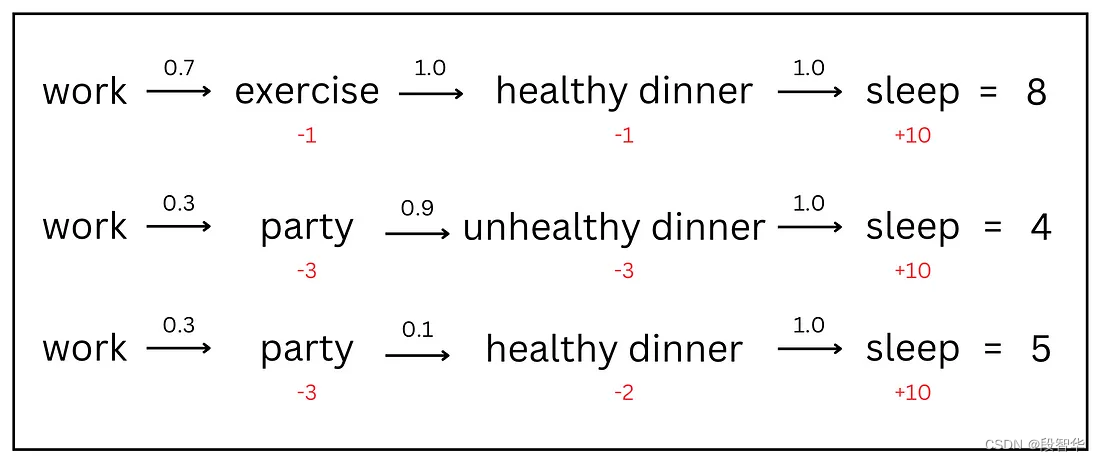

IT 员工生命中的一天可以表示为一个简单的 马尔可夫决策过程,具有员工访问的不同状态,每个状态的转移概率为黑色,奖励为红色。

通过例子更好地理解概念。这个简单的示例可以让你深入了解如何从日常经验中导出基本的 马尔可夫决策过程。将自己想象为一名 IT 员工,从在办公室工作开始新的一天。轮班结束后,你面临一个决定:要么去健身房,要么出去社交和聚会。一旦你在健身房完成锻炼,你就会有动力健康饮食并睡个好觉。聚会后,你可以选择吃不健康或健康的食物。可以为员工访问的所有不同情况(状态)分配概率和奖励。从这个简单的 马尔可夫决策过程 中导出一些马尔可夫过程。

通过考虑各种转移概率, 可以构建从“工作”状态开始到“睡眠”状态结束的特定马尔可夫过程。在这个过程中, 可以将总奖励加起来。大家就了解了员工在不同状态下如何获得奖励,以及哪些后续状态会带来更大的奖励。通过对此类奖励采取贪婪行动,员工可以学会在 马尔可夫决策过程 中获得最大奖励。

大模型技术分享

《企业级生成式人工智能LLM大模型技术、算法及案例实战》线上高级研修讲座

模块一:Generative AI 原理本质、技术内核及工程实践周期详解

模块二:工业级 Prompting 技术内幕及端到端的基于LLM 的会议助理实战

模块三:三大 Llama 2 模型详解及实战构建安全可靠的智能对话系统

模块四:生产环境下 GenAI/LLMs 的五大核心问题及构建健壮的应用实战

模块五:大模型应用开发技术:Agentic-based 应用技术及案例实战

模块六:LLM 大模型微调及模型 Quantization 技术及案例实战

模块七:大模型高效微调 PEFT 算法、技术、流程及代码实战进阶

模块八:LLM 模型对齐技术、流程及进行文本Toxicity 分析实战

模块九:构建安全的 GenAI/LLMs 核心技术Red Teaming 解密实战

模块十:构建可信赖的企业私有安全大模型Responsible AI 实战

Llama3Responsible_AI_83">Llama3关键技术深度解析与构建Responsible AI、算法及开发落地实战

1、Llama开源模型家族大模型技术、工具和多模态详解:学员将深入了解Meta Llama 3的创新之处,比如其在语言模型技术上的突破,并学习到如何在Llama 3中构建trust and safety AI。他们将详细了解Llama 3的五大技术分支及工具,以及如何在AWS上实战Llama指令微调的案例。

2、解密Llama 3 Foundation Model模型结构特色技术及代码实现:深入了解Llama 3中的各种技术,比如Tiktokenizer、KV Cache、Grouped Multi-Query Attention等。通过项目二逐行剖析Llama 3的源码,加深对技术的理解。

3、解密Llama 3 Foundation Model模型结构核心技术及代码实现:SwiGLU Activation Function、FeedForward Block、Encoder Block等。通过项目三学习Llama 3的推理及Inferencing代码,加强对技术的实践理解。

4、基于LangGraph on Llama 3构建Responsible AI实战体验:通过项目四在Llama 3上实战基于LangGraph的Responsible AI项目。他们将了解到LangGraph的三大核心组件、运行机制和流程步骤,从而加强对Responsible AI的实践能力。

5、Llama模型家族构建技术构建安全可信赖企业级AI应用内幕详解:深入了解构建安全可靠的企业级AI应用所需的关键技术,比如Code Llama、Llama Guard等。项目五实战构建安全可靠的对话智能项目升级版,加强对安全性的实践理解。

6、Llama模型家族Fine-tuning技术与算法实战:学员将学习Fine-tuning技术与算法,比如Supervised Fine-Tuning(SFT)、Reward Model技术、PPO算法、DPO算法等。项目六动手实现PPO及DPO算法,加强对算法的理解和应用能力。

7、Llama模型家族基于AI反馈的强化学习技术解密:深入学习Llama模型家族基于AI反馈的强化学习技术,比如RLAIF和RLHF。项目七实战基于RLAIF的Constitutional AI。

8、Llama 3中的DPO原理、算法、组件及具体实现及算法进阶:学习Llama 3中结合使用PPO和DPO算法,剖析DPO的原理和工作机制,详细解析DPO中的关键算法组件,并通过综合项目八从零开始动手实现和测试DPO算法,同时课程将解密DPO进阶技术Iterative DPO及IPO算法。

9、Llama模型家族Safety设计与实现:在这个模块中,学员将学习Llama模型家族的Safety设计与实现,比如Safety in Pretraining、Safety Fine-Tuning等。构建安全可靠的GenAI/LLMs项目开发。

10、Llama 3构建可信赖的企业私有安全大模型Responsible AI系统:构建可信赖的企业私有安全大模型Responsible AI系统,掌握Llama 3的Constitutional AI、Red Teaming。

解码Sora架构、技术及应用

一、为何Sora通往AGI道路的里程碑?

1,探索从大规模语言模型(LLM)到大规模视觉模型(LVM)的关键转变,揭示其在实现通用人工智能(AGI)中的作用。

2,展示Visual Data和Text Data结合的成功案例,解析Sora在此过程中扮演的关键角色。

3,详细介绍Sora如何依据文本指令生成具有三维一致性(3D consistency)的视频内容。 4,解析Sora如何根据图像或视频生成高保真内容的技术路径。

5,探讨Sora在不同应用场景中的实践价值及其面临的挑战和局限性。

二、解码Sora架构原理

1,DiT (Diffusion Transformer)架构详解

2,DiT是如何帮助Sora实现Consistent、Realistic、Imaginative视频内容的?

3,探讨为何选用Transformer作为Diffusion的核心网络,而非技术如U-Net。

4,DiT的Patchification原理及流程,揭示其在处理视频和图像数据中的重要性。

5,Conditional Diffusion过程详解,及其在内容生成过程中的作用。

三、解码Sora关键技术解密

1,Sora如何利用Transformer和Diffusion技术理解物体间的互动,及其对模拟复杂互动场景的重要性。

2,为何说Space-time patches是Sora技术的核心,及其对视频生成能力的提升作用。

3,Spacetime latent patches详解,探讨其在视频压缩和生成中的关键角色。

4,Sora Simulator如何利用Space-time patches构建digital和physical世界,及其对模拟真实世界变化的能力。

5,Sora如何实现faithfully按照用户输入文本而生成内容,探讨背后的技术与创新。

6,Sora为何依据abstract concept而不是依据具体的pixels进行内容生成,及其对模型生成质量与多样性的影响。