自然语言引导下的单目深度估计:泛化能力与鲁棒性的新挑战

- 一、自然语言引导下的单目深度估计进展

- 二、泛化能力与鲁棒性的挑战

- 三、评估方法与实验验证

- 四、代码实例与未来展望

在人工智能领域,单目深度估计一直是一个备受关注的热点问题。通过单张图片推断出场景中各点的深度信息,是计算机视觉中的一项关键任务。近年来,随着深度学习技术的飞速发展,单目深度估计领域取得了显著的进步。然而,一项最新的研究为我们揭示了这一领域中尚未被充分探索的一面——自然语言作为额外指导在单目深度估计中的应用及其带来的泛化能力和鲁棒性挑战。

一、自然语言引导下的单目深度估计进展

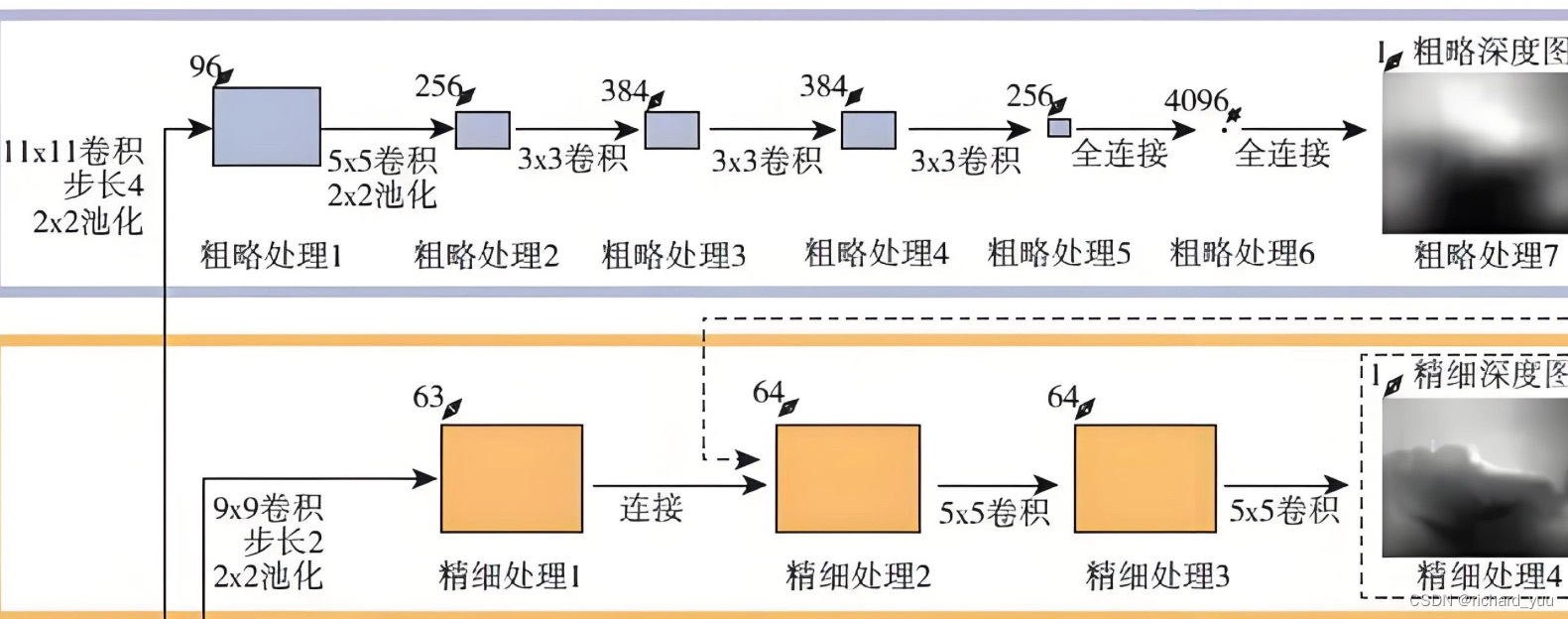

近期,研究人员在单目深度估计领域取得了令人印象深刻的成果,他们通过引入自然语言作为额外的指导信息,为深度估计任务提供了新的视角。这种方法的核心思想是利用自然语言描述的物体之间的三维空间关系,作为先验知识来辅助深度估计器的训练。通过生成描述物体中心的三维空间关系的“低级”句子,研究人员成功地将这些句子作为额外的语言先验,并评估了它们对深度估计的下游影响。

这种方法在理论上具有很大的潜力,因为它能够利用人类语言中的丰富信息来指导计算机视觉任务。然而,在实际应用中,研究人员发现了一些意想不到的问题。首先,他们发现当前的语言引导的深度估计器只有在使用场景级描述时才能表现最佳,而使用低级描述时的表现却出人意料地更差。这表明,在将自然语言转化为计算机视觉任务的有效指导时,我们需要更深入地理解语言和视觉之间的关联。

二、泛化能力与鲁棒性的挑战

尽管利用自然语言作为额外指导在单目深度估计中取得了令人瞩目的成果,但这种方法在泛化能力和鲁棒性方面面临着新的挑战。首先,由于自然语言的多样性和复杂性,生成的描述句子可能无法完全覆盖所有可能的场景和情况。这导致深度估计器在面对未知或罕见场景时可能出现泛化能力不足的问题。

其次,研究人员还发现,尽管利用了额外的数据,但这些方法对有针对性的对抗攻击并不具备鲁棒性。这意味着,攻击者可以通过精心设计的输入来欺骗深度估计器,使其产生错误的深度估计结果。这种脆弱性限制了自然语言引导下的单目深度估计器在实际应用中的可靠性。

此外,随着分布偏移的增加,这些方法的性能也会出现下降。在真实世界的应用中,由于光照、遮挡、噪声等因素的影响,输入的图片可能会与训练数据中的图片存在较大的差异。这种差异会导致深度估计器的性能下降,甚至完全失效。

三、评估方法与实验验证

为了量化自然语言先验对单目深度估计的影响并评估其在不同环境中的有效性,研究人员提出了一种新的评估方法。他们通过生成不同难度级别的描述句子,并将它们作为额外的语言先验输入到深度估计器中,来观察这些句子对深度估计结果的影响。

在实验验证方面,研究人员使用了多个标准数据集来测试他们的方法。他们发现,在使用场景级描述时,深度估计器的性能得到了显著提升;而使用低级描述时,性能则出现了下降。此外,他们还测试了这些方法对对抗攻击的鲁棒性以及在不同分布偏移下的性能表现。实验结果表明,尽管利用了额外的数据,但这些方法在面对有针对性的对抗攻击时仍然显得脆弱;并且随着分布偏移的增加,它们的性能也会逐渐下降。

四、代码实例与未来展望

以下是一个简单的代码实例,用于演示如何将自然语言描述作为额外指导信息输入到深度估计器中:

使用PyTorch框架来模拟这一过程:

pythonimport torch

import torch.nn as nn

import torchvision.transforms as transforms

from PIL import Image

from torchvision.models import resnet50

from transformers import BertTokenizer, BertModel# 假设我们有一个预训练的ResNet模型用于图像特征提取

class ImageFeatureExtractor(nn.Module):def __init__(self, pretrained=True):super(ImageFeatureExtractor, self).__init__()self.resnet = resnet50(pretrained=pretrained)self.resnet.fc = nn.Identity() # 移除全连接层,保留特征def forward(self, x):return self.resnet(x)# 假设我们有一个预训练的BERT模型用于文本特征提取

class TextFeatureExtractor(nn.Module):def __init__(self):super(TextFeatureExtractor, self).__init__()self.tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')self.bert = BertModel.from_pretrained('bert-base-uncased')def forward(self, text):inputs = self.tokenizer(text, return_tensors="pt", padding=True, truncation=True)outputs = self.bert(**inputs)# 使用BERT的最后一层隐藏状态作为文本特征return outputs.last_hidden_state[:, 0, :] # 取[CLS] token的表示作为句子表示# 假设我们有一个简单的深度估计器模型

class DepthEstimator(nn.Module):def __init__(self, image_feature_size, text_feature_size):super(DepthEstimator, self).__init__()self.fc = nn.Linear(image_feature_size + text_feature_size, 1) # 假设输出单个深度值def forward(self, image_feature, text_feature):combined_feature = torch.cat((image_feature, text_feature), dim=1)depth_prediction = self.fc(combined_feature)return depth_prediction# 实例化模型

image_extractor = ImageFeatureExtractor(pretrained=True)

text_extractor = TextFeatureExtractor()

depth_estimator = DepthEstimator(image_feature_size=2048, text_feature_size=768) # 假设ResNet和BERT的输出维度# 加载图像并预处理

image = Image.open('path_to_image.jpg')

transform = transforms.Compose([transforms.Resize(256),transforms.CenterCrop(224),transforms.ToTensor(),transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),

])

image_tensor = transform(image).unsqueeze(0) # 添加batch维度# 加载自然语言描述

text = "The car is in front of the building."

text_feature = text_extractor(text)# 提取图像特征

with torch.no_grad():image_feature = image_extractor(image_tensor)# 合并特征并预测深度

combined_feature = torch.cat((image_feature.squeeze(0), text_feature.unsqueeze(0)), dim=1)

depth_prediction = depth_estimator(combined_feature)print(f"Predicted depth: {depth_prediction.item()}")

请注意,上述代码是一个简化的示例,用于演示如何将自然语言描述和图像特征结合到深度估计任务中。在实际应用中,您可能需要调整模型架构、超参数和预处理方法,以适应您的特定任务和数据集。此外,为了处理多张图像和多个描述,您可能需要循环遍历数据并批处理输入。