一、安装软件

1.1 安装Ollama

你可以访问Ollama的官方网站https://ollama.com/download,选择适合你操作系统的安装包进行下载。老周这里是Mac系统,所以选择下载macOS系统。

1.2 安装cherry studio

前往官网https://cherry-ai.com/download下载对应操作系统的安装包

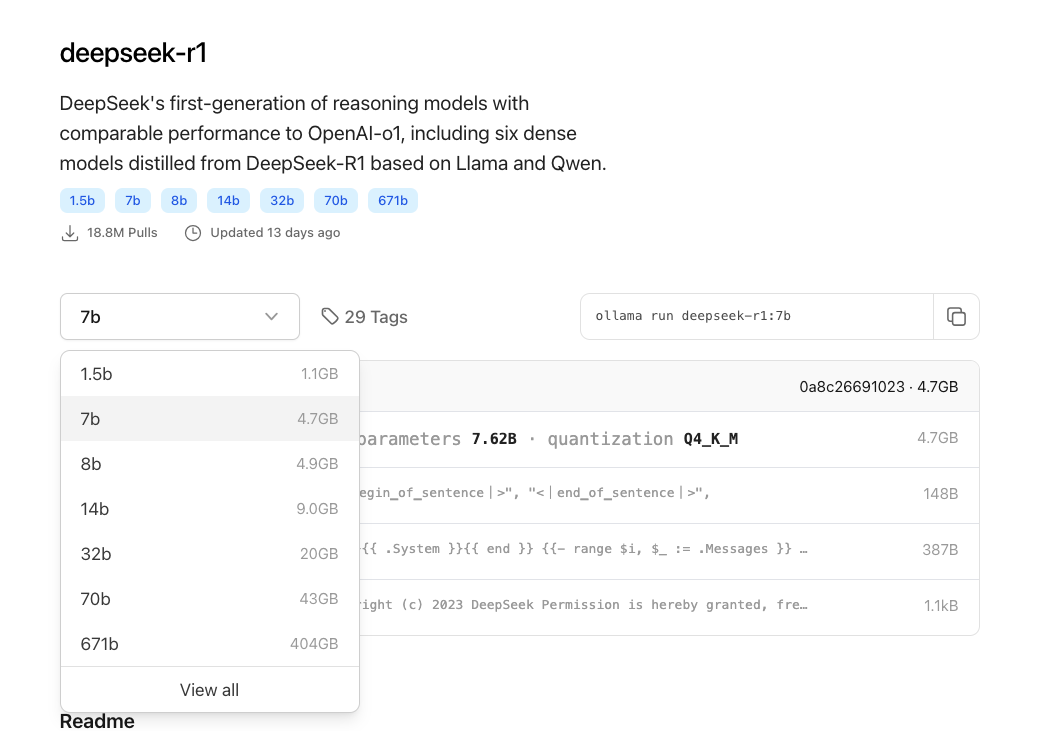

1.3 下载deepseek R1本地模型

直接前往Ollama官网:https://ollama.com/library/deepseek-r1

根据自己电脑的配置选择不同参数的模型,

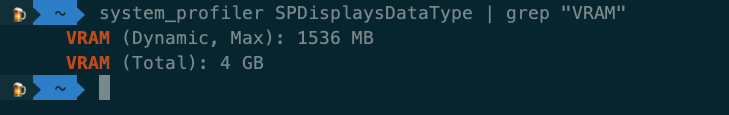

查下自己MAC电脑的显存:

system_profiler SPDisplaysDataType | grep "VRAM"

根据自己电脑的配置选择不同参数的模型。

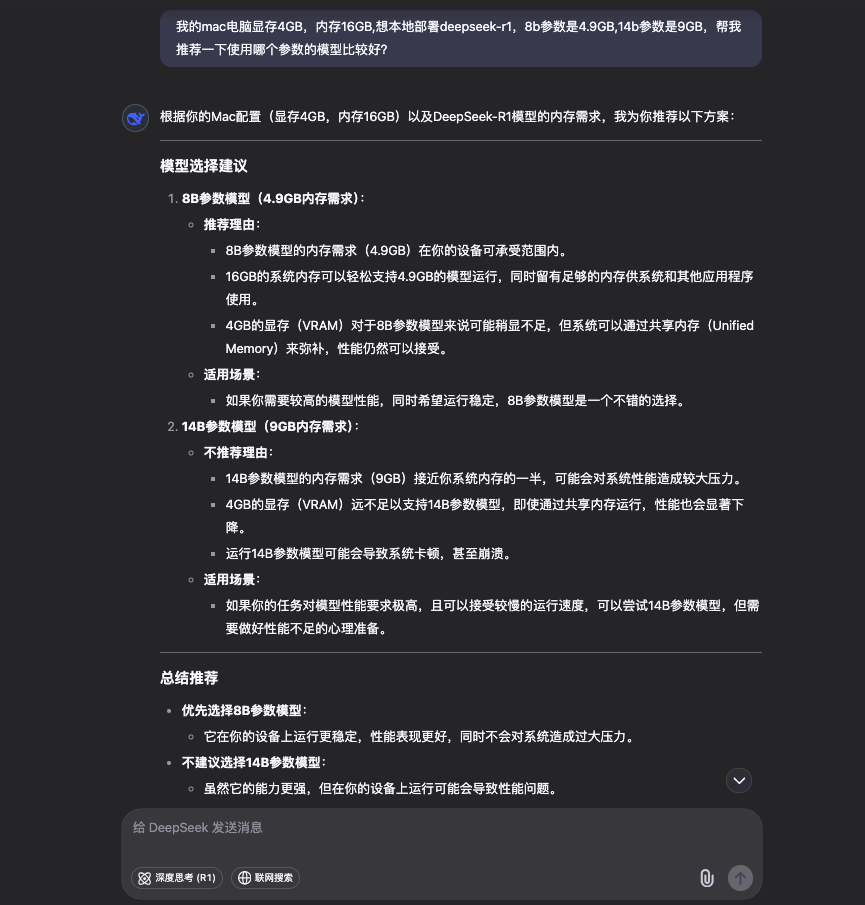

老周这里让 DeepSeek 帮我推荐使用哪个参数的模型。

根据推荐老周这里选择了8b参数的模型:

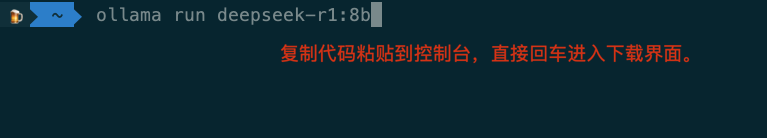

ollama run deepseek-r1:8b

打开终端(Mac OS)或运行(Windows,可以用win键+r快捷键弹出),粘贴刚刚复制的代码(ollama run deepseek-r1:8b)

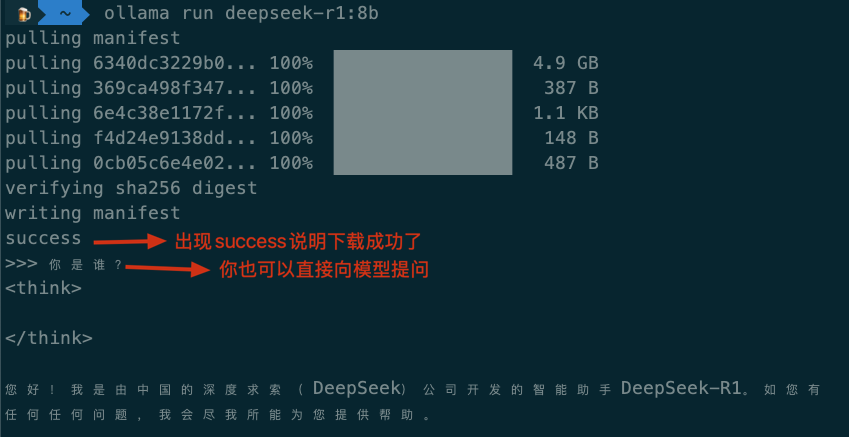

接下来可能有点慢,测你家网速的时候到了。

下载完成后,你已经可以直接使用Deepseek R1这个大模型了。不过,为了让大家有更好的体验,我特别推荐使用Cherry Studio这个工具。它不仅能调用你本地下载的模型,还可以连接各种云端模型服务,使用起来非常便捷。

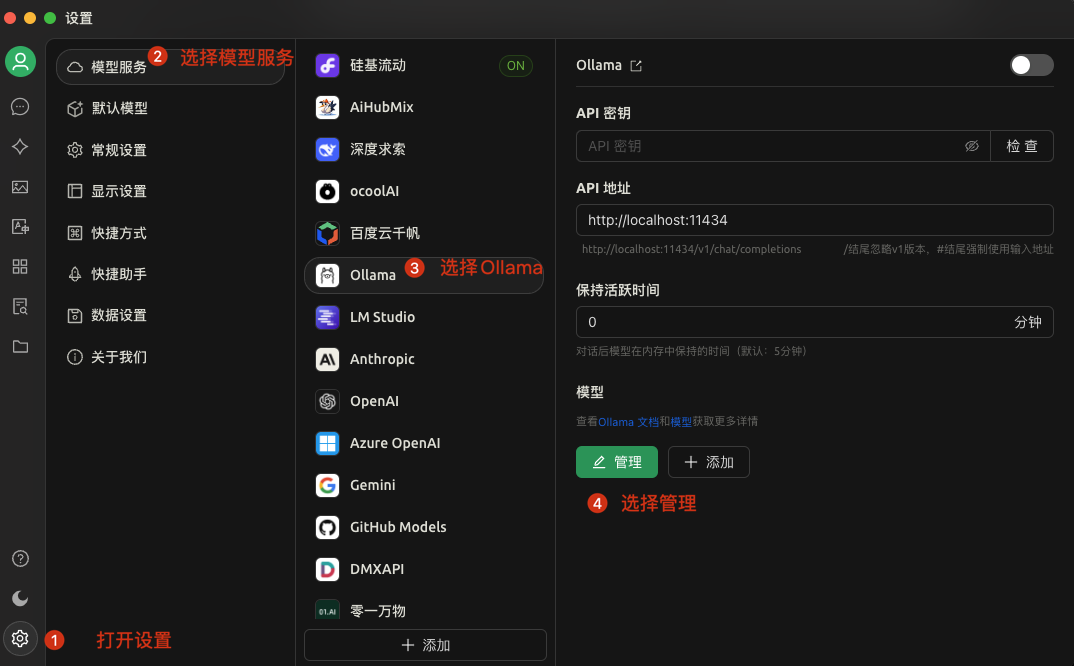

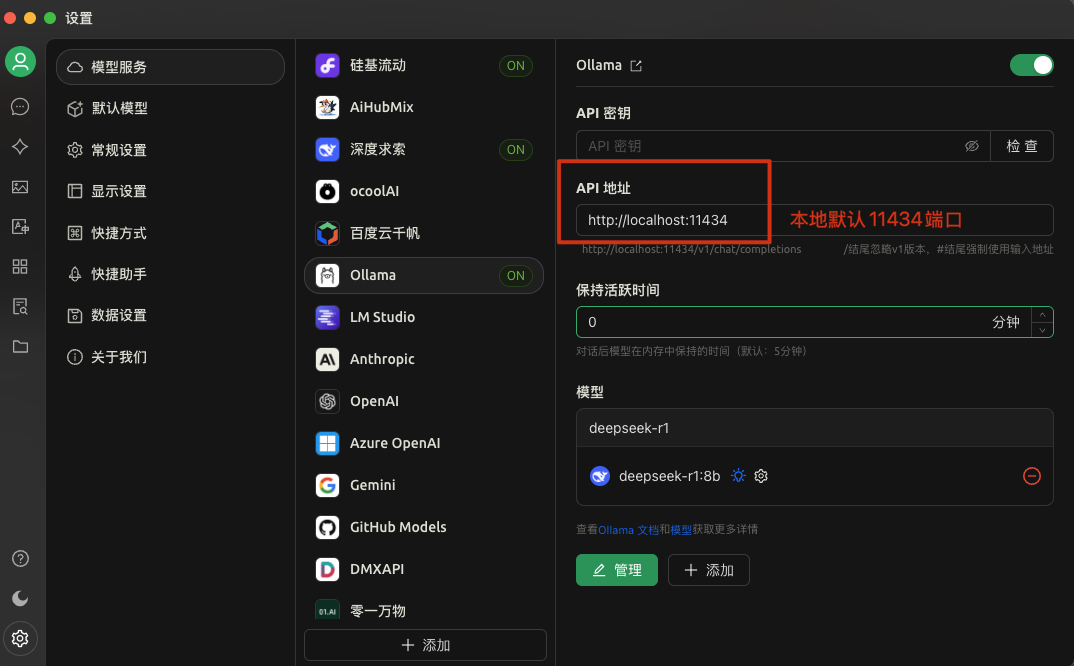

1.4 设置Cherry Studio

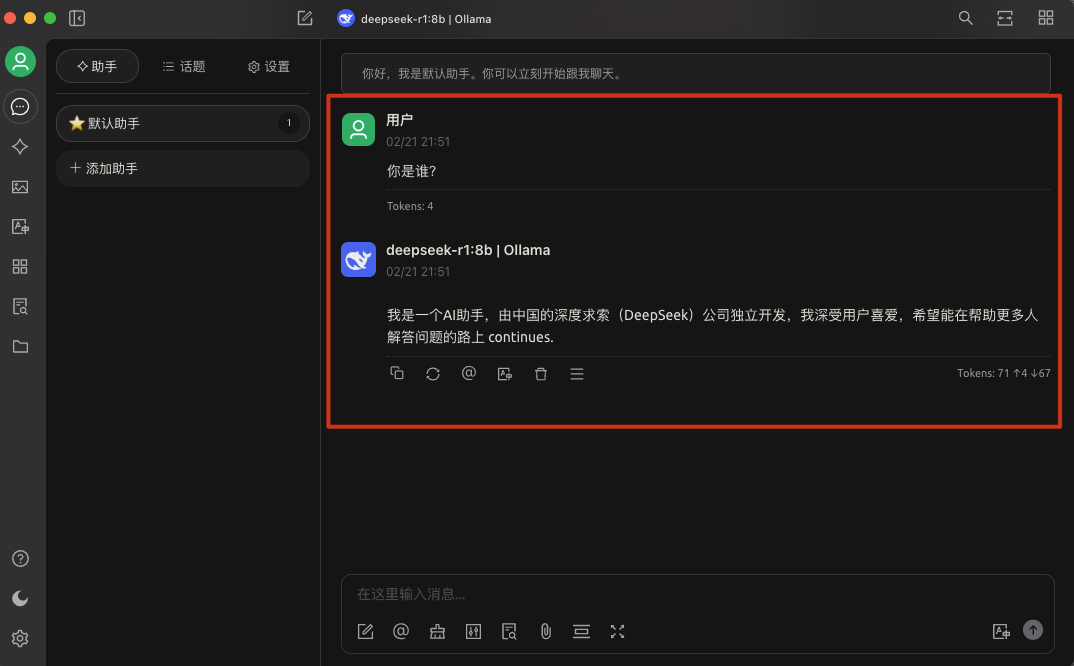

然后在聊天界面,选择你所要对话的大模型,就可以直接对话了。如果出现对话说明本地部署DeepSeek R1大模型成功了。如果出现404啥的说明你没有配置对API地址,检查下面这两个操作是否配置对了。

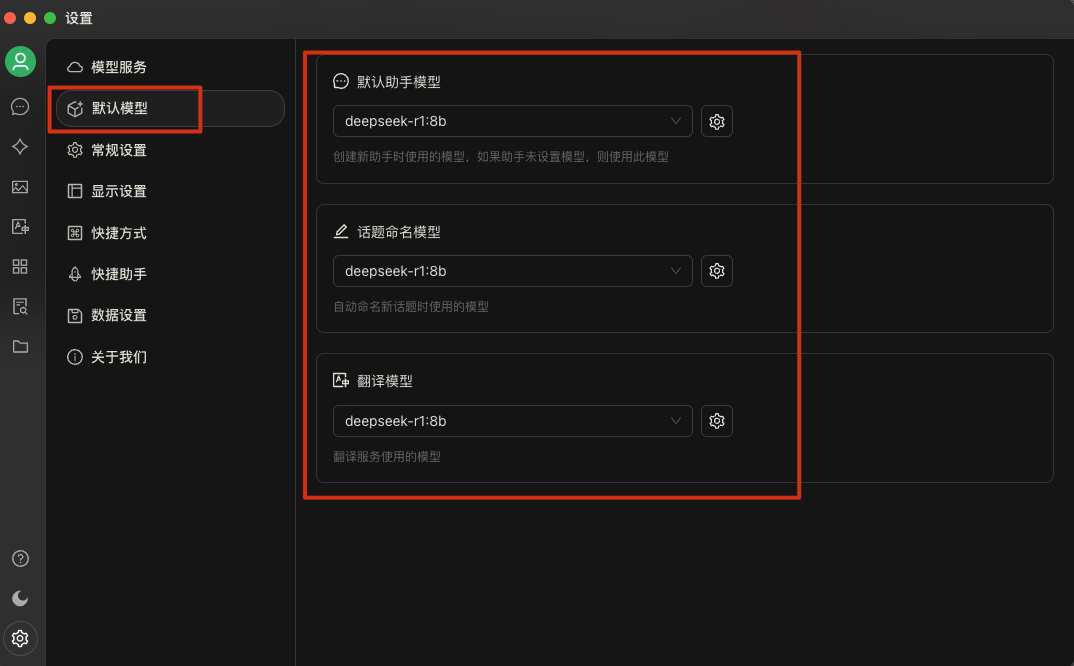

默认模型选择你下载好的模型~

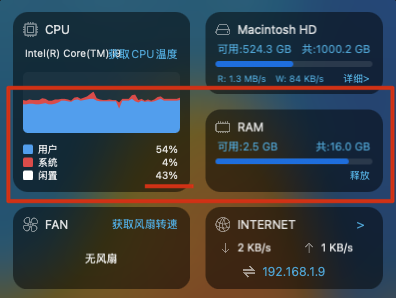

我让DeepSeek帮我安排一个行程,推理阶段吃掉我一半的CPU、内存也只省2G左右。