文章目录

- 💻 环境说明

- 🛠️ Ollama安装配置

- 1. 安装[Ollama](https://github.com/ollama/ollama)

- 2. 启动Ollama

- 3. 模型存储位置

- 4. 配置 Ollama

- 🌐 OpenWebUI部署

- 1. 安装Docker

- 2. 部署[OpenWebUI](https://www.openwebui.com/)(可视化大模型对话界面)

- 🔒 离线部署方案

- ⚡ 性能优化建议

- ❓ 常见问题

- 🎉 结语

想拥有一个完全属于自己的AI助手,还不依赖互联网?本教程带你从零开始搭建本地AI环境!(Apple Silicon架构)

💻 环境说明

| 配置项 | Mac | Windows |

|---|---|---|

| 操作系统 | macOS Sonoma | Windows 10/11 |

| CPU | M4 | 12核或以上 |

| 内存 | 16GB | 32GB或以上 |

| 硬盘空间 | 20GB | 20GB或以上 |

🛠️ Ollama安装配置

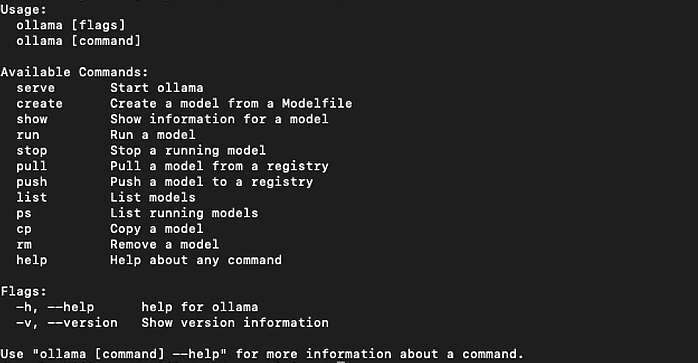

1. 安装Ollama

# 使用Homebrew安装

brew install ollama# 或直接下载安装包

curl https://ollama.ai/download/Ollama-darwin.zip -o Ollama.zip

unzip Ollama.zip# 输入`ollama`或 `ollama -v`验证安装

ollama

2. 启动Ollama

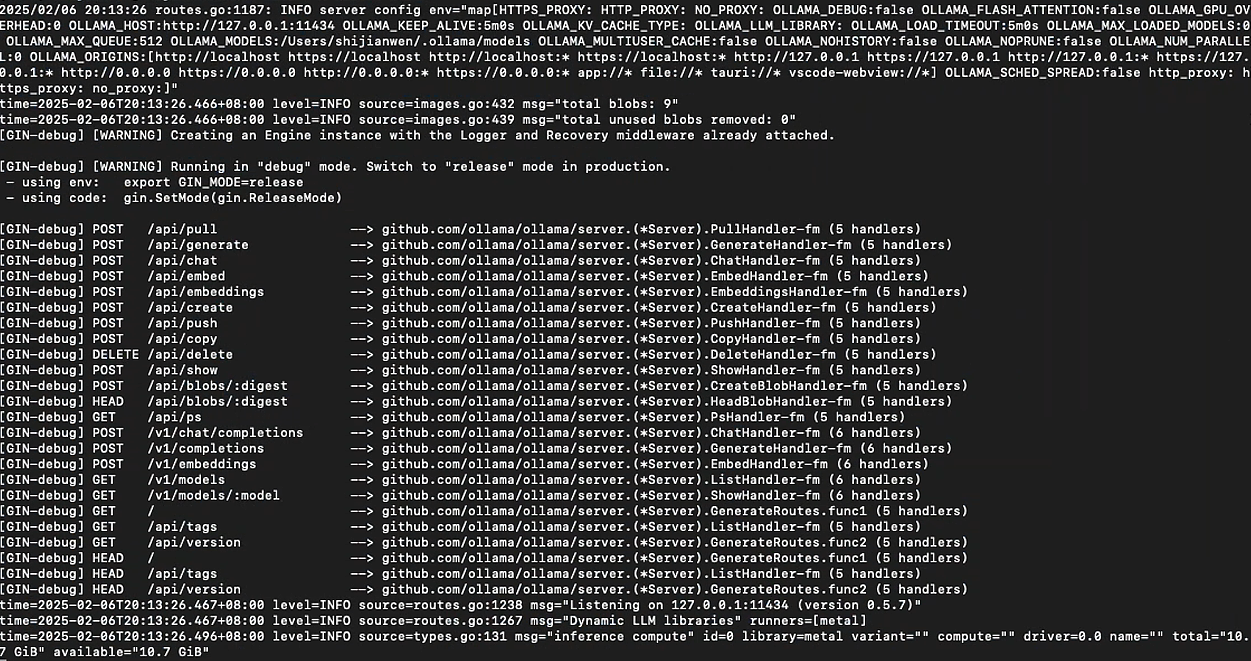

# 启动Ollama服务

ollama serve

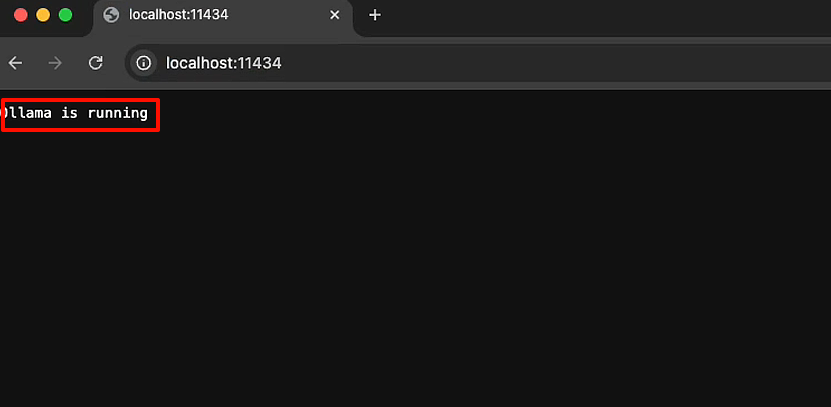

# 或点击浏览器访问:http://localhost:11434

显示Ollama is running代表已经运行起来了!

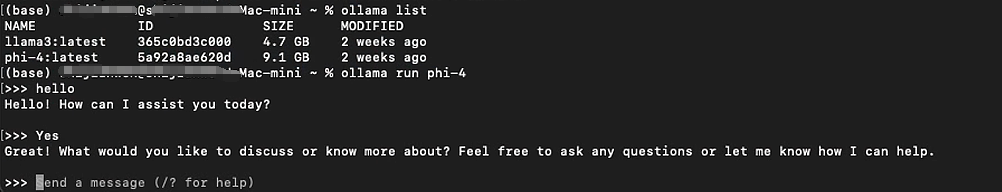

# 下载Llama3 8B模型

ollama run llama3:8b # 建议先尝试小模型

💡 小贴士:你应该至少有 8 GB 的 RAM 来运行 7B 模型,16 GB 的 RAM 来运行 13B 模型,以及 32 GB 的 RAM 来运行 33B 模型。

3. 模型存储位置

Mac下,Ollama的默认存储位置:

- 模型文件:

~/.ollama/models - 配置文件:

~/Library/Application Support/Ollama

Windows下,Ollama的默认存储位置:

- 程序目录:

C:\Users\<用户名>\AppData\Local\Programs\Ollama - 模型目录:

C:\Users\<用户名>\.ollamamodels - 配置文件:

C:\Users\<用户名>\AppData\Local\Ollama

💡 小贴士:建议通过环境变量OLLAMA_MODELS自定义模型存储路径,避免占用系统盘空间。

4. 配置 Ollama

Ollama 提供了多种环境变量以供配置:

- OLLAMA_DEBUG:是否开启调试模式,默认为 false。

- OLLAMA_FLASH_ATTENTION:是否闪烁注意力,默认为 true。

- OLLAMA_HOST:Ollama 服务器的主机地址,默认为空。

- OLLAMA_KEEP_ALIVE:保持连接的时间,默认为 5m。

- OLLAMA_LLM_LIBRARY:LLM 库,默认为空。

- OLLAMA_MAX_LOADED_MODELS:最大加载模型数,默认为 1。

- OLLAMA_MAX_QUEUE:最大队列数,默认为空。

- OLLAMA_MAX_VRAM:最大虚拟内存,默认为空。

- OLLAMA_MODELS:模型目录,默认为空。

- OLLAMA_NOHISTORY:是否保存历史记录,默认为 false。

- OLLAMA_NOPRUNE:是否启用剪枝,默认为 false。

- OLLAMA_NUM_PARALLEL:并行数,默认为 1。

- OLLAMA_ORIGINS:允许的来源,默认为空。

- OLLAMA_RUNNERS_DIR:运行器目录,默认为空。

- OLLAMA_SCHED_SPREAD:调度分布,默认为空。

- OLLAMA_TMPDIR:临时文件目录,默认为空。

- OLLAMA_DEBUG:是否开启调试模式,默认为 false。

- OLLAMA_FLASH_ATTENTION:是否闪烁注意力,默认为 true。

- OLLAMA_HOST:Ollama 服务器的主机地址,默认为空。

- OLLAMA_KEEP_ALIVE:保持连接的时间,默认为 5m。

- OLLAMA_LLM_LIBRARY:LLM 库,默认为空。

- OLLAMA_MAX_LOADED_MODELS:最大加载模型数,默认为 1。

- OLLAMA_MAX_QUEUE:最大队列数,默认为空。

- OLLAMA_MAX_VRAM:最大虚拟内存,默认为空。

- OLLAMA_MODELS:模型目录,默认为空。

- OLLAMA_NOHISTORY:是否保存历史记录,默认为 false。

- OLLAMA_NOPRUNE:是否启用剪枝,默认为 false。

- OLLAMA_NUM_PARALLEL:并行数,默认为 1。

- OLLAMA_ORIGINS:允许的来源,默认为空。

- OLLAMA_RUNNERS_DIR:运行器目录,默认为空。

- OLLAMA_SCHED_SPREAD:调度分布,默认为空。

- OLLAMA_TMPDIR:临时文件目录,默认为空。

🌐 OpenWebUI部署

1. 安装Docker

- 访问 Docker官网 下载Mac版本(Apple Silicon)

- 安装并启动Docker Desktop

- 配置国内镜像源加速下载(我这里

科学上网不需要)

💡 小贴士:Windows 安装 Docker 需要开启 Hyper-V(Windows专业版必需)

2. 部署OpenWebUI(可视化大模型对话界面)

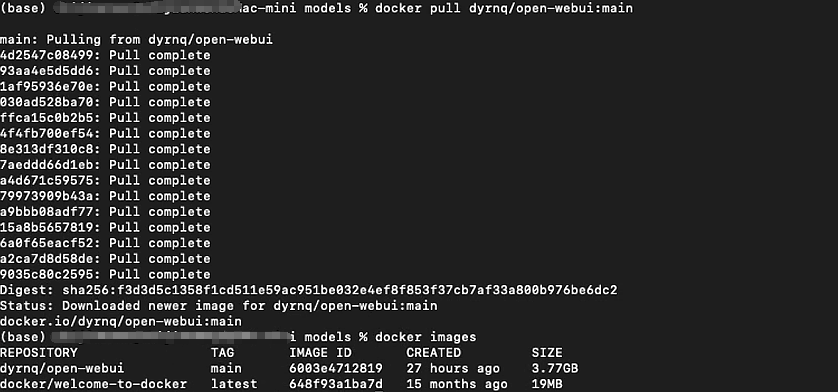

# 拉取镜像 (直接run默认会拉取 latest 标签的镜像)

docker pull ghcr.io/open-webui/open-webui:main#(官方文档)以上是从 GitHub Container Registry (GHCR) 上拉取镜像,而不是从 Docker Hub。

# 也可以docker hub 拉取 open-webui镜像

docker pull dyrnq/open-webui:main

# 启动容器

docker run -d -p 3000:8080 \--add-host=host.docker.internal:host-gateway \-v open-webui:/app/backend/data \--name open-webui \--restart always \ghcr.io/open-webui/open-webui:main

访问 http://localhost:3000 即可使用Web界面。

创建账号,这个是本地账号,随便添加账号信息即可

创建账号,这个是本地账号,随便添加账号信息即可

选择ollama中的模型,聊天测试

也可以在这里直接拉取模型

与下载的新模型进行对话

💡 小贴士:

- 注册时邮箱可以随便填写,设置密码后注意保存!

- ollama后台一定要运行着模型,如:ollama run phi-4

🔒 离线部署方案

如果需要在无网环境下部署,可以按照以下步骤操作:

-

在有网环境下准备资源:

- 下载Ollama安装包

- 导出模型文件

- 导出Docker镜像

-

离线环境部署:

- 安装Ollama

- 复制模型文件到指定目录

- 导入Docker镜像

- 启动OpenWebUI

⚡ 性能优化建议

-

内存管理

- 关闭不必要的后台应用

- 使用Activity Monitor监控内存使用

-

模型选择

- 建议从小模型开始测试

- 推荐模型大小顺序:

- qwen2:0.5b (最轻量)

- llama2:7b (平衡型)

- codellama:7b (代码专用)

-

温度控制

- 保持Mac Mini通风良好

- 可使用监控工具观察CPU温度

❓ 常见问题

-

Q: M4芯片能跑多大的模型?

A: 16GB内存的M4可以流畅运行8B参数的模型,更大的模型可能会影响性能。 -

Q: Llama中文支持不好怎么办?

A: 可以使用Llama-Chinese等经过中文优化的模型。 -

Q: OpenWebUI打不开怎么办?

A: 检查Docker状态:docker ps # 查看容器状态 docker logs open-webui # 查看日志

🎉 结语

通过本教程的配置,你已经拥有了一个完全本地化的AI助手!有任何问题欢迎在评论区讨论,让我们一起探索AI的无限可能!

如果觉得这篇文章对你有帮助,别忘了点赞转发哦~ 👍

你用Mac Mini跑过哪些AI模型?欢迎分享你的使用体验!💭