论文地址:Forging Vision Foundation Models for Autonomous Driving: Challenges, Methodologies, and Opportunitie

0 Abstract

论文摘要解读

这篇论文讨论了**大规模基础模型(Foundation Models)在人工智能(AI)领域的革命性影响,尤其是在自动驾驶(Autonomous Driving)中的应用,重点研究了视觉基础模型(Vision Foundation Models, VFMs)**的开发。

核心内容总结

-

背景:

- 大型基础模型(如 SAM、DALL-E2、GPT-4)因其在多任务中的适应性和高效性,正成为广泛AI应用的重要基石。

- 自动驾驶是AI的重要应用领域之一,但面临缺乏专用视觉基础模型的挑战。

-

主要挑战:

- 训练数据的稀缺性:需要更全面的数据支持。

- 多传感器集成:自动驾驶涉及多种传感器(如相机、激光雷达等)的数据融合。

- 任务多样性:不同任务需要定制的架构,增加了开发难度。

-

论文贡献:

- 系统性分析:通过分析超过250篇相关论文,详细探讨了VFM开发的核心技术,包括:

- 数据准备

- 预训练策略

- 下游任务适配

- 关键技术前沿:

- NeRF(神经辐射场)

- 扩散模型(Diffusion Models)

- 3D高斯分割(3D Gaussian Splatting)

- 世界模型(World Models)

- 研究路线图:提出了针对自动驾驶视觉基础模型开发的全面研究框架。

- 开源平台:构建了一个名为“Forge-VFM4AD”的开源库,为研究人员提供最新进展和资源。

- 系统性分析:通过分析超过250篇相关论文,详细探讨了VFM开发的核心技术,包括:

-

关键词:

- Vision Foundation Models, Data Generation, Self-supervised Training, Autonomous Driving, Literature Survey

潜在价值

- 这篇论文为研究人员提供了关于自动驾驶领域视觉基础模型开发的全面综述和方向建议。

- 提供了前沿技术的深入讨论,并通过开源平台帮助推进整个领域的发展。

1 Introduction

1. 引言(Introduction)

- 自动驾驶(Autonomous Driving,AD)技术的快速发展正在重新塑造交通领域,传统的感知系统依赖模块化架构,专注于特定任务(如目标检测、语义分割、深度估计等)。

- 传统模型通常为每个任务单独设计,使用深度学习进行训练。这种“分割”的方法会导致模型缺乏对整体上下文的理解,进而限制了系统处理长尾场景的能力。

- **基础模型(Foundation Models)**的出现(例如NLP领域的GPT-3/4)展示了通过少样本学习和自监督学习,能够广泛适应多种任务。

2. 基础模型在自动驾驶中的局限性

-

问题1:缺乏3D感知能力

现有基础模型大多针对2D数据或文本数据设计,无法有效利用自动驾驶领域中至关重要的3D信息(如深度估计)。 -

问题2:多模态数据融合困难

自动驾驶任务需要融合不同传感器的数据(例如LiDAR、摄像头、雷达等),现有模型很难高效处理多模态数据。 -

问题3:任务异质性与数据稀缺性

3. 应对挑战的希望与进展

- 数据稀缺性:通过持续数据收集和模拟技术(如鸟瞰图表示、BEV)等解决。

- 模型适配性:探索自监督学习、迁移学习、和统一的感知表示来应对多任务场景的需求。

4. 研究的主要贡献

- 提出统一开发框架: 针对自动驾驶的视觉基础模型,设计了从数据准备到自监督学习和模型适配的开发管道。

- 对现有工作进行分类和分析: 系统地分类现有技术,并提供深入比较。

- 聚焦挑战与未来方向: 调研超过250篇论文,提出关键领域的挑战及研究方向。

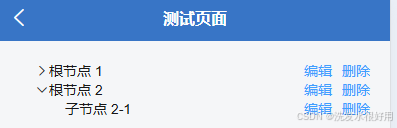

Fig. 1 Our survey at a glance. Background.

Fig. 1: 总览图解

这张图表和文字说明展示了关于为自动驾驶开发视觉基础模型(VFMs)的调研框架。整个调研覆盖了以下几个关键部分:

1. 背景(Background)

- 目标:

- 介绍基础模型(Foundation Models)的发展。

- 探讨在自动驾驶社区中,VFMs的多样化表示(Representations)和应用(Applications)。

- 内容:

- VFMs的基本概念及适配性。

- 自动驾驶领域独特的表征需求(如三维表示和语义分割)。

2. 数据准备(Data Preparation, Section 3)

- 数据是基础模型训练的核心:

- 提出大规模数据收集的挑战,尤其在自动驾驶领域。

- 涉及的生态系统包括真实道路采集(如Waymo、KITTI数据集)和模拟器(如CARLA)。

- 创新技术:

- 生成对抗网络(GAN): 用于数据生成和增强。

- 扩散模型(Diffusion Models): 提升数据多样性。

- 神经辐射场(NeRF): 构建三维场景。

- 3D高斯分布(3D Gaussian Splatting, 3DGS): 用于精确表示三维信息。

3. 预训练(Pre-training, Section 4)

- 自监督学习是探索的重点,包含以下方法:

- 基于重建(Reconstruction-based): 学习数据表示的基本结构。

- 基于对比(Contrastive-based): 通过对比样本增强特征学习。

- 基于渲染(Rendering-based): 对三维场景生成逼真渲染。

- 基于世界模型(World Model-based): 构建环境理解。

- 蒸馏方法(Distillation-based): 精简模型以提升效率。

4. 模型适配(Adaptation, Section 5)

- 目标:解决VFMs在自动驾驶领域的适配性问题。

- 适配方法:

- 应用其他领域训练的VFMs到自动驾驶任务。

- 涉及Meta的SAM模型、OpenAI的GPT-4V、CLIP、Flamingo等多模态模型。

- 探讨如何将这些模型优化用于自动驾驶中的多模态数据处理和任务要求。

调研总结

- 挑战的解决: 数据稀缺性、任务多样性、模型迁移等问题的应对方法。

- 技术框架: 覆盖了从数据准备、预训练到模型适配的整个流程。

- 贡献:

- 系统性分类与分析技术。

- 突出自监督学习的重要性。

- 将基础模型的跨领域迁移引入自动驾驶。

2 Background

关键要点

-

现有基础模型的概览:

- 探讨了目前在计算机视觉和其他领域中基础模型的发展现状,涵盖它们的主要技术特点和应用场景。

-

表征形式的演进:

- 随着技术的发展,自动驾驶的感知需求从早期的简单2D表示逐渐演变为更复杂的三维表示(如Bird’s Eye View, BEV),以满足复杂驾驶场景的处理需求。

-

自动驾驶感知中的常见任务:

2.1 Large Foundation Models

1. Large Language Models (LLMs, 大规模语言模型)

-

概述:

- 大规模语言模型(如GPT-3)基于海量的文本数据进行训练,推动了自然语言处理(NLP)的革命。

- 它们可以完成从文本生成、翻译到对话和问答等多种语言任务,表现出接近人类的流畅度。

-

最新发展:

- 例如,GPT-4(OpenAI, 2023)和PaLM(Chowdhery et al., 2022)等模型,进一步提升了模型的规模和语言理解能力。

- 开源模型如LLaMA/LLaMA2(Touvron et al., 2023)提供了从7亿到650亿参数的多样化选项。

- 多语言支持:模型如ChatGLM-6B和GLM-130B通过扩展多语言能力,展示了更强的迁移能力。

2. Vision Foundation Models (VFMs, 视觉基础模型)

-

概述:

- 受语言模型成功的启发,计算机视觉领域开发了类似的视觉基础模型。

- 例如,Vision Transformers (ViTs) 基于Transformer架构,处理视觉任务(如图像分类、分割)。

-

主要模型:

- DINO/DINOv2: 使用自监督学习和知识蒸馏,增强了特征学习能力。

- MAE、BEIT、CAE: 通过遮挡建模(Masked Modeling),提取通用的视觉特征。

- SAM (Segment Anything Model): 专注于图像分割,训练在大量数据集上(11亿图像和1.1亿分割掩码),展现出强大的零样本泛化能力。

3. Multimodal Foundation Models (多模态基础模型)

-

概述:

- 多模态模型(如CLIP、BLIP)结合视觉和文本,建立跨模态的桥梁。

- 通过训练大规模图文配对数据,它们能够处理零样本分类和实例级对齐等任务。

-

示例模型:

- CLIP (Radford et al., 2021): 在图像分类中表现出色。

- FILIP (Yao et al., 2021): 提供更精确的多模态对齐。

4. Generative Foundation Models (生成基础模型)

-

概述:

- 生成模型(如DALL-E、Stable Diffusion)擅长根据文本生成高质量图像,扩展了AI在创意领域的应用。

-

示例应用:

- Inpaint Anything (Yu et al., 2023): 使用生成模型对图像进行修复或重绘。

- Edit Everything (Gao et al., 2023): 结合SAM、CLIP、Stable Diffusion,以视觉和文本提示精准操控图像。

重点发展趋势:

-

大模型规模化:

- 越来越多的大规模模型在参数量上达到数百亿甚至千亿级别,提升了任务适应性和泛化能力。

-

多模态融合:

- 模型的设计逐渐从单一模态(语言或视觉)扩展到多模态,进一步提高了任务覆盖范围和交互能力。

-

自监督学习:

- 在缺乏标注数据的情况下,使用自监督技术提取通用特征,显著减少数据标注的依赖。

Fig. 2 Research tree of forging vision foundation models for autonomous driving.

1. 数据准备(Data Preparation)

这是训练视觉基础模型的第一步,涉及生成和增强训练数据的方法。主要技术包括:

a. 生成对抗网络(GAN)

- 模型示例:

- DriveGAN、DeepRoad、SurfelGAN、LiDARGAN。

- 应用:

- 生成真实感的驾驶场景,模拟多样的路况和环境。

b. 扩散模型(Diffusion Models)

- 模型示例:

- GeoDiffusion、DriveDreamer、DrivingDiffusion、MagicDrive。

- 应用:

- 通过逐步扩散和生成高质量驾驶场景。

c. 神经辐射场(NeRF, Neural Radiance Field)

- 模型示例:

- READ、MapNeRF、UniSim、MARS、S-NeRF、RoMe、StreetSurf。

- 应用:

- 生成高精度的三维场景表示,支持真实感的虚拟驾驶模拟。

d. 3D高斯分布(3D Gaussian Splatting)

- 模型示例:

- PVG、DrivingGaussian、StreetGaussians。

- 应用:

- 表征场景中的三维信息,提高几何建模的准确性。

2. 自监督学习训练范式(Self-supervised Training Paradigms)

自监督学习在自动驾驶模型的预训练中至关重要,常见的训练方法包括:

a. 基于对比学习(Contrastive-based)

- 模型示例:

- PointContrast、DepthContrast、SegContrast、ProposalContrast。

- 应用:

- 通过对比正负样本学习多样化的特征表示。

b. 基于重建(Reconstruction-based)

- 模型示例:

- VoxelMAE、GeoMAE、MaskPoint、MAELi、BEV-MAE、IAE、Occupancy-MAE。

- 应用:

- 通过重建损失优化模型,学习场景中物体的几何和语义特征。

c. 基于蒸馏(Distillation-based)

- 模型示例:

- SLidR、ST-SLidR、SEAL。

- 应用:

- 提取和精简已有模型的知识,提升新模型的性能。

d. 基于渲染(Rendering-based)

- 模型示例:

- Ponder、Ponderv2、PRED、UniPAD、RenderOcc、SelfOcc。

- 应用:

- 将三维场景渲染为逼真的二维图像,提升感知能力。

e. 基于世界模型(World Model-based)

- 模型示例:

- GAIA-1、ADriver-I、MLLM、OccWorld、MUVO、Drive-WM。

- 应用:

- 构建环境的世界模型,支持长期驾驶规划和决策。

3. 模型适配(Adaptation)

模型适配旨在将已有的基础模型调整为适合自动驾驶任务,主要涉及以下模型类型:

a. Vision Foundation Models(视觉基础模型)

- 模型示例:

- CalibAnything、RobustSAM、SPINO、SEAL。

- 应用:

- 应用于多模态视觉任务,例如目标检测、语义分割和3D建模。

b. Large Language Models(大规模语言模型)

- 模型示例:

- GPT-Driver、LanguageMPC、Drive Like a Human、DriveGPT4、LiDAR-LLM。

- 应用:

- 将语言模型与驾驶任务结合,实现基于文本的场景理解和人机交互。

c. Multimodal Foundation Models(多模态基础模型)

- 模型示例:

- LSeg、ODISE、CLIP2Scene、OVO、POP-3D、Dolphins、GPT-4V、DriveLM。

- 应用:

- 跨视觉和语言模态的任务(例如图像-文本对齐、语义分割)。

总结

这张研究树系统性地总结了开发自动驾驶视觉基础模型的关键技术路径,包括数据准备、自监督训练范式和模型适配的各类方法。重点在于:

- 数据准备技术不断提升模拟场景的真实性和多样性。

- 自监督学习极大地减少了对标注数据的依赖。

- 模型适配通过融合多模态技术推动自动驾驶系统的通用性。

2.2 Development of Representation

1. 图像作为表征(Image as Representation)

-

特点:

-

局限性:

- 单目图像无法直接感知深度信息,需要将2D输出转化为3D空间。

- 常用方法包括基于2D特征估计目标位置和维度,然后转换为3D表示。

-

扩展:

- 研究者逐渐探索使用双目相机,通过结合时间和空间信息提高3D感知能力。

2. 点云作为表征(Point Cloud as Representation)

-

特点:

- 激光雷达(LiDAR)生成的点云由于其卓越的深度感知能力和丰富的3D几何信息,成为自动驾驶中的关键表征。

- 点云通常被用作基于LiDAR感知任务的基础表征。

-

四种主要方法:

- 基于点(Point-based):

- 优化点云的原始几何信息,捕获局部结构和细粒度模式。

- 示例:Q. Hu et al. (2020), Qi et al. (2017)。

- 基于体素(Voxel-based):

- 将点云分割成紧凑的3D体素网格,便于与传统卷积神经网络结合。

- 示例:Deng et al. (2021), Lang et al. (2019)。

- 基于投影(Projection-based):

- 将点云投影到二维像素(例如深度图),利用2D卷积网络的能力。

- 示例:B. Wu et al. (2019), Kong et al. (2023)。

- 基于混合(Hybrid-based):

- 综合不同表征方法的优点,提升感知精度。

- 示例:S. Shi et al. (2020), Tang et al. (2020)。

- 基于点(Point-based):

-

扩展能力:

- 点云作为多传感器融合的重要中间表征,可以提高物体检测和场景理解的能力。

3. 鸟瞰图(Bird’s-Eye View, BEV)

-

特点:

- BEV是一种顶部俯视表示法,消除了视角遮挡问题,减轻了尺度变化的影响。

- 非常适合路径规划和控制任务,其中物体的位置和关系至关重要。

-

方法:

- 基于LiDAR的原生3D结构可以直接生成BEV表示。

- 基于摄像头的方法需要桥接2D图像和3D BEV空间之间的差距:

- 深度提升(Depth-based lifting): 通过深度估计将图像转换为BEV。

- 基于查询的提升(Query-based lifting): 使用查询提取特征并将其投影到BEV平面。

-

扩展:

- BEV已成为场景理解领域的主流方法,但需要通过专用头部模块处理下游任务。

4. 占用网格(Scene as Occupancy)

-

特点:

- 占用表征是场景理解中的新兴范式,直接编码了3D环境(例如3D体素网格)。

- 在垂直维度上实现对复杂结构(如桥梁、隧道、树枝等)的精确检测。

-

优势:

- 占用模型能够无缝集成语义信息和速度估计,丰富对环境的理解。

-

关键工作:

- 例如,OpenOccupancy、SurroundOcc、Occ3D等方法基于BEV感知架构进行扩展。

- 后续研究(Cao and de Charette, 2022;Gan et al., 2023)进一步优化了设计,展示了占用感知的潜力。

总结

- 自动驾驶感知的表征方法经历了从传统2D图像到复杂3D点云和占用网格的演变。

- 各种表征方法在不同场景和任务中展现出独特的优缺点:

- 图像:适合语义信息丰富的任务。

- 点云:提供高精度的3D几何信息。

- BEV:俯视视角对规划和控制友好。

- 占用网格:增强了复杂场景的感知能力。

Fig. 3 Chronological overview of the image, LiDAR, BEV and occupancy representations.

从图中,可以看到从2015年至2023年,自动驾驶感知领域在图像(Image)、LiDAR(激光雷达)、鸟瞰图(BEV)、和占用网格(Occupancy)表征上的代表性技术和方法的时间发展趋势。

以下是按时间顺序的详细解析:

2015 年

- 图像表征(Image Representation)

- FCN (Long et al.): 提出了全卷积网络(Fully Convolutional Networks),实现端到端的语义分割任务。

- R-CNN (Girshick et al.): 开创了区域卷积网络,用于目标检测任务。

2016 年

- 图像表征(Image Representation)

2017 年

- LiDAR 表征(LiDAR Representation)

2018 年

- LiDAR 表征(LiDAR Representation)

- VoxelNet (Zhou et al.): 提出了将点云分成3D体素网格,并通过深度学习处理的点云建模方法。

- PointPillars (Lang et al.): 使用柱状体素表示点云数据,提高了检测效率。

- 图像表征(Image Representation)

- RetinaNet (Lin et al.): 提出了Focal Loss,用于解决目标检测中的类别不平衡问题。

2019 年

- 图像表征(Image Representation)

- LiDAR 表征(LiDAR Representation)

- 3DSSD (Yang et al.): 是一种高效的点云目标检测方法。

2020 年

- LiDAR 表征(LiDAR Representation)

- 图像表征(Image Representation)

- SMOKE (Liu et al.): 基于单目相机的3D目标检测方法。

2021 年

- LiDAR 表征(LiDAR Representation)

- FCOS3D (Wang et al.): 将FCOS扩展到3D目标检测。

- 鸟瞰图表征(BEV Representation)

- LSS (Philion et al.): 提出了基于BEV的场景理解方法。

2022 年

- 鸟瞰图表征(BEV Representation)

- BEVDet (Huang et al.): 实现了高效的BEV感知。

- BEVDepth (Li et al.): 在BEV感知中加入深度估计。

- BEVFormer (Li et al.): 使用时序信息提升BEV表征性能。

- BEVFusion (Liang et al.): 结合多传感器数据进行BEV感知。

- 占用网格表征(Occupancy Representation)

- MonoScene (Cao et al.): 基于单目相机的占用网格方法。

2023 年

- 鸟瞰图表征(BEV Representation)

- PETR (Liu et al.): 基于BEV的3D目标检测方法。

- DETR 4D (Luo et al.): 集成时间信息的BEV方法。

- 占用网格表征(Occupancy Representation)

- OpenOccupancy (Wang et al.): 将占用感知扩展到开放环境。

- SurroundOcc (Wei et al.): 基于多视角的占用网格方法。

- Occ3D (Tian et al.): 在3D占用网格表征上引入了时空一致性。

总结

- 自动驾驶感知领域的技术从早期的图像表征(Image)逐步发展到LiDAR 表征(LiDAR),再到近年来的鸟瞰图表征(BEV)和占用网格表征(Occupancy)。

- 技术趋势:

2.3 Vision Applications

从 2.3 Vision Applications(视觉应用) 部分可以看出,本文详细分析了自动驾驶领域中基于视觉感知的主要任务及其方法,包括深度估计、目标检测、地图构建、语义分割、目标跟踪和占用预测。以下是每个任务的解析:

1. 深度估计(Depth Estimation)

-

目标:

- 通过输入图像生成密集的深度图,用于感知场景中物体的距离信息。

-

分类:

- 基于双目(Stereo-based):

- 使用两个重叠视角的图像,通过三角测量估算深度。

- 示例:Laga et al. (2020)。

- 特点:需要精确的相机校准。

- 基于单目(Monocular-based):

- 从单个图像估算深度,方法更加简单,减少了校准需求。

- 示例:Alhashim and Wonka (2018)、Eigen et al. (2014)、Lee et al. (2022)。

- 基于双目(Stereo-based):

2. 目标检测(Object Detection)

-

目标:

- 检测和预测重要物体(如汽车、行人、自行车等)的位置、大小和类别。

-

分类:

3. 地图构建(Map Construction)

-

目标:

- 构建高精度地图(HD Maps),对道路环境的元素(如车道线、标志等)进行语义化建模。

-

方法:

- 传统的离线HD地图构建依赖大量人工工作(Kim et al., 2021)。

- 在线语义地图构建:

- 最近,利用摄像头、LiDAR等传感器的多模态输入,提出了在线地图生成方法。

- 示例:Wang et al. (2023)、Zhang et al. (2023)。

4. 语义分割(Semantic Segmentation)

-

目标:

- 为图像中的每个像素分配语义标签,理解场景中的物体和背景。

-

分类:

- 2D语义分割:

- 示例:Chen et al. (2017)、Mohan and Valada (2021)。

- 3D语义分割:

- 示例:Zhang et al. (2019)。

- 将语义标签分配到点云中的每一个点。

- 2D语义分割:

5. 目标跟踪(Object Tracking)

-

目标:

- 持续估算场景中每个物体的状态(位置和运动),并为每个物体分配唯一ID。

-

特点:

- 实现跨时间的连续跟踪,解决遮挡和外观变化的问题。

- 示例:Brasó et al. (2022)、Guo et al. (2022)。

6. 占用预测(Occupancy Prediction)

-

目标:

- 对驾驶场景中每个体素(3D像素)的占用状态和语义标签进行估计。

-

特点:

- 相较于紧凑的3D边界框,占用表示法在描述一般物体、背景和不规则形状物体上更有优势。

- 示例:Li et al. (2023)、Tian et al. (2023)。

总结

这一部分展示了视觉感知在自动驾驶中的多样化应用:

- 从2D到3D: 随着技术的发展,感知任务正从传统的2D图像分析向3D点云、语义分割和占用预测扩展。

- 实时性和多模态融合: 许多任务已经集成了多种传感器输入(如摄像头和LiDAR),以提高感知的鲁棒性和精度。

3 Data Preparation

从 3. Data Preparation(数据准备) 部分可以看出,这部分强调了在自动驾驶领域中,数据准备的重要性及其面临的挑战,尤其是在多样化驾驶场景和数据稀缺的情况下。以下是主要内容的总结与解析:

核心背景

-

自动驾驶的复杂性:

- 自动驾驶系统需要处理复杂多样的驾驶场景,包括:

- 不同的交通参与者。

- 各种天气、光照和路况条件。

- 突发事件(如行人相关的交通事故)。

- 为确保系统的稳健性,必须在多种场景下进行广泛测试。

- 自动驾驶系统需要处理复杂多样的驾驶场景,包括:

-

数据采集的困难:

- 高昂的成本和低效率:

- 收集涵盖所有可能场景的大规模数据集(如意外事故)几乎不可行。

- 数据分布差异:

- 使用合成数据训练的模型在现实场景中可能表现出泛化能力不足的问题。

- 高昂的成本和低效率:

关键问题

- 如何生成真实且可控的数据以缓解数据稀缺问题:

- 模型需要从逼真的训练数据中学习。

- 需要弥合合成数据和真实数据之间的差距。

技术解决方案

-

生成对抗网络(GANs):

- 用于合成逼真的驾驶场景图像。

- 提供多样化的样本,扩展数据集的覆盖范围。

-

扩散模型(Diffusion Models):

- 通过逐步生成逼真的图像,在模拟复杂场景时具有优势。

-

神经辐射场(NeRF):

- 用于生成高精度的3D场景,提供场景的几何和视觉信息。

- 适用于虚拟驾驶训练和场景模拟。

-

3D高斯分布(3D Gaussian Splatting):

- 用于建模三维空间中的数据分布,帮助生成真实感的点云和3D表示。

发展前景

- 近期的技术进展(尤其是扩散模型和NeRF)显著提高了合成数据的真实性,模糊了真实数据和机器生成数据之间的界限。

- 这些技术为解决数据稀缺问题提供了有前景的支持。

总结

这一部分讨论了通过现有数据集和生成技术的结合来增强自动驾驶数据准备的多样性和效率。目标是以经济高效的方式生成可用数据,支持以下方向:

- 增强现有数据集: 通过数据生成或扩充弥补采集难度大的场景。

- 合成高质量数据: 模拟真实场景以进行模型训练。

- 平衡合成数据与现实数据的差异: 提升模型的泛化性能。

Table 2 Overview of various data generation techniques in autonomous driving scenes.

从 Table 2 中,我们可以看到自动驾驶场景中多种数据生成技术的概览。表格将数据生成方法按照类别、数据集、输入和输出等维度进行了总结,同时指出了是否支持跨视角生成(Cross-view)。以下是该表的解析:

1. 方法类别

数据生成技术被归为以下几种主要类别:

- GAN (Generative Adversarial Networks, 生成对抗网络):

- 用于生成高质量图像或点云。

- Diffusion Models (扩散模型):

- 通过逐步生成数据,产生高真实感的图像和视频。

- NeRF (Neural Radiance Fields, 神经辐射场):

- 生成高精度的3D场景表示。

- 3D Gaussian Splatting (3DGS):

- 用于生成三维点云或图像。

2. 各类别的具体方法与数据集

GAN

-

Pix2PixHD (Wang et al., 2018):

- 数据集: Cityscapes。

- 输入/输出: 图像 -> 图像。

- 应用: 生成城市街景的高分辨率图像。

-

DeepRoad (Zhang et al., 2018):

- 数据集: Udacity。

- 输入/输出: 图像 -> 图像。

- 特点: 支持多视角生成。

-

LiDARGAN (Sallab et al., 2019):

- 数据集: KITTI/CARLA。

- 输入/输出: LiDAR点云 -> LiDAR点云。

- 应用: 生成高质量点云。

-

DriveGAN (Kim et al., 2021):

- 数据集: CARLA/Gibson。

- 输入/输出: 视频、动作 -> 视频。

- 特点: 结合驾驶动作生成视频。

Diffusion Models

-

MCVD (Voleti et al., 2022):

- 数据集: Cityscapes。

- 输入/输出: 视频/图像 -> 视频/图像。

- 应用: 生成城市交通场景。

-

GeoDiffusion (Chen et al., 2023):

- 数据集: nuScenes。

- 输入/输出: 图像、2D边界框 -> 视频。

- 特点: 跨视角生成支持。

-

DrivingDiffusion (Li et al., 2023):

- 数据集: nuScenes。

- 输入/输出: 3D布局 -> 视频。

- 特点: 聚焦于高质量视频生成。

-

MagicDrive (Gao et al., 2023):

- 数据集: nuScenes。

- 输入/输出: 3D边界框、相机姿态、HDMap -> 图像。

- 特点: 模拟真实驾驶场景。

NeRF

-

READ (Li et al., 2023):

- 数据集: KITTI/Brno Urban。

- 输入/输出: LiDAR点云 -> LiDAR点云。

- 应用: 提供高精度3D场景建模。

-

MapNeRF (Wu et al., 2023):

- 数据集: Argoverse2。

- 输入/输出: 视频、地图、相机姿态 -> 视频。

- 特点: 支持多视角生成。

-

MARS (Wu et al., 2023):

- 数据集: PandaSet。

- 输入/输出: 3D边界框、相机姿态 -> 图像。

- 特点: 生成3D点云和图像。

-

NeRF-LiDAR (Zhang et al., 2022):

- 数据集: nuScenes。

- 输入/输出: LiDAR点云 -> LiDAR点云。

3D Gaussian Splatting (3DGS)

-

PVG (Chen et al., 2023):

- 数据集: KITTI/Waymo。

- 输入/输出: 图像 -> 图像。

- 特点: 生成高质量的三维点云。

-

DrivingGaussian (Zhou et al., 2023):

- 数据集: nuScenes/Waymo。

- 输入/输出: 图像、LiDAR点云(可选) -> 图像。

- 特点: 提供可选的点云生成支持。

-

Street Gaussians (Yan et al., 2024):

- 数据集: KITTI/Waymo。

- 输入/输出: 图像 -> 图像。

3. 特点与应用

输入数据类型:

- 包括图像、视频、LiDAR点云、3D边界框、相机姿态等。

- 结合多模态数据可以增强生成的真实性和多样性。

输出数据类型:

- 生成的输出多为图像、视频、或点云。

- 部分方法(如MagicDrive)能生成多模态输出(如图像+HDMap)。

跨视角支持:

- 部分方法(如DeepRoad、GeoDiffusion)能够生成多视角或多视频帧,适合自动驾驶中的多视角感知任务。

总结

-

技术发展:

- 从传统GAN到更复杂的扩散模型和NeRF,数据生成技术的真实感和多样性显著提升。

- 特别是扩散模型和NeRF,已经能够支持更高维度的多模态数据生成。

-

数据应用:

- 生成的合成数据不仅弥补了现实数据的稀缺性,还提供了极端天气、复杂场景等多样化的训练数据。

-

未来方向:

- 进一步整合多模态输入输出(如图像+点云+HDMap)。

- 提高跨视角和时空一致性生成的性能。

3.1 Autonomous Driving Datasets

从 3.1 Autonomous Driving Datasets(自动驾驶数据集) 的部分可以看出,这部分内容着重分析了自动驾驶领域中的数据集,其重要性、分类、传感器支持以及现实数据与合成数据的优缺点。以下是详细总结与解析:

1. 数据集的重要性

-

数据的重要作用:

-

当前数据集的覆盖:

- 涉及的时间范围从2009年至2024年,涵盖了传感器配置、数据集多样性以及支持的任务。

- 数据集不仅反映了现实驾驶场景的挑战(如各种天气条件),还解决了注释扩展需求。

2. 数据的来源与类型

-

传感器种类:

- 自动驾驶数据集通常通过配备以下传感器的车辆采集:

- 摄像头: 提供RGB图像。

- LiDAR: 提供点云数据。

- 雷达: 提供毫米波数据。

- GPS、IMU、CAN-bus: 提供定位和车辆控制信息。

- 自动驾驶数据集通常通过配备以下传感器的车辆采集:

-

传感器数据类型:

- RGB图像。

- 点云(3D几何信息)。

- 毫米波雷达数据。

- GPS位置信息和车辆状态信息。

3. 数据集的多样性

-

学术与工业领域:

- 数据集广泛覆盖学术研究和工业应用场景。

-

仅基于相机的数据集:

- 例如:

- Caltech Pedestrian (Dollár et al., 2009): 专注于行人检测。

- Cityscapes (Cordts et al., 2016): 用于城市街景语义分割。

- IDD (Varma et al., 2019): 用于不规则城市场景。

- 这些数据集通常仅依赖于相机收集数据,展示了多样化的相机配置(如前视、全景等)。

- 例如:

-

LiDAR数据集:

- LiDAR传感器因其高精度点云捕捉能力而成为主流选择。

- 例如:nuScenes (Caesar et al., 2020)。

- 但雷达数据集较为稀少,主要原因是毫米波雷达的复杂回波信号和冗余信息。

4. 合成数据与现实数据

-

合成数据集的作用:

- 代表数据集:

- Virtual KITTI (Gaidon et al., 2016): 虚拟驾驶环境。

- Virtual KITTI 2 (Cabon et al., 2020): 提供了更多复杂场景。

- UrbanSyn (Gómez et al., 2023): 模拟多样化天气条件。

- 合成数据集的灵活性允许模拟极端天气和稀有驾驶场景。

- 代表数据集:

-

挑战:

- 合成数据与真实数据之间存在领域差距(Domain Gap),限制了模型的泛化能力。

- 例如:Y. Li et al. (2023) 探讨了如何弥合这一差距。

总结

-

多样化的数据集是自动驾驶研究的基石:

- 数据集涵盖了从相机到LiDAR、雷达等传感器的多模态信息。

- 数据集的发展随着技术需求的增长而不断演进。

-

现实数据与合成数据的结合:

- 合成数据集为训练提供了灵活性,但需要解决领域适配问题。

- 未来研究可能需要更好地整合这两种类型的数据。

-

传感器融合:

- 利用多模态数据(如摄像头+LiDAR+GPS)进一步提升感知能力。

Table 1 Existing perception datasets for driving scene. For Supported Tasks.

从 Table 1 中,我们可以看到一个详细的自动驾驶感知场景中现有数据集的总结表。这张表对各种数据集的支持任务、数据多样性(场景数量、时长、天气条件)和传感器类型进行了分类和比较。以下是表格的解析:

1. 数据集支持的任务

- OD(Object Detection):目标检测

- SS(Semantic Segmentation):语义分割

- OT(Object Tracking):目标跟踪

- MP(Motion Planning):运动规划

2. 数据多样性

- 场景数量(Scenes): 提供了视频片段的数量。

- 时长(Hours): 数据的总时长。

- 天气条件(Weather):

- SU(Sunny):晴天

- SN(Snowy):雪天

- C(Cloudy):多云

- F(Foggy):雾天

- R(Rainy):雨天

3. 传感器配置

- 摄像头(Camera): 提供的视角(例如前视或360度视角)。

- LiDAR: 是否包含激光雷达数据。

- 雷达(Radar): 是否包含毫米波雷达数据。

- 其他传感器: 包括 GPS、IMU(惯性测量单元)和 CAN(车辆总线数据)。

4. 关键数据集分析

传统数据集:

-

Caltech Pedestrian (2009):

- 支持任务: 2D目标检测。

- 数据多样性: 包括晴天和多云条件。

- 传感器: 前视摄像头。

-

KITTI (2012):

- 支持任务: 2D/3D目标检测、语义分割、目标跟踪。

- 数据多样性: 6小时数据,晴天和多云。

- 传感器: 前视摄像头、LiDAR。

-

Cityscapes (2016):

- 支持任务: 2D/3D目标检测、语义分割。

- 数据多样性: 多场景、多云晴天。

近期数据集:

-

nuScenes (2020):

- 支持任务: 2D/3D目标检测、语义分割、目标跟踪。

- 数据多样性: 包括多种天气条件,360度摄像头视角。

- 传感器: LiDAR、雷达、GPS、IMU。

-

Waymo (2020):

- 支持任务: 2D/3D目标检测、语义分割、目标跟踪、运动规划。

- 数据多样性: 1,000个场景,24小时数据,涵盖多种天气。

- 传感器: 360度摄像头、LiDAR、GPS、IMU。

-

ZOD (2023):

- 支持任务: 2D/3D目标检测、语义分割。

- 数据多样性: 1,473个场景,覆盖多种天气条件。

- 传感器: 前视摄像头、LiDAR、GPS。

5. 数据集比较的洞察

-

任务覆盖:

- 早期数据集(如Caltech Pedestrian、KITTI)更专注于2D目标检测。

- 最近的数据集(如Waymo、nuScenes)扩展到3D感知和多任务支持,包括目标跟踪和运动规划。

-

数据多样性:

- 近期数据集显著提高了天气条件的覆盖范围(例如雨天、雾天),增强了模型的泛化能力。

- 数据时长也从几小时扩展到了数百小时。

-

传感器融合:

- 最新数据集(如nuScenes、Waymo)集成了LiDAR、雷达、GPS和IMU,提供了更全面的多模态数据支持。

- 较早的数据集通常仅依赖于单一传感器(如摄像头)。

总结

- 自动驾驶数据集的发展趋势是从单模态(如摄像头)向多模态(如摄像头+LiDAR+雷达)的方向演变。

- 数据多样性(场景数量、天气条件)和任务覆盖范围的扩展增强了模型的泛化能力。

- 新的数据集提供了更高的时长和分辨率支持,为训练和评估复杂场景下的自动驾驶模型提供了基础。

3.2 Generative Adversarial Network

从 3.2 Generative Adversarial Network(GAN,生成对抗网络) 的部分可以看出,GAN 被广泛应用于自动驾驶数据生成,尤其在图像、视频以及 LiDAR 点云的合成方面。以下是详细解析:

1. GAN 的基本原理

-

引入:

- GAN 的概念由 Goodfellow 等人在 2014 年提出。

- 它由两个网络组成:

- 生成器(Generator): 负责生成尽可能接近真实样本的数据。

- 判别器(Discriminator): 负责区分生成数据和真实数据。

-

工作机制:

- 通过生成器和判别器的对抗训练(一个两玩家的最小化-最大化游戏),生成器能够逐步优化并生成真实感的图像。

-

优势:

- GAN 可以合成高分辨率、具有真实感的图像。

2. GAN 在自动驾驶中的应用

图像生成

-

Pix2Pix 和 Pix2PixHD:

- 方法: Pix2Pix 使用条件 GAN(cGAN)进行图像到图像的翻译。

- 应用:

- 基于语义分割图或边缘图生成真实驾驶场景图像。

- 扩展:

- Pix2PixHD(T.-C. Wang et al., 2018)扩展为高分辨率图像生成,支持长达30秒的视频生成。

-

CycleGAN:

- 方法: 通过无配对样本(Unpaired Samples)进行图像到图像翻译。

- 应用:

- 数据增强,例如将CG(计算机图形)场景转换为真实图像,或进行日/夜、夏/冬等条件转换。

- 优势:

- 解决了需要配对图像的限制。

-

DeepRoad:

- 方法: 使用 GAN 生成包含不同天气条件的驾驶场景。

- 应用:

- 测试深度学习模型在不同驾驶场景中的稳健性。

-

DriveGAN:

- 方法: 一种基于 GAN 的高质量神经模拟器。

- 应用:

- 支持控制天气和背景物体位置。

- 特点:

- 提供可控的驾驶场景模拟。

-

SufelGAN:

- 方法: 数据驱动的简单高效方法。

- 应用:

- 用于生成具有真实视角和移动物体的驾驶场景图像。

LiDAR 点云生成

-

LiDARGAN:

- 方法: 基于 CycleGAN,生成高分辨率的真实 LiDAR 点云。

- 应用:

- 从模拟 LiDAR 转换到真实 LiDAR(Sim2Real),或从低分辨率生成高分辨率点云。

-

Caccia et al. (2019):

- 方法: 提出了一种 GAN 方法,可以捕获真实 LiDAR 扫描的局部和全局特征。

- 应用:

- 生成高质量的 LiDAR 数据。

-

J. Lee et al. (2022):

- 方法: 基于 GAN 的 LiDAR-to-LiDAR 转换。

- 应用:

- 在不同天气条件下模拟点云数据。

3. GAN 的优缺点

优势:

- 真实感强: GAN 生成的图像和点云具有较高的真实感,可弥补数据集的不足。

- 数据增强: 提供多样化的数据,如模拟极端天气条件、不同时间段等场景。

局限性:

-

分辨率限制:

- GAN 通常生成的分辨率较低,特别是在处理高维数据(如 LiDAR 点云)时。

-

多模态一致性问题:

- 在同时生成多个模态数据(如图像和点云)时,可能缺乏一致性。

4. 总结与应用前景

-

在自动驾驶中的价值:

- GAN 被广泛用于生成逼真的驾驶场景图像和点云,扩展现有数据集的多样性,增强模型的泛化能力。

-

未来研究方向:

- 提高生成分辨率。

- 增强多模态数据的一致性。

- 在更复杂的驾驶场景(如动态环境)中应用 GAN。

3.3 Diffusion Models

从 3.3 Diffusion Models(扩散模型) 部分可以看出,扩散模型在图像和视频生成方面表现出色,并且在一定程度上超过了 GAN 的性能。以下是详细解析:

1. 扩散模型的基本原理

-

定义:

- 扩散模型通过对噪声图像进行逐步降噪来生成高质量数据。

- 其优势在于可以利用高尺度分类器对噪声图像进行训练,既能保持数据的真实性,又能保证生成的多样性。

-

优点:

- 扩散模型在处理图像和视频生成时,能够生成高保真(High-Fidelity)的数据,同时保持多样性(Diversity)。

2. 扩散模型在自动驾驶中的应用

单帧与多帧生成

-

MCVD (Voleti et al., 2022):

- 方法: 基于滑动窗口的自回归方法,使用概率性条件分数降噪扩散模型。

- 应用: 生成多帧视频数据。

-

Align your Latents (Blattmann et al., 2023):

- 方法: 添加时间层以生成时序一致的视频。

- 应用: 确保视频帧的时间一致性。

-

FDM (Harvey et al., 2022):

- 方法: 基于任意数量帧进行训练,支持灵活的时间序列建模。

- 应用: 生成长时间序列视频。

-

GeoDiffusion (K. Chen et al., 2023):

- 方法: 利用几何信息进行生成,包括多视角和基于相机姿态的图像。

- 应用: 确保不同视角之间的一致性。

多视角与时序建模

-

DriveDreamer (X. Wang et al., 2023):

- 方法: 两阶段管道:

- 理解交通结构信息。

- 视频预测训练。

- 应用: 控制生成的驾驶场景视频,使其符合交通约束。

- 方法: 两阶段管道:

-

Drive-WM (Y. Wang et al., 2023):

- 方法: 联合多视角和时间建模,通过联合建模因子提高帧间一致性。

- 应用: 生成多视角视频和帧。

-

DrivingDiffusion (X. Li et al., 2023):

- 方法: 包含多视角单帧生成模型、单视角时间模型和后处理模块。

- 应用: 确保跨视角和时间的一致性,同时延长视频长度。

-

MagicDrive (R. Gao et al., 2023):

- 方法: 单一模型,生成多视角街景图像及多视角3D几何控制。

- 特点: 跨视角一致性模块。

3. 具体技术与数据生成

-

Bird’s Eye View(BEV)与占用感知:

- BEV 和占用感知逐渐成为自动驾驶感知的主要方法。

- 在这种条件下,生成多视角图像序列越来越重要。

-

DatasetDM (D. Wu et al., 2023):

- 方法: 基于少量标注数据的可训练解码器。

- 应用: 提供无限量的高质量合成数据以支持下游任务。

4. 扩散模型的挑战

-

训练难度:

- 从零开始训练扩散模型极具挑战性,往往需要依赖于预训练的 Stable Diffusion 模型。

-

缺乏3D几何能力:

- 扩散模型目前主要擅长生成高保真图像或视频,但在重建3D几何结构方面仍有不足。

总结与应用前景

-

应用优势:

- 扩散模型在视频生成中展现出极大的潜力,尤其在确保时序一致性和视角一致性方面。

- 随着 BEV 和占用感知的兴起,多视角数据生成的重要性持续增加。

-

未来研究方向:

- 增强扩散模型的3D几何重建能力。

- 开发更高效的训练方法,降低对预训练模型的依赖。

- 进一步提升多模态(如图像、视频、点云)生成的一致性。

Fig. 4 Illustration of diffusion-based data generation.

图 4 展示了基于扩散模型的数据生成流程的一个示例,特别是结合对象边界框位置和几何信息生成高保真图像。以下是该流程的关键解析:

1. 主要组成部分

-

输入信息:

- G2T(Geometry-to-Text Translation):

- 将输入的几何信息(如视角、摄像机位置和对象的边界框位置)翻译为文本描述,作为生成条件。

- 示例:前置摄像头的视角和物体在图像中的空间位置。

- G2T(Geometry-to-Text Translation):

-

噪声图像(Noise Image):

- 初始输入是一个纯噪声图像,该图像将在后续的扩散模型中被逐步去噪。

-

生成器(Denoiser):

- 使用扩散模型中的去噪网络,结合条件信息(如边界框位置和几何信息)将噪声逐步还原为真实感图像。

2. 输出

- 生成的图像(Generated Images):

- 经过扩散模型处理后的结果是逼真的驾驶场景图像,具有高保真度。

- 生成的图像可以包括:

- 不同的天气条件(如雨天、晴天)。

- 不同视角(如前视、侧视)。

3. 应用场景

- 目标检测模型的训练(Train Object Detectors):

- 生成的图像用于训练目标检测器(Object Detectors)。

- 通过扩充数据集,提高检测器在不同条件下(如光照变化、车辆密集场景等)的性能。

4. 技术亮点

-

几何与文本的结合:

- 利用几何信息生成条件文本(G2T),使模型能够生成符合空间约束的真实感图像。

-

去噪过程:

- 扩散模型通过逐步去噪,从随机噪声中生成高质量驾驶场景图像。

-

多样化训练数据:

- 模型能够生成不同视角、不同环境条件的场景,提高模型的泛化能力。

5. 潜在挑战

-

几何一致性:

- 确保生成的图像与输入的几何信息完全匹配仍然具有挑战性。

-

多模态生成:

- 在多传感器环境(如图像和点云)中,扩散模型需要生成跨模态一致的数据。

-

计算成本:

- 扩散模型的训练和推理过程可能需要较高的计算资源。

总结

基于扩散模型的数据生成方法为自动驾驶领域提供了一种强大的数据扩充手段:

- 高保真图像生成: 通过条件约束生成符合实际需求的场景数据。

- 支持下游任务: 特别是目标检测模型的训练和评估。

3.4 Neural Radiance Field

从 3.4 Neural Radiance Field (NeRF) 部分可以看出,NeRF 提供了一种突破性的解决方案,用于生成逼真的 3D 场景,并在自动驾驶领域展现了重要潜力。以下是详细解析:

1. NeRF 的基本原理

-

背景:

- GAN 和扩散模型在生成高保真图像方面表现出色,但缺乏 3D 几何约束,无法生成新视角的场景。

- NeRF(Mildenhall et al., 2021)作为一种新型技术,通过建模光线穿过场景的辐射值,实现了高质量 3D 场景的生成。

-

工作机制:

- 采样:

- NeRF 沿着每条光线采样点,捕获每个采样点的 3D 空间位置和光线的 2D 方向(形成 5D 向量)。

- 网络输入:

- 这些 5D 向量被输入到多层感知器(MLP)神经网络中。

- 输出:

- 网络输出每个采样点的颜色值和体素密度。

- 优化:

- 不断优化这些参数以重建场景,并支持新视角的合成。

- 采样:

2. NeRF 的扩展与改进

-

扩展方法:

- NeRF++ (Zhang et al., 2020):

- 扩展了 NeRF 的场景建模能力以适应大规模场景。

- NeRF in the Wild (Martin-Brualla et al., 2021):

- 适应真实场景的照明变化。

- Mip-NeRF (Barron et al., 2021):

- 提高了对空间分辨率的建模能力。

- NeRF++ (Zhang et al., 2020):

-

进一步优化:

- 从少量输入视角训练 NeRF:

- 提高了模型的效率,减少了对大量视角数据的依赖。

- Pixel-NeRF (Yu et al., 2021):

- 从单视图学习场景表示。

- Behind the Scenes (Wimbauer et al., 2023):

- 提供了更加详细的 NeRF 扩展。

- 从少量输入视角训练 NeRF:

3. NeRF 在自动驾驶场景中的应用

-

驾驶场景的仿真与生成:

- READ (Li et al., 2023):

- 支持大规模神经场景渲染,不仅可以生成真实驾驶场景,还支持场景拼接与编辑。

- UniSim (Yang et al., 2023):

- 使用原始传感器数据(如 LiDAR 和摄像头)构建 3D 场景模型。

- 能够生成动态一致的 LiDAR 和摄像头数据,支持从新视角生成场景。

- READ (Li et al., 2023):

-

场景一致性与多视角生成:

- MapNeRF (Wu et al., 2023):

- 引入地图先验(如地面与车道信息)以增强语义一致性。

- MARS (Wu et al., 2023):

- 基于 NeRF 的开源模块化框架,用于照片级真实感的场景仿真。

- MapNeRF (Wu et al., 2023):

-

大规模驾驶场景重建:

- S-NeRF、RoMe、StreetSurf (2023):

- 这些方法专注于大规模驾驶场景的重建与仿真。

- S-NeRF、RoMe、StreetSurf (2023):

-

LiDAR 数据的生成:

- LiDAR-NeRF (Tao et al., 2023):

- 学习 LiDAR 点的几何和属性,生成高质量的点云数据。

- NeRF-LiDAR (Zhang et al., 2023):

- 将真实图像和点云数据结合,学习 3D 场景表示,用于自动驾驶模型训练。

- LiDAR-NeRF (Tao et al., 2023):

4. 优势与局限

优势:

- 多视角一致性:

- NeRF 可生成从不同视角观察的场景图像,支持复杂驾驶场景仿真。

- 多模态一致性:

- 可同时生成 LiDAR 点云和摄像头图像,适合自动驾驶多传感器场景。

- 高保真图像生成:

- 场景细节逼真,可在不同光照条件下渲染。

局限:

- 实时性:

- NeRF 的数据生成过程计算开销较大,难以满足实时应用需求。

- 高分辨率生成:

- 生成高分辨率场景仍是技术瓶颈。

- 复杂性:

- 对大规模动态场景的建模尚有难度。

5. 总结与未来展望

-

应用潜力:

- NeRF 在多传感器一致性仿真和高真实感场景生成方面具有广阔的前景。

- 在自动驾驶领域,NeRF 可用于数据增强、模型训练和场景重建。

-

未来方向:

- 提高实时处理能力。

- 拓展对动态场景和复杂环境的建模。

- 结合其他生成模型(如扩散模型)以增强 3D 表现能力。

Fig. 5 Illustration of NeRF-based data generation methods.

图 5 展示了基于 NeRF(神经辐射场)的数据生成方法的工作流程,主要用于生成 3D 场景,结合静态背景和动态物体,实现复杂场景的高保真重建。以下是解析:

1. 主要组成部分

-

场景建模:

- 静态背景(灰色部分):

- 场景中的静态部分,如道路、建筑物等,被建模为固定的背景。

- 动态物体(红色部分):

- 场景中的动态物体(如车辆、行人)被单独建模并与背景分离。

- 静态背景(灰色部分):

-

输入数据:

- 传感器(Sensor):

- 收集场景的原始数据,例如摄像头和 LiDAR 数据。

- 采样点(Sampled Points):

- 从场景中采样点进行特征计算。

- 传感器(Sensor):

-

神经特征生成:

- 体渲染(Volume Rendering):

- 使用体渲染技术生成神经特征描述符。

- 特征描述符包含空间位置和光照信息,用于表示场景中的每个采样点。

- 体渲染(Volume Rendering):

-

背景特征网格(Background Feature Grid):

- 静态背景特征以网格形式存储,用于加速后续计算。

-

超网络(Hypernet):

- 根据输入信息生成动态物体和背景的特征描述。

- 动态物体通过单独的网络进行建模,生成时间一致的特征。

2. 数据生成过程

-

特征解码:

- 使用卷积神经网络(CNN)将生成的神经特征解码为图像。

- 这些图像能够反映场景的空间细节和动态行为。

-

输出图像:

- 最终生成高保真度的场景图像,包括静态背景和动态物体的结合。

3. 应用场景

-

自动驾驶仿真:

- 生成包含复杂动态行为的驾驶场景(如车辆行驶、行人移动)。

- 场景数据可用于自动驾驶模型的训练与评估。

-

数据增强:

- 通过动态物体与静态背景的组合,生成不同天气、光照和交通条件下的场景数据。

-

虚拟环境构建:

- 为虚拟现实或增强现实(VR/AR)应用构建逼真的场景。

4. 技术优势

- 静态与动态结合:

- 通过将静态背景与动态物体分离,NeRF 提供了更加灵活的场景生成方法。

- 高保真渲染:

- 使用体渲染技术捕获场景的真实细节,确保生成图像的高质量。

- 多模态支持:

- 可以结合 LiDAR 和摄像头数据,实现跨模态场景建模。

5. 局限与挑战

- 计算复杂性:

- 体渲染与高分辨率图像生成需要高计算资源,难以实时处理。

- 动态一致性:

- 在复杂场景中,确保动态物体的时空一致性仍具有挑战性。

总结

图 5 展示的基于 NeRF 的方法为自动驾驶数据生成提供了一种高效且灵活的解决方案。通过静态背景与动态物体的结合,以及特征描述与解码,能够生成真实感强且多样化的驾驶场景,为模型训练和仿真提供了重要支持。

3.5 3D Gaussian Splatting

3.5 3D Gaussian Splatting(3DGS) 部分介绍了 3D Gaussian Splatting 技术在场景重建和渲染中的应用。这种方法最近得到了越来越多的关注,特别是在自动驾驶场景中具有显著优势。以下是对该部分的解析:

1. 什么是 3D Gaussian Splatting (3DGS)?

-

概念:

- 3DGS 使用 3D 高斯原语来表示场景,每个高斯原语可以被认为是一个小的、具有体积属性的点,能够描述场景中的某些特定细节。

- 通过基于光栅化的渲染技术,3DGS 实现了实时渲染,且所需内存占用较小。

-

核心特点:

- 能够以较低的计算成本实现高效的动态场景重建和渲染。

- 在训练速度和推理速度上比 NeRF(神经辐射场)等方法更优。

2. 3DGS 在自动驾驶中的应用

-

PVG 方法 (Periodic Vibration Gaussian, Chen et al., 2023):

- 核心:

- 引入周期振动、高斯透明度、时间相关的透明度延迟,以及基于场流的时间平滑机制。

- 优势:

- 对比 NeRF,PVG 在动态场景重建和新视角合成上具有优势。

- 同时,PVG 提高了训练速度和推理效率。

- 核心:

-

DrivingGaussian (X. Zhou et al., 2023):

- 方法:

- 使用分层数据建模复杂的驾驶场景。

- 引入以下模块:

- 增量静态 3D 高斯模块: 用于重建静态背景。

- 复合动态高斯图模块: 用于处理动态物体。

- 特色:

- 支持插入动态物体(例如车辆)到重建的高斯场中,并维持时间一致性。

- 适用于模拟复杂驾驶场景。

- 方法:

-

Street Gaussians (Y. Yan et al., 2024):

- 方法:

- 提出了一种新颖的姿态优化策略,并结合 4D 球谐函数外观模型处理动态物体(如移动车辆)。

- 应用:

- 快速合成物体和背景,支持场景编辑和实时渲染。

- 可在半小时内完成训练,显示出极高的效率。

- 方法:

3. 技术优点

-

实时性:

- 3DGS 可以快速渲染高分辨率图像。

- 训练速度和推理效率显著提高,特别是在动态场景重建中。

-

灵活性:

- 支持场景编辑和物体插入,能够处理动态变化的复杂驾驶场景。

-

多视角生成:

- 通过高斯场的动态组合,3DGS 支持多视角和时间一致性的场景合成。

4. 当前的局限性

-

3D 场景表示能力不足:

- 尽管 3DGS 可以快速重建和渲染动态场景,但在全面表达复杂 3D 场景(例如多物体相互作用)方面仍然有限。

-

研究潜力:

- 未来需要在场景的几何一致性和语义细化方面进一步提升。

5. 总结与未来展望

-

应用潜力:

- 3DGS 是一种极具前景的技术,特别是在实时动态场景重建和渲染中。

- 它为自动驾驶仿真提供了一种高效的解决方案,可以用于模型训练和场景生成。

-

研究方向:

- 增强其对复杂几何和动态场景的表示能力。

- 提升在多传感器融合场景中的适用性(例如结合 LiDAR 和摄像头数据)。

Fig. 6 Illustration of 3DGS-based data generation methods.

3d7449e282beb5.png" alt="在这里插入图片描述" />

图 6 详细说明了基于 3D Gaussian Splatting (3DGS) 的数据生成方法,展示了如何通过组合静态背景和动态对象生成全局 3D 高斯模型,并应用于多种任务(例如新视角合成和极端场景模拟)。以下是该图的解析:

1. 核心流程

静态和动态场景建模

-

增量静态 3D 高斯(Incremental Static 3D Gaussians):

- 用于建模场景中的静态背景,如道路、建筑等。

- 将静态场景分解为多个高斯点,这些点以增量方式更新,逐步构建全局 3D 场景表示。

-

复合动态高斯图(Composite Dynamic Gaussian Graph):

- 用于建模动态物体,如行驶的汽车、行人等。

- 每个动态对象被建模为高斯节点(Node),并以图的形式连接。

- 每个节点可以存储对象的动态信息(如运动轨迹)和外观信息。

-

全局合成(Composite DrivingGaussian):

- 将静态和动态高斯图结合在一起,形成全局 3D 高斯表示,用于场景的整体建模。

2. 支持的任务

训练完成后,基于 3DGS 的全局表示可以支持以下任务:

-

新视角合成(Surrounding View Synthesis):

- 根据训练好的 3D 场景模型,从新的观察角度生成场景图像。

- 示例:从不同的车辆位置或传感器角度生成周围环境的视图。

-

动态场景重建(Dynamic Scene Reconstruction):

- 重建复杂动态场景,包括车辆和行人的动态行为。

- 示例:重现某一路段的车辆行驶和行人过街的动态过程。

-

极端场景模拟(Corner Case Simulation):

3. 技术细节

-

节点和图表示:

- 动态物体(如车辆和行人)被表示为高斯节点,每个节点具有属性信息(如时间一致性和空间位置)。

- 图结构确保了动态物体在时间维度上的一致性。

-

全局渲染(Global Rendering):

- 将静态和动态高斯场融合,通过光栅化渲染生成逼真的场景图像。

-

训练过程:

- 通过增量方式逐步训练静态场景,并加入动态高斯节点,保持时间和空间的精确性。

4. 应用优势

-

高效训练和推理:

- 3DGS 能够高效地处理静态和动态场景,训练和推理速度较 NeRF 提升显著。

-

灵活的场景模拟:

- 可以快速插入新的动态对象(如车辆或行人)到场景中,用于仿真新的测试场景。

-

广泛的任务支持:

- 支持多任务,包括视角合成、动态重建和极端场景模拟。

5. 局限与未来方向

-

局限性:

- 当前 3DGS 对动态物体的建模仍受限于高斯图的表示能力。

- 复杂动态场景中的几何细节可能无法完全捕获。

-

未来改进方向:

- 提升动态高斯图对复杂物体的精确建模。

- 将 3DGS 扩展到多模态场景(如结合 LiDAR 和图像数据)。

总结

图 6 形象地展示了 3DGS 在自动驾驶场景中的应用和优势。通过将静态背景与动态物体结合,3DGS 能够支持高效的多任务场景生成和仿真,是一种极具前景的技术。

4 Self-supervised Training

第 4 部分:Self-supervised Training(自监督训练) 对自动驾驶领域的自监督学习进行了系统性分析。以下是对该部分的解析:

1. 什么是自监督学习?

-

定义:

- 自监督学习是一种无监督学习范式,通过大规模未标注数据的训练来自动生成训练信号。

- 它能够从数据中提取一般性的信息,而无需依赖人工标注,降低了训练过程中的数据标注成本。

-

应用场景:

- 自监督学习在自然语言处理(NLP)和图像处理等领域取得了显著成果,例如 GPT 在文本生成和 DINO 在图像表示学习中的应用。

-

在视觉基础模型(VFMs)中的作用:

- 自监督学习为自动驾驶领域的 VFMs 训练引入了新机会,能够有效利用未标注的驾驶数据(如图像、LiDAR 点云)以构建强大的视觉表示。

2. 自监督学习在自动驾驶中的意义

-

数据来源:

- 自动驾驶通常需要处理大量未标注的数据,包括摄像头捕获的 RGB 图像、LiDAR 点云数据等。

- 自监督学习能够直接从这些原始数据中学习特征,减少标注需求。

-

自监督学习的效果:

- 泛化能力: 学习到的视觉表示在不同任务(如目标检测、语义分割)中可以很好地泛化。

- 鲁棒性: 能够适应各种驾驶场景和环境(如光照变化、遮挡)。

3. 自监督训练方法的分类

根据表格 3,本文对自动驾驶领域中的自监督学习范式进行了分类,主要包括以下五种类型:

-

基于对比学习(Contrastive-based):

- 原理:

- 学习相似样本之间的特征一致性,同时区分非相似样本。

- 示例: PointContrast、DepthContrast、SegContrast、ProposalContrast。

- 优势:

- 增强模型对空间几何关系的理解能力。

- 应用场景:

- 用于点云数据的特征提取和深度估计。

- 原理:

-

基于重建(Reconstruction-based):

- 原理:

- 通过重建输入数据来学习其特征表示。

- 示例: VoxelMAE、GeoMAE、MaskPoint、MAELi。

- 优势:

- 通过恢复部分缺失信息学习全局和局部特征。

- 应用场景:

- 自动驾驶中的 3D 点云和图像修复任务。

- 原理:

-

基于蒸馏(Distillation-based):

- 原理:

- 从教师模型中提取知识并传递给学生模型。

- 示例: SLiDR、ST-SLiDR、SEAL。

- 优势:

- 在模型压缩与轻量化上有显著效果。

- 应用场景:

- 针对资源受限设备(如车载硬件)优化自动驾驶模型。

- 原理:

-

基于渲染(Rendering-based):

- 原理:

- 利用渲染技术生成场景表示。

- 示例: Ponder、RenderOcc。

- 优势:

- 融合了图像和几何信息的能力。

- 应用场景:

- 场景理解与仿真。

- 原理:

-

基于世界模型(World Model-based):

- 原理:

- 学习整个环境的全局表示,以模拟场景中的动态。

- 示例: GAIA-1、ADriver-I、OccWorld。

- 优势:

- 捕捉动态物体和复杂环境的变化。

- 应用场景:

- 自动驾驶场景模拟和预测。

- 原理:

4. 技术优势

-

高效利用未标注数据:

- 大量的未标注驾驶数据可以被直接用于模型训练,减少标注成本。

-

提升模型鲁棒性:

- 自监督学习使模型在不同任务中具有更强的适应性,尤其是在光照变化、遮挡和天气条件复杂的环境下。

-

任务迁移能力:

- 学习到的特征表示可以迁移到目标检测、深度估计等下游任务中。

5. 局限与挑战

-

模型训练的计算复杂性:

- 自监督方法通常需要大量计算资源,特别是在处理 3D 数据(如点云)时。

-

学习信号设计的复杂性:

- 如何生成有效的自监督学习信号,仍然是一个关键问题。

-

数据质量的依赖:

- 模型性能与原始数据的质量密切相关,噪声数据可能影响训练效果。

总结

自监督学习在自动驾驶视觉基础模型的构建中展现了巨大潜力。通过结合对比学习、重建、蒸馏、渲染和世界模型方法,自监督训练能够高效地从未标注数据中学习特征,为构建泛化性强的视觉表示提供了重要支持。未来方向包括进一步优化算法效率,降低训练成本,并拓展其在更多场景中的应用。

Table 3 Overview of existing self-supervised learning (SSL) methods in autonomous driving scenes.

表 3 提供了当前自动驾驶场景中使用的自监督学习方法的详细概述。以下是表格的解读与总结:

1. 表格结构解析

- Method(方法): 每种自监督学习方法的名称及其引用来源。

- Model Input(输入数据): 用于模型训练的输入数据类型,例如 LiDAR 数据、摄像头图像或两者结合。

- Type of SSL(自监督学习类型): 不同的自监督学习范式,包括对比学习(Contrastive-based)、重建(Reconstruction-based)、蒸馏(Distillation-based)、渲染(Rendering-based)和世界模型(World Model-based)。

- Pre-train Dataset(预训练数据集): 用于预训练的主要数据集,例如 Waymo、KITTI、nuScenes、ONCE 等。

- Vision Tasks(视觉任务): 自监督学习支持的目标任务,例如目标检测(Detection)、语义分割(Segmentation)、占用预测(Occupancy Prediction)和对象追踪(Tracking)。

2. 主要方法类别分析

(1) 对比学习 (Contrastive-based)

- 输入数据: 主要是 LiDAR 数据,部分方法结合了摄像头图像。

- 代表方法:

- GCC-3D (H. Liang et al., 2021):使用 Waymo 数据集,主要用于目标检测。

- ProposalContrast (Yin et al., 2022):同样基于 Waymo 数据集,侧重检测任务。

- BEVContrast (Sautier et al., 2024):在 KITTI 和 nuScenes 数据集上进行训练,支持检测和分割任务。

- 任务应用: 主要集中于目标检测和语义分割,特别是通过对比特征学习增强模型对空间几何关系的理解。

(2) 重建 (Reconstruction-based)

- 输入数据: 主要基于 LiDAR 点云。

- 代表方法:

- BEV-MAE (Z. Lin and Wang, 2022):基于 Waymo 数据集,用于检测任务。

- MAELi (Krispel et al., 2024):在 Waymo 数据集上预训练,支持检测和分割任务。

- GD-MAE (H. Yang et al., 2023):专注于 Waymo 数据集,用于目标检测。

- 任务应用: 强调通过重建丢失部分的输入数据来学习全局和局部特征,适用于检测和分割任务。

(3) 蒸馏 (Distillation-based)

- 输入数据: LiDAR 和摄像头图像的结合。

- 代表方法:

- S2M2-SSD (Zheng et al., 2022):使用 nuScenes 数据集,支持目标检测。

- SLiDR 和 ST-SLiDR:均采用 nuScenes 数据集,支持检测和分割任务。

- 任务应用: 蒸馏技术用于从复杂模型中提取知识,并将其应用于更轻量级的模型,适合资源受限的场景。

(4) 渲染 (Rendering-based)

- 输入数据: 结合 LiDAR 和摄像头数据。

- 代表方法:

- PonderV2 (H. Zhu et al., 2023):使用 nuScenes 数据集,支持检测和分割任务。

- PRED (H. Yang et al., 2023):结合 nuScenes 和 ONCE 数据集,用于检测和分割。

- 任务应用: 渲染技术结合几何与图像信息,适用于场景建模和目标检测。

(5) 世界模型 (World Model-based)

- 输入数据: 仅基于摄像头图像。

- 代表方法:

- UniWorld (Min et al., 2023b):基于 nuScenes 数据集,支持检测、占用预测等任务。

- ViDAR (Z. Yang et al., 2023b):支持检测、分割和对象追踪。

- 任务应用: 学习全局场景建模,支持复杂任务(如检测、分割、追踪和占用预测)。

3. 主要数据集概览

- Waymo 数据集:

- 主要用于 LiDAR 数据驱动的方法(如对比学习和重建)。

- KITTI 数据集:

- 提供广泛的 LiDAR 和摄像头数据,常用于小规模任务。

- nuScenes 数据集:

- 被广泛应用于所有类型的自监督学习方法。

- ONCE 数据集:

- 用于世界模型和渲染方法,支持多任务学习。

4. 视觉任务分析

- 目标检测(Detection):

- 几乎所有自监督学习方法都支持目标检测任务。

- 语义分割(Segmentation):

- 重建和蒸馏方法表现突出。

- 占用预测(Occupancy Prediction):

- 主要由世界模型方法支持。

- 对象追踪(Tracking):

- 世界模型方法(如 UniWorld)也有所涉及。

5. 总结

- 表 3 展示了自监督学习在自动驾驶视觉任务中的多样化方法和应用。

- 各方法的选择取决于输入数据类型、任务需求和计算资源的可用性。

- 随着 nuScenes 和 Waymo 等高质量数据集的普及,这些方法在检测、分割和占用预测等任务中的表现将进一步提升。

4.1 Contrastive

从上述内容中,我们可以详细探讨 对比学习(Contrastive Learning) 在自动驾驶领域的应用和发展。以下是对相关内容的逐步解析:

1. 什么是对比学习(Contrastive Learning)

对比学习的核心目标是通过比较样本的相似性和差异性,学习到具有判别力的特征表示:

- MoCo(Momentum Contrast):

- 提出的对比学习方法,主要用于图像表示学习。

- MoCov2(X. Chen et al., 2020)进一步改进了其框架,使其在 2D 图像领域取得了显著成果。

- 灵感来自于对比学习在图像领域的成功,研究人员尝试将其扩展到 3D 自动驾驶任务。

2. 场景级别方法(Scene-level Methods)

场景级别的方法专注于整个点云场景的对比表示学习。

(1) 早期工作

- PointContrast(S. Xie et al., 2020):

- 针对 3D 点云提出的视图级别对比学习方法。

- 对两个增强点云的特征进行对齐,学习判别特征。

- DepthContrast(Z. Zhang et al., 2021):

- 利用视图对比的思想,专注于点云数据。

- 主要用于室内感知场景,但在语义信息上存在限制。

(2) 后续改进

- GCC-3D(H. Liang et al., 2021):

- 引入几何感知的对比框架,结合几何距离来指导点云的特征学习。

- 解决了传统硬标签策略中可能存在的“类别冲突”问题。

- SimIPU(Z. Li et al., 2022):

- 针对多模态点云和相机数据,提出了一种新的多模态对比学习预训练方法。

- 通过模块化的空间感知设计,显著提升了户外多模态数据的表现。

- AD-PT(Yuan et al., 2023):

- 采用点云的半监督预训练框架,通过少量标注和大量未标注点云数据来生成统一的特征。

3. 区域级别方法(Region-level Methods)

场景级别方法在捕获全局上下文方面有效,但可能丢失重要的局部细节。因此,区域级别的对比方法被提出。

(1) 细节解析

- SegContrast(Nunes et al., 2022):

- 针对语义分割任务,从点云中提取与类别无关的分割片段。

- 利用对比损失来捕获分割片段之间的上下文信息,提升语义分割准确性。

- ProposalContrast(Yin et al., 2022):

- 针对 3D 对象检测,提出了一种两阶段的提议区域级别自监督学习框架。

- 将学习单元聚焦于目标区域,降低了复杂的分割或提议池化计算的成本。

(2) BEVContrast(Sautier et al., 2024):

- 通过投影技术,将特征映射到 Bird’s Eye View(BEV)平面,并在二维网格中进行局部池化。

- 提供了一种高效的计算方式,适用于需要全局语义信息的场景。

4. 总结与展望

- 对比学习通过全局场景表示(Scene-level)与局部区域表示(Region-level)的结合,为自动驾驶感知提供了强大的特征学习能力。

- 方法的演变逐步解决了单纯全局方法在局部细节中的局限性,尤其是在多模态和几何感知的场景中表现突出。

- 未来可以关注以下方向:

- 在更大规模、更多模态的数据集上的对比学习性能。

- 更高效的计算框架,适应自动驾驶的实时需求。

- 结合其他方法(如渲染或蒸馏)以提升综合性能。

Fig. 7 Illustration of scene-level contrastive learning-based methods.

这张图(Fig. 7)展示了基于场景级别对比学习的方法,以下是图解内容的关键点:

1. 原理概述

场景级别对比学习主要用于从点云中学习特征,以下是具体的过程:

- 输入点云(Original Point Cloud):

- 原始点云被作为输入,例如由 LiDAR 捕获的 3D 场景数据。

- 数据变换(Transformations T1 和 T2):

- 原始点云经过两种不同的变换操作(T1 和 T2),生成两个不同版本的点云:

- T1: 一种随机的几何变换。

- T2: 另一种变换,可能涉及旋转、平移或其他扰动。

- 目的是制造不同的视图以供对比学习。

- 原始点云经过两种不同的变换操作(T1 和 T2),生成两个不同版本的点云:

2. 点云网络(Point Cloud Networks)

- 权重共享(Shared Weights):

- 两个经过变换的点云分别通过相同的点云网络(例如基于 PointNet 或其他架构的模型)。

- 网络对输入的点云进行特征提取,输出高维特征向量。

3. 特征对比(Feature Contrastive)

-

推拉机制(Pull Together & Push Apart):

- Pull Together:

- 提取的点云特征中,相同类别或来源的点云特征被“拉近”,表示它们在特征空间中的距离应更接近。

- Push Apart:

- 不同类别或来源的点云特征则被“推远”,确保模型能够有效地区分不同类别的点云。

- Pull Together:

-

对比损失(Contrastive Loss):

- 使用对比损失函数(如 InfoNCE 或其他变种),优化点云特征,使得变换后的视图能够维持一致性,同时具备区分力。

4. 适用场景

场景级别的对比学习通常适用于以下任务:

- 3D 点云检测: 用于目标检测或场景理解任务。

- 语义分割: 利用点云的空间结构提升语义分割性能。

- 点云对齐: 学习如何在几何变换下保持一致的点云特征。

5. 关键优势

- 鲁棒性: 能够在多视图、多变换下保持特征一致性。

- 高效性: 无需大量标签数据,适合自监督学习。

- 泛化性: 对新场景或不同类型点云有更好的泛化能力。

4.2 Reconstruction

这段论文内容集中讨论了**重建(Reconstruction)**在3D感知模型预训练中的关键作用,以及不同方法在摄像头、点云和多模态数据上的应用。以下是总结和分析:

1. 重建方法的总体作用

- 重建式预训练成为3D感知领域(尤其是自动驾驶)的核心技术。

- 它使用自监督学习方法,通过重建被遮挡或损坏的输入数据来预训练感知模型。

- 该方法可应用于摄像头数据和点云数据,有助于捕捉复杂的场景信息。

2. 基于摄像头的重建 (Camera-based Reconstruction)

- 主要方法:

- 利用Masked AutoEncoders (MAE) 等技术。

- 具体方法如:MAE、SimMIM、MCMMAE、MixMAE 和 SparK 等,都通过重建遮挡图像区域,实现对场景图像模式和不同组件之间关系的编码。

- 进展:

- GeoMIM 是第一个引入摄像头 MAE 预训练到自动驾驶的框架:

- 在训练阶段利用激光雷达 BEV 特征作为辅助信息,但推理时不需要激光雷达数据。

- 这一策略类似于蒸馏方法,提高了几何感知能力。

- GeoMIM 是第一个引入摄像头 MAE 预训练到自动驾驶的框架:

3. 基于点云的重建 (Point-cloud-based Reconstruction)

- 主要方法:

- Point-MAE:通过集合到集合的 Chamfer 距离损失,恢复遮挡的点,提高3D几何的重建精度。

- VoxelMAE:通过区分占用的体素来恢复点云数据。

- GeoMAE:通过引入几何信息(如质心、法向量和曲率)来提升模型对点云的理解。

- MaskPoint:采用二分类的方式预测点云是否被占用。

- MAELi:通过适应激光雷达的球面投影特性,实现点云数据的稀疏重建。

- 创新点:

- GD-MAE(生成解码器 MAE):引入生成式解码器,自动从环境中提取被遮挡的几何信息。

- BEV-MAE:使用鸟瞰图视角(BEV)指导模型学习特征表示,从而简化预训练过程。

4. 多模态重建 (Multi-modal Reconstruction)

- 挑战:如何从多模态(2D+3D)的数据中学习感知模型,仍然是开放性问题。

- 方法探索:

- PiMAE:提出一种3D和2D交互的自监督预训练框架,提升了2D和3D检测器的性能。

- M3I:统一了多模态数据的优化目标,从而简化了训练流程。

- MA3E:通过遮挡令牌学习统一的视觉和语言表示,用于迁移到下游任务。

5. 关键点总结

- 创新性:

- 论文提到的方法结合了多种技术(如 MAE、蒸馏策略、生成解码器等),有效提高了对遮挡信息的重建能力。

- 应用前景:

- 基于摄像头的重建适合场景理解和几何感知。

- 基于点云的重建更专注于几何结构,特别是对于稀疏数据的处理。

- 多模态重建则是未来的重点,尤其在融合视觉和语言、2D与3D数据方面。

Fig. 8 Illustration of reconstruction-based methods.

3d18ec9d1b527.png" alt="在这里插入图片描述" />

从图8中可以看出,这是一幅关于基于重建的预训练方法的示意图,展示了不同类型数据(图像、视频、点云、体素)的自监督预训练方式。以下是具体分析:

图中内容解读:

-

(a) Image MAE (图像 MAE)

- 过程:遮挡部分图像块(Mask),通过自监督学习重建被遮挡的区域。

- 特点:

- 专注于2D图像数据。

- 使用 Masked AutoEncoders (MAE) 方法。

- 适用场景:用于场景图像的理解和2D视觉任务。

-

(b) Video MAE (视频 MAE)

- 过程:对视频帧进行遮挡,通过学习重建遮挡部分。

- 特点:

- 增加了时间维度,需要捕捉空间和时间的上下文信息。

- 适用场景:运动目标检测、视频场景理解等。

-

© Point-MAE (点云 MAE)

- 过程:遮挡点云中的某些点,通过重建方法恢复点云。

- 特点:

- 专注于3D点云数据,如激光雷达点云。

- 使用 Chamfer 距离等指标衡量重建质量。

- 适用场景:3D场景重建、目标检测。

-

(d) Voxel-MAE (体素 MAE)

- 过程:对点云划分为体素网格,对遮挡的体素进行重建。

- 特点:

- 不仅关注点的分布,还考虑点之间的局部几何结构。

- 使用体素网格的表示方式增强3D数据的稠密性。

- 适用场景:稠密点云建模和几何信息恢复。

重建方法的核心机制

- 遮挡-重建:通过自监督的方式,随机遮挡输入数据的一部分,并利用剩余的可见数据重建被遮挡的部分。

- 优势:

- 学习到数据的底层模式和特征表示。

- 不需要人工标注,降低数据需求。

- 对不同类型的输入(图像、视频、点云、体素)具有通用性。

对比与应用场景

- Image MAE 和 Video MAE 适用于2D数据,主要在图像分类、检测、分割、视频分析中应用。

- Point-MAE 和 Voxel-MAE 适用于3D数据,广泛用于自动驾驶、点云分割、3D目标检测和场景理解等任务。

4.3 Distillation

片段主要讨论的是 基于蒸馏的预训练(Distillation-based pre-training) 技术,重点在于如何通过知识蒸馏(knowledge distillation)提升 LiDAR 感知模型 的性能,尤其是在数据受限和复杂表示的情况下。以下是内容总结与分析:

主要内容总结

-

知识蒸馏的基础概念

- 知识蒸馏是通过从已训练的“教师模型”中提取知识来提升“学生模型”性能的一种技术。在这里,论文聚焦于 LiDAR 感知模型 的蒸馏技术。

-

当前技术和研究进展

- 基于图像的感知方法的利用:

- 许多方法利用了基于图像的感知模型(Image-based perception models),特别是在数据丰富和已有模型可靠的情况下,将这些知识迁移到数据稀缺和表示复杂的场景中(例如 LiDAR 感知模型)。

- SLidR 和 S2M2-SSD 的研究:

- SLidR 和 S2M2-SSD 的框架提出了 2D-to-3D 和 fusion-to-3D 表示蒸馏方法,用于大规模点云的跨模态自监督学习。这些研究显著提升了 LiDAR 感知模型的性能。

- Mahmoud 等人(2023)贡献:

- 通过引入语义容忍的对比约束(semantically tolerant contrastive constraint)和类平衡损失(class-balancing loss),进一步优化了 SLidR 方法,实现了性能提升。

- SEAL 的最新进展:

- 构建在 SLidR 基础上,SEAL 结合了 Vision Foundation Models(VFMs),如 SAM(Segment Anything Model),提出了跨模态对比目标(cross-modal contrastive objective)。这一方法通过利用 VFMs 的强大表示能力,显著提高了跨模态表示蒸馏的能力。

- 基于图像的感知方法的利用:

-

蒸馏技术的价值

- 蒸馏技术显著提升了 LiDAR 感知模型 的性能,尤其是在涉及大规模点云和跨模态学习的预训练任务中。

- 通过将预训练图像模型中的知识迁移到 LiDAR 感知领域,研究者克服了 LiDAR 数据中的任务挑战,为未来自动驾驶系统中的 VFMs 技术奠定了基础。

分析与亮点

-

跨模态表示蒸馏的创新性

- 将 2D 图像知识迁移到 3D 点云,体现了图像和 LiDAR 数据之间的深度结合。

- SLidR 和后续改进(如 SEAL)成功地结合了自监督学习和跨模态对比学习,为处理复杂 LiDAR 数据提供了一种有效的解决方案。

-

基础模型的使用(VFMs)

- VFMs 的引入(如 SAM)展现了视觉基础模型在跨模态感知任务中的潜力。通过学习 VFMs 表示能力,这些方法更适用于自动驾驶等实际场景。

-

技术发展方向

- 未来研究可能集中于:

- 增强跨模态学习的鲁棒性

- 优化对比学习目标函数

- 在稀疏数据环境中进一步提升 LiDAR 模型性能

- 未来研究可能集中于:

Fig. 9 Illustration of distillation-based methods.

从您上传的图示和对应文字描述来看,这张图展示了基于蒸馏方法的架构流程(Distillation-based Methods),尤其在**教师模型(Teacher Model)和学生模型(Student Model)**之间的知识传递过程。以下是总结和分析:

图示总结

-

输入数据:多模态支持

- 输入可以是 LiDAR 点云(LiDAR Point Cloud)、摄像机图像(Camera Image),或者两者结合。

- 提供多模态输入使得模型在多种数据表示之间找到更通用的特征。

-

教师模型(Teacher Model)

- 教师模型通常是强大的预训练模型,可以在大规模数据集上训练完成。

- 教师模型接受多模态或单模态输入,通过其投影头(Projection Head)生成高质量特征或预测。

-

学生模型(Student Model)

- 学生模型设计为轻量级模型,其目标是通过蒸馏学习继承教师模型的知识。

- 蒸馏过程通过对比损失(contrastive loss)或一致性约束(consistency constraints)进行优化。

-

知识蒸馏(Knowledge Distillation)

- 学生模型从教师模型中学习高层次表示和预测特性。

- 通过教师模型生成的梯度信息(grad)指导学生模型优化。

-

投影头(Projection Head)

- 教师模型和学生模型都通过投影头来生成中间特征表示,用于对比学习和一致性约束优化。

文字描述总结

-

教师模型功能:

教师模型更强大,可以接收多模态或单模态输入,在大规模数据集上完成预训练。 -

学生模型功能:

学生模型较轻量级,通过蒸馏过程(contrastive loss 或 consistency constraints)从教师模型中学习,最终性能得以增强。 -

蒸馏方法目标:

通过蒸馏技术,知识从强大的教师模型传递给学生模型,同时利用对比损失等机制提升学生模型的泛化能力和性能。

关键点分析

-

多模态学习的增强

- 通过输入 LiDAR 和图像数据,教师模型能学到不同模态间的互补特征,提高模型的表达能力。

-

轻量级模型的重要性

- 由于实际场景(如自动驾驶)对模型推理速度和计算资源的限制,轻量级学生模型在部署中更具优势。

- 蒸馏方法有效提升学生模型性能,确保在资源受限情况下仍能获得较优表现。

-

对比学习与一致性约束的应用

- 对比学习(contrastive loss)利用模态间的相似性或差异性,帮助学生模型学到高质量的特征。

- 一致性约束(consistency constraints)确保学生模型生成的表示与教师模型保持一致。

4.4 Volume Rendering

这段内容介绍了体积渲染(Volume Rendering) 在3D感知领域中的作用,特别是针对自动驾驶场景的应用。以下是主要内容的分析和总结:

1. 体积渲染的基本原理

-

体积渲染是一种基于渲染的自监督学习方法,用于处理点云或多视图图像,生成统一的体积空间。

-

方法流程:

- 提取视觉特征(从点云或多视图图像中)。

- 结合相机的内参和外参,计算每个像素视图中的光线。

- 使用多层感知机(MLPs) 预测光线上的点的签名距离函数(SDF) 和 RGB 值。

- 基于这些预测值,通过可微渲染方法生成深度图和图像。

-

优点:

- 支持多模态输入(如点云与图像融合)。

- 渲染过程可微分,有助于网络优化。

2. 用于预训练的渲染方法

- 早期工作:

- Ponder D. Huang et al. (2023) 是最早提出的渲染式预训练方法,为这一领域奠定了基础。但其适用性目前仅限于室内场景。

- 扩展工作:

- H. Zhu et al. (2023) 扩展了稀疏体素表示,使渲染能够应用于室外场景,包括目标检测和语义分割等任务。

- PRED (H. Yang et al. 2023) 利用渲染技术进行激光雷达骨干网络的预训练,同时结合预训练语义分割模型生成伪标签,进一步增强预训练效果。

- UniPAD (H. Yang et al. 2023) 提出统一框架,可以接受多视图图像和点云作为输入,通过遮挡区域引导网络专注于关键信息。

3. 自监督占用预测 (Self-supervised Occupancy)

- 渲染方法还可以用于占用预测任务,为2D监督(深度图和语义图)提供支持。

- 方法探索:

- Rende-rOcc (M. Pan et al. 2023):

- 提出基于2D监督的占用预测方法,生成跨多个帧的3D光线。

- 通过动态物体选取光线,结合类别平衡采样,最终渲染深度和语义图。

- SelfOcc (Y. Huang et al. 2023):

- 在类似框架中引入伪深度和伪语义标签作为额外监督。

- OccNeRF (C. Zhang et al. 2023):

- 引入时间光度一致性损失,监督渲染深度,减少对深度标签的依赖。

- Rende-rOcc (M. Pan et al. 2023):

4. 渲染方法的优势

- 渲染方法作为一种补充工具,推动了视觉基础模型(VFM) 在自动驾驶领域的发展。

- 特点:

- 充分利用2D标签进行3D感知。

- 拓展了渲染技术的应用范围,如从室内到室外、多模态融合等。

关键点总结

- 体积渲染通过将2D和3D数据统一到一个可微分框架中,有效提升了3D场景理解能力。

- 预训练方法扩展到室外和复杂场景,并结合伪标签生成进一步增强学习效果。

- 自监督占用预测方法创新地利用2D监督信号进行3D建模,并结合伪标签和一致性损失减少对真实标签的需求。

Fig. 10 Illustration of rendering-based methods.

从您提供的图示(Fig. 10)来看,这部分图解了**基于渲染的方法(Rendering-based Methods)**在3D特征体积到多视图RGB图像和深度图的渲染过程。以下是详细总结和分析:

图解内容总结

-

输入和特征表示

- 输入数据通过多层感知器(MLP)提取特征,并映射到一个**体积表示(Volumetric Representation)**中,形成统一的体素特征表示。

- 光线追踪(Ray Points)用于连接3D体积和多视角图像。

-

渲染过程

- 光线在体素空间中采样,并通过特征向量表示每个采样点的属性。

- 渲染过程由两个网络完成:

- SDF Network(符号距离函数网络):

用于预测每个光线点的深度值,生成渲染的深度图(Rendered Depth Images)。 - RGB Network(RGB网络):

用于预测每个光线点的RGB值,生成渲染的RGB图像(Rendered RGB Images)。

- SDF Network(符号距离函数网络):

-

输出监督

- 渲染的深度图和RGB图像通过**可微分神经渲染(Differentiable Neural Rendering)**生成。

- 渲染结果与原始多视图RGB图像和深度图进行对比,作为监督信号,用于优化渲染网络。

图解方法分析

-

核心流程:

- 通过将3D特征映射到体积空间,并沿着光线对采样点进行预测,结合深度图和RGB图像的渲染,提供了一个统一的渲染框架。

- 这一过程利用多模态数据(点云、图像)和体渲染技术,在多视图重建任务中提供高质量的深度和RGB表示。

-

网络模块:

- SDF Network:

使用符号距离函数(Signed Distance Function)表示场景中的几何结构,对深度进行预测。 - RGB Network:

对光线上的颜色值进行预测,捕获场景的外观信息。

- SDF Network:

-

可微分渲染:

- 可微分渲染是关键技术,使得整个渲染过程可以端到端训练,深度图和RGB图像的差异能够通过梯度传递回网络参数中。

方法亮点

-

体素表示与光线追踪的结合:

- 将3D场景转换为体素表示,并通过光线追踪技术采样,实现了从3D到2D的有效转换。

-

多模态监督:

- 利用多视图RGB和深度图作为监督信号,提升了模型的重建质量和预测精度。

-

可扩展性:

- 这一方法可以扩展到各种3D感知任务,包括自动驾驶、AR/VR场景重建等。

4.5 World Model

这部分讨论了**世界模型(World Model)**在人工智能,尤其是自动驾驶领域的应用和发展,重点介绍了不同研究工作中的创新设计。以下是总结与分析:

世界模型的定义与作用

-

定义

世界模型是人工智能中的一个长期研究概念,主要用于预测未来状态,基于行动和过去的观测来推理环境演变。 -

核心能力

- 理解环境并预测其未来状态。

- 不依赖与真实环境的直接交互,即可进行推理和决策。

-

成功应用

世界模型已在机器人学、模拟环境(如自动驾驶场景)和实际场景中获得了广泛应用。 -

在自动驾驶中的价值

当前研究工作与方法

1. Image-based World Models

-

GAIA-1 (Hu et al., 2023)

- 生成式世界模型,输入包括图像、文本和动作。

- 利用自回归Transformer预测下一个动作序列,结合视频扩散模型(Video Diffusion Models)提高输出的时间一致性。

- 局限:未关注控制信号的预测,仅适合模拟驾驶场景。

-

ADriver-I (Jia et al., 2023)

- 提出无限驾驶的概念,结合历史视觉-动作对和当前视觉信息,直接预测低级控制信号和未来帧。

- 使用多模态大语言模型(MLLM)和视频扩散模型生成未来驾驶场景。

-

Drive-WM (Wang et al., 2023)

- 解决多视图和时间一致性问题,通过联合建模未来多视图和帧,生成更真实的驾驶场景视频。

2. 3D World Models

-

OccWorld (Zheng et al., 2023)

- 基于3D占用预测,使用自监督方法对高层概念和场景进行编码。

- 提出空间-时间生成式Transformer,用于预测未来占用场景和运动轨迹。

-

Waabi-WM (Zhang et al., 2023)

- 通过离散扩散框架预测未来场景,并利用MaskGIT提升解码效率。

-

MUVO (Bogdoll et al., 2023)

- 使用几何体素表示(Geometric Voxel Representations),结合相机和LiDAR数据预测多步未来的场景表示。

3. World Models for Pre-training

-

UniWorld (Min et al., 2023b)

- 使用未标注的图像-LiDAR数据对世界模型进行预训练。

- 将多视图图像生成统一特征,并转化为鸟瞰图(BEV)表示,用于占用预测任务,并支持下游任务。

-

ViDAR (Yang et al., 2023b)

- 基于历史视觉信息预测未来点云,通过潜在渲染操作(Latent Rendering Operator)提升多任务性能,包括3D目标检测、语义分割、占用预测等。

方法优势与创新点

-

自监督学习

- 多数世界模型通过自监督学习方式训练,避免了对大规模标注数据的依赖。

- 示例:OccWorld 使用生成式Transformer预测未来场景。

-

多模态输入

- 结合视觉、LiDAR和动作数据,增强了模型的感知能力。

- 示例:MUVO 模型整合了相机和 LiDAR 数据。

-

生成式方法

- 使用扩散模型和生成式Transformer预测未来帧,生成更真实的驾驶场景。

- 示例:ADriver-I 利用视频扩散模型预测未来驾驶场景。

-

时间和空间一致性

- 针对未来帧生成中的视觉和时间一致性问题提出了优化。

- 示例:Drive-WM 通过联合建模多视图和时间一致性提高预测效果。

未来发展方向

-

统一框架设计

- 设计兼容多模态输入的统一框架,并适应不同场景需求。

-

实时性优化

- 提升模型的推理效率,满足自动驾驶场景中的实时性要求。

-

增强泛化能力

- 提高模型在多种驾驶场景和动态环境中的适应性。

-

结合更多先验知识

- 融入交通规则、驾驶经验等先验知识,生成更安全和合理的驾驶决策。

Fig. 11 Illustration of world-model based methods.

图 11 展示了基于 ViDAR(Visual Point Cloud Forecasting) 的世界模型的预训练方法,重点在于多视图几何和时间建模下的未来点云预测。这一模型使用自监督学习方法,通过历史多帧图像预测未来帧的点云数据。以下是详细解读:

图示总结

-

模型任务目标

- 预测未来扫描(点云),作为自监督学习的预任务。

- 提供时间序列点云的多视图表示,既包含空间几何信息,也包含时间变化信息。

-

主要组件:

- 输入数据:

多帧、多视角图像(Multi-frame Multi-view Images),用于提供历史视觉信息。 - History Encoder(历史编码器):

编码输入的历史帧信息,将其转换为嵌入表示(embedding vectors)。 - Latent Rendering(潜在渲染):

通过渲染操作将编码的嵌入映射到3D几何空间,为未来点云预测生成隐式表示。 - Future Decoder(未来解码器):

逐步解码未来时间点(如 t+1、t+2、t+3)的点云,生成未来的鸟瞰图(BEV Queries)和车辆自身运动状态(Ego-motion)。

- 输入数据:

-

输出:

- 生成的未来点云(Multi-frame Point Clouds),结合未来场景的几何结构和车辆运动预测。

方法亮点与创新

-

多视图和时间建模:

- 同时考虑多视角信息(Multi-view Geometry)和时间序列变化(Temporal Modelling),增强了对动态场景的建模能力。

- 在自动驾驶场景中,可以更好地预测未来点云,为路径规划和避障提供支持。

-

潜在渲染(Latent Rendering):

- 将历史编码映射到3D空间,通过隐式表示连接历史和未来数据。这种方式减少了对真实点云标注的依赖。

-

逐步解码(Future Decoder):

- 解码器分阶段预测未来场景,通过鸟瞰图(BEV)和车辆运动预测增强了未来点云的生成精度。

-

自监督预训练:

- 预测未来点云作为自监督学习任务,不需要昂贵的标签,能够充分利用未标注的多模态数据。

应用场景与价值

-

自动驾驶:

- ViDAR 模型可以为动态环境下的未来场景预测提供高效工具。

- 通过预测未来点云,帮助实现更精准的路径规划和避障。

-

多任务学习:

- 生成的鸟瞰图和点云可以为其他任务(如3D目标检测、语义分割)提供预训练特征。

-

研究价值:

- 通过隐式渲染和多帧解码器的方法,探索时间和空间上的联合建模,是世界模型在视觉点云预测中的新尝试。

未来改进方向

-

提高预测精度:

- 进一步优化潜在渲染操作,使得生成的未来点云与真实场景更加一致。

-

引入更多模态:

- 结合 LiDAR 数据、车辆传感器数据,进一步增强多模态建模能力。

-

应用到实时场景:

- 提高解码器的实时性,适应自动驾驶中的动态场景预测需求。

Table 4 Summary of techniques for world model.

3dc63481f9ae06187beddc471.png" alt="在这里插入图片描述" />

这张表格(Table 4)总结了多种世界模型的关键技术特性,包括输入、编码器(Encoder)、模型架构(Architecture)、解码器(Decoder)和输出。以下是详细的总结和分析:

表格内容逐项解析

1. ADriver-I (Jia et al., 2023)

- 输入(Input): 图像(I)和动作(Act,以文本格式)。

- 编码器(Encoder): CLIP-ViT(Vision Transformer)。

- 模型架构(Architecture): 扩散模型(Diffusion)。

- 解码器(Decoder): 视频扩散解码器(Video Diffusion Decoder)。

- 输出(Output): 图像(I)和动作(Act)。

特点:

- 使用 CLIP-ViT 作为编码器,结合扩散模型生成未来图像和动作。

- 适用于复杂的驾驶场景中,特别是历史视觉-动作对的预测。

2. DriveDreamer (X. Wang et al., 2023)

- 输入(Input): 图像(I)、动作(Act)、3D框和文本(3D Box, Text)。

- 编码器(Encoder): VAE(变分自动编码器)。

- 模型架构(Architecture): 扩散模型(Diffusion)。

- 解码器(Decoder): 视频解码器和动作解码器(Video Decoder, Action Decoder)。

- 输出(Output): 图像(I)和动作(Act)。

特点:

- 引入 3D 空间中的框和文本信息,进一步增强了对场景的理解。

- 适合需要生成复杂驾驶行为的任务。

3. Driving-WM (Y. Wang et al., 2023)

- 输入(Input): 图像(I)和动作(Act)。

- 编码器(Encoder): VAE(变分自动编码器)。

- 模型架构(Architecture): 扩散模型(Diffusion)。

- 解码器(Decoder): VAE解码器(VAE Decoder)。

- 输出(Output): 图像(I)和轨迹(Traj)。

特点:

- 侧重于轨迹生成任务,通过 VAE 建模视觉和动作之间的关系。

- 在未来轨迹预测和场景生成中表现优异。

4. OccWorld (Zheng et al., 2023)

- 输入(Input): 占用场景(Occ)和自车运动姿态(Ego Poses)。

- 编码器(Encoder): VQVAE(向量量化自动编码器)。

- 模型架构(Architecture): GPT(生成式预训练Transformer)。

- 解码器(Decoder): VQVAE 解码器。

- 输出(Output): 占用场景(Occ)和自车运动姿态(Ego Poses)。

特点:

- 使用占用预测和自车运动建模未来场景。

- 基于 GPT 的空间-时间生成方法,适合动态环境中的场景建模。

5. Waabi-WM (L. Zhang et al., 2023)

- 输入(Input): 点云(PC)和动作(Act)。

- 编码器(Encoder): VQVAE(向量量化自动编码器)。

- 模型架构(Architecture): 离散扩散(Discrete Diffusion)。

- 解码器(Decoder): VQVAE 解码器。

- 输出(Output): 点云(PC)。

特点:

- 专注于点云预测,结合动作信息生成未来点云。

- 离散扩散框架的应用提高了点云生成的效率和准确性。

6. GAIA-1 (A. Hu et al., 2023)

- 输入(Input): 图像(I)、文本(Text)和动作(Act)。

- 编码器(Encoder): VQVAE(向量量化自动编码器)。

- 模型架构(Architecture): GPT(生成式预训练Transformer)。

- 解码器(Decoder): 视频扩散解码器(Video Diffusion Decoder)。

- 输出(Output): 图像(I)。

特点:

- 以生成未来图像为主,利用 GPT 和扩散模型提高生成的时间一致性。

- 局限于图像生成任务,未涉及动作控制信号。

7. MUVO (Bogdoll, Yang, and Zöllner, 2023)

- 输入(Input): 图像(I)、点云(PC)和动作(Act)。

- 编码器(Encoder): ResNet-18 和 SensorFusion。

- 模型架构(Architecture): GRU(门控循环单元)。

- 解码器(Decoder): 任务特定解码器(Task Specific Decoder)。

- 输出(Output): 图像(I)、动作(Act)和占用场景(Occ)。

特点:

- 综合使用多模态数据(图像、点云、动作)建模未来场景。

- 使用 GRU 处理时间序列数据,适合多任务场景中的长时间依赖建模。

表格总结

-

输入数据多样性:

- 不同方法结合了图像(I)、点云(PC)、动作(Act)等多种数据类型,部分方法(如 GAIA-1 和 DriveDreamer)还引入了文本作为输入。

-

编码器的选择:

- 常用编码器包括变分自动编码器(VAE)、向量量化自动编码器(VQVAE)、ResNet 等,适用于不同任务特性。

-

模型架构的多样性:

- 扩散模型(Diffusion)在生成未来图像和场景时占主导地位。

- GPT 架构用于占用预测和空间-时间建模,展现了强大的生成能力。

-

输出特性:

- 输出多集中于图像(I)、动作(Act)、占用场景(Occ)以及轨迹(Traj),满足自动驾驶多样化任务需求。

未来研究方向

-

多模态整合:

- 探索更加高效的多模态数据融合方式,提高输入信息的利用效率。

-

模型泛化:

- 提高世界模型在多种驾驶场景中的适应性,特别是动态和稀疏标注环境下的性能。

-

实时性优化:

- 优化计算效率,满足实际部署中的实时预测需求。

5 Adaptation

这一段内容来自第5章:Adaptation(适配),讨论了将现有基础模型(Foundation Models)应用于自动驾驶领域的挑战与解决方法。以下是详细的总结和分析:

核心内容总结

-

现状与挑战:

-

可行性分析:

- 现有的基础模型(Foundation Models)为自动驾驶领域的探索提供了重要参考,包括:

- 视觉基础模型(Vision Foundation Models)

- 多模态基础模型(Multimodal Foundation Models)

- 大型语言模型(Large Language Models)

- 现有的基础模型(Foundation Models)为自动驾驶领域的探索提供了重要参考,包括:

-

研究目标:

- 通过分析现有基础模型的应用,发现其在自动驾驶领域的局限性。

- 从其他领域的基础模型中汲取关键经验和洞察,提炼出设计专用视觉基础模型的方向。

-

成果与提议:

分析与关键点

-

现有基础模型的优势:

- 视觉基础模型: 在图像识别、场景理解等任务中表现优异。

- 多模态基础模型: 提供了处理多模态输入(如图像、文本、LiDAR点云)的能力。

- 大型语言模型: 在知识推理、指令理解和解释任务中展现了强大的泛化能力。

-

自动驾驶领域的独特需求:

-

基础模型的局限性:

-

专用视觉基础模型的必要性:

未来研究方向

-

专用模型设计:

-

模型训练优化:

- 利用大规模自动驾驶场景数据进行预训练,提升模型在特定领域的泛化能力。

- 融入自监督学习和强化学习机制,以更好地适应动态环境。

-

多模态整合:

- 深入探索视觉、LiDAR和语言数据的联合建模方法,为多模态感知任务提供高效解决方案。

-

实时性与部署:

- 优化计算资源需求,提高模型在嵌入式系统中的运行效率,满足实际部署的实时性要求。

Table 5 Overview of the adaptation of existing foundation models in autonomous driving scenarios.

这是一张关于基础模型(Foundation Models, FMs)在自动驾驶场景中的适配概述的表格,内容包括不同方法、类型、任务和数据集的对应关系。以下是详细分析:

表格内容结构

1. Method(方法)

列举了多种在自动驾驶场景中使用的基础模型方法,包括2023年和2024年的研究工作。

2. Type(类型)

方法的分类主要分为以下几类:

- VFM(Vision Foundation Model):视觉基础模型,主要用于感知任务。

- LLM(Large Language Model):大语言模型,更多用于决策规划等高层任务。

- CLIP:基于视觉-语言的跨模态模型。

- VLM(Vision-Language Model):视觉-语言基础模型,用于多模态任务。

3. Task(任务)

任务范围覆盖了自动驾驶的多个领域,从感知到规划决策:

- LiDAR-Camera Calibration(激光雷达与摄像头校准)

- 2D/3D Semantic Segmentation(语义分割)

- Occupancy Prediction(占据预测)

- Scene Understanding(场景理解)

- Planning(路径规划)

- Decision-Making(决策)

- Tracking(目标跟踪)

4. Dataset(数据集)

列举了用于各类任务的代表性数据集,包括:

- KITTI:经典的自动驾驶感知数据集。

- nuScenes:涵盖多传感器数据的综合自动驾驶数据集。

- Cityscapes:城市街景语义分割数据集。

- Waymo:Waymo公开的大规模自动驾驶数据集。

- CARLA/DAIR-V2X:用于虚拟仿真和车联网研究的数据集。

主要观察与总结

视觉基础模型(VFM)

- CalibAnything、RobustSAM、SPINO 等方法基于视觉任务,主要处理激光雷达与摄像头的校准、多视角语义分割等问题。

- 典型任务包括 2D/3D语义分割 和 点云分割。

- 使用的数据集多为 KITTI、nuScenes、SemanticKITTI 等经典感知数据集。

大语言模型(LLM)

- GPT-Driver、LanguageMPC、HiLM-D 等方法将LLM引入高层次任务,例如场景理解、路径规划和决策。

- 这些模型擅长基于文本描述的指令进行自动驾驶模拟,进一步增强了系统的灵活性。

- 使用的模拟数据集包括 IdSim、HighwayEnv、DRAMA。

跨模态模型(CLIP 和 VLM)

- CLIP2Scene、Dolphins 等方法通过视觉-语言的结合,推动了自动驾驶场景的语义分割和场景识别任务。

- VLM(Vision-Language Models) 更侧重于融合视觉与语言,处理多模态任务,如场景认知与决策。

- 数据集扩展到跨模态领域,如 ScanNet、nuScenes 和 BDD-X。

趋势与价值

-

多模态融合:

- 自动驾驶正在从单一视觉/激光雷达感知,向视觉与语言结合的方向发展(如VLM)。

- 这种趋势提高了对场景理解的深度和人机交互的灵活性。

-

任务分工细化:

- 感知任务由视觉基础模型(VFM)主导,侧重于低层次的场景语义分割和几何理解。

- 规划与决策任务则更多依赖大语言模型(LLM),展现出对高层语义的深刻把握。

-

数据集多样性:

- 自动驾驶数据集覆盖了从实际驾驶场景到虚拟仿真环境的多种情况,增强了模型的泛化能力。

-

模型适配性增强:

- 各类方法将通用基础模型适配至具体任务,显著降低开发难度,并提高了模型的可扩展性。

应用场景

- 自动驾驶感知:点云分割、语义分割等VFM方法直接提升车辆对环境的感知能力。

- 智能导航:LLM方法能够优化路径规划和决策过程,实现更加人性化的驾驶行为。

- 跨模态增强:CLIP和VLM方法为多模态数据的融合提供了解决方案,有助于提升场景理解能力。

5.1 Vision Foundation Model

这一部分内容主要聚焦于**视觉基础模型(Vision Foundation Model, VFM)**的潜力与局限性,尤其是在自动驾驶领域中的应用。以下是总结和分析:

核心内容总结

-

视觉基础模型的应用

- 社区对视觉基础模型(如 SAM 和 DINO)的广泛接受和研究带来了大量潜在应用,涵盖了从 2D 到 3D 的广泛任务:

- 2D任务:

- 图像修复(Image inpainting)[T. Yu et al., 2023]。

- 图像描述生成(Image captioning)[T. Wang et al., 2023]。

- 视频目标跟踪(Video object tracking)[J. Yang et al., 2023]。

- 医学图像分析(Medical image analysis)[Y. Huang, Y. Ma et al., 2023]。

- 3D任务:

- 研究如 [C. Chen et al., 2023; D. Zhang et al., 2023; Y. Zhou et al., 2023] 在 3D 分析任务中应用 VFM。

- 2D任务:

- 通过延展和改进,VFM 被广泛应用于自动驾驶场景的任务。

- 社区对视觉基础模型(如 SAM 和 DINO)的广泛接受和研究带来了大量潜在应用,涵盖了从 2D 到 3D 的广泛任务:

-

在自动驾驶中的适配与应用

- SAM 的应用:

- Calib-Anything [Z. Luo et al., 2023]: 利用 SAM 提出一种零额外训练的 LiDAR-相机校准方法,适配多种常见场景。

- Shan et al. (2023): 探讨 SAM 的分割鲁棒性,验证其在不同自动驾驶数据集上的适应性。

- DINO 的应用:

- SPINO [Käppler et al., 2023]: 利用 DINOv2 提取的任务无关特征,实现了全景分割的泛化能力。

- VFM 在训练中的作用:

- SEAL [Y. Liu et al., 2023]: 使用 SAM 类模型进行大规模 3D 点云的自监督表征学习。

- Peng et al. (2023): 利用实例掩码提高 3D 语义分割领域的无监督领域自适应。

- RadOcc [Zhang et al., 2023]: 结合 SAM 的形状先验信息进行段引导知识蒸馏,用于增强 3D 占用表示。

- SAM 的应用:

-

视觉基础模型的局限性

- VFM 在图像感知任务中表现优秀,但在处理 3D 信息时存在明显不足:

- 3D建模能力有限: 由于缺乏针对点云或其他 3D 模态的设计,现有模型难以捕获完整的 3D 场景信息。

- 架构适配性问题: 当前 VFM 的架构通常针对 2D 任务优化,难以无缝集成新的模态(如 LiDAR 点云)。

- VFM 在图像感知任务中表现优秀,但在处理 3D 信息时存在明显不足:

分析与亮点

-

应用领域的广泛性

- VFM 的高迁移能力使其在图像、视频、医疗等领域具备通用性。

- 在自动驾驶领域的适配,通过结合 LiDAR 数据、任务无关特征提取等方式,提升了模型在动态场景中的表现。

-

创新的适配方法

- 如 Calib-Anything 提出了一种无额外训练的 LiDAR-相机校准方法,展示了 VFM 在多模态数据适配中的潜力。

- RadOcc 通过蒸馏结合跨模态知识传递,推动了 3D 表示学习的进展。

-

对 3D 分析任务的拓展

- 将 SAM、DINO 等模型的能力从 2D 图像扩展到 3D 场景中,使 VFM 能够部分适应自动驾驶中的 3D 任务。

-

局限性与研究方向

- 现有 VFM 的 3D 表示能力不足,阻碍了其在自动驾驶等需要高度 3D 感知能力的场景中的表现。

- 需要设计专门的架构,将 LiDAR 数据等新模态无缝融入模型,或者开发直接面向 3D 的新一代基础模型。

未来研究方向

-

跨模态模型设计

- 开发能够同时处理 2D 和 3D 数据的统一基础模型架构,解决现有模型在 3D 任务中的局限性。

-

自监督与多模态结合

- 借助自监督学习,结合视觉和 LiDAR 等多模态信息,进一步提升感知能力。

-

优化基础模型架构

- 针对自动驾驶场景,开发优化的轻量级基础模型,以适应实时性和部署要求。

-

领域适配与泛化

- 通过领域自适应技术(如 Peng 等人提出的方法)增强 VFM 在动态、复杂场景中的表现。

Fig. 12 Illustration of a method that adapts SAM to segment any point cloud.

3d7243690aed.png" alt="在这里插入图片描述" />

这是一张展示如何将 Segment Anything Model (SAM) 应用于点云分割的图示,图中的方法结合了多模态数据(2D图像和3D点云)和语义分割技术,适配点云场景。以下是详细解读:

图解核心内容

1. 2D-3D对应关系 (2D-3D Correspondence)

- 左侧展示了将 相机图像 (Camera) 和 激光雷达 (LiDAR) 数据相结合的过程:

- 相机捕捉的图像:用于获取2D的场景语义信息。

- 激光雷达点云:提供3D几何信息,帮助定位实际物体的空间位置。

- 姿态估计 (Pose):通过姿态信息将2D图像的像素坐标与3D点云的点位一一对应,实现数据对齐。

2. 传感器数据 (Sensor Data)

- 中间部分展示了来自两种传感器的数据:

- 图像 (左上):原始相机拍摄的城市街景图像。

- 点云 (左下):通过激光雷达采集的3D点云数据,提供几何结构。

- GT (Ground Truth):点云的手动标注语义分割结果。

3. SAM分割方法 (Segment Anything Model, SAM)

- SAM是一种强大的通用分割模型,能够从2D图像中提取语义分割信息。

- 图中右上部分展示了SAM生成的语义分割图像:

- 将图像中的不同对象(如车辆、建筑物、行人等)分割为不同的语义区域。

- SAM的分割结果通过2D-3D对应关系,映射到激光雷达点云上,实现点云的语义分割。

4. 点云分割结果

- SAM方法用于点云分割的最终结果分为两类:

- GT (Ground Truth):人工标注的点云分割结果,用作对比基准。

- Seal:使用SAM生成的自动分割结果,与GT相比,精度虽稍有差距,但无需人工干预,成本显著降低。

创新点与亮点

-

多模态数据融合:

- 通过姿态估计,将2D图像和3D点云进行对齐,最大化利用两种数据的优势。

- SAM在2D图像上的优秀表现,成功扩展到点云分割任务中。

-

自动化语义分割:

- SAM无需人工标注即可生成高质量的2D分割结果,再映射到点云上,大幅降低分割成本。

-

自监督学习潜力:

- SAM适用于自动驾驶和机器人场景中的大规模数据分割任务,为自监督学习提供了可能性。

实际应用价值

-

自动驾驶系统:

- 提升车辆感知能力,通过高效的点云分割,实现更精准的障碍物识别和场景理解。

-

机器人导航:

- 在复杂环境中,点云分割结果可用于路径规划和避障,显著提高导航效率。

-

数据标注加速:

- SAM的点云分割能力可用于加速自动驾驶数据集的标注过程,减少人工工作量。

总结

该方法利用SAM模型从2D到3D的映射能力,实现了点云的语义分割,为自动驾驶和其他需要多模态数据处理的场景提供了一种高效、低成本的解决方案。未来,可以进一步探索如何优化点云映射的精度,并结合实时数据处理需求,提升实际应用性能。

5.2 Large Language Models

这段内容主要介绍了大语言模型(Large Language Models, LLM)在自动驾驶领域中的应用、潜力及局限性,以下是详细解析:

1. LLM在自动驾驶领域的核心优势

-

泛化与解释能力(Generalization and Interpretability):

- LLM在处理超出训练分布的场景(如罕见的稀有事件)时表现出色。

- 它们内置的推理能力非常适合需要逻辑处理和决策的任务。

-

少样本学习(Few-shot Learning):

- LLM能通过少量样本快速适应任务,尤其在数据稀缺的场景下,能够实现模型快速、准确的适配与推理。

2. LLM的典型应用场景

(1) 路径规划(Planning)

- GPT-Driver(Mao et al., 2023):使用GPT-3.5作为运动规划器,生成改进后的轨迹规划。

- Drive Like a Human(Fu et al., 2024):

- 探索LLM在人类驾驶逻辑中的应用,重点解决长尾场景中的推理与问题解决。

- LanguageMPC(Sha et al., 2023):

- 将语言模型与模型预测控制(Model Predictive Control, MPC)结合,实现更优的决策规划。

- DiLu(Wen et al., 2023):

- 构建基于知识驱动的多任务系统,聚焦推理、反思和记忆能力。

(2) 感知(Perception)

- PromptTrack(Wu et al., 2023):

- 提出了一种跨模态的推理方法,通过提示的方式预测3D物体的位置和运动轨迹。

- HiLM-D(Ding et al., 2023):

- 引入一种高分辨率的多模态LLM架构,用于风险目标定位、意图预测和建议生成。

- 通过将细粒度的视觉信息嵌入LLM框架,提升了潜在危险的定位能力及行为预测能力。

- DriveGPT4(Xu et al., 2023):

- 专注于视觉问答能力,处理与驾驶相关的场景问题,如车辆状态、导航指导和交通情境理解。

- LiDAR-LLM(Yang et al., 2023):

- 探索了LLM在3D点云理解中的潜力,将3D场景的认知重新定义为语言建模问题,支持3D问答和零样本任务。

3. LLM的局限性与改进方向

-

对3D空间理解的限制:

- 当前的LLM在3D场景建模方面存在明显不足,例如无法完全理解停车等复杂任务所需的3D空间。

- 如何将LLM扩展为适配3D任务的基础模型,仍是一个亟需探索的开放问题。

-

未达到当前领域最优性能:

- LLM的性能尚未在自动驾驶的下游任务(如高精度规划、实时感知等)中达到最优表现。

- 虽然LLM在泛化与推理方面表现出色,但具体任务的执行效果仍需进一步优化。

4. LLM在自动驾驶中的潜力

- LLM在视觉任务中表现出强大的适应能力,尤其适合数据稀缺场景。

- 通过结合语言提示,LLM可以有效融合多模态信息(如3D检测与语言提示),提升场景理解和预测能力。

- HiLM-D和DriveGPT4等研究进一步展示了LLM在风险预测、意图识别和建议生成中的巨大潜力。

总结与展望

- LLM为自动驾驶提供了一种新的范式,从路径规划到场景感知,再到语言交互,其应用范围广泛。

- 然而,提升LLM在3D空间理解与下游任务的实际性能是未来发展的重要方向。

- 未来,可能需要结合专门设计的3D感知模块与LLM的推理能力,构建更全面的多模态自动驾驶基础模型。

Fig. 13 Illustration of a method that adapts the large language model as a motion planner for autonomous driving.

3dd058a.png" alt="在这里插入图片描述" />

这张图展示了一个将大语言模型(LLM, 如GPT)用作运动规划器的方法,主要应用于自动驾驶中的路径规划。以下是对图中内容的详细解读:

图解核心内容

1. 整体流程概述

-

输入:感知与预测数据(Perception and Prediction)

- 系统首先从传感器数据中获取场景信息,包括:

- 车辆的位置与运动状态(如“Car at (12.05, 4.12), moving to (11.98, 2.30)”)。

- 自车状态(Ego-states),例如速度信息(如“Velocity: (0, 2.34)”)。

- 这些信息以语言描述的形式输入到LLM中。

- 系统首先从传感器数据中获取场景信息,包括:

-

核心:LLM进行运动规划

- 大语言模型将感知和预测的信息转化为语言描述。

- 通过其强大的推理能力,LLM生成规划结果,包括:

- 潜在风险分析(Potential Effects):如“Within the safety zone of the ego-vehicle”。

- 规划轨迹(Planned Trajectory):如“[(0.12, 2.98), …, (3.45, 18.90)]”。

-

输出:运动规划结果(Motion Planning Results)

- LLM输出以语言形式描述规划结果,并用于指导自车的运动。

2. 方法的核心特点

-

语言描述转化:

- 将感知数据转化为语言描述,使LLM可以理解并处理。

- 利用LLM的语言推理能力,将高维的感知信息(如车辆状态和轨迹)映射为规划决策。

-

动态环境推理:

- 通过感知模块,预测周围车辆的行为(如位置变化),并评估潜在的安全风险。

- 例如,LLM可以识别自车与周围车辆的安全距离,并在此基础上生成合理的路径。

-

规划结果解释性:

- LLM输出的规划轨迹具有较强的解释性,可直接分析“为什么选择该路径”。

3. 应用场景与潜在优势

-

动态环境中的路径规划:

- LLM可以通过对周围环境的语言描述,动态生成复杂环境下的安全轨迹,例如在交通拥堵或多车变道的场景中。

- 例如,上图中描述了车辆运动状态和潜在风险,确保规划轨迹的安全性。

-

人机协同决策:

- 由于LLM输出以语言为主,规划结果可以直接供驾驶员或开发者理解,便于人机协作。

-

快速适配能力:

- LLM基于**少样本学习(Few-shot Learning)**的能力,可以在不同环境下快速适配,从而降低数据和模型训练成本。

4. 局限性与挑战

-

实时性不足:

- 由于LLM对输入输出过程较为复杂,可能难以满足实时规划需求。

-

三维空间理解能力有限:

- 当前方法通过语言描述进行推理,但LLM对3D场景的理解仍较为抽象,可能导致复杂场景下的规划精度下降。

-

安全性与鲁棒性:

- 在高风险场景中(如高速公路变道),LLM的规划结果是否足够可靠,仍需进一步验证。

总结与展望

- 该方法展示了LLM在自动驾驶运动规划中的潜力,尤其是在复杂场景的动态推理和高层次规划中表现出色。

- 未来的改进方向可能包括:

- 结合LLM与传统的运动规划算法,提高实时性和精度。

- 加强LLM对3D空间的理解能力,以适配更复杂的驾驶环境。

- 优化模型性能,使其满足实际部署需求。

5.3 Multimodal Foundation Models

这段内容主要讨论了**多模态基础模型(Multimodal Foundation Models, MFMs)**在自动驾驶中的应用,特别是CLIP模型及其他视觉-语言模型(VLMs)的潜力。以下是详细解读:

1. CLIP模型及其应用

CLIP简介

- CLIP(Contrastive Language-Image Pre-training) 是一个基于Transformer架构的多模态基础模型,结合视觉和文本编码器,能够从图像和文本中独立提取特征,并通过计算两者的对齐分数来实现语义理解。

- CLIP通过在超过4亿对(图像-文本)数据上进行预训练,达到了领先的图像表征性能。

CLIP在自动驾驶中的应用

-

开放词汇语义分割(Open-Vocabulary Semantic Segmentation):

- 自动驾驶需要能够识别新物体的能力,这对于动态场景中的感知至关重要。

- 一些研究利用CLIP的预训练特征嵌入来提升分割性能,例如:

- MaskCLIP(Dong et al., 2023):直接生成像素级分割掩码。

- FC-CLIP(Q. Yu et al., 2023):冻结CLIP的卷积模块,使用掩码池化特征进行分类。

- ODISE(J. Xu et al., 2023):采用文本到图像扩散模型,生成候选掩码并分类。

-

2D-3D感知延展:

- CLIP的潜力不仅限于2D图像,还被扩展到3D场景感知:

- CLIP2Scene(R. Chen et al., 2023):引入2D-3D校准矩阵,推动CLIP在3D场景理解中的应用。

- OVO(Tan et al., 2023):提出一种语义占据预测方法,无需3D标注即可完成训练。

- POP-3D(Vobecký et al., 2023):用于预测3D语义占据图,支持自由形式语言查询。

- CLIP的潜力不仅限于2D图像,还被扩展到3D场景感知:

2. 视觉-语言模型(VLMs)在自动驾驶中的崛起

VLM的核心潜力

- 除了CLIP,其他视觉-语言模型在自动驾驶中也展现出显著潜力:

- 感知能力:VLM能够处理多模态输入(如图像、文本、点云),提升环境感知的精度。

- 推理与交互能力:通过引入高级认知功能,VLM可以为复杂场景提供决策支持。

典型研究

-

Dolphins(Y. Ma et al., 2023):

- 基于OpenFlamingo架构,强调自动驾驶系统中的推理和交互能力,展示了VLM在决策过程中的潜力。

-

On the Road with GPT-4V(Wen et al., 2023):

-

DriveLM(Sima et al., 2023):

-

Reason2Drive(Nie et al., 2023):

- 收集了链式问答数据(Sequential Question-Answering),覆盖感知、预测、推理等多任务场景,展示了链式推理在自动驾驶中的价值。

3. 挑战与未来方向

CLIP的局限性

- 尽管CLIP在多模态学习中表现优异,但其在自动驾驶中的应用仍面临挑战:

- 对3D场景的适配不足:CLIP的2D特性使其在3D场景中需要更多的适配和扩展。

- 任务专用性不足:CLIP偏向通用感知,在针对性任务(如动态环境预测)中效果有限。

VLM的潜力扩展

- VLM模型(如GPT-4V、DriveLM)的出现表明,VLM的感知与推理能力可以推动自动驾驶的发展,但需要解决以下问题:

- 实时性与高效性:多模态模型的计算复杂度较高,如何满足实时自动驾驶需求仍是难点。

- 多模态数据的融合:更高效的图像、点云、文本等多模态融合技术是未来研究的重点。

未来探索方向

- 开放词汇感知:开发能够识别新物体和场景的开放词汇模型。

- 多模态统一框架:探索统一处理视觉、语言和3D数据的多模态模型。

- 链式推理与任务适配:结合链式问答机制,加强模型对复杂自动驾驶任务的适配能力。

总结

- CLIP和其他VLMs正在逐步成为多模态自动驾驶感知和决策的核心技术。

- 未来,通过持续的架构优化与新数据集的开发,这些模型有望显著提升自动驾驶系统的鲁棒性与可靠性。

- 自动驾驶领域的多模态学习仍需进一步突破,但CLIP和VLMs的进展已经为全自动驾驶系统奠定了坚实基础。

Fig. 14 Illustration of a method that adapts a multi-modal foundation model i.e.CLIP for 3D scene understanding.

3d13.png" alt="在这里插入图片描述" />

这幅图展示了 CLIP2Scene 方法如何将 CLIP 模型扩展到 3D 场景理解,并通过语义和时空一致性正则化优化其性能。以下是对图中内容的详细解读:

图解核心内容

1. 问题定义:CLIP在3D场景理解中的作用

- 问题:如何利用CLIP提升对3D场景的理解?

- CLIP模型(包含图像编码器和文本编码器)原本用于2D图像和文本的多模态对齐。

- 在3D场景中,CLIP的能力可以帮助识别点云中的物体,如车辆(car)、公交车(bus) 和 行人(pedestrian)。

2. CLIP2Scene架构

-

输入数据:3D点云数据

- 原始的3D点云场景(左上方)。

- 点云通常表示为稀疏的三维几何数据,直接用于自动驾驶中的场景感知。

-

CLIP模块:

- 图像编码器:提取图像特征。

- 文本编码器:提取语义特征(如“car”、“bus”)。

- CLIP的多模态对齐特性使其能够将3D点云中的几何数据与语言描述对齐,从而实现对3D物体的语义理解。

-

CLIP2Scene模型:

- 将CLIP的特性引入到3D场景理解中,结合语义一致性和时空一致性正则化进行优化。

- 语义一致性:确保点云中的物体标签与CLIP的文本嵌入一致。

- 时空一致性:确保物体在动态点云(例如多个时间帧)中的特征连续性。

3. 输出结果

- CLIP2Scene可以通过三种不同标注水平生成3D场景的理解:

- 无标注(Annotation-free):

- 在完全没有标注的情况下,通过CLIP的预训练能力直接生成语义分割结果。

- 1%标注:

- 仅需极少量标注数据,利用CLIP的能力提升语义理解精度。

- 100%标注:

- 在完整标注数据集上运行,达到最优性能。

- 无标注(Annotation-free):

方法的创新点

-

开放词汇学习:

- CLIP能够识别3D点云中的新物体(如未见过的物体类别),无需重新训练模型。

- 对比传统方法,CLIP2Scene减少了对人工标注的依赖。

-

多模态一致性:

- 跨图像和文本的多模态对齐特性被扩展到点云任务,提升了3D场景感知的鲁棒性。

-

标注效率高:

- 通过CLIP的预训练特性,CLIP2Scene在仅1%标注数据的情况下,仍能获得高质量的3D分割结果。

应用价值

-

自动驾驶感知:

- CLIP2Scene可以有效识别3D场景中的关键物体,如车辆、行人、道路等,为自动驾驶系统提供实时感知能力。

-

智能机器人导航:

- 在动态场景中,CLIP2Scene的时空一致性优化可以帮助机器人更好地识别环境变化。

-

数据标注成本降低:

- 在标注数据稀缺的情况下,CLIP2Scene依然能够获得较高的分割精度,显著降低数据标注的时间和经济成本。

未来研究方向

- 增强3D场景动态理解:

- 优化时空一致性模块,使其能够更准确地处理复杂动态场景。

- 结合点云与图像数据:

- 探索更高效的2D图像与3D点云融合方法,提升感知精度。

- 适配实时系统:

- 优化CLIP2Scene的计算效率,以适配实时自动驾驶场景。

6 Present and Future

这部分内容(第6章:Present and Future)总结了当前的研究趋势,并提出了未来在自动驾驶视觉基础模型(Vision Foundation Models for Autonomous Driving, VFMs)领域的重要研究方向。以下是详细解析:

当前趋势

-

多模态模型的应用:

- 越来越多的研究开始探索将视觉模型(如CLIP)与文本、点云等其他模态结合,以提升自动驾驶系统的感知能力。

- 多模态融合能够提供更丰富的信息源,改善复杂场景的理解和决策。

-

开放词汇感知:

- 自动驾驶对未见物体的感知需求推动了开放词汇模型的发展,例如通过CLIP实现的开放语义分割(Open-Vocabulary Segmentation)。

- 这种趋势降低了对标注数据的依赖,同时提升了系统的适应性。

-

自监督学习与预训练:

- 自监督学习和预训练大模型正在成为主流方法。

- 它们通过大规模无标注数据实现了对视觉任务的优异性能,并在下游任务中展示出极高的迁移能力。

-

实时性与资源优化:

- 当前的视觉基础模型在计算资源和实时性上仍面临挑战。

- 研究正向轻量化和高效模型方向发展,以适配车载计算环境。

未来研究方向

-

统一多模态感知框架:

- 开发能够统一处理视觉、文本、点云等多模态数据的框架。

- 目标是增强感知模型的灵活性和鲁棒性,尤其是在动态复杂场景中。

-

时空一致性建模:

- 加强模型在动态场景中的理解能力。

- 通过引入时空一致性约束,提高模型在预测物体运动和轨迹规划中的表现。

-

知识驱动推理:

- 引入基于知识的推理模块,使模型能够处理更高层次的决策任务,例如因果推理和意图预测。

- 这一方向可以进一步优化模型对长尾场景的适应能力。

-

实时优化与硬件适配:

- 在保证模型性能的同时,优化其计算效率,使其能够适配车载实时计算需求。

- 包括模型剪枝、量化和混合精度训练等技术。

-

跨领域通用性:

- 开发能够在不同场景和任务中通用的视觉基础模型,例如城市交通、高速公路、室内导航等。

- 通过跨领域的数据集和任务设计,提升模型的泛化能力。

-

安全性与鲁棒性测试:

- 针对自动驾驶的安全性需求,未来研究需专注于模型在极端和复杂场景中的鲁棒性。

- 包括对模型在遮挡、光照变化和传感器噪声等情况下的表现评估。

总结

这部分内容强调了自动驾驶视觉基础模型领域的重要性和潜力。当前的研究聚焦在多模态融合、自监督学习和实时优化等方向,而未来的研究将更加侧重于模型的统一性、时空建模以及跨领域适配能力。这些趋势将进一步推动自动驾驶技术的发展,为安全可靠的自动驾驶系统奠定基础。

6.1 Data Preparation

这段内容主要讨论了自动驾驶数据准备的两个核心环节:数据采集(Data Collection)和数据生成(Data Generation)。以下是详细解析:

6.1.1 数据采集(Data Collection)

-

数据集的两代演进:

- 第一代数据集(如KITTI, Geiger et al., 2012):

- 主要特点:传感器模态有限(例如摄像头和激光雷达),数据量较小,任务范围局限于感知层面(如物体检测、语义分割)。

- 第二代数据集(如nuScenes, Caesar et al., 2020 和 Waymo, Sun et al., 2020):

- 特点:在传感器复杂性、数据规模和多样性上取得显著进步,涵盖的任务范围更广,不仅包括感知,还包括预测与控制。

- 数据来源:这些数据集整合了来自多个传感器(如多摄像头、多激光雷达)的大规模、多样化数据。

- 第一代数据集(如KITTI, Geiger et al., 2012):

-

未来趋势:

- 数据采集将更多依赖于未标注数据,结合自监督学习和人工智能生成技术,从在线数据源(如地图服务、交通监控)和自驾车运营中提取数据。

6.1.2 数据生成(Data Generation)

-

数据生成算法的演进:

- 早期算法:

- 主要针对单一数据模态(如生成激光雷达扫描或摄像头图像)。

- 最新算法:

- 支持多模态数据生成,同时在模拟场景复杂性和环境多样性上表现更好。

- 早期算法:

-

最新算法的特性:

- 多模态一致性(Multi-modal Consistency):

- 生成的多模态数据(如图像和点云)之间保持一致性,确保跨模态数据的时空对齐。

- 增强的场景模拟(Enhanced Scenario Simulation):

- 可操控虚拟环境中的特定元素,模拟极端场景(如行人突然出现、车辆失控等)。

- 多样化驾驶条件(Diverse Driving Conditions):

- 生成的数据涵盖不同天气(如雾、雨、雪)、光照条件(如夜晚、阳光直射)和季节变化。

- 多模态一致性(Multi-modal Consistency):

-

未来趋势:

- 人工智能生成计算(AIGC, Artificial Intelligence Generative Computing):

- 不仅生成全新数据,还通过对现有数据集的修改和增强,快速扩展和定制数据集。

- AIGC算法可根据特定地理区域或驾驶场景,生成更具针对性的数据。

- 人工智能生成计算(AIGC, Artificial Intelligence Generative Computing):

总结与展望

- 自动驾驶领域的数据准备正在经历从传统采集到智能生成的转变。

- 数据采集的重点正在从标注数据转向更高效的未标注数据整合。

- 数据生成技术的进步(如多模态一致性、场景模拟和AIGC)将推动自动驾驶模型在复杂场景中的性能提升。

- 未来,通过结合自监督学习和生成技术,自动驾驶数据准备将更加高效、灵活,并能够适应多样化的应用场景。

6.2 Self-supervised Training

这段内容讨论了**自监督学习(Self-supervised Learning, SSL)**在自动驾驶中的关键趋势和未来研究方向。以下是详细解析:

6.2 自监督学习的关键趋势

1. 从单模态到多模态(From Single-Modal to Multi-Modal)

-

早期方法:

- 主要依赖单一传感器模态(如摄像头图像或激光雷达扫描)。

- 这些方法在各自模态内提取特征,但无法有效融合不同模态的信息。

-

最新发展:

- 新一代自监督方法逐渐支持多模态融合。

- 多模态方法结合了视觉、点云和其他传感器数据,从而更全面地理解复杂的驾驶环境。

2. 多视角与时间一致性(Multi-View and Temporal Consistency)

-

多视角整合:

- 自监督方法现在能够结合来自多个视角的数据,从不同的摄像头或激光雷达输入中提取互补信息。

-

时间一致性:

- 自监督学习开始引入时间维度的约束,通过分析连续时间帧内的场景变化,增强模型对动态环境的感知能力。

3. 从图像学习3D信息(Learning 3D from Images)

-

创新点:

- 最新技术能够直接从2D图像中推断3D形状先验(3D shape priors)。

- 这种方法允许从未标注的2D图像训练3D模型,无需昂贵的3D数据。

-

应用价值:

- 消除了对高成本3D标注数据的依赖,极大地降低了数据准备的复杂性。

- 这种能力可以推动3D感知任务(如点云分割或3D目标检测)的进步。

未来研究方向

1. 加强模态间交互

- 目标:进一步加强不同模态(如视觉、点云、文本等)之间的交互。

- 方法:

- 开发无缝的信息交换机制,实现多传感器之间的联合推理。

- 例如,通过自监督学习的方法对视觉和激光雷达数据进行协同训练。

2. 利用大模型知识蒸馏

- 背景:

- 基础模型(Foundation Models),如在大规模数据集上训练的大语言模型(LLMs),在知识表征上表现出色。

- 研究方向:

总结

- 自监督学习在自动驾驶中已经取得显著进步,从单模态到多模态、多视角到时间一致性,以及从2D图像推断3D信息。

- 未来的研究将专注于:

- 多模态协同感知:提升不同模态间的交互与整合。

- 知识蒸馏:利用强大的预训练大模型,加速领域模型的开发。

- 资源高效化:消除对昂贵标注数据的依赖,推动自监督学习在现实场景中的应用。

6.3 Adaptation

这部分内容讨论了视觉基础模型(Vision Foundation Models, VFMs)在自动驾驶领域的适配(Adaptation),以及相关的挑战和未来发展方向。以下是详细解读:

6.3 适配(Adaptation)

1. VFMs在自动驾驶中的适配形式

-

先验提取(Prior Extraction):

- 方法:

- 利用基础模型(如SAM或DINO)提取图像中的关键信息(如重要的图像区域或Patch)。

- 提取的先验知识用于下游任务,如物体检测或分割。

- 优势:

- 提高下游任务的效率和准确性,同时减少从零开始训练模型的需求。

- 方法:

-

混合架构(Hybrid Architectures):

- 方法:

- 将预训练基础模型(如GPT)集成到世界模型中,预测驾驶环境中的未来变化(如生成未来的标记序列)。

- 利用大语言模型(LLMs)的推理能力,增强预测精度。

- 应用:

- 用于复杂场景下的路径规划和环境感知。

- 方法:

-

知识蒸馏与辅助训练(Knowledge Distillation and Assisted Training):

2. VFMs适配中的关键挑战与未来研究方向

-

多任务微调(Multi-Task Fine-Tuning):

- 挑战:

- 如何在一个模型上同时对多个下游任务(如目标检测、轨迹预测)进行高效微调。

- 需要设计算法,能够在维持共享视觉表示的同时协调任务间的特定适配。

- 挑战:

-

任务协同交互(Synergistic Task Interactions):

- 挑战:

- 探索如何在VFM框架中,不同的任务(涉及多模态感知)可以协同工作,互相增强。

- 目标:

- 开发具有更全面驾驶环境理解能力的模型。

- 挑战:

-

实时部署(Real-Time Deployment):

- 挑战:

- 自动驾驶对实时性的高要求,需要开发能在车载硬件上高效运行的轻量化模型。

- 解决方案:

- 探索模型压缩技术、轻量化架构以及专用硬件加速。

- 挑战:

总结与展望

-

VFMs的潜力:

- VFMs有能力通过多样化的数据源学习,理解复杂的交通场景,并实时应对,从而彻底改变自动驾驶领域。

-

未来方向:

- 通过知识蒸馏和多模态融合优化模型性能。

- 研究高效的实时模型部署方案。

- 开发能够支持多任务微调和任务协同的框架。

通过克服这些挑战,VFMs有望提供鲁棒性强、适应性好的模型,为自动驾驶车辆的安全性和可靠性铺平道路。

7 Conclusion

结论内容解读

-

基础模型的重要性:

- 基础模型(Foundation Models)的出现从根本上重塑了人工智能领域的格局。

- 它们在自动驾驶领域的潜力毋庸置疑,有望彻底变革这一领域。

-

论文的主要贡献:

- 论文聚焦于**构建视觉基础模型(VFM)**以服务于自动驾驶,具体强调了以下关键技术:

- 数据生成(Data Generation)

- 预训练(Pre-training)

- 适配(Adaptation)

- 论文聚焦于**构建视觉基础模型(VFM)**以服务于自动驾驶,具体强调了以下关键技术:

-

挑战:

- 尽管研究提供了清晰的方向,但实现稳健且适应性强的自动驾驶感知系统仍然存在诸多挑战。

-

期望:

- 通过本文的研究和开发的平台,希望能够促进未来在安全关键型自动驾驶场景中的视觉基础模型研究。

总结和意义

这段结论部分强调了基础模型在自动驾驶领域的核心作用,同时也承认当前仍存在的技术瓶颈。作者希望论文的研究成果和所开发的工具能够推动该领域的发展。