以ChatGPT为主的大语言模型出现已有半年时间,研究逐渐从针对模型本身的进化和功能,延展到如何更为有效地利用大模型,将它与其它工具结合,落地,以解决实际领域中的问题。

这里的增强主要指让大语言模型(LM)与外部扩展模块相结合,从而获得超越单纯的自然语言建模的能力。具体能力包含:推理、使用工具、行动。它不仅能解决更多类型的问题,在连接外部模块后,其处理自然语言处理能力也得到突破性进展。

本文介绍一篇增强语言模型综述,以及几篇最近发表的具体应用方法和框架的文章。

增强语言模型综述

英文题目: Augmented Language Models: a Survey

中文题目: 增强语言模型综述

论文地址: http://arxiv.org/abs/2302.07842

解读:https://blog.csdn.net/xieyan0811/article/details/130910473?spm=1001.2014.3001.5501

(将近5000字,太长就不贴了)

一篇综述性文章,来Meta,发布时间为2023-02-15。

文章从方法论的角论进入阐释。内容分为六部分:介绍,推理,使用工具和行动,学习方法,讨论,结论,正文22页。

对于比较关注 LM 领域的读者,这篇文章中并没有提到让人意外的特殊方法。然而,文章对现有方法进行了全面细致的整理,提供了全景视角的概览,详细引用了相关文献和软件示例。是对知识很好的概览和梳理,可作为入门读物。

Chameleon:使用大型语言模型进行即插即用的组合推理

本篇来自加州大学&微软,发布时间为2023-04-19。

英文题目: Chameleon: Plug-and-Play Compositional Reasoning with Large Language Models

中文题目: Chameleon:使用大型语言模型进行即插即用的组合推理

论文地址: http://arxiv.org/abs/2304.09842

解读:

- 目标:使用LLM与其它工具结合,解决具体领域的问题。在不同类型的数据和各种模型工具之间建立起了桥梁,利用LLM实现了之前需要人工设计的调用顺序和方法。

- 当前问题:自然语言大模型LLM由于其自身的限制,无法访问最新信息、无法使用外部工具,无法进行精确的数学推理。

- 效果:结合GPT-4,在ScienceQA(86.54%)和TabMWP(98.78)任务中,得到了显著的提升。

- 方法:

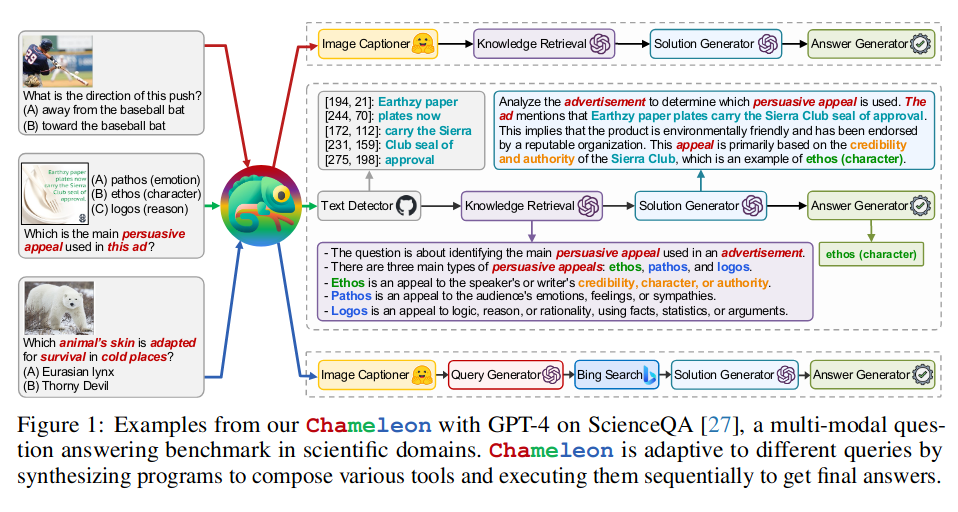

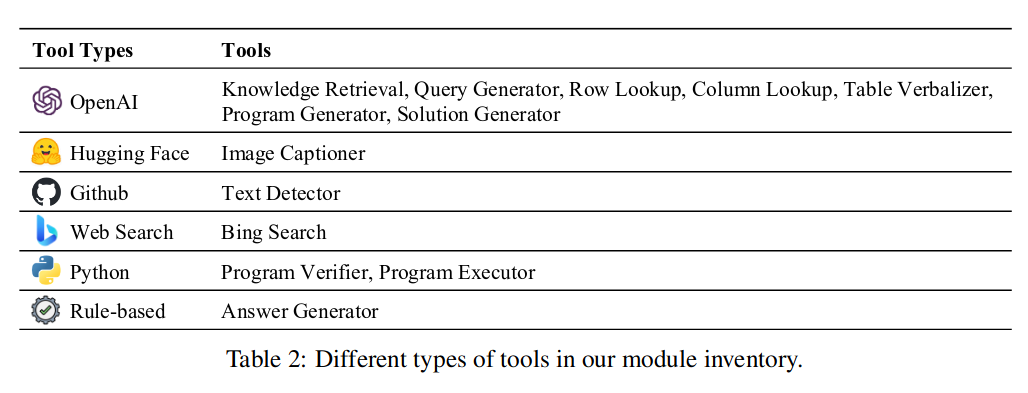

提出chameleon(变色龙),即插即用的组合推理框架,该框架可以组合多种工具,其中可包含LLM模型、现成的视觉模型、网络搜索引擎、Python 函数和根据用户兴趣定制的基于规则的模块,并将LLM 作为自然语言规划器,将问题拆解成多种工具组合的链条(设计工作流程),然后调用工具协同解决问题,最后通过答案生成器生成回答。

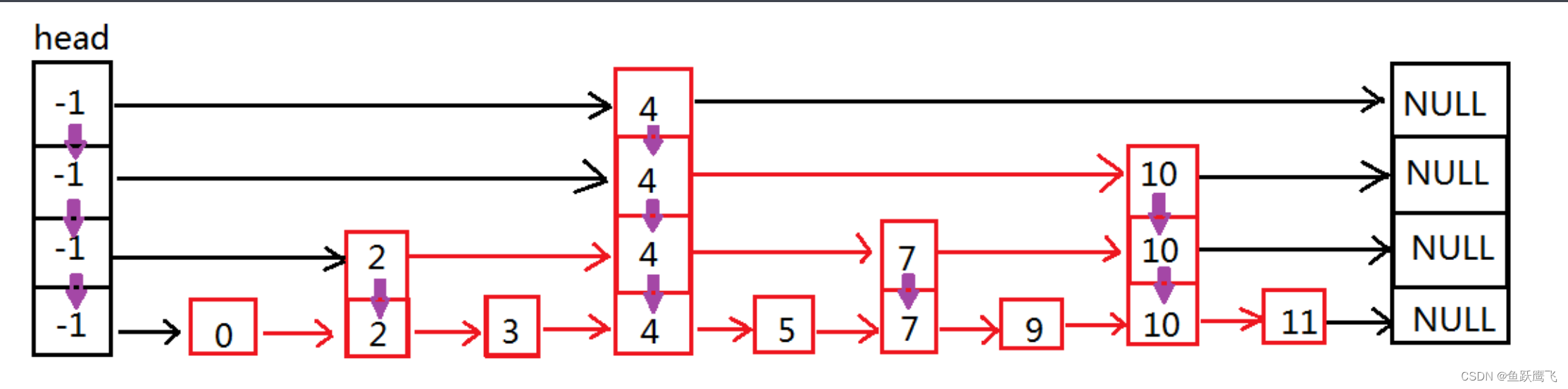

图-1展示了看图回答问题的三个示例,针对第二个问题,展示了从文本识别,信息检索,生成解决方法,最终生成答案的过程。

其中可使用的工具包含:

SuperICL:小型模型作为大型语言模型的插件

本篇来自加州大学&微软,发布时间为2023-05-15。

英文题目: Small Models are Valuable Plug-ins for Large Language Models

中文题目: 小型模型作为大型语言模型的插件

论文地址: http://arxiv.org/abs/2305.08848

解读

- 目标:利用自然语言大模型(LLM),提升对大规模的有监督数据的预测效果。

- 当前问题:由于上下文长度的限制,只能在对话中给LLM提供有限的上下文提示(In-Context Learning)。

- 效果:在效果评测,稳定性,多语言和可解释性方面均表现出其优越性。

- 方法

文中提出了SuperICL,将LLM视为黑盒,与本地经过调优的小模型相结合,以提升有监督任务的能力。

之前只是将有监督的示例和待预测的测试数据传递给LLM来获得答案。文中提出的方法,首先针对训练集和测试集数据训练了本地模型,预测标签和置信度。然后将这些结果和测试数据一起传递给LLM,从而使LLM不仅学习了推理结果,还学习了决策过程,从而实现了更好的推理和解释能力。

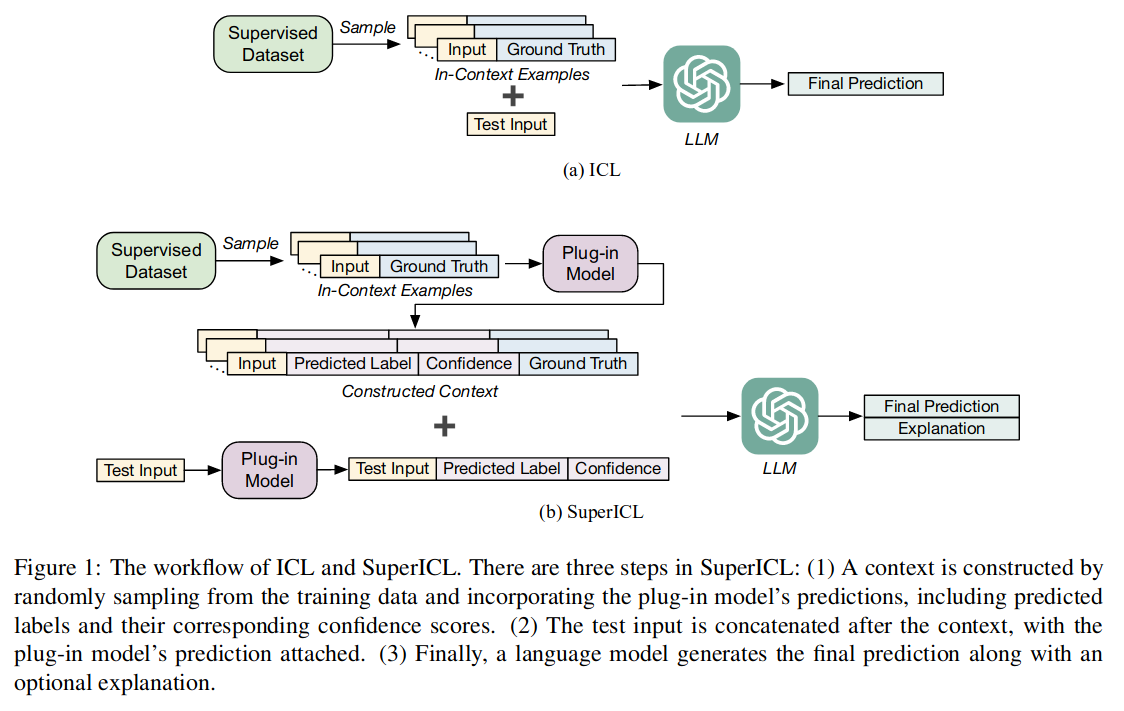

图-1(a)部分展示了ICL的工作过程(之前),它从训练集的上下文中采样,再结合测试集数据一起传给LLM,得到输出;

图-1(b)展示了SuperICL的工作过程,分为三步:

- 通过从训练数据中随机抽样并结合本地模型的预测构建上下文,包括预测标签及其相应的置信度分数。

- 测试输入连接在上下文之后,并附加了本地模型对测试数据的预测。

- 语言模型生成最终预测以及解释。

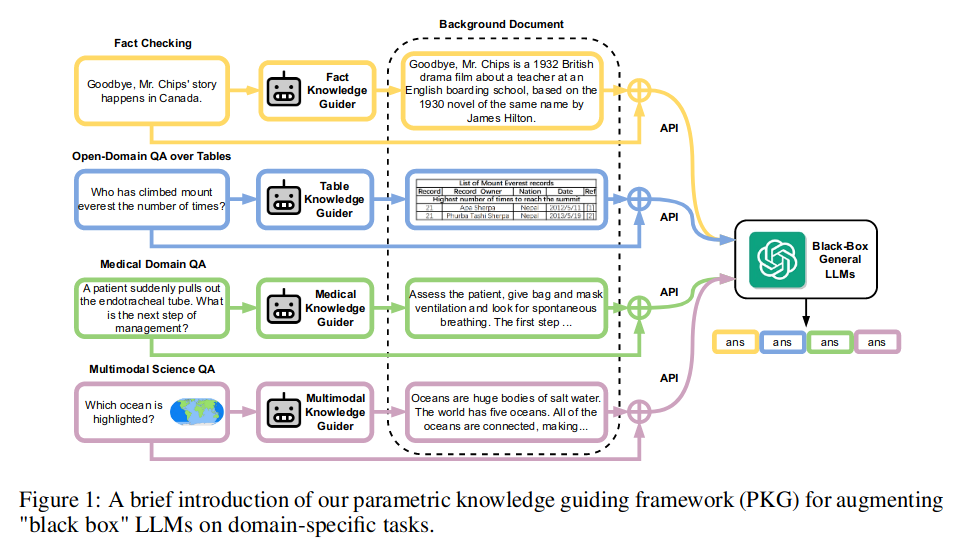

PKG:参数化知识指导的增强大语言模型

本篇来自香港大学&微软,发布时间为2023-05-18。

英文题目: Augmented Large Language Models with Parametric Knowledge Guiding

中文题目: 参数化知识指导的增强大语言模型

论文地址: http://arxiv.org/abs/2305.04757

解读:

- 目标:促进大模型LLM在领域知识密集型任务中的应用

- 当前问题:在解决具体问题时,涉及更多领域相关的知识,最新的知识,以及私有数据。

- 效果:提升了模型在一系列领域知识密集型任务上的性能,包括事实 (+7.9%)、表格 (+11.9%)、医学 (+3.0%) 和多模态 (+8.1%) 知识。

- 方法:

提出PKG(Parametric Knowledge Guiding)参数化知识引导框架,结合本地模型和LLM模型,本地模型基于开源的自然语言模型(Llama),它可以存储离线的领域知识,将领域知识转化成参数输出,作为background和问题一起传入大模型。

文中的图-1展示了PKG的工作过程: