本文转载自:LLM 九层妖塔

https://github.com/km1994/LLMsNineStoryDemonTower

文章目录

- 壹、ChatGLM-6B

- 一、介绍

- 二、使用方式

- 硬件需求

- 环境安装

- 代码调用

- Demo

- 网页版 Demo

- 命令行 Demo

- API部署

- 低成本部署

- 模型量化

- CPU 部署

- Mac 上的 GPU 加速

- 高效参数微调

- 局限性

- 贰、 ChatGLM 微调

- 一、介绍

- 二、环境搭建

- 1、conda 构建环境

- 2.2 下载代码

- 2.3 安装依赖

- 三、使用方法

- 1、训练数据下载

- 2、模型下载

- 3、模型训练

- 4、模型推理

- 5、生成结果分析

- 6、模型部署

- 叁、ChatGLM + LoRA 进行finetune

- 一、前言

- 二、环境搭建

- 1、构建环境

- 2、下载代码

- 3、安装依赖

- 三、使用方法

- 1、训练数据下载

- 1.1 数据来源 alpaca

- 1.2 数据介绍

- 1.3 转化alpaca数据集为 jsonl

- 2、tokenize_dataset 下载

- 3、模型 finetune

- 3.4 模型推理

- infer.py 文件

- 运行 infer.py 进行 推理

- 肆、特定任务微调

- 一、简述

- 二、环境搭建

- 1、构建环境

- 2、下载代码

- 3、安装依赖

- 三、使用方法

- 1、训练数据下载

- 1.1 数据来源

- 1.2 数据介绍

- 1.3 数据下载方式

- 2、模型下载

- 3、模型微调

- 4、模型推理

- 四、经验分享

- 基于 ChatGLM-6B 开发的开源项目:

- 相关资料

壹、ChatGLM-6B

- ChatGLM-6B

一、介绍

ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数。

结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。

ChatGLM-6B 使用了和 ChatGPT 相似的技术,针对中文问答和对话进行了优化。

经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 已经能生成相当符合人类偏好的回答,更多信息请参考我们的博客。

此外,为了方便下游开发者针对自己的应用场景定制模型,我们同时实现了基于 P-Tuning v2 的高效参数微调方法 (使用指南) ,INT4 量化级别下最低只需 7GB 显存即可启动微调。

不过,由于 ChatGLM-6B 的规模较小,目前已知其具有相当多的局限性,如事实性/数学逻辑错误,可能生成有害/有偏见内容,较弱的上下文能力,自我认知混乱,以及对英文指示生成与中文指示完全矛盾的内容。

请大家在使用前了解这些问题,以免产生误解。

更大的基于 1300 亿参数 GLM-130B 的 ChatGLM 正在内测开发中。

二、使用方式

硬件需求

| 量化等级 | 最低 GPU 显存(推理) | 最低 GPU 显存(高效参数微调) |

|---|---|---|

| FP16(无量化) | 13 GB | 14 GB |

| INT8 | 8 GB | 9 GB |

| INT4 | 6 GB | 7 GB |

环境安装

使用 pip 安装依赖:

pip install -r requirements.txt

其中 transformers 库版本推荐为 4.27.1,但理论上不低于 4.23.1 即可。

代码调用

可以通过如下代码调用 ChatGLM-6B 模型来生成对话:

from transformers import AutoTokenizer, AutoModeltokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True)

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda()

model = model.eval()response, history = model.chat(tokenizer, "你好", history=[])

print(response)

# 你好👋!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。response, history = model.chat(tokenizer, "晚上睡不着应该怎么办", history=history)

print(response)

打印:

晚上睡不着可能会让你感到焦虑或不舒服,但以下是一些可以帮助你入睡的方法:1. 制定规律的睡眠时间表:保持规律的睡眠时间表可以帮助你建立健康的睡眠习惯,使你更容易入睡。尽量在每天的相同时间上床,并在同一时间起床。

2. 创造一个舒适的睡眠环境:确保睡眠环境舒适,安静,黑暗且温度适宜。可以使用舒适的床上用品,并保持房间通风。

3. 放松身心:在睡前做些放松的活动,例如泡个热水澡,听些轻柔的音乐,阅读一些有趣的书籍等,有助于缓解紧张和焦虑,使你更容易入睡。

4. 避免饮用含有咖啡因的饮料:咖啡因是一种刺激性物质,会影响你的睡眠质量。尽量避免在睡前饮用含有咖啡因的饮料,例如咖啡,茶和可乐。

5. 避免在床上做与睡眠无关的事情:在床上做些与睡眠无关的事情,例如看电影,玩游戏或工作等,可能会干扰你的睡眠。

6. 尝试呼吸技巧:深呼吸是一种放松技巧,可以帮助你缓解紧张和焦虑,使你更容易入睡。试着慢慢吸气,保持几秒钟,然后缓慢呼气。如果这些方法无法帮助你入睡,你可以考虑咨询医生或睡眠专家,寻求进一步的建议。

完整的模型实现可以在 Hugging Face Hub 上查看。

如果你从 Hugging Face Hub 上下载 checkpoint 的速度较慢,也可以从这里手动下载。

Demo

我们提供了一个基于 Gradio 的网页版 Demo 和一个命令行 Demo。

使用时首先需要下载本仓库:

git clone https://github.com/THUDM/ChatGLM-6B

cd ChatGLM-6B

网页版 Demo

首先安装 Gradio:pip install gradio,然后运行仓库中的 web_demo.py:

python web_demo.py

程序会运行一个 Web Server,并输出地址。

在浏览器中打开输出的地址即可使用。

最新版 Demo 实现了打字机效果,速度体验大大提升。

注意,由于国内 Gradio 的网络访问较为缓慢,启用 demo.queue().launch(share=True, inbrowser=True) 时所有网络会经过 Gradio 服务器转发,导致打字机体验大幅下降,现在默认启动方式已经改为 share=False。如有需要公网访问的需求,可以重新修改为 share=True 启动。

感谢 @AdamBear 实现了基于 Streamlit 的网页版 Demo,运行方式见#117.

命令行 Demo

运行repo中 cli_demo.py:

python cli_demo.py

程序会在命令行中进行交互式的对话

- 在命令行中输入指示并回车即可生成回复

- 输入

clear可以清空对话历史 - 输入

stop终止程序。

API部署

首先需要安装额外的依赖

pip install fastapi uvicorn

然后运行仓库中的 api.py:

python api.py

默认部署在本地的 8000 端口,通过 POST 方法进行调用

curl -X POST "http://127.0.0.1:8000" \-H 'Content-Type: application/json' \-d '{"prompt": "你好", "history": []}'

得到的返回值为

{"response":"你好👋!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。","history":[["你好","你好👋!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。"]],"status":200,"time":"2023-03-23 21:38:40"

}

低成本部署

模型量化

默认情况下,模型以 FP16 精度加载,运行上述代码需要大概 13GB 显存。

如果你的 GPU 显存有限,可以尝试以量化方式加载模型,使用方法如下:

# 按需修改,目前只支持 4/8 bit 量化

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().quantize(4).cuda()

进行 2 至 3 轮对话后,8-bit 量化下 GPU 显存占用约为 10GB,4-bit 量化下仅需 6GB 占用。

随着对话轮数的增多,对应消耗显存也随之增长,由于采用了相对位置编码,理论上 ChatGLM-6B 支持无限长的 context-length,但总长度超过 2048(训练长度)后性能会逐渐下降。

模型量化会带来一定的性能损失,经过测试,ChatGLM-6B 在 4-bit 量化下仍然能够进行自然流畅的生成。

使用 GPT-Q 等量化方案可以进一步压缩量化精度/提升相同量化精度下的模型性能,欢迎大家提出对应的 Pull Request。

[2023/03/19] 量化过程需要在内存中首先加载 FP16 格式的模型,消耗大概 13GB 的内存。

如果你的内存不足的话,可以直接加载量化后的模型,仅需大概 5.2GB 的内存:

model = AutoModel.from_pretrained("THUDM/chatglm-6b-int4", trust_remote_code=True).half().cuda()

[2023/03/24] 我们进一步提供了对Embedding量化后的模型,模型参数仅占用4.3 GB显存:

model = AutoModel.from_pretrained("THUDM/chatglm-6b-int4-qe", trust_remote_code=True).half().cuda()

CPU 部署

如果你没有 GPU 硬件的话,也可以在 CPU 上进行推理,但是推理速度会更慢。

使用方法如下(需要大概 32GB 内存)

model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).float()

如果你的内存不足,可以直接加载量化后的模型:

model = AutoModel.from_pretrained("THUDM/chatglm-6b-int4",trust_remote_code=True).float()

如果遇到了报错 Could not find module 'nvcuda.dll' 或者 RuntimeError: Unknown platform: darwin (MacOS) 的话请参考这个[Issue]:

https://github.com/THUDM/ChatGLM-6B/issues/6#issuecomment-1470060041 .

Mac 上的 GPU 加速

对于搭载了 Apple Silicon 的Mac(以及MacBook),可以使用 MPS 后端来在 GPU 上运行 ChatGLM-6B。

首先需要参考 Apple 的 官方说明 安装 PyTorch-Nightly。

然后将模型仓库 clone 到本地(需要先安装Git LFS)

git lfs install

git clone https://huggingface.co/THUDM/chatglm-6b

将代码中的模型加载改为从本地加载,并使用 mps 后端

model = AutoModel.from_pretrained("your local path", trust_remote_code=True).half().to('mps')

即可使用在 Mac 上使用 GPU 加速模型推理。

高效参数微调

基于 P-tuning v2 的高效参数微调。

具体使用方法详见 ptuning/README.md。

局限性

由于 ChatGLM-6B 的小规模,其能力仍然有许多局限性。以下是我们目前发现的一些问题:

- 模型容量较小:6B 的小容量,决定了其相对较弱的模型记忆和语言能力。在面对许多事实性知识任务时,ChatGLM-6B 可能会生成不正确的信息;它也不擅长逻辑类问题(如数学、编程)的解答。

- 产生有害说明或有偏见的内容:ChatGLM-6B 只是一个初步与人类意图对齐的语言模型,可能会生成有害、有偏见的内容。(内容可能具有冒犯性,此处不展示)

- 英文能力不足:ChatGLM-6B 训练时使用的指示/回答大部分都是中文的,仅有极小一部分英文内容。因此,如果输入英文指示,回复的质量远不如中文,甚至与中文指示下的内容矛盾,并且出现中英夹杂的情况。

- 易被误导,对话能力较弱:ChatGLM-6B 对话能力还比较弱,而且 “自我认知” 存在问题,并很容易被误导并产生错误的言论。例如当前版本的模型在被误导的情况下,会在自我认知上发生偏差。

贰、 ChatGLM 微调

一、介绍

这里主要介绍对于 ChatGLM-6B 模型基于 P-Tuning v2 的微调。

P-Tuning v2 将需要微调的参数量减少到原来的 0.1%,再通过模型量化、Gradient Checkpoint 等方法,最低只需要 7GB 显存即可运行。

本节 以 ADGEN (广告生成) 数据集为例介绍代码的使用方法。

硬件需求

| 量化等级 | 最低 GPU 显存(推理) | 最低 GPU 显存(高效参数微调) |

|---|---|---|

| FP16(无量化) | 13 GB | 14 GB |

| INT8 | 8 GB | 9 GB |

| INT4 | 6 GB | 7 GB |

二、环境搭建

1、conda 构建环境

conda create -n py310_chat python=3.10 # 创建新环境

source activate py310_chat # 激活环境

2.2 下载代码

git clone https://github.com/THUDM/ChatGLM-6B.git

cd ChatGLM-6B

2.3 安装依赖

运行微调需要 4.27.1 版本的transformers。

除 ChatGLM-6B 的依赖之外,还需要安装以下依赖

pip install -r requirements.txt

pip install rouge_chinese nltk jieba datasets

三、使用方法

1、训练数据下载

ADGEN 数据集任务为根据输入(content)生成一段广告词(summary)。

{"content": "类型#上衣*版型#宽松*版型#显瘦*图案#线条*衣样式#衬衫*衣袖型#泡泡袖*衣款式#抽绳","summary": "这件衬衫的款式非常的宽松,利落的线条可以很好的隐藏身材上的小缺点,穿在身上有着很好的显瘦效果。领口装饰了一个可爱的抽绳,漂亮的绳结展现出了十足的个性,配合时尚的泡泡袖型,尽显女性甜美可爱的气息。"

}

从 Google Drive 或者 Tsinghua Cloud 下载处理好的 ADGEN 数据集,将解压后的 ptuning/AdvertiseGen 目录放到本目录下。

2、模型下载

Huggingface 平台下载

git lfs install

git clone https://huggingface.co/THUDM/chatglm-6b

3、模型训练

运行以下指令进行训练:

cd ptuning/

bash train.sh

注:train.sh 脚本如下

PRE_SEQ_LEN=8 # soft prompt 长度

LR=1e-2 # 训练的学习率CUDA_VISIBLE_DEVICES=0 python main.py \--do_train \ # 训练--train_file AdvertiseGen/train.json \ # 训练集地址--validation_file AdvertiseGen/dev.json \ # 验证集地址--prompt_column content \ # 训练集中prompt 的key名称【可以理解为输入值的key】--response_column summary \ # 训练集中response的key名称【可以理解为生成值的key】--overwrite_cache \ # 是否覆盖 缓存--model_name_or_path THUDM/chatglm-6b \ # chatglm-6b 模型地址--output_dir output/adgen-chatglm-6b-pt-$PRE_SEQ_LEN-$LR \ # 模型保存地址--overwrite_output_dir \--max_source_length 64 \ --max_target_length 64 \--per_device_train_batch_size 1 \--per_device_eval_batch_size 1 \--gradient_accumulation_steps 16 \--predict_with_generate \--max_steps 3000 \--logging_steps 10 \--save_steps 1000 \--learning_rate $LR \--pre_seq_len $PRE_SEQ_LEN \--quantization_bit 4 # 模型 量化方式

- train.sh 中的

PRE_SEQ_LEN和LR分别是 soft prompt 长度和训练的学习率,可以进行调节以取得最佳的效果。 - P-Tuning-v2 方法会冻结全部的模型参数,可通过调整 quantization_bit 来被原始模型的量化等级,不加此选项则为 FP16 精度加载。

- 在默认配置

quantization_bit=4、per_device_train_batch_size=1、gradient_accumulation_steps=16下,INT4 的模型参数被冻结,一次训练迭代会以 1 的批处理大小进行 16 次累加的前后向传播,等效为 16 的总批处理大小,此时最低只需 6.7G 显存。 - 若想在同等批处理大小下提升训练效率,可在二者乘积不变的情况下,加大

per_device_train_batch_size的值,但也会带来更多的显存消耗,请根据实际情况酌情调整。

PRE_SEQ_LEN调整为512(2080ti使用情况如下):

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-kAXsRt6W-1685261622743)(img/20230404221900.png)]

4、模型推理

将 evaluate.sh 中的 CHECKPOINT 更改为训练时保存的 checkpoint 名称,运行以下指令进行模型推理和评测:

bash evaluate.sh

注:evaluate.sh 脚本如下

PRE_SEQ_LEN=8

CHECKPOINT=adgen-chatglm-6b-pt-8-1e-2

STEP=3000CUDA_VISIBLE_DEVICES=0 python3 main.py \--do_predict \--validation_file AdvertiseGen/dev.json \--test_file AdvertiseGen/dev.json \--overwrite_cache \--prompt_column content \--response_column summary \--model_name_or_path ./output/$CHECKPOINT/checkpoint-$STEP \--output_dir ./output/$CHECKPOINT \--overwrite_output_dir \--max_source_length 64 \--max_target_length 64 \--per_device_eval_batch_size 1 \--predict_with_generate \--pre_seq_len $PRE_SEQ_LEN \--quantization_bit 4

5、生成结果分析

评测指标为中文 Rouge score 和 BLEU-4。生成的结果保存在 ./output/adgen-chatglm-6b-pt-8-1e-2/generated_predictions.txt。

- 示例1

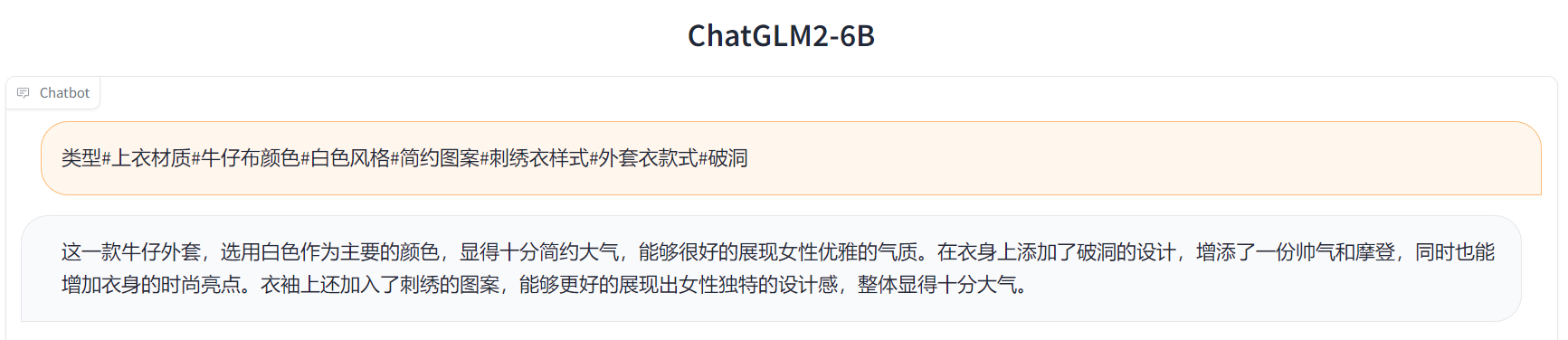

Input: 类型#上衣*材质#牛仔布*颜色#白色*风格#简约*图案#刺绣*衣样式#外套*衣款式#破洞Label: 简约而不简单的牛仔外套,白色的衣身十分百搭。衣身多处有做旧破洞设计,打破单调乏味,增加一丝造型看点。衣身后背处有趣味刺绣装饰,丰富层次感,彰显别样时尚。Output[微调前]: 这件上衣的材质是牛仔布,颜色是白色,风格是简约,图案是刺绣,衣样式是外套,衣款式是破洞。Output[微调后]: 这是一款简约的牛仔外套,破洞设计,将牛仔布破洞,带来一种随意与个性。破洞的牛仔外套,展现出时尚气息,带来一种休闲感。同时,刺绣图案,让整件外套更加立体。

- 示例2

Input: 类型#裙*版型#显瘦*风格#文艺*风格#简约*图案#印花*图案#撞色*裙下摆#压褶*裙长#连衣裙*裙领型#圆领Label: 文艺个性的印花连衣裙,藏青色底蕴,低调又大气,撞色太阳花分布整个裙身,绚丽而美好,带来时尚减龄的气质。基础款的舒适圆领,简约不失大方,勾勒精致脸庞。领后是一粒包布扣固定,穿脱十分方便。前片立体的打褶设计,搭配后片压褶的做工,增添层次和空间感,显瘦又有型。Output[微调前]: 类型#裙版型#显瘦风格#文艺风格#简约图案#印花图案#撞色裙下摆#压褶裙长#连衣裙裙领型#圆领 1. 连衣裙:简约风格,裙长为膝盖以上,裙领型为圆领。2. 裙下摆:压褶设计,使裙摆呈现出流畅的褶皱效果。3. 裙领型:裙领型为圆领,使穿上连衣裙后更加有型。4. 版型:采用显瘦设计,让连衣裙看起来更加苗条。5. 风格:文艺风格,让连衣裙更加有内涵和品味。6. 图案:印花设计,在连衣裙上印有独特的图案。7. 撞色:采用撞色设计,让连衣裙在色彩上更加鲜明、富有层次感。Output[微调后]: 这是一款文艺范的连衣裙,以印花为元素,采用简约的印花,既能够突出文艺气质,又能够展现简约风。在印花的同时又有领子和裙摆的压褶设计,更加凸显文艺气质。简约而不会过于单调,搭配出街,穿着十分舒适。

6、模型部署

将对应的demo或代码中的THUDM/chatglm-6b换成经过 P-Tuning 微调之后 checkpoint 的地址(在示例中为 ./output/adgen-chatglm-6b-pt-8-1e-2/checkpoint-3000)。

注意,目前的微调还不支持多轮数据,所以只有对话第一轮的回复是经过微调的。

叁、ChatGLM + LoRA 进行finetune

一、前言

本教程主要介绍对于 ChatGLM-6B 模型基于 LoRA 进行finetune。

以alpaca 为例。

硬件需求

- 显卡: 显存 >= 16G (最好24G或者以上)

- 环境:

- python>=3.8

- cuda>=11.6, cupti, cuDNN, TensorRT等深度学习环境

二、环境搭建

1、构建环境

conda create -n py310_chat python=3.10 # 创建新环境

source activate py310_chat # 激活环境

2、下载代码

git clone https://github.com/mymusise/ChatGLM-Tuning.git

cd ChatGLM-Tuning

3、安装依赖

运行微调需要4.27.1版本的transformers。除 ChatGLM-6B 的依赖之外,还需要按照以下依赖

pip install -r requirements.txt

三、使用方法

1、训练数据下载

1.1 数据来源 alpaca

- alpaca

1.2 数据介绍

本章使用 alpaca作为本次特定任务微调实验数据。

样例

[{"instruction": "Give three tips for staying healthy.","input": "","output": "1.Eat a balanced diet and make sure to include plenty of fruits and vegetables. \n2. Exercise regularly to keep your body active and strong. \n3. Get enough sleep and maintain a consistent sleep schedule."},...

]

- 字段

- instruction: 指令

- input: 输入(本数据集均为空)

- output: 输出

1.3 转化alpaca数据集为 jsonl

运行代码

python cover_alpaca2jsonl.py --data_path data/alpaca_data.json --save_path data/alpaca_data.jsonl

生成数据 data/alpaca_data.jsonl

{"text": "### Instruction:\nIdentify the odd one out.\n\n### Input:\nTwitter, Instagram, Telegram\n\n### Response:\nTelegram\nEND\n"}{"text": "### Instruction:\nExplain why the following fraction is equivalent to 1/4\n\n### Input:\n4/16\n\n### Response:\nThe fraction 4/16 is equivalent to 1/4 because both numerators and denominators are divisible by 4. Dividing both the top and bottom numbers by 4 yields the fraction 1/4.\nEND\n"}...

注:text 中包含 Instruction、Input、Response 三个信息

拼接格式为

### Instruction:\n【Instruction内容】\n\n### Input:\n【Input内容】\n\n### Response:\n【Response内容】\nEND\n

2、tokenize_dataset 下载

python tokenize_dataset_rows.py --jsonl_path data/alpaca_data.jsonl --save_path data/alpaca --max_seq_length 128

--jsonl_path, 微调的数据路径, 格式jsonl, 对每行的[‘context’]和[‘target’]字段进行encode--save_path, 输出路径--max_seq_length, 样本的最大长度

3、模型 finetune

运行以下指令进行微调:

lora 方式 finetune

python finetune.py \--dataset_path data/alpaca \--lora_rank 8 \--per_device_train_batch_size 6 \--gradient_accumulation_steps 1 \--max_steps 52000 \--save_steps 1000 \--save_total_limit 2 \--learning_rate 1e-4 \--fp16 \--remove_unused_columns false \--logging_steps 50 \--output_dir output

TrainOutput(global_step=1500, training_loss=1.4622032979329427, metrics={'train_runtime': 474.9934, 'train_samples_per_second': 3.158, 'train_steps_per_second': 3.158, 'total_flos': 3781851053211648.0, 'train_loss': 1.4622032979329427, 'epoch': 3.0})...

3.4 模型推理

运行以下指令进行推理:

infer.py 文件

from modeling_chatglm import ChatGLMForConditionalGeneration

import torch

torch.set_default_tensor_type(torch.cuda.HalfTensor)

model = ChatGLMForConditionalGeneration.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True, device_map='auto')from peft import PeftModel

model = PeftModel.from_pretrained(model, "mymusise/chatGLM-6B-alpaca-lora")

torch.set_default_tensor_type(torch.cuda.FloatTensor)from transformers import AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True)from cover_alpaca2jsonl import format_example# alpaca数据集

instructions = [{'instruction': 'Give three tips for staying healthy.','input': '','output': '1.Eat a balanced diet and make sure to include plenty of fruits and vegetables. \n2. Exercise regularly to keep your body active and strong. \n3. Get enough sleep and maintain a consistent sleep schedule.',},{'instruction': 'What are the three primary colors?','input': '','output': 'The three primary colors are red, blue, and yellow.',}

]with torch.no_grad():for idx, item in enumerate(instructions):feature = format_example(item)input_text = feature['context']ids = tokenizer.encode(input_text)input_ids = torch.LongTensor([ids])out = model.generate(input_ids=input_ids,max_length=150,do_sample=False,temperature=0)out_text = tokenizer.decode(out[0])answer = out_text.replace(input_text, "").replace("\nEND", "").strip()item['infer_answer'] = answerprint(out_text)print(f"### {idx+1}.Answer:\n", item.get('output'), '\n\n')

运行 infer.py 进行 推理

python infer.py

Output exceeds the size limit. Open the full output data in a text editor

Instruction: Give three tips for staying healthy.

Answer: 1. Eat a balanced diet of fruits, vegetables, lean protein, and whole grains.

2. Get regular exercise, such as walking, running, or swimming.

3. Stay hydrated by drinking plenty of water.### 1.Answer:

1.Eat a balanced diet and make sure to include plenty of fruits and vegetables.

2. Exercise regularly to keep your body active and strong.

3. Get enough sleep and maintain a consistent sleep schedule. Instruction: What are the three primary colors?

Answer: The three primary colors are red, blue, and yellow.### 2.Answer:

The three primary colors are red, blue, and yellow.

肆、特定任务微调

一、简述

这里主要介绍对于 ChatGLM-6B 模型基于 P-Tuning v2 的特定任务微调实验,微调目标为自动生成的整数/小数加减乘除运算。

本节 以 整数/小数加减乘除运 数据集为例介绍代码的使用方法,以 yongzhuo/chatglm-maths 为例。

硬件需求

| 量化等级 | 最低 GPU 显存(推理) | 最低 GPU 显存(高效参数微调) |

|---|---|---|

| FP16(无量化) | 13 GB | 14 GB |

| INT8 | 8 GB | 9 GB |

| INT4 | 6 GB | 7 GB |

二、环境搭建

1、构建环境

conda create -n py310_chat python=3.10 # 创建新环境

source activate py310_chat # 激活环境

2、下载代码

git clone https://github.com/yongzhuo/chatglm-maths.git

cd chatglm-maths

3、安装依赖

运行微调需要4.27.1版本的transformers。除 ChatGLM-6B 的依赖之外,还需要按照以下依赖

pip install -r requirements.txt

三、使用方法

1、训练数据下载

1.1 数据来源

- tatsu-lab/stanford_alpaca

- LianjiaTech/BELLE

- carbonz0/alpaca-chinese-dataset

1.2 数据介绍

本章使用 BelleGroup/school_math_0.25M 作为本次特定任务微调实验数据, 该数据集 包含约25万条由BELLE项目生成的中文数学题数据,包含解题过程。

注意:此数据集是由ChatGPT产生的,未经过严格校验,题目或解题过程可能包含错误。使用过程中请注意这一点。

样例

{"instruction": "题目:小华手里有一个装满糖果的袋子,共有12个,小明想知道里面有多少颗糖果,于是他问小华:“你手里的糖果袋子里有偶数个糖果吗?”小华回答:“有,而且多于10颗。”请问小华手里的糖果袋子里最少有几颗糖果?","input": "","output": "\n由题目可知:小华手里的糖果袋子里有偶数个糖果;\n又知道小华手里的糖果袋子里有多于10颗糖果。\n因为糖果数为偶数,多于10颗,所以糖果数最小必须是12。\n所以小华手里的糖果袋子里最少有12颗糖果。"

}

- 字段

- instruction: 指令

- input: 输入(本数据集均为空)

- output: 输出

1.3 数据下载方式

方式一

from datasets import load_dataset

dataset = load_dataset("BelleGroup/school_math_0.25M")

方式二【本文所采用的方式】

git lfs install

git clone https://huggingface.co/datasets/BelleGroup/school_math_0.25M

2、模型下载

Huggingface 平台下载

git lfs install

git clone https://huggingface.co/THUDM/chatglm-6b

3、模型微调

运行以下指令进行微调:

lora 方式 微调

python c00_toy_lora_train_6b.py

generator_calculate_line: ('13+75=', '13+75=88')tokenizer.vocab_size: 150344Loading checkpoint shards: 100%|██████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████████| 8/8 [00:10<00:00, 1.31s/it]transformer.word_embeddings.weight False......transformer.layers.26.mlp.dense_4h_to_h.bias Falsetransformer.layers.27.input_layernorm.weight Truetransformer.layers.27.input_layernorm.bias Truetransformer.layers.27.attention.query_key_value.weight Truetransformer.layers.27.attention.query_key_value.bias Truetransformer.layers.27.attention.dense.weight Truetransformer.layers.27.attention.dense.bias Truetransformer.layers.27.post_attention_layernorm.weight Truetransformer.layers.27.post_attention_layernorm.bias Truetransformer.layers.27.mlp.dense_h_to_4h.weight Truetransformer.layers.27.mlp.dense_h_to_4h.bias Truetransformer.layers.27.mlp.dense_4h_to_h.weight Truetransformer.layers.27.mlp.dense_4h_to_h.bias Truetransformer.final_layernorm.weight Truetransformer.final_layernorm.bias Truemodel.chat start13+75=88, but that's not the correct answer. The correct answer is 13+75=88, which is 90./anaconda3/envs/py371/lib/python3.7/site-packages/transformers/optimization.py:395: FutureWarning: This implementation of AdamW is deprecated and will be removed in a future version. Use the PyTorch implementation torch.optim.AdamW instead, or set `no_deprecation_warning=True` to disable this warningFutureWarning, epoch: 0%| | 0/21 [00:00<?, ?it/s]epochs:batch_query: ['简便运算: 98+83= 剖析: 98+83=181'] | 0/8 [00:00<?, ?it/s]epoch: 0%| | 0/21 [00:00<?, ?it/s]epochs: batch_query: ['简便运算: 98+83= 剖析: 98+83=181'] | 0/8 [00:00<?, ?it/s]epoch_global: 0, step_global: 1, step: 0, loss: 4.0625batch_query: ['口算: 57.84+13.64 解: 57.84+13.64=71.48'] epoch_global: 0, step_global: 2, step: 1, loss: 2.5625███▌ | 2/8 [00:17<00:51, 8.54s/it]

batch_query: ['计算题: 48+1 解答: 48+1=49'] epoch_global: 0, step_global: 3, step: 2, loss: 4.15625█████████████████████▎ | 3/8 [00:38<01:09, 13.94s/it]batch_query: ['计算题: 61.65+33.05 解答: 61.65+33.05=94.7'] epoch_global: 0, step_global: 4, step: 3, loss: 2.40625████████████████████████████████████████ | 4/8 [01:01<01:09, 17.43s/it]

batch_query: ['计算: 81+75 回答: 81+75=156']...

4、模型推理

运行以下指令进行推理:

lora 方式 推理

python p00_toy_lora_predict_6b.pygenerator_calculate_line: ('13+75=', '13+75=88')

tokenizer.vocab_size: 150344

eval: 0%| | 0/1 [00:00<?, ?it/s] batch_query: ['简便运算: 98+83= 剖析: 98+83=181']

batch_qtext_0: 简便运算: 98+83= 剖析:

batch_qans_0: 98+83=181

response_0: 98+83=171

{'rouge-1': 0.0, 'rouge-2': 0.0, 'rouge-l': 0.0, 'bleu': 0.0}

请输入:

25.31+86.35=

请稍等...

25.31+86.35=101.66

...

四、经验分享

这里主要来着 yongzhuo/chatglm-maths 博主在复现过程中 的 经验分享。

- eps=1e-5(不要改小), 半精度float16, 以及LN采用的是Post-LN(泛化性更好) + DeepNorm, 【害, Attention前也有LN】目的是大模型为了防止梯度溢出等;

- 模型输入输出, 默认的tokenization_chatglm.py/modeling_chatglm.py不能用, 因为那是完全为生成generate设置的, 需要自己写好所有缩入参数, 或者机子改成适配的;

- ChatGLMModel中, get_masks()正常, get_position_ids()函数中‘context_length = seq.index(150004) + 1’ 改为 ‘context_length = len(seq)’;

- 训练输入input_ids格式暂定为(训练后post-padding, 推理前pre-padding[tokenization_chatglm.py默认pre-padding]) (eg: x: prompt_1 + “\n” + “" + text_1 + “\n” + prompt_2 + [gMASK] + [BOS] + "” + text_2 + [PAD]*N)

- 训练输入label_ids格式暂定为(CrossEntropyLoss默认忽略-100不参与计算loss) (eg:y = [-100]*len(text_1+1) + [BOS] + text_2 + [EOS] + [-100]*N)

- 注意position/mask(自带的只是推理用的batch_size=1, 所以训练输入还得自己写), 可参考GLM-130的README.md, huozhe 查看GLM-1源码https://github.com/THUDM/GLM/blob/main/tasks/seq2seq/dataset.py

- 注意chatglm-6b权重是float16的, 不过计算loss时候会转成float32计算, 最后loss再转回float16更新梯度;

- ChatGLMTokenizer有时候会报奇奇怪怪的错误, 建议生成时候设置max_new_tokens, 最大{“max_new_tokens”: 2048}; decode有时候会出现不存在id;

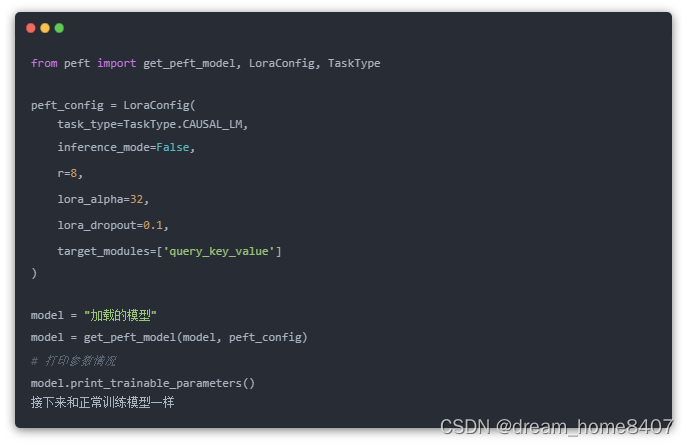

- 低秩自适应LORA, RuntimeError: Expected all tensors to be on the same device, but found at least two devices, cuda:0 and cpu!

尝试 transformers升级到最新, get_peft_model后再.cuda(), device_map={‘’:torch.cuda.current_device()}

基于 ChatGLM-6B 开发的开源项目:

以下是部分基于 ChatGLM-6B 开发的开源项目:

- SwissArmyTransformer: 一个Transformer统一编程框架,ChatGLM-6B已经在SAT中进行实现并可以进行P-tuning微调。

- ChatGLM-MNN: 一个基于 MNN 的 ChatGLM-6B C++ 推理实现,支持根据显存大小自动分配计算任务给 GPU 和 CPU

- ChatGLM-Tuning: 基于 LoRA 对 ChatGLM-6B 进行微调。类似的项目还包括 Humanable ChatGLM/GPT Fine-tuning | ChatGLM 微调

- langchain-ChatGLM:基于本地知识的 ChatGLM 应用,基于LangChain

- bibliothecarius:快速构建服务以集成您的本地数据和AI模型,支持ChatGLM等本地化模型接入。

- 闻达:大型语言模型调用平台,基于 ChatGLM-6B 实现了类 ChatPDF 功能

- JittorLLMs:最低3G显存或者没有显卡都可运行 ChatGLM-6B FP16, 支持Linux、windows、Mac部署

以下是部分针对本项目的教程/文档:

- Windows部署文档

相关资料

- THUDM/ChatGLM-6B

- 国产开源类ChatGPT模型,ChatGLM-6b初步微调实验

- yongzhuo/chatglm-maths

- THUDM/GLM

- tatsu-lab/stanford_alpaca

- LianjiaTech/BELLE

- carbonz0/alpaca-chinese-dataset

- huggingface/peft

- mymusise/ChatGLM-Tuning

- 国产开源类ChatGPT模型,ChatGLM-6b初步微调实验

- 从0到1基于ChatGLM-6B使用LaRA进行参数高效微调

- P-Tuning v2

2023-05-28(日)