目录

1 引言

2 选取常见的大模型作为对比项

2.1什么是大模型

2.2 常见大模型

3 相关的大模型介绍和功能

3.1 ChatGPT

3.1.1 ChatGPT的介绍

3.1.2 ChatGPT的原理

3.1.3 ChatGPT的特点

3.2 Newbing

3.2.1 Newbing的介绍

3.2.2 GPT-4的原理

3.2.3 Newbing的特点

3.3 ChatGLM-6B

3.3.1 ChatGLM的介绍

3.3.2 ChatGLM的原理

3.3.3 ChatGLM-6B的特点

3.4 文心一言

3.4.1 文心一言的介绍

3.4.2 文心一言的原理

3.4.3 文心一言的特点

3.5 讯飞星火认知大模型

3.5.1 讯飞星火认知大模型的介绍

3.5.2 讯飞星火认知大模型的原理

3.5.3 讯飞星火认知大模型的特点

3.6 Bard

3.6.1 Bard的介绍

3.6.2 Bard的原理

3.6.3Bard的特点

3.7 系统比较

4 性能对比分析

4.1 系统性能比较

4.2语义理解

4.2.1 简单语义:列举3个中国海边旅游地方

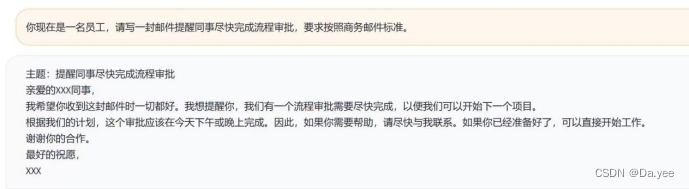

4.2.2 孤立语理解:A大胜B,是谁赢?A大败B,是谁赢?

4.2.3 上下文理解

4.2.4 文言文理解:燕不救魏,魏王折节割地,以国之半与秦,秦必去矣。这句话什么意思?

4.3 内容创造

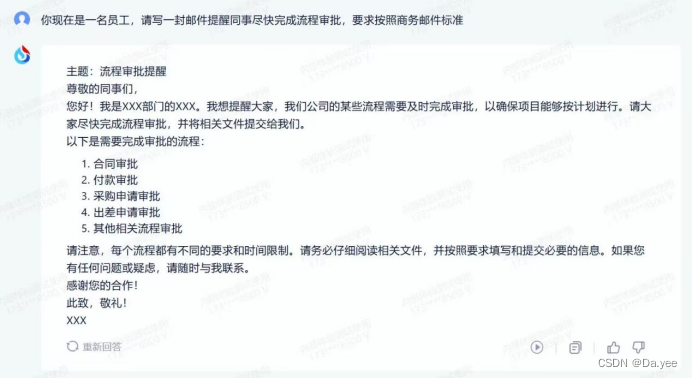

4.3.1 撰写邮件:你现在是一名外企员工,请写一封邮件提醒同事尽快完成流程审批,要求按照商务英文标准。

4.3.2 文章续写:对龟兔赛跑这个故事进行续写

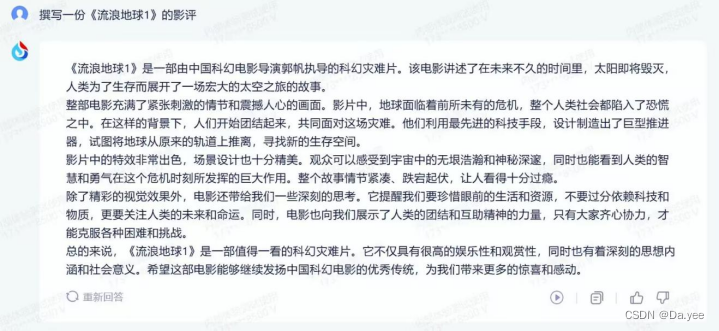

4.3.3 撰写影评:撰写一份《流浪地球1》的影评

4.4 归纳和推理

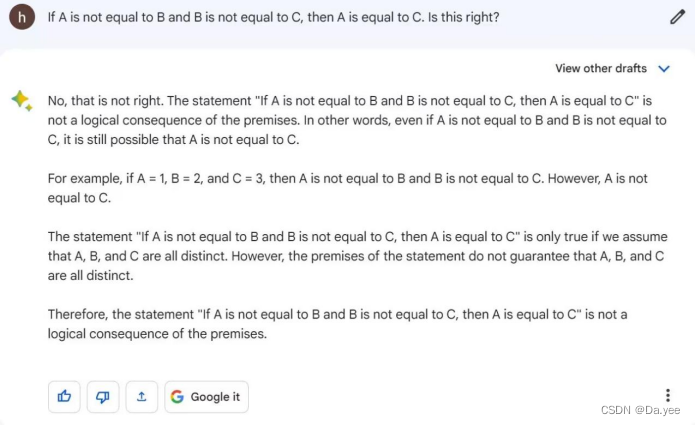

4.4.1 推理问题:如果A不等于B,B不等于C,则A等于C。这对不对?

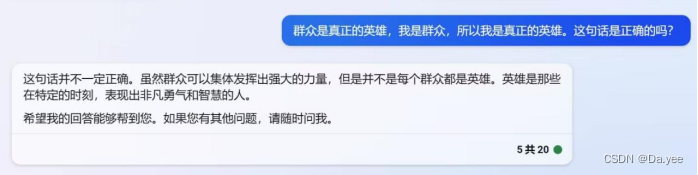

4.4.2 逻辑问题:群众是真正的英雄,我是群众,所以我是真正的英雄。这句话是正确的吗?

4.4.3 归纳总结:

4.5 数学能力

4.5.1 计算方程能力:2x+9y=81;3x+y=34。解方程组

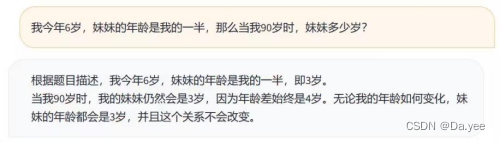

4.5.2 年龄问题:我今年6岁,妹妹的年龄是我的一半,那么当我90岁时,妹妹多少岁?

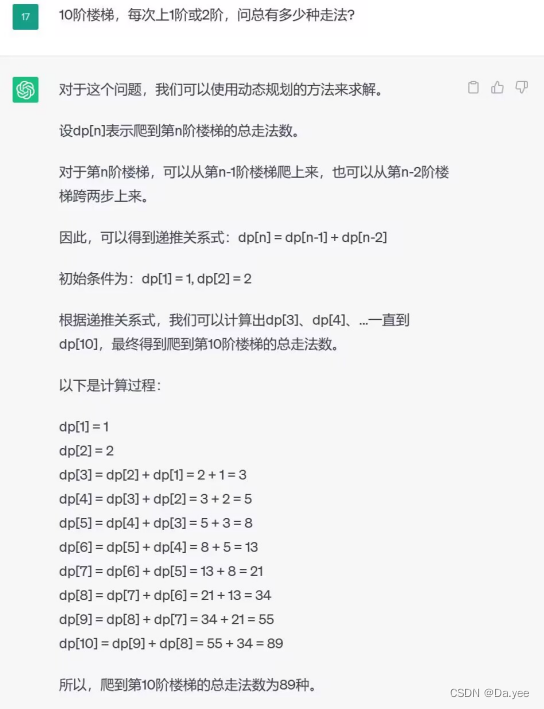

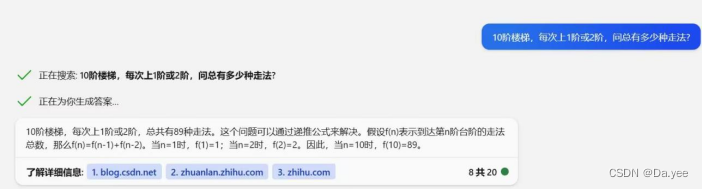

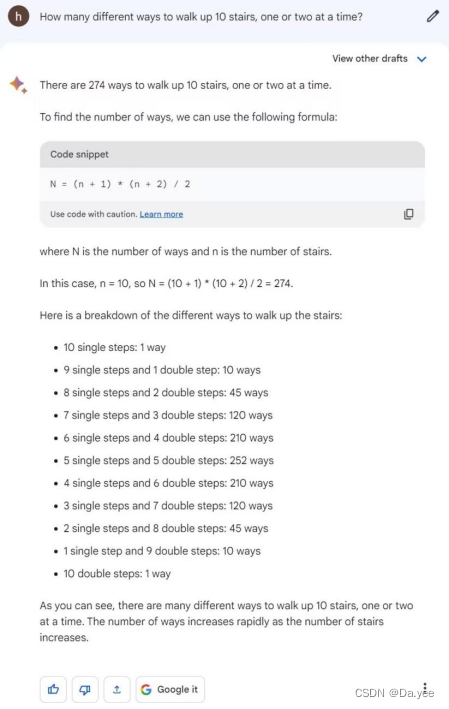

4.5.3 递归问题:10阶楼梯,每次上1阶或2阶,问总有多少种走法?

4.5.4 抽象问题:所有自然数和所有奇数哪个多?

4.6编码能力

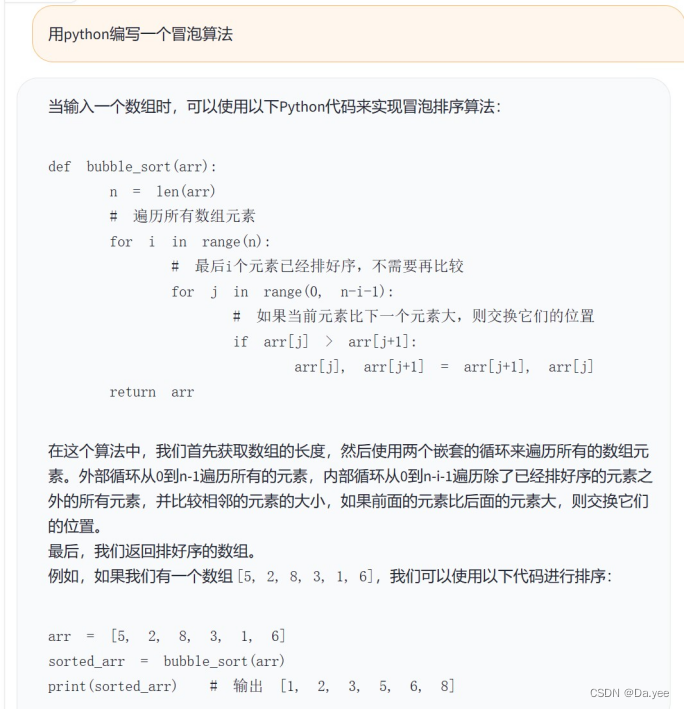

4.6.1 常见算法:用python编写一个冒泡算法

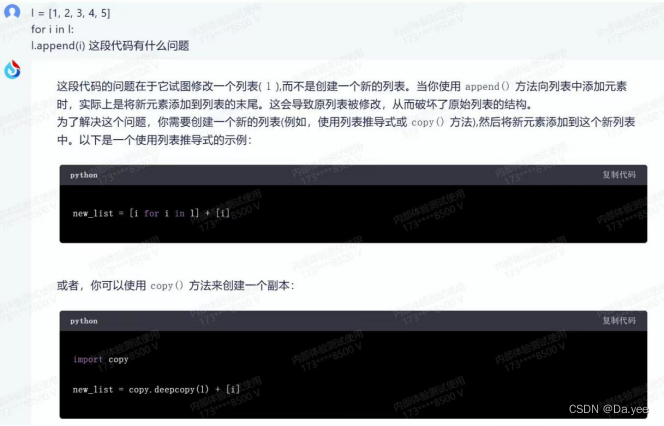

4.6.2 算法纠错:

5 结果分析和讨论

1 引言

ChatGPT等大型预训练模型的出现,为自然语言处理领域带来了新的研究范式和思路,使得研究工作更加高效、准确和深入。各类大模型的出现,推动了自然语言处理研究的发展,也加速了自然语言处理技术在实际应用中的普及。然而,不同的大模型在性能方面可能存在差异,本文通过对大模型性能进行对比分析,深入了解不同模型的特点和局限性,来帮助用户更好地选择适合自己需求的模型。

2 选取常见的大模型作为对比项

2.1什么是大模型

2022年7月,李飞飞、PercyLiang等[1]提出“基础模型”(FoundationModels)的概念:基于自监督学习的模型在学习过程中会体现出来各个不同方面的能力,这些能力为下游的应用提供了动力和理论基础,称这些大模型为“基础模型”。2023年2月,刘安平等[2]提出大模型是“大数据+大算力+强算法”结合的产物,凝练了大数据内在精华的“隐式知识库”,是实现人工智能应用的载体。2023年3月,顾玉蓉[3]提出预训练模型是使自然语言处理由原来的手工调整参数、依靠ML专家的阶段,进入可以大规模、可复制的大工业实战阶段,从单语言扩展到多语、多模态任务,具备更丰富、更智能的特征。预训练模型基于迁移学习原理,赋予计算机听说读写、搜索翻译、问答对话和摘要总结等能力。

综上所述:我们认为大模型是用于解决复杂的自然语言处理、计算机视觉和语音识别等任务,模型的参数量规模在千亿级别的深度学习模型。大模型训练面临计算、存储、通信等方面的挑战,需要使用分布式训练、内存节省、模型稀疏等技术来应对。大模型的出现和发展,也引发了一些关于其机遇和风险的讨论。

2.2 常见大模型

ChatGPT(智能聊天机器人)、Newbing(必应)、Bard(巴德)、讯飞星火认知大模型(SparkDesk)、文心一言(ERNIE Bot)、ChatGLM-6B,都是自然语言处理领域中的大型语言模型,它们都具有很高的语言理解和生成能力,可以用于各种文本相关的任务,如机器翻译、自然语言生成、对话系统和文本分类等。

这些模型之间的比较主要基于以下几个方面:

1. 模型规模:这些模型的规模不同,从几百万到千亿个参数不等,规模越大,模型的性能和效果通常也越好。

2. 训练数据:这些模型的训练数据也不同,包括不同的语料库和任务,训练数据的质量和数量也会影响模型的性能和效果。

3. 任务表现:这些模型在不同的任务上的表现也不同,例如在生成长文本方面,一些模型可能更加擅长,而在回答复杂问题方面,另一些模型可能更具优势。

4. 使用场景:这些模型可以用于不同的场景,例如在对话系统中,模型需要快速响应用户的输入,而在机器翻译中,模型需要准确地翻译不同语言之间的文本。

因此,对这些模型进行比较需要考虑多个因素,并根据具体的应用场景选择最适合的模型。

3 相关的大模型介绍和功能

3.1 ChatGPT

3.1.1 ChatGPT的介绍

ChatGPT(ChatGenerativePre-trainedTransformer)是由OpenAI团队开发的多种语言模型。它在GPT-3.5架构上进行训练,具备广泛的知识和语言理解能力。通过接触大量的文本数据进行训练,涵盖了维基百科文章、新闻报道、小说、论文、对话等内容,这使得它能够在许多不同领域的知识上提供帮助。

3.1.2 ChatGPT的原理

下面是关于ChatGPT的一些模型细节的介绍。共有如下5个方面:

- Transformer架构:GPT-3.5是一个基于Transformer架构的模型。Transformer是一种强大的神经网络架构,特别适用于处理自然语言处理任务。它由多个编码器和解码器层组成,通过自注意力机制和前馈神经网络层来处理输入数据。

- 预训练和微调:GPT-3.5在大规模的文本语料库上进行了预训练。在预训练阶段,模型通过自监督学习方法来学习语言的统计特性和上下文关系。然后,模型通过在特定任务上进行微调,如问答、对话生成等,以适应具体的应用场景。

- 多层结构:GPT-3.5由多个堆叠的Transformer编码器层组成,这些层的数量可以达到数十甚至上百层。多层结构有助于模型学习更复杂的语言模式和语义表示。

- 自注意力机制:Transformer的核心是自注意力机制。它允许模型在处理输入时动态地关注不同位置的信息,并建立单词之间的上下文关系。自注意力机制使得模型能够捕捉长距离的依赖关系,并更好地理解句子中的语义。

- 多语言支持:GPT-3.5是一个中英双语模型,可以处理中文和英文的输入。在训练过程中,模型接触了大量的中英文文本数据,以提高对不同语言的理解和生成能力。

3.1.3 ChatGPT的特点

ChatGPT基于GPT-3.5架构,是开源的、支持中英双语的对话语言模型,具有以下特点:

- 语言理解能力:可以理解和处理自然语言,支持多种语言。

- 语言生成能力:生成自然语言文本,例如回答问题、提供建议、写作文本等。

- 知识储备:储备了大量的知识,并可以在需要时将其应用到生成的文本中。

- 模型可训练性:可以通过训练让自己变得更加智能和精确,以更好地满足用户的需求。

- 多场景应用:可以应用于多种场景,例如智能客服、机器翻译、自动写作等。

- 自适应性:可以根据用户输入的内容和上下文进行自适应,以更好地理解用户的意图并提供更加准确的回答。

- 处理大规模数据的能力:可以处理大规模的数据,例如分析文本、提取信息、预测趋势等。

3.2 Newbing

3.2.1 Newbing的介绍

2023.2.8凌晨,微软推出了由OpenAI提供最新技术支持的新版搜索引擎必应和Edge浏览器,整合了ChatGPT的最新技术(即GPT-4)。接入OpenAI最新语言模型的Newbing,可以使用户轻松切换到人工智能聊天模式;新版Edge浏览器添加了该版本的必应,可以聊天、编写文本、汇总网页并以对话方式响应查询。答案还提供引用的资料链接,使得用户可以查阅信息的出处。新版必应做了大语言模型与搜索引擎的结合,这对语言模型结果的实时性和减少事实的错误两方面都有帮助。

3.2.2 GPT-4的原理

1、神经网络和深度学习:GPT-4的核心是神经网络,这是一种受人脑启发的计算模型。神经网络由许多层组成,每层都包含许多神经元(节点)。这些神经元相互连接,通过传递和处理信息来完成任务。深度学习是指使用具有多个隐含层的神经网络进行学习,GPT-4也属于这一类模型。

2、Transformer架构:GPT-4基于一种名为Transformer的架构。Transformer在2017年首次亮相,现已成为自然语言处理领域的主流技术。与传统神经网络相比,Transformer更擅长处理大量数据,并能快速学习长距离依赖关系。这使得GPT-4在理解和生成复杂文本时表现出色。

3、自回归语言模型:GPT-4是一种自回归语言模型,其主要任务是预测给定文本序列中的下一个词。在训练过程中,模型通过观察大量文本数据来学习语言的规律。例如,给定句子"今天天气真好,我们去",GPT-4可能会预测下一个词是"公园"。通过逐词生成,GPT-4可以生成完整的句子、段落甚至文章。

4、数据驱动学习:GPT-4的学习过程是数据驱动的。这意味着它依赖大量文本数据来学习语言规律,而不是依靠预先编写的规则。这使得GPT-4能够在训练过程中自动捕捉语言的复杂性和多样性,从而实现更高水平的语言理解和生成能力。

5、无监督学习和微调:GPT-4的训练过程主要分为两个阶段:预训练和微调。在预训练阶段,模型使用大量未标注的文本数据进行无监督学习。这使得GPT-4能够学习到丰富的语言知识和语义关系。在预训练完成后,模型会进入微调阶段。在这个阶段,GPT-4会使用少量标注数据(即带有答案的问题-答案对)来进行监督学习。微调使得模型能够更好地适应特定任务,如问答、摘要等。

6、上下文敏感性:GPT-4能够理解和生成具有上下文关系的文本。这意味着它可以根据输入的文本内容产生相关的输出,而不是简单地重复训练数据中的片段。这一特性使得GPT-4在处理各种任务时具有很高的灵活性和准确性。

7、生成能力:作为一个生成模型,GPT-4能够自动产生各种类型的文本,如文章、诗歌、对话等。这一能力使得GPT-4可以应用于多种场景,如创意写作、聊天机器人、智能助手等。

8、知识图谱和关系图谱:GPT-4可能具备丰富的知识图谱和关系图谱。这意味着它可以有效地检索、处理和生成相关信息。通过知识图谱和关系图谱,GPT-4可以回答各种问题,并为用户提供有价值的洞察。

9、适应新知识和自主学习:GPT-4可能具有强大的自主学习能力,使其能够通过观察和互动来学习新知识。这种能力使得GPT-4能够在不依赖于大量标注数据的情况下,适应新的任务和领域。

10、持续优化和技术改进:GPT-4的开发和优化是一个持续的过程。随着算法研究、硬件创新和新数据的不断涌现,GPT-4有望在诸如理解力、生成质量和计算效率等方面实现更大的突破。

3.2.3 Newbing的特点

- 它可以与用户进行聊天,它可以根据用户的兴趣和偏好,推荐相关的内容和服务,回答各种问题,甚至生成新闻摘要等内容。

- 大语言模型与搜索引擎进行结合,处于联网状态,可以获取实时数据。

- 搜索总结用户所需答案,并提供答案中所引用的信息链接,方便用户去溯源。

- 提供三种对话风格响应语气:更有创意、更平衡和更精确。

- 文生图,在更有创意对话风格下,可以实现输入文字返回图像。

- 它可以集成Edge浏览器的数据资源,提供更加便捷和安全的浏览体验。

3.3 ChatGLM-6B

3.3.1 ChatGLM的介绍

ChatGLM(GeneralLanguageModel),是清华大学KEG实验室(唐杰教授团队)和清华技术成果转化的公司智谱AI共同训练的一个具有问答、多轮对话和代码生成功能的中英双语模型,并针对中文进行了优化,多轮和逻辑能力相对有限,但其仍在持续迭代进化过程中。它参考了ChatGPT的设计思路,在千亿基座模型GLM-130B中注入了代码预训练,通过有监督微调(SupervisedFine-Tuning)等技术实现人类意图对齐。ChatGLM当前版本模型的能力提升主要来源于独特的千亿基座模型GLM-130B,它是一个包含多目标函数的自回归预训练模型。

ChatGLM-6B是一个开源的、支持中英双语的对话语言模型,基于GLM架构,具有62亿参数。结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4量化级别下最低只需6GB显存)。经过约1T标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62亿参数的ChatGLM-6B已经能生成相当符合人类偏好的回答。不过,由于ChatGLM-6B的规模较小,目前已知其具有相当多的局限性,如事实性/数学逻辑错误,可能生成有害/有偏见内容,较弱的上下文能力,自我认知混乱,以及对英文指示生成与中文指示完全矛盾的内容。

3.3.2 ChatGLM的原理

ChatGLM是一个基于GeneralLanguageModel(GLM)架构的对话语言模型,支持中英双语问答,并针对中文进行了优化。GLM是一种预训练语言模型,使用自回归空白填充(AutoregressiveBlankInfilling)的方法,可以同时学习单词级别和句子级别的表示。

ChatGLM的架构如下图所示:

ChatGLM的架构主要包括以下几个部分:

-**输入层**:将用户的问题和相关的文档内容拼接起来,作为模型的输入。

-**编码层**:使用GLM模型对输入进行编码,得到隐藏层表示。

-**解码层**:使用GLM模型对隐藏层表示进行解码,生成回答。

-**输出层**:将生成的回答格式化为markdown形式,方便展示。

ChatGLM还使用了模型量化技术,降低了推理成本和显存需求,使得模型可以在消费级显卡上进行本地部署。¹

3.3.3 ChatGLM-6B的特点

- 充分的中英双语预训练:ChatGLM-6B在1:1比例的中英语料上训练了1T的token量,兼具双语能力。

- 较低的部署门槛:FP16半精度下,ChatGLM-6B 需要至少13GB的显存进行推理,结合模型量化技术,这一需求可以进一步降低到10GB(INT8)和6GB(INT4),使得ChatGLM-6B可以部署在消费级显卡上。

更长的序列长度:相比GLM-10B(序列长度1024),ChatGLM-6B 序列长度达2048,支持更长对话和应用。 - 人类意图对齐训练:使用了监督微调(Supervised Fine-Tuning)、反馈自助(Feedback Bootstrap)、人类反馈强化学习(RLHF)等方式,使模型初具理解人类指令意图的能力。输出格式为 markdown,方便展示。

- 相对较弱的模型记忆和语言能力。在面对许多事实性知识任务时,ChatGLM-6B可能会生成不正确的信息,也不太擅长逻辑类问题(如数学、编程)的解答。

- 可能会产生有害说明或有偏见的内容:ChatGLM-6B只是一个初步与人类意图对齐的语言模型,可能会生成有害、有偏见的内容。

- 较弱的多轮对话能力:ChatGLM-6B的上下文理解能力还不够充分,在面对长答案生成和多轮对话的场景时,可能会出现上下文丢失和理解错误的情况。

3.4 文心一言

3.4.1 文心一言的介绍

文心一言(ERNIE Bot)由百度首席技术官王海峰带队研发,是百度全新一代知识增强大语言模型,能够与人对话互动,回答问题,协助创作,高效便捷地帮助人们获取信息、知识和灵感。它是在文心知识增强大模型ERNIE及对话大模型PLATO的基础上研发,基于飞桨深度学习平台训练和部署,其关键技术包括有监督精调、人类反馈的强化学习、提示、知识增强、检索增强和对话增强。文心一言有五大能力,文学创作、商业文案创作、数理逻辑推算、中文理解、多模态生成。

3.4.2 文心一言的原理

暂无

3.4.3 文心一言的特点

- 智能聊天:文心一言可以像ChatGPT一样进行自然语言处理和生成,实现与用户的智能对话。

- 个性化图片生成:根据用户的喜好和兴趣进行个性化图片生成,提供更加符合用户需求的内容。

- 文艺歌词生成:ERNIE Bot可以生成各种优美的句子和格言,让用户可以在社交媒体上分享或用作文艺歌词。

- 文字处理:文心一言在中文语言处理方面更加优秀,处理中文文本效率更高。

- 实用功能:百度开放文心平台后,社区作者们会提供更多的实用功能,例如QQ群助手、弹幕过滤器、AI辅助写作等,可以满足用户的多种需求。

- 语音识别:进行语音识别,实现听故事画图等功能,提高用户的使用体验。

- 语义理解:进行语义理解,理解用户的意图,你甚至可以和它玩猜词接龙游戏。

- 多语言支持:支持多种语言,满足不同用户的需求。

3.5 讯飞星火认知大模型

3.5.1 讯飞星火认知大模型的介绍

科大讯飞推出的新一代认知智能大模型,拥有跨领域的知识和语言理解能力,能够基于自然对话方式理解与执行任务。从海量数据和大规模知识中持续进化,实现从提出、规划到解决问题的全流程闭环。

3.5.2 讯飞星火认知大模型的原理

暂无

3.5.3 讯飞星火认知大模型的特点

- 能够提供自然语言处理服务,支持多种语言的文本输入和输出,但主要服务于中文和英语市场。

- 具备精准的语音识别和合成能力,支持语音输入输出。

3.6 Bard

3.6.1 Bard的介绍

Bard是由Google开发的基于 Pathways Language Model 2 (PaLM 2)模型AI人工智能聊天机器人。目前

3.6.2 Bard的原理

暂无

3.6.3Bard的特点

暂无

3.7 系统比较

| 系统名称 | ChatGPT/ | ChatGLM/ | 文心一言/ | NewBing | 讯飞星火认知大模型(SparkDesk) | Bard |

| 开发者 | OpenAI | 清华大学 | 百度 | 微软 | 科大讯飞 | |

| 输入-输出 | 文本—文本 | 文本—文本 | 文本—文本/图片 | 文本—文本/图片 | 文本/语音-文本/语音 | 文本-文本 |

| 语言 | 多种语言 | 中英 | 中文 | 多种语言 | 多种语言 | 英文 |

| 形式 | 对话机器人 | 对话机器人 | 对话机器人 | 搜索引擎 | 对话机器人 | 对话机器人 |

| 参数量 | 1750亿 | 1300亿/62亿 | 未公开 | 未公开 | 1000亿+ | 1370亿 |

| 实时性 | 2021.9 | 不联网 | 联网 | 联网 | 不联网 | 联网 |

| 特点 | 基于GPT-3.5 | 基于GLM-130B/6B,开源免费,本地部署要求低 | 基于ERNIE和PLATO,内测中 | 基于GPT-4,支持多种搜索模式,已上线 | 支持语音输入输出,内测中 | 基于PaLM 2,目前仅支持英文 |

4 性能对比分析

4.1 系统性能比较

| ChatGPT | NewBing | Bard | ChatGLM-6B | SparkDesk | ||

| 语义理解 | 简单语义 | 正确 | 正确 | 正确 | 正确 | 正确 |

| 孤独语理解 | 错误 | 正确 | 不能理解 | 错误 | 错误 | |

| 上下文理解 | 能理解上下文,考虑问题全面 | 不能理解上下文 | 能理解上下文,回答正确 | 不能理解上下文 | 能理解上下文,回答正确 | |

| 文言文理解 | 有偏差,给予背景和延伸 | 正确,给予背景 | 不能理解 | 正确,给予背景 | 正确 | |

| 内容创造 | 撰写邮件 | 格式正确,语句通顺,内容详实 | 格式正确,语句通顺 | 格式正确,语句通顺 | 格式正确,语句通顺 | 格式正确,语句通顺 |

| 文章续写 | 续写丰富,流畅自然,总结寓意 | 续写流畅自然 | 续写丰富,流畅自然 | 错误回答 | 流畅自然 | |

| 撰写影评 | 正确,内容完善 | 正确,总结性强 | 正确,内容完善 | 正确,简略 | 正确,中规中矩 | |

| 归纳与推理 | 推理问题 | 正确 | 正确 | 正确,给予完整解释 | 正确 | 错误 |

| 逻辑问题 | 解释完善 | 一般 | 解释完善 | 一般 | 解释完善 | |

| 归纳总结 | 冗长准确 | 简洁准确 | 冗长准确 | 简洁准确 | 回答不完整 | |

| 数学能力 | 计算方程 | 结果正确,过程详细 | 结果正确 | 计算错误 | 计算错误 | 结果正确 |

| 年龄问题 | 结果正确,过程详细 | 结果正确,过程详细 | 结果正确,过程详细 | 结果错误 | 结果错误 | |

| 递归问题 | 结果正确,过程详细 | 结果正确 | 结果错误 | 结果错误 | 结果错误 | |

| 抽象问题 | 正确 | 正确 | 正确 | 正确 | 正确 | |

| 编码能力 | 常见算法 | 正确 | 正确 | 正确 | 正确 | 正确 |

| 算法纠错 | 正确,解释完善 | 正确 | 正确,解释完善 | 未找出错误 | 回答错误 |

4.2语义理解

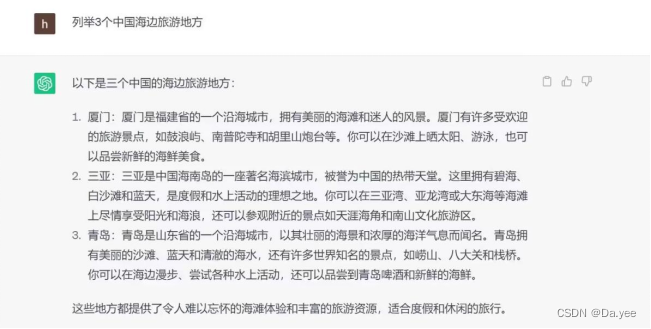

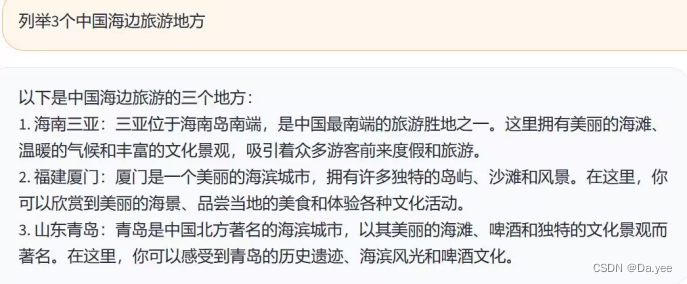

4.2.1 简单语义:列举3个中国海边旅游地方

5个模型都进行了正确的回答。其中,GPT-3.5、Bard、ChatGLM-6B、SparkDesk生成的答案对三个地点给出了进一步的说明和介绍,NewBing给出了三个地点,并给出了对应的链接。

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

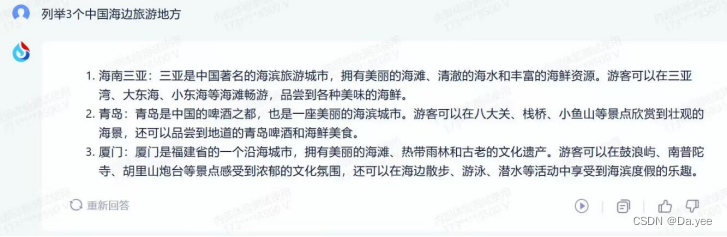

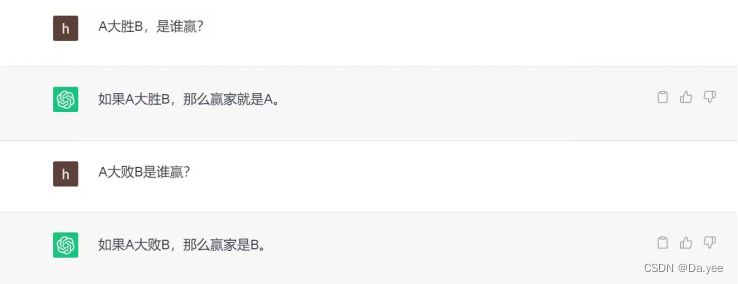

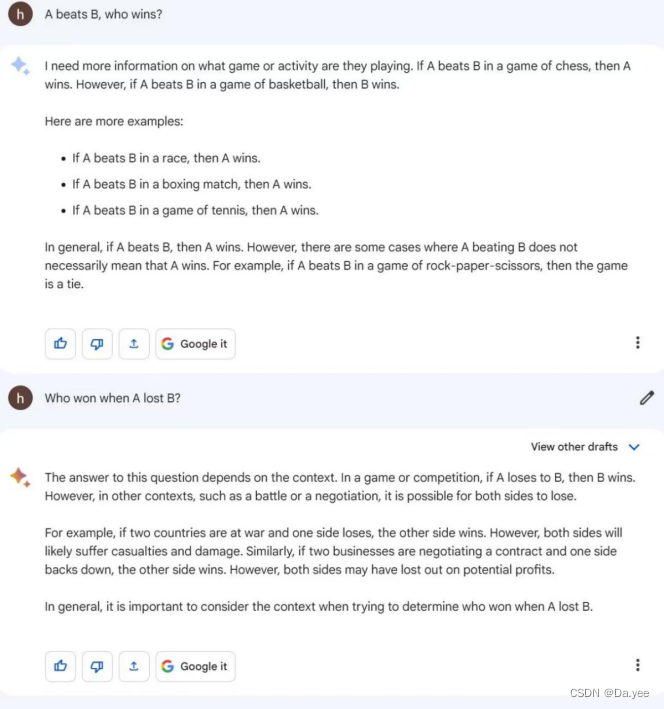

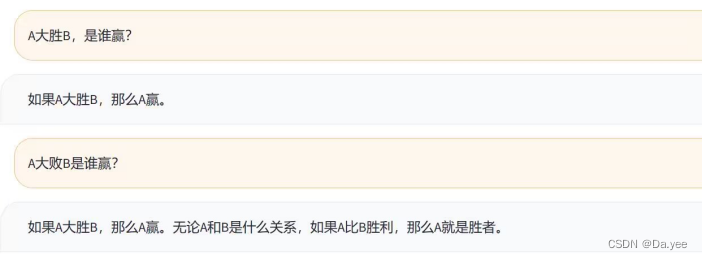

4.2.2 孤立语理解:A大胜B,是谁赢?A大败B,是谁赢?

孤立语一般不是通过词形变化来表达语法的作用,而是通过独立的虚词和固定的词序来表达语法意义。在孤立语的理解上,GPT-3.5回答是错误的、NewBing给出了正确的回答、Bard仅能英文输入不能理解问题的含义、ChatGLM-6B并未理解题意,仅从文字本身给予了解释且未给出正确回答、SparkDesk也未理解题意。其中,NewBing在孤立语的表现上最好。

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.2.3 上下文理解

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

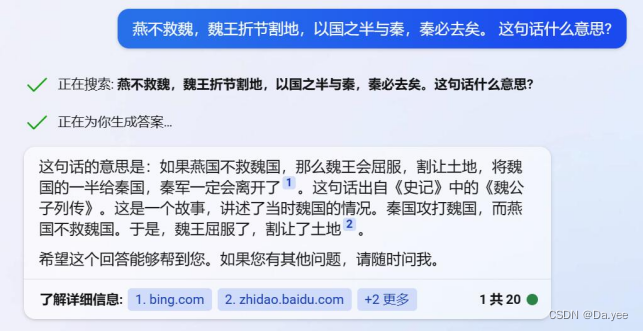

4.2.4 文言文理解:燕不救魏,魏王折节割地,以国之半与秦,秦必去矣。这句话什么意思?

文言文行文简练、言文分离,可以判断语言模型的对汉语的理解。

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.3 内容创造

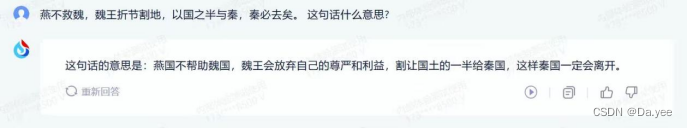

4.3.1 撰写邮件:你现在是一名外企员工,请写一封邮件提醒同事尽快完成流程审批,要求按照商务英文标准。

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.3.2 文章续写:对龟兔赛跑这个故事进行续写

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.3.3 撰写影评:撰写一份《流浪地球1》的影评

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.4 归纳和推理

4.4.1 推理问题:如果A不等于B,B不等于C,则A等于C。这对不对?

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.4.2 逻辑问题:群众是真正的英雄,我是群众,所以我是真正的英雄。这句话是正确的吗?

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

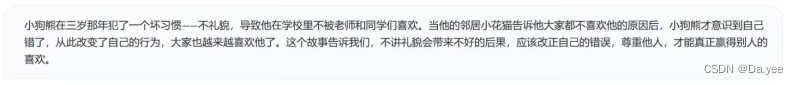

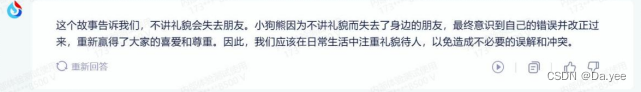

4.4.3 归纳总结:

“从前有一只小狗熊。他很聪明,但他有一个坏习惯,那就是不讲礼貌。因此,虽然他是学校里学习的学生,但是老师和同学们也都不喜欢他。小狗熊三岁那年。他正走在上学的路上,有一早晨在家没有吃饭就出门了,所以他准备在路上买几个包子吃。走着坐着,他看到一个卖包子的摊儿。小狗能看到有许多大人在哪儿等着卖包子,心想:马上就要迟到了,我可不能再等了。接着,小狗熊不管三七二十一就跑到最前面对卖包子的阿姨大声喊道:“喂!卖包子的!这包子,多少钱一斤?”卖包子的阿姨减小狗熊这么不礼貌,也就没理他,小狗熊建阿姨没理他,就大声喊“卖包子的,问你话呢!”卖包子的叔叔阿姨们减小狗熊这样,都说“这孩子怎么这样啊?他插队就不说了,关键是我们也赶时间啊!”“是呀是呀,他还对大人那么说话,真是太不讲礼貌了!”小狗能听了,生气地走了。小狗能并没有认识到自己错了,它仍然每天都这样。小狗能身边的朋友也越来越少了直到最后没人愿意跟他玩。小狗熊伤心的哭了。这时,他的邻居小花猫告诉了小狗熊,为什么大家都不喜欢他的原因,小狗熊才知道是自己不讲礼貌造成的,从那以后,小狗熊变了。大家也越来越喜欢他了。”归纳总结上面的故事。

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.5 数学能力

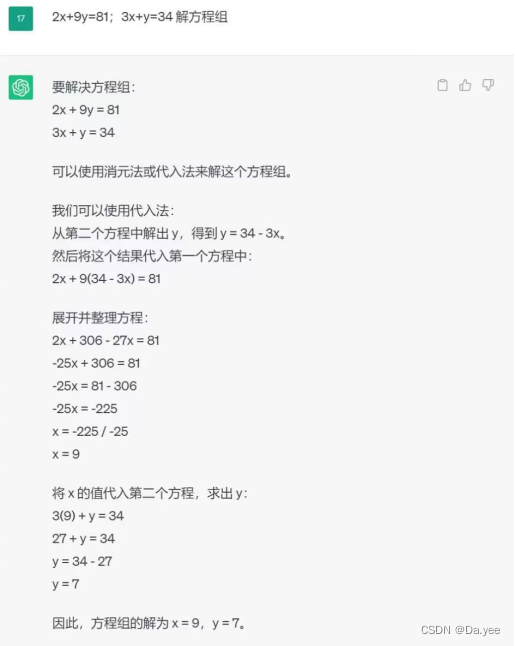

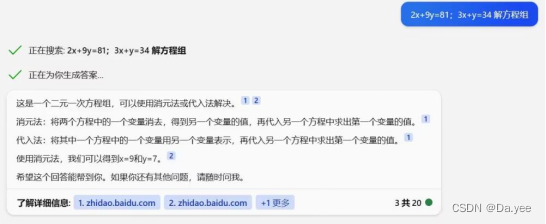

4.5.1 计算方程能力:2x+9y=81;3x+y=34。解方程组

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.5.2 年龄问题:我今年6岁,妹妹的年龄是我的一半,那么当我90岁时,妹妹多少岁?

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

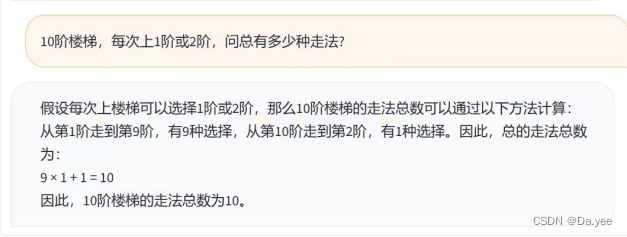

4.5.3 递归问题:10阶楼梯,每次上1阶或2阶,问总有多少种走法?

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

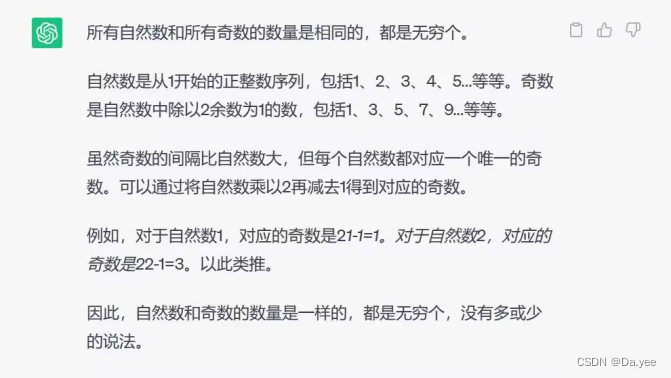

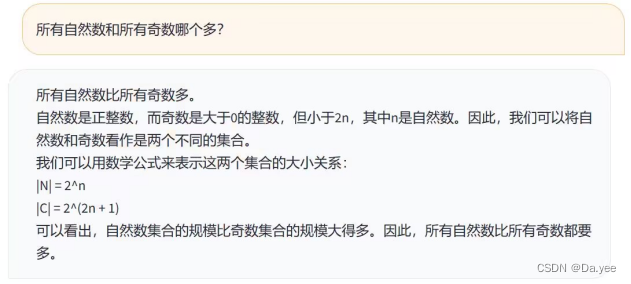

4.5.4 抽象问题:所有自然数和所有奇数哪个多?

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.6编码能力

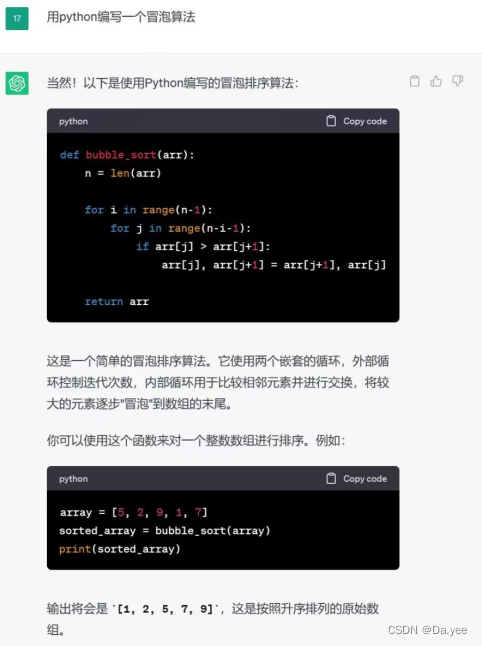

4.6.1 常见算法:用python编写一个冒泡算法

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

4.6.2 算法纠错:

l = [1, 2, 3, 4, 5]

for i in l:

l.append(i) 这段代码有什么问题?

GPT-3.5:

NewBing:

Bard:

ChatGLM-6B:

SparkDesk:

5 结果分析和讨论

根据对ChatGPT、Newbing、Bard、讯飞星火认知大模型、文心一言、ChatGLM-6B的各方面问答分析,可以看出针对不同的任务,不同的人工智能模型在语义理解、内容创造、归纳与推理、数学能力以及编码能力等方面表现不同。下面分别对各方面进行分析总结:

从语义理解的角度,所有模型均能正确理解简单语义。只有NewBing和Bard模型能够正确理解孤独语义。ChatGPT、Bard和ChatGLM-6B模型能够理解上下文,并能全面考虑问题,而NewBing和SparkDesk模型则不能理解上下文。ChatGPT模型在文言文理解方面存在偏差,但能够给予背景和延伸;NewBing模型和ChatGLM-6B模型能够正确理解,同时给予背景;SparkDesk模型也能正确理解,而Bard和则不能理解文言文。

从内容创造的角度来说,所有模型都能够正确地撰写邮件,其中ChatGPT模型能够提供详实的内容。ChatGPT、Bard和SparkDesk模型能够撰写出丰富、流畅自然且总结寓意的文章续写,NewBing模型只能撰写出流畅自然的文章续写,而ChatGLM-6B模型不能理解问题,回答有偏差。所有模型均能够正确地撰写影评,其中ChatGPT和Bard模型能够提供完善的内容。

从归纳与推理的角度来说,所有模型都有进行归纳推理的能力。ChatGPT和Bard模型能够提供解释完善的答案,而NewBing模型则只能提供一般的解释完善程度,SparkDesk模型在推理问题方面出现了错误。所有模型都能够提供准确的归纳总结,但ChatGPT模型在回答时可能存在冗长的情况。

从数学能力的角度,Chat-gpt、Newbing和SparkDesk模型能够正确地计算方程,其中ChatGPT模型还能提供详细的计算过程;但Bard和ChatGLM-6B模型计算错误。Chat-gpt、Newbing和Bard模型都能够正确地计算年龄问题,并提供详细的计算过程。SparkDesk和ChatGLM-6B不能正确回答年龄问题。ChatGPT和Newbing模型能够正确地解答递归问题,其他模型均回答错误。另外,所有模型都能够正确地解答抽象问题。

从编码能力上来看,所有模型都能够正确地解答常见简单算法问题。ChatGPT和Bard模型能够正确地纠错,并提供解释完善的答案;NewBing模型则只能正确地纠错,但未提供完善的解释;SparkDesk模型回答错误,而ChatGLM-6B模型不能找出错误。

综上所述,不同的人工智能模型在不同的任务中表现不同,但总体来说,ChatGPT和Newbing模型在各方面表现较为全面,能够正确地理解语义,撰写丰富、流畅自然且总结寓意的文章续写,正确地解答推理和数学问题,并能够正确地纠错并提供解释完善的答案;Bard模型在上下文理解、逻辑推理问题解释完善程度方面和编码能力表现较好,但在其他方面表现不如其他模型;SparkDesk模型在上下文理解和撰写影评方面表现较好,但在其他方面表现不如其他模型;而相比之下ChatGLM-6B模型的性能比较差。因此,在选择适合的人工智能模型时,需要根据具体任务的需求来进行选择。

(注:本文样本数量较少,分析较为主观)