强化学习是一种机器学习技术,它关注的是在特定环境中,如何最大化一个智能体(agent)的累积奖励(reward)。强化学习算法会根据当前状态和环境的反馈来选择下一个动作,不断地进行试错,从而优化智能体的行为。

SARSA是一种基于强化学习的算法,它可以用于解决马尔可夫决策过程(Markov Decision Process,MDP)问题。在MDP中,一个智能体处于一个状态,可以选择执行某个动作,并且会获得一个奖励。这个过程会重复进行,智能体会根据当前状态、动作和奖励来更新自己的行为。

下面是SARSA算法的详细步骤:

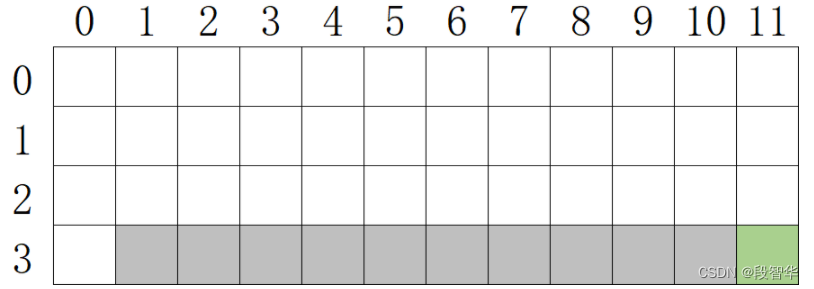

1、初始化Q值函数:在SARSA算法中,Q值函数表示在某个状态下采取某个动作可以获得的累积奖励。我们可以初始化一个空的Q值函数或者使用随机值来进行初始化。

2、选择动作:在每个时间步中,根据当前状态和Q值函数选择一个动作。在SARSA算法中,我们会使用“ε-greedy”策略来进行动作选择,即在大部分时间内选择当前Q值最高的动作,但是有一定概率(ε)随机选择一个动作。

3、执行动作并观察奖励和下一个状态:执行所选的动作,并观察在该状态下执行该动作所获得的奖励和下一个状态。

4、选择下一个动作:根据下一个状态和当前Q值函数选择下一个动作。这个步骤和第二步类似,使用“ε-greedy”策略来进行动作选择。

5、更新Q值函数:根据当前状态、执行的动作、观察到的奖励和下一个状态来更新Q值函数。具体地,使用如下公式进行更新:

Q(s, a) = Q(s, a) + α[r + γQ(s’, a’) - Q(s, a)]

其中,s是当