Transformer网络原理与实战

- 1. 什么是Transformer网络

- 2. Transformer网络原理

- 2.1 自注意力机制

- 2.2 多头自注意力机制

- 2.3 Transformer网络的训练

- 3.Transformer网络实战

1. 什么是Transformer网络

Transformer网络是一种基于自注意力机制的神经网络,由Google于2017年提出,并被广泛应用于自然语言处理、语音识别、图像生成等领域。相对于传统的循环神经网络和卷积神经网络,Transformer网络具有更好的并行性和更高的计算效率,在处理长文本时表现更加出色。

Transformer网络的核心思想是利用自注意力机制来实现序列建模。该模型的输入和输出都是序列,它可以将源序列和目标序列分别映射到一个连续的向量空间中,并使用自注意力机制来计算输入序列中各个位置之间的依赖关系,从而实现对序列的建模。

2. Transformer网络原理

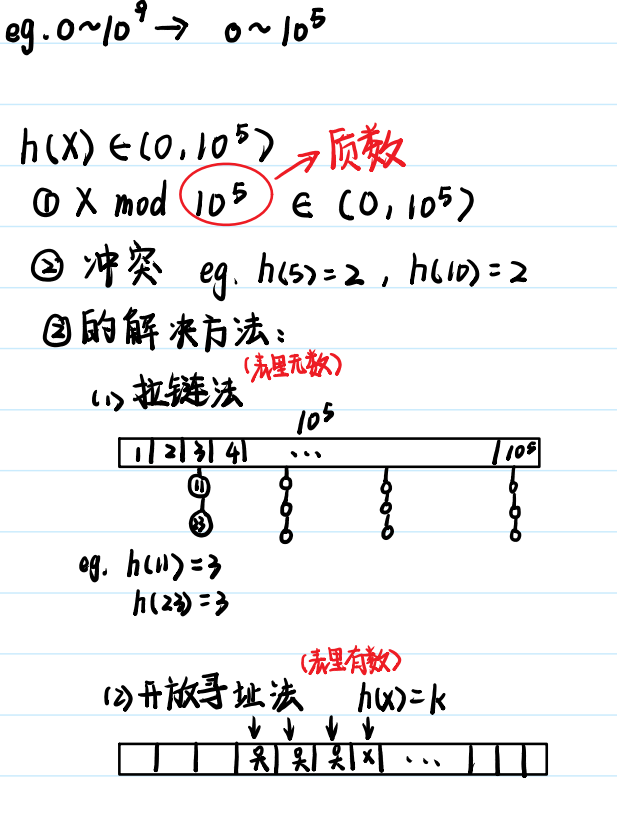

2.1 自注意力机制

自注意力机制是Transformer网络的核心组成部分。它可以根据输入序列中各个位置之间的依赖关系来计算每个位置的注意力权重,然后将加权后的向量作为该位置的表示。自注意力机制可以在不同的位置之间建立联系,从而实现对序列中所有位置的建模。

具体来说,自注意力机制包括三个部分:查询向量、键向量和值向量。假设输入序列为 X = x 1 , x 2 , . . . , x n X = {x_1, x_2, ..., x_n} X=x1,x2,...,xn,则对于每个位置 i i i,我们可以将其表示为一个 d d d 维向量 h i h_i hi,其中 d d d 是向量的维度。然后,我们可以通过以下公式计算该位置的注意力权重:

α i , j = exp ( e i , j ) ∑ k = 1 n exp ( e i , k ) \alpha_{i,j} = \frac{\exp(e_{i,j})}{\sum_{k=1}^{n}\exp(e_{i,k})} αi,j=∑k=1nexp(ei,k)exp(ei,j)

其中, e i , j e_{i,j} ei,j 是位置 i i i 和位置 j j j 之间的相似度,可以通过查询向量 q i q_i qi 和键向量 k j k_j kj 的点积来计算:

e i , j = q i T k j e_{i,j} = q_i^Tk_j ei,j=qiTkj

最后,我们可以将注意力权重 α i , j \alpha_{i,j} αi,j 与值向量 v j v_j vj 的加权和作为位置 $i的表示:

h i = ∑ j = 1 n α i , j v j h_i = \sum_{j=1}^{n}\alpha_{i,j}v_j hi=j=1∑nαi,jvj

2.2 多头自注意力机制

在实际应用中,为了更好地捕捉序列中的信息,我们通常会使用多个查询、键和值向量来计算自注意力。这就是多头自注意力机制的核心思想。

具体来说,我们可以将输入序列 X X X 分别映射到 h h h 维向量空间中得到 H = h 1 , h 2 , . . . , h n H = {h_1, h_2, ..., h_n} H=h1,h2,...,hn,然后将 H H H 沿着向量的维度分成 m m m 个部分,每个部分包含 h / m h/m h/m 维向量。然后,我们可以对每个部分分别计算查询向量、键向量和值向量,并使用自注意力机制来计算该部分的表示。

最后,我们将 m m m 个表示向量拼接起来,得到整个序列的表示。这样做可以使模型更加灵活,能够同时处理不同层次的信息。

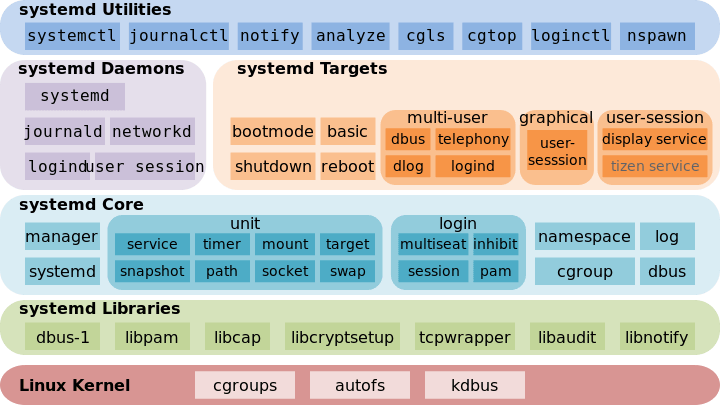

编码器-解码器结构Transformer网络通常采用编码器-解码器结构来完成序列到序列的转换任务。编码器负责将输入序列映射到连续的向量空间中,而解码器则利用编码器输出的向量来生成目标序列。

具体来说,编码器由多个相同的层级组成,每个层级包括一个多头自注意力层和一个前馈神经网络层。其中,多头自注意力层用于捕捉序列中的依赖关系,前馈神经网络层用于对位置向量进行非线性变换。

解码器也由多个相同的层级组成,每个层级包括一个多头自注意力层、一个编码器-解码器注意力层和一个前馈神经网络层。其中,多头自注意力层用于捕捉目标序列中的依赖关系,编码器-解码器注意力层用于将编码器的输出与解码器当前时刻的输入进行关联,前馈神经网络层用于对位置向量进行非线性变换。

2.3 Transformer网络的训练

在训练Transformer网络时,我们通常采用交叉熵损失函数和Adam优化器。具体来说,我们可以使用编码器来生成输入序列的表示,然后将该表示输入到解码器中,逐步生成目标序列。

在每个时间步,我们可以使用交叉熵损失函数来计算模型生成的序列和目标序列之间的差异,并使用反向传播算法来更新模型参数。为了避免过拟合,我们通常会在训练过程中使用dropout和层规范化等技术来加强模型的泛化能力。

3.Transformer网络实战

在实际应用中,我们可以使用PyTorch等深度学习框架来实现Transformer网络。以下是一个简单的示例:

import torch

import torch.nn as nn

import torch.nn.functional as Fclass MultiHeadAttention(nn.Module):def __init__(self, d_model, num_heads):super(MultiHeadAttention, self).__init__()self.d_model = d_modelself.num_heads = num_headsself.head_dim = d_model // num_headsself.query = nn.Linear(d_model, d_model)self.key = nn.Linear(d_model, d_model)self.value = nn.Linear(d_model, d_model)self.fc = nn.Linear(d_model, d_model)def forward(self, x, mask=None):batch_size = x.shape[0]Q = self.query(x).view(batch_size, -1, self.num_heads, self.head_dim)K = self.key(x).view(batch_size, -1, self.num_heads, self.head_dim)V = self.value(x).view(batch_size, -1, self.num_heads, self.head_dim)Q = Q.permute(0, 2, 1, 3)K = K.permute(0, 2, 1, 3)V = V.permute(0, 2, 1, 3)scores = torch.matmul(Q, K.permute(0, 1,3, 2))scores = scores / self.head_dim ** 0.5if mask is not None:scores = scores.masked_fill(mask == 0, -1e9)attn_weights = F.softmax(scores, dim=-1)attn_output = torch.matmul(attn_weights, V)attn_output = attn_output.permute(0, 2, 1, 3).contiguous()attn_output = attn_output.view(batch_size, -1, self.d_model)attn_output = self.fc(attn_output)return attn_output, attn_weightsclass PositionalEncoding(nn.Module):def __init__(self, d_model, max_len=5000):super(PositionalEncoding, self).__init__()self.d_model = d_modelpe = torch.zeros(max_len, d_model)position = torch.arange(0, max_len, dtype=torch.float).unsqueeze(1)div_term = torch.exp(torch.arange(0, d_model, 2).float() * (-math.log(10000.0) / d_model))pe[:, 0::2] = torch.sin(position * div_term)pe[:, 1::2] = torch.cos(position * div_term)pe = pe.unsqueeze(0)self.register_buffer('pe', pe)def forward(self, x):x = x * math.sqrt(self.d_model)seq_len =x.size(1)x = x + self.pe[:, :seq_len, :]return xclass TransformerBlock(nn.Module):def __init__(self, d_model, num_heads, dropout_rate=0.1):super(TransformerBlock, self).__init__()self.multihead_attention = MultiHeadAttention(d_model, num_heads)self.norm1 = nn.LayerNorm(d_model)self.dropout1 = nn.Dropout(dropout_rate)self.fc1 = nn.Linear(d_model, 4 * d_model)self.gelu = nn.GELU()self.fc2 = nn.Linear(4 * d_model, d_model)self.norm2 = nn.LayerNorm(d_model)self.dropout2 = nn.Dropout(dropout_rate)def forward(self, x, mask=None):attn_output, attn_weights = self.multihead_attention(x, mask=mask)x = x + self.dropout1(self.norm1(attn_output))fc_output = self.fc2(self.gelu(self.fc1(x)))x = x + self.dropout2(self.norm2(fc_output))return x, attn_weightsclass TransformerEncoder(nn.Module):def __init__(self, num_layers, d_model, num_heads, dropout_rate=0.1):super(TransformerEncoder, self).__init__()self.num_layers = num_layersself.d_model = d_modelself.layers = nn.ModuleList([TransformerBlock(d_model, num_heads, dropout_rate) for _ in range(num_layers)])def forward(self, x, mask=None):for i in range(self.num_layers):x, attn_weights = self.layers[i](x, mask=mask)return x, attn_weightsclass Transformer(nn.Module):def __init__(self, num_layers, d_model, num_heads, hidden_dim, dropout_rate=0.1):super(Transformer, self).__init__()self.encoder = TransformerEncoder(num_layers, d_model, num_heads, dropout_rate)self.fc = nn.Linear(d_model, hidden_dim)self.dropout = nn.Dropout(dropout_rate)self.output_layer = nn.Linear(hidden_dim, 1)def forward(self, x, mask=None):x, attn_weights = self.encoder(x, mask=mask)x = torch.mean(x, dim=1)x = self.dropout(F.relu(self.fc(x)))x = self.output_layer(x)return x.squeeze(), attn_weights